Terlepas dari penggunaan model bahasa besar (LLM) untuk membantu menulis kode, CEO Nvidia Jensen Huang percaya bahwa di masa depan, perangkat lunak perusahaan hanya akan menjadi kumpulan bot obrolan yang dirangkai untuk menyelesaikan tugas tersebut.

“Tidak mungkin Anda akan menulisnya dari awal atau menulis sejumlah besar kode Python atau semacamnya,” katanya di atas panggung selama GTC. intisari Senin. “Kemungkinan besar Anda akan membentuk tim AI.”

Tim AI ini, jelas Jensen, mungkin menyertakan model yang dirancang untuk memecah dan mendelegasikan permintaan ke berbagai model lainnya. Beberapa model ini mungkin dilatih untuk memahami layanan bisnis seperti SAP atau Service Now, sementara model lainnya mungkin melakukan analisis numerik pada data yang disimpan dalam database vektor. Data ini kemudian dapat digabungkan dan disajikan kepada pengguna akhir dengan model lain.

“Kami bisa mendapatkan laporan setiap hari atau Anda tahu, laporan paling penting yang ada hubungannya dengan rencana pembangunan, atau perkiraan, atau peringatan pelanggan, atau database bug atau apa pun yang terjadi,” jelasnya.

Untuk menyatukan semua model ini, Nvidia mengambil satu halaman dari buku Docker dan telah membuat runtime container untuk AI.

Dijuluki Nvidia Inference Microservices, atau disingkat NIM, ini pada dasarnya adalah gambar kontainer yang berisi kedua model, apakah itu sumber terbuka atau kepemilikan, beserta semua dependensi yang diperlukan untuk menjalankannya. Model dalam container ini kemudian dapat diterapkan di sejumlah runtime apa pun, termasuk node Kubernetes yang dipercepat Nvidia.

“Anda dapat menerapkannya di infrastruktur kami yang disebut DGX Cloud, atau Anda dapat menerapkannya di lokasi, atau Anda dapat menerapkannya di mana pun Anda suka. Setelah Anda mengembangkannya, itu bisa Anda bawa ke mana saja,” kata Jensen.

Tentu saja, Anda harus berlangganan suite AI Enterprise Nvidia terlebih dahulu, yang harganya tidak murah yaitu $4,500/tahun per GPU atau $1/jam per GPU di cloud. Strategi penetapan harga ini tampaknya memberi insentif pada sistem dengan kinerja lebih tinggi dan lebih padat secara umum karena biayanya sama terlepas dari apakah Anda menggunakan L40 atau B100s.

Jika gagasan untuk memasukkan beban kerja yang dipercepat GPU ke dalam container terdengar familiar, ini bukanlah ide baru bagi Nvidia. Akselerasi CUDA telah terjadi didukung pada berbagai runtime container, termasuk Docker, Podman, Containerd, atau CRI-O selama bertahun-tahun, dan sepertinya Container Runtime Nvidia tidak akan berhasil.

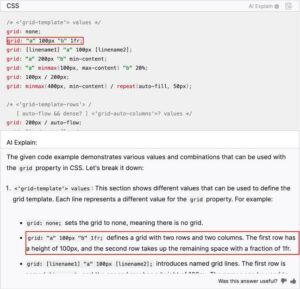

Proposisi nilai di balik NIM tampaknya adalah bahwa Nvidia akan menangani pengemasan dan optimalisasi model-model ini sehingga mereka memiliki versi CUDA, Triton Inference Server, atau TensorRT LLM yang tepat, yang diperlukan untuk mendapatkan kinerja terbaik dari model-model tersebut.

Argumennya adalah jika Nvidia merilis pembaruan yang secara dramatis meningkatkan kinerja inferensi jenis model tertentu, memanfaatkan fungsi tersebut hanya perlu menghapus gambar NIM terbaru.

Selain optimasi model perangkat keras tertentu, Nvidia juga berupaya untuk memungkinkan komunikasi yang konsisten antar container, sehingga mereka dapat mengobrol satu sama lain, melalui panggilan API.

Seperti yang kami pahami, panggilan API yang digunakan oleh berbagai model AI yang ada di pasaran saat ini tidak selalu konsisten sehingga lebih mudah untuk merangkai beberapa model dan model lainnya mungkin memerlukan pekerjaan tambahan.

Meminjamkan pengetahuan institusional ke model tujuan umum

Siapa pun yang telah menggunakan chatbot AI akan tahu bahwa meskipun mereka biasanya cukup baik dalam menjawab pertanyaan pengetahuan umum, mereka tidak selalu paling dapat diandalkan untuk permintaan yang tidak jelas atau teknis.

Jensen menyoroti fakta ini dalam pidatonya. Ditanya tentang program internal yang digunakan dalam Nvidia, model bahasa besar Meta Llama 2 70B secara mengejutkan memberikan definisi untuk istilah yang tidak terkait.

Alih-alih mencoba membuat perusahaan melatih model mereka sendiri – sesuatu yang akan menjual banyak GPU tetapi akan sangat membatasi pasar yang dapat ditangani – Nvidia telah mengembangkan alat untuk menyempurnakan NIM-nya dengan data dan proses pelanggan.

“Kami memiliki layanan bernama NeMo Microservices yang membantu Anda mengkurasi data, menyiapkan data sehingga Anda dapat… menggunakan AI ini. Anda menyempurnakannya dan kemudian Anda membatasinya; Anda kemudian dapat mengevaluasi… kinerjanya dibandingkan dengan contoh lainnya,” jelas Huang.

Dia juga berbicara tentang layanan NeMo Retriever Nvidia yang didasarkan pada konsep penggunaan retrieval augmented generation (RAG) untuk memunculkan informasi yang modelnya belum dilatih secara khusus.

Idenya di sini adalah dokumen, proses, dan data lainnya dapat dimuat ke dalam database vektor yang terhubung ke model. Berdasarkan kueri, model kemudian dapat mencari database tersebut, mengambil, dan meringkas informasi yang relevan.

Model NIM dan NeMo Retriever untuk mengintegrasikan RAG telah tersedia sekarang, sementara NeMo Microservices masih dalam akses awal. ®

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- Sumber: https://go.theregister.com/feed/www.theregister.com/2024/03/19/nvidia_why_write_code_when/

- :memiliki

- :adalah

- $NAIK

- 7

- a

- Tentang Kami

- dipercepat

- percepatan

- mengakses

- di seluruh

- tambahan

- Tambahan

- dapat dialamatkan

- Keuntungan

- terhadap

- AI

- AI chatbot

- Model AI

- Waspada

- Semua

- sepanjang

- juga

- selalu

- an

- analisis

- dan

- Lain

- Apa pun

- apa saja

- di manapun

- api

- muncul

- ADALAH

- argumen

- sekitar

- AS

- At

- ditambah

- tersedia

- berdasarkan

- BE

- menjadi

- di belakang

- makhluk

- percaya

- TERBAIK

- antara

- Book

- meningkatkan

- kedua

- bot

- Istirahat

- bug

- membangun

- ikat

- bisnis

- tapi

- by

- bernama

- Panggilan

- CAN

- Bisa Dapatkan

- ceo

- tertentu

- rantai

- mengobrol

- ChatBot

- murah

- awan

- CO

- kode

- koleksi

- bergabung

- komunikasi

- lengkap

- konsep

- terhubung

- konsisten

- Wadah

- Wadah

- Biaya

- Kelas

- dibuat

- pendeta pembantu

- pelanggan

- data pelanggan

- data

- Basis Data

- hari

- definisi

- ketergantungan

- menyebarkan

- dikerahkan

- dirancang

- mengembangkan

- dikembangkan

- do

- Buruh pelabuhan

- dokumen

- doesn

- turun

- secara dramatis

- selama

- setiap

- Awal

- mudah

- memungkinkan

- akhir

- Enterprise

- perangkat lunak perusahaan

- perusahaan

- dasarnya

- Setiap

- persis

- contoh

- menjelaskan

- Menjelaskan

- fakta

- akrab

- akhir

- Pertama

- Untuk

- Ramalan

- dari

- fungsi

- masa depan

- Umum

- generasi

- mendapatkan

- akan

- baik

- GPU

- GPU

- menangani

- Terjadi

- Perangkat keras

- Memiliki

- he

- membantu

- membantu

- di sini

- lebih tinggi

- Disorot

- -nya

- jam

- HTTPS

- huang

- ide

- if

- gambar

- gambar

- in

- insentif

- memasukkan

- Termasuk

- informasi

- Infrastruktur

- Kelembagaan

- Mengintegrasikan

- intern

- ke

- adalah n

- IT

- NYA

- jensen huang

- jpg

- hanya

- Intisari

- Tahu

- pengetahuan

- bahasa

- besar

- Terbaru

- 'like'

- Mungkin

- MEMBATASI

- ll

- Llama

- LLM

- melihat

- terlihat seperti

- Lot

- Pasar

- Mungkin..

- meta

- microservices

- mungkin

- model

- model

- Senin

- paling

- perlu

- Perlu

- New

- node

- sekarang

- jumlah

- Nvidia

- of

- on

- Di atas kapal

- sekali

- Buka

- open source

- optimasi

- optimisasi

- or

- Lainnya

- Lainnya

- kami

- di luar

- sendiri

- pengemasan

- halaman

- untuk

- Melakukan

- prestasi

- rencana

- plato

- Kecerdasan Data Plato

- Data Plato

- prem

- Mempersiapkan

- disajikan

- cukup

- di harga

- proses

- program

- dalil

- hak milik

- disediakan

- menarik

- tujuan

- Ular sanca

- pertanyaan

- Pertanyaan

- lap

- RE

- Bagaimanapun juga

- Pers

- relevan

- dapat diandalkan

- melaporkan

- permintaan

- permintaan

- membutuhkan

- dihasilkan

- pengambilan

- benar

- berjalan

- runtime

- s

- Tersebut

- sama

- getah

- menggaruk

- Pencarian

- terlihat

- menjual

- Server

- layanan

- Layanan

- Pendek

- tunggal

- So

- Perangkat lunak

- beberapa

- sesuatu

- suara

- sumber

- tertentu

- Secara khusus

- Tahap

- tersimpan

- Penyelarasan

- Tali

- berlangganan

- rangkaian

- meringkaskan

- Permukaan

- sistem

- Mengambil

- pengambilan

- tugas

- tim

- Teknis

- istilah

- bahwa

- Grafik

- Masa depan

- mereka

- Mereka

- kemudian

- Ini

- mereka

- ini

- untuk

- hari ini

- bersama

- alat

- puncak

- Pelatihan VE

- terlatih

- Pelaut

- mencoba

- lagu

- jenis

- memahami

- mungkin

- Memperbarui

- bekas

- Pengguna

- menggunakan

- biasanya

- nilai

- variasi

- berbagai

- versi

- sangat

- melalui

- we

- apa pun

- apakah

- yang

- sementara

- SIAPA

- seluruh

- lebar

- akan

- dengan

- dalam

- Kerja

- kerja

- akan

- menulis

- tulis kode

- tahun

- namun

- Kamu

- milikmu

- Youtube

- zephyrnet.dll