Tim ilmu data dan teknik data menghabiskan sebagian besar waktu mereka dalam fase persiapan data dari siklus hidup machine learning (ML) melakukan langkah-langkah pemilihan, pembersihan, dan transformasi data. Ini adalah langkah penting dan penting dari setiap alur kerja ML untuk menghasilkan wawasan dan prediksi yang berarti, karena data yang buruk atau berkualitas rendah sangat mengurangi relevansi wawasan yang diperoleh.

Tim rekayasa data secara tradisional bertanggung jawab atas penyerapan, konsolidasi, dan transformasi data mentah untuk konsumsi hilir. Ilmuwan data sering kali perlu melakukan pemrosesan tambahan pada data untuk kasus penggunaan ML khusus domain seperti bahasa alami dan deret waktu. Misalnya, algoritme ML tertentu mungkin sensitif terhadap nilai yang hilang, fitur sparse, atau outlier dan memerlukan pertimbangan khusus. Bahkan dalam kasus di mana kumpulan data dalam kondisi yang baik, ilmuwan data mungkin ingin mengubah distribusi fitur atau membuat fitur baru untuk memaksimalkan wawasan yang diperoleh dari model. Untuk mencapai tujuan ini, ilmuwan data harus mengandalkan tim rekayasa data untuk mengakomodasi perubahan yang diminta, yang mengakibatkan ketergantungan dan penundaan dalam proses pengembangan model. Sebagai alternatif, tim ilmu data dapat memilih untuk melakukan persiapan data dan rekayasa fitur secara internal menggunakan berbagai paradigma pemrograman. Namun, ini memerlukan investasi waktu dan upaya dalam pemasangan dan konfigurasi perpustakaan dan kerangka kerja, yang tidak ideal karena waktu itu dapat dihabiskan dengan lebih baik untuk mengoptimalkan kinerja model.

Pengatur Data Amazon SageMaker menyederhanakan persiapan data dan proses rekayasa fitur, mengurangi waktu yang diperlukan untuk mengumpulkan dan menyiapkan data untuk ML dari minggu ke menit dengan menyediakan antarmuka visual tunggal bagi ilmuwan data untuk memilih, membersihkan, dan menjelajahi kumpulan data mereka. Data Wrangler menawarkan lebih dari 300 transformasi data bawaan untuk membantu menormalkan, mengubah, dan menggabungkan fitur tanpa menulis kode apa pun. Anda dapat mengimpor data dari beberapa sumber data, seperti Layanan Penyimpanan Sederhana Amazon (Amazon S3), Amazon Athena, Pergeseran Merah Amazon, dan Kepingan salju. Anda sekarang juga dapat menggunakan batu bata data sebagai sumber data di Data Wrangler untuk menyiapkan data untuk ML dengan mudah.

Databricks Lakehouse Platform menggabungkan elemen terbaik dari data lake dan data warehouse untuk menghadirkan keandalan, tata kelola yang kuat, dan kinerja data warehouse dengan keterbukaan, fleksibilitas, dan dukungan pembelajaran mesin dari data lake. Dengan Databricks sebagai sumber data untuk Pengatur Data, kini Anda dapat dengan cepat dan mudah terhubung ke Databricks, secara interaktif melakukan kueri data yang disimpan di Databricks menggunakan SQL, dan melihat pratinjau data sebelum mengimpor. Selain itu, Anda dapat menggabungkan data Anda di Databricks dengan data yang disimpan di Amazon S3, dan data yang dikueri melalui Amazon Athena, Amazon Redshift, dan Snowflake untuk membuat kumpulan data yang tepat untuk kasus penggunaan ML Anda.

Dalam posting ini, kami mengubah dataset Lending Club Loan menggunakan Amazon SageMaker Data Wrangler untuk digunakan dalam pelatihan model ML.

Ikhtisar solusi

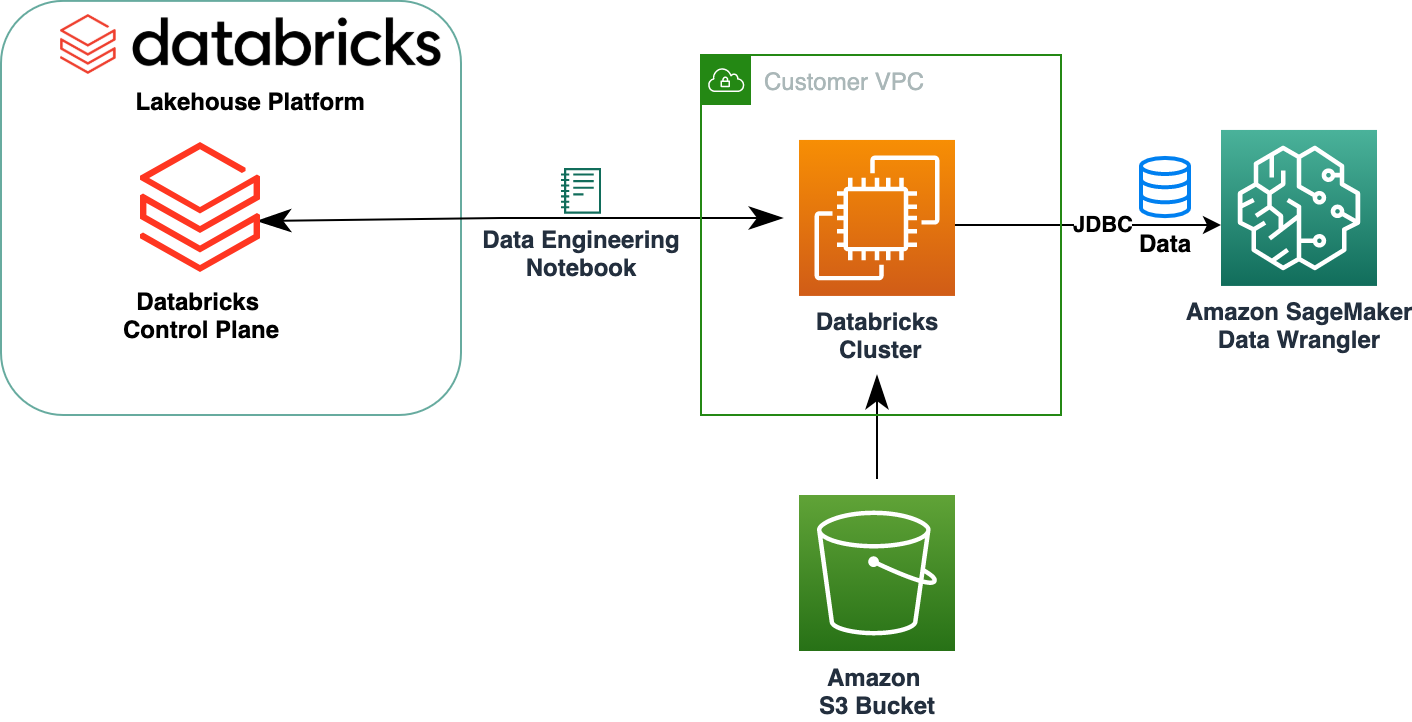

Diagram berikut menggambarkan arsitektur solusi kami.

Dataset Lending Club Loan berisi data pinjaman lengkap untuk semua pinjaman yang diterbitkan hingga 2007–2011, termasuk status pinjaman saat ini dan informasi pembayaran terbaru. Ini memiliki 39,717 baris, 22 kolom fitur, dan 3 label target.

Untuk mengubah data kami menggunakan Data Wrangler, kami menyelesaikan langkah-langkah tingkat tinggi berikut:

- Unduh dan pisahkan kumpulan data.

- Buat aliran Data Wrangler.

- Impor data dari Databricks ke Data Wrangler.

- Impor data dari Amazon S3 ke Data Wrangler.

- Bergabunglah dengan datanya.

- Terapkan transformasi.

- Ekspor kumpulan data.

Prasyarat

Posting ini mengasumsikan Anda memiliki cluster Databricks yang sedang berjalan. Jika klaster Anda berjalan di AWS, pastikan Anda telah mengonfigurasi yang berikut ini:

Pengaturan Databricks

- An profil contoh dengan izin yang diperlukan untuk mengakses bucket S3

- A kebijakan ember dengan izin yang diperlukan untuk bucket S3 target

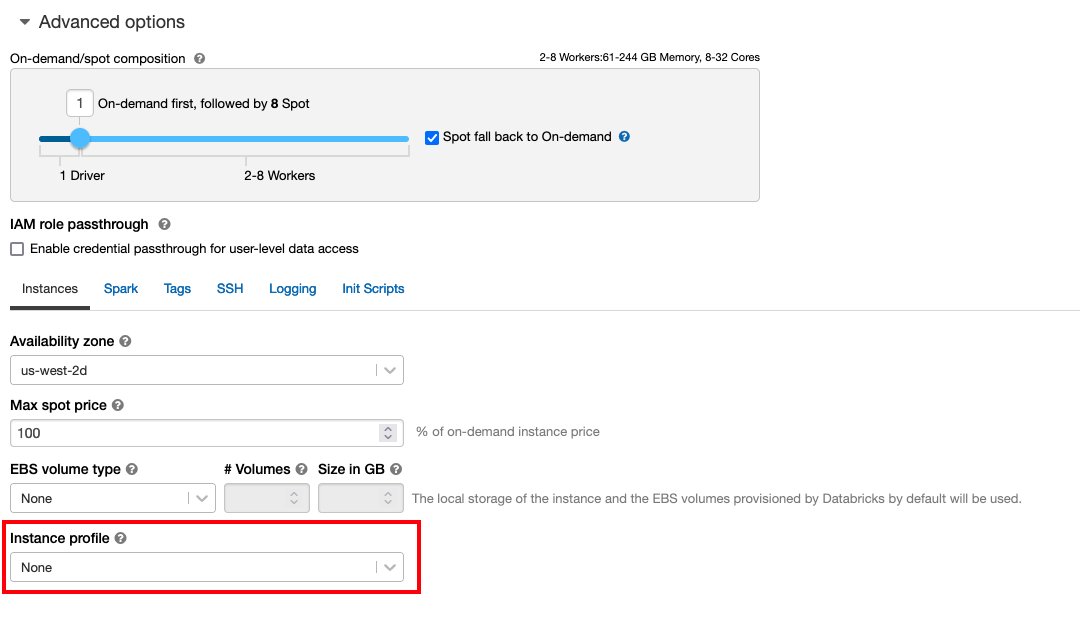

Mengikuti Akses aman ke bucket S3 menggunakan profil instan untuk yang dibutuhkan Identitas AWS dan Manajemen Akses (IAM), kebijakan bucket S3, dan konfigurasi cluster Databricks. Pastikan cluster Databricks dikonfigurasi dengan yang benar Instance Profile, dipilih di bawah opsi lanjutan, untuk mengakses bucket S3 yang diinginkan.

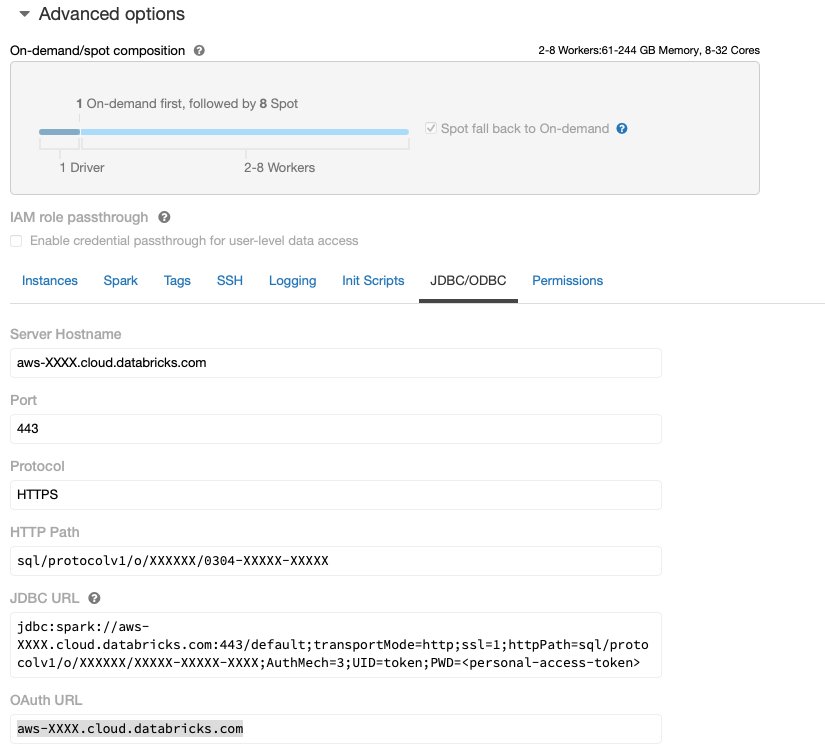

Setelah klaster Databricks aktif dan berjalan dengan akses yang diperlukan ke Amazon S3, Anda dapat mengambil JDBC URL dari klaster Databricks Anda untuk digunakan oleh Data Wrangler untuk menyambungkannya.

Ambil URL JDBC

Untuk mengambil URL JDBC, selesaikan langkah-langkah berikut:

- Di Databricks, navigasikan ke UI cluster.

- Pilih cluster Anda.

- pada konfigurasi tab, pilih Advanced options.

- Bawah Advanced options, memilih JDBC/ODBC Tab.

- Salin URL JDBC.

Pastikan untuk mengganti akses pribadi Anda token di URL-nya.

Pengaturan Data Wrangler

Langkah ini mengasumsikan Anda memiliki akses ke Amazon SageMaker, sebuah instance dari Studio Amazon SageMaker, dan pengguna Studio.

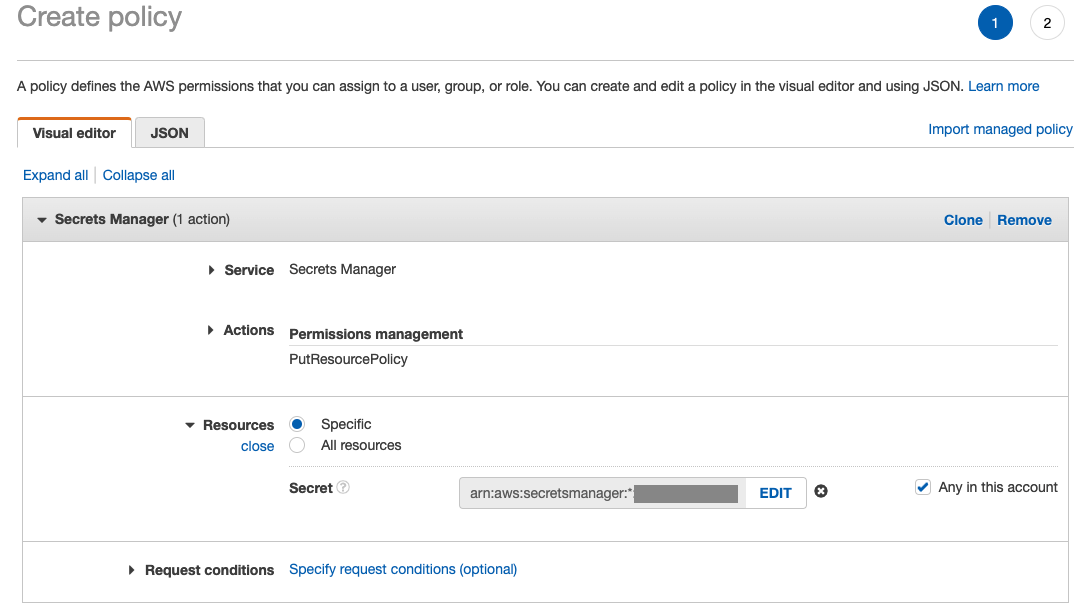

Untuk mengizinkan akses ke koneksi Databricks JDBC dari Data Wrangler, pengguna Studio memerlukan izin berikut:

secretsmanager:PutResourcePolicy

Ikuti langkah-langkah di bawah ini untuk memperbarui peran eksekusi IAM yang ditetapkan ke pengguna Studio dengan izin di atas, sebagai pengguna administratif IAM.

- Di konsol IAM, pilih Peran di panel navigasi.

- Pilih peran yang ditetapkan untuk pengguna Studio Anda.

- Pilih Tambahkan izin.

- Pilih Buat kebijakan sebaris.

- Untuk Layanan, pilih Manajer Rahasia.

- On tindakan, pilih Tingkat akses.

- Pilih Manajemen izin.

- Pilih MasukkanResourcePolicy.

- Untuk Sumber, pilih Spesifik dan pilih Apa saja di akun ini.

Unduh dan pisahkan kumpulan data

Anda bisa mulai dengan mengunduh kumpulan data. Untuk tujuan demonstrasi, kami membagi dataset dengan menyalin kolom fitur id, emp_title, emp_length, home_owner, dan annual_inc untuk membuat detik pinjaman_2.csv mengajukan. Kami menghapus kolom yang disebutkan di atas dari file pinjaman asli kecuali id kolom dan ganti nama file asli menjadi pinjaman_1.csv. Unggah pinjaman_1.csv file untuk batu bata data untuk membuat tabel loans_1 dan pinjaman_2.csv dalam ember S3.

Buat aliran Data Wrangler

Untuk informasi tentang prasyarat Data Wrangler, lihat Memulai dengan Data Wrangler.

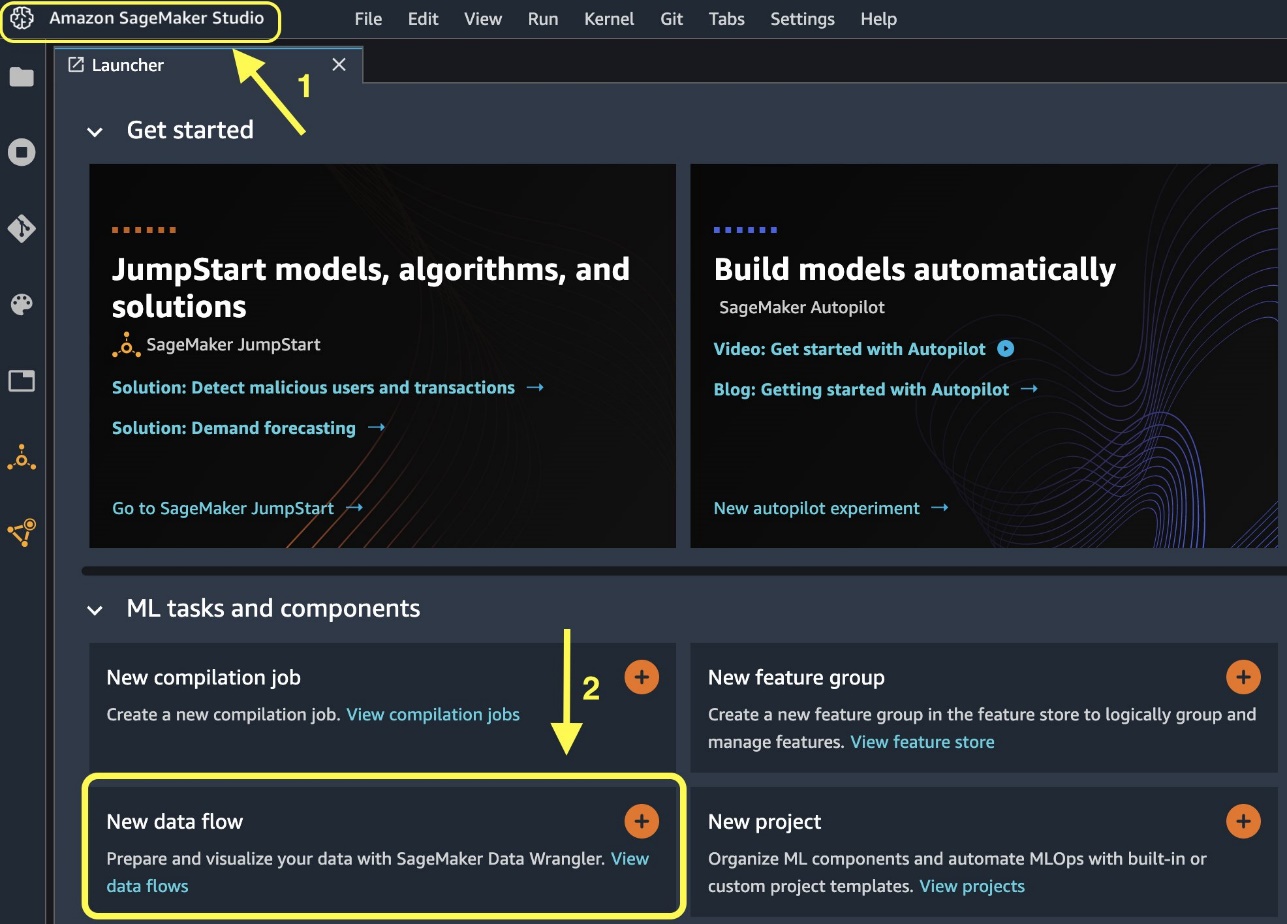

Mari kita mulai dengan membuat aliran data baru.

- Di konsol Studio, di File menu, pilih New.

- Pilih Aliran data Wrangler.

- Ubah nama aliran sesuai keinginan.

Atau, Anda dapat membuat aliran data baru dari Peluncur.

Pembuatan alur baru dapat memakan waktu beberapa menit untuk diselesaikan. Setelah alur dibuat, Anda melihat Impor data .

Impor data dari Databricks ke Data Wrangler

Selanjutnya, kami menyiapkan Databricks (JDBC) sebagai sumber data di Data Wrangler. Untuk mengimpor data dari Databricks, pertama-tama kita perlu menambahkan Databricks sebagai sumber data.

- pada Impor data tab aliran Data Wrangler Anda, pilih Tambahkan sumber data.

- Di menu drop-down, pilih Databrick (JDBC).

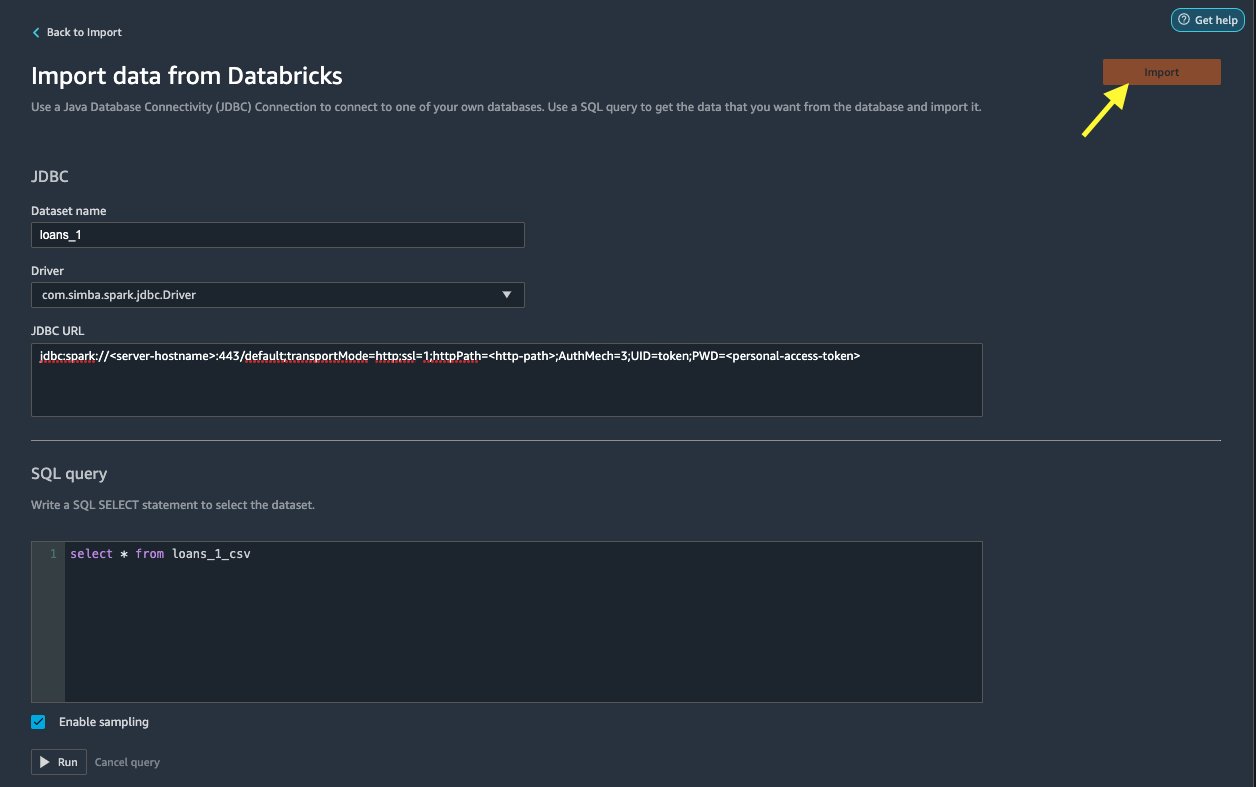

pada Impor data dari Databricks halaman, Anda memasukkan detail cluster Anda.

- Untuk Nama kumpulan data, masukkan nama yang ingin Anda gunakan dalam file aliran.

- Untuk sopir, pilih drivernya

com.simba.spark.jdbc.Driver. - Untuk URL JDBC, masukkan URL cluster Databricks Anda yang diperoleh sebelumnya.

URL harus menyerupai format berikut jdbc:spark://<serve- hostname>:443/default;transportMode=http;ssl=1;httpPath=<http- path>;AuthMech=3;UID=token;PWD=<personal-access-token>.

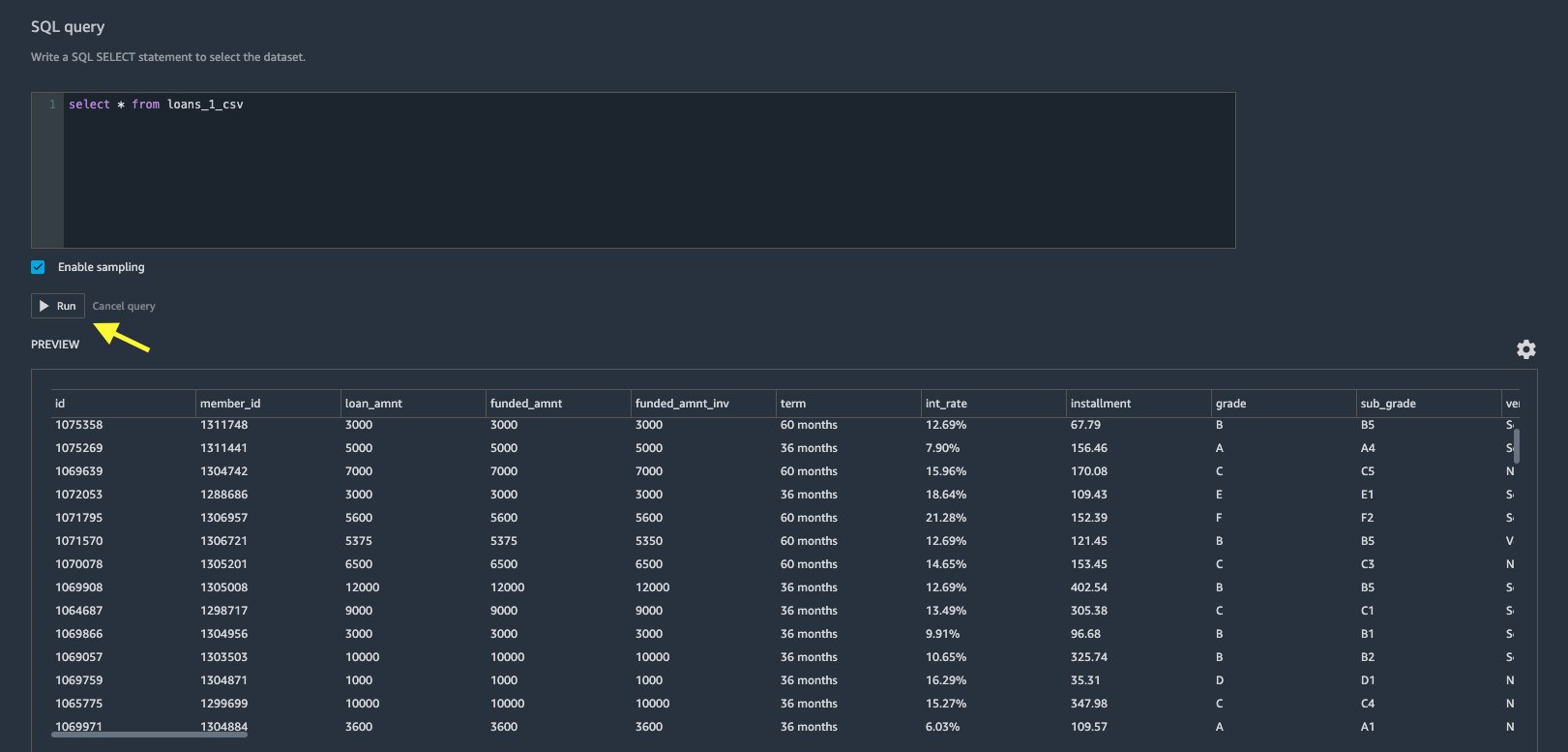

- Di editor kueri SQL, tentukan pernyataan SQL SELECT berikut ini:

Jika Anda memilih nama tabel yang berbeda saat mengunggah data ke Databricks, ganti loan_1 di kueri SQL di atas.

Dalam majalah Permintaan SQL Di bagian Data Wrangler, Anda dapat membuat kueri tabel apa pun yang terhubung ke database JDBC Databricks. Yang telah dipilih sebelumnya Aktifkan pengambilan sampel pengaturan mengambil 50,000 baris pertama dari kumpulan data Anda secara default. Bergantung pada ukuran kumpulan data, batalkan pilihan Aktifkan pengambilan sampel dapat mengakibatkan waktu impor lebih lama.

- Pilih Run.

Menjalankan kueri memberikan pratinjau kumpulan data Databricks Anda secara langsung di Data Wrangler.

Data Wrangler memberikan fleksibilitas untuk mengatur beberapa koneksi bersamaan ke satu cluster Databricks atau beberapa cluster jika diperlukan, memungkinkan analisis dan persiapan pada kumpulan data gabungan.

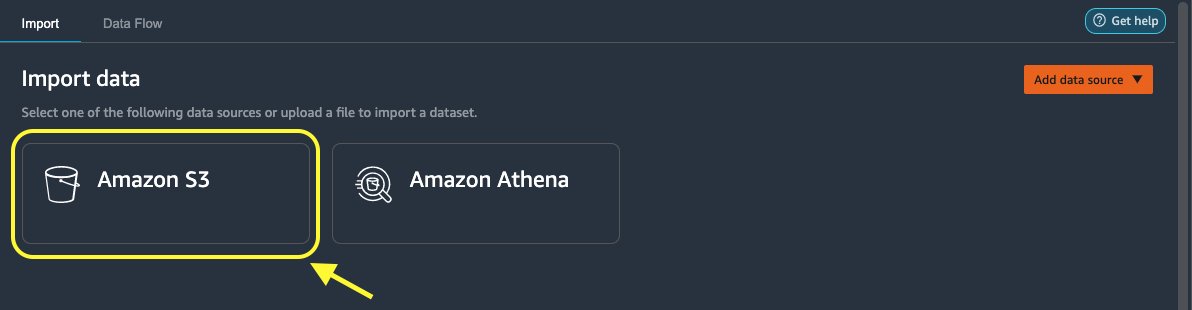

Impor data dari Amazon S3 ke Data Wrangler

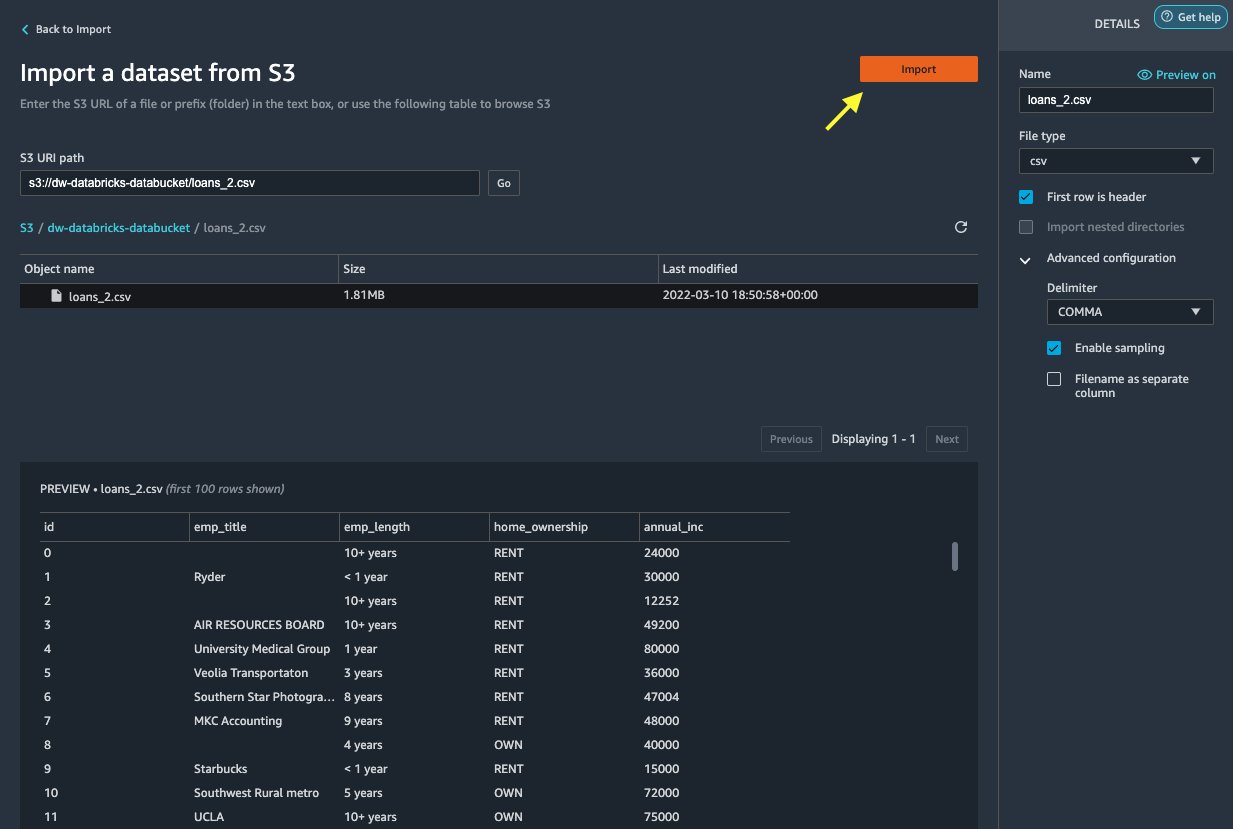

Selanjutnya, mari impor loan_2.csv berkas dari Amazon S3.

- Pada tab Impor, pilih Amazon S3 sebagai sumber datanya.

- Navigasikan ke ember S3 untuk

loan_2.csvfile.

Saat Anda memilih file CSV, Anda dapat melihat pratinjau data.

- Dalam majalah Rincian panel, pilih Konfigurasi lanjutan untuk memastikan Aktifkan pengambilan sampel dipilih dan GUGUS KALIMAT dipilih untuk Pembatas.

- Pilih impor.

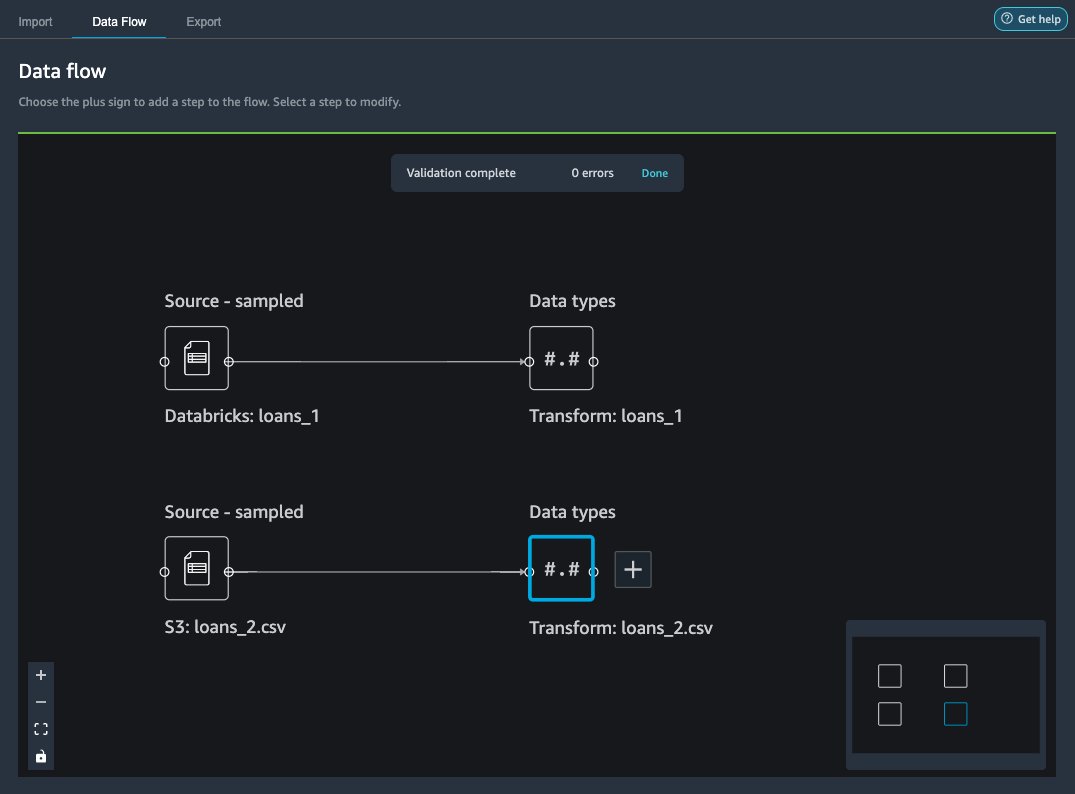

Setelah loans_2.csv set data berhasil diimpor, antarmuka aliran data menampilkan sumber data Databricks JDBC dan Amazon S3.

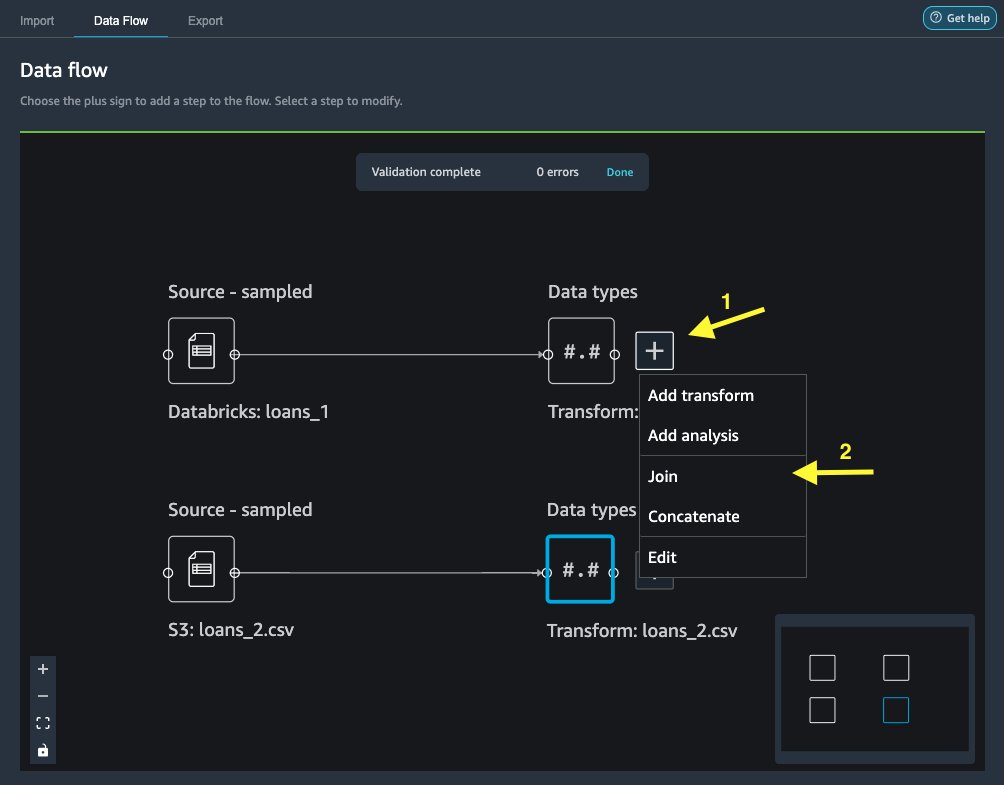

Bergabunglah dengan data

Sekarang setelah kita mengimpor data dari Databricks dan Amazon S3, mari gabungkan kumpulan data menggunakan kolom pengenal unik umum.

- pada Aliran data tab, untuk Tipe data, pilih tanda plus untuk

loans_1. - Pilih Ikuti seminar.

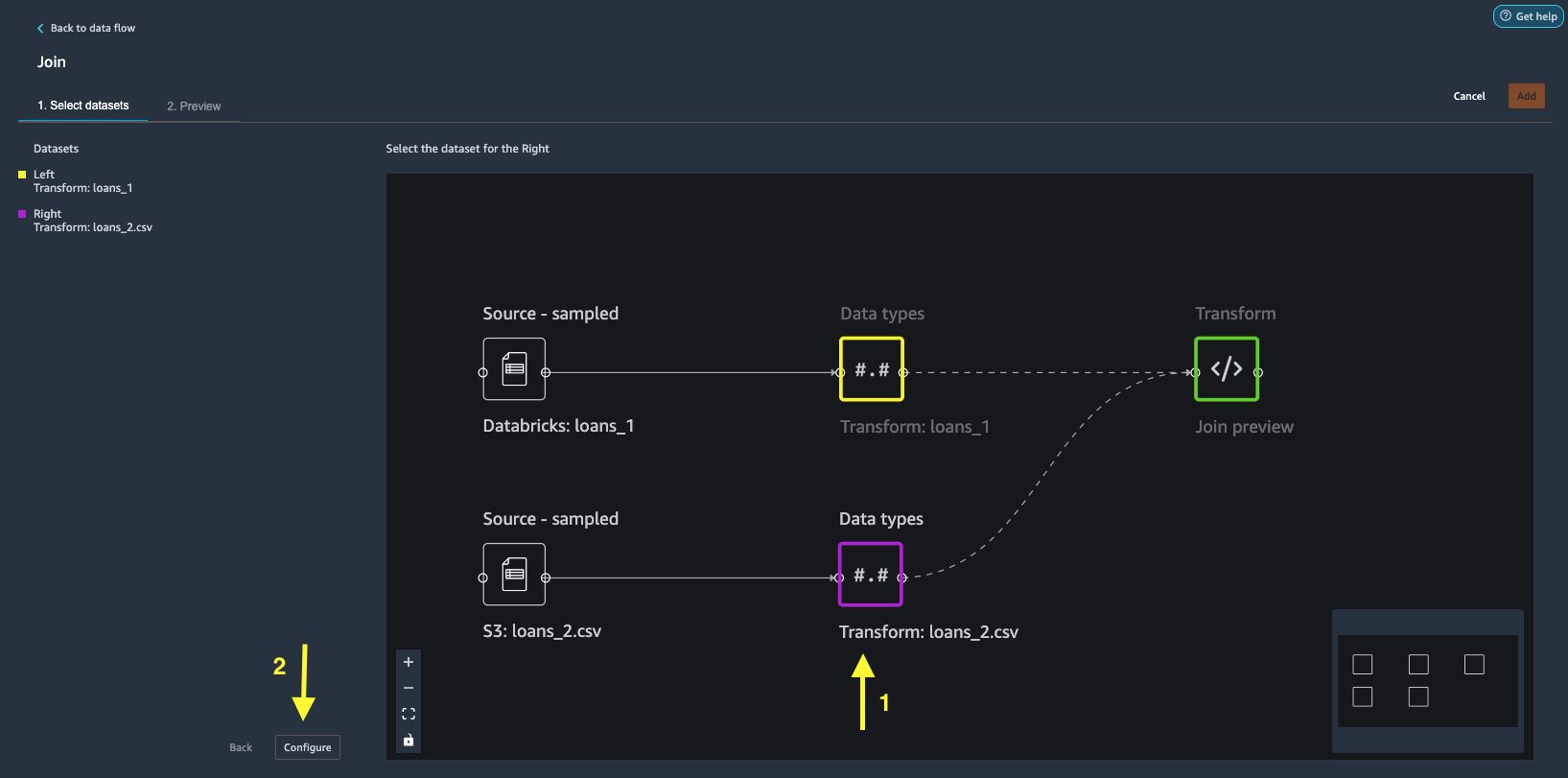

- Pilih

loans_2.csvfile sebagai Kanan Himpunan data. - Pilih Konfigurasi untuk mengatur kriteria bergabung.

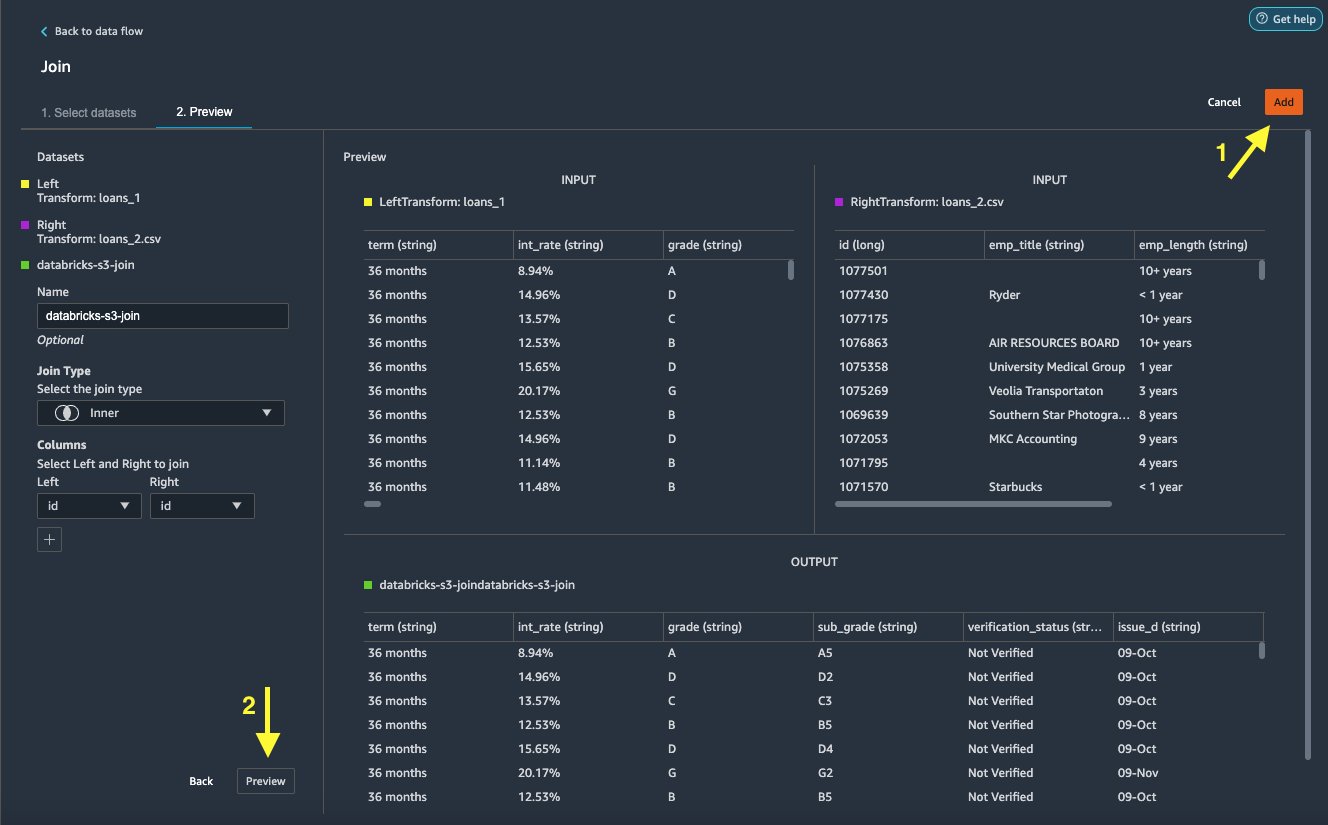

- Untuk Nama, masukkan nama untuk bergabung.

- Untuk Gabung tipe, pilih Batin untuk posting ini.

- Pilih

idkolom untuk bergabung. - Pilih Mendaftar untuk melihat pratinjau kumpulan data yang digabungkan.

- Pilih Add untuk menambahkannya ke aliran data.

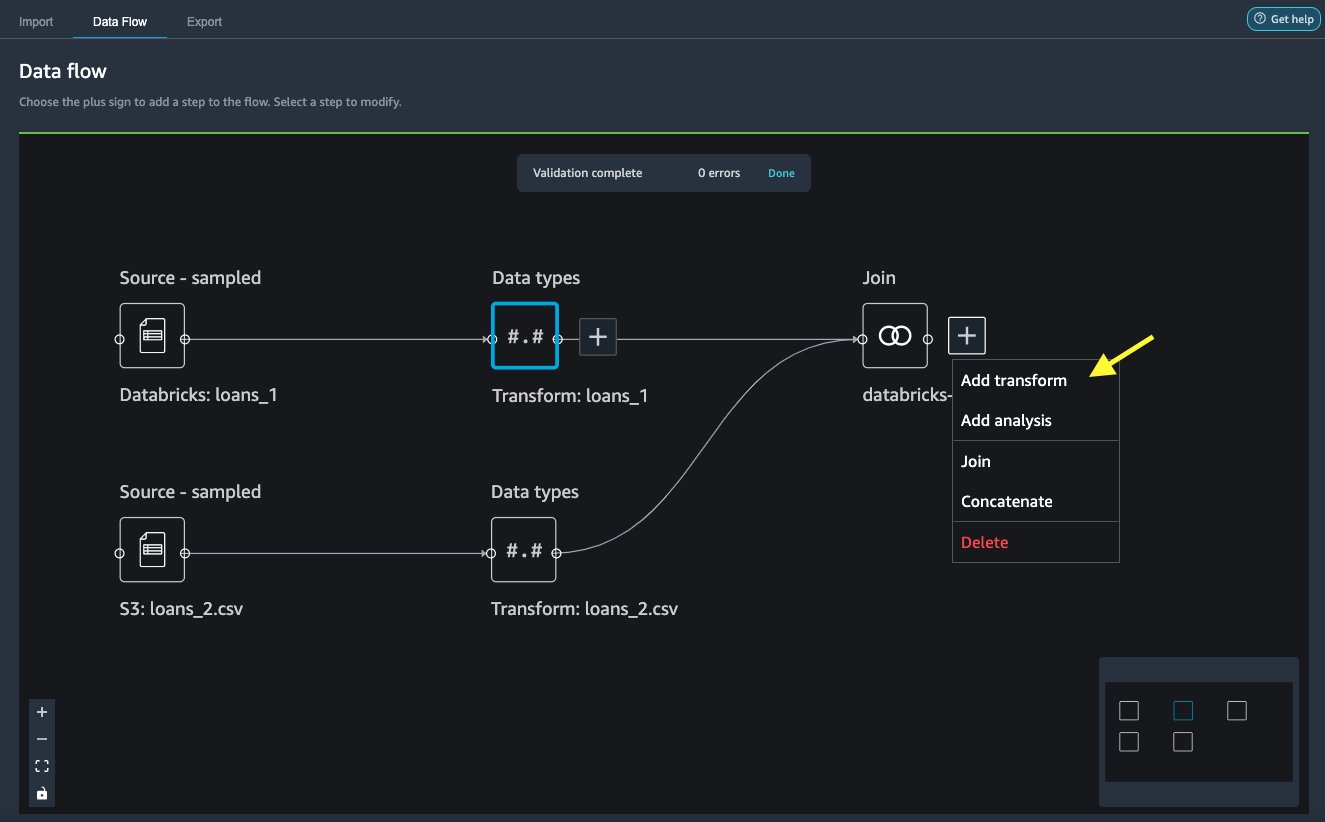

Terapkan transformasi

Data Wrangler hadir dengan lebih dari 300 transformasi bawaan, yang tidak memerlukan pengkodean. Mari gunakan transformasi bawaan untuk menyiapkan kumpulan data.

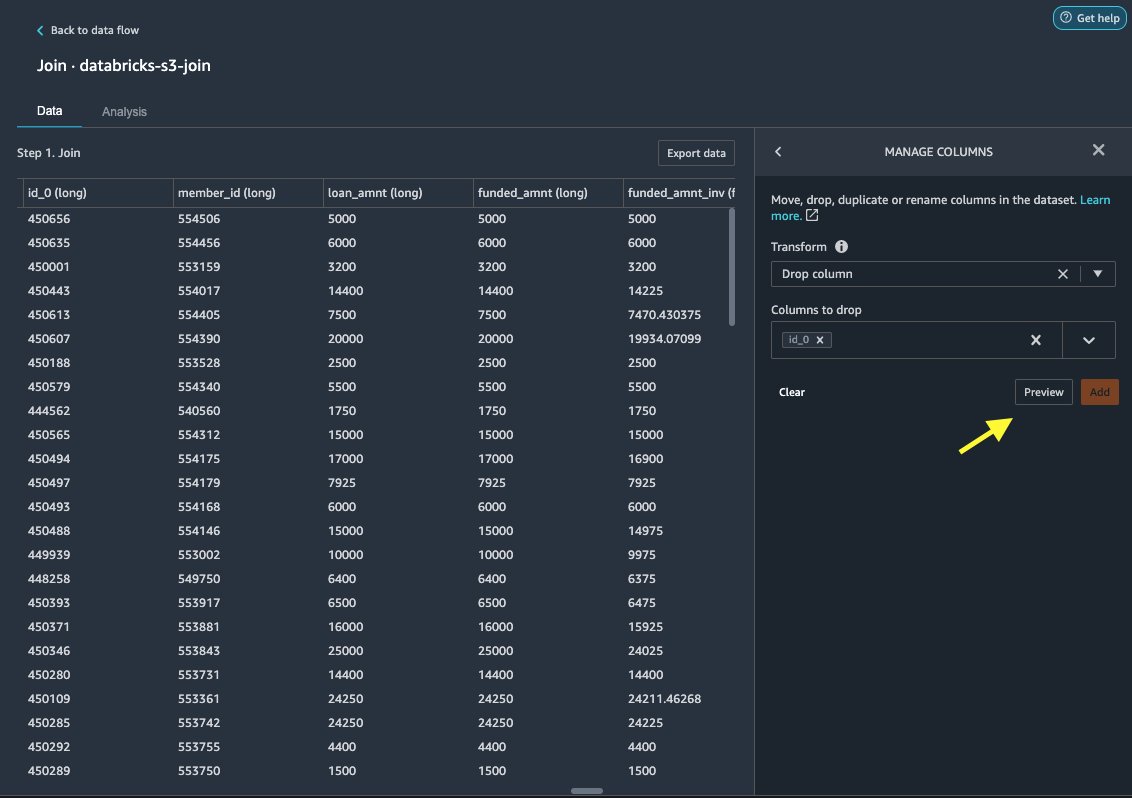

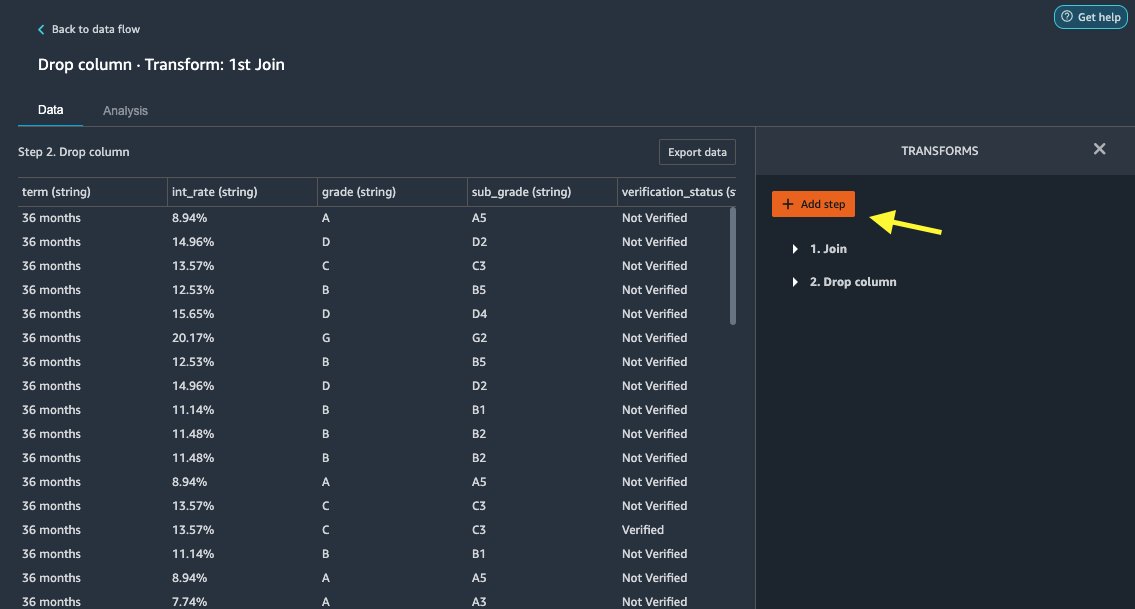

Jatuhkan kolom

Pertama kita jatuhkan kolom ID yang berlebihan.

- Pada node yang bergabung, pilih tanda plus.

- Pilih Tambahkan transformasi.

- Bawah mengubah, pilih + Tambahkan langkah.

- Pilih Kelola kolom.

- Untuk Mengubah, pilih Jatuhkan kolom.

- Untuk Kolom untuk dijatuhkan, pilih kolom

id_0. - Pilih Preview.

- Pilih Add.

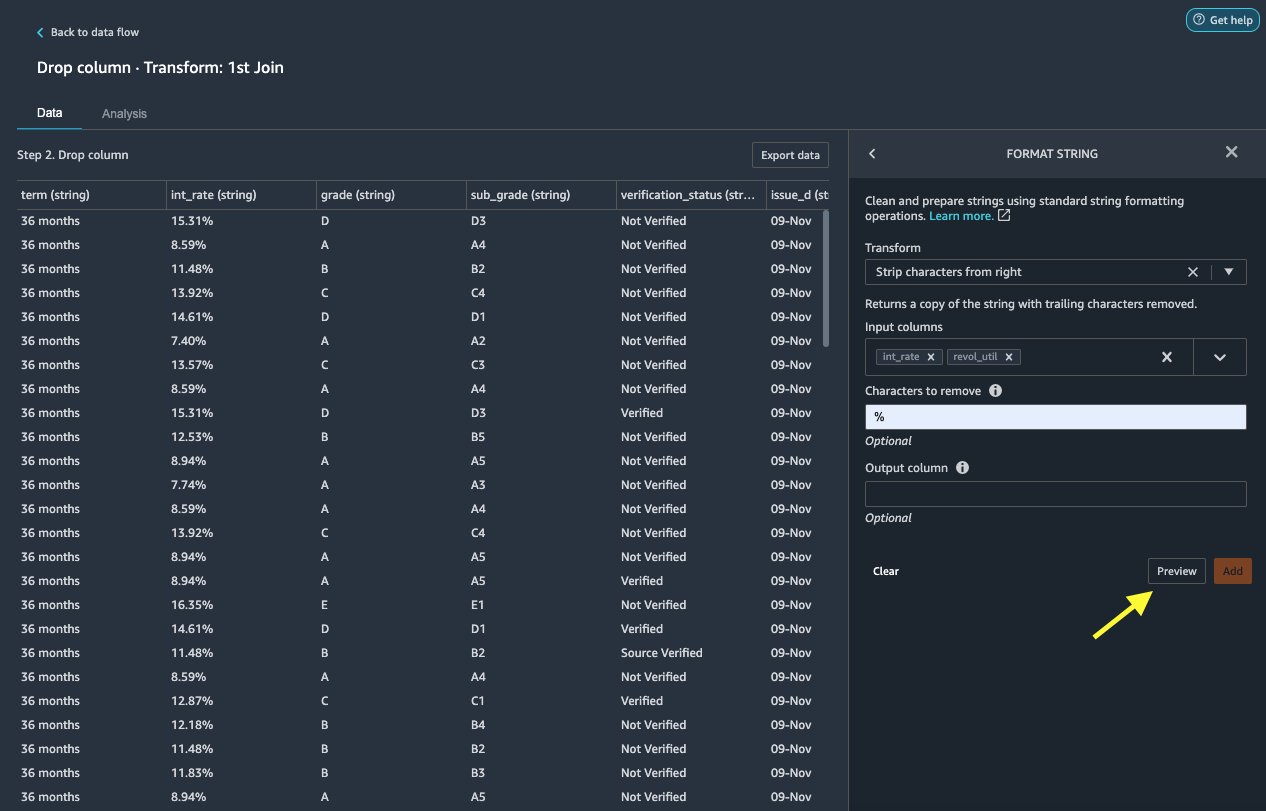

Memformat string

Mari kita terapkan pemformatan string untuk menghapus simbol persentase dari int_rate dan revol_util kolom.

- pada Data tab, di bawah Transformasi, pilih + Tambahkan langkah.

- Pilih Memformat string.

- Untuk Mengubah, pilih Strip karakter dari kanan.

Data Wrangler memungkinkan Anda untuk menerapkan transformasi yang Anda pilih pada beberapa kolom secara bersamaan.

- Untuk Kolom masukan, pilih

int_ratedanrevol_util. - Untuk Karakter untuk dihapus, Masuk

%. - Pilih Preview.

- Pilih Add.

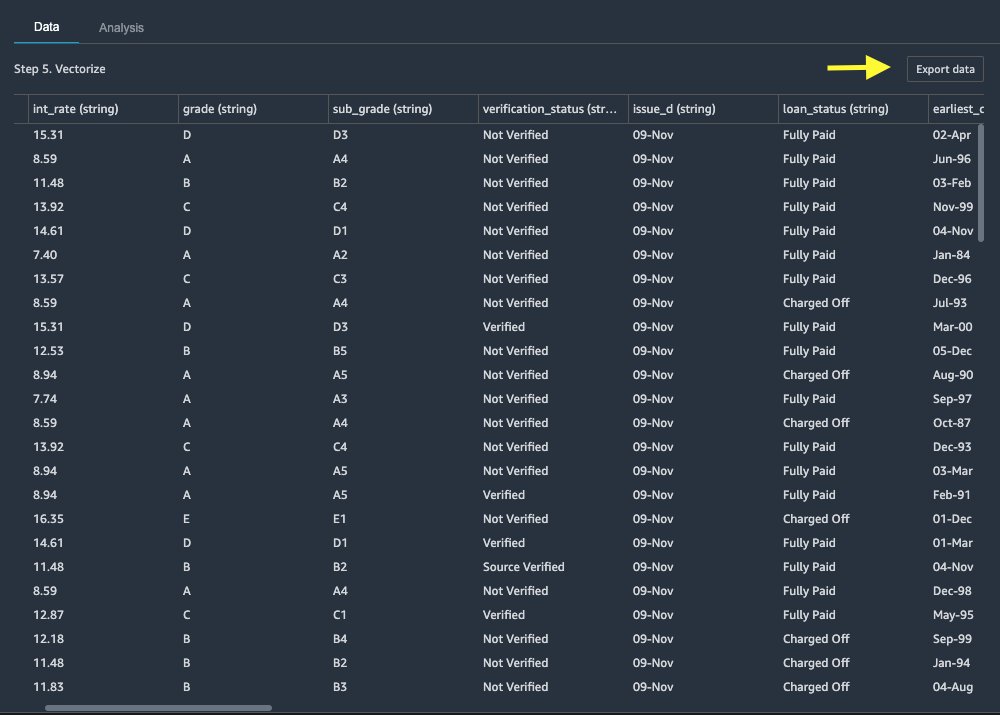

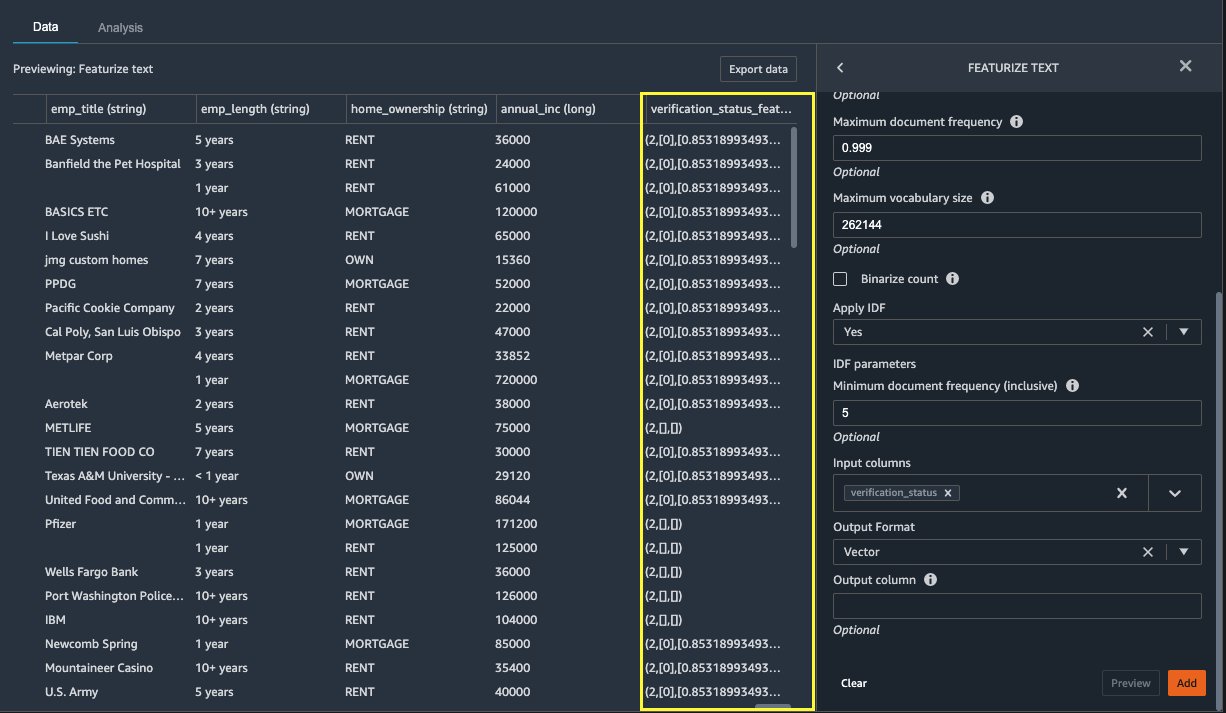

Menampilkan teks

Sekarang mari kita membuat vektor verification_status, kolom fitur teks. Kami mengubah kolom teks menjadi vektor term frequency-inverse document frequency (TF-IDF) dengan menerapkan count vectorizer dan tokenizer standar seperti yang dijelaskan di bawah ini. Data Wrangler juga menyediakan opsi untuk membawa tokenizer Anda sendiri, jika diinginkan.

- Bawah transformer, pilih + Tambahkan langkah.

- Pilih Menampilkan teks.

- Untuk Mengubah, pilih Vektorisasi.

- Untuk Kolom masukan, pilih

verification_status. - Pilih Preview.

- Pilih Add.

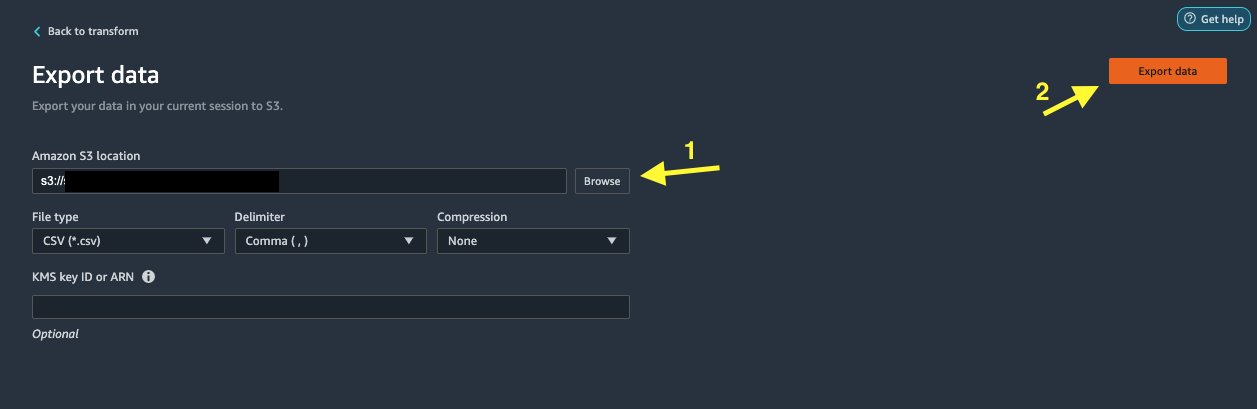

Ekspor kumpulan data

Setelah kami menerapkan beberapa transformasi pada jenis kolom yang berbeda, termasuk teks, kategorikal, dan numerik, kami siap menggunakan kumpulan data yang diubah untuk pelatihan model ML. Langkah terakhir adalah mengekspor kumpulan data yang diubah ke Amazon S3. Di Data Wrangler, Anda memiliki beberapa opsi untuk dipilih untuk konsumsi hilir transformasi:

- Pilih Langkah ekspor untuk secara otomatis membuat notebook Jupyter dengan kode Pemrosesan SageMaker untuk memproses dan mengekspor kumpulan data yang diubah ke bucket S3. Untuk informasi lebih lanjut, lihat Luncurkan pekerjaan pemrosesan dengan beberapa klik menggunakan Amazon SageMaker Data Wrangler.

- Ekspor buku catatan Studio yang membuat Pipa SageMaker dengan aliran data Anda, atau buku catatan yang membuat Toko Fitur Amazon SageMaker grup fitur dan menambahkan fitur ke toko fitur offline atau online.

- Pilih Ekspor data untuk mengekspor langsung ke Amazon S3.

Dalam posting ini, kami memanfaatkan Ekspor data pilihan dalam Mengubah view untuk mengekspor kumpulan data yang diubah langsung ke Amazon S3.

Membersihkan

Jika pekerjaan Anda dengan Data Wrangler selesai, matikan instance Data Wrangler Anda untuk menghindari biaya tambahan.

Kesimpulan

Dalam posting ini, kami membahas bagaimana Anda dapat dengan cepat dan mudah menyiapkan dan menghubungkan Databricks sebagai sumber data di Data Wrangler, secara interaktif meminta data yang disimpan di Databricks menggunakan SQL, dan melihat pratinjau data sebelum mengimpor. Selain itu, kami melihat bagaimana Anda dapat menggabungkan data Anda di Databricks dengan data yang disimpan di Amazon S3. Kami kemudian menerapkan transformasi data pada kumpulan data gabungan untuk membuat jalur persiapan data. Untuk mengeksplorasi lebih banyak kemampuan analisis Data Wrangler, termasuk kebocoran target dan pembuatan laporan bias, lihat posting blog berikut Percepat persiapan data menggunakan Amazon SageMaker Data Wrangler untuk prediksi penerimaan kembali pasien diabetes.

Untuk memulai dengan Data Wrangler, lihat Siapkan Data ML dengan Amazon SageMaker Data Wrangler, dan lihat informasi terbaru tentang Data Wrangler halaman produk.

Tentang Penulis

Roop Bain adalah Arsitek Solusi di AWS yang berfokus pada AI/ML. Dia bersemangat membantu pelanggan berinovasi dan mencapai tujuan bisnis mereka menggunakan Kecerdasan Buatan dan Pembelajaran Mesin. Di waktu luangnya, Roop senang membaca dan mendaki.

Roop Bain adalah Arsitek Solusi di AWS yang berfokus pada AI/ML. Dia bersemangat membantu pelanggan berinovasi dan mencapai tujuan bisnis mereka menggunakan Kecerdasan Buatan dan Pembelajaran Mesin. Di waktu luangnya, Roop senang membaca dan mendaki.

Igor Alekseev adalah Partner Solution Architect di AWS dalam bidang Data dan Analytics. Igor bekerja dengan mitra strategis membantu mereka membangun arsitektur kompleks yang dioptimalkan AWS. Sebelum bergabung dengan AWS, sebagai Arsitek Data/Solusi, ia mengimplementasikan banyak proyek di Big Data, termasuk beberapa data lake di ekosistem Hadoop. Sebagai Data Engineer, ia terlibat dalam penerapan AI/ML untuk deteksi penipuan dan otomatisasi kantor. Proyek Igor berada di berbagai industri termasuk komunikasi, keuangan, keselamatan publik, manufaktur, dan perawatan kesehatan. Sebelumnya, Igor bekerja sebagai full stack engineer/tech lead.

Igor Alekseev adalah Partner Solution Architect di AWS dalam bidang Data dan Analytics. Igor bekerja dengan mitra strategis membantu mereka membangun arsitektur kompleks yang dioptimalkan AWS. Sebelum bergabung dengan AWS, sebagai Arsitek Data/Solusi, ia mengimplementasikan banyak proyek di Big Data, termasuk beberapa data lake di ekosistem Hadoop. Sebagai Data Engineer, ia terlibat dalam penerapan AI/ML untuk deteksi penipuan dan otomatisasi kantor. Proyek Igor berada di berbagai industri termasuk komunikasi, keuangan, keselamatan publik, manufaktur, dan perawatan kesehatan. Sebelumnya, Igor bekerja sebagai full stack engineer/tech lead.

Huong Nguyen adalah Manajer Produk Senior di AWS. Dia memimpin pengalaman pengguna untuk SageMaker Studio. Dia memiliki pengalaman 13 tahun menciptakan produk yang terobsesi dengan pelanggan dan berdasarkan data untuk ruang perusahaan dan konsumen. Di waktu luangnya, dia suka membaca, berada di alam terbuka, dan menghabiskan waktu bersama keluarganya.

Huong Nguyen adalah Manajer Produk Senior di AWS. Dia memimpin pengalaman pengguna untuk SageMaker Studio. Dia memiliki pengalaman 13 tahun menciptakan produk yang terobsesi dengan pelanggan dan berdasarkan data untuk ruang perusahaan dan konsumen. Di waktu luangnya, dia suka membaca, berada di alam terbuka, dan menghabiskan waktu bersama keluarganya.

Henry Wang adalah seorang insinyur pengembangan perangkat lunak di AWS. Dia baru saja bergabung dengan tim Data Wrangler setelah lulus dari UC Davis. Dia memiliki minat dalam ilmu data dan pembelajaran mesin dan melakukan pencetakan 3D sebagai hobi.

Henry Wang adalah seorang insinyur pengembangan perangkat lunak di AWS. Dia baru saja bergabung dengan tim Data Wrangler setelah lulus dari UC Davis. Dia memiliki minat dalam ilmu data dan pembelajaran mesin dan melakukan pencetakan 3D sebagai hobi.

- Coinsmart. Pertukaran Bitcoin dan Crypto Terbaik Eropa.

- Platoblockchain. Intelijen Metaverse Web3. Pengetahuan Diperkuat. AKSES GRATIS.

- CryptoHawk. Radar Altcoin. Uji Coba Gratis.

- Sumber: https://aws.amazon.com/blogs/machine-learning/prepare-data-from-databricks-for-machine-learning-using-amazon-sagemaker-data-wrangler/

- "

- 000

- 100

- 39

- 3d

- Tentang Kami

- mengakses

- menampung

- Tambahan

- maju

- Keuntungan

- algoritma

- Semua

- Amazon

- analisis

- analisis

- Menerapkan

- arsitektur

- buatan

- kecerdasan buatan

- Kecerdasan Buatan dan Pembelajaran Mesin

- ditugaskan

- Otomatisasi

- AWS

- makhluk

- TERBAIK

- Big data

- Blog

- batas

- membangun

- built-in

- bisnis

- kemampuan

- kasus

- Pilih

- Pembersihan

- klub

- kode

- Pengkodean

- Kolom

- bergabung

- Umum

- komunikasi

- kompleks

- konfigurasi

- terhubung

- koneksi

- Koneksi

- pertimbangan

- konsul

- konsolidasi

- konsumen

- konsumsi

- mengandung

- dibuat

- menciptakan

- membuat

- terbaru

- pelanggan

- data

- ilmu data

- Basis Data

- menunda

- Tergantung

- Deteksi

- Pengembangan

- berbeda

- langsung

- menampilkan

- turun

- pengemudi

- Menjatuhkan

- mudah

- ekosistem

- editor

- aktif

- memungkinkan

- insinyur

- Teknik

- Enter

- Enterprise

- contoh

- Kecuali

- eksekusi

- pengalaman

- menyelidiki

- keluarga

- Fitur

- Fitur

- Biaya

- keuangan

- Pertama

- keluwesan

- aliran

- berikut

- format

- penipuan

- penuh

- menghasilkan

- generasi

- baik

- pemerintahan

- Kelompok

- kesehatan

- membantu

- Seterpercayaapakah Olymp Trade? Kesimpulan

- HTTPS

- identitas

- diimplementasikan

- penting

- pengimporan

- Termasuk

- industri

- informasi

- wawasan

- Intelijen

- bunga

- Antarmuka

- investasi

- terlibat

- IT

- Jobs

- ikut

- bergabung

- Label

- bahasa

- Terbaru

- memimpin

- terkemuka

- pengetahuan

- pinjaman

- Pinjaman

- tampak

- mesin

- Mesin belajar

- manajer

- pabrik

- ML

- model

- model

- lebih

- beberapa

- Alam

- Alam

- Navigasi

- Fitur Baru

- buku catatan

- Penawaran

- Pengunjung

- secara online

- pilihan

- Opsi

- urutan

- sendiri

- pasangan

- rekan

- bergairah

- pembayaran

- persentase

- prestasi

- pribadi

- tahap

- Platform

- kebijaksanaan

- Prediksi

- Preview

- proses

- Produk

- Produk

- Pemrograman

- memprojeksikan

- menyediakan

- menyediakan

- publik

- tujuan

- segera

- Mentah

- Bacaan

- mengurangi

- melaporkan

- membutuhkan

- wajib

- tanggung jawab

- berjalan

- Safety/keselamatan

- Ilmu

- ilmuwan

- terpilih

- Seri

- layanan

- set

- pengaturan

- penting

- Sederhana

- Ukuran

- Perangkat lunak

- pengembangan perangkat lunak

- larutan

- Solusi

- spasi

- menghabiskan

- Pengeluaran

- membagi

- tumpukan

- standar

- awal

- mulai

- Pernyataan

- Status

- penyimpanan

- menyimpan

- Strategis

- kuat

- studio

- berhasil

- mendukung

- target

- tim

- Melalui

- waktu

- Pelatihan

- Mengubah

- Transformasi

- ui

- unik

- Memperbarui

- menggunakan

- variasi

- berbagai

- sementara

- tanpa

- Kerja

- bekerja

- bekerja

- penulisan