Organisasi dalam industri pinjaman dan hipotek memproses ribuan dokumen setiap hari. Dari aplikasi hipotek baru hingga pembiayaan kembali hipotek, proses bisnis ini melibatkan ratusan dokumen per aplikasi. Ada otomatisasi terbatas yang tersedia saat ini untuk memproses dan mengekstrak informasi dari semua dokumen, terutama karena berbagai format dan tata letak. Karena volume aplikasi yang tinggi, menangkap wawasan strategis dan mendapatkan informasi penting dari konten adalah proses yang memakan waktu, sangat manual, rawan kesalahan, dan mahal. Alat pengenalan karakter optik (OCR) lawas hemat biaya, rawan kesalahan, melibatkan banyak konfigurasi, dan sulit untuk diskalakan. Pemrosesan dokumen cerdas (IDP) dengan layanan kecerdasan buatan (AI) AWS membantu mengotomatiskan dan mempercepat pemrosesan aplikasi hipotek dengan tujuan keputusan yang lebih cepat dan berkualitas, sekaligus mengurangi biaya keseluruhan.

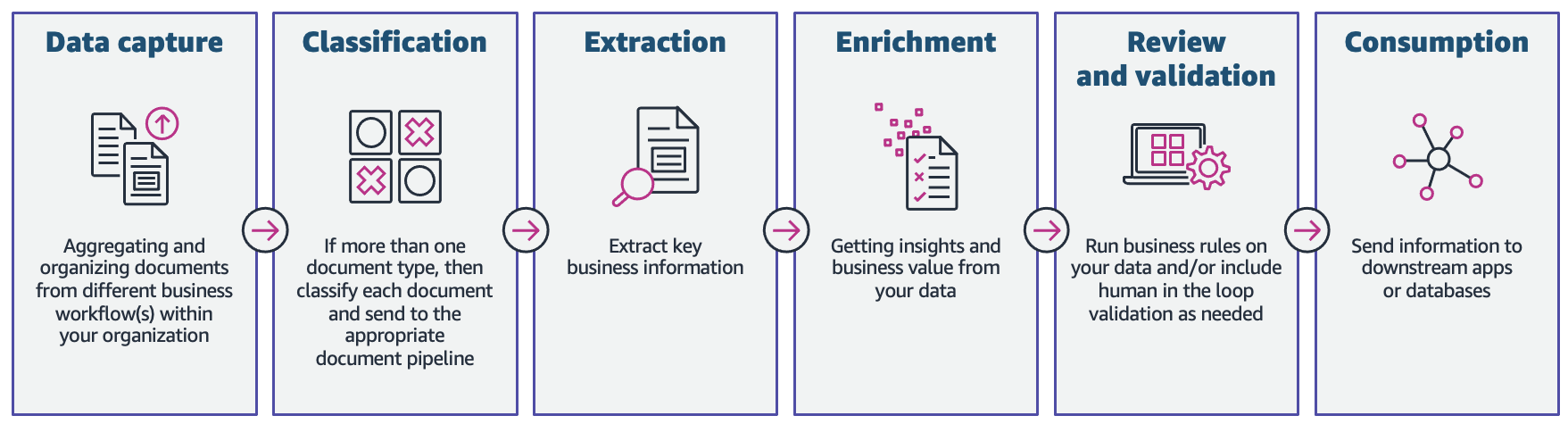

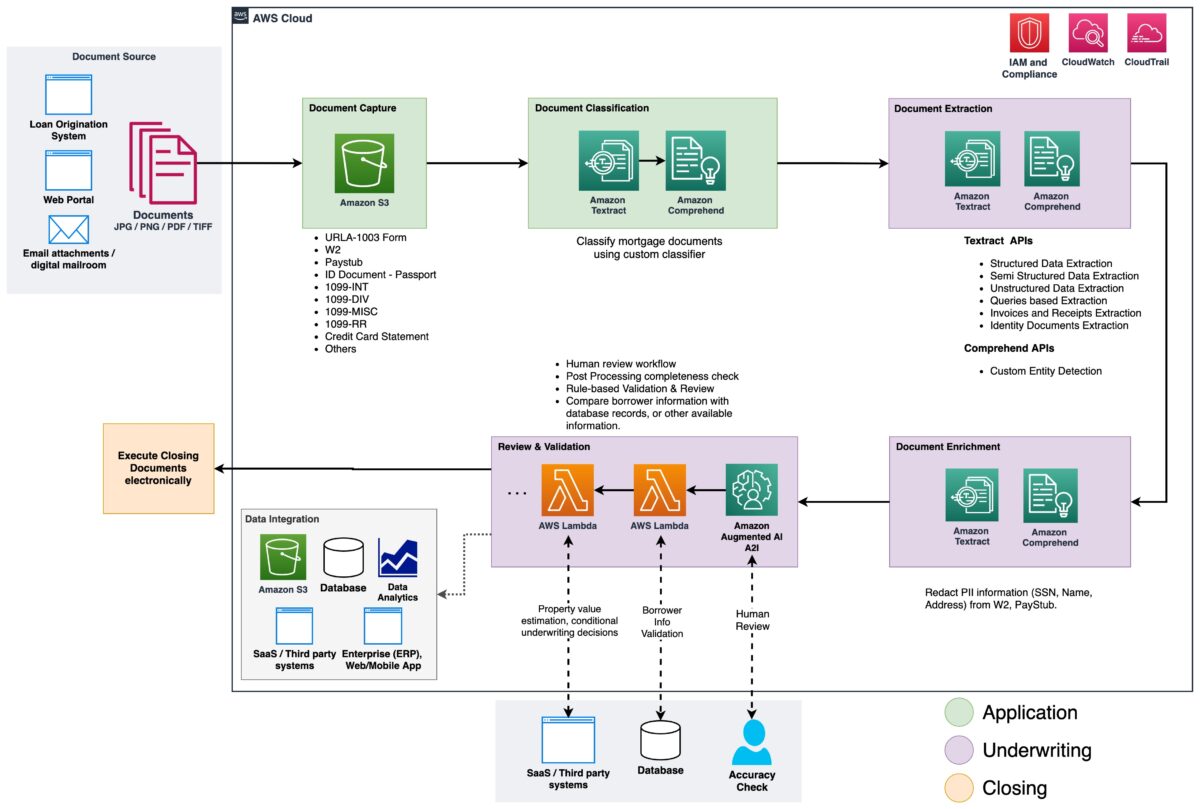

Dalam postingan ini, kami mendemonstrasikan bagaimana Anda dapat memanfaatkan kemampuan machine learning (ML) dengan Teks Amazon, dan Amazon Comprehend untuk memproses dokumen dalam aplikasi hipotek baru, tanpa perlu keterampilan ML. Kami menjelajahi berbagai fase IDP seperti yang ditunjukkan pada gambar berikut, dan bagaimana mereka terhubung ke langkah-langkah yang terlibat dalam proses aplikasi hipotek, seperti pengajuan aplikasi, penjaminan emisi, verifikasi, dan penutupan.

Meskipun setiap aplikasi hipotek mungkin unik, kami memperhitungkan beberapa dokumen paling umum yang disertakan dalam aplikasi hipotek, seperti formulir Aplikasi Pinjaman Perumahan Terpadu (URLA-1003), formulir 1099, dan nota hipotek.

Ikhtisar solusi

Amazon Textract adalah layanan ML yang secara otomatis mengekstrak teks, tulisan tangan, dan data dari dokumen yang dipindai menggunakan model ML yang telah dilatih sebelumnya. Amazon Comprehend adalah layanan pemrosesan bahasa alami (NLP) yang menggunakan ML untuk mengungkap wawasan dan koneksi berharga dalam teks dan dapat melakukan klasifikasi dokumen, pengenalan entitas nama (NER), pemodelan topik, dan banyak lagi.

Gambar berikut menunjukkan tahapan IDP yang berkaitan dengan tahapan proses pengajuan KPR.

Pada awal proses, dokumen diunggah ke Layanan Penyimpanan Sederhana Amazon (Amazon S3) ember. Ini memulai proses klasifikasi dokumen untuk mengkategorikan dokumen ke dalam kategori yang diketahui. Setelah dokumen dikategorikan, langkah selanjutnya adalah mengekstrak informasi kunci dari mereka. Kami kemudian melakukan pengayaan untuk dokumen tertentu, yang dapat berupa hal-hal seperti redaksi informasi pengenal pribadi (PII), penandaan dokumen, pembaruan metadata, dan banyak lagi. Langkah selanjutnya melibatkan validasi data yang diekstraksi pada fase sebelumnya untuk memastikan kelengkapan aplikasi hipotek. Validasi dapat dilakukan melalui aturan validasi bisnis dan aturan validasi dokumen silang. Skor kepercayaan dari informasi yang diekstraksi juga dapat dibandingkan dengan ambang batas yang ditetapkan, dan secara otomatis dialihkan ke peninjau manusia melalui Amazon Augmented AI (Amazon A2I) jika ambang batas tidak terpenuhi. Pada fase akhir proses, data yang diekstraksi dan divalidasi dikirim ke sistem hilir untuk penyimpanan, pemrosesan, atau analisis data lebih lanjut.

Pada bagian berikut, kami membahas tahapan IDP yang berkaitan dengan tahapan aplikasi hipotek secara rinci. Kami menelusuri fase-fase IDP dan mendiskusikan jenis-jenis dokumen; cara kami menyimpan, mengklasifikasikan, dan mengekstrak informasi, serta cara kami memperkaya dokumen menggunakan machine learning.

Penyimpanan dokumen

Amazon S3 adalah layanan penyimpanan objek yang menawarkan skalabilitas, ketersediaan data, keamanan, dan kinerja terdepan di industri. Kami menggunakan Amazon S3 untuk menyimpan dokumen hipotek dengan aman selama dan setelah proses aplikasi hipotek. SEBUAH paket aplikasi hipotek dapat berisi beberapa jenis formulir dan dokumen, seperti URLA-1003, 1099-INT/DIV/RR/MISC, W2, slip gaji, laporan bank, laporan kartu kredit, dan lainnya. Dokumen-dokumen ini diserahkan oleh pemohon dalam tahap aplikasi hipotek. Tanpa memeriksanya secara manual, mungkin tidak segera jelas dokumen mana yang disertakan dalam paket. Proses manual ini bisa memakan waktu dan mahal. Pada fase berikutnya, kami mengotomatiskan proses ini menggunakan Amazon Comprehend untuk mengklasifikasikan dokumen ke dalam kategori masing-masing dengan akurasi tinggi.

Klasifikasi dokumen

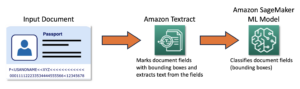

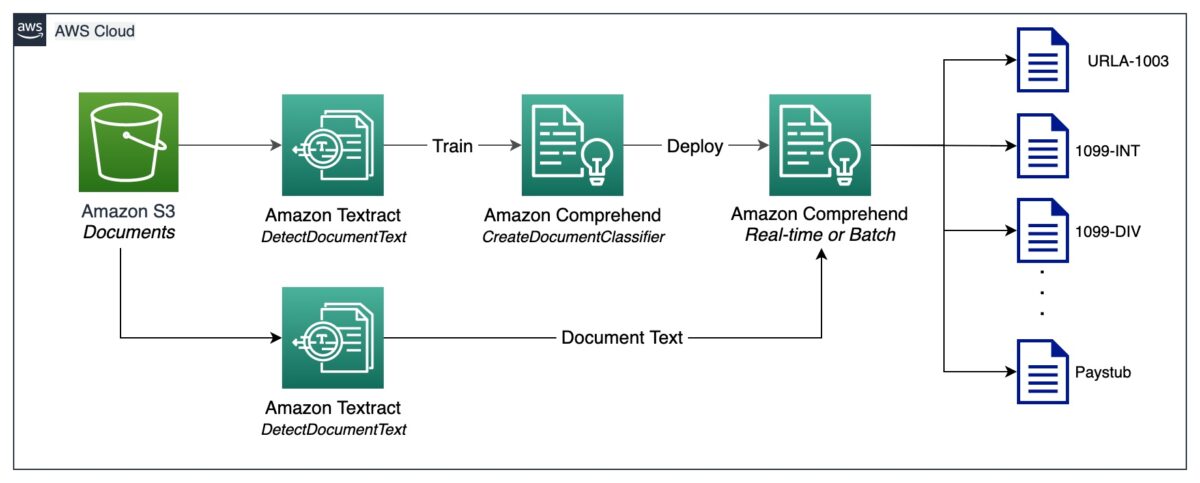

Klasifikasi dokumen adalah metode dimana sejumlah besar dokumen tak dikenal dapat dikategorikan dan diberi label. Kami melakukan klasifikasi dokumen ini menggunakan Amazon Comprehend pengklasifikasi kustom. Pengklasifikasi kustom adalah model ML yang dapat dilatih dengan sekumpulan dokumen berlabel untuk mengenali kelas yang Anda minati. Setelah model dilatih dan digunakan di belakang titik akhir yang dihosting, kita dapat menggunakan pengklasifikasi untuk menentukan kategori (atau kelas) yang dimiliki oleh dokumen tertentu. Dalam hal ini, kami melatih pengklasifikasi khusus di mode multi-kelas, yang dapat dilakukan dengan file CSV atau file manifes yang diperbesar. Untuk keperluan demonstrasi ini, kami menggunakan file CSV untuk melatih pengklasifikasi. Lihat kami Repositori GitHub untuk contoh kode lengkap. Berikut ini adalah gambaran tingkat tinggi dari langkah-langkah yang terlibat:

- Ekstrak teks biasa yang disandikan UTF-8 dari file gambar atau PDF menggunakan Amazon Textract DeteksiTeks Dokumen API.

- Siapkan data pelatihan untuk melatih pengklasifikasi kustom dalam format CSV.

- Latih pengklasifikasi khusus menggunakan file CSV.

- Terapkan model terlatih dengan titik akhir untuk klasifikasi dokumen waktu nyata atau gunakan mode multi-kelas, yang mendukung operasi waktu nyata dan asinkron.

Diagram berikut menggambarkan proses ini.

Anda dapat mengotomatiskan klasifikasi dokumen menggunakan titik akhir yang diterapkan untuk mengidentifikasi dan mengkategorikan dokumen. Otomatisasi ini berguna untuk memverifikasi apakah semua dokumen yang diperlukan ada dalam paket hipotek. Dokumen yang hilang dapat dengan cepat diidentifikasi, tanpa intervensi manual, dan diberitahukan kepada pemohon jauh lebih awal dalam prosesnya.

Ekstraksi dokumen

Pada fase ini, kami mengekstrak data dari dokumen menggunakan Amazon Textract dan Amazon Comprehend. Untuk dokumen terstruktur dan semi-terstruktur yang berisi formulir dan tabel, kami menggunakan Amazon Textract Analisis Dokumen API. Untuk dokumen khusus seperti dokumen ID, Amazon Textract menyediakan AnalisisID API. Beberapa dokumen mungkin juga berisi teks padat, dan Anda mungkin perlu mengekstrak istilah kunci khusus bisnis dari dokumen tersebut, yang juga dikenal sebagai entitas. Kami menggunakan pengakuan entitas kustom kemampuan Amazon Comprehend untuk melatih pengenal entitas kustom, yang dapat mengidentifikasi entitas tersebut dari teks padat.

Pada bagian berikut, kami menelusuri contoh dokumen yang ada dalam paket aplikasi hipotek, dan mendiskusikan metode yang digunakan untuk mengekstrak informasi darinya. Untuk setiap contoh ini, cuplikan kode dan contoh keluaran singkat disertakan.

Ekstrak data dari Unified Residential Loan Application URLA-1003

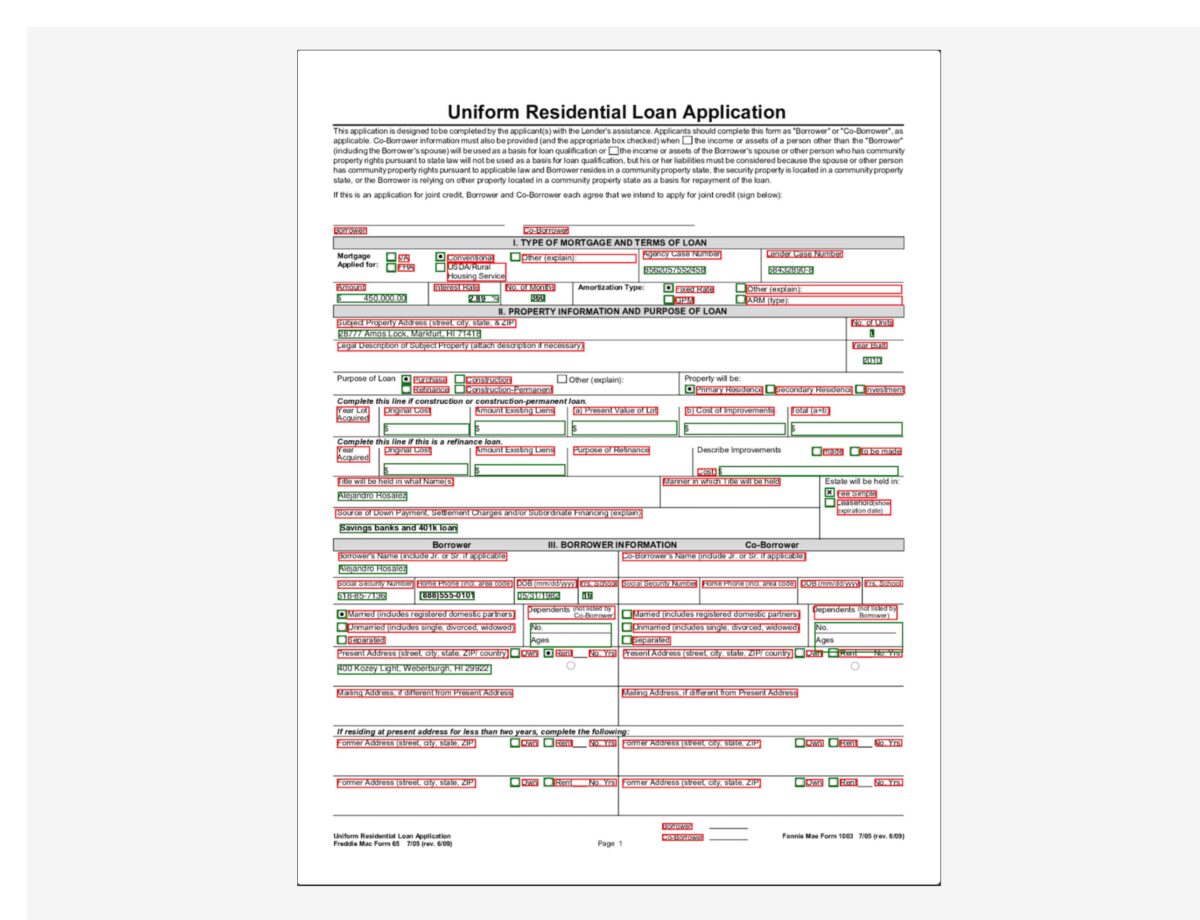

Aplikasi Pinjaman Perumahan Terpadu (URLA-1003) adalah formulir aplikasi pinjaman hipotek standar industri. Ini adalah dokumen yang cukup rumit yang berisi informasi tentang pemohon hipotek, jenis properti yang dibeli, jumlah yang dibiayai, dan rincian lain tentang sifat pembelian properti. Berikut ini adalah contoh URLA-1003, dan tujuan kami adalah mengekstrak informasi dari dokumen terstruktur ini. Karena ini adalah formulir, kami menggunakan API AnalisisDocument dengan tipe fitur FORMULIR.

Jenis fitur FORMULIR mengekstrak informasi formulir dari dokumen, yang kemudian dikembalikan dalam format pasangan nilai kunci. Cuplikan kode berikut menggunakan amazon-textract-textractor Pustaka Python untuk mengekstrak informasi formulir hanya dengan beberapa baris kode. Metode kenyamanan call_textract() memanggil AnalyzeDocument API secara internal, dan parameter yang diteruskan ke metode abstrak beberapa konfigurasi yang dibutuhkan API untuk menjalankan tugas ekstraksi. Document adalah metode praktis yang digunakan untuk membantu mengurai respons JSON dari API. Ini memberikan abstraksi tingkat tinggi dan membuat keluaran API dapat diubah dan mudah untuk mendapatkan informasi. Untuk informasi lebih lanjut, lihat Pengurai Respons Textract dan Teksraktor.

Perhatikan bahwa output berisi nilai untuk kotak centang atau tombol radio yang ada di formulir. Misalnya, dalam contoh dokumen URLA-1003, Pembelian pilihan dipilih. Output yang sesuai untuk tombol radio diekstraksi sebagai “Purchase” (kunci) dan “SELECTED” (nilai), menunjukkan bahwa tombol radio telah dipilih.

Ekstrak data dari 1099 formulir

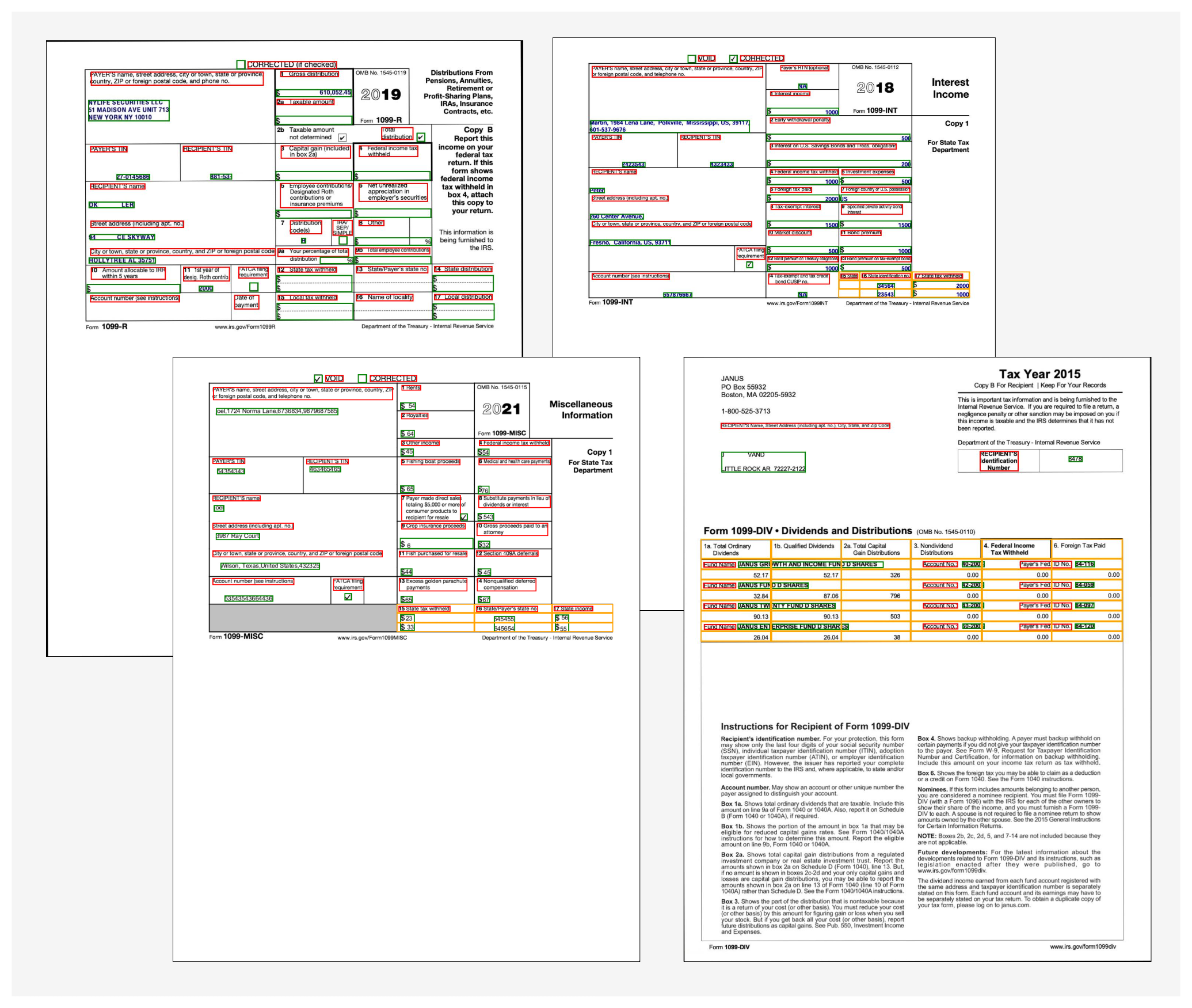

Paket aplikasi hipotek juga dapat berisi sejumlah dokumen IRS, seperti 1099-DIV, 1099-INT, 1099-MISC, dan 1099-R. Dokumen-dokumen ini menunjukkan pendapatan pemohon melalui bunga, dividen, dan komponen pendapatan lain-lain yang berguna selama penjaminan emisi untuk membuat keputusan. Gambar berikut menunjukkan kumpulan dokumen-dokumen ini, yang serupa dalam struktur. Namun, dalam beberapa kasus, dokumen berisi informasi formulir (ditandai dengan kotak pembatas merah dan hijau) serta informasi tabular (ditandai dengan kotak pembatas kuning).

Untuk mengekstrak informasi formulir, kami menggunakan kode serupa seperti yang dijelaskan sebelumnya dengan AnalyzeDocument API. Kami melewati fitur tambahan dari TABEL ke API untuk menunjukkan bahwa kita memerlukan data formulir dan tabel yang diekstrak dari dokumen. Cuplikan kode berikut menggunakan AnalyzeDocument API dengan fitur BENTUK dan TABEL pada dokumen 1099-INT:

Karena dokumen berisi satu tabel, output kodenya adalah sebagai berikut:

Informasi tabel berisi posisi sel (baris 0, kolom 0, dan seterusnya) dan teks terkait di dalam setiap sel. Kami menggunakan metode praktis yang dapat mengubah data tabel ini menjadi tampilan kisi yang mudah dibaca:

Kami mendapatkan output berikut:

Untuk mendapatkan output dalam format CSV yang mudah digunakan, jenis format Pretty_Print_Table_Format.csv dapat diteruskan ke table_format parameter. Format lain seperti TSV (nilai yang dipisahkan tab), HTML, dan Lateks juga didukung. Untuk informasi lebih lanjut, lihat Texttract-PrettyPrinter.

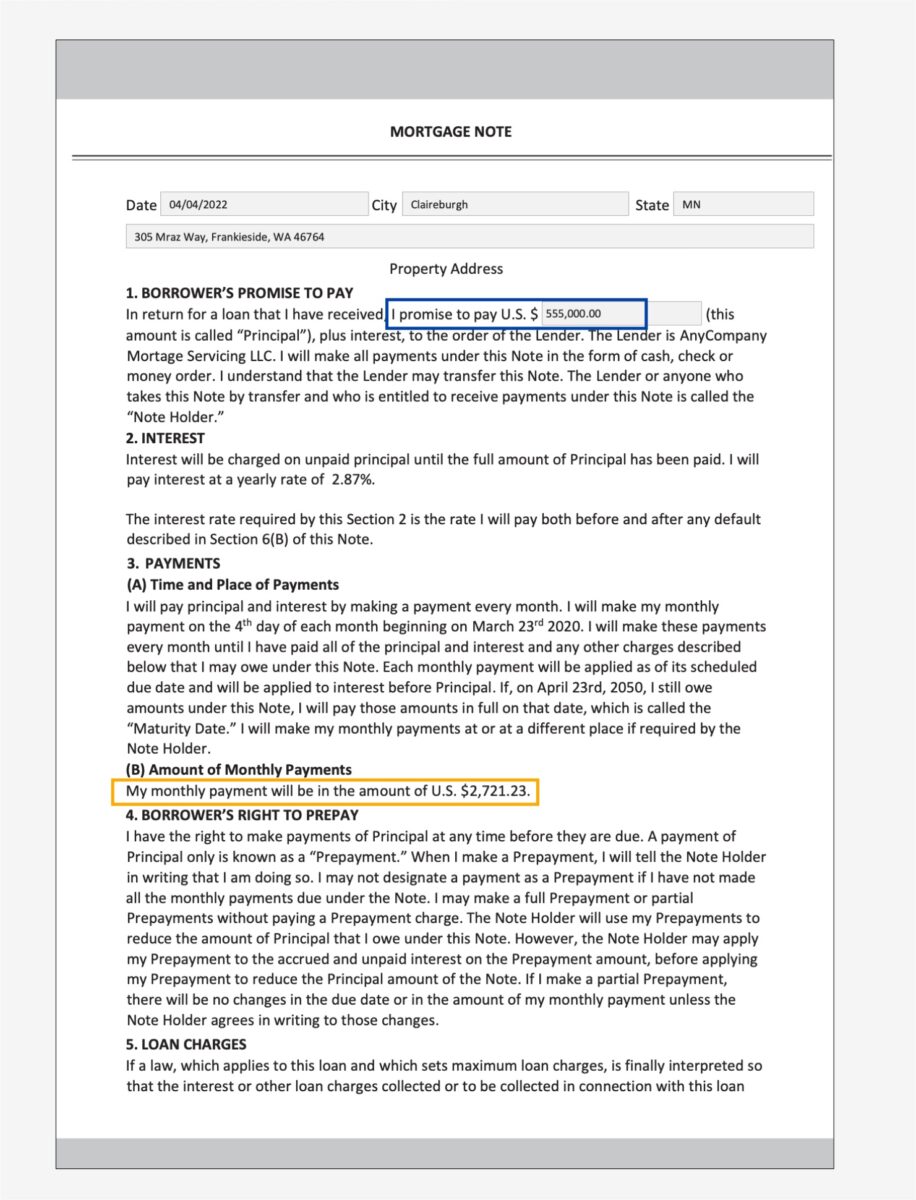

Ekstrak data dari catatan hipotek

Paket aplikasi hipotek mungkin berisi dokumen tidak terstruktur dengan teks padat. Beberapa contoh dokumen teks padat adalah kontrak dan perjanjian. Catatan hipotek adalah perjanjian antara pemohon hipotek dan pemberi pinjaman atau perusahaan hipotek, dan berisi informasi dalam paragraf teks padat. Dalam kasus seperti itu, kurangnya struktur membuat sulit untuk menemukan informasi bisnis utama yang penting dalam proses aplikasi hipotek. Ada dua pendekatan untuk memecahkan masalah ini:

Dalam contoh catatan hipotek berikut, kami secara khusus tertarik untuk mengetahui jumlah pembayaran bulanan dan jumlah pokok.

Untuk pendekatan pertama, kami menggunakan Query dan QueriesConfig metode praktis untuk mengonfigurasi serangkaian pertanyaan yang diteruskan ke Amazon Textract AnalyzeDocument panggilan API. Jika dokumennya multi-halaman (PDF atau TIFF), kami juga dapat menentukan nomor halaman tempat Amazon Textract harus mencari jawaban atas pertanyaan tersebut. Cuplikan kode berikut menunjukkan cara membuat konfigurasi kueri, membuat panggilan API, dan selanjutnya mengurai respons untuk mendapatkan jawaban dari respons:

Kami mendapatkan output berikut:

Untuk pendekatan kedua, kami menggunakan Amazon Comprehend DeteksiEntitas API dengan catatan hipotek, yang mengembalikan entitas yang dideteksi dalam teks dari a kumpulan entitas yang telah ditentukan sebelumnya. Ini adalah entitas yang telah dilatih oleh pengenal entitas Amazon Comprehend. Namun, karena persyaratan kami adalah mendeteksi entitas tertentu, pengenal entitas kustom Amazon Comprehend dilatih dengan sekumpulan contoh dokumen nota hipotek, dan daftar entitas. Kami mendefinisikan nama entitas sebagai PRINCIPAL_AMOUNT dan MONTHLY_AMOUNT. Data pelatihan disiapkan setelah pelatihan Amazon Comprehend pedoman persiapan data untuk pengakuan entitas kustom. Pengenal entitas dapat dilatih dengan anotasi dokumen atau dengan daftar entitas. Untuk tujuan contoh ini, kami menggunakan daftar entitas untuk melatih model. Setelah kami melatih modelnya, kami dapat menerapkannya dengan titik akhir waktu nyata atau di mode batch untuk mendeteksi dua entitas dari isi dokumen. Berikut ini adalah langkah-langkah yang terlibat untuk melatih pengenal entitas kustom dan menerapkannya. Untuk panduan kode lengkap, lihat repositori GitHub kami.

- Siapkan data pelatihan (daftar entitas dan dokumen dengan format teks biasa (dikodekan UTF-8)).

- Mulai pelatihan pengenal entitas menggunakan BuatEntityRecognizer API menggunakan data pelatihan.

- Terapkan model terlatih dengan titik akhir waktu nyata menggunakan Buat Titik Akhir API.

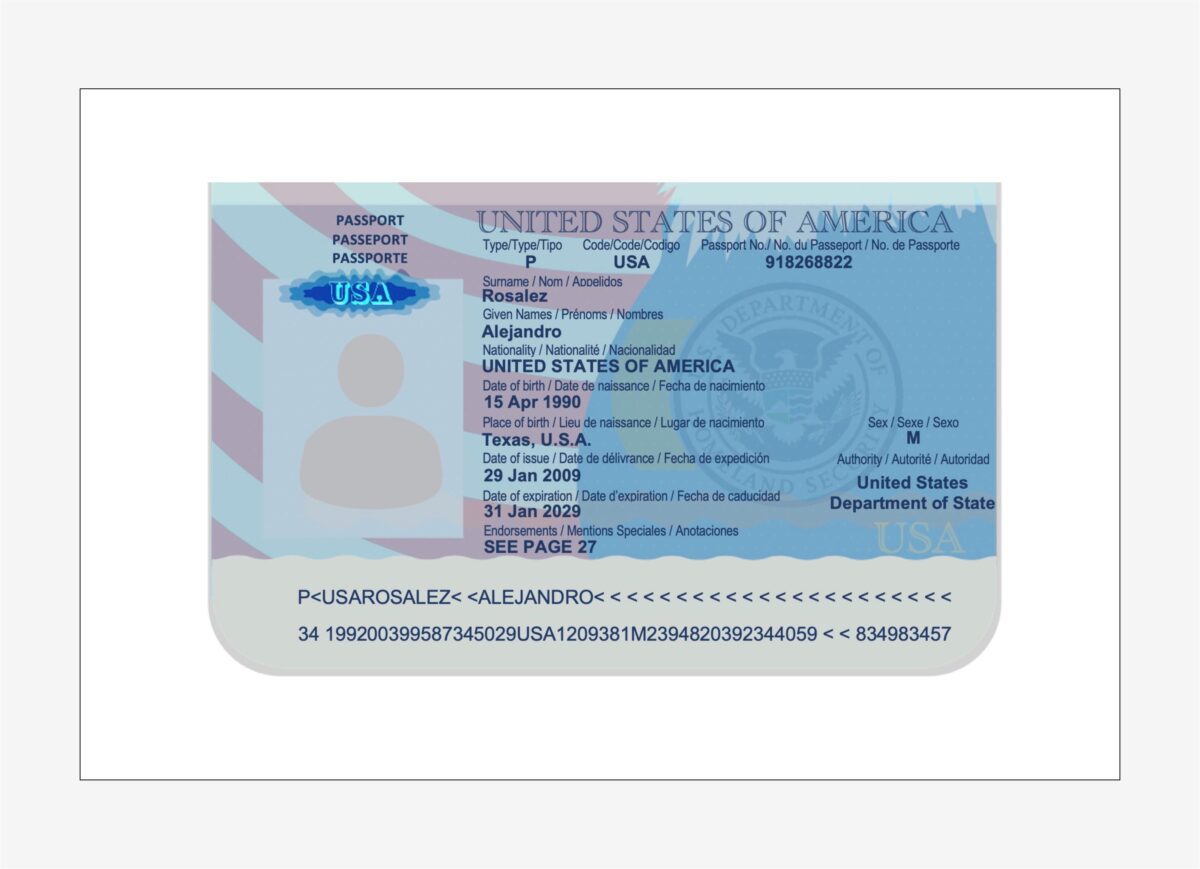

Ekstrak data dari paspor AS

Teks Amazon menganalisis dokumen identitas kemampuan dapat mendeteksi dan mengekstrak informasi dari dokumen ID yang berbasis di AS seperti SIM dan paspor. Itu AnalyzeID API mampu mendeteksi dan menafsirkan bidang tersirat dalam dokumen ID, yang memudahkan untuk mengekstrak informasi spesifik dari dokumen. Dokumen identitas hampir selalu menjadi bagian dari paket aplikasi hipotek, karena digunakan untuk memverifikasi identitas peminjam selama proses penjaminan, dan untuk memvalidasi kebenaran data biografi peminjam.

Kami menggunakan metode kenyamanan bernama call_textract_analyzeid, yang menyebut AnalyzeID API secara internal. Kami kemudian mengulangi respons untuk mendapatkan pasangan nilai kunci yang terdeteksi dari dokumen ID. Lihat kode berikut:

AnalyzeID mengembalikan informasi dalam struktur yang disebut IdentityDocumentFields, yang berisi kunci yang dinormalisasi dan nilainya yang sesuai. Misalnya, pada keluaran berikut, FIRST_NAME adalah kunci yang dinormalisasi dan nilainya adalah ALEJANDRO. Dalam contoh gambar paspor, bidang untuk nama depan diberi label sebagai “Nama yang Diberikan / Prénoms / Nombre,” namun AnalyzeID dapat menormalkannya menjadi nama kunci FIRST_NAME. Untuk daftar bidang normalisasi yang didukung, lihat Objek Respons Dokumentasi Identitas.

Paket hipotek mungkin berisi beberapa dokumen lain, seperti slip gaji, formulir W2, pernyataan bank, pernyataan kartu kredit, dan surat verifikasi pekerjaan. Kami memiliki sampel untuk masing-masing dokumen ini bersama dengan kode yang diperlukan untuk mengekstrak data dari mereka. Untuk basis kode lengkap, lihat buku catatan di . kami Repositori GitHub.

Pengayaan dokumen

Salah satu bentuk pengayaan dokumen yang paling umum adalah redaksi informasi sensitif atau rahasia pada dokumen, yang mungkin diamanatkan karena undang-undang atau peraturan privasi. Misalnya, paystub pemohon hipotek mungkin berisi data PII sensitif, seperti nama, alamat, dan SSN, yang mungkin perlu diedit untuk penyimpanan yang diperpanjang.

Pada contoh dokumen paystub sebelumnya, kami melakukan redaksi data PII seperti SSN, nama, nomor rekening bank, dan tanggal. Untuk mengidentifikasi data PII dalam dokumen, kami menggunakan Amazon Comprehend Deteksi PII kemampuan melalui DeteksiPIIIEntitas API. API ini memeriksa konten dokumen untuk mengidentifikasi keberadaan informasi PII. Karena API ini memerlukan input dalam format teks biasa yang disandikan UTF-8, pertama-tama kami mengekstrak teks dari dokumen menggunakan Amazon Textract DeteksiTeks Dokumen API, yang mengembalikan teks dari dokumen dan juga mengembalikan informasi geometri seperti dimensi dan koordinat kotak pembatas. Kombinasi dari kedua keluaran tersebut kemudian digunakan untuk menggambar redaksi pada dokumen sebagai bagian dari proses pengayaan.

Tinjau, validasi, dan integrasikan data

Data yang diekstraksi dari fase ekstraksi dokumen mungkin memerlukan validasi terhadap aturan bisnis tertentu. Informasi spesifik juga dapat divalidasi di beberapa dokumen, juga dikenal sebagai validasi lintas dokumen. Contoh validasi lintas dokumen dapat membandingkan nama pemohon dalam dokumen ID dengan nama dalam dokumen aplikasi hipotek. Anda juga dapat melakukan validasi lain seperti estimasi nilai properti dan keputusan underwriting bersyarat pada fase ini.

Jenis validasi ketiga terkait dengan skor kepercayaan dari data yang diekstraksi dalam fase ekstraksi dokumen. Amazon Textract dan Amazon Comprehend mengembalikan skor kepercayaan untuk formulir, tabel, data teks, dan entitas yang terdeteksi. Anda dapat mengonfigurasi ambang batas skor keyakinan untuk memastikan bahwa hanya nilai yang benar yang dikirim ke hilir. Ini dicapai melalui Amazon A2I, yang membandingkan skor kepercayaan data yang terdeteksi dengan ambang batas kepercayaan yang telah ditentukan sebelumnya. Jika ambang batas tidak terpenuhi, dokumen dan output yang diekstrak akan diarahkan ke manusia untuk ditinjau melalui UI intuitif. Peninjau mengambil tindakan korektif pada data dan menyimpannya untuk diproses lebih lanjut. Untuk informasi lebih lanjut, lihat Konsep Inti Amazon A2I.

Kesimpulan

Dalam posting ini, kami membahas fase pemrosesan dokumen cerdas yang terkait dengan fase aplikasi hipotek. Kami melihat beberapa contoh umum dari dokumen yang dapat ditemukan dalam paket aplikasi hipotek. Kami juga membahas cara mengekstraksi dan memproses konten terstruktur, semi-terstruktur, dan tidak terstruktur dari dokumen-dokumen ini. IDP menyediakan cara untuk mengotomatisasi pemrosesan dokumen hipotek end-to-end yang dapat diskalakan ke jutaan dokumen, meningkatkan kualitas keputusan aplikasi, mengurangi biaya, dan melayani pelanggan lebih cepat.

Sebagai langkah selanjutnya, Anda dapat mencoba contoh kode dan buku catatan di . kami Repositori GitHub. Untuk mempelajari lebih lanjut tentang bagaimana IDP dapat membantu beban kerja pemrosesan dokumen Anda, kunjungi Otomatisasi pemrosesan data dari dokumen.

Tentang penulis

Anjan Biswas adalah Arsitek Solusi Layanan AI Senior dengan fokus pada AI/ML dan Analisis Data. Anjan adalah bagian dari tim layanan AI di seluruh dunia dan bekerja dengan pelanggan untuk membantu mereka memahami, dan mengembangkan solusi untuk masalah bisnis dengan AI dan ML. Anjan memiliki lebih dari 14 tahun pengalaman bekerja dengan rantai pasokan global, manufaktur, dan organisasi ritel dan secara aktif membantu pelanggan memulai dan meningkatkan layanan AWS AI.

Anjan Biswas adalah Arsitek Solusi Layanan AI Senior dengan fokus pada AI/ML dan Analisis Data. Anjan adalah bagian dari tim layanan AI di seluruh dunia dan bekerja dengan pelanggan untuk membantu mereka memahami, dan mengembangkan solusi untuk masalah bisnis dengan AI dan ML. Anjan memiliki lebih dari 14 tahun pengalaman bekerja dengan rantai pasokan global, manufaktur, dan organisasi ritel dan secara aktif membantu pelanggan memulai dan meningkatkan layanan AWS AI.

Dwiti Pathak adalah Manajer Akun Teknis Senior yang berbasis di San Diego. Dia fokus membantu industri Semikonduktor terlibat dalam AWS. Di waktu luangnya, dia suka membaca tentang teknologi baru dan bermain permainan papan.

Dwiti Pathak adalah Manajer Akun Teknis Senior yang berbasis di San Diego. Dia fokus membantu industri Semikonduktor terlibat dalam AWS. Di waktu luangnya, dia suka membaca tentang teknologi baru dan bermain permainan papan.

Balaji Puli adalah Arsitek Solusi yang berbasis di Bay Area, CA. Saat ini membantu pelanggan ilmu kehidupan perawatan kesehatan AS Barat Laut tertentu mempercepat adopsi cloud AWS mereka. Balaji senang bepergian dan suka menjelajahi berbagai masakan.

Balaji Puli adalah Arsitek Solusi yang berbasis di Bay Area, CA. Saat ini membantu pelanggan ilmu kehidupan perawatan kesehatan AS Barat Laut tertentu mempercepat adopsi cloud AWS mereka. Balaji senang bepergian dan suka menjelajahi berbagai masakan.

- Lanjutan (300)

- AI

- ai seni

- generator seni ai

- punya robot

- Amazon Comprehend

- Teks Amazon

- kecerdasan buatan

- sertifikasi kecerdasan buatan

- kecerdasan buatan dalam perbankan

- robot kecerdasan buatan

- robot kecerdasan buatan

- perangkat lunak kecerdasan buatan

- Pembelajaran Mesin AWS

- blockchain

- konferensi blockchain

- kecerdasan

- kecerdasan buatan percakapan

- konferensi kripto

- dall's

- belajar mendalam

- google itu

- Mesin belajar

- plato

- plato ai

- Kecerdasan Data Plato

- Permainan Plato

- Data Plato

- permainan plato

- skala ai

- sintaksis

- zephyrnet.dll