Ya.. Saya berbicara tentang aplikasi AI – banyak aplikasi AI kami dan yang akan datang membisikkan kepada manusia tentang apa yang harus dilakukan…. bagaimana melakukannya… tetapi bukan tentang pembisik yang berinteraksi dengan AI chatbots.

Menurut IDC prediksi, pasar AI global dapat mencapai lebih dari $500 miliar pada tahun 2024 – peningkatan lebih dari 50% dari tahun 2021. Ini menunjukkan bahwa kami beralih dari eksperimen bisnis ke menerima bahwa ini adalah bagian integral dari strategi perusahaan untuk semua ukuran. Ini adalah alat yang diperlukan untuk mengubah data menjadi wawasan untuk memicu tindakan berdasarkan keputusan yang lebih baik. Tidak ada yang memperdebatkan manfaat AI untuk mengurangi risiko bisnis dan meningkatkan ROI dengan inovasi. Tapi, seperti biasa, ada …TAPI… AI yang tidak memihak lebih mudah diucapkan daripada dilakukan.

Penting bagi bisnis, model AI ini perlu beroperasi secara andal dengan visibilitas dan akuntabilitas. Jika tidak, kegagalan, dalam hal ini, memiliki konsekuensi mengerikan yang berdampak pada arus kas perusahaan mana pun dan bahkan mungkin mengakibatkan masalah hukum. Satu-satunya cara untuk menghindari ini adalah otomatisasi dan transparansi untuk menjawab satu pertanyaan "Dapatkah Anda membuktikan bahwa aplikasi/beban kerja AI ini dibangun secara etis." Aka…bagaimana caramu memerintah? Dan dapatkah Anda membuktikan bahwa itu diatur terus menerus?

Di sinilah perusahaan suka IBM telah berinvestasi dalam tata kelola AI untuk mengatur keseluruhan proses dalam mengarahkan, mengelola, dan memantau aktivitas AI organisasi. Tugas utamanya adalah memastikan semua unit bisnis tetap proaktif dan memasukkan kerangka kerja tata kelola ke dalam inisiatif untuk memperkuat kemampuan memenuhi prinsip dan peraturan etika. Terutama, industri yang diatur seperti Perbankan dan jasa keuangan diwajibkan secara hukum untuk memberikan bukti untuk memuaskan regulator.

Pengaruh AI tumbuh secara eksponensial di sektor jasa keuangan karena tekanan luar biasa dari transformasi digital. Seperti yang dikatakan, lebih mudah diucapkan daripada dilakukan karena:

1. Mengoperasikan aplikasi AI dengan percaya diri:

Dalam beberapa kasus, model dibangun tanpa kejelasan dan katalogisasi; tidak perlu dikatakan lagi, pemantauan menyelinap di tengah-tengah segalanya untuk melacak siklus hidup ujung ke ujung. Sementara bank berjuang dengan aplikasi lama, mengotomatiskan proses untuk menciptakan transparansi dan penjelasan menjadi lebih sulit dan, pada gilirannya, menjadi kotak hitam. Tidak ada yang tahu mengapa / bagaimana keputusan dibuat. Aplikasi baru yang terjerat dengan aplikasi lawas tidak pernah melihat siang hari meskipun ROI yang besar dikaitkan dengannya karena kualitas dan risiko yang tidak dirasakan.

Itu membawa kita ke poin kedua – mengelola risiko reputasi

2. Mengelola risiko Reputasi beserta keseluruhan risikonya

saya telah bertanya #obrolanGPT dan #Penyair – siapa Padma Chukka. #ObrolanGPT menolak untuk menjawab meskipun saya mengubah pertanyaan dengan berbagai cara. Tetap saja, Bard memberi saya jawaban terperinci, termasuk profil LinkedIn saya… tetapi data berasal dari berbagai situs di mana profil lama saya masih ada sebagai bagian dari bio speaker. Sejak saat itu, saya belum membuka Bard. Secepat itu, saya dimatikan, alias – Risiko reputasi. Misalkan saya dapat mematikan chatbot sederhana ketika saya menyadari bahwa datanya mungkin tidak konsisten. Bagaimana mungkin saya tidak memastikan sebelum memutuskan untuk membeli aplikasi yang diresapi AI untuk menjalankan bisnis penting? Risiko reputasi merupakan faktor penting yang terkadang dilupakan oleh perusahaan. Jika Anda mengukur risiko reputasi, orang dapat melihat dampak yang luar biasa pada bisnis jika tidak proaktif.

Untuk menambah kerumitan, yang ketiga adalah…

3. Bagaimana perusahaan menanggapi perubahan peraturan AI?

Untuk menghindari risiko reputasi, tim AI yang sukses dan bertanggung jawab harus mengetahui setiap peraturan lokal dan global, yang dirilis seperti video tik-tok dengan pemberitahuan sesaat. Dan ketidakpatuhan pada akhirnya dapat merugikan organisasi dengan denda jutaan dolar di sekitar pekerjaan seperti Undang-Undang Kecerdasan Buatan Uni Eropa yang diusulkan. Mungkin sampai 30 juta Euro atau 6% dari pendapatan global perusahaan – OUCH.

Yah, tidak semuanya harus cerah saat bepergian… selama kita tahu cara mengubah situasi dari menakutkan menjadi cerah.

Tidak mengherankan… selalu tentang orang, proses, dan teknologi. Jadi pertama-tama, buat badan pengatur lintas fungsi untuk mendidik, mengarahkan, dan memantau inisiatif berdasarkan tujuan. Kemudian tolok ukur teknologi dan proses AI saat ini, pahami celahnya, lalu perbaiki untuk pembuktian di masa mendatang. Kemudian gunakan serangkaian alur kerja tata kelola otomatis yang sejalan dengan persyaratan kepatuhan. Terakhir, atur sistem pemantauan untuk memperingatkan pemilik jika ambang batas yang dapat diterima semakin dekat. Dari sisi Teknologi, AI yang dirancang dengan baik, dijalankan dengan baik, dan terhubung dengan baik memerlukan banyak blok bangunan. Dan pastikan itu memiliki beberapa atau semua kemampuan:

· Integritas data di berbagai penerapan

· Gunakan alat yang terbuka dan fleksibel yang mematuhi Tata Kelola AI

· Pastikan untuk menawarkan akses swalayan dengan kontrol privasi – cara untuk melacak

· Desain dengan mempertimbangkan otomatisasi dan tata kelola AI

· Dapat terhubung dan dapat disesuaikan untuk berbagai pemangku kepentingan melalui alur kerja yang dapat disesuaikan

Setelah kami mengubah aplikasi dari menakutkan menjadi Rosy… maka pertanyaan selanjutnya adalah bagaimana Anda membuktikan…

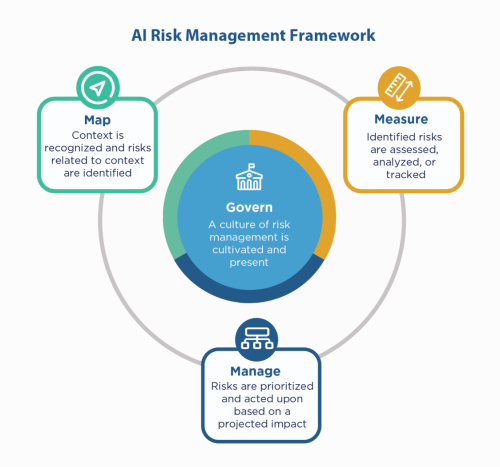

Pertama, kembali ke prinsip-prinsip AI perusahaan – bangun dengan prinsip-prinsip tersebut, namun Anda masih perlu "menunjukkan" bahwa Anda patuh, terutama di lingkungan yang diatur seperti Layanan Keuangan. Karena layanan keuangan harus mengeluh dengan NIST 800-53, mereka dapat melihat Kerangka Manajemen Risiko AI NIST (AI RMF). NIST menyarankan kontrol dalam empat keluarga – Atur, Petakan, Ukur, dan Kelola. Menggunakannya sebagai faktor pemandu dan uji stres aplikasi untuk mengidentifikasi celah yang perlu diperbaiki dan dipantau.

IBM dapat memvalidasi model Anda sebelum Anda memasukkannya ke dalam produksi, dan dapat dipantau untuk keadilan, kualitas, dan penyimpangan. Itu juga dapat memberikan dokumentasi yang menjelaskan perilaku dan prediksi model untuk memenuhi persyaratan regulator dan auditor. Penjelasan ini dapat memberikan visibilitas dan meringankan kesulitan audit, serta meningkatkan transparansi dan kemampuan untuk menentukan risiko yang mungkin terjadi.

Dengarkan bisikan AI itu dengan percaya diri!

#Layanan Keuangan #bertanggung jawabai #ethicalai #NISAIRMF

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- Platoblockchain. Intelijen Metaverse Web3. Pengetahuan Diperkuat. Akses Di Sini.

- Mencetak Masa Depan bersama Adryenn Ashley. Akses Di Sini.

- Sumber: https://www.finextra.com/blogposting/24053/the-costly-consequences-of-unethical-ai-whisperer?utm_medium=rssfinextra&utm_source=finextrablogs

- :adalah

- $NAIK

- 2021

- 2024

- 7

- a

- kemampuan

- Tentang Kami

- diterima

- mengakses

- akuntabilitas

- di seluruh

- Bertindak

- Tindakan

- kegiatan

- mengikuti

- AI

- UU AI

- Tata kelola AI

- alias

- Waspada

- Semua

- selalu

- dan

- menjawab

- aplikasi

- Aplikasi

- aplikasi

- aplikasi

- ADALAH

- sekitar

- AS

- terkait

- At

- Audit

- auditor

- Otomatis

- mengotomatisasi

- Otomatisasi

- kembali

- Perbankan

- Bank

- berdasarkan

- BE

- karena

- sebelum

- makhluk

- patokan

- Manfaat

- Lebih baik

- Milyar

- Black

- Blok

- tubuh

- Kotak

- Membawa

- membangun

- Bangunan

- dibangun di

- bisnis

- membeli

- by

- CAN

- kemampuan

- kasus

- kasus

- Uang tunai

- arus kas

- mengubah

- ChatBot

- chatbots

- kejelasan

- penutupan

- Perusahaan

- perusahaan

- kompleksitas

- pemenuhan

- compliant

- Mengadakan

- dengan penuh percaya diri

- Terhubung

- Konsekuensi

- terus menerus

- kontrol

- Biaya

- bisa

- membuat

- kritis

- terbaru

- disesuaikan

- siklus

- data

- berdebat

- Memutuskan

- keputusan

- mengurangi

- Mendesain

- terperinci

- Menentukan

- digital

- Transformasi digital

- mengerikan

- langsung

- Mengarahkan

- beberapa

- dokumentasi

- dolar

- Jatuhan

- mudah

- mendidik

- ujung ke ujung

- memastikan

- Enterprise

- lingkungan

- terutama

- penting

- etis

- EU

- Euro

- Bahkan

- Setiap

- segala sesuatu

- bukti

- ada

- ada

- menjelaskan

- eksponensial

- Kegagalan

- keadilan

- Jatuh

- keluarga

- Akhirnya

- keuangan

- jasa keuangan

- akhir

- tambahan

- Pertama

- fleksibel

- aliran

- Untuk

- Kerangka

- dari

- dari 2021

- masa depan

- Memberikan

- Aksi

- pemerintahan

- Pertumbuhan

- Memiliki

- Seterpercayaapakah Olymp Trade? Kesimpulan

- How To

- HTTPS

- besar

- Manusia

- i

- mengenali

- Dampak

- in

- Termasuk

- Meningkatkan

- menunjukkan

- industri

- mempengaruhi

- inisiatif

- Innovation

- wawasan

- integral

- integritas

- berinteraksi

- diinvestasikan

- IT

- NYA

- Pekerjaan

- Tahu

- Warisan

- Informasi

- masalah hukum

- Hidup

- 'like'

- baris

- lokal

- Panjang

- melihat

- terbuat

- membuat

- mengelola

- pengelolaan

- pelaksana

- peta

- Pasar

- Hal-hal

- Mungkin..

- mengukur

- Pelajari

- mungkin

- juta

- jutaan

- model

- model

- saat

- Memantau

- dipantau

- pemantauan

- lebih

- beberapa

- perlu

- Perlu

- Tidak perlu

- New

- berikutnya

- nisan

- target

- of

- menawarkan

- Tua

- on

- ONE

- Buka

- beroperasi

- organisasi

- jika tidak

- secara keseluruhan

- pemilik

- Sakit

- bagian

- Konsultan Ahli

- plato

- Kecerdasan Data Plato

- Data Plato

- Titik

- mungkin

- Prediksi

- tekanan

- primer

- prinsip-prinsip

- pribadi

- Proaktif

- proses

- proses

- Produksi

- Profil

- bukti

- diusulkan

- Rasakan itu

- memberikan

- menempatkan

- kualitas

- pertanyaan

- segera

- mencapai

- menyadari

- beregulasi

- industri yang diatur

- Regulasi

- peraturan

- Regulator

- reputasi

- wajib

- Persyaratan

- membutuhkan

- Menanggapi

- tanggung jawab

- mengakibatkan

- pendapatan

- Risiko

- manajemen risiko

- risiko

- ROI

- Cerah

- s

- Tersebut

- Kedua

- sektor

- Swalayan

- Layanan

- set

- harus

- Menunjukkan

- sisi

- Sederhana

- sejak

- Situs

- situasi

- ukuran

- So

- beberapa

- percikan

- Pembicara

- stakeholder

- tinggal

- Masih

- Penyelarasan

- Memperkuat

- tekanan

- Berjuang

- sukses

- sistem

- pembicaraan

- tim

- Teknologi

- uji

- bahwa

- Grafik

- Mereka

- Ini

- Ketiga

- ambang

- Melalui

- untuk

- alat

- alat

- jalur

- Transformasi

- Transparansi

- dahsyat

- MENGHIDUPKAN

- Berbalik

- Akhirnya

- memahami

- unit

- mendatang

- us

- menggunakan

- MENGESAHKAN

- berbagai

- Video

- jarak penglihatan

- Cara..

- cara

- Apa

- sementara

- SIAPA

- dengan

- tanpa

- Kerja

- Alur kerja

- Kamu

- Anda

- zephyrnet.dll