Pernah melihat bayi kijang belajar berjalan? Anak rusa, yang pada dasarnya adalah ayah mamalia berkaki panjang, merangkak berdiri, jatuh, berdiri, dan jatuh lagi. Akhirnya, ia berdiri cukup lama untuk mengayunkan kakinya yang seperti tusuk gigi ke dalam serangkaian air terjun yang hampir jatuh… ahem, langkah. Hebatnya, beberapa menit setelah pertunjukan yang menawan ini, anak rusa itu melompat-lompat seperti seorang profesional tua.

Nah, sekarang kami memiliki versi robot dari adegan Serengeti klasik ini.

Anak rusa dalam hal ini adalah anjing robotik di University of California, Berkeley. Dan itu juga merupakan pembelajar yang sangat cepat (relatif terhadap jenis robot lainnya). Robot ini juga istimewa karena, tidak seperti robot mencolok lainnya yang mungkin pernah Anda lihat secara online, robot ini menggunakan kecerdasan buatan untuk mengajari dirinya sendiri cara berjalan.

Mulai dari punggungnya, kaki melambai, robot belajar membalik dirinya, berdiri, dan berjalan dalam satu jam. Sepuluh menit lagi pelecehan dengan gulungan karton sudah cukup untuk mengajarinya bagaimana bertahan dan pulih dari didorong oleh penangannya.

Ini bukan pertama kalinya robot telah menggunakan kecerdasan buatan untuk belajar berjalan. Tapi sementara robot sebelumnya mempelajari keterampilan dengan coba-coba melalui iterasi yang tak terhitung jumlahnya dalam simulasi, bot Berkeley belajar sepenuhnya di dunia nyata.

[Embedded content]

Di sebuah kertas diterbitkan di server pracetak arXiv, para peneliti—Danijar Hafner, Alejandro Escontrela, dan Philipp Wu—mengatakan bahwa mentransfer algoritme yang telah dipelajari dalam simulasi ke dunia nyata tidaklah mudah. Detail kecil dan perbedaan antara dunia nyata dan simulasi dapat membuat robot pemula tersandung. Di sisi lain, algoritme pelatihan di dunia nyata tidak praktis: Ini akan memakan terlalu banyak waktu dan keausan.

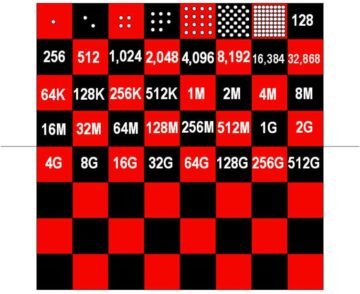

Empat tahun lalu, misalnya, OpenAI memamerkan tangan robot berkemampuan AI yang dapat memanipulasi kubus. Algoritme kontrol, Dactyl, membutuhkan pengalaman selama 100 tahun dalam simulasi yang didukung oleh 6,144 CPU dan 8 GPU Nvidia V100 untuk menyelesaikan tugas yang relatif sederhana ini. Banyak hal telah berkembang sejak itu, tetapi masalahnya sebagian besar tetap ada. Algoritme pembelajaran penguatan murni membutuhkan terlalu banyak percobaan dan kesalahan untuk mempelajari keterampilan agar dapat dilatih di dunia nyata. Sederhananya, proses pembelajaran akan menghancurkan peneliti dan robot sebelum membuat kemajuan yang berarti.

Tim Berkeley berangkat untuk memecahkan masalah ini dengan algoritma yang disebut Dreamer. Membangun apa yang disebut "model dunia, Pemimpi dapat memproyeksikan kemungkinan tindakan di masa depan akan mencapai tujuannya. Dengan pengalaman, akurasi proyeksinya meningkat. Dengan menyaring tindakan yang kurang berhasil sebelumnya, model dunia memungkinkan robot untuk lebih efisien mencari tahu apa yang berhasil.

“Mempelajari model dunia dari pengalaman masa lalu memungkinkan robot membayangkan hasil masa depan dari tindakan potensial, mengurangi jumlah coba-coba di lingkungan nyata yang diperlukan untuk mempelajari perilaku yang sukses,” tulis para peneliti. “Dengan memprediksi hasil di masa depan, model dunia memungkinkan perencanaan dan pembelajaran perilaku yang diberikan hanya sejumlah kecil interaksi dunia nyata.”

Dengan kata lain, model dunia dapat mengurangi waktu pelatihan yang setara dengan tahun dalam simulasi menjadi tidak lebih dari satu jam canggung di dunia nyata.

Pendekatan ini mungkin memiliki relevansi yang lebih luas daripada anjing robot juga. Tim juga menerapkan Dreamer ke lengan robot pick-and-place dan robot beroda. Dalam kedua kasus tersebut, mereka menemukan bahwa Dreamer mengizinkan robot mereka mempelajari keterampilan yang relevan secara efisien, tanpa memerlukan waktu sim. Aplikasi masa depan yang lebih ambisius mungkin termasuk mobil self-driving.

Tentu masih ada tantangan yang harus dihadapi. Meskipun pembelajaran penguatan mengotomatiskan beberapa pengkodean tangan yang rumit di balik robot paling canggih saat ini, itu masih membutuhkan insinyur untuk menentukan tujuan robot dan apa yang merupakan kesuksesan — latihan yang memakan waktu dan terbuka untuk lingkungan dunia nyata. Juga, meskipun robot selamat dari eksperimen tim di sini, pelatihan yang lebih lama pada keterampilan yang lebih maju mungkin terbukti terlalu banyak bagi bot masa depan untuk bertahan hidup tanpa kerusakan. Para peneliti mengatakan mungkin bermanfaat untuk menggabungkan pelatihan simulator dengan pembelajaran dunia nyata yang cepat.

Namun, hasilnya memajukan AI dalam robotika langkah lain. Dreamer memperkuat kasus bahwa "pembelajaran penguatan akan menjadi alat landasan di masa depan kontrol robot," Jonathan Hurst, seorang profesor robotika di Oregon State University mengatakan MIT Technology Review.

Gambar Kredit: Danijar Hafner / Youtube