Dalam upaya kita untuk membatasi potensi destruktif dari kecerdasan buatan, sebuah makalah baru dari Universitas Cambridge menyarankan untuk memasukkan saklar mematikan dan penguncian jarak jauh, seperti yang dikembangkan untuk menghentikan peluncuran senjata nuklir tanpa izin, ke dalam perangkat keras yang menggerakkannya.

Kertas [PDF], yang mencakup suara-suara dari berbagai institusi akademis dan beberapa dari OpenAI, menyatakan bahwa mengatur perangkat keras yang diandalkan oleh model ini mungkin merupakan cara terbaik untuk mencegah penyalahgunaannya.

“Komputasi yang relevan dengan AI adalah titik intervensi yang sangat efektif: Komputasi ini dapat dideteksi, dikecualikan, dan dapat diukur, serta diproduksi melalui rantai pasokan yang sangat terkonsentrasi,” argumen para peneliti.

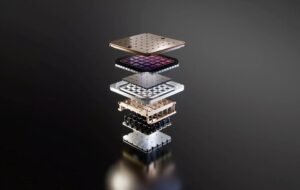

Melatih model paling produktif, yang diyakini melebihi satu triliun parameter, memerlukan infrastruktur fisik yang sangat besar: puluhan ribu GPU atau akselerator dan waktu pemrosesan berminggu-minggu atau bahkan berbulan-bulan. Hal ini, kata para peneliti, membuat keberadaan dan kinerja relatif sumber daya tersebut sulit disembunyikan.

Terlebih lagi, chip paling canggih yang digunakan untuk melatih model-model ini diproduksi oleh sejumlah kecil perusahaan, seperti Nvidia, AMD, dan Intel, sehingga memungkinkan pembuat kebijakan untuk membatasi penjualan barang-barang tersebut kepada orang atau negara yang menjadi perhatian.

Faktor-faktor ini, bersama dengan faktor-faktor lain seperti kendala rantai pasokan pada manufaktur semikonduktor, menawarkan kepada pembuat kebijakan cara untuk lebih memahami bagaimana dan di mana infrastruktur AI diterapkan, siapa yang boleh dan tidak boleh mengaksesnya, dan menerapkan hukuman atas penyalahgunaannya, menurut makalah tersebut. .

Mengendalikan infrastruktur

Makalah ini menyoroti berbagai cara yang dapat diambil oleh pembuat kebijakan dalam melakukan pendekatan terhadap regulasi perangkat keras AI. Banyak saran – termasuk yang dirancang untuk meningkatkan visibilitas dan membatasi penjualan akselerator AI – sudah diterapkan di tingkat nasional.

Tahun lalu Presiden AS Joe Biden mengajukan sebuah perintah eksekutif bertujuan untuk mengidentifikasi perusahaan yang mengembangkan model AI penggunaan ganda yang besar serta vendor infrastruktur yang mampu melakukannya melatih mereka. Jika Anda belum familiar, “penggunaan ganda” mengacu pada teknologi yang dapat melakukan tugas ganda dalam aplikasi sipil dan militer.

Baru-baru ini, Departemen Perdagangan AS diusulkan peraturan yang mengharuskan penyedia cloud Amerika untuk menerapkan kebijakan “kenali pelanggan Anda” yang lebih ketat untuk mencegah orang atau negara yang menjadi perhatian untuk menghindari pembatasan ekspor.

Para peneliti mencatat, visibilitas seperti ini sangat berharga karena dapat membantu menghindari perlombaan senjata lainnya, seperti yang dipicu oleh kontroversi celah rudal, di mana laporan yang salah menyebabkan penumpukan rudal balistik secara besar-besaran. Meskipun bermanfaat, mereka memperingatkan bahwa pelaksanaan persyaratan pelaporan ini berisiko melanggar privasi pelanggan dan bahkan menyebabkan kebocoran data sensitif.

Sementara itu, di bidang perdagangan, Departemen Perdagangan terus melakukan hal yang sama melangkah pembatasan, membatasi kinerja akselerator yang dijual ke Tiongkok. Namun, seperti yang telah kami laporkan sebelumnya, meskipun upaya ini mempersulit negara-negara seperti Tiongkok untuk mendapatkan chip Amerika, upaya tersebut masih jauh dari sempurna.

Untuk mengatasi keterbatasan ini, para peneliti telah mengusulkan penerapan pencatatan global untuk penjualan chip AI yang akan melacaknya sepanjang siklus hidupnya, bahkan setelah mereka meninggalkan negara asalnya. Registri seperti itu, menurut mereka, dapat memasukkan pengenal unik ke dalam setiap chip, yang dapat membantu memerangi penyelundupan dari komponen.

Pada spektrum yang lebih ekstrim, para peneliti menyarankan bahwa tombol pemutus (kill switch) dapat dimasukkan ke dalam silikon untuk mencegah penggunaannya dalam aplikasi berbahaya.

Secara teori, hal ini memungkinkan regulator merespons lebih cepat terhadap penyalahgunaan teknologi sensitif dengan memutus akses ke chip dari jarak jauh, namun penulis memperingatkan bahwa hal ini bukannya tanpa risiko. Implikasinya adalah, jika diterapkan secara tidak benar, tombol mematikan tersebut dapat menjadi sasaran para penjahat dunia maya.

Proposal lain akan mengharuskan banyak pihak untuk menyetujui tugas pelatihan AI yang berpotensi berisiko sebelum dapat diterapkan dalam skala besar. “Senjata nuklir menggunakan mekanisme serupa yang disebut hubungan tindakan permisif,” tulis mereka.

Untuk senjata nuklir, kunci keamanan ini dirancang untuk mencegah satu orang bertindak nakal dan melancarkan serangan pertama. Namun untuk AI, idenya adalah jika seseorang atau perusahaan ingin melatih model melewati ambang batas tertentu di cloud, mereka harus terlebih dahulu mendapatkan otorisasi untuk melakukannya.

Meskipun alat ini ampuh, para peneliti mengamati bahwa hal ini bisa menjadi bumerang karena mencegah pengembangan AI yang diinginkan. Argumennya adalah meskipun penggunaan senjata nuklir memiliki dampak yang cukup jelas, AI tidak selalu bersifat hitam-putih.

Namun jika hal ini terasa terlalu distopia bagi selera Anda, makalah ini mendedikasikan seluruh bagiannya untuk merealokasi sumber daya AI demi kemajuan masyarakat secara keseluruhan. Gagasannya adalah bahwa para pembuat kebijakan dapat bersatu untuk membuat komputasi AI lebih mudah diakses oleh kelompok-kelompok yang tidak mungkin menggunakannya untuk kejahatan, sebuah konsep yang digambarkan sebagai “alokasi.”

Apa salahnya mengatur pengembangan AI?

Mengapa harus bersusah payah? Penulis makalah ini berpendapat bahwa perangkat keras fisik pada dasarnya lebih mudah dikendalikan.

Dibandingkan dengan perangkat keras, “masukan dan keluaran lain dari pengembangan AI – data, algoritme, dan model terlatih – merupakan barang tak berwujud yang mudah dibagikan dan tidak dapat bersaing, sehingga sulit untuk dikendalikan,” tulis makalah tersebut.

Argumennya adalah bahwa begitu sebuah model dipublikasikan, baik secara terbuka atau bocor, tidak ada yang bisa mengembalikan jin ke dalam botol dan menghentikan penyebarannya ke seluruh internet.

Para peneliti juga menyoroti bahwa upaya untuk mencegah penyalahgunaan model terbukti tidak dapat diandalkan. Dalam salah satu contoh, penulis menyoroti betapa mudahnya para peneliti membongkar perlindungan di Llama 2 Meta yang dimaksudkan untuk mencegah model menghasilkan bahasa yang menyinggung.

Secara ekstrim, dikhawatirkan model penggunaan ganda yang cukup canggih dapat digunakan untuk mempercepat hal ini pengembangan senjata kimia atau biologi.

Makalah ini mengakui bahwa regulasi perangkat keras AI bukanlah sebuah solusi jitu dan tidak menghilangkan kebutuhan akan regulasi di aspek lain dalam industri ini.

Namun, partisipasi beberapa peneliti OpenAI sulit untuk diabaikan mengingat partisipasi CEO Sam Altman upaya untuk mengontrol narasi seputar regulasi AI. ®

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- Sumber: https://go.theregister.com/feed/www.theregister.com/2024/02/16/boffins_propose_regulating_ai_hardware/

- :memiliki

- :adalah

- :bukan

- :Di mana

- $NAIK

- 7

- a

- Sanggup

- pelanggaran

- AC

- akademik

- mempercepat

- akselerator

- mengakses

- dapat diakses

- di seluruh

- Tindakan

- alamat

- maju

- Setelah

- AI

- Model AI

- Pelatihan AI

- ditujukan

- algoritma

- Semua

- alokasi

- mengizinkan

- diizinkan

- Membiarkan

- sepanjang

- sudah

- juga

- selalu

- AMD

- Amerika

- an

- dan

- Lain

- aplikasi

- pendekatan

- ADALAH

- membantah

- argumen

- senjata

- sekitar

- buatan

- kecerdasan buatan

- AS

- aspek

- At

- otorisasi

- penulis

- menghindari

- kembali

- BE

- menjadi

- sebelum

- makhluk

- diyakini

- TERBAIK

- Lebih baik

- Perbaikan

- biden

- Black

- membangun

- tapi

- by

- bernama

- cambridge

- CAN

- mampu

- kasus

- ceo

- tertentu

- rantai

- kimia

- Tiongkok

- keping

- Keripik

- sipil

- awan

- CO

- memerangi

- bagaimana

- Perdagangan

- Perusahaan

- perusahaan

- komponen

- menghitung

- Pekat

- konsep

- Perhatian

- mengingat

- kendala

- terus

- kontrol

- kontroversi

- bisa

- negara

- negara

- Kelas

- pelanggan

- pemotongan

- penjahat cyber

- data

- Departemen

- dikerahkan

- dijelaskan

- dirancang

- dikembangkan

- berkembang

- Pengembangan

- sulit

- do

- doesn

- melakukan

- dua kali lipat

- dystopian

- setiap

- memudahkan

- mudah

- mudah

- Efektif

- upaya

- antara

- menghapuskan

- dipekerjakan

- akhir

- melaksanakan

- Seluruh

- Bahkan

- contoh

- melebihi

- mengeksekusi

- adanya

- ekspor

- ekstrim

- sangat

- faktor

- akrab

- jauh

- lebih cepat

- ditakuti

- terasa

- Pertama

- Untuk

- Depan

- dari

- depan

- celah

- menghasilkan

- Jin

- mendapatkan

- mendapatkan

- Aksi

- Go

- akan

- barang

- GPU

- Grup

- tangan

- Sulit

- sulit

- Perangkat keras

- Memiliki

- membantu

- menyembunyikan

- Disorot

- highlight

- Seterpercayaapakah Olymp Trade? Kesimpulan

- Namun

- HTTPS

- ide

- identifier

- mengidentifikasi

- if

- mengabaikan

- besar

- melaksanakan

- diimplementasikan

- mengimplementasikan

- memperbaiki

- in

- Di lain

- termasuk

- Termasuk

- menggabungkan

- salah

- sendiri-sendiri

- industri

- Infrastruktur

- secara inheren

- input

- lembaga

- berwujud

- Intel

- Intelijen

- intervensi

- ke

- adalah n

- IT

- NYA

- JOE

- Joe Biden

- jpg

- Membunuh

- Jenis

- bahasa

- besar

- jalankan

- peluncuran

- memimpin

- Dipimpin

- meninggalkan

- Tingkat

- siklus hidup

- 'like'

- MEMBATASI

- keterbatasan

- membatasi

- link

- sedikit

- Llama

- Kunci

- terbuat

- membuat

- MEMBUAT

- Membuat

- jahat

- pabrik

- banyak

- besar-besaran

- Mungkin..

- cara

- berarti

- mekanisme

- meta

- mungkin

- Militer

- Aplikasi Militer

- rudal

- penyalahgunaan

- model

- model

- bulan

- lebih

- paling

- beberapa

- NARASI

- nasional

- Perlu

- bersih

- New

- tidak

- mencatat

- nuklir

- jumlah

- banyak sekali

- Nvidia

- mengamati

- of

- lepas

- serangan

- menawarkan

- on

- sekali

- ONE

- Buka

- OpenAI

- or

- asal

- Lainnya

- Lainnya

- kami

- di luar

- Hasil

- output

- lebih

- kertas

- parameter

- partisipasi

- khususnya

- pihak

- hukuman

- sempurna

- prestasi

- orang

- orang

- fisik

- plato

- Kecerdasan Data Plato

- Data Plato

- bermain

- Titik

- Kebijakan

- kebijakan

- ampuh

- potensi

- berpotensi

- kekuatan

- presiden

- presiden joe biden

- cukup

- mencegah

- mencegah

- sebelumnya

- pribadi

- pengolahan

- Diproduksi

- produktif

- usul

- diusulkan

- terbukti

- penyedia

- diterbitkan

- menempatkan

- Puting

- terukur

- pencarian

- Ras

- RE

- baru-baru ini

- mengacu

- pendaftaran

- Mengatur

- mengatur

- Regulasi

- Regulator

- relatif

- relatif

- mengandalkan

- terpencil

- sedikit

- Dilaporkan

- Pelaporan

- laporan

- membutuhkan

- Persyaratan

- membutuhkan

- peneliti

- Sumber

- Menanggapi

- membatasi

- pembatasan

- Risiko

- risiko

- berisiko

- s

- pengamanan

- penjualan

- penjualan

- Universitas

- sam altman

- mengatakan

- Skala

- Bagian

- keamanan

- tampaknya

- semikonduktor

- peka

- melayani

- beberapa

- menandatangani

- Silikon

- Silver

- mirip

- kecil

- So

- Masyarakat

- terjual

- Spektrum

- penyebaran

- awal

- berhenti

- henti

- menyerang

- ketat

- seperti itu

- menyarankan

- menyediakan

- supply chain

- Beralih

- target

- tugas

- rasanya

- Teknologi

- memiliki

- bahwa

- Grafik

- mereka

- Mereka

- teori

- Sana.

- Ini

- mereka

- ini

- itu

- ribuan

- ambang

- waktu

- untuk

- bersama

- terlalu

- alat

- jalur

- perdagangan

- Pelatihan VE

- terlatih

- Pelatihan

- dipicu

- Triliun

- kesulitan

- tidak sah

- memahami

- unik

- universitas

- Universitas Cambridge

- mungkin

- us

- Presiden AS

- menggunakan

- bekas

- Berharga

- Ve

- vendor

- melalui

- jarak penglihatan

- SUARA

- ingin

- Cara..

- cara

- we

- Senjata

- minggu

- BAIK

- adalah

- yang

- sementara

- putih

- SIAPA

- seluruh

- dengan

- tanpa

- akan

- Salah

- menulis

- tahun

- Kamu

- Anda

- zephyrnet.dll