Banyak aplikasi yang dimaksudkan untuk pemeliharaan peralatan industri, pemantauan perdagangan, manajemen armada, dan pengoptimalan rute dibangun menggunakan API Cassandra dan driver open-source untuk memproses data dengan kecepatan tinggi dan latensi rendah. Mengelola tabel Cassandra sendiri bisa memakan waktu dan mahal. Amazon Keyspaces (untuk Apache Cassandra) memungkinkan Anda menyiapkan, mengamankan, dan menskalakan tabel Cassandra di AWS Cloud tanpa mengelola infrastruktur tambahan.

Dalam posting ini, kami akan memandu Anda melalui Layanan AWS terkait dengan model pembelajaran mesin (ML) pelatihan menggunakan Amazon Keyspaces pada tingkat tinggi, dan memberikan petunjuk langkah demi langkah untuk menyerap data dari Amazon Keyspaces ke Amazon SageMaker dan melatih model yang dapat digunakan untuk kasus penggunaan segmentasi pelanggan tertentu.

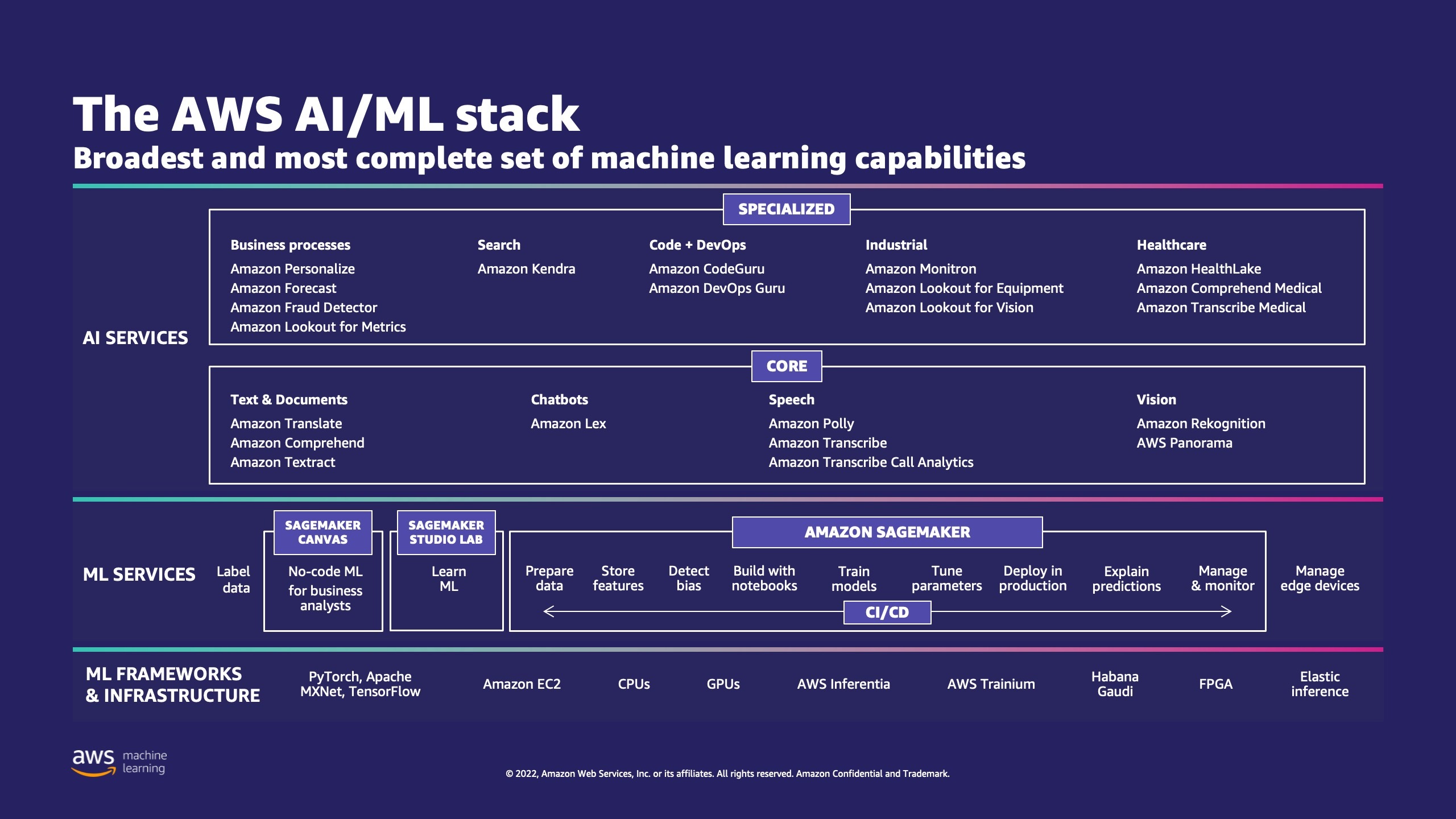

AWS memiliki beberapa layanan untuk membantu bisnis menerapkan proses ML di cloud.

AWS ML Stack memiliki tiga lapisan. Di lapisan tengah adalah SageMaker, yang memberi pengembang, ilmuwan data, dan insinyur ML kemampuan untuk membangun, melatih, dan menerapkan model ML dalam skala besar. Ini menghilangkan kerumitan dari setiap langkah alur kerja ML sehingga Anda dapat lebih mudah menerapkan kasus penggunaan ML Anda. Ini mencakup segala hal mulai dari pemeliharaan prediktif hingga visi komputer untuk memprediksi perilaku pelanggan. Pelanggan mencapai peningkatan hingga 10 kali lipat dalam produktivitas ilmuwan data dengan SageMaker.

Apache Cassandra adalah pilihan populer untuk kasus penggunaan yang banyak membaca dengan data tidak terstruktur atau semi terstruktur. Misalnya, bisnis pengiriman makanan populer memperkirakan waktu pengiriman, dan pelanggan ritel dapat terus menggunakan informasi katalog produk di Database Apache Cassandra. Ruang Kunci Amazon adalah layanan database yang kompatibel dengan Apache Cassandra tanpa server yang skalabel, sangat tersedia, dan terkelola. Anda tidak perlu menyediakan, menambal, atau mengelola server, dan Anda tidak perlu menginstal, memelihara, atau mengoperasikan perangkat lunak. Tabel dapat ditingkatkan dan diturunkan secara otomatis, dan Anda hanya membayar untuk sumber daya yang Anda gunakan. Amazon Keyspaces memungkinkan Anda menjalankan beban kerja Cassandra di AWS menggunakan kode aplikasi Cassandra dan alat pengembang yang sama dengan yang Anda gunakan saat ini.

SageMaker menyediakan rangkaian algoritme bawaan untuk membantu ilmuwan data dan praktisi ML memulai pelatihan dan menerapkan model ML dengan cepat. Dalam posting ini, kami akan menunjukkan kepada Anda bagaimana pelanggan ritel dapat menggunakan riwayat pembelian pelanggan di Database Keyspaces dan menargetkan segmen pelanggan yang berbeda untuk kampanye pemasaran.

K-berarti adalah algoritma pembelajaran tanpa pengawasan. Ini mencoba untuk menemukan pengelompokan diskrit dalam data, di mana anggota kelompok sedekat mungkin satu sama lain dan seberbeda mungkin dari anggota kelompok lain. Anda menentukan atribut yang ingin digunakan algoritme untuk menentukan kesamaan. SageMaker menggunakan versi modifikasi dari algoritma pengelompokan k-means skala web. Dibandingkan dengan versi asli algoritme, versi yang digunakan oleh SageMaker lebih akurat. Namun, seperti algoritme aslinya, ia menskalakan ke kumpulan data yang sangat besar dan memberikan peningkatan dalam waktu pelatihan.

Ikhtisar solusi

Instruksi mengasumsikan bahwa Anda akan menggunakan SageMaker Studio untuk menjalankan kode. Kode terkait telah dibagikan di Contoh AWS GitHub. Mengikuti petunjuk di lab, Anda dapat melakukan hal berikut:

- Instal dependensi yang diperlukan.

- Hubungkan ke Amazon Keyspaces, buat Tabel, dan serap data sampel.

- Buat model ML klasifikasi menggunakan data di Amazon Keyspaces.

- Jelajahi hasil model.

- Bersihkan sumber daya yang baru dibuat.

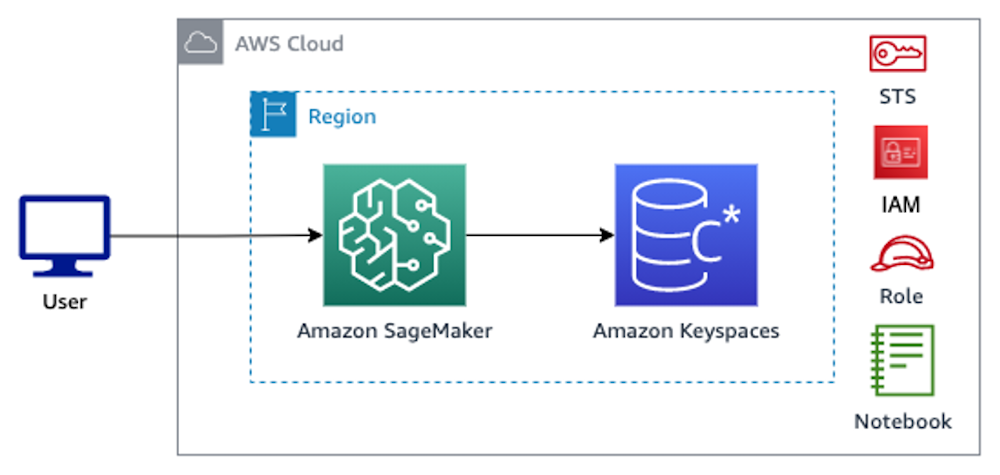

Setelah selesai, Anda akan mengintegrasikan SageMaker dengan Amazon Keyspaces untuk melatih model ML seperti yang ditunjukkan pada gambar berikut.

Sekarang Anda dapat mengikuti petunjuk langkah demi langkah dalam posting ini untuk menyerap data mentah yang disimpan di Amazon Keyspaces menggunakan SageMaker dan data yang diambil untuk pemrosesan ML.

Prasyarat

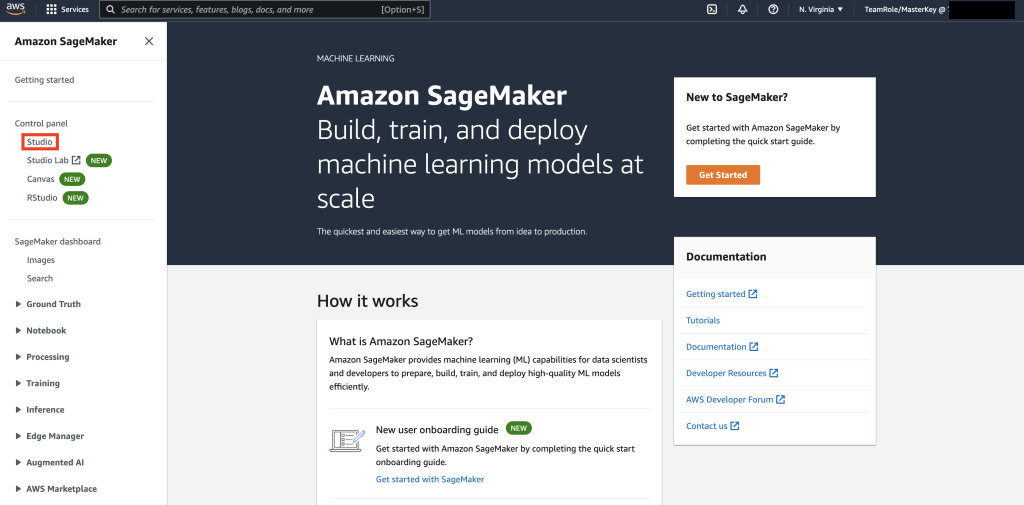

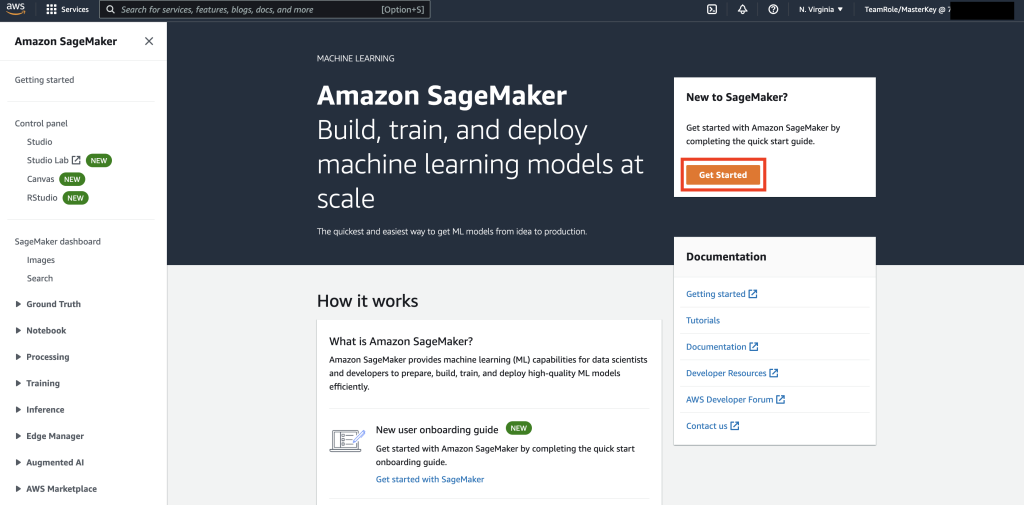

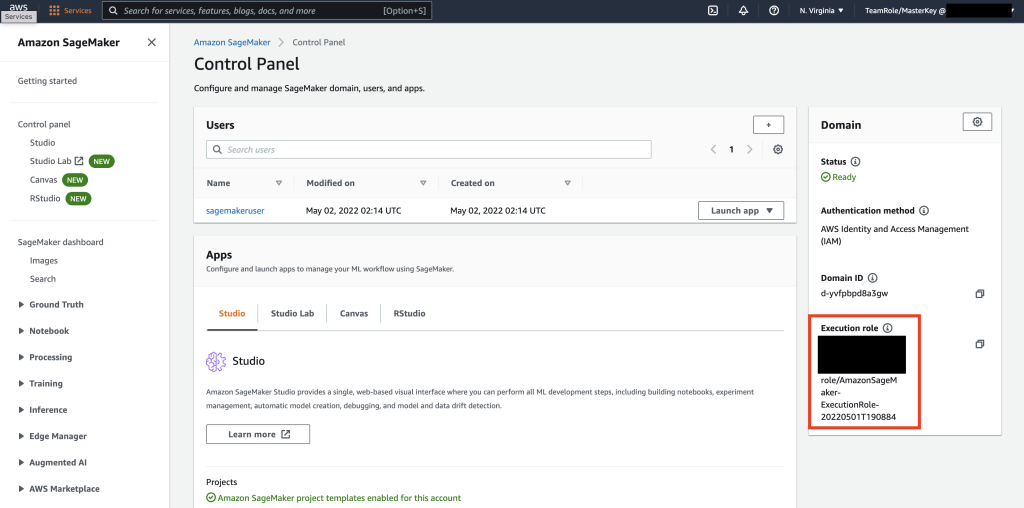

Pertama, Navigasikan ke SageMaker.

Selanjutnya, jika ini adalah pertama kalinya Anda menggunakan SageMaker, pilih Memulai.

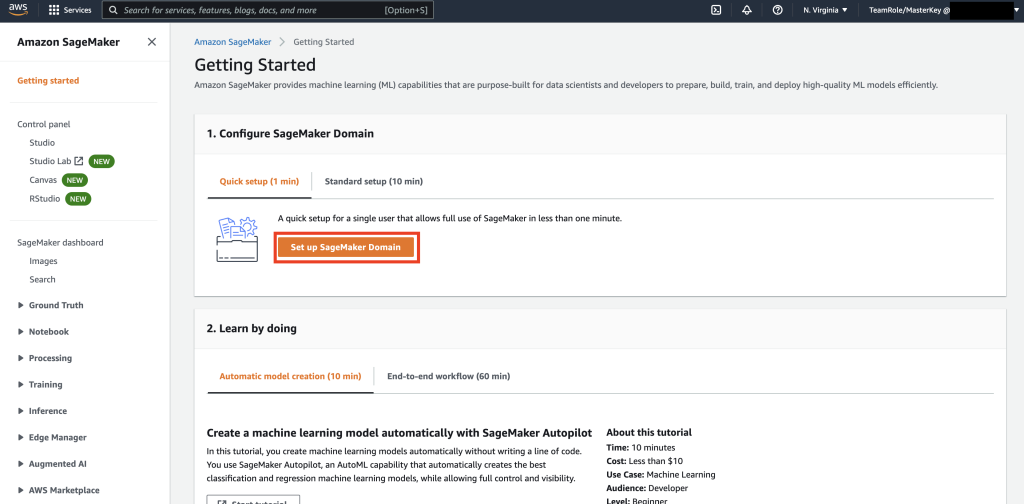

Selanjutnya, pilih Siapkan Domain SageMaker.

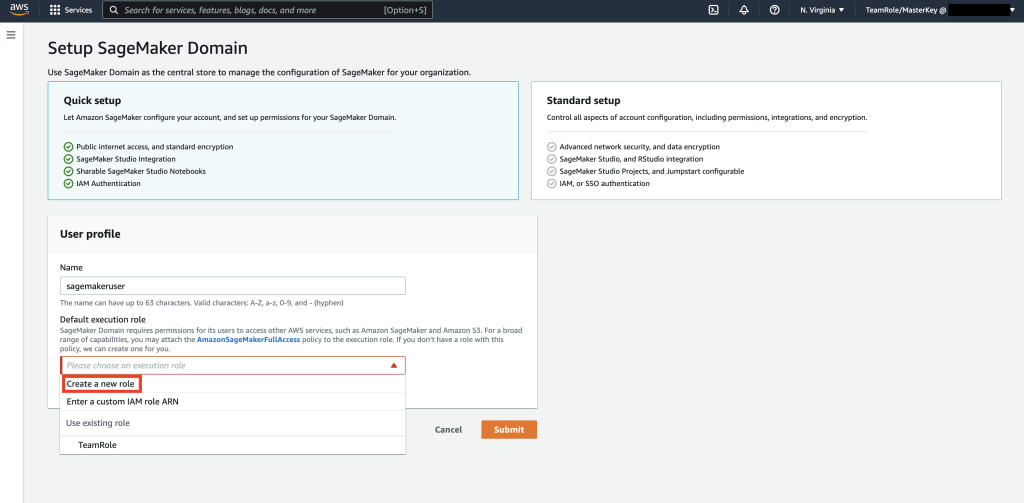

Selanjutnya, buat profil pengguna baru dengan Nama – pengguna bijak, Lalu pilih Buat Peran Baru dalam Peran Eksekusi Default sub bagian.

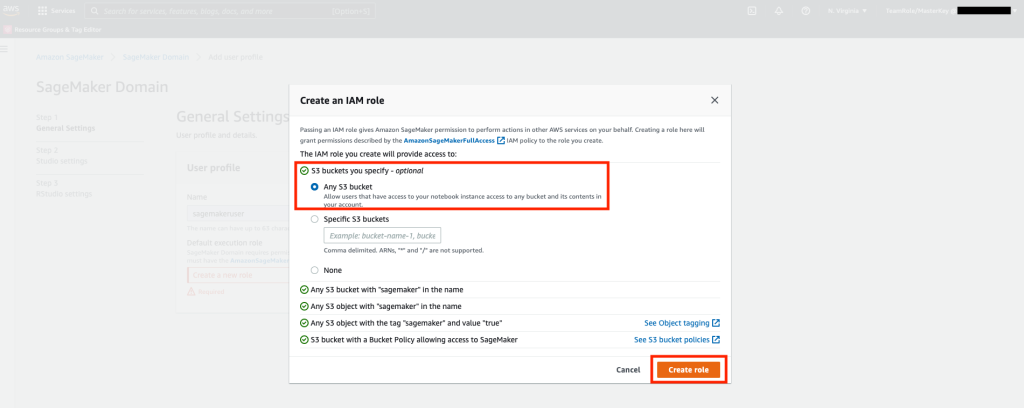

Selanjutnya, di layar yang muncul, pilih apa saja Layanan Penyimpanan Sederhana Amazon (Amazon S3) ember, dan pilih Buat peran.

Peran ini akan digunakan dalam langkah-langkah berikut untuk mengizinkan SageMaker mengakses Tabel Ruang Kunci menggunakan kredensial sementara dari peran tersebut. Ini menghilangkan kebutuhan untuk menyimpan nama pengguna dan kata sandi di buku catatan.

Selanjutnya, ambil peran yang terkait dengan pengguna bijak yang dibuat pada langkah sebelumnya dari bagian ringkasan.

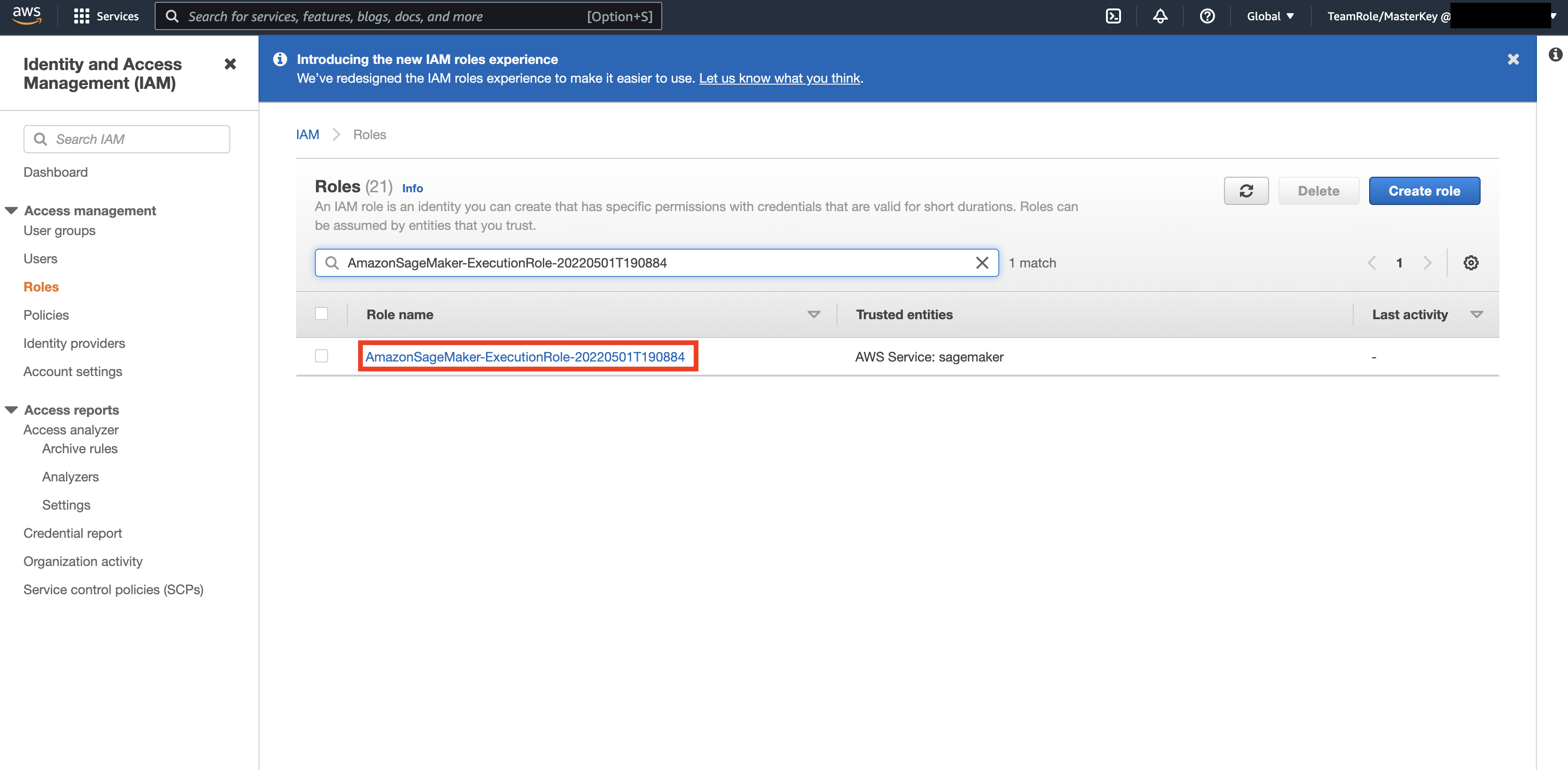

Kemudian, navigasikan ke Konsol AWS dan lihat ke atas AWS Identitas dan Manajemen Akses (IAM). Dalam IAM, navigasikan ke Peran. Di dalam Peran, cari peran eksekusi yang diidentifikasi pada langkah sebelumnya.

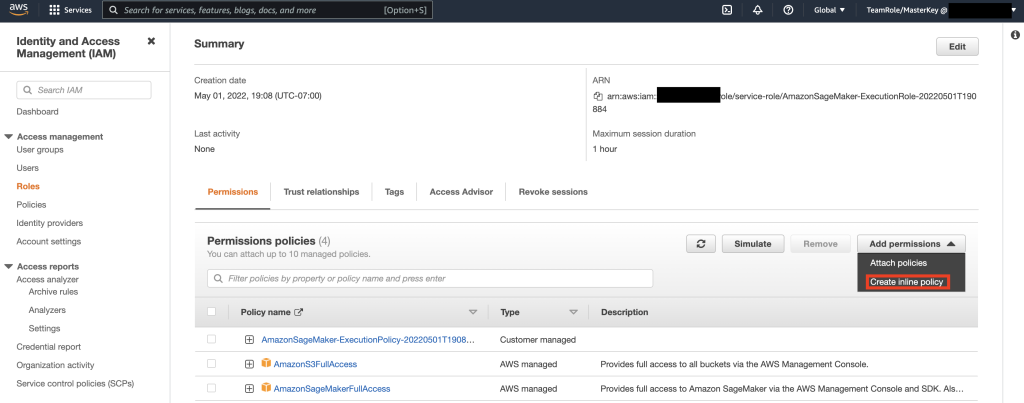

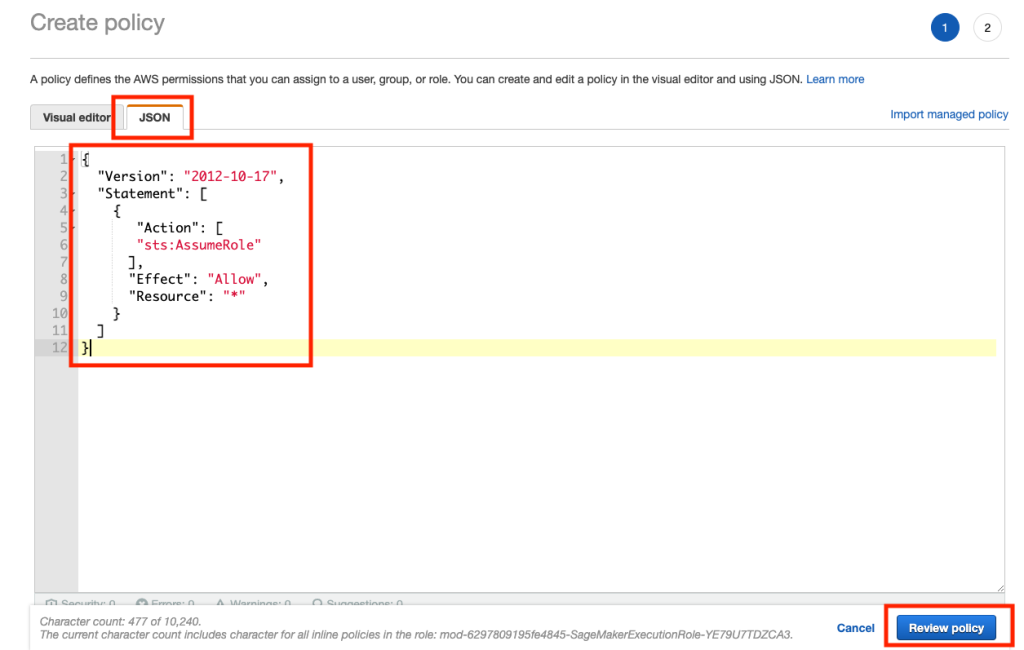

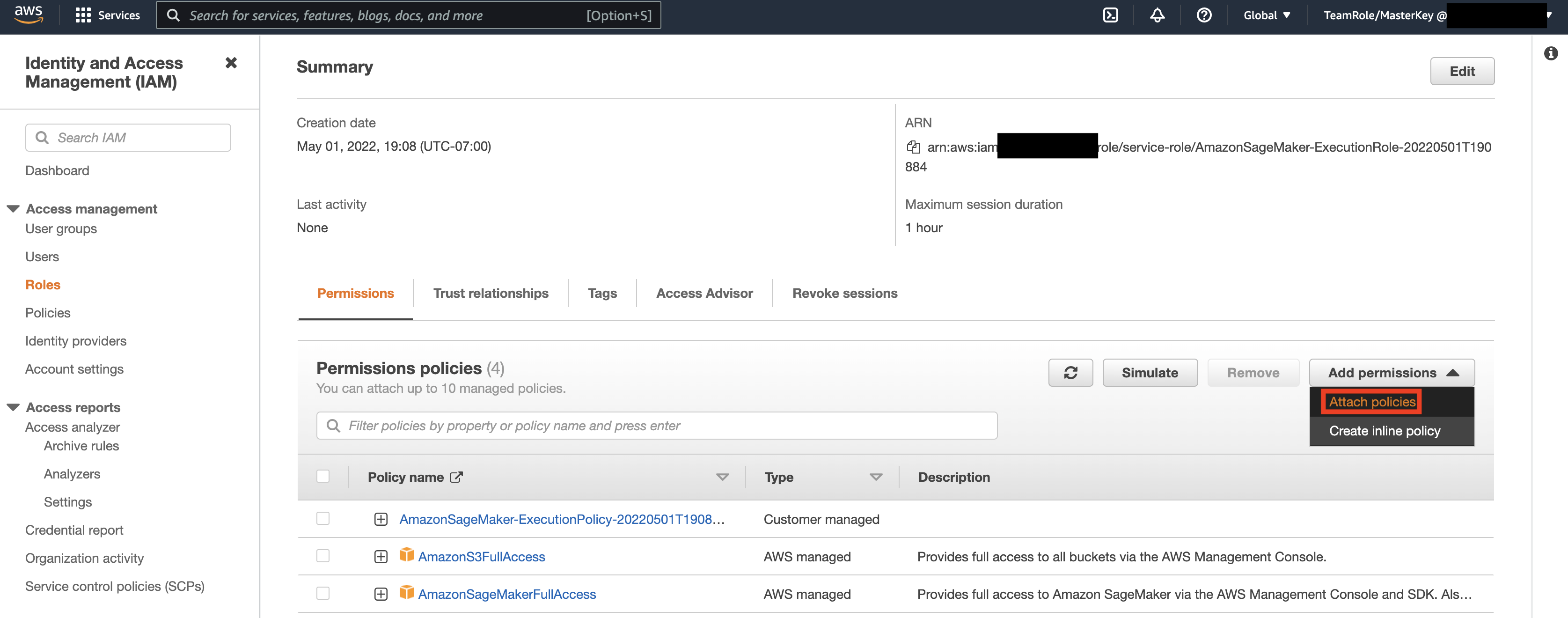

Selanjutnya, pilih peran yang diidentifikasi pada langkah sebelumnya dan pilih Tambahkan Izin. Pada drop down yang muncul, pilih Create Inline Policy. SageMaker memungkinkan Anda memberikan tingkat akses granular yang membatasi tindakan yang dapat dilakukan pengguna/aplikasi berdasarkan kebutuhan bisnis.

Kemudian, pilih tab JSON dan salin kebijakan dari bagian Catatan di Github halaman. Kebijakan ini memungkinkan notebook SageMaker terhubung ke Keyspaces dan mengambil data untuk diproses lebih lanjut.

Kemudian, pilih Tambahkan izin lagi dan dari drop down, dan pilih Lampirkan Kebijakan.

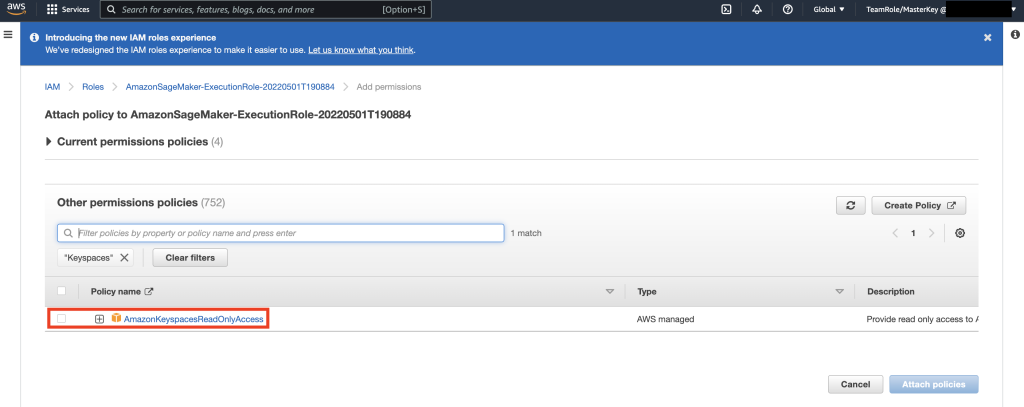

Cari kebijakan AmazonKeyspacesFullAccess, dan centang kotak di samping hasil yang cocok, lalu pilih Lampirkan Kebijakan.

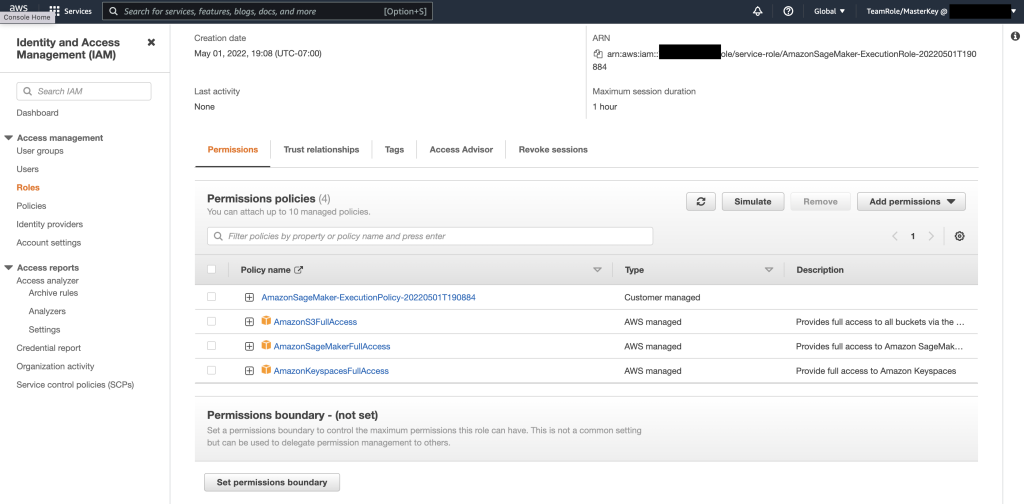

Verifikasi bahwa bagian kebijakan izin menyertakan AmazonS3FullAccess, AmazonSageMakerFullAccess, AmazonKeyspacesFullAccess, serta kebijakan sebaris yang baru ditambahkan.

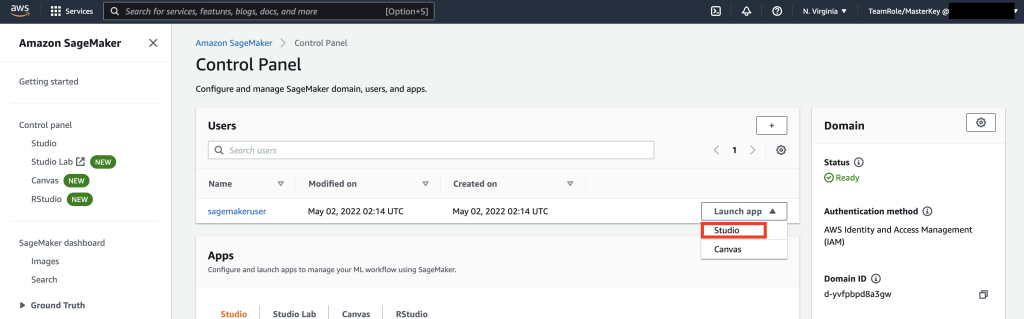

Selanjutnya, navigasikan ke SageMaker Studio menggunakan AWS Console dan pilih SageMaker Studio. Sesampai di sana, pilih Luncurkan Aplikasi dan pilih Studio.

Panduan buku catatan

Cara yang lebih disukai untuk terhubung ke Keyspaces dari SageMaker Notebook adalah dengan menggunakan Proses AWS Signature Versi 4 (SigV4) berdasarkan Kredensial Sementara untuk otentikasi. Dalam skenario ini, kami TIDAK perlu membuat atau menyimpan kredensial Keyspaces dan dapat menggunakan kredensial untuk mengautentikasi dengan plugin SigV4. Kredensial keamanan sementara terdiri dari ID kunci akses dan kunci akses rahasia. Namun, mereka juga menyertakan token keamanan yang menunjukkan kapan kredensial kedaluwarsa. Dalam posting ini, kami akan membuat peran IAM dan menghasilkan kredensial keamanan sementara.

Pertama, kita menginstal driver (cassandra-sigv4). Driver ini memungkinkan Anda untuk menambahkan informasi autentikasi ke permintaan API Anda menggunakan AWS Signature Version 4 Process (SigV4). Dengan menggunakan plugin, Anda dapat memberikan kredensial jangka pendek kepada pengguna dan aplikasi untuk mengakses Amazon Keyspaces (untuk Apache Cassandra) menggunakan pengguna dan peran IAM. Setelah ini, Anda akan mengimpor sertifikat yang diperlukan bersama dengan dependensi paket tambahan. Pada akhirnya, Anda akan mengizinkan notebook untuk mengambil peran untuk berbicara dengan Keyspaces.

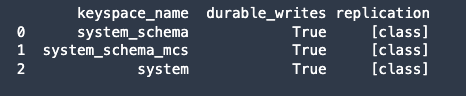

Selanjutnya, sambungkan ke Amazon Keyspaces dan baca data sistem dari Keyspaces ke Pandas DataFrame untuk memvalidasi koneksi.

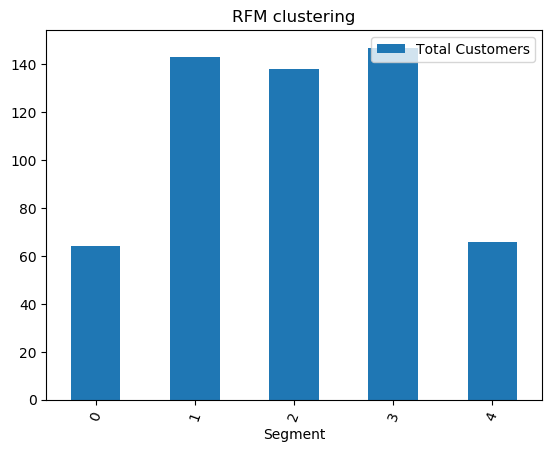

Selanjutnya, siapkan data untuk pelatihan pada kumpulan data mentah. Di notebook python yang terkait dengan posting ini, gunakan kumpulan data ritel yang diunduh dari di sini, dan memprosesnya. Tujuan bisnis kami mengingat kumpulan data adalah untuk mengelompokkan pelanggan menggunakan panggilan metrik RFM tertentu. Model RFM didasarkan pada tiga faktor kuantitatif:

- Kekinian: Seberapa baru pelanggan melakukan pembelian.

- Frekuensi: Seberapa sering pelanggan melakukan pembelian.

- Nilai Moneter: Berapa banyak uang yang dihabiskan pelanggan untuk pembelian.

Analisis RFM secara numerik memberi peringkat pelanggan di masing-masing dari tiga kategori ini, umumnya pada skala 1 hingga 5 (semakin tinggi angkanya, semakin baik hasilnya). Pelanggan "terbaik" akan menerima skor tertinggi di setiap kategori. Kami akan menggunakan fungsi diskritisasi berbasis Quantile (qcut) panda. Ini akan membantu membedakan nilai ke dalam ember berukuran sama berdasarkan atau berdasarkan kuantil sampel.

Dalam contoh ini, kami menggunakan CQL untuk membaca catatan dari tabel Keyspace. Dalam beberapa kasus penggunaan ML, Anda mungkin perlu membaca data yang sama dari tabel Keyspaces yang sama beberapa kali. Dalam hal ini, kami sarankan Anda menyimpan data Anda ke dalam ember Amazon S3 untuk menghindari tambahan biayas membaca dari Amazon Keyspaces. Bergantung pada skenario Anda, Anda juga dapat menggunakan Amazon ESDM untuk menelan file Amazon S3 yang sangat besar ke dalam SageMaker.

Selanjutnya, kami melatih model ML menggunakan algoritme KMeans dan memastikan bahwa cluster telah dibuat. Dalam skenario khusus ini, Anda akan melihat bahwa cluster yang dibuat dicetak, menunjukkan bahwa pelanggan dalam kumpulan data mentah telah dikelompokkan bersama berdasarkan berbagai atribut dalam kumpulan data. Informasi cluster ini dapat digunakan untuk kampanye pemasaran yang ditargetkan.

(Opsional) Selanjutnya, kami menyimpan segmen pelanggan yang telah diidentifikasi oleh model ML kembali ke tabel Amazon Keyspaces untuk pemasaran yang ditargetkan. Pekerjaan batch dapat membaca data ini dan menjalankan kampanye yang ditargetkan ke pelanggan di segmen tertentu.

Akhirnya, kita membersihkan sumber daya dibuat selama tutorial ini untuk menghindari timbulnya biaya tambahan.

Mungkin diperlukan beberapa detik hingga satu menit untuk menyelesaikan penghapusan keyspace dan tabel. Saat Anda menghapus keyspace, keyspace dan semua tabelnya akan dihapus dan Anda berhenti dikenakan biaya dari mereka.

Kesimpulan

Posting ini menunjukkan kepada Anda cara menyerap data pelanggan dari Amazon Keyspaces ke SageMaker dan melatih model pengelompokan yang memungkinkan Anda mengelompokkan pelanggan. Anda dapat menggunakan informasi ini untuk pemasaran yang ditargetkan, sehingga sangat meningkatkan KPI bisnis Anda. Untuk mempelajari lebih lanjut tentang Amazon Keyspaces, tinjau sumber daya berikut:

- Latih Model Machine Learning menggunakan Amazon Keyspaces sebagai Sumber Data (Buku Catatan SageMaker)

- Hubungkan ke Amazon Keyspaces dari desktop Anda menggunakan IDE IntelliJ, PyCharm, atau DataGrip

- Referensi Bahasa CQL untuk Amazon Keyspaces (untuk Apache Cassandra)

- Cara menyiapkan akses baris perintah ke Amazon Keyspaces (untuk Apache Cassandra) dengan menggunakan gambar Docker toolkit pengembang baru

- Manajemen Identitas dan Akses untuk Amazon Keyspaces (untuk Apache Cassandra)

- Menghubungkan ke Amazon Keyspaces dari SageMaker dengan kredensial khusus layanan

- Keterkinian, Frekuensi, Nilai Moneter (RFM)

- Referensi kode Kaggle

Tentang Penulis

Vadim Lyakhovich adalah Arsitek Solusi Senior di AWS di San Francisco Bay Area yang membantu pelanggan bermigrasi ke AWS. Dia bekerja dengan organisasi mulai dari perusahaan besar hingga perusahaan rintisan kecil untuk mendukung inovasi mereka. Dia juga membantu pelanggan untuk merancang solusi yang skalabel, aman, dan hemat biaya di AWS.

Vadim Lyakhovich adalah Arsitek Solusi Senior di AWS di San Francisco Bay Area yang membantu pelanggan bermigrasi ke AWS. Dia bekerja dengan organisasi mulai dari perusahaan besar hingga perusahaan rintisan kecil untuk mendukung inovasi mereka. Dia juga membantu pelanggan untuk merancang solusi yang skalabel, aman, dan hemat biaya di AWS.

Parth Patel adalah Arsitek Solusi di AWS di San Francisco Bay Area. Parth memandu pelanggan untuk mempercepat perjalanan mereka ke cloud dan membantu mereka mengadopsi AWS cloud dengan sukses. Dia fokus pada ML dan Modernisasi Aplikasi.

Parth Patel adalah Arsitek Solusi di AWS di San Francisco Bay Area. Parth memandu pelanggan untuk mempercepat perjalanan mereka ke cloud dan membantu mereka mengadopsi AWS cloud dengan sukses. Dia fokus pada ML dan Modernisasi Aplikasi.

Ram Pathangi adalah Arsitek Solusi di AWS di San Francisco Bay Area. Dia telah membantu pelanggan di bidang Pertanian, Asuransi, Perbankan, Ritel, Perawatan Kesehatan & Ilmu Hayati, Perhotelan, dan vertikal Hi-Tech untuk menjalankan bisnis mereka dengan sukses di AWS cloud. Dia berspesialisasi dalam Database, Analytics, dan ML.

Ram Pathangi adalah Arsitek Solusi di AWS di San Francisco Bay Area. Dia telah membantu pelanggan di bidang Pertanian, Asuransi, Perbankan, Ritel, Perawatan Kesehatan & Ilmu Hayati, Perhotelan, dan vertikal Hi-Tech untuk menjalankan bisnis mereka dengan sukses di AWS cloud. Dia berspesialisasi dalam Database, Analytics, dan ML.

- Coinsmart. Pertukaran Bitcoin dan Crypto Terbaik Eropa.

- Platoblockchain. Intelijen Metaverse Web3. Pengetahuan Diperkuat. AKSES GRATIS.

- CryptoHawk. Radar Altcoin. Uji Coba Gratis.

- Sumber: https://aws.amazon.com/blogs/machine-learning/train-machine-learning-models-using-amazon-keyspaces-as-a-data-source/

- '

- "

- &

- 10

- 100

- 9

- kemampuan

- Tentang Kami

- mempercepat

- mengakses

- tepat

- Mencapai

- tindakan

- Tambahan

- pertanian

- di depan

- algoritma

- Semua

- Amazon

- analisis

- analisis

- Lain

- api

- Lebah

- aplikasi

- Aplikasi

- aplikasi

- DAERAH

- perhatian

- atribut

- Otentikasi

- secara otomatis

- tersedia

- AWS

- Perbankan

- Teluk

- Blog

- batas

- membangun

- bisnis

- bisnis

- panggilan

- Kampanye

- yang

- kasus

- Kategori

- sertifikat

- beban

- pilihan

- klasifikasi

- awan

- kode

- dibandingkan

- komputer

- Terhubung

- koneksi

- konsul

- hemat biaya

- bisa

- negara

- membuat

- dibuat

- Surat kepercayaan

- pelanggan

- pelanggan

- data

- kumpulan data

- Basis Data

- database

- memberikan

- pengiriman

- Tergantung

- menyebarkan

- penggelaran

- Desktop

- Menentukan

- Pengembang

- pengembang

- berbeda

- Buruh pelabuhan

- turun

- pengemudi

- Menjatuhkan

- selama

- mudah

- Insinyur

- perusahaan

- peralatan

- perkiraan

- contoh

- eksekusi

- faktor

- Pertama

- pertama kali

- ARMADA KAPAL

- berfokus

- mengikuti

- berikut

- makanan

- Francisco

- fungsi

- lebih lanjut

- umumnya

- menghasilkan

- mendapatkan

- GitHub

- sangat

- Kelompok

- Grup

- Panduan

- Kesehatan

- Perawatan Kesehatan

- membantu

- membantu

- High

- lebih tinggi

- sangat

- sejarah

- Seterpercayaapakah Olymp Trade? Kesimpulan

- How To

- Namun

- HTTPS

- identitas

- gambar

- melaksanakan

- perbaikan

- meningkatkan

- memasukkan

- termasuk

- indeks

- industri

- informasi

- Infrastruktur

- inovasi

- install

- asuransi

- terpadu

- IT

- Pekerjaan

- perjalanan

- kunci

- laboratorium

- bahasa

- besar

- jalankan

- lapisan

- BELAJAR

- pengetahuan

- Tingkat

- Biologi

- melihat

- setia

- mesin

- Mesin belajar

- terbuat

- memelihara

- MEMBUAT

- mengelola

- berhasil

- pengelolaan

- pelaksana

- Marketing

- besar-besaran

- sesuai

- Anggota

- ML

- model

- model

- Moneter

- uang

- pemantauan

- lebih

- paling

- beberapa

- perlu

- buku catatan

- jumlah

- beroperasi

- optimasi

- organisasi

- Lainnya

- paket

- tertentu

- Kata Sandi

- tambalan

- Membayar

- Plugin

- Kebijakan

- kebijaksanaan

- Populer

- mungkin

- potensi

- meramalkan

- Mempersiapkan

- sebelumnya

- harga pompa cor beton mini

- primer

- proses

- proses

- pengolahan

- Produk

- produktifitas

- Profil

- menjanjikan

- memberikan

- menyediakan

- membeli

- pembelian

- kuantitatif

- segera

- mulai

- Mentah

- Bacaan

- menerima

- baru-baru ini

- sarankan

- arsip

- permintaan

- wajib

- Persyaratan

- Sumber

- Hasil

- eceran

- ulasan

- Risiko

- Peran

- Rute

- Run

- San

- San Fransisco

- SC

- terukur

- Skala

- ILMU PENGETAHUAN

- ilmuwan

- Layar

- Pencarian

- detik

- aman

- keamanan

- token keamanan

- ruas

- segmentasi

- segmen

- Tanpa Server

- layanan

- Layanan

- set

- berbagi

- jangka pendek

- ditunjukkan

- mirip

- Sederhana

- tidur

- kecil

- So

- Perangkat lunak

- padat

- Solusi

- beberapa

- spesialisasi

- tumpukan

- mulai

- Startups

- penyimpanan

- menyimpan

- studio

- berhasil

- mendukung

- sistem

- sistem

- Berbicara

- target

- ditargetkan

- sementara

- Grafik

- Melalui

- waktu

- kali

- hari ini

- bersama

- token

- toolkit

- alat

- puncak

- perdagangan

- Pelatihan

- menggunakan

- kasus penggunaan

- Pengguna

- nilai

- berbagai

- versi

- vertikal

- penglihatan

- Apa

- dalam

- tanpa

- kerja

- akan

- Anda