Amazon SageMembuatr Pengatur Data adalah alat persiapan data berbasis UI yang membantu melakukan analisis data, pemrosesan awal, dan visualisasi dengan fitur untuk membersihkan, mengubah, dan menyiapkan data lebih cepat. Templat alur siap pakai Data Wrangler membantu mempercepat persiapan data bagi ilmuwan data dan praktisi pembelajaran mesin (ML) dengan membantu Anda mempercepat dan memahami pola praktik terbaik untuk aliran data menggunakan kumpulan data umum.

Anda dapat menggunakan alur Data Wrangler untuk melakukan tugas berikut:

- Visualisasi data – Memeriksa properti statistik untuk setiap kolom dalam kumpulan data, membangun histogram, mempelajari outlier

- Pembersihan data – Menghapus duplikat, menjatuhkan atau mengisi entri dengan nilai yang hilang, menghapus outlier

- Pengayaan data dan rekayasa fitur – Memproses kolom untuk membangun fitur yang lebih ekspresif, memilih subset fitur untuk pelatihan

Posting ini akan membantu Anda memahami Data Wrangler menggunakan contoh alur pra-bangun berikut GitHub. Repositori menampilkan transformasi data tabular, transformasi data deret waktu, dan transformasi kumpulan data gabungan. Masing-masing membutuhkan jenis transformasi yang berbeda karena sifat dasarnya. Data tabular atau cross-sectional standar dikumpulkan pada titik waktu tertentu. Sebaliknya, data deret waktu diambil berulang kali dari waktu ke waktu, dengan setiap titik data berurutan bergantung pada nilai masa lalunya.

Mari kita lihat contoh bagaimana kita bisa menggunakan aliran data sampel untuk data tabular.

Prasyarat

Data Wrangler adalah Amazon SageMaker fitur yang tersedia di dalamnya Studio Amazon SageMaker, jadi kita harus mengikuti proses orientasi Studio untuk mengaktifkan lingkungan Studio dan notebook. Meskipun Anda dapat memilih dari beberapa metode autentikasi, cara termudah untuk membuat domain Studio adalah dengan mengikuti Mulai cepat instruksi. Mulai cepat menggunakan pengaturan default yang sama dengan pengaturan Studio standar. Anda juga dapat memilih untuk menggunakan Pusat Identitas AWS IAM (penerus AWS Single Sign-On) untuk autentikasi (lihat Masuk ke Domain Amazon SageMaker Menggunakan IAM Identity Center).

Impor dataset dan file aliran ke Data Wrangler menggunakan Studio

Langkah-langkah berikut menguraikan cara mengimpor data ke SageMaker untuk digunakan oleh Data Wrangler:

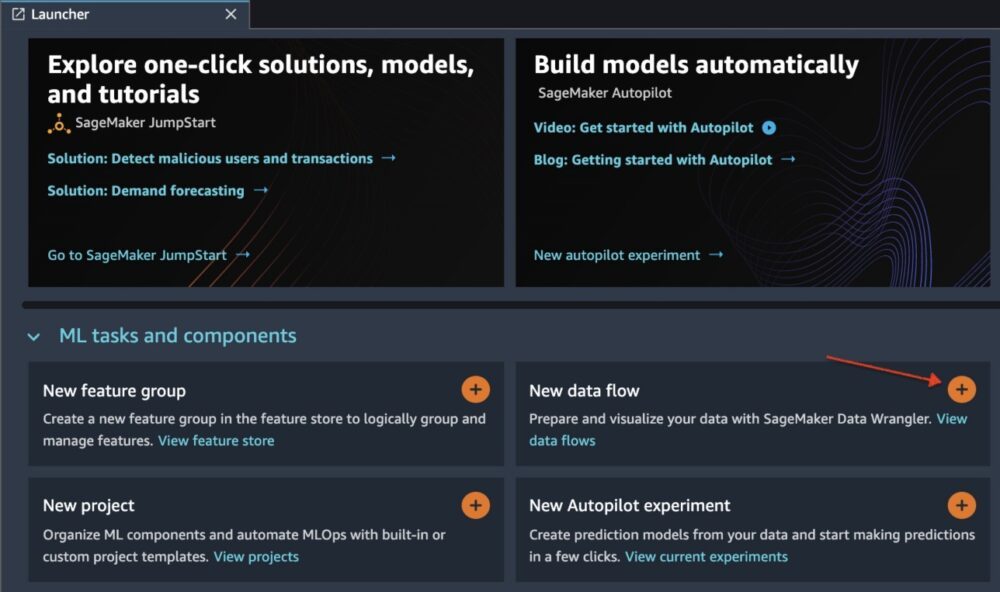

Inisialisasi Data Wrangler melalui UI Studio dengan memilih Aliran data baru.

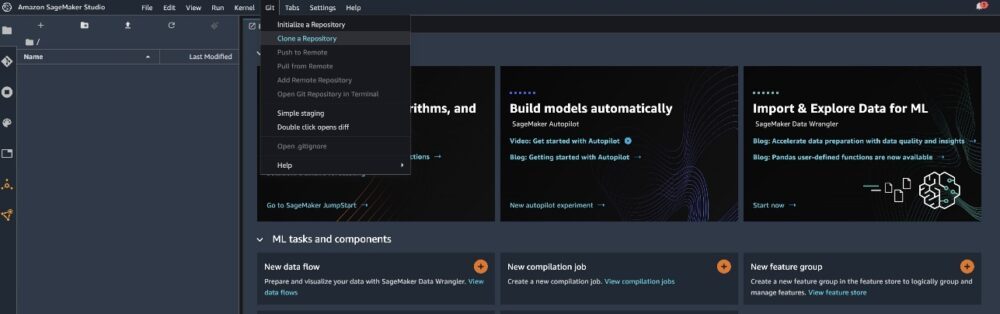

Clone file GitHub repo untuk mengunduh file aliran ke lingkungan Studio Anda.

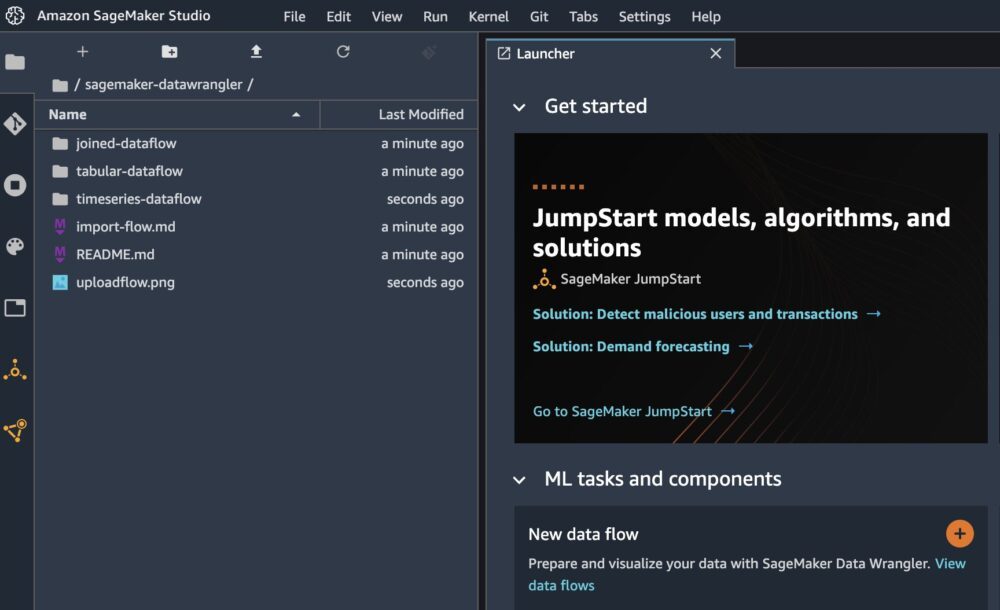

Saat klon selesai, Anda seharusnya dapat melihat konten repositori di panel kiri.

Pilih file Hotel-Pemesanan-Klasifikasi.flow untuk mengimpor file aliran ke Data Wrangler.

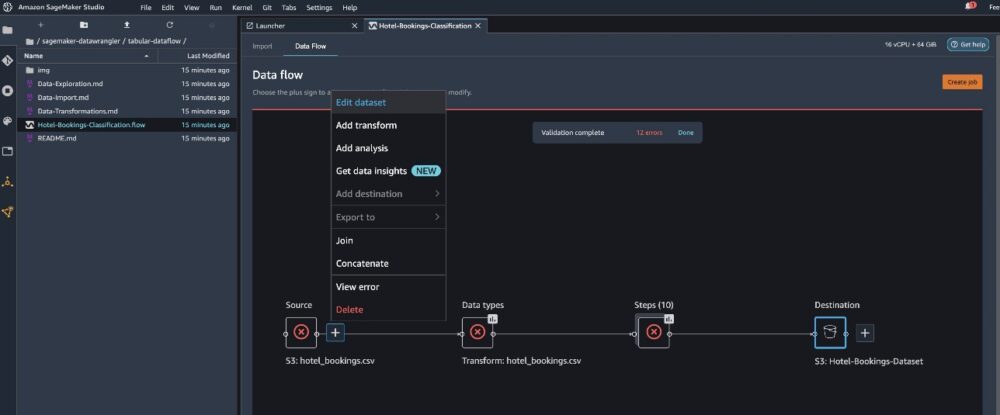

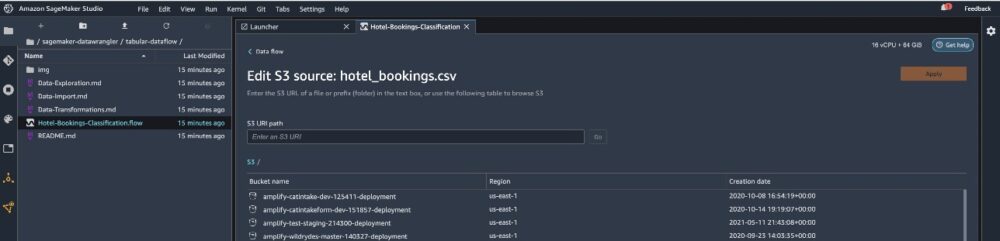

Jika Anda menggunakan deret waktu atau menggabungkan alur data, alur akan muncul sebagai nama yang berbeda. Setelah alur diimpor, Anda akan melihat tangkapan layar berikut. Ini menunjukkan kesalahan kepada kami karena kami perlu memastikan bahwa file aliran mengarah ke sumber data yang benar Layanan Penyimpanan Sederhana Amazon (Amazon S3).

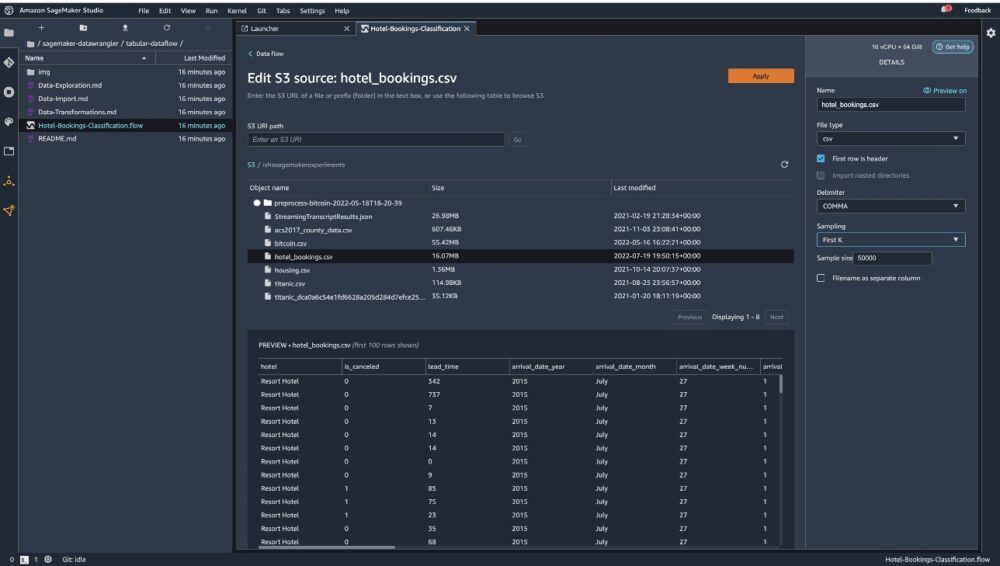

Pilih Edit kumpulan data untuk memunculkan semua bucket S3 Anda. Selanjutnya, pilih dataset hotel_bookings.csv dari bucket S3 Anda untuk dijalankan melalui aliran data tabel.

Perhatikan bahwa jika Anda menggunakan bergabung aliran data, Anda mungkin harus mengimpor beberapa set data ke Data Wrangler

Di panel kanan, pastikan GUGUS KALIMAT dipilih sebagai pembatas dan Sampling diatur ke K . pertama. Kumpulan data kami cukup kecil untuk menjalankan transformasi Data Wrangler pada kumpulan data lengkap, tetapi kami ingin menyoroti bagaimana Anda dapat mengimpor kumpulan data. Jika Anda memiliki kumpulan data yang besar, pertimbangkan untuk menggunakan pengambilan sampel. Memilih impor untuk mengimpor set data ini ke Data Wrangler.

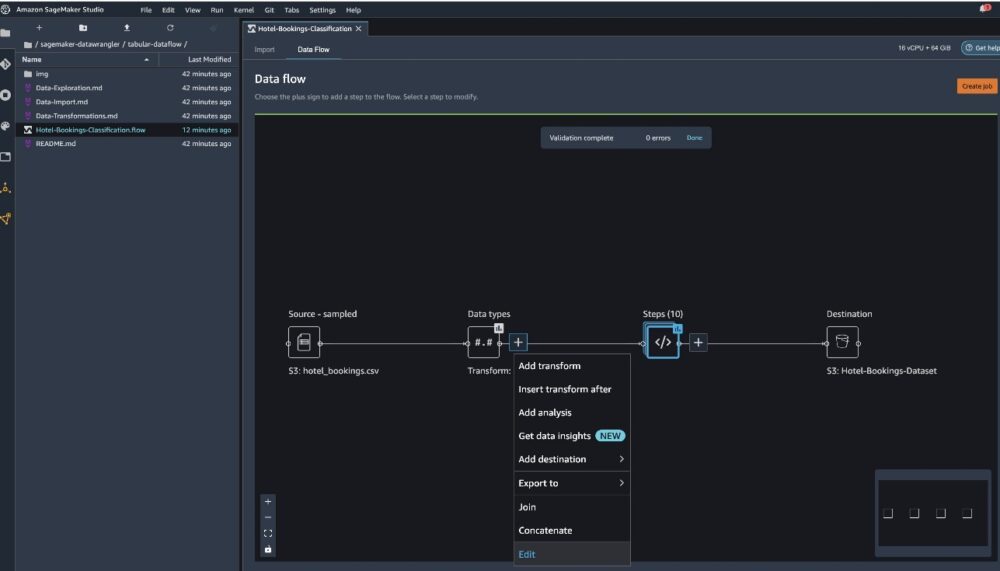

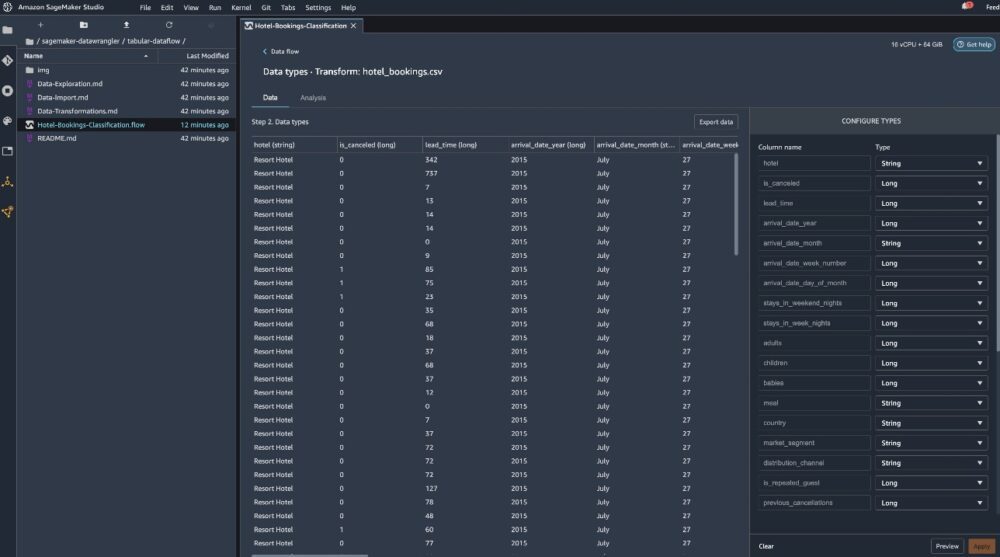

Setelah dataset diimpor, Data Wrangler secara otomatis memvalidasi dataset dan mendeteksi tipe data. Anda dapat melihat bahwa kesalahan telah hilang karena kami menunjuk ke kumpulan data yang benar. Editor alur sekarang menampilkan dua blok yang memperlihatkan bahwa data diimpor dari sumber dan jenis data dikenali. Anda juga dapat mengedit tipe data jika diperlukan.

Tangkapan layar berikut menunjukkan tipe data kami.

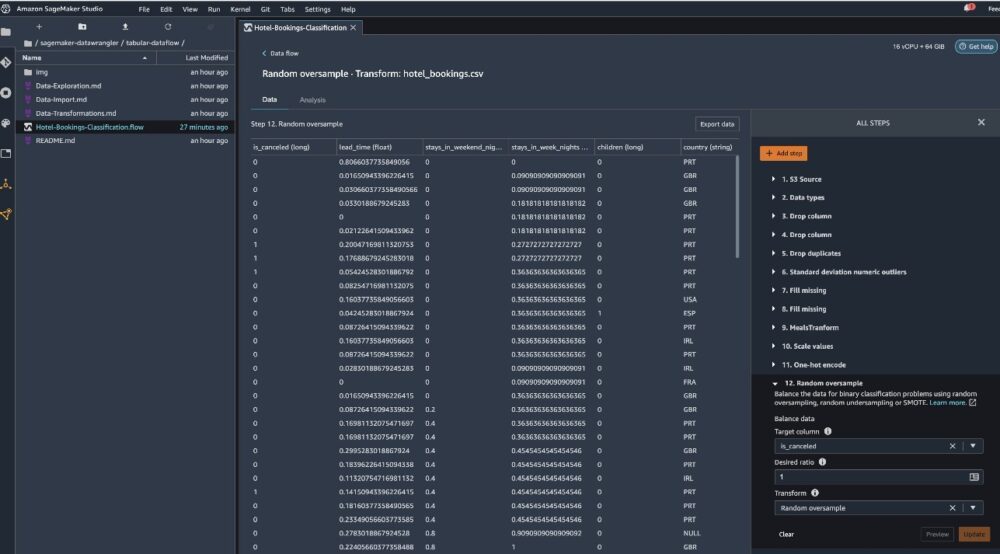

Mari kita lihat beberapa transformasi yang dilakukan sebagai bagian dari aliran tabel ini. Jika Anda menggunakan seri waktu or bergabung aliran data, periksa beberapa transformasi umum di GitHub repo. Kami melakukan beberapa analisis data eksplorasi dasar menggunakan laporan wawasan data yang mempelajari kebocoran target dan kolinearitas fitur dalam kumpulan data, analisis ringkasan tabel, dan kemampuan pemodelan cepat. Jelajahi langkah-langkah di GitHub repo.

Sekarang kami menjatuhkan kolom berdasarkan rekomendasi yang diberikan oleh Wawasan Data dan Laporan Kualitas.

- Untuk kebocoran target, jatuhkan status_reservasi.

- Untuk kolom yang berlebihan, jatuhkan daftar_hari_menunggu, hotel, tipe_kamar_pesanan, tanggal_kedatangan_bulan, tanggal_status_reservasi, bayi, dan tanggal_kedatangan_hari_bulan_.

- Berdasarkan hasil korelasi linier, jatuhkan kolom nomor_tanggal_kedatangan_minggu dan kedatangan_tanggal_tahun karena nilai korelasi untuk pasangan fitur (kolom) ini lebih besar dari ambang batas yang disarankan yaitu 0.90.

- Berdasarkan hasil korelasi non linier, turun status_reservasi. Kolom ini sudah ditandai untuk dijatuhkan berdasarkan analisis kebocoran target.

- Proses nilai numerik (min-max scaling) untuk lead_time, stays_in_weekend_nights, stays_in_weekday_nights, is_repeated_guest, prev_cancellations, prev_bookings_not_canceled, booking_changes, adr, total_of_specical_requests, dan diperlukan_mobil_parkir_ruang.

- Variabel kategori enkode one-hot seperti makan, tamu_berulang, segmen_pasar, tipe_kamar_ditugaskan, tipe_setoran, dan Tipe pelanggan.

- Seimbangkan variabel target Oversample acak untuk ketidakseimbangan kelas. Gunakan kemampuan pemodelan cepat untuk menangani outlier dan nilai yang hilang.

Ekspor ke Amazon S3

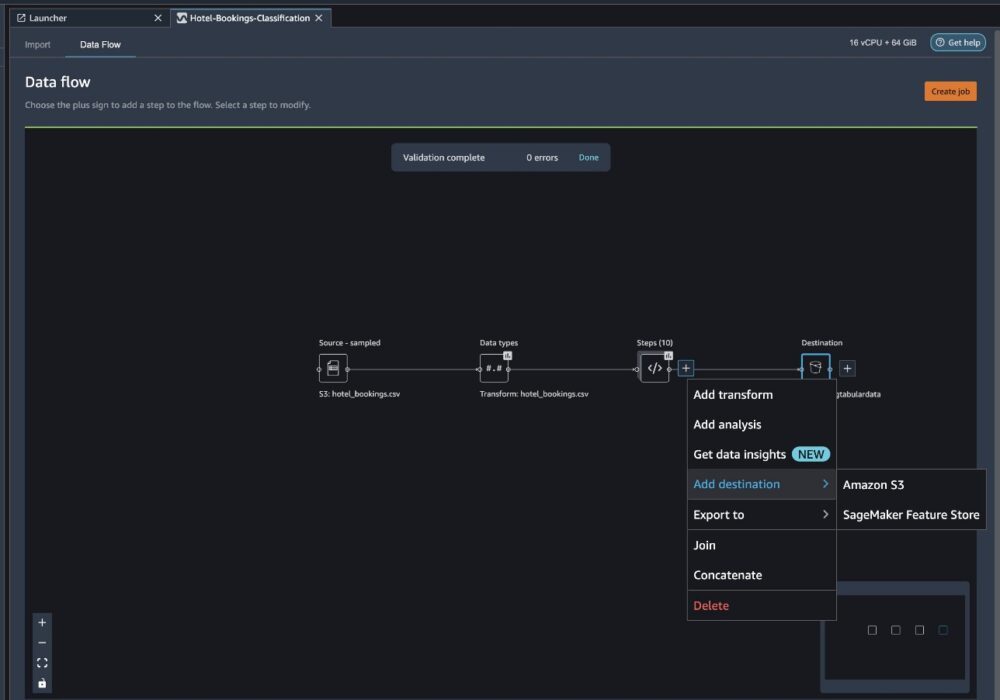

Sekarang kami telah melalui berbagai transformasi dan siap untuk mengekspor data ke Amazon S3. Opsi ini membuat tugas pemrosesan SageMaker, yang menjalankan alur pemrosesan Data Wrangler dan menyimpan kumpulan data yang dihasilkan ke bucket S3 yang ditentukan. Ikuti langkah selanjutnya untuk menyiapkan ekspor ke Amazon S3:

Pilih tanda plus di sebelah kumpulan elemen transformasi dan pilih Tambahkan tujuan, kemudian Amazon S3.

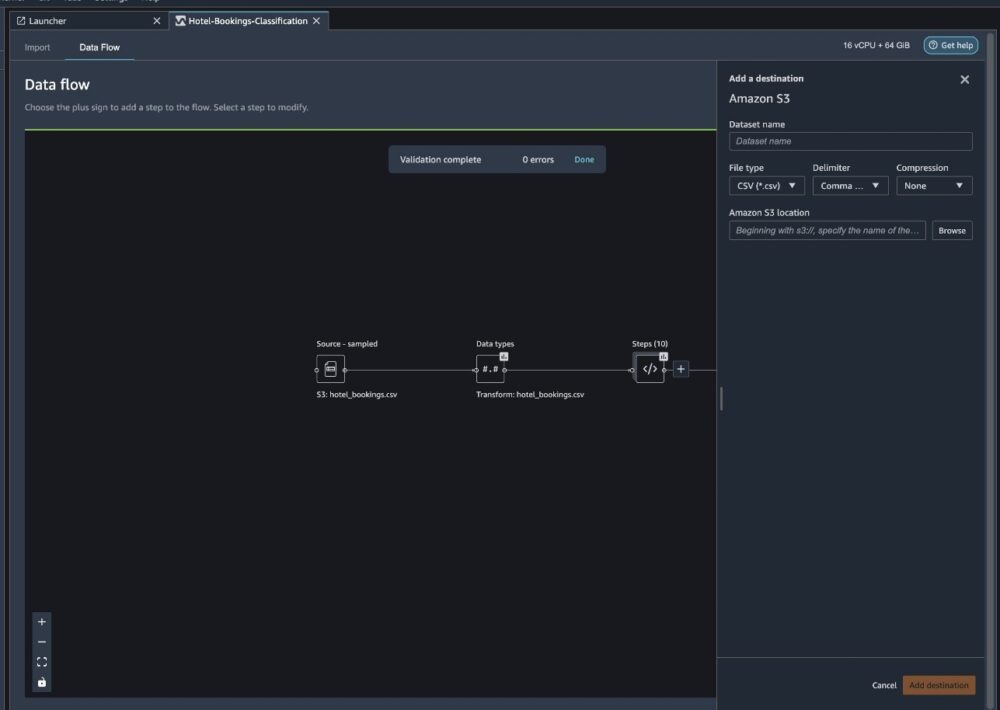

- Untuk Nama kumpulan data, masukkan nama untuk kumpulan data baru, misalnya

NYC_export. - Untuk Jenis berkas, pilih CSV.

- Untuk Pembatas, pilih Koma.

- Untuk Kompresi, pilih None.

- Untuk Lokasi Amazon S3, gunakan nama bucket yang sama dengan yang kita buat sebelumnya.

- Pilih Tambahkan tujuan.

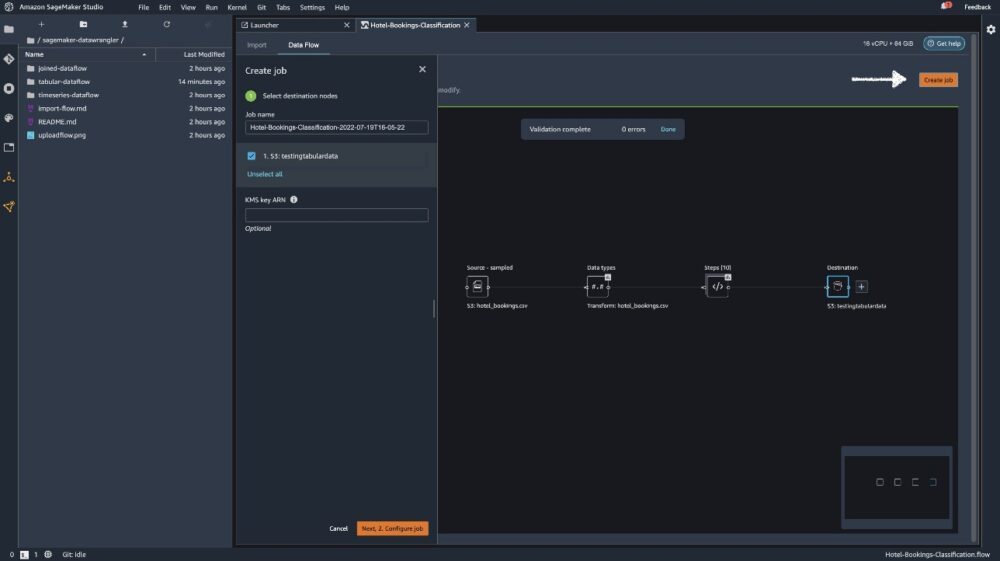

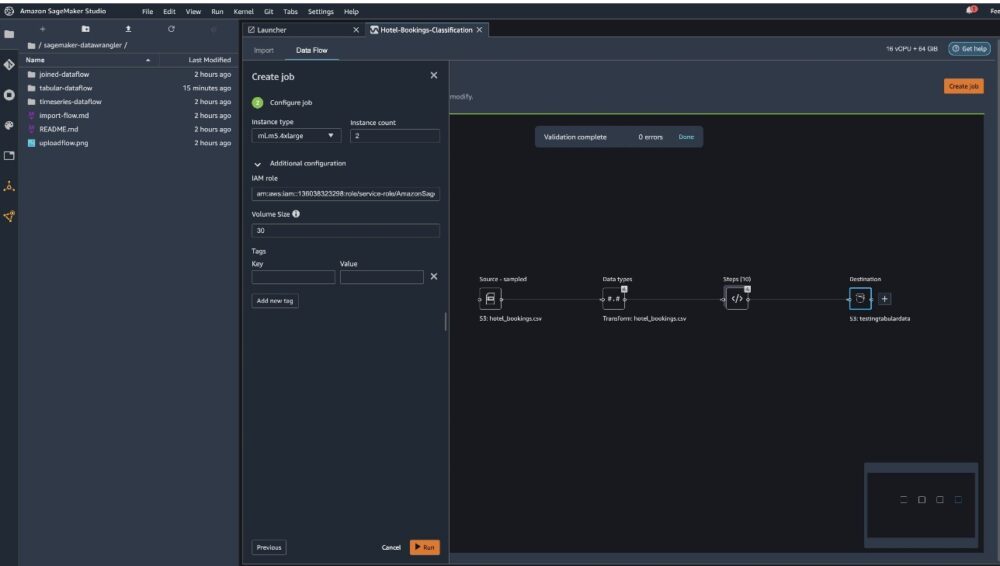

Pilih Ciptakan pekerjaan.

Untuk Nama Pekerjaan, masukkan nama atau pertahankan opsi yang dibuat secara otomatis dan pilih tujuan. Tujuan kita hanya satu, S3:testingtabulardata, tetapi Anda mungkin memiliki beberapa tujuan dari langkah yang berbeda dalam alur kerja Anda. Tinggalkan ARN kunci KMS bidang kosong dan pilih Selanjutnya.

Sekarang Anda harus mengonfigurasi kapasitas komputasi untuk suatu pekerjaan. Anda dapat menyimpan semua nilai default untuk contoh ini.

- Untuk Jenis instance, gunakan ml.m5.4xlarge.

- Untuk Jumlah instance, gunakan 2.

- Anda dapat menjelajahi Konfigurasi tambahan, tetapi pertahankan pengaturan default.

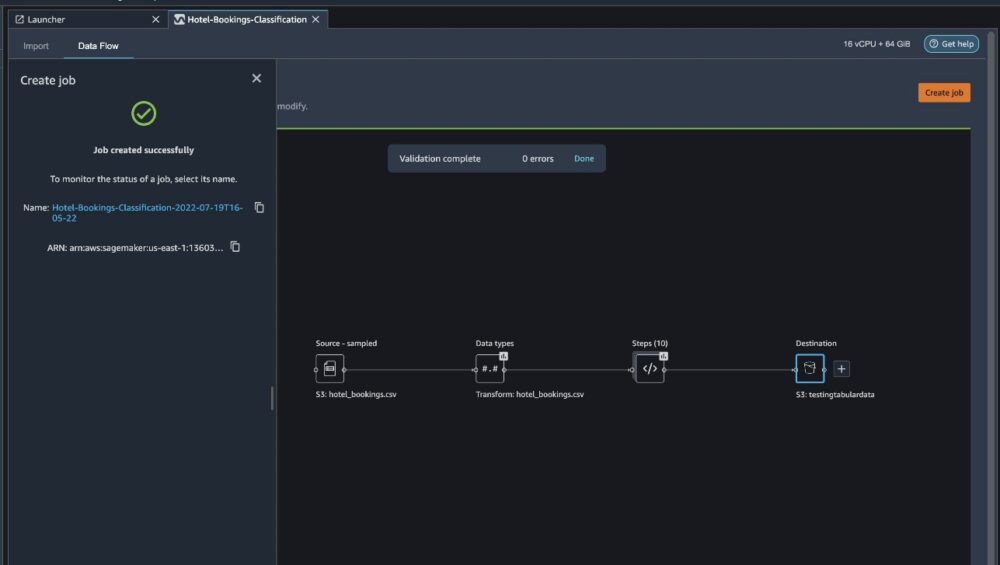

- Pilih Run.

Sekarang pekerjaan Anda telah dimulai, dan perlu waktu untuk memproses data sebesar 6 GB sesuai alur pemrosesan Data Wrangler kami. Biaya untuk pekerjaan ini sekitar $2 USD, karena biaya ml.m5.4xlarge $0.922 USD per jam dan kami menggunakan dua di antaranya.

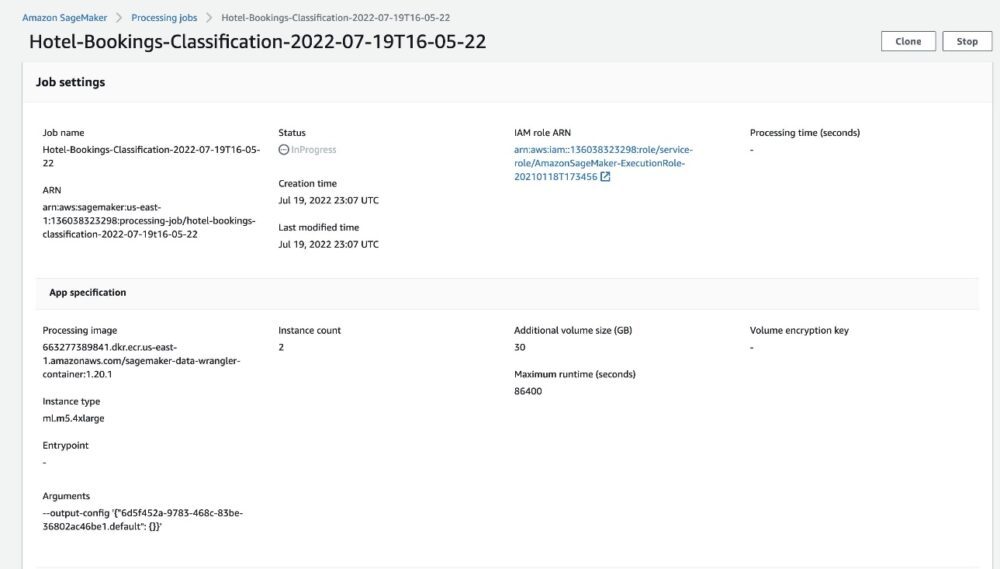

Jika Anda memilih nama pekerjaan, Anda akan dialihkan ke jendela baru dengan detail pekerjaan.

Di halaman detail pekerjaan, Anda dapat melihat semua parameter dari langkah sebelumnya.

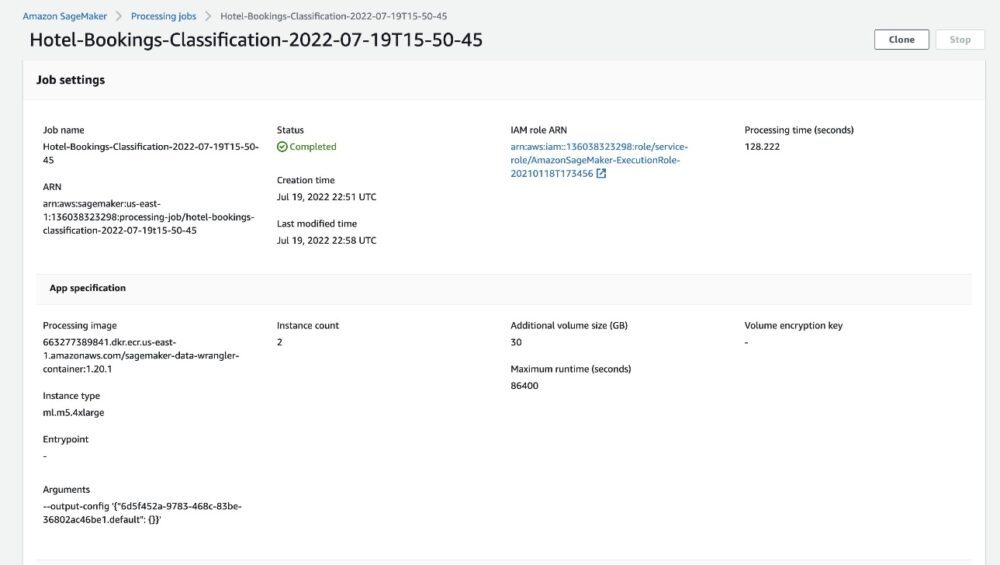

Saat status pekerjaan berubah menjadi Selesai, Anda juga dapat memeriksa Waktu pemrosesan (detik) nilai. Pekerjaan pemrosesan ini membutuhkan waktu sekitar 5–10 menit untuk diselesaikan.

Saat pekerjaan selesai, file keluaran kereta dan pengujian tersedia di folder keluaran S3 yang sesuai. Anda dapat menemukan lokasi keluaran dari konfigurasi tugas pemrosesan.

Setelah tugas pemrosesan Data Wrangler selesai, kami dapat memeriksa hasil yang disimpan di bucket S3 kami. Jangan lupa untuk mengupdate job_name variabel dengan nama pekerjaan Anda.

Anda sekarang dapat menggunakan data yang diekspor ini untuk menjalankan model ML.

Membersihkan

Hapus bucket S3 Anda dan Anda Aliran data Wrangler untuk menghapus sumber daya yang mendasarinya dan mencegah biaya yang tidak diinginkan setelah Anda menyelesaikan percobaan.

Kesimpulan

Dalam postingan ini, kami menunjukkan bagaimana Anda dapat mengimpor aliran data pra-bangun tabular ke Data Wrangler, menghubungkannya dengan kumpulan data kami, dan mengekspor hasilnya ke Amazon S3. Jika kasus penggunaan Anda mengharuskan Anda untuk memanipulasi data deret waktu atau menggabungkan beberapa kumpulan data, Anda dapat menelusuri alur sampel bawaan lainnya di GitHub repo.

Setelah Anda mengimpor alur kerja persiapan data bawaan, Anda dapat mengintegrasikannya dengan Amazon SageMaker Processing, Pipa Amazon SageMaker, dan Toko Fitur Amazon SageMaker untuk menyederhanakan tugas pemrosesan, pembagian, dan penyimpanan data pelatihan ML. Anda juga dapat mengekspor contoh aliran data ini ke skrip Python dan membuat pipeline persiapan data ML khusus, sehingga mempercepat kecepatan rilis Anda.

Kami mendorong Anda untuk memeriksa kami Repositori GitHub untuk mendapatkan praktik langsung dan menemukan cara baru untuk meningkatkan akurasi model! Untuk mempelajari lebih lanjut tentang SageMaker, kunjungi Panduan Pengembang Amazon SageMaker.

Tentang Penulis

Isya Dua adalah Arsitek Solusi Senior yang berbasis di San Francisco Bay Area. Dia membantu pelanggan AWS Enterprise tumbuh dengan memahami tujuan dan tantangan mereka, dan memandu mereka tentang bagaimana mereka dapat merancang aplikasi mereka dengan cara cloud-native sambil memastikan mereka tangguh dan dapat diskalakan. Dia sangat tertarik dengan teknologi pembelajaran mesin dan kelestarian lingkungan.

Isya Dua adalah Arsitek Solusi Senior yang berbasis di San Francisco Bay Area. Dia membantu pelanggan AWS Enterprise tumbuh dengan memahami tujuan dan tantangan mereka, dan memandu mereka tentang bagaimana mereka dapat merancang aplikasi mereka dengan cara cloud-native sambil memastikan mereka tangguh dan dapat diskalakan. Dia sangat tertarik dengan teknologi pembelajaran mesin dan kelestarian lingkungan.

- AI

- ai seni

- generator seni ai

- punya robot

- Amazon SageMaker

- Pengatur Data Amazon SageMaker

- kecerdasan buatan

- sertifikasi kecerdasan buatan

- kecerdasan buatan dalam perbankan

- robot kecerdasan buatan

- robot kecerdasan buatan

- perangkat lunak kecerdasan buatan

- Pembelajaran Mesin AWS

- blockchain

- konferensi blockchain

- kecerdasan

- kecerdasan buatan percakapan

- konferensi kripto

- dall's

- belajar mendalam

- google itu

- Mesin belajar

- plato

- plato ai

- Kecerdasan Data Plato

- Permainan Plato

- Data Plato

- permainan plato

- skala ai

- sintaksis

- zephyrnet.dll