Laporan radiologi adalah dokumen yang komprehensif dan panjang yang menjelaskan dan menginterpretasikan hasil pemeriksaan pencitraan radiologi. Dalam alur kerja yang umum, ahli radiologi mengawasi, membaca, dan menafsirkan gambar, dan kemudian secara ringkas merangkum temuan-temuan utama. Ringkasan (atau tayangan) adalah bagian terpenting dari laporan karena membantu dokter dan pasien fokus pada isi penting laporan yang berisi informasi untuk pengambilan keputusan klinis. Menciptakan kesan yang jelas dan berdampak membutuhkan lebih banyak upaya daripada sekedar menyatakan kembali temuan. Oleh karena itu, keseluruhan prosesnya melelahkan, memakan waktu, dan rentan terhadap kesalahan. Seringkali dibutuhkan waktu bertahun-tahun latihan bagi dokter untuk mengumpulkan keahlian yang cukup dalam menulis ringkasan laporan radiologi yang ringkas dan informatif, yang selanjutnya menyoroti pentingnya otomatisasi proses. Selain itu, pembuatan ringkasan temuan laporan secara otomatis sangat penting untuk pelaporan radiologi. Hal ini memungkinkan terjemahan laporan ke dalam bahasa yang dapat dibaca manusia, sehingga mengurangi beban pasien dalam membaca laporan yang panjang dan tidak jelas.

Untuk mengatasi masalah ini, kami mengusulkan penggunaan AI generatif, yaitu jenis AI yang dapat membuat konten dan ide baru, termasuk percakapan, cerita, gambar, video, dan musik. AI Generatif didukung oleh model pembelajaran mesin (ML)—model sangat besar yang telah dilatih sebelumnya mengenai data dalam jumlah besar dan biasa disebut sebagai model dasar (FM). Kemajuan terkini dalam ML (khususnya penemuan arsitektur jaringan saraf berbasis transformator) telah menyebabkan munculnya model yang berisi miliaran parameter atau variabel. Solusi yang diusulkan dalam postingan ini menggunakan penyempurnaan model bahasa besar (LLM) terlatih untuk membantu menghasilkan ringkasan berdasarkan temuan dalam laporan radiologi.

Postingan ini menunjukkan strategi untuk menyempurnakan LLM yang tersedia untuk umum untuk tugas peringkasan laporan radiologi menggunakan layanan AWS. LLM telah menunjukkan kemampuan luar biasa dalam pemahaman dan pembuatan bahasa alami, berfungsi sebagai model dasar yang dapat disesuaikan dengan berbagai domain dan tugas. Ada manfaat signifikan menggunakan model terlatih. Hal ini mengurangi biaya komputasi, mengurangi jejak karbon, dan memungkinkan Anda menggunakan model canggih tanpa harus melatihnya dari awal.

Solusi kami menggunakan FLAN-T5 XL FM, menggunakan Mulai Lompatan Amazon SageMaker, yang merupakan hub ML yang menawarkan algoritme, model, dan solusi ML. Kami mendemonstrasikan cara melakukannya menggunakan buku catatan Studio Amazon SageMaker. Menyempurnakan model yang telah dilatih sebelumnya melibatkan pelatihan lebih lanjut pada data tertentu untuk meningkatkan performa pada tugas yang berbeda namun terkait. Solusi ini melibatkan penyempurnaan model FLAN-T5 XL, yang merupakan versi yang disempurnakan T5 (Transformator Transfer Teks-ke-Teks) LLM tujuan umum. T5 mengubah tugas pemrosesan bahasa alami (NLP) menjadi format teks-ke-teks terpadu, berbeda dengan BERTI-model gaya yang hanya dapat menampilkan label kelas atau rentang masukan. Ini disesuaikan untuk tugas ringkasan pada 91,544 laporan radiologi teks bebas yang diperoleh dari Kumpulan data MIMIC-CXR.

Ikhtisar solusi

Pada bagian ini, kami membahas komponen kunci dari solusi kami: memilih strategi untuk tugas tersebut, menyempurnakan LLM, dan mengevaluasi hasilnya. Kami juga mengilustrasikan arsitektur solusi dan langkah-langkah untuk mengimplementasikan solusi tersebut.

Identifikasi strategi untuk tugas tersebut

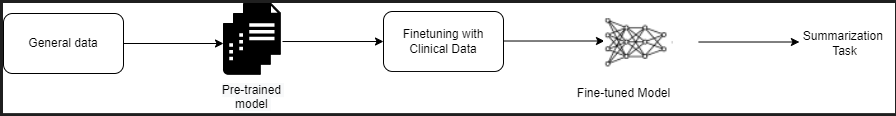

Ada berbagai strategi untuk melakukan tugas mengotomatiskan peringkasan laporan klinis. Misalnya, kita dapat menggunakan model bahasa khusus yang telah dilatih sebelumnya mengenai laporan klinis dari awal. Sebagai alternatif, kita dapat secara langsung menyempurnakan model bahasa tujuan umum yang tersedia untuk umum untuk melakukan tugas klinis. Penggunaan model agnostik domain yang disesuaikan mungkin diperlukan dalam situasi di mana pelatihan a model bahasa dari awal terlalu mahal. Dalam solusi ini, kami mendemonstrasikan pendekatan terakhir dengan menggunakan model FLAN -T5 XL, yang kami sesuaikan untuk tugas klinis dalam merangkum laporan radiologi. Diagram berikut menggambarkan alur kerja model.

Laporan radiologi pada umumnya terorganisir dengan baik dan ringkas. Laporan semacam itu sering kali memiliki tiga bagian utama:

- Latar Belakang – Memberikan informasi umum tentang demografi pasien dengan informasi penting tentang pasien, riwayat klinis, dan riwayat kesehatan yang relevan serta rincian prosedur pemeriksaan

- Temuan – Menyajikan diagnosis dan hasil ujian terperinci

- pencetakan – Secara ringkas merangkum temuan yang paling menonjol atau interpretasi temuan dengan penilaian signifikansi dan potensi diagnosis berdasarkan kelainan yang diamati

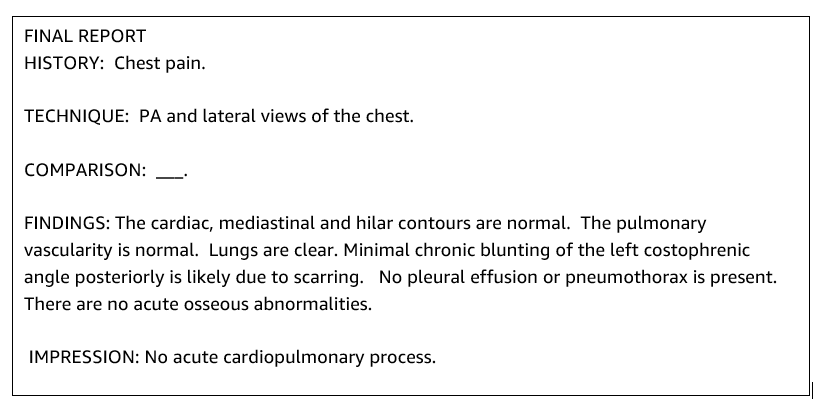

Dengan menggunakan bagian temuan dalam laporan radiologi, solusinya menghasilkan bagian kesan, yang sesuai dengan ringkasan dokter. Gambar berikut adalah contoh laporan radiologi.

Sempurnakan LLM tujuan umum untuk tugas klinis

Dalam solusi ini, kami menyempurnakan model FLAN-T5 XL (menyesuaikan semua parameter model dan mengoptimalkannya untuk tugas tersebut). Kami menyempurnakan model menggunakan kumpulan data domain klinis MIMIK-CXR, yang merupakan kumpulan data radiografi dada yang tersedia untuk umum. Untuk menyempurnakan model ini melalui SageMaker Jumpstart, contoh berlabel harus disediakan dalam bentuk pasangan {prompt, penyelesaian}. Dalam hal ini, kami menggunakan pasangan {Temuan, Kesan} dari laporan asli dalam kumpulan data MIMIC-CXR. Untuk menyimpulkan, kami menggunakan prompt seperti yang ditunjukkan pada contoh berikut:

![]()

Model ini disempurnakan pada komputasi yang dipercepat ml.p3.16xbesar misalnya dengan 64 CPU virtual dan memori 488 GiB. Untuk validasi, 5% dari kumpulan data dipilih secara acak. Waktu yang berlalu dari tugas pelatihan SageMaker dengan penyesuaian adalah 38,468 detik (sekitar 11 jam).

Evaluasi hasilnya

Ketika pelatihan selesai, penting untuk mengevaluasi hasilnya. Untuk analisis kuantitatif dari kesan yang dihasilkan, kami menggunakan RED (Recall-Oriented Understudy for Gisting Evaluation), metrik yang paling umum digunakan untuk mengevaluasi ringkasan. Metrik ini membandingkan ringkasan yang dibuat secara otomatis dengan referensi atau kumpulan ringkasan atau terjemahan referensi (yang dibuat oleh manusia). ROUGE1 mengacu pada tumpang tindih unigram (setiap kata) antara kandidat (keluaran model) dan ringkasan referensi. ROUGE2 mengacu pada tumpang tindih bigram (dua kata) antara ringkasan kandidat dan referensi. ROUGEL adalah metrik tingkat kalimat dan mengacu pada urutan umum terpanjang (LCS) antara dua bagian teks. Itu mengabaikan baris baru dalam teks. ROUGELsum adalah metrik tingkat ringkasan. Untuk metrik ini, baris baru dalam teks tidak diabaikan namun ditafsirkan sebagai batas kalimat. LCS kemudian dihitung antara setiap pasangan referensi dan kalimat kandidat, dan kemudian LCS gabungan dihitung. Untuk menggabungkan skor-skor ini pada sekumpulan referensi dan kalimat kandidat tertentu, rata-ratanya dihitung.

Panduan dan arsitektur

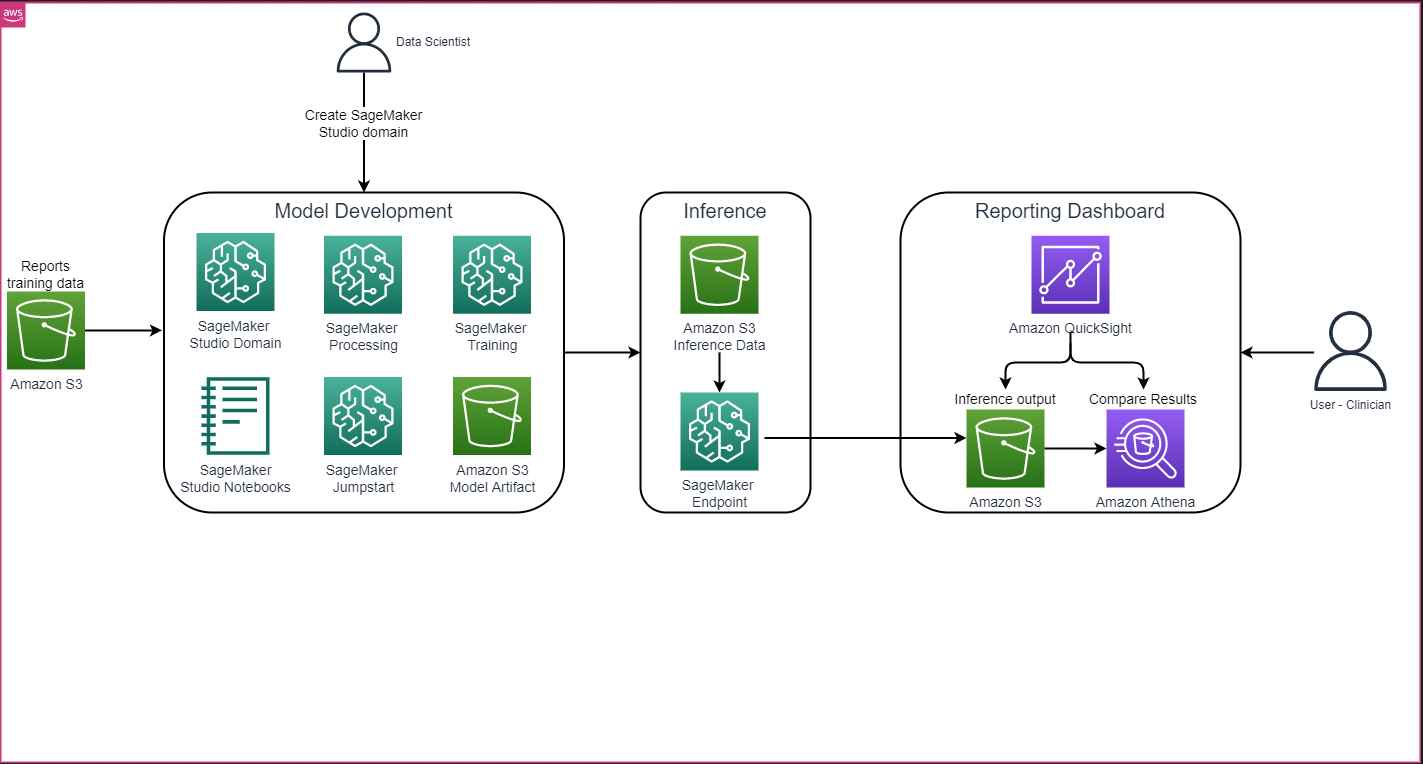

Arsitektur solusi keseluruhan seperti yang ditunjukkan pada gambar berikut terutama terdiri dari lingkungan pengembangan model yang menggunakan SageMaker Studio, penerapan model dengan titik akhir SageMaker, dan dasbor pelaporan menggunakan Amazon QuickSight.

Di bagian berikut, kami mendemonstrasikan penyempurnaan LLM yang tersedia di SageMaker JumpStart untuk meringkas tugas khusus domain melalui SageMaker Python SDK. Secara khusus, kami membahas topik-topik berikut:

- Langkah-langkah untuk menyiapkan lingkungan pengembangan

- Ikhtisar kumpulan data laporan radiologi yang modelnya telah disesuaikan dan dievaluasi

- Demonstrasi menyempurnakan model FLAN-T5 XL menggunakan SageMaker JumpStart secara terprogram dengan SageMaker Python SDK

- Inferensi dan evaluasi model yang telah dilatih sebelumnya dan disempurnakan

- Perbandingan hasil dari model terlatih dan model yang telah disempurnakan

Solusinya tersedia di Menghasilkan Tayangan Laporan Radiologi menggunakan AI generatif dengan Model Bahasa Besar di AWS GitHub repo.

Prasyarat

Untuk memulai, Anda memerlukan Akun AWS di mana Anda dapat menggunakan SageMaker Studio. Anda perlu membuat profil pengguna untuk SageMaker Studio jika Anda belum memilikinya.

Jenis instance pelatihan yang digunakan dalam postingan ini adalah ml.p3.16xlarge. Perhatikan bahwa tipe instans p3 memerlukan peningkatan batas kuota layanan.

Grafik Kumpulan data MIMIC CXR dapat diakses melalui perjanjian penggunaan data, yang memerlukan pendaftaran pengguna dan penyelesaian proses kredensial.

Siapkan lingkungan pengembangan

Untuk menyiapkan lingkungan pengembangan, Anda membuat bucket S3, mengonfigurasi notebook, membuat titik akhir dan menyebarkan model, serta membuat dasbor QuickSight.

Buat ember S3

Buat ember S3 bernama llm-radiology-bucket untuk menampung kumpulan data pelatihan dan evaluasi. Ini juga akan digunakan untuk menyimpan artefak model selama pengembangan model.

Konfigurasikan buku catatan

Selesaikan langkah-langkah berikut:

- Luncurkan SageMaker Studio dari konsol SageMaker atau Antarmuka Baris Perintah AWS (AWS CLI).

Untuk informasi selengkapnya tentang orientasi ke domain, lihat Masuk ke Domain Amazon SageMaker.

- Buat yang baru Buku catatan SageMaker Studio untuk membersihkan data laporan dan menyempurnakan model. Kami menggunakan instance notebook ml.t3.medium 2vCPU+4GiB dengan kernel Python 3.

- Di dalam notebook, instal paket yang relevan seperti

nest-asyncio,IPyWidgets(untuk widget interaktif untuk notebook Jupyter), dan SageMaker Python SDK:

Untuk menyimpulkan model yang telah dilatih sebelumnya dan disempurnakan, buat titik akhir dan terapkan setiap model dalam buku catatan sebagai berikut:

- Buat objek model dari kelas Model yang dapat disebarkan ke titik akhir HTTPS.

- Buat titik akhir HTTPS dengan objek model yang sudah dibuat sebelumnya

deploy()Metode:

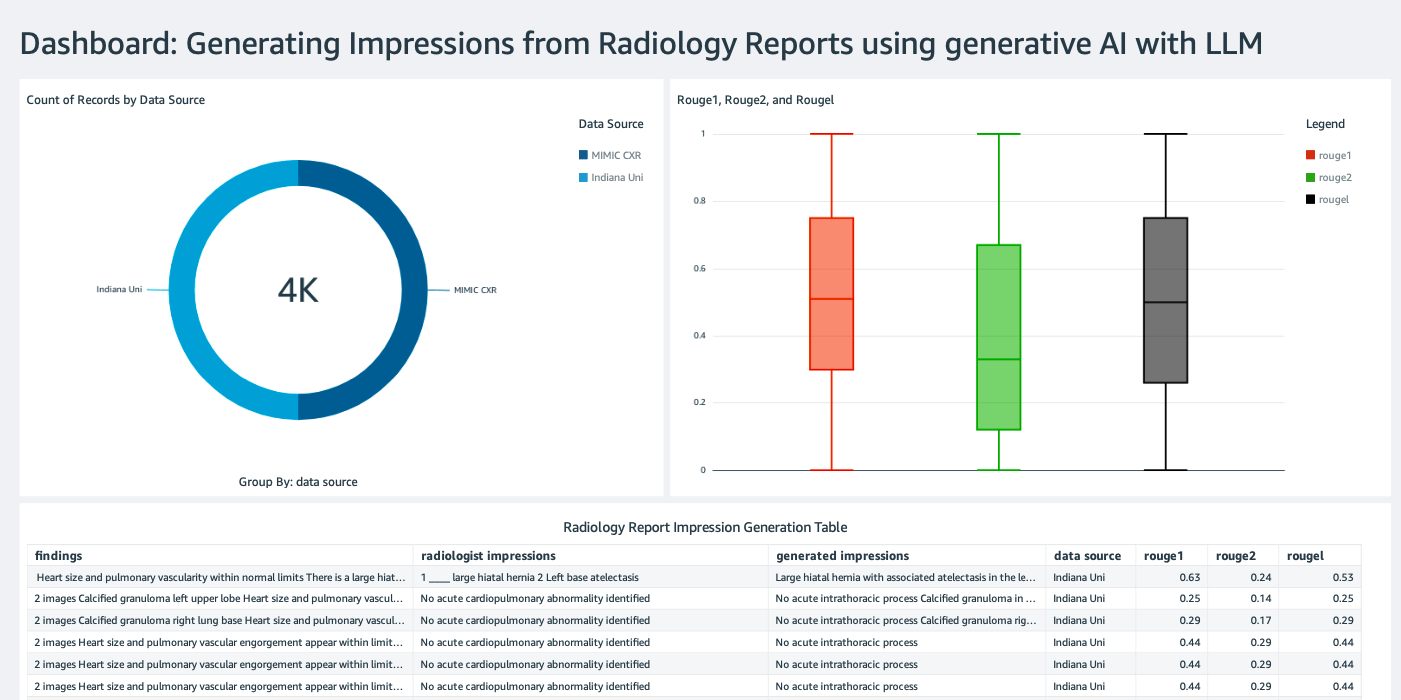

Buat dasbor QuickSight

Membuat Dasbor QuickSight dengan sumber data Athena dengan hasil inferensi masuk Layanan Penyimpanan Sederhana Amazon (Amazon S3) untuk membandingkan hasil inferensi dengan kebenaran dasar. Tangkapan layar berikut menunjukkan contoh dasbor kami.

Kumpulan data laporan radiologi

Model sekarang telah disempurnakan, semua parameter model disesuaikan pada 91,544 laporan yang diunduh dari Kumpulan data MIMIC-CXR v2.0. Karena kami hanya menggunakan data teks laporan radiologi, kami hanya mengunduh satu file laporan terkompresi (mimic-cxr-reports.zip) dari situs web MIMIC-CXR. Sekarang kami mengevaluasi model yang telah disempurnakan pada 2,000 laporan (disebut sebagai dev1 kumpulan data) dari yang terpisah mengulurkan subset dari kumpulan data ini. Kami menggunakan 2,000 laporan radiologi lainnya (disebut sebagai dev2) untuk mengevaluasi model yang disempurnakan dari koleksi rontgen dada dari Jaringan rumah sakit Universitas Indiana. Semua kumpulan data dibaca sebagai file JSON dan diunggah ke bucket S3 yang baru dibuat llm-radiology-bucket. Perhatikan bahwa semua kumpulan data secara default tidak berisi Informasi Kesehatan yang Dilindungi (PHI); semua informasi sensitif diganti dengan tiga garis bawah berturut-turut (___) oleh penyedia.

Sempurnakan dengan SageMaker Python SDK

Untuk menyempurnakan, model_id ditentukan sebagai huggingface-text2text-flan-t5-xl dari daftar model SageMaker JumpStart. Itu training_instance_type diatur sebagai ml.p3.16xlarge dan inference_instance_type sebagai ml.g5.2xlarge. Data pelatihan dalam format JSON dibaca dari bucket S3. Langkah selanjutnya adalah menggunakan model_id yang dipilih untuk mengekstrak URI sumber daya SageMaker JumpStart, termasuk image_uri (The Registry Kontainer Elastis Amazon (Amazon ECR) URI untuk image Docker), model_uri (artefak model terlatih URI Amazon S3), dan script_uri (skrip pelatihan):

Selain itu, lokasi keluaran diatur sebagai folder dalam bucket S3.

Hanya satu hyperparameter, epoch, yang diubah menjadi 3, dan sisanya disetel sebagai default:

Metrik pelatihan seperti eval_loss (untuk kehilangan validasi), loss (untuk kerugian pelatihan), dan epoch yang akan dilacak didefinisikan dan dicantumkan:

Kami menggunakan URI sumber daya SageMaker JumpStart (image_uri, model_uri, script_uri) diidentifikasi sebelumnya untuk membuat estimator dan menyempurnakannya pada himpunan data pelatihan dengan menentukan jalur S3 dari himpunan data tersebut. Kelas Estimator membutuhkan entry_point parameter. Dalam hal ini, JumpStart menggunakan transfer_learning.py. Tugas pelatihan gagal dijalankan jika nilai ini tidak ditetapkan.

Pekerjaan pelatihan ini dapat memakan waktu berjam-jam untuk diselesaikan; oleh karena itu, disarankan untuk mengatur parameter tunggu ke False dan memantau status tugas pelatihan di konsol SageMaker. Menggunakan TrainingJobAnalytics berfungsi untuk melacak metrik pelatihan pada berbagai stempel waktu:

Terapkan titik akhir inferensi

Untuk menarik perbandingan, kami menerapkan titik akhir inferensi untuk model yang telah dilatih sebelumnya dan model yang telah disempurnakan.

Pertama, ambil URI gambar Docker inferensi menggunakan model_id, dan gunakan URI ini untuk membuat instance model SageMaker dari model terlatih. Terapkan model terlatih dengan membuat titik akhir HTTPS dengan objek model yang sudah dibuat sebelumnya deploy() metode. Untuk menjalankan inferensi melalui SageMaker API, pastikan untuk lulus kelas Predictor.

Ulangi langkah sebelumnya untuk membuat instans model SageMaker dari model yang telah disempurnakan dan membuat titik akhir untuk menyebarkan model tersebut.

Evaluasi modelnya

Pertama, atur panjang teks yang diringkas, jumlah keluaran model (harus lebih besar dari 1 jika beberapa ringkasan perlu dibuat), dan jumlah balok untuk pencarian sinar.

Buat permintaan inferensi sebagai payload JSON dan gunakan untuk menanyakan titik akhir untuk model yang telah dilatih sebelumnya dan disempurnakan.

Hitung agregatnya skor PEMERAH (ROUGE1, ROUGE2, ROUGEL, ROUGELsum) seperti yang dijelaskan sebelumnya.

Bandingkan hasilnya

Tabel berikut menggambarkan hasil evaluasi pada dev1 dan dev2 kumpulan data. Hasil evaluasi pada dev1 (2,000 temuan dari Laporan Radiologi MIMIC CXR) menunjukkan peningkatan sekitar 38 poin persentase dalam rata-rata agregat ROUGE1 dan ROUGE2 skor dibandingkan dengan model yang telah dilatih sebelumnya. Untuk dev2, peningkatan sebesar 31 poin persentase dan 25 poin persentase diamati pada skor ROUGE1 dan ROUGE2. Secara keseluruhan, penyesuaian menghasilkan peningkatan sebesar 38.2 poin persentase dan 31.3 poin persentase pada skor ROUGELsum untuk dev1 dan dev2 kumpulan data, masing-masing.

|

Evaluasi Dataset |

Model yang sudah terlatih | Model yang disempurnakan | ||||||

| PEMERAH1 | PEMERAH2 | PEMERAH | ROUGELsum | PEMERAH1 | PEMERAH2 | PEMERAH | ROUGELsum | |

dev1 |

0.2239 | 0.1134 | 0.1891 | 0.1891 | 0.6040 | 0.4800 | 0.5705 | 0.5708 |

dev2 |

0.1583 | 0.0599 | 0.1391 | 0.1393 | 0.4660 | 0.3125 | 0.4525 | 0.4525 |

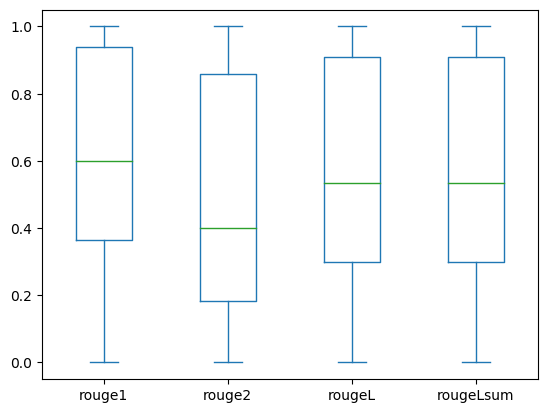

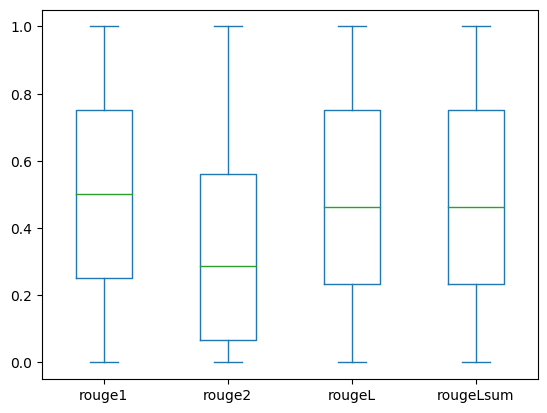

Plot kotak berikut menggambarkan distribusi skor ROUGE untuk dev1 dan dev2 kumpulan data dievaluasi menggunakan model yang disempurnakan.

|

|

(sebuah): dev1 |

(B): dev2 |

Tabel berikut menunjukkan bahwa skor ROUGE untuk kumpulan data evaluasi memiliki median dan mean yang kurang lebih sama sehingga terdistribusi secara simetris.

| Dataset | Musik | Menghitung | Berarti | Deviasi Std | Minimum | 25% persentil | 50% persentil | 75% persentil | Maksimum |

dev1 |

PEMERAH1 | 2000.00 | 0.6038 | 0.3065 | 0.0000 | 0.3653 | 0.6000 | 0.9384 | 1.0000 |

| PEMERAH 2 | 2000.00 | 0.4798 | 0.3578 | 0.0000 | 0.1818 | 0.4000 | 0.8571 | 1.0000 | |

| ROUGE L | 2000.00 | 0.5706 | 0.3194 | 0.0000 | 0.3000 | 0.5345 | 0.9101 | 1.0000 | |

| ROUGELsum | 2000.00 | 0.5706 | 0.3194 | 0.0000 | 0.3000 | 0.5345 | 0.9101 | 1.0000 | |

dev2 |

PEMERAH 1 | 2000.00 | 0.4659 | 0.2525 | 0.0000 | 0.2500 | 0.5000 | 0.7500 | 1.0000 |

| PEMERAH 2 | 2000.00 | 0.3123 | 0.2645 | 0.0000 | 0.0664 | 0.2857 | 0.5610 | 1.0000 | |

| ROUGE L | 2000.00 | 0.4529 | 0.2554 | 0.0000 | 0.2349 | 0.4615 | 0.7500 | 1.0000 | |

| PEMERAH Lsum | 2000.00 | 0.4529 | 0.2554 | 0.0000 | 0.2349 | 0.4615 | 0.7500 | 1.0000 |

Membersihkan

Untuk menghindari timbulnya biaya di masa mendatang, hapus sumber daya yang Anda buat dengan kode berikut:

Kesimpulan

Dalam postingan ini, kami mendemonstrasikan cara menyempurnakan model FLAN-T5 XL untuk tugas peringkasan spesifik domain klinis menggunakan SageMaker Studio. Untuk meningkatkan keyakinan, kami membandingkan prediksi dengan kebenaran dasar dan mengevaluasi hasilnya menggunakan metrik ROUGE. Kami menunjukkan bahwa model yang disesuaikan untuk tugas tertentu memberikan hasil yang lebih baik daripada model yang telah dilatih sebelumnya untuk tugas NLP umum. Kami ingin menunjukkan bahwa menyempurnakan LLM tujuan umum menghilangkan biaya pra-pelatihan sama sekali.

Meskipun penelitian yang disajikan di sini berfokus pada laporan rontgen dada, penelitian ini mempunyai potensi untuk diperluas ke kumpulan data yang lebih besar dengan beragam anatomi dan modalitas, seperti MRI dan CT, yang laporan radiologinya mungkin lebih kompleks dengan banyak temuan. Dalam kasus seperti ini, ahli radiologi dapat membuat tayangan berdasarkan tingkat kekritisannya dan menyertakan rekomendasi tindak lanjut. Selain itu, menyiapkan loop umpan balik untuk aplikasi ini akan memungkinkan ahli radiologi meningkatkan kinerja model dari waktu ke waktu.

Seperti yang kami tunjukkan di postingan ini, model yang disempurnakan menghasilkan tayangan untuk laporan radiologi dengan skor ROUGE yang tinggi. Anda dapat mencoba menyempurnakan LLM pada laporan medis khusus domain lainnya dari departemen berbeda.

Tentang penulis

Dr.Adewale Akinfaderin adalah Ilmuwan Data Senior di bidang Kesehatan dan Ilmu Hayati di AWS. Keahliannya adalah dalam metode AI/ML yang dapat direproduksi dan end-to-end, implementasi praktis, dan membantu pelanggan layanan kesehatan global merumuskan dan mengembangkan solusi terukur untuk masalah interdisipliner. Beliau memiliki dua gelar sarjana di bidang Fisika dan gelar Doktor di bidang Teknik.

Dr.Adewale Akinfaderin adalah Ilmuwan Data Senior di bidang Kesehatan dan Ilmu Hayati di AWS. Keahliannya adalah dalam metode AI/ML yang dapat direproduksi dan end-to-end, implementasi praktis, dan membantu pelanggan layanan kesehatan global merumuskan dan mengembangkan solusi terukur untuk masalah interdisipliner. Beliau memiliki dua gelar sarjana di bidang Fisika dan gelar Doktor di bidang Teknik.

Priya Padate adalah Arsitek Solusi Mitra Senior dengan keahlian luas di bidang Kesehatan dan Ilmu Hayati di AWS. Priya mendorong strategi masuk ke pasar dengan mitra dan mendorong pengembangan solusi untuk mempercepat pengembangan berbasis AI/ML. Dia bersemangat menggunakan teknologi untuk mentransformasi industri perawatan kesehatan guna mendorong hasil perawatan pasien yang lebih baik.

Priya Padate adalah Arsitek Solusi Mitra Senior dengan keahlian luas di bidang Kesehatan dan Ilmu Hayati di AWS. Priya mendorong strategi masuk ke pasar dengan mitra dan mendorong pengembangan solusi untuk mempercepat pengembangan berbasis AI/ML. Dia bersemangat menggunakan teknologi untuk mentransformasi industri perawatan kesehatan guna mendorong hasil perawatan pasien yang lebih baik.

Ekta Walia Bhullar, PhD, adalah konsultan AI/ML senior di unit bisnis layanan profesional AWS Healthcare and Life Sciences (HCLS). Beliau memiliki pengalaman luas dalam penerapan AI/ML dalam domain perawatan kesehatan, khususnya di bidang radiologi. Di luar pekerjaan, saat tidak membahas AI di bidang radiologi, ia suka berlari dan mendaki.

Ekta Walia Bhullar, PhD, adalah konsultan AI/ML senior di unit bisnis layanan profesional AWS Healthcare and Life Sciences (HCLS). Beliau memiliki pengalaman luas dalam penerapan AI/ML dalam domain perawatan kesehatan, khususnya di bidang radiologi. Di luar pekerjaan, saat tidak membahas AI di bidang radiologi, ia suka berlari dan mendaki.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Otomotif / EV, Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- ChartPrime. Tingkatkan Game Trading Anda dengan ChartPrime. Akses Di Sini.

- BlockOffset. Modernisasi Kepemilikan Offset Lingkungan. Akses Di Sini.

- Sumber: https://aws.amazon.com/blogs/machine-learning/automatically-generate-impressions-from-findings-in-radiology-reports-using-generative-ai-on-aws/

- :memiliki

- :adalah

- :bukan

- :Di mana

- $NAIK

- 000

- 1

- 100

- 11

- 116

- 125

- 16

- 20

- 22

- 25

- 26%

- 29

- 31

- 36

- 7

- 700

- 8

- 9

- 91

- a

- Sanggup

- Tentang Kami

- mempercepat

- dipercepat

- diakses

- menyelesaikan

- Mengumpulkan

- Selain itu

- kemajuan

- terhadap

- pengumpulan

- Persetujuan

- AI

- AI / ML

- algoritma

- Semua

- memungkinkan

- sudah

- juga

- sama sekali

- Amazon

- Amazon SageMaker

- Amazon Web Services

- jumlah

- an

- analisis

- dan

- Lain

- Apa pun

- api

- Aplikasi

- pendekatan

- sekitar

- arsitektur

- ADALAH

- argumen

- AS

- penilaian

- At

- secara otomatis

- secara otomatis

- mengotomatisasi

- tersedia

- rata-rata

- menghindari

- AWS

- mendasarkan

- berdasarkan

- BE

- karena

- sebelum

- makhluk

- Manfaat

- Lebih baik

- antara

- lebih besar

- miliaran

- kedua

- batas-batas

- Kotak

- beban

- bisnis

- tapi

- by

- bernama

- CAN

- calon

- kemampuan

- karbon

- yang

- kasus

- kasus

- berubah

- beban

- memilih

- kelas

- Pembersihan

- jelas

- Klinis

- dokter

- kode

- koleksi

- Umum

- umum

- membandingkan

- dibandingkan

- lengkap

- penyelesaian

- kompleks

- komponen

- luas

- komputasi

- komputasi

- ringkas

- kepercayaan

- berturut-turut

- terdiri

- konsul

- konsultan

- mengandung

- Wadah

- Konten

- isi

- kontras

- percakapan

- berkorespondensi

- Biaya

- mahal

- Biaya

- bisa

- sepasang

- membuat

- dibuat

- membuat

- kritis

- kekritisan

- adat

- pelanggan

- dasbor

- data

- ilmuwan data

- kumpulan data

- Pengambilan Keputusan

- Default

- didefinisikan

- Derajat

- Demografi

- mendemonstrasikan

- menunjukkan

- menunjukkan

- departemen

- menyebarkan

- dikerahkan

- penyebaran

- menggambarkan

- dijelaskan

- terperinci

- rincian

- mengembangkan

- Pengembangan

- berbeda

- langsung

- membahas

- mendiskusikan

- didistribusikan

- distribusi

- Buruh pelabuhan

- dokter

- dokumen

- domain

- domain

- Dont

- seri

- mendorong

- drive

- selama

- setiap

- Terdahulu

- usaha

- antara

- menghilangkan

- lain

- aktif

- memungkinkan

- ujung ke ujung

- Titik akhir

- Teknik

- ditingkatkan

- cukup

- Seluruh

- Lingkungan Hidup

- masa

- zaman

- kesalahan

- terutama

- penting

- mengevaluasi

- dievaluasi

- mengevaluasi

- evaluasi

- ujian

- contoh

- contoh

- menjalankan

- diperluas

- pengalaman

- keahlian

- luas

- Pengalaman yang luas

- ekstrak

- gagal

- palsu

- umpan balik

- Angka

- File

- File

- Temuan

- Fokus

- berfokus

- berikut

- berikut

- Untuk

- bentuk

- format

- Prinsip Dasar

- dari

- fungsi

- lebih lanjut

- Selanjutnya

- masa depan

- Umum

- tujuan umum

- menghasilkan

- dihasilkan

- menghasilkan

- generasi

- generatif

- AI generatif

- mendapatkan

- diberikan

- Aksi

- Pergi ke pasar

- lulus

- lebih besar

- Tanah

- Memiliki

- memiliki

- he

- Kesehatan

- Informasi kesehatan

- kesehatan

- industri kesehatan

- membantu

- membantu

- membantu

- di sini

- High

- menyoroti

- Kenaikan

- -nya

- sejarah

- tuan rumah

- JAM

- Seterpercayaapakah Olymp Trade? Kesimpulan

- How To

- HTML

- http

- HTTPS

- Pusat

- MemelukWajah

- manusia

- ID

- ide-ide

- diidentifikasi

- if

- menggambarkan

- gambar

- gambar

- Pencitraan

- berdampak

- melaksanakan

- implementasi

- mengimpor

- penting

- memperbaiki

- perbaikan

- in

- memasukkan

- Termasuk

- Meningkatkan

- industri

- informasi

- informatif

- memasukkan

- install

- contoh

- interaktif

- interpretasi

- ke

- Penemuan

- IT

- Pekerjaan

- Jobs

- json

- hanya

- hanya satu

- Menjaga

- kunci

- label

- bahasa

- besar

- jalankan

- pengetahuan

- Dipimpin

- Panjang

- Hidup

- Biologi

- 'like'

- 'like

- MEMBATASI

- baris

- Daftar

- Daftar

- LLM

- terletak

- tempat

- lepas

- mesin

- Mesin belajar

- membuat

- Mungkin..

- berarti

- medis

- medium

- Memori

- metode

- metode

- metrik

- Metrik

- mungkin

- menit

- ML

- model

- model

- Memantau

- lebih

- paling

- MRI

- banyak

- beberapa

- musik

- harus

- nama

- Alam

- Pengolahan Bahasa alami

- perlu

- Perlu

- jaringan

- saraf jaringan

- New

- baru saja

- berikutnya

- nLP

- buku catatan

- sekarang

- jumlah

- obyek

- diperoleh

- of

- menawarkan

- sering

- on

- Onboarding

- ONE

- hanya

- mengoptimalkan

- or

- urutan

- asli

- Lainnya

- kami

- di luar

- hasil

- keluaran

- di luar

- lebih

- secara keseluruhan

- mengesampingkan

- ikhtisar

- paket

- pasangan

- pasang

- parameter

- parameter

- bagian

- tertentu

- pasangan

- rekan

- lulus

- bergairah

- path

- pasien

- pasien

- persentase

- Melakukan

- prestasi

- phd

- Fisika

- potongan-potongan

- plato

- Kecerdasan Data Plato

- Data Plato

- Titik

- poin

- Pos

- potensi

- didukung

- Praktis

- Prediksi

- Predictor

- disajikan

- hadiah

- terutama

- Masalah

- masalah

- proses

- pengolahan

- Diproduksi

- profesional

- Profil

- mengusulkan

- diusulkan

- terlindung

- disediakan

- penyedia

- menyediakan

- di depan umum

- Ular sanca

- kuantitatif

- Baca

- Bacaan

- baru

- rekomendasi

- direkomendasikan

- mengurangi

- referensi

- disebut

- mengacu

- regex

- Pendaftaran

- terkait

- relevan

- luar biasa

- diganti

- melaporkan

- Pelaporan

- laporan

- permintaan

- wajib

- membutuhkan

- sumber

- Sumber

- masing-masing

- ISTIRAHAT

- mengakibatkan

- Hasil

- Pengembalian

- Naik

- Run

- berjalan

- pembuat bijak

- sama

- terukur

- ILMU PENGETAHUAN

- ilmuwan

- menggaruk

- SDK

- Pencarian

- detik

- Bagian

- bagian

- melihat

- terpilih

- senior

- peka

- putusan pengadilan

- terpisah

- layanan

- Layanan

- porsi

- set

- pengaturan

- pengaturan

- dia

- harus

- menunjukkan

- ditunjukkan

- Pertunjukkan

- makna

- penting

- Sederhana

- hanya

- kecil

- So

- larutan

- Solusi

- MEMECAHKAN

- beberapa

- merentang

- khusus

- tertentu

- Secara khusus

- ditentukan

- awal

- mulai

- state-of-the-art

- Status

- Langkah

- Tangga

- Masih

- penyimpanan

- menyimpan

- cerita

- strategi

- Penyelarasan

- studio

- seperti itu

- RINGKASAN

- yakin

- tabel

- Mengambil

- Dibutuhkan

- tugas

- tugas

- Teknologi

- dari

- bahwa

- Grafik

- Mereka

- kemudian

- Sana.

- dengan demikian

- karena itu

- Ini

- ini

- itu

- tiga

- Melalui

- waktu

- untuk

- terlalu

- Topik

- jalur

- Pelatihan VE

- Pelatihan

- transfer

- Mengubah

- transformator

- Terjemahan

- kebenaran

- mencoba

- dua

- mengetik

- khas

- garis bawah

- pemahaman

- terpadu

- satuan

- universitas

- upload

- menggunakan

- bekas

- Pengguna

- kegunaan

- menggunakan

- pengesahan

- nilai

- Nilai - Nilai

- berbagai

- Luas

- versi

- melalui

- Video

- maya

- menunggu

- adalah

- we

- jaringan

- layanan web

- Situs Web

- ketika

- yang

- sementara

- lebar

- akan

- dengan

- dalam

- tanpa

- Word

- kata

- Kerja

- alur kerja

- akan

- penulisan

- x-ray

- tahun

- Kamu

- Anda

- zephyrnet.dll