Bias dalam sistem AI terbukti menjadi batu sandungan utama dalam upaya mengintegrasikan teknologi secara lebih luas ke dalam masyarakat kita. Inisiatif baru yang akan memberi penghargaan kepada para peneliti karena menemukan prasangka apa pun dalam Sistem AI bisa membantu memecahkan masalah.

Upaya ini dimodelkan pada hadiah bug yang dibayarkan oleh perusahaan perangkat lunak kepada pakar keamanan siber yang memperingatkan merekaf setiap kelemahan keamanan potensial dalam produk mereka. Idenya bukanlah yang baru; "hadiah bias" adalah pertama kali diusulkan oleh ASaya peneliti dan pengusaha JB Rubinovitz pada tahun 2018, dan berbagai organisasi telah menjalankan tantangan seperti itu.

Namun upaya baru ini berupaya menciptakan forum berkelanjutan untuk kompetisi bounty bias yang independen dari organisasi tertentu. Terdiri dari sukarelawan dari berbagai perusahaan termasuk Twitter, apa yang disebut "Bias Buccaneers" berencana untuk mengadakan kompetisi reguler, atau "pemberontakan", dan awal bulan ini meluncurkan tantangan pertama.

"Bug bounty adalah praktik standar dalam keamanan siber yang belum menemukan pijakan di komunitas bias algoritmik, ”organisasinizer katakan di situs web mereka. “Sementara acara satu kali awal menunjukkan antusiasme untuk hadiah, Bias Buccaneers adalah organisasi nirlaba pertama yang dimaksudkan untuk menciptakan Pemberontakan yang sedang berlangsung, berkolaborasi dengan perusahaan teknologi, dan membuka jalan bagi evaluasi sistem AI yang transparan dan dapat direproduksi.”

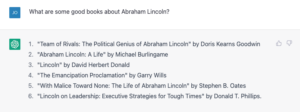

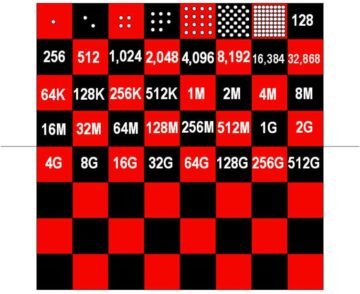

Kompetisi pertama ini ditujukan untuk mengatasi bias dalam algoritme pendeteksian gambar, tetapi alih-alih membuat orang menargetkan sistem AI tertentu, sebuah kompetisi akan chtuntut peneliti untuk membuat alat yang dapat mendeteksi kumpulan data yang bias. Idenya adalah untuk membuat model pembelajaran mesin yang dapat secara akurat melabeli setiap gambar dalam kumpulan data dengan warna kulit, jenis kelamin yang dirasakan, dan kelompok usia. Kompetisi berakhir pada 30 November dan memiliki hadiah pertama $6,000, hadiah kedua $4,000, dan hadiah ketiga $2,000.

Tantangannya didasarkan pada fakta bahwa seringkali sumber bias algoritmik bukanlah algoritme itu sendiri, tetapi sifat data yang dilatihnya. Alat otomatis yang dapat dengan cepat menilai seberapa seimbang suatu koleksi of gambar dalam kaitannya dengan atribut yang sering menjadi sumber diskriminasi dapat membantu peneliti AI menghindari sumber data yang bias.

Tetapi penyelenggara mengatakan ini hanyalah langkah pertama dalam upaya membangun perangkat untuk menilai bias dalam kumpulan data, algoritme, dan aplikasi, dan pada akhirnya menciptakan standar untuk caral dengan bias algoritmik, keadilan, dan kemampuan untuk dijelaskan.

Nya bukan satu-satunya upaya seperti itu. Salah satu pemimpin baru prakarsa adalah Rumman Chowdhury dari Twitter, yang membantu mengatur kompetisi bounty bias AI pertama tahun lalu, menargetkan algoritma platform yang digunakan untuk memotong gambar yang pengguna mengeluh disukai kulit putih dan wajah laki-laki atas yang hitam dan perempuan.

Kompetisi memberi peretas akses ke model perusahaan dan menantang mereka untuk menemukan kekurangan di dalamnya. Peserta menemukan berbagai masalah, termasuking preferensi untuk wajah stereotip cantik, keengganan untuk orang dengan rambut putih (penanda usia), dan preferensi untuk meme dengan bahasa Inggris daripada tulisan Arab.

Universitas Stanford juga baru-baru ini menyelesaikan kompetisi yang menantang tim untuk menghasilkan alat yang dirancang untuk membantu orang mengaudit sistem AI yang digunakan secara komersial atau open-source untuk diskriminasi. Dan undang-undang UE saat ini dan yang akan datang dapat mewajibkan perusahaan untuk secara teratur mengaudit data dan algoritme mereka.

Tapi mengambil Hadiah bug AI dan audit algoritmik mainstream dan membuatnya efektif akan lebih mudah diucapkan daripada dilakukan. Tak pelak lagi, perusahaan yang membangun bisnis mereka berdasarkan algoritme mereka akan menolak segala upaya untuk mendiskreditkan mereka.

Membangun pelajaran dari sistem audit dalam domain lain, seperti keuangan dan peraturan lingkungan dan kesehatan, peneliti baru-baru ini diuraikan beberapa bahan penting untuk akuntabilitas yang efektif. Salah satu yang paling penting kriteria mereka mengidentifikasi adalah keterlibatan yang berarti dari pihak ketiga yang independen.

Para peneliti menunjukkan bahwa audit AI sukarela saat ini sering melibatkan konflik kepentingan, seperti organisasi target yang membayar audit, membantu membingkai ruang lingkup audit, atau memiliki kesempatan untuk meninjau temuan sebelum dipublikasikan. Kekhawatiran ini tercermin dalam laporan terbaru dari Liga Keadilan Algoritma, yangch mencatat outsized peran organisasi target dalam program hadiah bug keamanan siber saat ini.

Menemukan cara untuk mendanai dan mendukung auditor AI dan pemburu bug yang benar-benar independen akan menjadi tantangan yang signifikan, terutama karena mereka akan menghadapi beberapa perusahaan dengan sumber daya paling baik di dunia. Untungnya, tampaknya ada perasaan yang berkembang di dalam industri bahwa mengatasi masalah ini akan sangat penting untuk menjaga kepercayaan pengguna pada layanan mereka.

Gambar Kredit: Jakob Rosen / Unsplash