Model bahasa besar (LLM) telah menarik imajinasi dan perhatian para pengembang, ilmuwan, teknolog, wirausaha, dan eksekutif di beberapa industri. Model ini dapat digunakan untuk menjawab pertanyaan, meringkas, menerjemahkan, dan lainnya dalam aplikasi seperti agen percakapan untuk dukungan pelanggan, pembuatan konten untuk pemasaran, dan asisten pengkodean.

Baru-baru ini, Meta dirilis Lama 2 untuk peneliti dan entitas komersial, menambah daftar LLM lainnya, termasuk MosesML MPT dan elang. Dalam posting ini, kita akan membahas cara menyempurnakan Llama 2 Pelatihan AWS, akselerator yang dibuat khusus untuk pelatihan LLM, untuk mengurangi waktu dan biaya pelatihan. Kami meninjau skrip penyesuaian yang disediakan oleh Neuron AWS SDK (menggunakan NeMo Megatron-LM), berbagai konfigurasi yang kami gunakan, dan hasil throughput yang kami lihat.

Tentang model Llama 2

Mirip dengan sebelumnya Lama 1 model dan model lain seperti GPT, Llama 2 menggunakan arsitektur khusus dekoder Transformer. Muncul dalam tiga ukuran: 7 miliar, 13 miliar, dan 70 miliar parameter. Dibandingkan dengan Llama 1, Llama 2 menggandakan panjang konteks dari 2,000 menjadi 4,000, dan menggunakan perhatian kueri yang dikelompokkan (hanya untuk 70B). Model terlatih Llama 2 dilatih pada 2 triliun token, dan modelnya yang telah disempurnakan telah dilatih pada lebih dari 1 juta anotasi manusia.

Pelatihan terdistribusi Llama 2

Untuk mengakomodasi Llama 2 dengan panjang urutan 2,000 dan 4,000, kami mengimplementasikan skrip menggunakan NeMo Megatron untuk Trainium yang mendukung paralelisme data (DP), paralelisme tensor (TP), dan paralelisme pipa (PP). Untuk lebih spesifiknya, dengan implementasi baru beberapa fitur seperti untie word embedding, rotary embedding, RMSNorm, dan aktivasi Swiglu, kami menggunakan skrip umum dari Neuron GPT Megatron-LM untuk mendukung skrip pelatihan Llama 2.

Prosedur pelatihan tingkat tinggi kami adalah sebagai berikut: untuk lingkungan pelatihan kami, kami menggunakan cluster multi-instance yang dikelola oleh sistem SLURM untuk pelatihan terdistribusi dan penjadwalan di bawah kerangka NeMo.

Pertama, unduh model Llama 2 dan kumpulan data pelatihan, lalu proses terlebih dahulu menggunakan tokenizer Llama 2. Misalnya, untuk menggunakan himpunan data RedPajama, gunakan perintah berikut:

Untuk panduan mendetail tentang pengunduhan model dan argumen skrip prapemrosesan, lihat Unduh kumpulan data dan tokenizer LlamaV2.

Selanjutnya, kompilasi modelnya:

Setelah model dikompilasi, luncurkan tugas pelatihan dengan skrip berikut yang telah dioptimalkan dengan konfigurasi dan hyperparameter terbaik untuk Llama 2 (termasuk dalam kode contoh):

Terakhir, kami memantau TensorBoard untuk melacak kemajuan pelatihan:

Untuk contoh kode dan script lengkap yang kami sebutkan, lihat Llama 7B tutorial dan kode NeMo di Neuron SDK untuk menjalani langkah-langkah yang lebih detail.

Eksperimen yang menyempurnakan

Kami menyempurnakan model 7B pada kumpulan data OSCAR (Open Super-large Crawled ALManaCH corpus) dan QNLI (Question-answering NLI) di lingkungan Neuron 2.12 (PyTorch). Untuk setiap panjang urutan 2,000 dan 4,000, kami mengoptimalkan beberapa konfigurasi, seperti batchsize dan gradient_accumulation, untuk efisiensi pelatihan. Sebagai strategi penyesuaian, kami mengadopsi penyesuaian penuh pada semua parameter (sekitar 500 langkah), yang dapat diperluas hingga pra-pelatihan dengan langkah yang lebih panjang dan kumpulan data yang lebih besar (misalnya, 1T RedPajama). Paralelisme urutan juga dapat diaktifkan untuk memungkinkan NeMo Megatron berhasil menyempurnakan model dengan panjang urutan lebih besar yaitu 4,000. Tabel berikut menunjukkan hasil konfigurasi dan throughput eksperimen penyempurnaan Llama 7B. Skala throughputnya hampir linier seiring dengan bertambahnya jumlah instans hingga 4.

| Perpustakaan Terdistribusi | Dataset | Panjang Urutan | Jumlah Instance | Tensor Paralel | Data Paralel | Parelel Pipa | Ukuran Kelompok Global | Throughput (seq/dtk) |

| Neuron NeMo Megatron | OSCAR | 4096 | 1 | 8 | 4 | 1 | 256 | 3.7 |

| . | . | 4096 | 2 | 8 | 4 | 1 | 256 | 7.4 |

| . | . | 4096 | 4 | 8 | 4 | 1 | 256 | 14.6 |

| . | QNLI | 4096 | 4 | 8 | 4 | 1 | 256 | 14.1 |

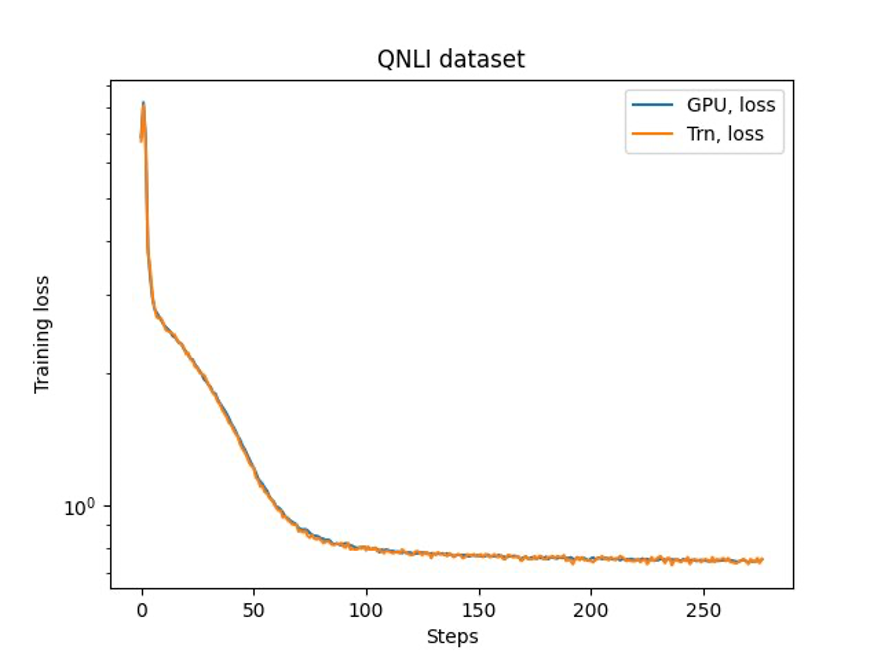

Langkah terakhir adalah memverifikasi keakuratan dengan model dasar. Kami menerapkan skrip referensi untuk eksperimen GPU dan mengonfirmasi bahwa kurva pelatihan untuk GPU dan Trainium cocok seperti yang ditunjukkan pada gambar berikut. Gambar tersebut mengilustrasikan kurva kerugian atas jumlah langkah pelatihan pada dataset QNLI. Presisi campuran diadopsi untuk GPU (biru), dan bf16 dengan pembulatan stokastik default untuk Trainium (oranye).

Kesimpulan

Dalam postingan ini, kami menunjukkan bahwa Trainium memberikan penyempurnaan Llama 2 yang berkinerja tinggi dan hemat biaya. Untuk sumber daya lebih lanjut tentang penggunaan Trainium untuk pra-pelatihan terdistribusi dan menyempurnakan model AI generatif Anda menggunakan NeMo Megatron, lihat Referensi Neuron AWS untuk NeMo Megatron.

Tentang Penulis

Hao Zhou adalah Ilmuwan Riset di Amazon SageMaker. Sebelumnya, dia bekerja mengembangkan metode pembelajaran mesin untuk deteksi penipuan untuk Amazon Fraud Detector. Dia bersemangat menerapkan pembelajaran mesin, pengoptimalan, dan teknik AI generatif pada berbagai masalah dunia nyata. Beliau meraih gelar PhD di bidang Teknik Elektro dari Northwestern University.

Hao Zhou adalah Ilmuwan Riset di Amazon SageMaker. Sebelumnya, dia bekerja mengembangkan metode pembelajaran mesin untuk deteksi penipuan untuk Amazon Fraud Detector. Dia bersemangat menerapkan pembelajaran mesin, pengoptimalan, dan teknik AI generatif pada berbagai masalah dunia nyata. Beliau meraih gelar PhD di bidang Teknik Elektro dari Northwestern University.

Karthick Gopalswamy adalah Ilmuwan Terapan di AWS. Sebelum AWS, dia bekerja sebagai ilmuwan di Uber dan Walmart Labs dengan fokus utama pada pengoptimalan bilangan bulat campuran. Di Uber, dia berfokus pada optimalisasi jaringan angkutan umum dengan produk SaaS sesuai permintaan dan perjalanan bersama. Di Walmart Labs, dia mengerjakan pengoptimalan harga dan pengemasan. Karthick memiliki gelar PhD di bidang Teknik Industri dan Sistem dengan minor di bidang Riset Operasi dari North Carolina State University. Penelitiannya berfokus pada model dan metodologi yang menggabungkan riset operasi dan pembelajaran mesin.

Karthick Gopalswamy adalah Ilmuwan Terapan di AWS. Sebelum AWS, dia bekerja sebagai ilmuwan di Uber dan Walmart Labs dengan fokus utama pada pengoptimalan bilangan bulat campuran. Di Uber, dia berfokus pada optimalisasi jaringan angkutan umum dengan produk SaaS sesuai permintaan dan perjalanan bersama. Di Walmart Labs, dia mengerjakan pengoptimalan harga dan pengemasan. Karthick memiliki gelar PhD di bidang Teknik Industri dan Sistem dengan minor di bidang Riset Operasi dari North Carolina State University. Penelitiannya berfokus pada model dan metodologi yang menggabungkan riset operasi dan pembelajaran mesin.

Xin Huang adalah Ilmuwan Terapan Senior untuk Amazon SageMaker JumpStart dan algoritme bawaan Amazon SageMaker. Dia berfokus pada pengembangan algoritme pembelajaran mesin yang dapat diskalakan. Minat penelitiannya adalah di bidang pemrosesan bahasa alami, pembelajaran mendalam yang dapat dijelaskan pada data tabular, dan analisis kuat pengelompokan ruang-waktu non-parametrik. Dia telah menerbitkan banyak makalah di konferensi ACL, ICDM, KDD, dan Royal Statistical Society: Series A.

Xin Huang adalah Ilmuwan Terapan Senior untuk Amazon SageMaker JumpStart dan algoritme bawaan Amazon SageMaker. Dia berfokus pada pengembangan algoritme pembelajaran mesin yang dapat diskalakan. Minat penelitiannya adalah di bidang pemrosesan bahasa alami, pembelajaran mendalam yang dapat dijelaskan pada data tabular, dan analisis kuat pengelompokan ruang-waktu non-parametrik. Dia telah menerbitkan banyak makalah di konferensi ACL, ICDM, KDD, dan Royal Statistical Society: Series A.

Taman Youngsuk adalah Ilmuwan Terapan Senior di AWS Annapurna Labs, yang bekerja mengembangkan dan melatih model dasar akselerator AI. Sebelumnya, Dr. Park mengerjakan Penelitian dan Pengembangan untuk Amazon Forecast di AWS AI Labs sebagai ilmuwan utama. Penelitiannya terletak pada interaksi antara pembelajaran mesin, model dasar, pengoptimalan, dan pembelajaran penguatan. Dia telah menerbitkan lebih dari 20 makalah tinjauan sejawat di tempat-tempat terkemuka, termasuk ICLR, ICML, AISTATS, dan KDD, dengan layanan pengorganisasian lokakarya dan presentasi tutorial di bidang rangkaian waktu dan pelatihan LLM. Sebelum bergabung dengan AWS, beliau memperoleh gelar PhD di bidang Teknik Elektro dari Stanford University.

Taman Youngsuk adalah Ilmuwan Terapan Senior di AWS Annapurna Labs, yang bekerja mengembangkan dan melatih model dasar akselerator AI. Sebelumnya, Dr. Park mengerjakan Penelitian dan Pengembangan untuk Amazon Forecast di AWS AI Labs sebagai ilmuwan utama. Penelitiannya terletak pada interaksi antara pembelajaran mesin, model dasar, pengoptimalan, dan pembelajaran penguatan. Dia telah menerbitkan lebih dari 20 makalah tinjauan sejawat di tempat-tempat terkemuka, termasuk ICLR, ICML, AISTATS, dan KDD, dengan layanan pengorganisasian lokakarya dan presentasi tutorial di bidang rangkaian waktu dan pelatihan LLM. Sebelum bergabung dengan AWS, beliau memperoleh gelar PhD di bidang Teknik Elektro dari Stanford University.

Yida Wang adalah ilmuwan utama di tim AWS AI Amazon. Minat penelitiannya adalah pada sistem, komputasi kinerja tinggi, dan analisis data besar. Saat ini dia bekerja pada sistem pembelajaran mendalam, dengan fokus pada kompilasi dan optimalisasi model pembelajaran mendalam untuk pelatihan dan inferensi yang efisien, terutama model dasar skala besar. Misinya adalah menjembatani model tingkat tinggi dari berbagai kerangka kerja dan platform perangkat keras tingkat rendah termasuk CPU, GPU, dan akselerator AI, sehingga model berbeda dapat berjalan dalam performa tinggi di perangkat berbeda.

Yida Wang adalah ilmuwan utama di tim AWS AI Amazon. Minat penelitiannya adalah pada sistem, komputasi kinerja tinggi, dan analisis data besar. Saat ini dia bekerja pada sistem pembelajaran mendalam, dengan fokus pada kompilasi dan optimalisasi model pembelajaran mendalam untuk pelatihan dan inferensi yang efisien, terutama model dasar skala besar. Misinya adalah menjembatani model tingkat tinggi dari berbagai kerangka kerja dan platform perangkat keras tingkat rendah termasuk CPU, GPU, dan akselerator AI, sehingga model berbeda dapat berjalan dalam performa tinggi di perangkat berbeda.

Jun (Lukas) Huan adalah Ilmuwan Utama di AWS AI Labs. Dr. Huan bekerja di bidang AI dan Ilmu Data. Dia telah menerbitkan lebih dari 160 makalah peer-review di konferensi dan jurnal terkemuka dan telah meluluskan 11 mahasiswa PhD. Ia adalah penerima Penghargaan Pengembangan Karir Dini Fakultas NSF pada tahun 2009. Sebelum bergabung dengan AWS, ia bekerja di Baidu Research sebagai ilmuwan terkemuka dan kepala Laboratorium Big Data Baidu. Dia mendirikan StylingAI Inc., sebuah perusahaan rintisan AI, dan menjabat sebagai CEO dan Kepala Ilmuwan pada tahun 2019–2021. Sebelum bergabung dengan industri ini, dia adalah Profesor Charles E. dan Mary Jane Spahr di Departemen EECS di Universitas Kansas. Dari tahun 2015–2018, ia bekerja sebagai direktur program di NSF AS yang bertanggung jawab atas program big datanya.

Jun (Lukas) Huan adalah Ilmuwan Utama di AWS AI Labs. Dr. Huan bekerja di bidang AI dan Ilmu Data. Dia telah menerbitkan lebih dari 160 makalah peer-review di konferensi dan jurnal terkemuka dan telah meluluskan 11 mahasiswa PhD. Ia adalah penerima Penghargaan Pengembangan Karir Dini Fakultas NSF pada tahun 2009. Sebelum bergabung dengan AWS, ia bekerja di Baidu Research sebagai ilmuwan terkemuka dan kepala Laboratorium Big Data Baidu. Dia mendirikan StylingAI Inc., sebuah perusahaan rintisan AI, dan menjabat sebagai CEO dan Kepala Ilmuwan pada tahun 2019–2021. Sebelum bergabung dengan industri ini, dia adalah Profesor Charles E. dan Mary Jane Spahr di Departemen EECS di Universitas Kansas. Dari tahun 2015–2018, ia bekerja sebagai direktur program di NSF AS yang bertanggung jawab atas program big datanya.

Shruti Koparkar adalah Manajer Pemasaran Produk Senior di AWS. Dia membantu pelanggan menjelajahi, mengevaluasi, dan mengadopsi infrastruktur komputasi terakselerasi Amazon EC2 untuk kebutuhan pembelajaran mesin mereka.

Shruti Koparkar adalah Manajer Pemasaran Produk Senior di AWS. Dia membantu pelanggan menjelajahi, mengevaluasi, dan mengadopsi infrastruktur komputasi terakselerasi Amazon EC2 untuk kebutuhan pembelajaran mesin mereka.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- Sumber: https://aws.amazon.com/blogs/machine-learning/fast-and-cost-effective-llama-2-fine-tuning-with-aws-trainium/

- :memiliki

- :adalah

- $NAIK

- 000

- 1

- 100

- 11

- 12

- 13

- 160

- 20

- 500

- 7

- 70

- 8

- a

- Tentang Kami

- dipercepat

- akselerator

- akselerator

- menampung

- ketepatan

- di seluruh

- Activation

- menambahkan

- mengambil

- diadopsi

- agen

- AI

- Model AI

- algoritma

- Semua

- mengizinkan

- hampir

- sudah

- juga

- Amazon

- Amazon EC2

- Prakiraan Amazon

- Detektor Penipuan Amazon

- Amazon SageMaker

- Mulai Lompatan Amazon SageMaker

- Amazon Web Services

- an

- analisis

- analisis

- dan

- aplikasi

- terapan

- Menerapkan

- arsitektur

- ADALAH

- DAERAH

- argumen

- AS

- asisten

- At

- perhatian

- hadiah

- AWS

- Baidu

- mendasarkan

- BE

- menjadi

- sebelum

- TERBAIK

- antara

- Besar

- Big data

- Milyar

- Biru

- kedua

- JEMBATAN

- built-in

- by

- CAN

- ditangkap

- Lowongan Kerja

- ceo

- biaya

- Charles

- kepala

- Kelompok

- kekelompokan

- kode

- Pengkodean

- menggabungkan

- datang

- komersial

- dibandingkan

- lengkap

- komputasi

- konferensi

- konfigurasi

- DIKONFIRMASI

- Konten

- pembuatan konten

- konteks

- percakapan

- hemat biaya

- Biaya

- penciptaan

- Sekarang

- melengkung

- pelanggan

- Customer Support

- pelanggan

- data

- Data Analytics

- ilmu data

- kumpulan data

- mendalam

- belajar mendalam

- Default

- memberikan

- Departemen

- terperinci

- Deteksi

- pengembang

- berkembang

- Pengembangan

- Devices

- berbeda

- Kepala

- Terkemuka

- didistribusikan

- pelatihan terdistribusi

- Dobel

- Download

- dr

- e

- setiap

- Awal

- efisiensi

- efisien

- embedding

- diaktifkan

- Teknik

- entitas

- pengusaha

- Lingkungan Hidup

- terutama

- mengevaluasi

- contoh

- eksekutif

- eksperimen

- eksperimen

- menyelidiki

- FAST

- Fitur

- Angka

- Fokus

- terfokus

- berfokus

- berikut

- berikut

- Untuk

- Ramalan

- Prinsip Dasar

- Didirikan di

- Kerangka

- kerangka

- penipuan

- deteksi penipuan

- dari

- penuh

- generatif

- AI generatif

- GPU

- GPU

- bimbingan

- Perangkat keras

- Memiliki

- he

- kepala

- membantu

- High

- tingkat tinggi

- kinerja tinggi

- -nya

- memegang

- Seterpercayaapakah Olymp Trade? Kesimpulan

- How To

- HTML

- HTTPS

- manusia

- menggambarkan

- imajinasi

- implementasi

- diimplementasikan

- in

- Inc

- termasuk

- Termasuk

- Meningkatkan

- industri

- industri

- industri

- Infrastruktur

- bunga

- kepentingan

- IT

- NYA

- jane

- Pekerjaan

- bergabung

- jpg

- Kansas

- Menjaga

- laboratorium

- Labs

- bahasa

- besar-besaran

- lebih besar

- Terakhir

- jalankan

- memimpin

- terkemuka

- pengetahuan

- Panjang

- terletak

- 'like'

- Daftar

- Llama

- LLM

- lagi

- lepas

- mesin

- Mesin belajar

- utama

- berhasil

- manajer

- banyak

- Marketing

- cocok

- tersebut

- meta

- metodologi

- metode

- juta

- minor

- Misi

- campur aduk

- model

- model

- Memantau

- lebih

- Alam

- Pengolahan Bahasa alami

- kebutuhan

- jaringan

- New

- utara

- carolina utara

- NSF

- jumlah

- Nvidia

- diperoleh

- of

- on

- Sesuai Permintaan

- hanya

- Buka

- Operasi

- optimasi

- dioptimalkan

- mengoptimalkan

- Jeruk

- pengorganisasian

- Lainnya

- kami

- lebih

- dokumen

- parameter

- Taman

- bergairah

- peer-review

- prestasi

- phd

- pipa saluran

- Platform

- plato

- Kecerdasan Data Plato

- Data Plato

- Pos

- sebelumnya

- di harga

- Utama

- Sebelumnya

- masalah

- Prosedur

- pengolahan

- Produk

- Produk

- Profesor

- program

- Kemajuan

- disediakan

- publik

- angkutan umum

- diterbitkan

- Ular sanca

- pytorch

- pertanyaan

- R & D

- dunia nyata

- menurunkan

- lihat

- dirilis

- penelitian

- peneliti

- Sumber

- Hasil

- ulasan

- kuat

- pembulatan

- kerajaan

- Run

- SaaS

- pembuat bijak

- melihat

- terukur

- sisik

- penjadwalan

- Ilmu

- ilmuwan

- ilmuwan

- naskah

- script

- SDK

- senior

- Urutan

- Seri

- Seri A

- layanan

- Layanan

- beberapa

- berbagi

- dia

- menunjukkan

- ditunjukkan

- Pertunjukkan

- ukuran

- So

- Masyarakat

- beberapa

- tertentu

- Stanford

- Universitas Stanford

- Start-up

- Negara

- statistik

- Langkah

- Tangga

- Penyelarasan

- Siswa

- berhasil

- seperti itu

- mendukung

- Mendukung

- sistem

- sistem

- tabel

- tim

- teknik

- teknologi

- dari

- bahwa

- Grafik

- Daerah

- mereka

- Mereka

- Ini

- ini

- tiga

- Melalui

- keluaran

- waktu

- Seri waktu

- kali

- untuk

- bersama

- Token

- puncak

- tp

- jalur

- terlatih

- Pelatihan

- transit

- Terjemahan

- Triliun

- tutorial

- uber

- bawah

- universitas

- us

- menggunakan

- bekas

- kegunaan

- menggunakan

- berbagai

- keadaan-keadaan

- memeriksa

- berjalan

- Walmart

- adalah

- we

- jaringan

- layanan web

- yang

- dengan

- Word

- bekerja

- kerja

- bekerja

- bengkel

- Anda

- zephyrnet.dll