GPU adalah alat yang ampuh untuk beban kerja pembelajaran mesin, meskipun belum tentu merupakan alat yang tepat untuk setiap pekerjaan AI, menurut Michael Bronstein, kepala penelitian pembelajaran grafik Twitter.

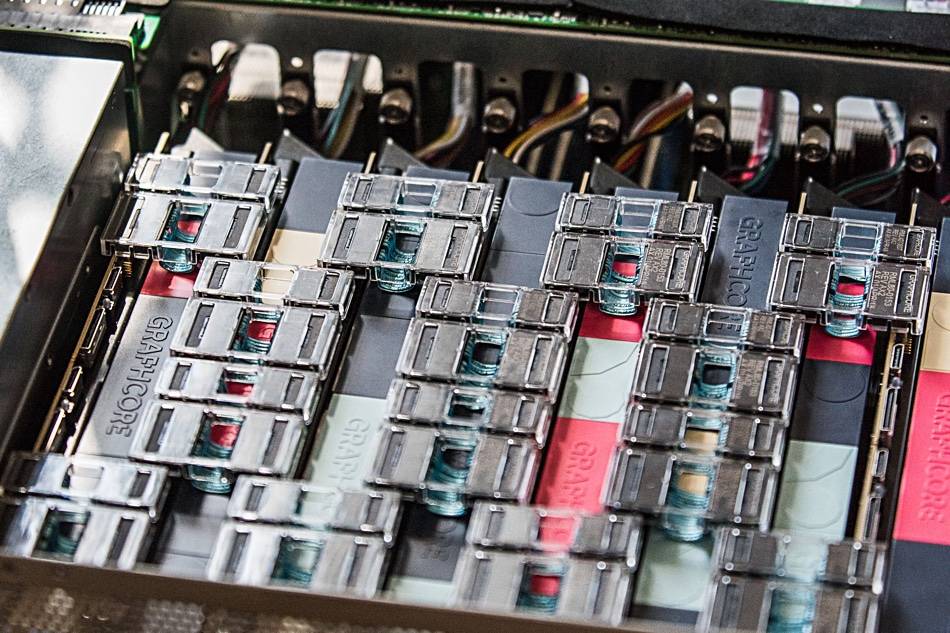

Timnya baru-baru ini menunjukkan perangkat keras AI Graphcore menawarkan "urutan kecepatan saat membandingkan prosesor IPU tunggal dengan GPU Nvidia A100," dalam model jaringan grafik temporal (TGN).

“Pilihan perangkat keras untuk mengimplementasikan model Graph ML adalah masalah penting, namun sering diabaikan,” bunyi a artikel bersama ditulis oleh Bronstein bersama Emanuele Rossi, peneliti ML di Twitter, dan Daniel Justus, peneliti di Graphcore.

Jaringan saraf grafik menawarkan sarana untuk menemukan keteraturan dalam sistem yang kompleks, dan biasanya digunakan dalam jaringan sosial dan sistem pemberi rekomendasi. Namun, sifat dinamis dari lingkungan ini membuat model ini sangat menantang untuk dilatih, ketiganya menjelaskan.

Grup menyelidiki kelayakan IPU Graphcore dalam menangani beberapa model TGN. Pengujian awal dilakukan pada model TGN kecil berdasarkan JODI Kumpulan data Wikipedia yang menautkan pengguna ke suntingan yang mereka buat ke halaman. Grafik terdiri dari 8,227 pengguna dan 1,000 artikel dengan total 9,227 node. JODIE adalah sistem prediksi sumber terbuka yang dirancang untuk memahami jaringan interaksi temporal.

Eksperimen ketiganya mengungkapkan bahwa ukuran batch yang besar mengakibatkan penurunan validasi dan akurasi inferensi, dibandingkan dengan ukuran batch yang lebih kecil.

"Memori node dan konektivitas grafik keduanya hanya diperbarui setelah batch penuh diproses," tulis ketiganya. “Oleh karena itu, acara selanjutnya dalam satu batch mungkin bergantung pada informasi yang sudah ketinggalan zaman karena mereka tidak mengetahui peristiwa sebelumnya.”

Namun, dengan menggunakan ukuran batch 10, grup tersebut mampu mencapai validasi dan akurasi inferensi yang optimal, tetapi mereka mencatat bahwa kinerja pada IPU masih lebih unggul daripada GPU, bahkan saat menggunakan ukuran batch yang besar.

“Saat menggunakan sisi batch 10, TGN dapat dilatih pada IPU sekitar 11 kali lebih cepat, dan bahkan dengan ukuran batch besar 200, pelatihan masih tiga kali lebih cepat pada IPU,” tulis postingan tersebut. “Di seluruh operasi, IPU menangani ukuran batch kecil dengan lebih efisien.”

Tim berpendapat bahwa akses memori yang cepat dan throughput tinggi yang ditawarkan oleh cache SRAM dalam prosesor besar Graphcore memberi IPU keunggulan.

Keunggulan kinerja ini juga diperluas ke model grafik yang melebihi memori dalam prosesor IPU — masing-masing IPU memiliki cache SRAM 1 GB — yang membutuhkan penggunaan memori DRAM yang lebih lambat yang terpasang pada chip.

Dalam pengujian pada model grafik yang terdiri dari 261 juta pengikut antara 15.5 juta pengguna Twitter, penggunaan DRAM untuk memori simpul membatasi throughput dengan dua faktor, tim Bronstein menemukan.

Namun, ketika memasukkan beberapa sub-grafik berdasarkan kumpulan data sintetis 10X ukuran grafik Twitter, tim menemukan throughput yang diskalakan secara independen dari ukuran grafik. Dengan kata lain, kinerja yang dicapai adalah hasil dari penggunaan memori yang lebih lambat dan bukan hasil dari ukuran model.

“Menggunakan teknik ini pada IPU, TGN dapat diterapkan pada ukuran grafik yang hampir berubah-ubah, hanya dibatasi oleh jumlah memori host yang tersedia sambil mempertahankan throughput yang sangat tinggi selama pelatihan dan inferensi,” tulis artikel tersebut.

Tim menyimpulkan bahwa arsitektur IPU Graphcore menunjukkan keunggulan signifikan dibandingkan GPU dalam beban kerja di mana komputasi dan akses memori bersifat heterogen.

Namun, kesimpulan yang lebih luas adalah bahwa peneliti ML harus mempertimbangkan dengan cermat pilihan perangkat keras mereka dan tidak boleh menggunakan GPU secara default.

“Ketersediaan layanan komputasi awan yang mengabstraksi perangkat keras yang mendasarinya mengarah pada kemalasan tertentu dalam hal ini,” tulis ketiganya. “Kami berharap penelitian kami akan menarik lebih banyak perhatian pada topik penting ini dan membuka jalan untuk algoritma dan arsitektur perangkat keras yang lebih efisien di masa depan untuk aplikasi Graph ML.” ®

- AI

- ai seni

- generator seni ai

- punya robot

- kecerdasan buatan

- sertifikasi kecerdasan buatan

- kecerdasan buatan dalam perbankan

- robot kecerdasan buatan

- robot kecerdasan buatan

- perangkat lunak kecerdasan buatan

- blockchain

- konferensi blockchain

- kecerdasan

- kecerdasan buatan percakapan

- konferensi kripto

- dall's

- belajar mendalam

- google itu

- Mesin belajar

- plato

- plato ai

- Kecerdasan Data Plato

- Permainan Plato

- Data Plato

- permainan plato

- skala ai

- sintaksis

- Pendaftaran

- zephyrnet.dll