Hari ini, kami mengumumkan ketersediaan contoh notebook yang mendemonstrasikan tugas menjawab pertanyaan menggunakan pendekatan berbasis Retrieval Augmented Generation (RAG) dengan model bahasa besar (LLM) di Mulai Lompatan Amazon SageMaker. Pembuatan teks menggunakan RAG dengan LLM memungkinkan Anda menghasilkan keluaran teks khusus domain dengan menyediakan data eksternal tertentu sebagai bagian dari konteks yang diumpankan ke LLM.

JumpStart adalah pusat pembelajaran mesin (ML) yang dapat membantu Anda mempercepat perjalanan ML Anda. JumpStart menyediakan banyak model bahasa terlatih yang disebut model pondasi yang dapat membantu Anda melakukan tugas seperti meringkas artikel, menjawab pertanyaan, dan membuat percakapan serta membuat gambar.

Dalam posting ini, kami menjelaskan RAG dan kelebihannya, dan mendemonstrasikan cara cepat memulai dengan menggunakan notebook sampel untuk menyelesaikan tugas menjawab pertanyaan menggunakan implementasi RAG dengan LLM di Jumpstart. Kami mendemonstrasikan dua pendekatan:

- Bagaimana mengatasi masalah dengan sumber terbuka LangChain perpustakaan dan Amazon SageMaker titik akhir dalam beberapa baris kode

- Cara menggunakan algoritme SageMaker KNN untuk melakukan pencarian semantik untuk data skala besar menggunakan titik akhir SageMaker

LLMS dan kendala

LLM dilatih pada data tidak terstruktur dalam jumlah besar dan hebat dalam pembuatan teks umum. LLM dapat menyimpan pengetahuan faktual dengan melatih parameternya pada korpus besar data bahasa alami.

Ada beberapa batasan dalam menggunakan LLM pra-terlatih siap pakai:

- Mereka biasanya dilatih secara offline, membuat model agnostik terhadap informasi terbaru (misalnya, chatbot yang dilatih dari 2011–2018 tidak memiliki informasi tentang COVID-19).

- Mereka membuat prediksi dengan hanya mencari informasi yang disimpan dalam parameternya, yang mengarah ke interpretasi yang lebih rendah.

- Mereka sebagian besar dilatih tentang kumpulan domain umum, membuatnya kurang efektif pada tugas khusus domain. Ada skenario ketika Anda ingin model menghasilkan teks berdasarkan data tertentu daripada data umum. Misalnya, perusahaan asuransi kesehatan mungkin ingin bot penjawab pertanyaan mereka menjawab pertanyaan menggunakan informasi terbaru yang disimpan dalam penyimpanan atau basis data dokumen perusahaan mereka, sehingga jawabannya akurat dan mencerminkan aturan bisnis unik mereka.

Saat ini, ada dua cara populer untuk mereferensikan data spesifik di LLM:

- Sisipkan data sebagai konteks di prompt model sebagai cara untuk memberikan informasi yang dapat digunakan model saat membuat hasilnya

- Sempurnakan model dengan menyediakan file dengan pasangan cepat dan selesai

Tantangan dari pendekatan berbasis konteks adalah bahwa model hadir dengan ukuran konteks yang terbatas, dan memasukkan semua dokumen sebagai konteks mungkin tidak sesuai dengan ukuran konteks model yang diperbolehkan. Bergantung pada model yang digunakan, mungkin ada biaya tambahan untuk konteks yang lebih besar.

Untuk pendekatan fine-tuning, menghasilkan informasi yang diformat dengan benar memakan waktu dan melibatkan biaya. Selain itu, jika data eksternal yang digunakan untuk fine-tuning sering berubah, ini akan menyiratkan seringnya fine-tuning dan pelatihan ulang diperlukan untuk menciptakan hasil yang akurat. Pelatihan yang sering berdampak pada kecepatan pasar dan menambah biaya solusi keseluruhan.

Untuk mendemonstrasikan kendala ini, kami menggunakan model LLM Flan T5 XXL dan mengajukan pertanyaan berikut:

Kami mendapatkan tanggapan berikut:

Seperti yang Anda lihat, responsnya tidak akurat. Jawaban yang benar adalah semua instans SageMaker mendukung Pelatihan Spot Terkelola.

Kami mencoba pertanyaan yang sama tetapi dengan konteks tambahan yang diteruskan dengan pertanyaan:

Kami mendapat tanggapan berikut kali ini:

Responsnya lebih baik tetapi masih belum akurat. Namun, dalam kasus penggunaan produksi nyata, pengguna dapat mengirimkan berbagai kueri, dan untuk memberikan respons yang akurat, Anda mungkin ingin menyertakan semua atau sebagian besar informasi yang tersedia sebagai bagian dari konteks statis untuk membuat respons yang akurat. Oleh karena itu, dengan pendekatan ini, kami dapat mencapai batasan batasan ukuran konteks karena bahkan informasi yang tidak relevan untuk pertanyaan yang diajukan dikirim sebagai bagian dari konteks. Di sinilah Anda dapat menggunakan pendekatan berbasis RAG untuk membuat respons yang terukur dan akurat untuk kueri pengguna.

Pengambilan Augmented Generation

Untuk mengatasi kendala yang telah kita bahas, kita dapat menggunakan Retrieval Augmented Generation (RAG) dengan LLM. RAG mengambil data dari luar model bahasa (non-parametrik) dan menambah petunjuknya dengan menambahkan data yang diambil relevan dalam konteks. Model RAG diperkenalkan oleh Lewis dkk. pada tahun 2020 sebagai model di mana memori parametrik adalah model seq2seq terlatih dan memori non-parametrik adalah indeks vektor padat Wikipedia, diakses dengan neural retriever terlatih.

Di RAG, data eksternal bisa berasal dari berbagai sumber data, seperti tempat penyimpanan dokumen, database, atau API. Langkah pertama adalah mengonversi dokumen dan kueri pengguna dalam format sehingga dapat dibandingkan dan pencarian relevansi dapat dilakukan. Agar format dapat dibandingkan untuk melakukan pencarian relevansi, kumpulan dokumen (perpustakaan pengetahuan) dan kueri yang dikirimkan pengguna diubah menjadi representasi numerik menggunakan model bahasa embedding. Penyematan pada dasarnya adalah representasi numerik dari konsep dalam teks. Selanjutnya, berdasarkan penyematan kueri pengguna, teks yang relevan diidentifikasi dalam kumpulan dokumen dengan pencarian kesamaan di ruang penyematan. Kemudian prompt yang diberikan oleh pengguna ditambahkan dengan teks relevan yang dicari dan ditambahkan ke konteks. Prompt sekarang dikirim ke LLM dan karena konteksnya memiliki data eksternal yang relevan bersama dengan prompt asli, keluaran model relevan dan akurat.

Untuk mempertahankan informasi terkini untuk dokumen referensi, Anda dapat memperbarui dokumen secara asinkron dan memperbarui representasi penyematan dokumen. Dengan cara ini, dokumen yang diperbarui akan digunakan untuk menghasilkan jawaban atas pertanyaan di masa mendatang guna memberikan jawaban yang akurat.

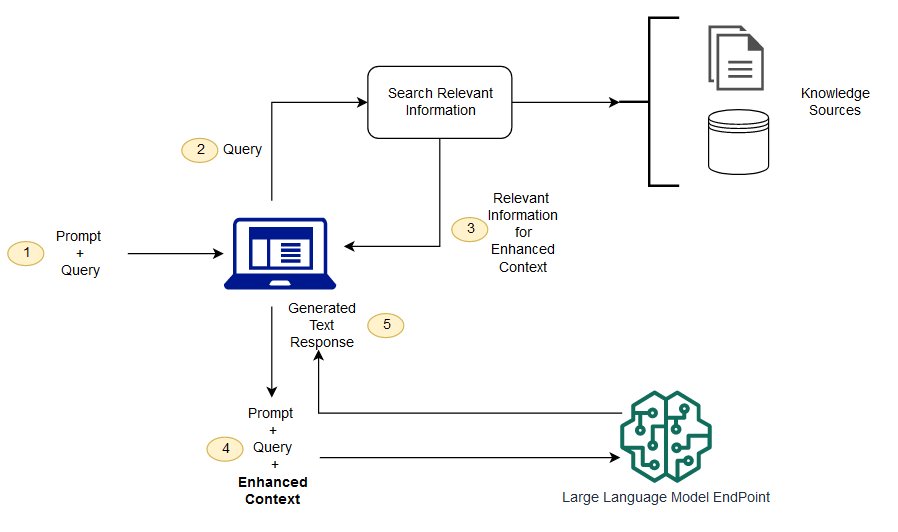

Diagram berikut menunjukkan alur konseptual penggunaan RAG dengan LLM.

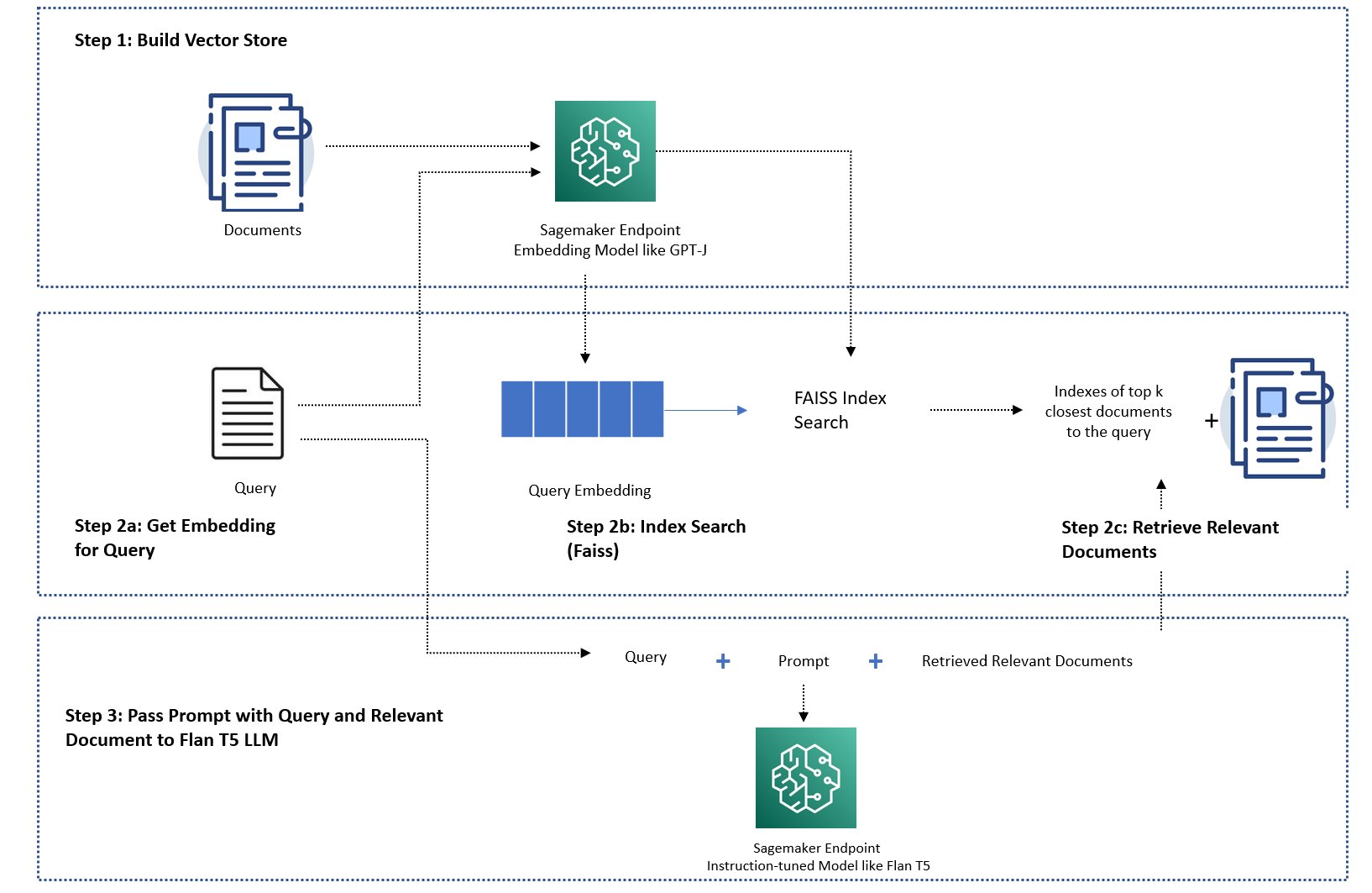

Dalam postingan ini, kami mendemonstrasikan cara mengimplementasikan aplikasi penjawab pertanyaan dengan langkah-langkah berikut:

- Hasilkan penyematan untuk setiap dokumen di perpustakaan pengetahuan dengan model penyematan SageMaker GPT-J-6B.

- Identifikasi K teratas dokumen yang paling relevan berdasarkan kueri pengguna.

- Untuk kueri Anda, buat penyematan kueri menggunakan model penyematan yang sama.

- Telusuri indeks dari K teratas dokumen yang paling relevan di ruang penyematan menggunakan penelusuran FAISS dalam memori.

- Gunakan indeks untuk mengambil dokumen terkait.

- Gunakan dokumen relevan yang diambil sebagai konteks dengan permintaan dan pertanyaan, dan kirimkan ke SageMaker LLM untuk menghasilkan respons.

Kami mendemonstrasikan pendekatan berikut:

- Cara menyelesaikan tugas menjawab pertanyaan dengan SageMaker LLM dan menyematkan titik akhir dan pustaka sumber terbuka LangChain dalam beberapa baris kode. Secara khusus, kami menggunakan dua titik akhir SageMaker untuk LLM (Flan T5 XXL) dan model penyematan (GPT-J 6B), dan database vektor yang digunakan adalah dalam memori FAISS. Untuk lebih jelasnya, lihat GitHub repo.

- Jika FAISS dalam memori tidak sesuai dengan kumpulan data besar Anda, kami memberi Anda a Algoritma SageMaker KNN untuk melakukan pencarian semantik, yang juga menggunakan FAISS sebagai algoritma pencarian yang mendasarinya. Untuk detailnya, lihat GitHub repo.

Diagram berikut menggambarkan arsitektur solusi.

Notebook implementasi berbasis RAG JumpStart dengan LangChain

LangChain adalah kerangka kerja sumber terbuka untuk mengembangkan aplikasi yang didukung oleh model bahasa. LangChain menyediakan antarmuka umum untuk banyak LLM yang berbeda. Ini juga memudahkan pengembang untuk menyatukan berbagai LLM dan membangun aplikasi yang kuat. LangChain menyediakan antarmuka standar untuk memori dan kumpulan implementasi memori untuk mempertahankan status antara panggilan agen atau rantai.

LangChain memiliki banyak fitur utilitas lain yang dapat menambah produktivitas pengembang. Fitur-fitur ini mencakup template prompt yang membantu menyesuaikan prompt menggunakan variabel dalam template prompt, agen untuk membangun aplikasi end-to-end, indeks untuk langkah pencarian dan pengambilan rantai, dan banyak lagi. Untuk lebih mengeksplorasi kemampuan LangChain, lihat dokumentasi LangChain.

Buat Model LLM

Sebagai langkah pertama, terapkan model JumpStart LLM pilihan Anda. Dalam demo ini, kami menggunakan titik akhir model Jumpstart Flan T5 XXL. Untuk instruksi penerapan, lihat Permintaan zero-shot untuk model dasar Flan-T5 di Amazon SageMaker JumpStart. Berdasarkan kasus penggunaan Anda, Anda juga dapat menggunakan model lain yang disesuaikan dengan instruksi seperti Fla T5 UL2 or BloomZ 7B1. Untuk detailnya, lihat contoh notebook.

Untuk menggunakan titik akhir SageMaker LLM dengan LangChain, kami menggunakan langchain.llms.sagemaker_endpoint.SagemakerEndpoint, yang mengabstraksi titik akhir SageMaker LLM. Kita perlu melakukan transformasi untuk payload request dan response seperti yang ditunjukkan pada kode berikut untuk integrasi LangChain SageMaker. Perhatikan bahwa Anda mungkin perlu menyesuaikan kode ContentHandler berdasarkan content_type dan menerima format model LLM yang Anda pilih untuk digunakan.

Buat model penyematan

Selanjutnya, kita perlu menyiapkan model yang disematkan. Kami menyebarkan GPT-J 6B model sebagai model embedding. Jika Anda menggunakan model penyematan JumpStart, Anda perlu menyesuaikan kelas penyematan titik akhir LangChain SageMaker dan mengubah permintaan dan respons model untuk diintegrasikan dengan LangChain. Untuk implementasi terperinci, lihat GitHub repo.

Muat dokumen khusus domain menggunakan pemuat dokumen LangChain dan buat indeks

Kami menggunakan CSVLoader paket di LangChain untuk memuat dokumen berformat CSV ke pemuat dokumen:

Selanjutnya, kami menggunakan TextSplitter untuk melakukan praproses data untuk tujuan penyematan dan menggunakan model penyematan SageMaker GPT-J-6B untuk membuat penyematan. Kami menyimpan penyematan di penyimpanan vektor FAISS untuk membuat indeks. Kami menggunakan indeks ini untuk menemukan dokumen relevan yang secara semantik mirip dengan kueri pengguna.

Kode berikut menunjukkan bagaimana semua langkah ini dilakukan oleh VectorstoreIndexCreator kelas hanya dalam beberapa baris kode di LangChain untuk membuat implementasi singkat dari menjawab pertanyaan dengan RAG:

Gunakan indeks untuk mencari konteks yang relevan dan meneruskannya ke model LLM

Selanjutnya, gunakan metode kueri pada indeks yang dibuat dan teruskan pertanyaan pengguna dan titik akhir SageMaker LLM. LangChain memilih empat dokumen terdekat (K=4) dan meneruskan konteks yang relevan yang diambil dari dokumen untuk menghasilkan respons yang akurat. Lihat kode berikut:

Kami mendapatkan respons berikut untuk kueri menggunakan pendekatan berbasis RAG dengan Flan T5 XXL:

Respon terlihat lebih akurat dibandingkan dengan respon yang kami dapatkan dengan pendekatan lain yang kami tunjukkan sebelumnya yang tidak memiliki konteks atau konteks statis yang mungkin tidak selalu relevan.

Pendekatan alternatif untuk mengimplementasikan RAG dengan lebih banyak penyesuaian menggunakan SageMaker dan LangChain

Di bagian ini, kami menunjukkan kepada Anda pendekatan lain untuk mengimplementasikan RAG menggunakan SageMaker dan LangChain. Pendekatan ini menawarkan fleksibilitas untuk mengonfigurasi parameter K teratas untuk pencarian relevansi dalam dokumen. Ini juga memungkinkan Anda untuk menggunakan fitur LangChain dari templat cepat, yang memungkinkan Anda untuk membuat parameter pembuatan prompt dengan mudah alih-alih membuat kode keras pada prompt.

Dalam kode berikut, kami secara eksplisit menggunakan FAISS untuk menghasilkan penyematan untuk setiap dokumen di perpustakaan pengetahuan dengan model penyematan SageMaker GPT-J-6B. Kemudian kami mengidentifikasi K teratas (K=3) dokumen yang paling relevan berdasarkan kueri pengguna.

Selanjutnya, kami menggunakan template prompt dan mengikatnya dengan SageMaker LLM:

Kami mengirimkan tiga (K=3) dokumen relevan teratas yang kami temukan sebagai konteks ke prompt dengan menggunakan rantai LangChain:

Dengan pendekatan implementasi RAG ini, kami dapat memanfaatkan fleksibilitas tambahan dari template permintaan LangChain dan menyesuaikan jumlah dokumen yang dicari untuk kecocokan relevansi menggunakan hyperparameter K atas.

Notebook implementasi berbasis RAG JumpStart dengan SageMaker KNN

Pada bagian ini, kami menerapkan pendekatan berbasis RAG menggunakan algoritme KNN untuk menemukan dokumen yang relevan guna menciptakan konteks yang lebih baik. Dalam pendekatan ini, kami tidak menggunakan LangChain, tetapi kami menggunakan kumpulan data yang sama FAQ Amazon SageMaker sebagai dokumen pengetahuan, menyematkan model GPT-J-6B dan LLM Flan T5 XXL seperti yang kami lakukan pada pendekatan LangChain sebelumnya.

Jika Anda memiliki kumpulan data yang besar, file Algoritma SageMaker KNN dapat memberi Anda pencarian semantik yang efektif. Algoritme SageMaker KNN juga menggunakan FAISS sebagai algoritma pencarian yang mendasarinya. Notebook untuk solusi ini dapat ditemukan di GitHub.

Pertama, kami menerapkan model penyematan LLM Flan T5 XXL dan GPT-J 6B dengan cara yang sama seperti di bagian sebelumnya. Untuk setiap catatan dalam basis data pengetahuan, kami membuat vektor penyematan menggunakan model penyematan GPT-J.

Selanjutnya kita menggunakan a SageMaker KNN pekerjaan pelatihan untuk mengindeks embedding dari data pengetahuan. Algoritma yang mendasari yang digunakan untuk mengindeks data adalah FAISS. Kami ingin menemukan lima dokumen paling relevan teratas, jadi kami mengaturnya TOP_K variabel ke 5. Kami membuat estimator untuk algoritme KNN, menjalankan tugas pelatihan, dan menerapkan model KNN untuk menemukan indeks dari lima dokumen teratas yang cocok dengan kueri. Lihat kode berikut:

Selanjutnya, kami membuat representasi embedding dari kueri menggunakan model embedding GPT-J-6B yang kami gunakan untuk membuat embedding dokumen pustaka pengetahuan:

Kemudian kami menggunakan titik akhir KNN dan meneruskan penyisipan kueri ke titik akhir KNN untuk mendapatkan indeks K atas dokumen yang paling relevan. Kami menggunakan indeks untuk mengambil dokumen tekstual terkait. Selanjutnya, kami menggabungkan dokumen, memastikan panjang konteks maksimum yang diizinkan tidak terlampaui. Lihat kode berikut:

Sekarang kita sampai pada langkah terakhir kita di mana kita menggabungkan kueri, prompt, dan konteks yang berisi teks dari dokumen yang relevan dan meneruskannya ke model LLM Flan T5 XXL generasi teks untuk menghasilkan jawabannya.

Kami mendapatkan respons berikut untuk kueri menggunakan pendekatan berbasis RAG dengan Flan T5 XXL:

Membersihkan

Pastikan untuk menghapus titik akhir yang kami buat di notebook ini saat tidak menggunakannya untuk menghindari biaya berulang.

Kesimpulan

Dalam posting ini, kami mendemonstrasikan penerapan pendekatan berbasis RAG dengan LLM untuk tugas menjawab pertanyaan menggunakan dua pendekatan: LangChain dan algoritme KNN bawaan. Pendekatan berbasis RAG mengoptimalkan akurasi pembuatan teks menggunakan Flan T5 XXL dengan secara dinamis menyediakan konteks relevan yang dibuat dengan mencari daftar dokumen.

Anda dapat menggunakan buku catatan ini di SageMaker apa adanya atau Anda dapat menyesuaikannya dengan kebutuhan Anda. Untuk menyesuaikan, Anda dapat menggunakan kumpulan dokumen Anda sendiri di perpustakaan pengetahuan, menggunakan implementasi pencarian relevansi lainnya seperti OpenSearch, dan menggunakan model embedding dan LLM pembuatan teks lain yang tersedia di JumpStart.

Kami berharap dapat melihat apa yang Anda buat di JumpStart menggunakan pendekatan berbasis RAG!

Tentang penulis

Dr Xin Huang adalah Ilmuwan Terapan Senior untuk Amazon SageMaker JumpStart dan algoritme bawaan Amazon SageMaker. Dia berfokus pada pengembangan algoritme pembelajaran mesin yang dapat diskalakan. Minat penelitiannya adalah di bidang pemrosesan bahasa alami, pembelajaran mendalam yang dapat dijelaskan pada data tabular, dan analisis kuat pengelompokan ruang-waktu non-parametrik. Dia telah menerbitkan banyak makalah di konferensi ACL, ICDM, KDD, dan Royal Statistical Society: Series A.

Dr Xin Huang adalah Ilmuwan Terapan Senior untuk Amazon SageMaker JumpStart dan algoritme bawaan Amazon SageMaker. Dia berfokus pada pengembangan algoritme pembelajaran mesin yang dapat diskalakan. Minat penelitiannya adalah di bidang pemrosesan bahasa alami, pembelajaran mendalam yang dapat dijelaskan pada data tabular, dan analisis kuat pengelompokan ruang-waktu non-parametrik. Dia telah menerbitkan banyak makalah di konferensi ACL, ICDM, KDD, dan Royal Statistical Society: Series A.

Rakhna Chadha adalah Arsitek Solusi Utama AI/ML dalam Akun Strategis di AWS. Rachna adalah seorang optimis yang percaya bahwa penggunaan AI secara etis dan bertanggung jawab dapat meningkatkan masyarakat di masa depan dan membawa kemakmuran ekonomi dan sosial. Di waktu senggangnya, Rachna suka menghabiskan waktu bersama keluarganya, mendaki gunung dan mendengarkan musik.

Rakhna Chadha adalah Arsitek Solusi Utama AI/ML dalam Akun Strategis di AWS. Rachna adalah seorang optimis yang percaya bahwa penggunaan AI secara etis dan bertanggung jawab dapat meningkatkan masyarakat di masa depan dan membawa kemakmuran ekonomi dan sosial. Di waktu senggangnya, Rachna suka menghabiskan waktu bersama keluarganya, mendaki gunung dan mendengarkan musik.

Dr.Kyle Ulrich adalah Ilmuwan Terapan dengan tim algoritme bawaan Amazon SageMaker. Minat penelitiannya meliputi algoritme pembelajaran mesin yang dapat diskalakan, visi komputer, deret waktu, non-parametrik Bayesian, dan proses Gaussian. PhD-nya dari Duke University dan dia telah menerbitkan makalah di NeurIPS, Cell, dan Neuron.

Dr.Kyle Ulrich adalah Ilmuwan Terapan dengan tim algoritme bawaan Amazon SageMaker. Minat penelitiannya meliputi algoritme pembelajaran mesin yang dapat diskalakan, visi komputer, deret waktu, non-parametrik Bayesian, dan proses Gaussian. PhD-nya dari Duke University dan dia telah menerbitkan makalah di NeurIPS, Cell, dan Neuron.

Hemant Singh adalah Insinyur Pembelajaran Mesin dengan pengalaman dalam Amazon SageMaker JumpStart dan algoritme bawaan Amazon SageMaker. Dia mendapatkan gelar masternya dari Courant Institute of Mathematical Sciences dan B.Tech dari IIT Delhi. Dia memiliki pengalaman dalam mengerjakan beragam masalah Pembelajaran Mesin dalam domain pemrosesan bahasa alami, visi komputer, dan analisis deret waktu.

Hemant Singh adalah Insinyur Pembelajaran Mesin dengan pengalaman dalam Amazon SageMaker JumpStart dan algoritme bawaan Amazon SageMaker. Dia mendapatkan gelar masternya dari Courant Institute of Mathematical Sciences dan B.Tech dari IIT Delhi. Dia memiliki pengalaman dalam mengerjakan beragam masalah Pembelajaran Mesin dalam domain pemrosesan bahasa alami, visi komputer, dan analisis deret waktu.

Manas Dadarkar adalah Manajer Pengembangan Perangkat Lunak yang memiliki rekayasa layanan Amazon Forecast. Dia sangat tertarik dengan penerapan pembelajaran mesin dan membuat teknologi ML tersedia dengan mudah bagi semua orang untuk diadopsi dan diterapkan ke produksi. Di luar pekerjaan, ia memiliki banyak minat termasuk bepergian, membaca, dan menghabiskan waktu bersama teman dan keluarga.

Manas Dadarkar adalah Manajer Pengembangan Perangkat Lunak yang memiliki rekayasa layanan Amazon Forecast. Dia sangat tertarik dengan penerapan pembelajaran mesin dan membuat teknologi ML tersedia dengan mudah bagi semua orang untuk diadopsi dan diterapkan ke produksi. Di luar pekerjaan, ia memiliki banyak minat termasuk bepergian, membaca, dan menghabiskan waktu bersama teman dan keluarga.

Dr Ashish Khetan adalah Ilmuwan Terapan Senior dengan algoritme bawaan Amazon SageMaker dan membantu mengembangkan algoritme pembelajaran mesin. Ia mendapatkan gelar PhD dari University of Illinois Urbana-Champaign. Dia adalah peneliti aktif dalam pembelajaran mesin dan inferensi statistik, dan telah menerbitkan banyak makalah di konferensi NeurIPS, ICML, ICLR, JMLR, ACL, dan EMNLP.

Dr Ashish Khetan adalah Ilmuwan Terapan Senior dengan algoritme bawaan Amazon SageMaker dan membantu mengembangkan algoritme pembelajaran mesin. Ia mendapatkan gelar PhD dari University of Illinois Urbana-Champaign. Dia adalah peneliti aktif dalam pembelajaran mesin dan inferensi statistik, dan telah menerbitkan banyak makalah di konferensi NeurIPS, ICML, ICLR, JMLR, ACL, dan EMNLP.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoAiStream. Kecerdasan Data Web3. Pengetahuan Diperkuat. Akses Di Sini.

- Mencetak Masa Depan bersama Adryenn Ashley. Akses Di Sini.

- Sumber: https://aws.amazon.com/blogs/machine-learning/question-answering-using-retrieval-augmented-generation-with-foundation-models-in-amazon-sagemaker-jumpstart/

- :memiliki

- :adalah

- :bukan

- :Di mana

- $NAIK

- 1

- 10

- 100

- 11

- 12

- 13

- 26%

- 500

- 7

- 8

- 9

- a

- Sanggup

- Tentang Kami

- abstrak

- mempercepat

- Menerima

- diakses

- Akun

- ketepatan

- tepat

- aktif

- menambahkan

- menambahkan

- menambahkan

- tambahan

- Tambahan

- Menambahkan

- mengambil

- Keuntungan

- keuntungan

- agen

- AI

- AI / ML

- AL

- algoritma

- algoritma

- Semua

- memungkinkan

- sepanjang

- juga

- selalu

- Amazon

- Prakiraan Amazon

- Amazon SageMaker

- Mulai Lompatan Amazon SageMaker

- jumlah

- an

- analisis

- dan

- Mengumumkan

- Lain

- menjawab

- jawaban

- Lebah

- Aplikasi

- aplikasi

- terapan

- Mendaftar

- pendekatan

- pendekatan

- arsitektur

- ADALAH

- DAERAH

- artikel

- AS

- At

- ditambah

- tersedianya

- tersedia

- menghindari

- AWS

- berdasarkan

- Bayesian

- BE

- karena

- percaya

- Lebih baik

- antara

- Bot

- membawa

- membangun

- built-in

- bisnis

- tapi

- by

- bernama

- Panggilan

- CAN

- kemampuan

- kasus

- kasus

- rantai

- rantai

- menantang

- Perubahan

- ChatBot

- pilihan

- Pilih

- kelas

- kekelompokan

- kode

- Pengkodean

- koleksi

- menggabungkan

- bagaimana

- perusahaan

- sebanding

- dibandingkan

- penyelesaian

- komputer

- Visi Komputer

- konsep

- konseptual

- konferensi

- kendala

- mengandung

- konteks

- Percakapan

- mengubah

- dikonversi

- benar

- Sesuai

- Biaya

- Covid-19

- membuat

- dibuat

- membuat

- penciptaan

- Sekarang

- kustomisasi

- menyesuaikan

- data

- ilmu data

- Basis Data

- database

- mendalam

- belajar mendalam

- Delhi

- mendemonstrasikan

- menunjukkan

- Tergantung

- menyebarkan

- dikerahkan

- penyebaran

- menggambarkan

- terperinci

- rincian

- mengembangkan

- Pengembang

- pengembang

- berkembang

- Pengembangan

- MELAKUKAN

- perbedaan

- berbeda

- dibahas

- beberapa

- dokumen

- dokumen

- Tidak

- melakukan

- domain

- dilakukan

- Duke

- universitas adipati

- dinamis

- E&T

- setiap

- Terdahulu

- mudah

- mudah

- Efektif

- tertanam

- embedding

- memungkinkan

- ujung ke ujung

- Titik akhir

- insinyur

- Teknik

- ditingkatkan

- memastikan

- Enterprise

- dasarnya

- etis

- Bahkan

- semua orang

- contoh

- melampaui

- pengalaman

- menyelidiki

- luar

- keluarga

- Fitur

- Fitur

- Fed

- beberapa

- File

- terakhir

- Menemukan

- temuan

- Pertama

- cocok

- tetap

- keluwesan

- aliran

- berfokus

- berikut

- Untuk

- Ramalan

- format

- Depan

- ditemukan

- Prinsip Dasar

- empat

- Kerangka

- sering

- sering

- teman

- dari

- lebih lanjut

- masa depan

- Umum

- menghasilkan

- dihasilkan

- menghasilkan

- generasi

- mendapatkan

- diberikan

- besar

- memiliki

- Sulit

- Memiliki

- he

- Kesehatan

- asuransi kesehatan

- membantu

- membantu

- dia

- High

- -nya

- Memukul

- Seterpercayaapakah Olymp Trade? Kesimpulan

- How To

- Namun

- HTML

- HTTPS

- Pusat

- i

- diidentifikasi

- mengenali

- if

- Illinois

- gambar

- dampak

- melaksanakan

- implementasi

- mengimpor

- memperbaiki

- in

- memasukkan

- Termasuk

- indeks

- indeks

- informasi

- contoh

- sebagai gantinya

- Lembaga

- instruksi

- asuransi

- mengintegrasikan

- integrasi

- kepentingan

- Antarmuka

- ke

- diperkenalkan

- IT

- NYA

- Pekerjaan

- perjalanan

- jpg

- json

- hanya

- pengetahuan

- bahasa

- besar

- besar-besaran

- lebih besar

- Terbaru

- terkemuka

- pengetahuan

- Panjang

- Perpustakaan

- 'like'

- 'like

- pembatasan

- keterbatasan

- Terbatas

- batas

- baris

- Daftar

- Listening

- LLM

- memuat

- pemuat

- lokasi

- melihat

- mencari

- TERLIHAT

- Rendah

- mesin

- Mesin belajar

- memelihara

- membuat

- MEMBUAT

- Membuat

- berhasil

- manajer

- banyak

- Pasar

- Cocok

- sesuai

- matematis

- maksimum

- Mungkin..

- Memori

- metode

- ML

- model

- model

- lebih

- paling

- banyak

- beberapa

- musik

- Alam

- Pengolahan Bahasa alami

- Perlu

- dibutuhkan

- kebutuhan

- berikutnya

- tidak

- buku catatan

- sekarang

- jumlah

- of

- Penawaran

- Pengunjung

- on

- hanya

- open source

- Mengoptimalkan

- or

- asli

- Lainnya

- kami

- keluaran

- di luar

- secara keseluruhan

- sendiri

- paket

- dokumen

- parameter

- bagian

- tertentu

- lulus

- Lulus

- melewati

- bergairah

- Melakukan

- rencana

- plato

- Kecerdasan Data Plato

- Data Plato

- Populer

- Pos

- didukung

- kuat

- Prediksi

- Predictor

- sebelumnya

- Utama

- Masalah

- masalah

- proses

- pengolahan

- Produk

- Produksi

- produktifitas

- kemakmuran

- memberikan

- disediakan

- menyediakan

- menyediakan

- diterbitkan

- tujuan

- query

- pertanyaan

- Pertanyaan

- segera

- jarak

- agak

- Bacaan

- siap

- nyata

- catatan

- mencerminkan

- daerah

- relevan

- gudang

- perwakilan

- permintaan

- penelitian

- peneliti

- tanggapan

- tanggapan

- tanggung jawab

- Hasil

- kembali

- kuat

- kerajaan

- aturan

- Run

- pembuat bijak

- sama

- Tabungan

- terukur

- skenario

- Ilmu

- ILMU PENGETAHUAN

- ilmuwan

- Pencarian

- mencari

- Bagian

- bagian

- melihat

- melihat

- terpilih

- DIRI

- mengirim

- senior

- Urutan

- Seri

- Seri A

- layanan

- Layanan

- set

- harus

- Menunjukkan

- ditunjukkan

- Pertunjukkan

- mirip

- Ukuran

- So

- Sosial

- Masyarakat

- Perangkat lunak

- pengembangan perangkat lunak

- larutan

- MEMECAHKAN

- sumber

- Space

- tertentu

- kecepatan

- Pengeluaran

- Spot

- standar

- mulai

- Negara

- statistik

- Langkah

- Tangga

- Masih

- menyimpan

- tersimpan

- Strategis

- langganan

- seperti itu

- memasok

- mendukung

- Didukung

- Mengambil

- tugas

- tugas

- tim

- tech

- Teknologi

- Template

- template

- dari

- bahwa

- Grafik

- Daerah

- informasi

- Negara

- mereka

- Mereka

- kemudian

- Sana.

- karena itu

- Ini

- mereka

- ini

- tiga

- waktu

- Seri waktu

- untuk

- bersama

- puncak

- Pelatihan VE

- terlatih

- Pelatihan

- Mengubah

- Transformasi

- mencoba

- dua

- pokok

- unik

- universitas

- mutakhir

- Memperbarui

- diperbarui

- penggunaan

- menggunakan

- gunakan case

- bekas

- Pengguna

- Pengguna

- menggunakan

- biasanya

- kegunaan

- berbagai

- maya

- mesin virtual

- penglihatan

- ingin

- adalah

- Cara..

- cara

- we

- adalah

- Apa

- ketika

- yang

- sementara

- SIAPA

- Wikipedia

- akan

- dengan

- dalam

- Kerja

- kerja

- akan

- Kamu

- Anda

- zephyrnet.dll