Seiring dengan pesatnya inovasi dalam kecerdasan buatan (AI), tahun 2024 akan menjadi waktu yang penting bagi organisasi dan badan pemerintahan untuk menetapkan standar keamanan, protokol, dan batasan lainnya untuk mencegah AI menjadi yang terdepan, demikian peringatan para pakar keamanan.

Model bahasa besar (LLM), yang didukung oleh algoritme canggih dan kumpulan data yang sangat besar, menunjukkan pemahaman bahasa yang luar biasa dan kemampuan percakapan yang mirip manusia. Salah satu platform tercanggih hingga saat ini adalah GPT-4 OpenAI, yang menawarkan kemampuan penalaran dan pemecahan masalah tingkat lanjut serta mendukung bot ChatGPT perusahaan. Dan perusahaan, bekerja sama dengan Microsoft, telah mulai mengerjakan GPT-5, seperti yang dikatakan CEO Sam Altman akan melangkah lebih jauh — sampai pada titik memiliki “kecerdasan super.”

Model-model ini mewakili potensi besar dalam peningkatan produktivitas dan efisiensi yang signifikan bagi organisasi, namun para ahli sepakat bahwa waktunya telah tiba untuk industri secara keseluruhan. untuk mengatasi risiko keamanan yang melekat ditimbulkan oleh pengembangan dan penyebarannya. Memang, penelitian terbaru oleh Writerbuddy AI, yang menawarkan alat penulisan konten berbasis AI, menemukan bahwa ChatGPT telah dikunjungi 14 miliar dan terus bertambah.

Ketika organisasi bergerak menuju kemajuan dalam AI, hal ini “harus dibarengi dengan pertimbangan etika dan penilaian risiko yang ketat,” kata Gal Ringel, CEO perusahaan privasi dan keamanan berbasis AI, MineOS.

Apakah AI merupakan Ancaman Eksistensial?

Kekhawatiran seputar keamanan AI generasi berikutnya mulai meningkat pada bulan Maret, dengan adanya surat terbuka yang ditandatangani oleh hampir 34,000 ahli teknologi terkemuka yang menyerukan penghentian pengembangan sistem AI generatif yang lebih canggih dari AI. GPT-4 OpenAI. Surat tersebut menyebutkan “risiko besar” terhadap masyarakat yang ditimbulkan oleh teknologi tersebut dan “perlombaan tak terkendali oleh laboratorium AI untuk mengembangkan dan menerapkan pikiran digital yang lebih kuat yang tidak dapat dipahami, diprediksi, atau diprediksi oleh siapa pun – bahkan penciptanya – pun. kendali yang andal.”

Terlepas dari ketakutan distopia tersebut, sebagian besar pakar keamanan tidak terlalu khawatir dengan skenario kiamat di mana mesin menjadi lebih pintar dari manusia dan mengambil alih dunia.

“Surat terbuka tersebut mencatat kekhawatiran yang sahih mengenai kemajuan pesat dan potensi penerapan AI dalam arti luas, ‘apakah ini baik bagi kemanusiaan’,” kata Matt Wilson, direktur teknik penjualan di perusahaan keamanan siber Netrix. “Meskipun mengesankan dalam skenario tertentu, alat AI versi publik tidak tampak terlalu mengancam.”

Yang mengkhawatirkan adalah fakta bahwa kemajuan dan adopsi AI berjalan terlalu cepat sehingga risikonya tidak bisa dikelola dengan baik, kata para peneliti. “Kami tidak dapat menutup kembali kotak Pandora,” kata Patrick Harr, CEO penyedia keamanan AI SlashNext.

Selain itu, “mencoba menghentikan laju inovasi di bidang ini tidak akan membantu mengurangi” risiko yang ditimbulkannya, yang harus ditangani secara terpisah, kata Marcus Fowler, CEO perusahaan keamanan AI DarkTrace Federal. Itu tidak berarti pengembangan AI harus dibiarkan begitu saja, katanya. Sebaliknya, tingkat penilaian risiko dan penerapan upaya perlindungan yang tepat harus sesuai dengan tingkat pelatihan dan pengembangan LLM.

“Teknologi AI berkembang dengan cepat, sehingga pemerintah dan organisasi yang menggunakan AI juga harus mempercepat diskusi seputar keamanan AI,” jelas Fowler.

Risiko AI Generatif

Ada beberapa risiko yang diketahui secara luas terhadap AI generatif yang memerlukan pertimbangan dan hanya akan menjadi lebih buruk seiring dengan semakin pintarnya teknologi generasi mendatang. Untungnya bagi manusia, sejauh ini tidak satu pun dari mereka yang mengajukan skenario kiamat fiksi ilmiah di mana AI berkonspirasi untuk menghancurkan penciptanya.

Sebaliknya, ancaman tersebut mencakup ancaman yang jauh lebih umum, seperti kebocoran data, yang mungkin merupakan informasi sensitif bisnis; penyalahgunaan untuk aktivitas jahat; dan keluaran yang tidak akurat yang dapat menyesatkan atau membingungkan pengguna, yang pada akhirnya mengakibatkan konsekuensi bisnis yang negatif.

Karena LLM memerlukan akses ke sejumlah besar data untuk memberikan keluaran yang akurat dan relevan secara kontekstual, informasi sensitif dapat terungkap atau disalahgunakan secara tidak sengaja.

“Risiko utamanya adalah karyawan yang memberi makan dengan informasi sensitif bisnis ketika memintanya untuk menulis rencana atau menyusun ulang email atau dek bisnis yang berisi informasi hak milik perusahaan,” catat Ringel.

Dari perspektif serangan siber, pelaku ancaman telah menemukan berbagai cara untuk menggunakan ChatGPT dan sistem AI lainnya sebagai senjata. Salah satu caranya adalah dengan menggunakan model tersebut untuk membuat kompromi email bisnis (BEC) yang canggih dan serangan phishing lainnya, yang memerlukan pembuatan pesan yang dipersonalisasi dan direkayasa secara sosial yang dirancang untuk mencapai kesuksesan.

“Dengan malware, ChatGPT memungkinkan penjahat dunia maya membuat variasi kode tanpa batas agar tetap selangkah lebih maju dari mesin pendeteksi malware,” kata Harr.

Halusinasi AI juga menimbulkan ancaman keamanan yang signifikan dan memungkinkan pelaku kejahatan mempersenjatai teknologi berbasis LLM seperti ChatGPT dengan cara yang unik. Halusinasi AI adalah respons AI yang masuk akal, namun tidak memadai, bias, atau sama sekali tidak benar. “Respon fiktif atau tanggapan lain yang tidak diinginkan dapat mengarahkan organisasi ke dalam pengambilan keputusan, proses, dan komunikasi yang menyesatkan,” Avivah Litan, wakil presiden Gartner memperingatkan.

Pelaku ancaman juga dapat menggunakan halusinasi ini untuk meracuni LLM dan “menghasilkan misinformasi spesifik sebagai jawaban atas sebuah pertanyaan,” kata Michael Rinehart, wakil presiden AI di penyedia keamanan data Securiti. “Hal ini dapat diperluas ke pembuatan kode sumber yang rentan dan, mungkin, ke model obrolan yang mampu mengarahkan pengguna situs ke tindakan yang tidak aman.”

Penyerang bahkan bisa bertindak sejauh itu mempublikasikan versi paket perangkat lunak yang berbahaya yang mungkin direkomendasikan LLM kepada pengembang perangkat lunak, dengan keyakinan bahwa ini adalah perbaikan yang sah untuk suatu masalah. Dengan cara ini, penyerang dapat mempersenjatai AI untuk melancarkan serangan rantai pasokan.

Jalan ke Depan

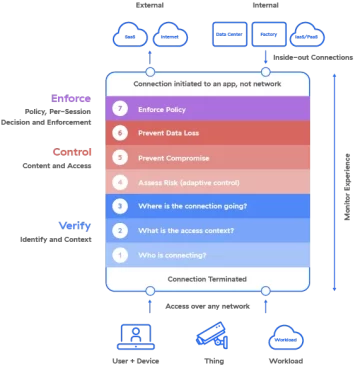

Mengelola risiko-risiko ini memerlukan tindakan terukur dan kolektif sebelum inovasi AI melampaui kemampuan industri untuk mengendalikannya, kata para ahli. Namun mereka juga punya ide tentang cara mengatasi masalah AI.

Harr percaya pada “melawan AI dengan A” strategi, yang mana “kemajuan dalam solusi keamanan dan strategi untuk menggagalkan risiko yang dipicu oleh AI harus berkembang dengan kecepatan yang sama atau lebih besar.

“Perlindungan keamanan siber perlu memanfaatkan AI agar berhasil melawan ancaman siber menggunakan teknologi AI,” tambahnya. “Sebagai perbandingan, teknologi keamanan lama tidak memiliki peluang melawan serangan ini.”

Namun, organisasi juga harus mengambil pendekatan terukur dalam mengadopsi AI – termasuk Solusi keamanan berbasis AI — agar mereka tidak menimbulkan lebih banyak risiko pada lingkungan mereka, Wilson dari Netrix memperingatkan.

“Pahami apa itu AI dan apa yang bukan AI,” sarannya. “Tantang vendor yang mengklaim menggunakan AI untuk menjelaskan fungsinya, bagaimana AI meningkatkan solusi mereka, dan mengapa hal itu penting bagi organisasi Anda.”

Rinehart dari Securiti menawarkan pendekatan dua tingkat untuk memasukkan AI ke dalam lingkungan secara bertahap dengan menerapkan solusi terfokus dan kemudian menempatkan pagar pembatas segera sebelum memaparkan organisasi pada risiko yang tidak perlu.

“Pertama, adopsi model khusus aplikasi, yang berpotensi ditambah dengan basis pengetahuan, yang disesuaikan untuk memberikan nilai dalam kasus penggunaan tertentu,” katanya. “Kemudian… menerapkan sistem pemantauan untuk melindungi model-model ini dengan memeriksa pesan-pesan yang masuk dan dari mereka untuk mengetahui masalah privasi dan keamanan.”

Para ahli juga merekomendasikan untuk menyiapkan kebijakan dan prosedur keamanan seputar AI sebelum diterapkan, bukan hanya sekedar pertimbangan untuk memitigasi risiko. Mereka bahkan dapat membentuk petugas risiko AI atau gugus tugas khusus untuk mengawasi kepatuhan.

Di luar perusahaan, industri secara keseluruhan juga harus mengambil langkah-langkah untuk menetapkan standar dan praktik keamanan seputar AI yang dapat diadopsi oleh semua orang yang mengembangkan dan menggunakan teknologi tersebut – sesuatu yang memerlukan tindakan kolektif baik dari sektor publik maupun swasta dalam skala global. , kata Fowler dari DarkTrace Federal.

Dia mengutip pedoman untuk membangun sistem AI yang aman diterbitkan secara kolaboratif oleh Badan Keamanan Siber dan Infrastruktur AS (CISA) dan Pusat Keamanan Siber Nasional Inggris (NCSC) sebagai contoh upaya yang harus dilakukan seiring dengan evolusi AI yang berkelanjutan.

“Intinya,” kata Rinehart dari Securiti, “tahun 2024 akan menjadi saksi adaptasi cepat dari keamanan tradisional dan teknik AI mutakhir untuk melindungi pengguna dan data di era AI generatif yang sedang berkembang ini.”

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- Sumber: https://www.darkreading.com/vulnerabilities-threats/skynet-ahoy-what-to-expect-next-gen-ai-security-risks

- :memiliki

- :adalah

- :bukan

- $NAIK

- 000

- 14

- 2024

- 7

- a

- kemampuan

- Tentang Kami

- mempercepat

- mengakses

- menemani

- tepat

- Tindakan

- tindakan

- kegiatan

- aktor

- adaptasi

- alamat

- dialamatkan

- Menambahkan

- mengambil

- Mengadopsi

- Adopsi

- maju

- kemajuan

- kemajuan

- terhadap

- badan

- di depan

- AI

- Sistem AI

- algoritma

- Semua

- mengizinkan

- sudah

- juga

- jumlah

- an

- dan

- dan infrastruktur

- muncul

- aplikasi

- pendekatan

- sesuai

- ADALAH

- ARM

- sekitar

- buatan

- kecerdasan buatan

- Kecerdasan buatan (AI)

- AS

- meminta

- penilaian

- penilaian

- At

- Serangan

- berusaha

- ditambah

- kembali

- Pertarungan

- BE

- BEC

- menjadi

- menjadi

- sebelum

- makhluk

- percaya

- percaya

- bias

- Milyar

- membanggakan

- tubuh

- Bot

- kedua

- Kotak

- luas

- Bangunan

- bisnis

- kompromi email bisnis

- tapi

- by

- bernama

- CAN

- tidak bisa

- kemampuan

- mampu

- kasus

- peringatan

- pusat

- ceo

- tertentu

- rantai

- menantang

- kesempatan

- mengobrol

- ChatGPT

- dikutip

- klaim

- kode

- Kolektif

- bagaimana

- komunikasi

- perusahaan

- perbandingan

- pemenuhan

- kompromi

- prihatin

- tentang

- Kekhawatiran

- Konsekuensi

- pertimbangan

- pertimbangan

- terus

- terus

- terus

- kebalikan

- kontrol

- percakapan

- perhitungan

- ditambah

- membuat

- penciptaan

- pencipta

- sangat penting

- canggih

- maya

- keamanan cyber

- Serangan cyber

- penjahat cyber

- Keamanan cyber

- data

- keamanan data

- set data

- Tanggal

- Pengambilan Keputusan

- dedicated

- Permintaan

- mendemonstrasikan

- menyebarkan

- dikerahkan

- penggelaran

- penyebaran

- menggambarkan

- dirancang

- menghancurkan

- Deteksi

- mengembangkan

- dikembangkan

- Pengembang

- berkembang

- Pengembangan

- digital

- Mengarahkan

- Kepala

- diskusi

- tidak

- doesn

- don

- kiamat

- dystopian

- efisiensi

- upaya

- muncul

- karyawan

- memungkinkan

- direkayasa

- Teknik

- Mesin

- Meningkatkan

- besar sekali

- Enterprise

- Lingkungan Hidup

- sama

- Era

- esensi

- menetapkan

- etis

- Bahkan

- pERNAH

- semua orang

- evolusi

- berkembang

- contoh

- eksistensial

- mengharapkan

- ahli

- Menjelaskan

- fakta

- akrab

- jauh

- salah

- ketakutan

- Federal

- pemberian makanan

- khayali

- Perusahaan

- Pertama

- Memperbaiki

- segera

- terfokus

- Untuk

- kekuatan

- Untung

- ditemukan

- dari

- FT

- didorong

- lebih lanjut

- masa depan

- Keuntungan

- GAL

- Gartner

- menghasilkan

- generasi

- Generasi

- generatif

- AI generatif

- mendapatkan

- mendapatkan

- Aksi

- skala global

- Go

- baik

- memerintah

- Pemerintah

- lebih besar

- memiliki

- Memiliki

- he

- membantu

- Seterpercayaapakah Olymp Trade? Kesimpulan

- How To

- HTTPS

- Kemanusiaan

- seperti manusia

- Manusia

- ide-ide

- segera

- melaksanakan

- mengimplementasikan

- impresif

- in

- tidak akurat

- secara tidak sengaja

- memasukkan

- Termasuk

- memang

- industri

- Tak terbatas

- Info

- informasi

- Infrastruktur

- inheren

- Innovation

- Intelijen

- ke

- memperkenalkan

- adalah n

- masalah

- IT

- NYA

- jpg

- pengetahuan

- Labs

- bahasa

- kebocoran

- Warisan

- sah

- surat

- Leverage

- 'like'

- LLM

- Mesin

- Utama

- membuat

- jahat

- malware

- deteksi malware

- berhasil

- March

- Marcus

- besar-besaran

- Cocok

- matt

- Hal-hal

- berarti

- hanya

- pesan

- Michael

- Microsoft

- mungkin

- pikiran

- Keterangan yg salah

- menyesatkan

- penyalahgunaan

- Mengurangi

- model

- pemantauan

- lebih

- paling

- MOUNT

- bergerak

- banyak

- harus

- banyak sekali

- nasional

- NCSC

- hampir

- kebutuhan

- negatif

- berikutnya

- tidak

- None

- mencatat

- terkenal

- Catatan

- mengamati

- of

- Penawaran

- Petugas

- on

- ONE

- hanya

- Buka

- OpenAI

- or

- organisasi

- organisasi

- Lainnya

- output

- lebih

- mengawasi

- Perdamaian

- Kemitraan

- patrick

- Personalized

- perspektif

- Phishing

- serangan phishing

- Tempat

- rencana

- Platform

- plato

- Kecerdasan Data Plato

- Data Plato

- Titik

- racun

- Kebijakan

- pose

- berpose

- pose

- mungkin

- potensi

- berpotensi

- didukung

- kuat

- kekuatan

- praktek

- meramalkan

- hadiah

- presiden

- mencegah

- pribadi

- Keamanan dan Privasi

- swasta

- sektor swasta

- Masalah

- pemecahan masalah

- Prosedur

- proses

- produktifitas

- mendalam

- Kemajuan

- tepat

- hak milik

- perlindungan

- protokol

- memberikan

- pemberi

- publik

- diterbitkan

- menempatkan

- Puting

- pertanyaan

- segera

- Ras

- cepat

- Penilaian

- agak

- diakui

- sarankan

- relevan

- luar biasa

- ulang

- mewakili

- merupakan

- membutuhkan

- penelitian

- peneliti

- tanggapan

- tanggapan

- dihasilkan

- Terungkap

- keras

- Risiko

- penilaian risiko

- risiko

- s

- pengamanan

- pengamanan

- Safety/keselamatan

- Tersebut

- penjualan

- Universitas

- sam altman

- mengatakan

- Skala

- skenario

- skenario

- sektor

- aman

- keamanan

- kebijakan keamanan

- risiko keamanan

- rasa

- peka

- set

- set

- pengaturan

- beberapa

- harus

- tertanda

- penting

- situs web

- Skynet

- cerdas

- So

- sejauh ini

- sosial

- Masyarakat

- Perangkat lunak

- larutan

- Solusi

- sesuatu

- mutakhir

- Space

- tertentu

- berdiri

- standar

- mulai

- tinggal

- mengemudikan

- Langkah

- Tangga

- berhenti

- strategi

- Penyelarasan

- sukses

- berhasil

- seperti itu

- Kecerdasan super

- menyediakan

- supply chain

- sistem

- sistem

- disesuaikan

- Mengambil

- tugas

- gugus tugas

- teknik

- teknologi

- Teknologi

- dari

- bahwa

- Grafik

- Inggris

- Dunia

- mereka

- Mereka

- kemudian

- Ini

- mereka

- ini

- itu

- ancaman

- aktor ancaman

- ancaman

- menggagalkan

- waktu

- untuk

- terlalu

- alat

- alat

- puncak

- terhadap

- tradisional

- terlatih

- benar

- mengetik

- Uk

- Akhirnya

- memahami

- pemahaman

- unik

- tidak perlu

- tidak diinginkan

- us

- menggunakan

- Pengguna

- menggunakan

- sah

- nilai

- Luas

- vendor

- Versi

- wakil

- Wakil Presiden

- Kunjungan

- Rentan

- Peringatkan

- Cara..

- cara

- we

- Apa

- ketika

- yang

- sementara

- seluruh

- mengapa

- sangat

- akan

- Wilson

- dengan

- menyaksikan

- Kerja

- dunia

- lebih buruk

- menulis

- tahun

- Anda

- zephyrnet.dll