Hari ini, kami dengan gembira mengumumkan bahwa model fondasi OpenAI Whisper telah tersedia untuk digunakan oleh pelanggan Mulai Lompatan Amazon SageMaker. Whisper adalah model terlatih untuk pengenalan ucapan otomatis (ASR) dan terjemahan ucapan. Dilatih pada 680 ribu jam data berlabel, model Whisper menunjukkan kemampuan yang kuat untuk melakukan generalisasi ke banyak kumpulan data dan domain tanpa perlu penyesuaian. Sagemaker JumpStart adalah pusat pembelajaran mesin (ML) dari SageMaker yang menyediakan akses ke model dasar selain algoritme bawaan dan templat solusi menyeluruh untuk membantu Anda memulai ML dengan cepat.

Anda juga dapat melakukan ASR menggunakan Amazon Transkripsikan , layanan pengenalan suara otomatis yang dikelola sepenuhnya dan terus dilatih.

Dalam postingan ini, kami menunjukkan cara menyebarkan BukaAI Whisper memodelkan dan memanggil model untuk menyalin dan menerjemahkan audio.

Model OpenAI Whisper menggunakan inferensi pelukanwajah-pytorch wadah. Sebagai pelanggan hub model SageMaker JumpStart, Anda dapat menggunakan ASR tanpa harus memelihara skrip model di luar SageMaker SDK. Model SageMaker JumpStart juga meningkatkan postur keamanan dengan titik akhir yang memungkinkan isolasi jaringan.

Model fondasi di SageMaker

SageMaker JumpStart menyediakan akses ke berbagai model dari hub model populer termasuk Hugging Face, PyTorch Hub, dan TensorFlow Hub, yang dapat Anda gunakan dalam alur kerja pengembangan ML Anda di SageMaker. Kemajuan terkini dalam ML telah memunculkan kelas model baru yang dikenal sebagai model pondasi, yang biasanya dilatih tentang miliaran parameter dan dapat disesuaikan dengan kategori kasus penggunaan yang luas, seperti peringkasan teks, menghasilkan seni digital, dan terjemahan bahasa. Karena model ini mahal untuk dilatih, pelanggan ingin menggunakan model pondasi yang telah dilatih sebelumnya dan menyempurnakannya sesuai kebutuhan, daripada melatih sendiri model tersebut. SageMaker menyediakan daftar model pilihan yang dapat Anda pilih di konsol SageMaker.

Anda sekarang dapat menemukan model pondasi dari penyedia model yang berbeda dalam SageMaker JumpStart, memungkinkan Anda memulai model pondasi dengan cepat. SageMaker JumpStart menawarkan model dasar berdasarkan tugas atau penyedia model yang berbeda, dan Anda dapat dengan mudah meninjau karakteristik model dan ketentuan penggunaan. Anda juga dapat mencoba model ini menggunakan widget pengujian UI. Saat Anda ingin menggunakan model dasar dalam skala besar, Anda dapat melakukannya tanpa meninggalkan SageMaker dengan menggunakan notebook bawaan dari penyedia model. Karena model dihosting dan diterapkan di AWS, Anda percaya bahwa data Anda, baik digunakan untuk mengevaluasi atau menggunakan model dalam skala besar, tidak akan dibagikan kepada pihak ketiga.

Model fondasi OpenAI Whisper

Whisper adalah model terlatih untuk ASR dan terjemahan ucapan. Whisper diusulkan di koran Pengenalan Ucapan yang Kuat melalui Pengawasan Lemah Berskala Besar oleh Alec Radford, dan lainnya, dari OpenAI. Kode asli dapat ditemukan di repositori GitHub ini.

Whisper adalah model encoder-decoder berbasis Transformer, juga disebut sebagai a urutan ke urutan model. Ia dilatih pada 680 ribu jam data ucapan berlabel yang dianotasi menggunakan pengawasan lemah berskala besar. Model Whisper menunjukkan kemampuan yang kuat untuk menggeneralisasi ke banyak kumpulan data dan domain tanpa memerlukan penyesuaian.

Model-model tersebut dilatih pada data berbahasa Inggris saja atau data multibahasa. Model yang hanya berbahasa Inggris dilatih untuk tugas pengenalan suara. Model multibahasa dilatih tentang pengenalan ucapan dan terjemahan ucapan. Untuk pengenalan ucapan, model memprediksi transkripsi di sama bahasa sebagai audio. Untuk terjemahan ucapan, model memprediksi transkripsi ke a berbeda bahasa ke audio.

Pos pemeriksaan Whisper hadir dalam lima konfigurasi dengan ukuran model yang berbeda-beda. Empat anak terkecil dilatih menggunakan data berbahasa Inggris saja atau multibahasa. Pos pemeriksaan terbesar hanya dapat digunakan dalam multibahasa. Kesepuluh pos pemeriksaan terlatih tersedia di Hub Wajah Memeluk. Pos pemeriksaan dirangkum dalam tabel berikut dengan tautan ke model di hub:

| Nama model | Jumlah parameter | Multilingual |

| berbisik-kecil | 39 M | Yes |

| basis bisikan | 74 M | Yes |

| bisikan-kecil | 244 M | Yes |

| bisikan-medium | 769 M | Yes |

| berbisik-besar | 1550 M | Yes |

| bisikan-besar-v2 | 1550 M | Yes |

Mari jelajahi bagaimana Anda dapat menggunakan model Whisper di SageMaker JumpStart.

Model dasar OpenAI Whisper WER dan perbandingan latensi

Tingkat kesalahan kata (WER) untuk model OpenAI Whisper yang berbeda berdasarkan Tes LibriSpeech-bersih ditunjukkan pada tabel berikut. WER adalah metrik umum untuk kinerja sistem pengenalan suara atau terjemahan mesin. Ini mengukur perbedaan antara teks referensi (kebenaran dasar atau transkripsi yang benar) dan keluaran sistem ASR dalam hal jumlah kesalahan, termasuk penggantian, penyisipan, dan penghapusan yang diperlukan untuk mengubah keluaran ASR menjadi referensi. teks. Angka-angka ini diambil dari Wajah Memeluk website.

| Model | WER (persen) |

| berbisik-kecil | 7.54 |

| basis bisikan | 5.08 |

| bisikan-kecil | 3.43 |

| bisikan-medium | 2.9 |

| berbisik-besar | 3 |

| bisikan-besar-v2 | 3 |

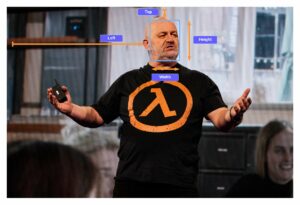

Untuk blog ini, kami mengambil file audio di bawah dan membandingkan latensi pengenalan ucapan di berbagai model bisikan. Latensi adalah jumlah waktu sejak pengguna mengirimkan permintaan hingga aplikasi Anda menunjukkan bahwa permintaan telah diselesaikan. Angka-angka dalam tabel berikut mewakili latensi rata-rata untuk total 100 permintaan menggunakan file audio yang sama dengan model yang dihosting di instance ml.g5.2xlarge.

| Model | Latensi rata-rata | keluaran model |

| berbisik-kecil | 0.43 | Kita hidup di masa yang sangat menyenangkan dengan penerangan mesin. Kecepatan pengembangan model ML akan meningkat. Namun Anda tidak akan mencapai kondisi akhir seperti yang kami menangkan di tahun-tahun mendatang. Kecuali kita benar-benar membuat model ini lebih mudah diakses oleh semua orang. |

| basis bisikan | 0.49 | Kita hidup di masa yang sangat menyenangkan dengan pembelajaran mesin. Kecepatan pengembangan model ML akan meningkat. Namun Anda tidak akan mencapai kondisi akhir yang kami menangkan di tahun-tahun mendatang. Kecuali kita benar-benar membuat model ini lebih mudah diakses oleh semua orang. |

| bisikan-kecil | 0.84 | Kita hidup di masa yang sangat menyenangkan dengan pembelajaran mesin. Kecepatan pengembangan model ML akan meningkat. Namun Anda tidak akan mencapai kondisi akhir yang kita inginkan di tahun-tahun mendatang kecuali kita benar-benar membuat model ini lebih mudah diakses oleh semua orang. |

| bisikan-medium | 1.5 | Kita hidup di masa yang sangat menyenangkan dengan pembelajaran mesin. Kecepatan pengembangan model ML akan meningkat. Namun Anda tidak akan mencapai kondisi akhir yang kita inginkan di tahun-tahun mendatang kecuali kita benar-benar membuat model ini lebih mudah diakses oleh semua orang. |

| berbisik-besar | 1.96 | Kita hidup di masa yang sangat menyenangkan dengan pembelajaran mesin. Kecepatan pengembangan model ML akan meningkat. Namun Anda tidak akan mencapai kondisi akhir yang kita inginkan di tahun-tahun mendatang kecuali kita benar-benar membuat model ini lebih mudah diakses oleh semua orang. |

| bisikan-besar-v2 | 1.98 | Kita hidup di masa yang sangat menyenangkan dengan pembelajaran mesin. Kecepatan pengembangan model ML akan meningkat. Namun Anda tidak akan mencapai kondisi akhir yang kita inginkan di tahun-tahun mendatang kecuali kita benar-benar membuat model ini lebih mudah diakses oleh semua orang. |

Panduan solusi

Anda dapat menerapkan model Whisper menggunakan konsol Amazon SageMaker atau menggunakan Notebook Amazon SageMaker. Dalam postingan ini, kami mendemonstrasikan cara menerapkan Whisper API menggunakan konsol SageMaker Studio atau Notebook SageMaker, lalu menggunakan model yang diterapkan untuk pengenalan ucapan dan terjemahan bahasa. Kode yang digunakan dalam posting ini dapat ditemukan di buku catatan GitHub ini.

Mari kembangkan setiap langkah secara mendetail.

Terapkan Whisper dari konsol

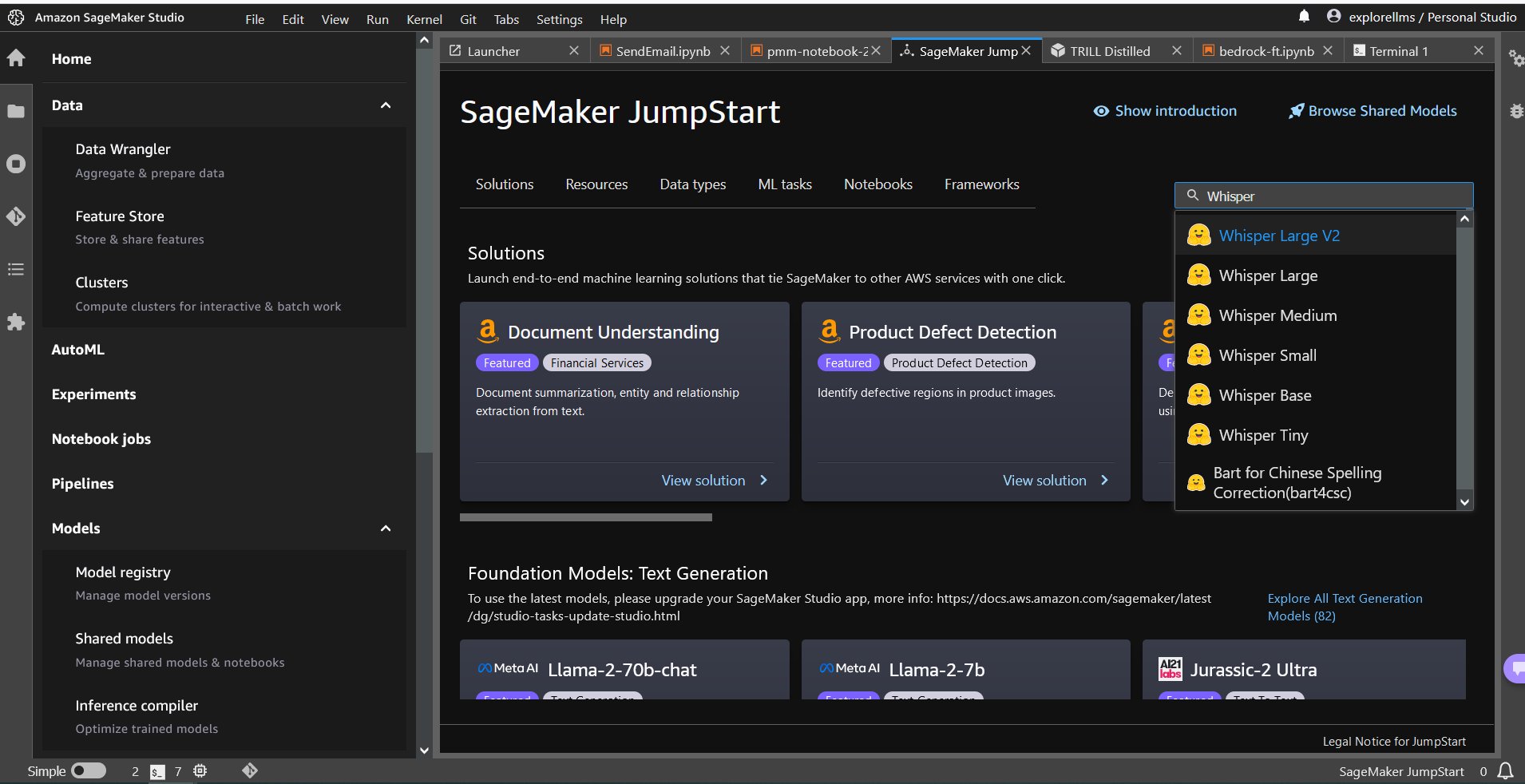

- Untuk memulai SageMaker JumpStart, buka konsol Amazon SageMaker Studio dan buka halaman peluncuran SageMaker JumpStart dan pilih Memulai dengan JumpStart.

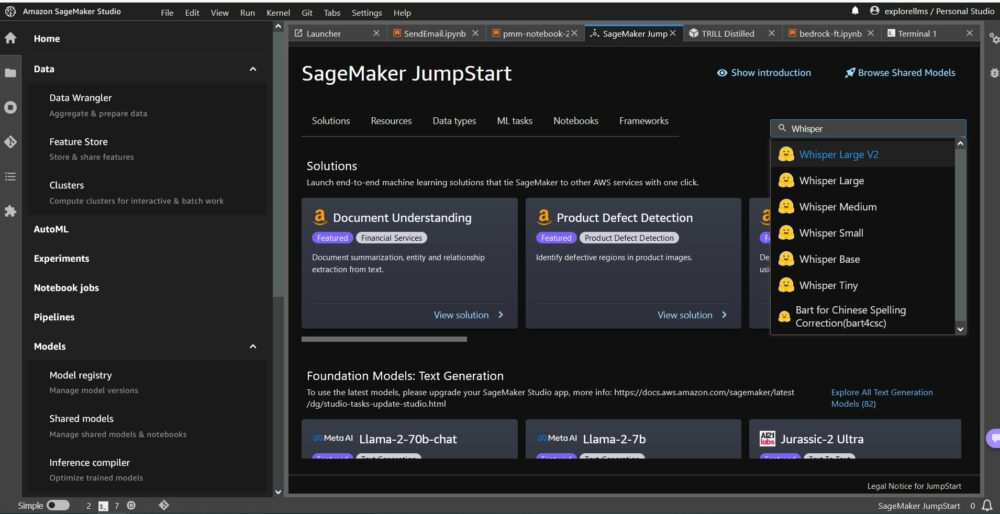

- Untuk memilih model Whisper, Anda dapat menggunakan tab di bagian atas atau menggunakan kotak pencarian di kanan atas seperti yang ditunjukkan pada gambar layar berikut. Untuk contoh ini, gunakan kotak pencarian di kanan atas dan enter

Whisper, lalu pilih model Whisper yang sesuai dari menu tarik-turun.

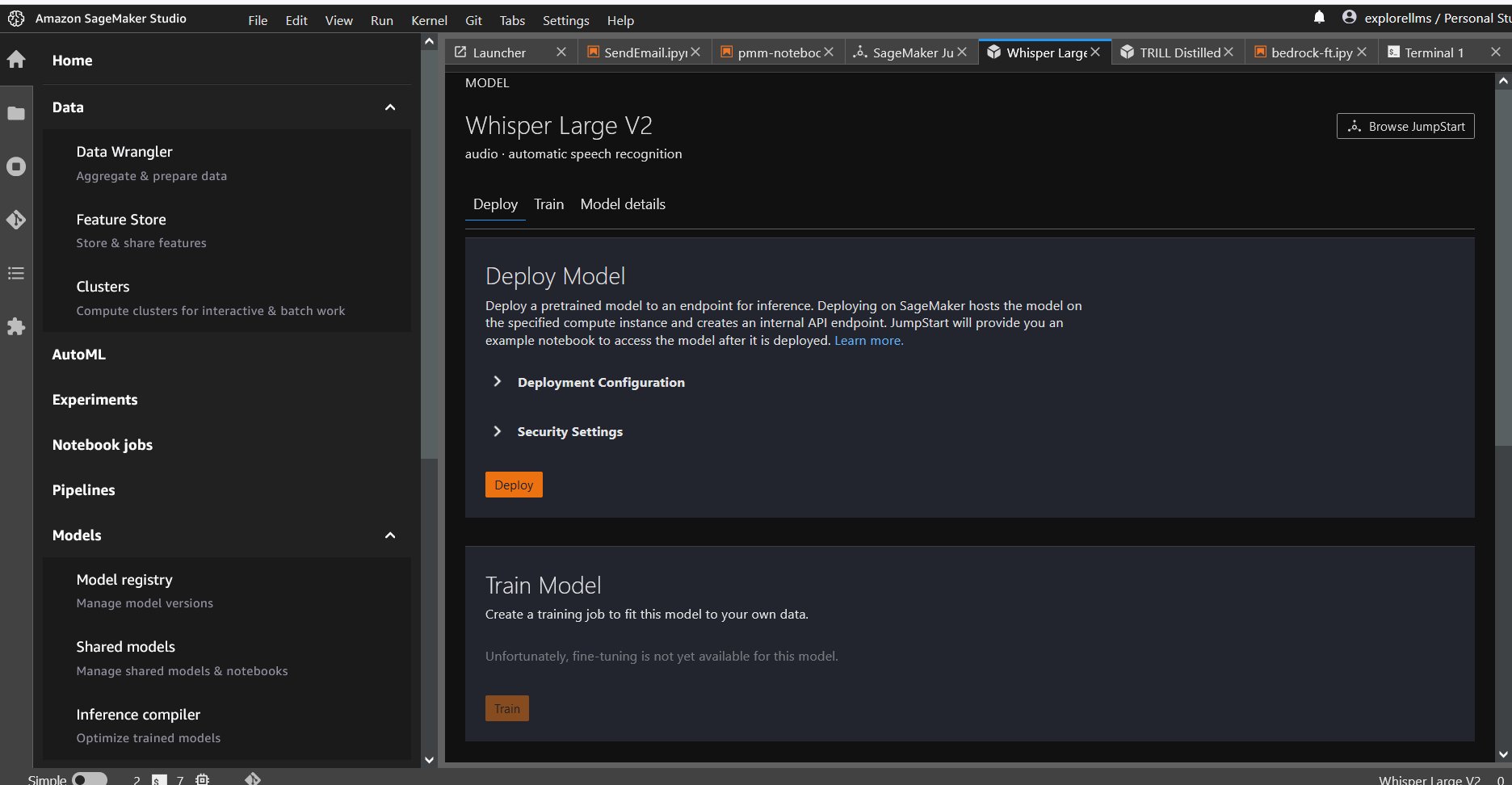

- Setelah Anda memilih model Whisper, Anda dapat menggunakan konsol untuk menyebarkan model tersebut. Anda dapat memilih instans untuk diterapkan atau menggunakan default.

Terapkan model dasar dari Sagemaker Notebook

Langkah-langkah untuk menerapkan terlebih dahulu dan kemudian menggunakan model yang diterapkan untuk menyelesaikan berbagai tugas adalah:

- Mendirikan

- Pilih model

- Ambil artefak dan terapkan titik akhir

- Gunakan model yang diterapkan untuk ASR

- Gunakan model yang diterapkan untuk terjemahan bahasa

- Bersihkan titik akhir

Mendirikan

Notebook ini diuji pada instans ml.t3.medium di SageMaker Studio dengan kernel Python 3 (ilmu data) dan dalam instans Notebook Amazon SageMaker dengan conda_python3 inti.

Pilih model terlatih

Siapkan Sesi SageMaker menggunakan Boto3, lalu pilih ID model yang ingin Anda terapkan.

Ambil artefak dan terapkan titik akhir

Dengan menggunakan SageMaker, Anda dapat melakukan inferensi pada model yang telah dilatih sebelumnya, bahkan tanpa menyempurnakannya terlebih dahulu pada kumpulan data baru. Untuk menghosting model terlatih, buatlah sebuah instance sagemaker.model.Model dan menyebarkannya. Kode berikut menggunakan instance default ml.g5.2xlarge untuk titik akhir inferensi model Whisper-large-v2. Anda dapat menerapkan model pada tipe instans lain dengan meneruskan instance_type dalam JumpStartModel kelas. Penerapannya mungkin memakan waktu beberapa menit.

Pengenalan ucapan otomatis

Selanjutnya, Anda membaca contoh file audio, sample1.wav, dari publik SageMaker Jumpstart Layanan Penyimpanan Sederhana Amazon (Amazon S3) lokasi dan meneruskannya ke prediktor untuk pengenalan suara. Anda dapat mengganti file sampel ini dengan file audio sampel lainnya, namun pastikan file .wav diambil sampelnya pada 16 kHz karena diperlukan oleh model pengenalan suara otomatis. File audio masukan harus kurang dari 30 detik.

Model ini mendukung banyak parameter saat melakukan inferensi. Mereka termasuk:

max_length: Model menghasilkan teks hingga panjang keluaran. Jika ditentukan, maka harus berupa bilangan bulat positif.- bahasa dan tugas: Tentukan bahasa keluaran dan tugas di sini. Model mendukung tugas transkripsi atau terjemahan.

max_new_tokens: Jumlah maksimum token yang akan dihasilkan.num_return_sequences: Jumlah urutan keluaran yang dikembalikan. Jika ditentukan, maka harus berupa bilangan bulat positif.num_beams: Jumlah balok yang digunakan dalam pencarian serakah. Jika ditentukan, bilangan bulatnya harus lebih besar dari atau sama dengannum_return_sequences.no_repeat_ngram_size: Model memastikan bahwa rangkaian katano_repeat_ngram_sizetidak diulangi dalam urutan keluaran. Jika ditentukan, maka harus berupa bilangan bulat positif yang lebih besar dari 1.- suhu: Ini mengontrol keacakan dalam output. Suhu yang lebih tinggi menghasilkan urutan keluaran dengan kata-kata dengan probabilitas rendah, dan suhu yang lebih rendah menghasilkan urutan keluaran dengan kata-kata dengan probabilitas tinggi. Jika suhu mendekati 0, ini menghasilkan decoding yang serakah. Jika ditentukan, itu harus berupa pelampung positif.

early_stopping: JikaTrue, pembuatan teks selesai ketika semua hipotesis balok mencapai akhir token kalimat. Jika ditentukan, itu harus boolean.do_sample: JikaTrue, contoh kata berikutnya untuk mengetahui kemungkinannya. Jika ditentukan, itu harus boolean.top_k: Dalam setiap langkah pembuatan teks, sampel hanya daritop_kkata-kata yang paling mungkin. Jika ditentukan, itu harus berupa bilangan bulat positif.top_p: Dalam setiap langkah pembuatan teks, ambil sampel dari kumpulan kata sekecil mungkin dengan probabilitas kumulatiftop_p. Jika ditentukan, itu harus berupa float antara 0 dan 1.

Anda dapat menentukan subset apa pun dari parameter sebelumnya saat memanggil titik akhir. Selanjutnya, kami tunjukkan contoh cara memanggil titik akhir dengan argumen ini.

Terjemahan bahasa

Untuk menampilkan terjemahan bahasa menggunakan model Whisper, gunakan file audio berikut dalam bahasa Prancis dan terjemahkan ke bahasa Inggris. File harus diambil sampelnya pada 16 kHz (seperti yang disyaratkan oleh model ASR), jadi pastikan untuk mengambil sampel ulang file jika diperlukan dan pastikan sampel Anda tidak melebihi 30 detik.

- Download

sample_french1.wavdari SageMaker JumpStart dari lokasi S3 publik sehingga dapat diteruskan dalam payload untuk diterjemahkan oleh model Whisper.

- Tetapkan parameter tugas sebagai

translatedan bahasa sebagaiFrenchuntuk memaksa model Whisper melakukan terjemahan ucapan. - penggunaan prediktor untuk memprediksi terjemahan bahasa. Jika Anda menerima kesalahan klien (kesalahan 413), periksa ukuran muatan ke titik akhir. Muatan untuk permintaan titik akhir pemanggilan SageMaker dibatasi sekitar 5 MB.

- Output teks yang diterjemahkan ke bahasa Inggris dari file audio Perancis sebagai berikut:

Membersihkan

Setelah Anda menguji titik akhir, hapus titik akhir inferensi SageMaker dan hapus model untuk menghindari dikenakan biaya.

Kesimpulan

Dalam postingan ini, kami menunjukkan kepada Anda cara menguji dan menggunakan model OpenAI Whisper untuk membangun aplikasi menarik menggunakan Amazon SageMaker. Cobalah model dasar di SageMaker hari ini dan beri tahu kami tanggapan Anda!

Panduan ini hanya untuk tujuan informasi. Anda tetap harus melakukan penilaian independen dan mengambil tindakan untuk memastikan bahwa Anda mematuhi praktik dan standar kendali mutu spesifik Anda, serta peraturan, undang-undang, regulasi, lisensi, dan ketentuan penggunaan setempat yang berlaku untuk Anda, konten Anda, dan konten Anda. model pihak ketiga yang dirujuk dalam panduan ini. AWS tidak memiliki kendali atau wewenang atas model pihak ketiga yang dirujuk dalam panduan ini dan tidak membuat pernyataan atau jaminan apa pun bahwa model pihak ketiga aman, bebas virus, operasional, atau kompatibel dengan lingkungan dan standar produksi Anda. AWS tidak membuat pernyataan, jaminan, atau jaminan apa pun bahwa informasi apa pun dalam panduan ini akan menghasilkan keluaran atau akibat tertentu.

Tentang penulis

Hemant Singh adalah Ilmuwan Terapan dengan pengalaman di Amazon SageMaker JumpStart. Ia mendapatkan gelar masternya dari Courant Institute of Mathematical Sciences dan B.Tech dari IIT Delhi. Dia memiliki pengalaman dalam menangani beragam masalah pembelajaran mesin dalam domain pemrosesan bahasa alami, visi komputer, dan analisis deret waktu.

Hemant Singh adalah Ilmuwan Terapan dengan pengalaman di Amazon SageMaker JumpStart. Ia mendapatkan gelar masternya dari Courant Institute of Mathematical Sciences dan B.Tech dari IIT Delhi. Dia memiliki pengalaman dalam menangani beragam masalah pembelajaran mesin dalam domain pemrosesan bahasa alami, visi komputer, dan analisis deret waktu.

Rakhna Chadha adalah Arsitek Solusi Utama AI/ML dalam Akun Strategis di AWS. Rachna adalah seorang optimis yang percaya bahwa penggunaan AI secara etis dan bertanggung jawab dapat meningkatkan masyarakat di masa depan dan membawa kemakmuran ekonomi dan sosial. Di waktu senggangnya, Rachna suka menghabiskan waktu bersama keluarganya, mendaki gunung dan mendengarkan musik.

Rakhna Chadha adalah Arsitek Solusi Utama AI/ML dalam Akun Strategis di AWS. Rachna adalah seorang optimis yang percaya bahwa penggunaan AI secara etis dan bertanggung jawab dapat meningkatkan masyarakat di masa depan dan membawa kemakmuran ekonomi dan sosial. Di waktu senggangnya, Rachna suka menghabiskan waktu bersama keluarganya, mendaki gunung dan mendengarkan musik.

Dr Ashish Khetan adalah Ilmuwan Terapan Senior dengan algoritme bawaan Amazon SageMaker dan membantu mengembangkan algoritme pembelajaran mesin. Ia mendapatkan gelar PhD dari University of Illinois Urbana-Champaign. Dia adalah peneliti aktif dalam pembelajaran mesin dan inferensi statistik, dan telah menerbitkan banyak makalah di konferensi NeurIPS, ICML, ICLR, JMLR, ACL, dan EMNLP.

Dr Ashish Khetan adalah Ilmuwan Terapan Senior dengan algoritme bawaan Amazon SageMaker dan membantu mengembangkan algoritme pembelajaran mesin. Ia mendapatkan gelar PhD dari University of Illinois Urbana-Champaign. Dia adalah peneliti aktif dalam pembelajaran mesin dan inferensi statistik, dan telah menerbitkan banyak makalah di konferensi NeurIPS, ICML, ICLR, JMLR, ACL, dan EMNLP.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- Sumber: https://aws.amazon.com/blogs/machine-learning/whisper-models-for-automatic-speech-recognition-now-available-in-amazon-sagemaker-jumpstart/

- :memiliki

- :adalah

- :bukan

- $NAIK

- 1

- 10

- 100

- 12

- 14

- 15%

- 150

- 16

- 30

- 7

- 8

- 9

- a

- kemampuan

- Tentang Kami

- mengakses

- dapat diakses

- Akun

- di seluruh

- aktif

- sebenarnya

- tambahan

- uang muka

- AI

- AI / ML

- algoritma

- Semua

- juga

- Amazon

- Amazon SageMaker

- Mulai Lompatan Amazon SageMaker

- Studio Amazon SageMaker

- Amazon Web Services

- jumlah

- an

- analisis

- dan

- Mengumumkan

- Apa pun

- api

- Aplikasi

- aplikasi

- terapan

- Mendaftar

- pendekatan

- sesuai

- ADALAH

- argumen

- Seni

- AS

- penilaian

- At

- audio

- kewenangan

- secara otomatis

- tersedia

- rata-rata

- menghindari

- AWS

- berdasarkan

- BE

- Balok

- karena

- menjadi

- percaya

- di bawah

- antara

- miliaran

- Blog

- Kotak

- membawa

- membangun

- built-in

- tapi

- by

- CAN

- kasus

- Kategori

- karakteristik

- beban

- memeriksa

- Pilih

- kelas

- klien

- kode

- bagaimana

- kedatangan

- Umum

- dibandingkan

- cocok

- Lengkap

- memenuhi

- komputer

- Visi Komputer

- konferensi

- konsul

- Wadah

- Konten

- terus menerus

- kontrol

- kontrol

- benar

- membuat

- dikuratori

- pelanggan

- pelanggan

- data

- ilmu data

- kumpulan data

- decoding

- Default

- Delhi

- mendemonstrasikan

- menyebarkan

- dikerahkan

- penyebaran

- rinci

- mengembangkan

- dikembangkan

- Pengembangan

- perbedaan

- berbeda

- digital

- digital Art

- beberapa

- do

- tidak

- domain

- domain

- Dont

- setiap

- mudah

- antara

- karyawan

- aktif

- memungkinkan

- akhir

- ujung ke ujung

- Titik akhir

- Inggris

- memastikan

- Memastikan

- Enter

- Lingkungan Hidup

- sama

- kesalahan

- kesalahan

- etis

- mengevaluasi

- Bahkan

- semua orang

- contoh

- melebihi

- gembira

- menarik

- ada

- Lihat lebih lanjut

- mahal

- pengalaman

- menyelidiki

- Menghadapi

- keluarga

- beberapa

- File

- File

- Menemukan

- Pertama

- lima

- Mengapung

- berikut

- berikut

- Untuk

- kekuatan

- ditemukan

- Prinsip Dasar

- empat

- Perancis

- dari

- masa depan

- menghasilkan

- menghasilkan

- menghasilkan

- generasi

- mendapatkan

- GitHub

- diberikan

- Go

- mendapat

- lebih besar

- Serakah

- Tanah

- jaminan

- bimbingan

- Memiliki

- memiliki

- he

- membantu

- membantu

- dia

- di sini

- lebih tinggi

- -nya

- tuan rumah

- host

- JAM

- Seterpercayaapakah Olymp Trade? Kesimpulan

- How To

- HTML

- HTTPS

- Pusat

- hub

- ID

- if

- Illinois

- mengimpor

- memperbaiki

- in

- memasukkan

- Termasuk

- Meningkatkan

- independen

- menunjukkan

- informasi

- Informational

- memasukkan

- install

- contoh

- Lembaga

- menarik

- ke

- isolasi

- IT

- jpg

- json

- Tahu

- dikenal

- bahasa

- besar-besaran

- terbesar

- Latensi

- jalankan

- Hukum

- pengetahuan

- meninggalkan

- Panjang

- kurang

- membiarkan

- lisensi

- Penerangan

- kemungkinan

- Mungkin

- 'like

- Terbatas

- link

- Daftar

- Listening

- hidup

- lokal

- tempat

- menurunkan

- mesin

- Mesin belajar

- memelihara

- membuat

- banyak

- matematis

- maksimum

- ukuran

- medium

- menu

- metrik

- mungkin

- menit

- ML

- model

- model

- saat

- lebih

- paling

- musik

- harus

- Alam

- Pengolahan Bahasa alami

- Perlu

- dibutuhkan

- jaringan

- New

- berikutnya

- tidak

- None

- buku catatan

- sekarang

- jumlah

- nomor

- of

- Penawaran

- on

- hanya

- Buka

- OpenAI

- operasional

- or

- asli

- Lainnya

- Lainnya

- di luar

- Hasil

- keluaran

- di luar

- lebih

- sendiri

- halaman

- dokumen

- parameter

- parameter

- tertentu

- pihak

- lulus

- Lulus

- Paten

- persen

- Melakukan

- prestasi

- melakukan

- phd

- plato

- Kecerdasan Data Plato

- Data Plato

- silahkan

- Populer

- positif

- mungkin

- Pos

- praktek

- meramalkan

- Predictor

- Prediksi

- Utama

- masalah

- pengolahan

- Produksi

- diusulkan

- kemakmuran

- penyedia

- menyediakan

- publik

- diterbitkan

- tujuan

- Ular sanca

- pytorch

- kualitas

- segera

- keserampangan

- jarak

- Penilaian

- agak

- mencapai

- Baca

- benar-benar

- menerima

- baru

- pengakuan

- referensi

- disebut

- peraturan

- ulang

- menggantikan

- mewakili

- permintaan

- permintaan

- wajib

- peneliti

- tanggapan

- tanggung jawab

- mengakibatkan

- Hasil

- ulasan

- benar

- Naik

- aturan

- s

- pembuat bijak

- Inferensi SageMaker

- penjualan

- sama

- Skala

- Ilmu

- ILMU PENGETAHUAN

- ilmuwan

- naskah

- SDK

- Pencarian

- detik

- aman

- keamanan

- mengirimkan

- senior

- putusan pengadilan

- Urutan

- Seri

- layanan

- Layanan

- Sidang

- set

- berbagi

- harus

- Menunjukkan

- menampilkan

- menunjukkan

- ditunjukkan

- Sederhana

- Ukuran

- ukuran

- So

- Sosial

- Masyarakat

- larutan

- MEMECAHKAN

- tertentu

- ditentukan

- pidato

- Speech Recognition

- kecepatan

- Pengeluaran

- standar

- mulai

- Negara

- statistik

- Langkah

- Tangga

- Masih

- penyimpanan

- Strategis

- kuat

- studio

- seperti itu

- pengawasan

- Mendukung

- yakin

- sistem

- tabel

- Mengambil

- diambil

- tugas

- tugas

- tech

- template

- sepuluh

- tensorflow

- istilah

- uji

- diuji

- teks

- dari

- bahwa

- Grafik

- hub

- Mereka

- diri

- kemudian

- Ini

- mereka

- Ketiga

- Pihak ketiga

- pihak ketiga

- ini

- ribu

- waktu

- Seri waktu

- kali

- untuk

- hari ini

- token

- Token

- mengambil

- puncak

- Total

- Pelatihan VE

- terlatih

- Mengubah

- menterjemahkan

- Terjemahan

- Kepercayaan

- kebenaran

- mencoba

- jenis

- khas

- ui

- universitas

- sampai

- us

- penggunaan

- menggunakan

- bekas

- Pengguna

- kegunaan

- menggunakan

- nilai

- bervariasi

- sangat

- melalui

- penglihatan

- ingin

- adalah

- we

- jaringan

- layanan web

- selamat datang

- adalah

- ketika

- apakah

- yang

- Berbisik

- SIAPA

- lebar

- akan

- dengan

- dalam

- tanpa

- Won

- Word

- kata

- alur kerja

- kerja

- tahun

- Kamu

- Anda

- zephyrnet.dll