Dalle startup alle imprese, le organizzazioni di tutte le dimensioni stanno iniziando a utilizzare l'intelligenza artificiale generativa. Vogliono trarre vantaggio dall’intelligenza artificiale generativa e tradurre lo slancio derivante da beta, prototipi e demo in guadagni di produttività e innovazioni nel mondo reale. Ma di cosa hanno bisogno le organizzazioni per portare l’intelligenza artificiale generativa in azienda e renderla reale? Quando parliamo con i clienti, ci dicono che hanno bisogno di sicurezza e privacy, scalabilità e rapporto qualità-prezzo e, soprattutto, di tecnologia rilevante per la loro attività. Siamo entusiasti di annunciare oggi nuove funzionalità e servizi per consentire alle organizzazioni grandi e piccole di utilizzare l’intelligenza artificiale generativa in modi creativi, creando nuove applicazioni e migliorando il modo in cui funzionano. In AWS, siamo estremamente concentrati sull'aiutare i nostri clienti in alcuni modi:

- Semplifica la creazione di applicazioni di intelligenza artificiale generativa con sicurezza e privacy integrate

- Concentrarsi sull'infrastruttura più performante e a basso costo per l'intelligenza artificiale generativa in modo da poter addestrare i propri modelli ed eseguire inferenze su larga scala

- Fornire applicazioni generative basate sull'intelligenza artificiale per l'azienda per trasformare il modo in cui viene svolto il lavoro

- Abilitare i dati come elemento di differenziazione per personalizzare i modelli di fondazione (FM) e renderli esperti del tuo business, dei tuoi dati e della tua azienda

Per aiutare un'ampia gamma di organizzazioni a creare esperienze di IA generativa differenziate, AWS ha lavorato fianco a fianco con i nostri clienti, tra cui BBVA, Thomson Reuters, United Airlines, Philips e LexisNexis Legal & Professional. E con le nuove funzionalità lanciate oggi, ci auguriamo una maggiore produttività, un maggiore coinvolgimento dei clienti ed esperienze più personalizzate che trasformeranno il modo in cui le aziende svolgono il lavoro.

Annuncio della disponibilità generale di Amazon Bedrock, il modo più semplice per creare applicazioni di intelligenza artificiale generativa con sicurezza e privacy integrate

I clienti sono entusiasti e ottimisti riguardo al valore che l’intelligenza artificiale generativa può apportare all’azienda. Si stanno immergendo in profondità nella tecnologia per apprendere i passaggi necessari per costruire un sistema di intelligenza artificiale generativa in produzione. Sebbene i recenti progressi nell’intelligenza artificiale generativa abbiano catturato l’attenzione diffusa, molte aziende non sono state in grado di prendere parte a questa trasformazione. I clienti ci dicono che hanno bisogno di una scelta di modelli, garanzie di sicurezza e privacy, un approccio incentrato sui dati, modalità economicamente vantaggiose per eseguire modelli e funzionalità come prompt engineering, retrieval augmented generation (RAG), agenti e altro ancora per creare applicazioni personalizzate . Ecco perché il 13 aprile 2023, abbiamo annunciato Roccia Amazzonica, il modo più semplice per creare e scalare applicazioni di intelligenza artificiale generativa con modelli di base. Amazon Bedrock è un servizio completamente gestito che offre una scelta di modelli di base ad alte prestazioni di fornitori leader come AI21 Labs, Anthropic, Cohere, Meta, Stability AI e Amazon, insieme a un'ampia gamma di funzionalità di cui i clienti hanno bisogno per creare un'intelligenza artificiale generativa applicazioni, semplificando lo sviluppo mantenendo privacy e sicurezza. Inoltre, come parte di a ha recentemente annunciato una collaborazione strategica, tutti i futuri FM di Anthropic saranno disponibili all'interno di Amazon Bedrock con accesso anticipato a funzionalità uniche per la personalizzazione del modello e le funzionalità di messa a punto.

Da aprile abbiamo visto in prima persona come startup come Coda, Urone AIe Nexxiot; grandi aziende come adidas, GoDaddy, Clariant e Broadridge; e ai partner piace Accenture, BCG, Leidos e Mission Cloud stanno già utilizzando Amazon Bedrock per creare in modo sicuro applicazioni di intelligenza artificiale generativa in tutti i settori. I fornitori di software indipendenti (ISV) apprezzano Salesforce si stanno ora integrando in modo sicuro con Amazon Bedrock per consentire ai propri clienti di potenziare applicazioni di intelligenza artificiale generativa. I clienti stanno applicando l’intelligenza artificiale generativa a nuovi casi d’uso; ad esempio, Lonely Planet, una delle principali società di media di viaggio, ha collaborato con il nostro Centro per l'innovazione dell'IA generativa introdurre una piattaforma AI scalabile che organizza i contenuti dei libri in pochi minuti per fornire consigli di viaggio coerenti e altamente accurati, riducendo i costi di generazione degli itinerari di quasi l'80%. E da allora, abbiamo continuato ad aggiungere nuove funzionalità, come gli agenti per Amazon Bedrock, nonché il supporto per nuovi modelli, come Cohere e gli ultimi modelli di Anthropic, per offrire ai nostri clienti una scelta più ampia e semplificare la creazione di AI generativa. applicazioni basate. Gli agenti per Bedrock rappresentano un punto di svolta, poiché consentono agli LLM di completare attività complesse basate sui propri dati e API, in privato, in sicurezza, con una configurazione in pochi minuti (non sono necessarie formazione o messa a punto).

Oggi siamo entusiasti di condividere nuovi annunci che semplificano l’introduzione dell’intelligenza artificiale generativa nella tua organizzazione:

- Disponibilità generale di Amazon Bedrock per aiutare un numero ancora maggiore di clienti a creare e scalare applicazioni di intelligenza artificiale generativa

- Scelta del modello ampliata con lama 2 (in arrivo nelle prossime settimane) e Incorporamenti di Amazon Titan offre ai clienti maggiore scelta e flessibilità per trovare il modello giusto per ogni caso d'uso e potenzia RAG per risultati migliori

- Amazon Bedrock è un servizio idoneo HIPAA e può essere utilizzato in conformità con il GDPR, consentendo a un numero ancora maggiore di clienti di beneficiare dell'intelligenza artificiale generativa

- Throughput assegnato per garantire un'esperienza utente coerente anche durante le ore di punta del traffico

Con la disponibilità generale di Amazon Bedrock, un numero maggiore di clienti avrà accesso alle funzionalità complete di Bedrock. I clienti possono facilmente sperimentare una varietà di FM di punta, personalizzarli privatamente con i propri dati utilizzando tecniche come fine tuning e RAG e creare agenti gestiti che eseguono attività aziendali complesse, dalla prenotazione di viaggi all'elaborazione di richieste di indennizzi assicurativi alla creazione di campagne pubblicitarie e alla gestione dell'inventario. -tutto senza scrivere alcun codice. Poiché Amazon Bedrock è serverless, i clienti non devono gestire alcuna infrastruttura e possono integrare e distribuire in modo sicuro funzionalità di intelligenza artificiale generativa nelle loro applicazioni utilizzando i servizi AWS con cui hanno già familiarità.

In secondo luogo, la scelta del modello è stata la pietra angolare di ciò che rende Amazon Bedrock un servizio unico e differenziato per i nostri clienti. In una fase così precoce dell’adozione dell’intelligenza artificiale generativa, non esiste un unico modello che sblocchi tutto il valore dell’intelligenza artificiale generativa e i clienti hanno bisogno della capacità di lavorare con una gamma di modelli ad alte prestazioni. Siamo entusiasti di annunciare la disponibilità generale di Amazon Titan Embeddings e, nelle prossime settimane, la disponibilità di Llama 2, il modello LLM (Large Language Model) di nuova generazione di Meta, che si unisce ai fornitori di modelli esistenti AI21 Labs, Anthropic, Cohere, Stability AI e Amazon. ampliando ulteriormente la scelta e la flessibilità per i clienti. Amazon Bedrock è il primo servizio di intelligenza artificiale generativa completamente gestito a offrire Llama 2, il LLM di nuova generazione di Meta, tramite un'API gestita. I modelli Llama 2 presentano miglioramenti significativi rispetto ai modelli Llama originali, tra cui l'addestramento sul 40% di dati in più e una lunghezza del contesto più lunga di 4,000 token per lavorare con documenti più grandi. Ottimizzati per fornire una risposta rapida sull'infrastruttura AWS, i modelli Llama 2 disponibili tramite Amazon Bedrock sono ideali per i casi d'uso del dialogo. I clienti possono ora creare applicazioni di intelligenza artificiale generativa basate sui modelli di parametri Llama 2 13B e 70B, senza la necessità di configurare e gestire alcuna infrastruttura.

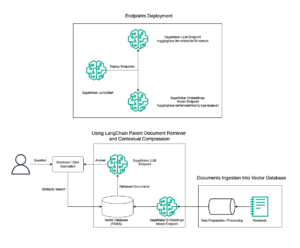

Gli FM Amazon Titan sono una famiglia di modelli creati e preaddestrati da AWS su set di dati di grandi dimensioni, che li rendono funzionalità potenti e generiche create per supportare una varietà di casi d'uso. Il primo di questi modelli generalmente disponibile per i clienti, Amazon Titan Embeddings, è un LLM che converte il testo in rappresentazioni numeriche (note come incorporamenti) per alimentare casi d'uso RAG. I FM sono adatti per un'ampia varietà di compiti, ma possono rispondere solo a domande basate su quanto appreso dai dati di addestramento e dalle informazioni contestuali in modo tempestivo, limitando la loro efficacia quando le risposte richiedono conoscenze tempestive o dati proprietari. I dati fanno la differenza tra un'applicazione di intelligenza artificiale generativa generica e un'applicazione che conosce veramente la tua azienda e i tuoi clienti. Per aumentare le risposte FM con dati aggiuntivi, molte organizzazioni si rivolgono a RAG, una tecnica popolare di personalizzazione del modello in cui un FM si connette a una fonte di conoscenza a cui può fare riferimento per aumentare le sue risposte. Per iniziare con RAG, i clienti devono prima accedere a un modello di incorporamento per convertire i propri dati in vettori che consentano al FM di comprendere più facilmente il significato semantico e le relazioni tra i dati. La creazione di un modello di incorporamento richiede enormi quantità di dati, risorse ed esperienza ML, rendendo RAG fuori dalla portata di molte organizzazioni. Amazon Titan Embeddings rende più semplice per i clienti iniziare a utilizzare RAG per estendere la potenza di qualsiasi FM utilizzando i propri dati proprietari. Amazon Titan Embeddings supporta più di 25 lingue e una lunghezza del contesto fino a 8,192 token, rendendolo particolarmente adatto a lavorare con singole parole, frasi o interi documenti in base al caso d'uso del cliente. Il modello restituisce vettori di output di 1,536 dimensioni, conferendogli un elevato grado di precisione e ottimizzando al tempo stesso risultati a bassa latenza ed economicamente vantaggiosi. Con nuovi modelli e funzionalità, è facile utilizzare i dati della tua organizzazione come risorsa strategica per personalizzare i modelli di base e creare esperienze più differenziate.

In terzo luogo, poiché i dati che i clienti desiderano utilizzare per la personalizzazione sono proprietà intellettuale così preziose, hanno bisogno che rimangano sicuri e privati. Grazie alla sicurezza e alla privacy integrate fin dal primo giorno, i clienti Amazon Bedrock possono avere la certezza che i loro dati rimarranno protetti. Nessuno dei dati del cliente viene utilizzato per addestrare gli FM di base originali. Tutti i dati sono crittografati a riposo e in transito. E puoi aspettarti gli stessi controlli di accesso AWS di cui disponi con qualsiasi altro servizio AWS. Oggi siamo entusiasti di costruire su queste basi e introdurre nuove funzionalità di sicurezza e governance: Amazon Bedrock è ora un servizio idoneo HIPAA e può essere utilizzato in conformità con GDPR, consentendo a un numero ancora maggiore di clienti di beneficiare dell’intelligenza artificiale generativa. Le nuove funzionalità di governance includono l'integrazione con Amazon Cloud Watch per tenere traccia delle metriche di utilizzo e creare dashboard personalizzati e integrazione con AWS CloudTrail per monitorare l'attività dell'API e risolvere i problemi. Queste nuove funzionalità di governance e sicurezza aiutano le organizzazioni a sfruttare il potenziale dell’intelligenza artificiale generativa, anche in settori altamente regolamentati, e a garantire che i dati rimangano protetti.

Infine, alcuni periodi dell’anno, come le festività, sono fondamentali affinché i clienti possano assicurarsi che i propri utenti possano ottenere un servizio ininterrotto dalle applicazioni basate sull’intelligenza artificiale generativa. Durante questi periodi, i clienti vogliono garantire che il loro servizio sia disponibile per tutti i propri clienti, indipendentemente dalla domanda. Amazon Bedrock ora consente ai clienti di riservare il throughput (in termini di token elaborati al minuto) per mantenere un'esperienza utente coerente anche durante i periodi di traffico di punta.

Insieme, le nuove funzionalità e i nuovi modelli che abbiamo annunciato oggi per Amazon Bedrock accelereranno la rapidità con cui le aziende potranno creare applicazioni più personalizzate e migliorare la produttività dei dipendenti. Insieme ai nostri continui investimenti nell'infrastruttura ML, Amazon Bedrock è il posto migliore in cui i clienti possono creare e scalare applicazioni di intelligenza artificiale generativa.

Per aiutare i clienti a iniziare rapidamente a utilizzare queste nuove funzionalità, stiamo aggiungendo al nostro corso un nuovo corso di formazione sull'intelligenza artificiale generativa per Amazon Bedrock raccolta di corsi di formazione digitali on demand. Amazon Bedrock – Per iniziare è un corso digitale gratuito e di autoapprendimento che introduce gli studenti al servizio. Questo corso di 60 minuti introdurrà gli sviluppatori e il pubblico tecnico ai vantaggi, alle funzionalità, ai casi d'uso e ai concetti tecnici di Amazon Bedrock.

Annuncio della funzionalità di personalizzazione di Amazon CodeWhisperer per generare consigli sul codice più pertinenti basati sulla codebase della tua organizzazione

In AWS stiamo creando nuove potenti applicazioni che trasformano il modo in cui i nostri clienti svolgono il lavoro con l'intelligenza artificiale generativa. Nell'aprile 2023 abbiamo annunciato la disponibilità generale di Amazon Code Whisperer, un compagno di codifica AI che aiuta gli sviluppatori a creare applicazioni software più velocemente fornendo suggerimenti di codice in 15 lingue, basati su commenti e codice in linguaggio naturale nell'ambiente di sviluppo integrato (IDE) di uno sviluppatore. CodeWhisperer è stato addestrato su miliardi di righe di codice disponibile al pubblico per aiutare gli sviluppatori a essere più produttivi in un'ampia gamma di attività. Abbiamo appositamente formato CodeWhisperer sul codice Amazon di alta qualità, comprese le API e le best practice di AWS, per aiutare gli sviluppatori a essere ancora più rapidi e precisi nella generazione di codice che interagisce con i servizi AWS come Cloud di calcolo elastico di Amazon (Amazon EC2), Servizio di archiviazione semplice Amazon (Amazon S3) e AWS Lambda. Clienti da Accenture a Persistent fino alla Bundesliga utilizzano CodeWhisperer per rendere i propri sviluppatori più produttivi.

Molti clienti desiderano inoltre che CodeWhisperer includa nei suoi suggerimenti API interne, librerie, best practice e modelli architettonici, in modo da poter accelerare ulteriormente lo sviluppo. Oggi, i partner di codifica AI non sono in grado di includere queste API nei loro suggerimenti di codice perché in genere sono formati su codice disponibile pubblicamente e quindi non sono a conoscenza del codice interno di un'azienda. Ad esempio, per creare una funzionalità per un sito Web di e-commerce che elenchi gli articoli in un carrello, gli sviluppatori devono trovare e comprendere il codice interno esistente, come l'API che fornisce la descrizione degli articoli, in modo da poter visualizzare la descrizione nel carrello. . Senza un compagno di codifica in grado di suggerire loro il codice interno corretto, gli sviluppatori devono passare ore a scavare nella loro codebase interna e nella documentazione per completare il loro lavoro. Anche dopo essere riusciti a trovare le risorse giuste, gli sviluppatori devono dedicare più tempo alla revisione del codice per assicurarsi che segua le migliori pratiche della propria azienda.

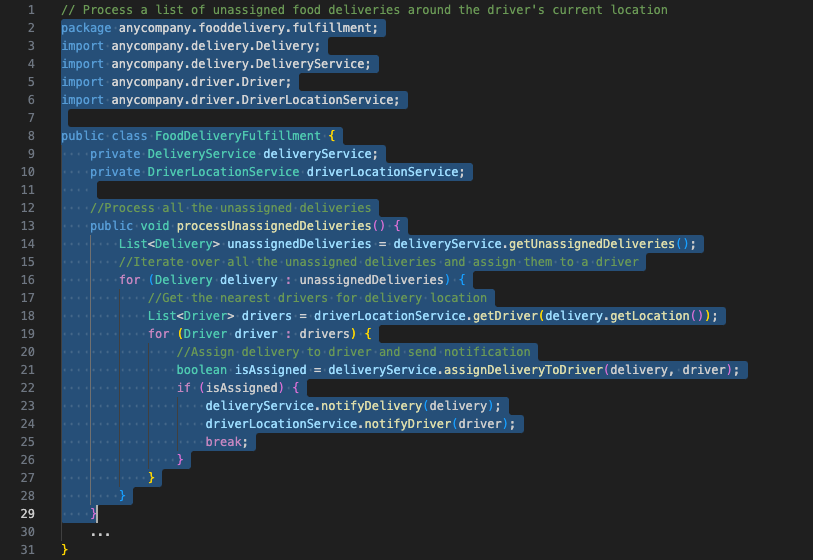

Oggi siamo entusiasti di annunciare una novità Funzionalità di personalizzazione di Amazon CodeWhisperer, che consente a CodeWhisperer di generare suggerimenti ancora migliori rispetto a prima, perché ora può includere API interne, librerie, best practice e modelli architettonici. Questa funzionalità utilizza le più recenti tecniche di personalizzazione del modello e del contesto e sarà presto disponibile in anteprima come parte di un nuovo livello CodeWhisperer Enterprise. Con questa funzionalità, puoi connettere in modo sicuro i tuoi repository privati a CodeWhisperer e, con pochi clic, personalizzare CodeWhisperer per generare consigli in tempo reale che includono la tua codebase interna. Ad esempio, con una personalizzazione di CodeWhisperer, uno sviluppatore che lavora in un'azienda di consegna di cibo può chiedere a CodeWhisperer di fornire consigli che includano un codice specifico relativo ai servizi interni dell'azienda, come "Elabora un elenco di consegne di cibo non assegnate intorno alla posizione attuale dell'autista". In precedenza, CodeWhisperer non conosceva le API interne corrette per "consegne di cibo non assegnate" o "posizione attuale dell'autista" perché non si tratta di informazioni disponibili al pubblico. Ora, una volta personalizzato sulla codebase interna dell'azienda, CodeWhisperer ne comprende l'intento, determina quali API interne e pubbliche sono più adatte all'attività e genera consigli sul codice per lo sviluppatore. La funzionalità di personalizzazione di CodeWhisperer può far risparmiare agli sviluppatori ore trascorse a cercare e modificare codice scarsamente documentato e aiuta gli sviluppatori nuovi ad inserirsi più rapidamente nell'azienda.

Nell'esempio seguente, dopo aver creato una personalizzazione privata, gli sviluppatori di AnyCompany (un'azienda di consegna di cibo) ricevono consigli sui codici CodeWhisperer che includono le loro API e librerie interne.

Abbiamo condotto uno studio recente con Persistente, una società globale di servizi e soluzioni che fornisce servizi di ingegneria digitale e modernizzazione aziendale ai clienti, per misurare i vantaggi in termini di produttività derivanti dalla capacità di personalizzazione di CodeWhisperer. Persistent ha scoperto che gli sviluppatori che utilizzano la funzionalità di personalizzazione sono in grado di completare le proprie attività di codifica fino al 28% più velocemente, in media, rispetto agli sviluppatori che utilizzano CodeWhisperer standard.

Abbiamo progettato questa funzionalità di personalizzazione mettendo al primo posto la privacy e la sicurezza. Gli amministratori possono gestire facilmente l'accesso a una personalizzazione privata dal file Console di gestione AWS, in modo che solo sviluppatori specifici possano accedervi. Gli amministratori possono anche garantire che solo i repository che soddisfano i loro standard siano idonei per l'uso in una personalizzazione di CodeWhisperer. L'utilizzo di repository di alta qualità aiuta CodeWhisperer a fornire suggerimenti che promuovono le migliori pratiche di sicurezza e qualità del codice. Ogni personalizzazione è completamente isolata dagli altri clienti e nessuna delle personalizzazioni realizzate con questa nuova funzionalità verrà utilizzata per addestrare il FM sottostante CodeWhisperer, proteggendo la preziosa proprietà intellettuale dei clienti.

Annuncio dell'anteprima delle funzionalità di creazione di BI generativa in Amazon QuickSight per aiutare gli analisti aziendali a creare e personalizzare facilmente elementi visivi utilizzando comandi in linguaggio naturale

La missione di AWS è quella di democratizzare l'accesso agli insight per tutti gli utenti dell'organizzazione. Amazon QuickSight, il nostro servizio di business intelligence (BI) unificato creato per il cloud, consente la condivisione delle informazioni tra tutti gli utenti dell'organizzazione. Con QuickSight, abbiamo utilizzato modelli generativi per alimentare Amazon QuickSight D, che consentono a qualsiasi utente di porre domande sui propri dati utilizzando il linguaggio naturale, senza dover scrivere query SQL o apprendere uno strumento di BI, dal 2020. Nel luglio 2023, ha annunciato che stiamo promuovendo l'innovazione iniziale in QuickSight Q con le nuove funzionalità LLM per fornire funzionalità di BI generativa in QuickSight. Gli attuali clienti di QuickSight come BMW Group e Traeger Grills non vedono l'ora di aumentare ulteriormente la produttività dei propri analisti utilizzando l'esperienza di creazione di BI generativa.

Oggi siamo entusiasti di rendere queste funzionalità LLM disponibili in anteprima con Funzionalità di creazione di dashboard BI generativa per gli analisti aziendali. Le nuove funzionalità di creazione della BI generativa estendono le query in linguaggio naturale di QuickSight Q oltre la risposta a domande ben strutturate (come "quali sono i 10 prodotti principali venduti in California?") per aiutare gli analisti a creare rapidamente elementi visivi personalizzabili da frammenti di domande (come "primi 10 prodotti"), chiarire l'intento di una query ponendo domande di follow-up, perfezionare le visualizzazioni e completare calcoli complessi. Gli analisti aziendali descrivono semplicemente il risultato desiderato e QuickSight genera immagini accattivanti che possono essere facilmente aggiunte a un dashboard o a un report con un solo clic. QuickSight Q offre anche domande correlate per aiutare gli analisti a chiarire casi ambigui quando più campi dati corrispondono alla loro query. Una volta ottenuta la visualizzazione iniziale, l'analista può aggiungere calcoli complessi, modificare i tipi di grafici e perfezionare le immagini utilizzando istruzioni in linguaggio naturale. Le nuove funzionalità di creazione della BI generativa in QuickSight Q rendono facile e veloce per gli analisti aziendali creare immagini accattivanti e ridurre i tempi necessari per fornire le informazioni necessarie per prendere decisioni basate sui dati su larga scala.

Creazione di elementi visivi utilizzando le funzionalità di BI generativa in Amazon QuickSight

Strumenti e funzionalità di intelligenza artificiale generativa per ogni azienda

Gli annunci di oggi aprono l'intelligenza artificiale generativa a qualsiasi cliente. Con sicurezza e privacy di livello aziendale, scelta di FM leader, un approccio incentrato sui dati e un'infrastruttura altamente performante ed economicamente vantaggiosa, le organizzazioni si affidano ad AWS per potenziare le proprie innovazioni con soluzioni di intelligenza artificiale generativa a ogni livello dello stack. Abbiamo assistito a un'innovazione entusiasmante da Bridgewater Associates a Omnicom da Asurion a Rocket Mortgage e, con questi nuovi annunci, attendiamo con ansia nuovi casi d'uso e applicazioni della tecnologia per aumentare la produttività. Questo è solo l'inizio: stiamo innovando nell'intero stack tecnologico con nuovi servizi e funzionalità creati per la tua organizzazione per aiutarti ad affrontare alcune delle sfide più grandi e cambiare il modo in cui lavoriamo.

Risorse

Per saperne di più, consulta le seguenti risorse:

Circa l'autore

Swami Shivasubramanian è vicepresidente dei dati e dell'apprendimento automatico presso AWS. In questo ruolo, Swami supervisiona tutti i servizi AWS Database, Analytics e AI e Machine Learning. La missione del suo team è aiutare le organizzazioni a far funzionare i propri dati con una soluzione di dati end-to-end completa per archiviare, accedere, analizzare, visualizzare e prevedere.

Swami Shivasubramanian è vicepresidente dei dati e dell'apprendimento automatico presso AWS. In questo ruolo, Swami supervisiona tutti i servizi AWS Database, Analytics e AI e Machine Learning. La missione del suo team è aiutare le organizzazioni a far funzionare i propri dati con una soluzione di dati end-to-end completa per archiviare, accedere, analizzare, visualizzare e prevedere.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/announcing-new-tools-to-help-every-business-embrace-generative-ai/

- :ha

- :È

- :non

- :Dove

- $ SU

- 000

- 1

- 10

- 100

- 13

- 15%

- 2020

- 2023

- 25

- 7

- 8

- a

- capacità

- capace

- Chi siamo

- accelerare

- Accenture

- accesso

- precisione

- preciso

- operanti in

- attività

- Ad

- aggiungere

- aggiunto

- l'aggiunta di

- aggiuntivo

- Inoltre

- Adidas

- amministratori

- Adozione

- avanzamenti

- Dopo shavasana, sedersi in silenzio; saluti;

- agenti

- AI

- AI e apprendimento automatico

- Piattaforma AI

- Addestramento AI

- AI-alimentato

- Compagnie Aeree

- Tutti

- consentire

- Consentire

- consente

- lungo

- già

- anche

- Amazon

- Amazon Code Whisperer

- Amazon EC2

- Amazon QuickSight

- Amazon Web Services

- importi

- an

- analista

- Gli analisti

- analitica

- analizzare

- ed

- Annunciare

- ha annunciato

- Annunci

- annunciando

- Antropico

- in qualsiasi

- api

- API

- Applicazioni

- applicazioni

- AMMISSIONE

- approccio

- Aprile

- architettonico

- SONO

- in giro

- AS

- chiedere

- chiedendo

- attività

- At

- attenzione

- udienze

- aumentata

- autore

- disponibilità

- disponibile

- media

- consapevole

- AWS

- base

- basato

- BBVA

- BCG

- BE

- perché

- stato

- prima

- essendo

- beneficio

- vantaggi

- MIGLIORE

- best practice

- Meglio

- fra

- Al di là di

- Big

- miliardi

- BMW

- libro

- riunioni

- Incremento

- portare

- ampio

- Broadridge

- costruire

- Costruzione

- costruito

- affari

- business intelligence

- aziende

- ma

- by

- calcoli

- California

- Responsabile Campagne

- Materiale

- Può ottenere

- funzionalità

- capacità

- capace

- capitalizzare

- catturato

- Custodie

- casi

- certo

- sfide

- il cambiamento

- Changer

- Grafico

- dai un'occhiata

- scegliere

- clicca

- Cloud

- codice

- base del codice

- codifica

- coesivo

- Venire

- arrivo

- Commenti

- Aziende

- compagno

- compagni

- azienda

- Società

- avvincente

- completamento di una

- completamente

- complesso

- conformità

- globale

- Calcolare

- concetti

- concerto

- condotto

- Connettiti

- collega

- coerente

- contenuto

- contesto

- contestuale

- continua

- controlli

- convertire

- pietra angolare

- correggere

- Costo

- costo effettivo

- Costi

- Portata

- creare

- creato

- Creazione

- Creative

- critico

- Corrente

- cliente

- Il coinvolgimento del cliente

- Clienti

- personalizzabile

- personalizzazione

- personalizzare

- personalizzate

- cruscotto

- cruscotti

- dati

- data-driven

- Banca Dati

- dataset

- giorno

- decisioni

- deep

- Laurea

- consegnare

- Consegne

- consegna

- consegna

- Richiesta

- democratizzare

- Demos

- schierare

- descrivere

- descrizione

- progettato

- desiderato

- determina

- Costruttori

- sviluppatori

- Mercato

- Dialogo

- differenza

- diversificato

- differenziatore

- digitale

- dimensioni

- Dsiplay

- do

- documentazione

- documenti

- fatto

- Dont

- durante

- ogni

- Presto

- più facile

- più semplice

- facilmente

- facile

- ecommerce

- efficacia

- eleggibile

- incorporamento

- abbraccio

- Dipendente

- enable

- Abilita

- crittografato

- da un capo all'altro

- Fidanzamento

- Ingegneria

- accrescere

- migliorata

- garantire

- Impresa

- di livello enterprise

- aziende

- Intero

- Ambiente

- Anche

- Ogni

- esempio

- eccitato

- coinvolgenti

- eseguire

- esistente

- espansione

- attenderti

- esperienza

- Esperienze

- esperimento

- esperto

- competenza

- estendere

- familiare

- famiglia

- FAST

- più veloce

- caratteristica

- Caratteristiche

- pochi

- campi

- Trovare

- sottile

- Nome

- Flessibilità

- i seguenti

- segue

- cibo

- consegna del cibo

- Nel

- prima linea

- Avanti

- essere trovato

- Fondazione

- Gratis

- da

- completamente

- ulteriormente

- promuovere

- futuro

- Guadagni

- gioco

- game-changer

- GDPR

- Generale

- generalmente

- generare

- genera

- la generazione di

- ELETTRICA

- generativo

- AI generativa

- ottenere

- ottenere

- gif

- dà

- Dare

- globali

- la governance

- maggiore

- Gruppo

- Avere

- avendo

- Aiuto

- aiutare

- aiuta

- Alta

- ad alte prestazioni

- alta qualità

- vivamente

- il suo

- Vacanze

- ORE

- Come

- Come lavoriamo

- HTML

- http

- HTTPS

- ideale

- migliorata

- miglioramenti

- miglioramento

- in

- includere

- Compreso

- crescente

- studente indipendente

- industrie

- far sapere

- informazioni

- informati

- Infrastruttura

- inizialmente

- innovare

- Innovazione

- innovazioni

- intuizioni

- assicurazione

- integrare

- integrato

- Integrazione

- integrazione

- intellettuale

- proprietà intellettuale

- Intelligence

- intento

- interagisce

- interno

- ai miglioramenti

- introdurre

- Introduce

- Investimenti

- IP

- isolato

- sicurezza

- IT

- elementi

- SUO

- accoppiamento

- jpg

- Luglio

- ad appena

- Sapere

- conoscenze

- conosciuto

- conosce

- Labs

- Lingua

- Le Lingue

- grandi

- Grandi imprese

- superiore, se assunto singolarmente.

- maggiore

- con i più recenti

- lanciato

- strato

- principale

- IMPARARE

- apprendimento

- Legale

- Lunghezza

- LexisNexis

- biblioteche

- piace

- limitativo

- Linee

- Lista

- elenchi

- Lama

- LLM

- località

- più a lungo

- Guarda

- cerca

- Basso

- macchina

- machine learning

- mantenere

- Mantenere

- make

- FA

- Fare

- gestire

- gestito

- gestione

- gestione

- molti

- massiccio

- partita

- significato

- misurare

- Media

- Soddisfare

- Meta

- Metrica

- minuto

- Minuti

- Missione

- ML

- modello

- modelli

- Impulso

- Monitorare

- Scopri di più

- Mutuo

- maggior parte

- multiplo

- Naturale

- quasi

- Bisogno

- di applicazione

- New

- Nuove funzionalità

- GENERAZIONE

- prossima generazione

- no

- Nessuna

- adesso

- of

- offrire

- Offerte

- on

- On-Demand

- Onboard

- una volta

- ONE

- in corso

- esclusivamente

- aprire

- Ottimista

- ottimizzati

- ottimizzazione

- or

- organizzazione

- organizzazioni

- organizza

- i

- Altro

- nostro

- su

- Risultato

- produzione

- ancora

- proprio

- parametro

- parte

- partner

- modelli

- Corrente di

- per

- periodi

- Personalizzata

- Frasi

- posto

- pianeta

- piattaforma

- Platone

- Platone Data Intelligence

- PlatoneDati

- Popolare

- potenziale

- energia

- alimentato

- potente

- pratiche

- predire

- premier

- Presidente

- Anteprima

- in precedenza

- Privacy

- Privacy e sicurezza

- un bagno

- Elaborato

- lavorazione

- Produzione

- produttivo

- della produttività

- Prodotti

- professionale

- promuoverlo

- proprietà

- proprio

- protetta

- proteggere

- prototipi

- fornire

- fornitori

- fornisce

- fornitura

- la percezione

- pubblicamente

- scopo

- metti

- Mettendo

- qualità

- query

- domanda

- Domande

- rapidamente

- gamma

- raggiungere

- di rose

- mondo reale

- tempo reale

- recente

- raccomandazioni

- ridurre

- riducendo

- raffinare

- Indipendentemente

- regolamentati

- industrie regolamentate

- relazionato

- Relazioni

- pertinente

- rimanere

- resti

- rapporto

- richiedere

- necessario

- richiede

- Prenotare

- Risorse

- Rispondere

- risposta

- risposte

- REST

- Risultati

- problemi

- revisione

- destra

- razzo

- Ruolo

- Correre

- forza di vendita

- stesso

- Risparmi

- scalabile

- Scala

- ricerca

- sicuro

- in modo sicuro

- problemi di

- visto

- serverless

- servizio

- Servizi

- set

- flessibile.

- Condividi

- condiviso

- Shopping

- significativa

- Un'espansione

- semplificando

- semplicemente

- da

- singolo

- Dimensioni

- piccole

- So

- Software

- venduto

- soluzione

- Soluzioni

- alcuni

- presto

- Fonte

- appositamente

- specifico

- velocità

- spendere

- esaurito

- Stabilità

- pila

- Standard

- standard

- iniziato

- Startup

- Passi

- conservazione

- Tornare al suo account

- Strategico

- Studio

- tale

- supporto

- supporti

- sicuro

- sistema

- attrezzatura

- Fai

- Parlare

- Task

- task

- Tech

- Consulenza

- tecniche

- Tecnologia

- dire

- condizioni

- testo

- di

- che

- Il

- loro

- Li

- poi

- Là.

- Strumenti Bowman per analizzare le seguenti finiture:

- di

- questo

- Attraverso

- portata

- fila

- tempo

- tempestivo

- volte

- titano

- a

- oggi

- Tokens

- strumenti

- top

- Top 10

- pista

- traffico

- Treni

- allenato

- Training

- Trasformare

- Trasformazione

- transito

- tradurre

- viaggiare

- veramente

- Affidati ad

- TURNO

- Tipi di

- tipicamente

- sottostante

- capire

- capisce

- unificato

- unico

- Unito

- sbloccare

- sblocca

- us

- Impiego

- uso

- caso d'uso

- utilizzato

- Utente

- Esperienza da Utente

- utenti

- usa

- utilizzando

- Prezioso

- APPREZZIAMO

- varietà

- fornitori

- via

- vice

- Vicepresidente

- visualizzazione

- visualizzare

- visivi

- volere

- Modo..

- modi

- we

- sito web

- servizi web

- Sito web

- Settimane

- WELL

- sono stati

- Che

- quando

- quale

- while

- OMS

- perché

- largo

- Vasta gamma

- molto diffuso

- volere

- con

- entro

- senza

- parole

- Lavora

- lavorato

- lavoro

- sarebbe

- scrivere

- scrittura

- anno

- Tu

- Trasferimento da aeroporto a Sharm

- zefiro