Dati degli Utenti: Vital Food dei LLM

SÌ! RT @bryce adoro questa citazione “Se non lo paghi, non sei il cliente; tu sei il prodotto che viene venduto. http://bit.ly/93JYCJ

— Tim O'Reilly (@timoreilly) 2 settembre 2010

Rimani aggiornato sulle notizie crittografiche, ricevi aggiornamenti quotidiani nella tua casella di posta.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://decrypt.co/211846/anthropic-says-it-wont-use-your-private-data-to-train-its-ai

- :ha

- :È

- :non

- 7

- 8

- a

- capacità

- Assoluta

- Secondo

- preciso

- adattamento

- indirizzamento

- Aggiunge

- Avanzate

- fa

- concorda

- AI

- Servizi di intelligenza artificiale

- Sistemi di intelligenza artificiale

- mira

- Alexa

- Allinea

- Tutti

- consente

- anche

- sempre

- Amazon

- an

- ed

- Antropico

- anticipare

- in qualsiasi

- applicabile

- SONO

- AS

- assumere

- At

- disponibile

- evitando

- consapevole

- basato

- BE

- perché

- essendo

- creduto

- benefico

- Meglio

- fra

- by

- Materiale

- clienti

- impegno

- impegna

- Aziende

- azienda

- competitivo

- concetto

- preoccupazioni

- costantemente

- contenuto

- contesto

- continuamente

- di controllo

- Comodo

- Conversazioni

- copyright

- potuto

- cruciale

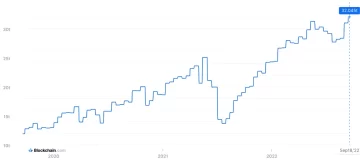

- crypto

- Notizie Cripto

- Corrente

- cliente

- Clienti

- alle lezioni

- Scuro

- dati

- privacy dei dati

- dibattito

- decenni

- decrypt

- deep

- apprendimento profondo

- Predefinito

- Difendere

- consegna

- dipende

- declina

- controversie

- Diversità

- do

- documento

- effettua

- dollari

- Dont

- durante

- Guadagno

- bordo

- efficacia

- o

- Fidanzamento

- migliorando

- assicura

- essential

- etico

- etica

- esempio

- exchange

- esperienza

- estensivo

- estensione

- esterno

- di fronte

- Nel

- Ex

- Fondato

- Gratis

- da

- guadagnando

- generare

- generato

- genera

- generativo

- AI generativa

- ottenere

- ottenere

- giganti

- Dare

- Go

- concedere

- afferrala

- cresce

- pesantemente

- onesto

- onore

- Tuttavia

- http

- HTTPS

- umano

- ideali

- if

- competenze

- in

- individuale

- informazioni

- intellettuale

- proprietà intellettuale

- intenzioni

- interazioni

- interno

- IP

- IT

- SUO

- stessa

- Le

- Lingua

- grandi

- con i più recenti

- Legge

- portare

- IMPARARE

- apprendimento

- Legale

- Leva

- piace

- Lama

- LLM

- amore

- make

- Fare

- Maggio..

- Media

- Meta

- milioni

- modello

- modelli

- Scopri di più

- maggior parte

- reti

- neurale

- reti neurali

- New

- notizie

- ottenendo

- of

- on

- OpenAI

- or

- apparentemente

- altrimenti

- nostro

- su

- uscite

- ancora

- proprio

- possiede

- pagato

- parti

- partito

- modelli

- Paga le

- pagamento

- cronologia

- personalizzazione

- Personalizzata

- Foto

- Platone

- Platone Data Intelligence

- PlatoneDati

- politica

- potenziale

- energia

- potente

- pratiche

- predire

- Previsioni

- preferenze

- atleta

- Privacy

- un bagno

- Prodotto

- Prodotto

- istruzioni

- proprietà

- fornire

- fornisce

- la percezione

- fiducia pubblica

- pubblicamente

- citare

- pneumatici

- RE

- mondo reale

- riceve

- raffinare

- considerare

- parente

- rilasciare

- pertinente

- Segnalati

- richieste

- ricercatori

- responsabile

- Rivelato

- diritti

- rivali

- rt

- Ryan

- s

- dire

- dice

- scena

- servizio

- Servizi

- set

- Condividi

- dovrebbero

- Scetticismo

- So

- Social

- Social Media

- venduto

- SILLABARE

- portavoce

- startup

- dichiarazione

- soggiorno

- step

- SISTEMI DI TRATTAMENTO

- Tandem

- Tech

- giganti della tecnologia

- tecniche

- condizioni

- testo

- che

- Il

- loro

- Li

- Strumenti Bowman per analizzare le seguenti finiture:

- di

- questo

- Tim

- a

- oggi

- top

- Treni

- allenato

- Training

- Trasparenza

- tendenze

- Affidati ad

- per

- capire

- e una comprensione reciproca

- imminenti

- aggiornato

- Aggiornamenti

- aggiornato

- caricato

- uso

- utilizzato

- Utente

- utenti

- utilizzando

- Prezioso

- vario

- versione

- Video

- importantissima

- Voce

- volume

- Prima

- we

- sono stati

- quando

- se

- quale

- perché

- volere

- con

- Word

- sarebbe

- Tu

- Trasferimento da aeroporto a Sharm

- zefiro