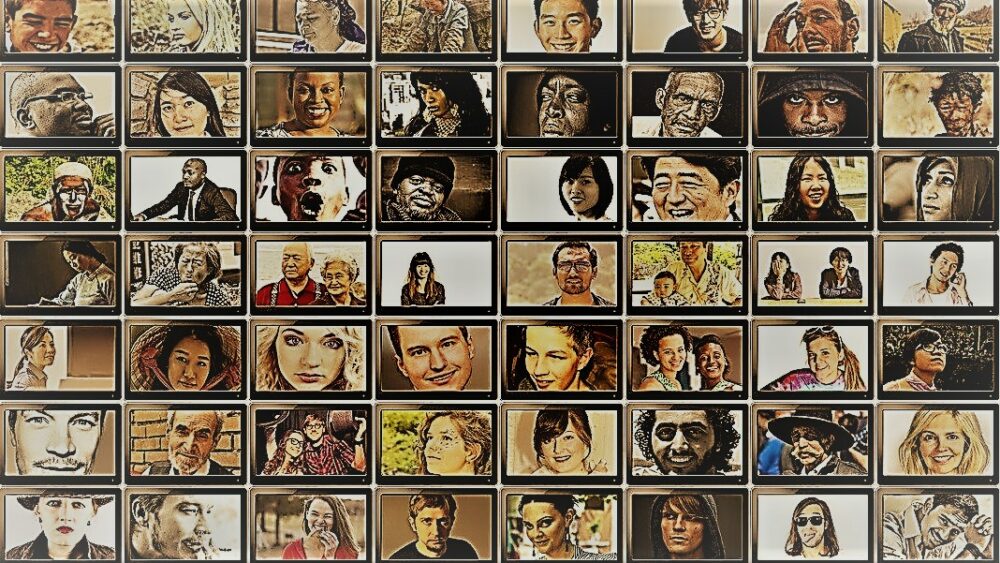

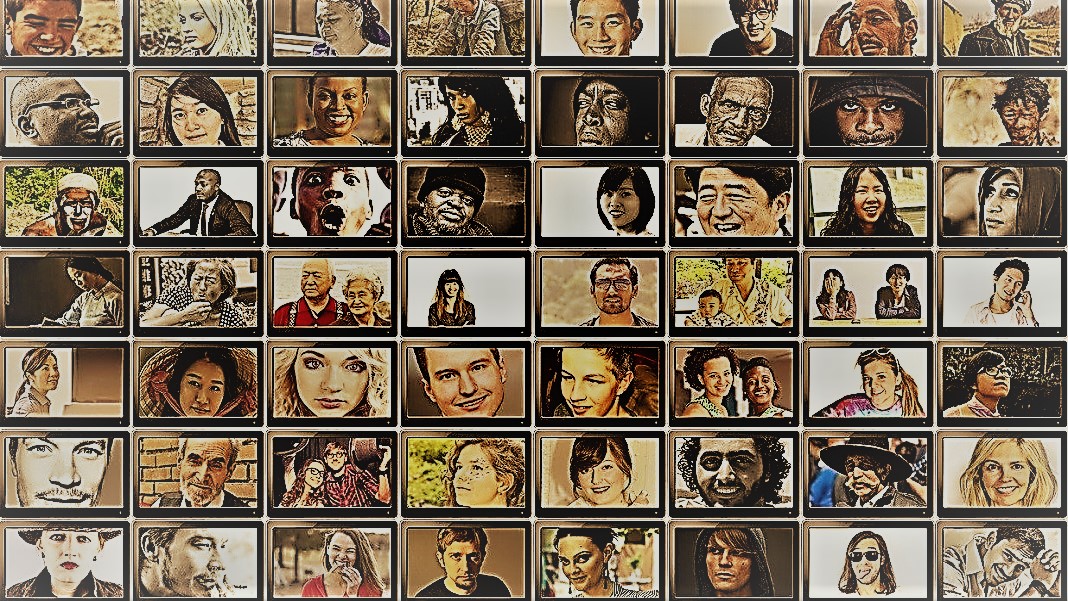

Sono un grande fan del programma di viaggi di Anthony Bourdain Parti sconosciute. In ogni episodio, lo chef visita villaggi remoti in tutto il mondo, documentando le vite, i cibi e le culture delle tribù regionali con cuore e mente aperti.

Lo spettacolo offre uno sguardo alla sorprendente diversità dell'umanità. Gli scienziati sociali hanno un obiettivo simile, comprendere il comportamento di persone, gruppi e culture diverse, ma usano una varietà di metodi in situazioni controllate. Per entrambi, i protagonisti di queste attività sono i soggetti: gli esseri umani.

Ma cosa succederebbe se sostituissi gli umani con i chatbot AI?

L'idea sembra assurda. Tuttavia, grazie all'avvento di ChatGPT e di altri modelli di linguaggio di grandi dimensioni (LLM), gli scienziati sociali stanno flirtando con l'idea di utilizzare questi strumenti per costruire rapidamente diversi gruppi di "umani simulati" ed eseguire esperimenti per sondare il loro comportamento e i loro valori come proxy per le loro controparti biologiche.

Se stai immaginando menti umane ricreate digitalmente, non è così. L'idea è di attingere all'esperienza di ChatGPT nell'imitare le risposte umane. Poiché i modelli racimolano enormi quantità di dati online - blog, commenti su Youtube, fan fiction, libri - catturano prontamente le relazioni tra le parole in più lingue. Questi sofisticati algoritmi possono anche decodificare aspetti sfumati del linguaggio, come ironia, sarcasmo, metafore e toni emotivi, un aspetto critico della comunicazione umana in ogni cultura. Questi punti di forza impostano gli LLM per imitare più personalità sintetiche con una vasta gamma di credenze.

Un altro bonus? Rispetto ai partecipanti umani, ChatGPT e altri LLM non si stancano, consentendo agli scienziati di raccogliere dati e testare teorie sul comportamento umano con una velocità senza precedenti.

L'idea, sebbene controversa, ha già il supporto. Un recente articolo esaminando il campo nascente è emerso che in alcuni scenari attentamente progettati, le risposte di ChatGPT erano correlate a quelle di circa il 95% dei partecipanti umani.

L'intelligenza artificiale "potrebbe cambiare il gioco per la ricerca nelle scienze sociali" disse Il dottor Igor Grossman dell'Università di Waterloo, che con i colleghi ha recentemente scritto un articolo di previsione in Scienze. La chiave per l'utilizzo Homo silico nella ricerca? Attenta gestione dei bias e fedeltà dei dati, ha affermato il team.

Sondaggio della mente della società umana

Cos'è esattamente la scienza sociale?

In parole povere, sta studiando come gli esseri umani, sia come individui che come gruppo, si comportano in circostanze diverse, come interagiscono tra loro e si sviluppano come cultura. È un ombrello di ricerca accademica con più rami: economia, scienze politiche, antropologia e psicologia.

La disciplina affronta una vasta gamma di argomenti importanti nell'attuale zeitgeist. Qual è l'impatto dei social media sulla salute mentale? Quali sono gli attuali atteggiamenti pubblici nei confronti del cambiamento climatico con l'aumento degli episodi meteorologici gravi? In che modo le diverse culture valutano i metodi di comunicazione e cosa scatena i malintesi?

Uno studio di scienze sociali inizia con una domanda e un'ipotesi. Uno dei miei preferiti: le culture tollerano l'odore del corpo in modo diverso? (Non scherzo, il tema è stato studiato un bel po', e sì, c'è una differenza!)

Gli scienziati utilizzano quindi una varietà di metodi, come questionari, test comportamentali, osservazione e modellazione per testare le loro idee. I sondaggi sono uno strumento particolarmente popolare, perché le domande possono essere rigorosamente progettate e controllate e raggiungono facilmente un'ampia gamma di persone quando vengono distribuite online. Gli scienziati analizzano quindi le risposte scritte e ricavano informazioni sul comportamento umano. In altre parole, l'uso del linguaggio da parte di un partecipante è fondamentale per questi studi.

Quindi, come si inserisce ChatGPT?

L'"Homo Silicus"

Per Grossman, gli LLM dietro chatbot come ChatGPT o Bard di Google rappresentano un'opportunità senza precedenti per riprogettare gli esperimenti di scienze sociali.

Poiché sono addestrati su enormi set di dati, gli LLM "possono rappresentare una vasta gamma di esperienze e prospettive umane", hanno affermato gli autori. Poiché i modelli "vagano" liberamente senza confini su Internet, come le persone che spesso viaggiano all'estero, possono adottare e mostrare una gamma più ampia di risposte rispetto ai soggetti umani reclutati.

ChatGPT inoltre non viene influenzato da altri membri di uno studio o si stanca, permettendogli potenzialmente di generare risposte meno distorte. Questi tratti possono essere particolarmente utili nei "progetti ad alto rischio", ad esempio imitando le risposte di persone che vivono in paesi in guerra o sotto regimi difficili attraverso i post sui social media. A loro volta, le risposte potrebbero informare gli interventi del mondo reale.

Allo stesso modo, gli LLM formati su temi culturali caldi come l'identità di genere o la disinformazione potrebbero riprodurre diverse scuole di pensiero teoriche o ideologiche per informare le politiche. Invece di sondare scrupolosamente centinaia di migliaia di partecipanti umani, l'intelligenza artificiale può generare rapidamente risposte basate sul discorso online.

A parte i potenziali usi nella vita reale, gli LLM possono anche fungere da soggetti digitali che interagiscono con partecipanti umani in esperimenti di scienze sociali, in qualche modo simili ai personaggi non giocanti (NPC) nei videogiochi. Ad esempio, il LLM potrebbe adottare diverse "personalità" e interagire online con volontari umani in tutto il mondo utilizzando il testo ponendo loro la stessa domanda. Poiché gli algoritmi non dormono, potrebbe funzionare 24 ore su 7, XNUMX giorni su XNUMX. I dati risultanti possono quindi aiutare gli scienziati a esplorare come culture diverse valutano informazioni simili e come si diffondono opinioni e disinformazione.

Bambini Steps

L'idea di utilizzare i chatbot al posto degli umani negli studi non è ancora mainstream.

Ma ci sono prove iniziali che potrebbe funzionare. UN studio di prestampa rilasciato questo mese da Georgia Tech, Microsoft Research e Olin College ha scoperto che un LLM ha replicato le risposte umane in numerosi esperimenti di psicologia classica, incluso il famigerato Esperimenti shock di Milgram.

Tuttavia, rimane una domanda critica: quanto bene questi modelli possono davvero catturare la risposta di un essere umano?

Ci sono diversi ostacoli.

Il primo è la qualità dell'algoritmo e dei dati di addestramento. La maggior parte dei contenuti online è dominata solo da una manciata di lingue. Un LLM addestrato su questi dati potrebbe facilmente imitare il sentimento, la prospettiva o persino il giudizio morale delle persone che usano quelle lingue, ereditando a sua volta pregiudizi dai dati di formazione.

"Questa riproduzione di pregiudizi è una delle principali preoccupazioni perché potrebbe amplificare le stesse disparità che gli scienziati sociali si sforzano di scoprire nella loro ricerca", ha affermato Grossman.

Alcuni scienziati temono anche che gli LLM siano giusti rigurgitando quello che gli viene detto. È l'antitesi di uno studio di scienze sociali, in cui l'obiettivo principale è catturare l'umanità in tutta la sua bellezza diversa e complessa. D'altra parte, ChatGPT e modelli simili sono noti per "allucinazioni”, inventando informazioni che sembrano plausibili ma sono false.

Per ora, "i grandi modelli linguistici si basano sulle 'ombre' delle esperienze umane", ha affermato Grossman. Poiché questi sistemi di intelligenza artificiale sono in gran parte scatole nere, è difficile capire come o perché generino determinate risposte, un po' preoccupante quando li si utilizza come proxy umani negli esperimenti comportamentali.

Nonostante i limiti, "gli LLM consentono agli scienziati sociali di rompere con i metodi di ricerca tradizionali e avvicinarsi al loro lavoro in modi innovativi", hanno affermato gli autori. Come primo passo, l'Homo silicus potrebbe aiutare a fare brainstorming e testare rapidamente le ipotesi, con quelle promettenti ulteriormente convalidate nelle popolazioni umane.

Ma affinché le scienze sociali accolgano veramente l'IA, dovranno esserci trasparenza, equità e parità di accesso a questi potenti sistemi. Gli LLM sono difficili e costosi da addestrare, con i modelli recenti sempre più chiusi dietro pesanti paywall.

"Dobbiamo assicurarci che gli LLM delle scienze sociali, come tutti i modelli scientifici, siano open-source, il che significa che i loro algoritmi e idealmente i dati sono disponibili a tutti per essere esaminati, testati e modificati", disse autore dello studio Dr. Dawn Parker presso l'Università di Waterloo. "Solo mantenendo la trasparenza e la replicabilità possiamo garantire che la ricerca in scienze sociali assistita dall'intelligenza artificiale contribuisca veramente alla nostra comprensione dell'esperienza umana".

Immagine di credito: Gerd Altmann / Pixabay

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Automobilistico/VE, Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- BlockOffset. Modernizzare la proprietà della compensazione ambientale. Accedi qui.

- Fonte: https://singularityhub.com/2023/07/25/chatgpt-is-replacing-humans-in-studies-on-human-behavior-and-its-working-surprisingly-well/

- :ha

- :È

- :non

- $ SU

- 23

- a

- WRI

- accademico

- accesso

- operanti in

- Legge

- adottare

- Avvento

- AI

- algoritmo

- Algoritmi

- Tutti

- consentire

- Consentire

- già

- anche

- importi

- an

- analizzare

- ed

- Anthony

- approccio

- SONO

- Arizona

- Italia

- articolo

- AS

- aspetto

- aspetti

- At

- autore

- gli autori

- disponibile

- basato

- BE

- Bellezza ed estetica

- perché

- stato

- comportamento

- dietro

- essendo

- credenze

- fra

- pregiudizio

- parziale

- Po

- Nero

- Blocchi

- stile di vita

- Bonus

- frontiere

- entrambi

- scatole

- brainstorm

- rami

- Rompere

- ma

- by

- Materiale

- catturare

- attento

- certo

- il cambiamento

- caratteri

- chatbots

- ChatGPT

- condizioni

- Clima

- Cambiamento climatico

- colleghi

- raccogliere

- College

- Commenti

- Comunicazione

- rispetto

- complesso

- Problemi della Pelle

- costruire

- contenuto

- contribuisce

- controllata

- controverso

- potuto

- paesi

- credito

- critico

- aspetto critico

- la cultura della

- Cultura

- Corrente

- dati

- dataset

- progettato

- sviluppare

- diverso

- difficile

- digitale

- digitalmente

- Dsiplay

- distribuito

- paesaggio differenziato

- Diversità

- do

- effettua

- non

- Dont

- dr

- disegnare

- ogni

- Presto

- facilmente

- Economia

- enorme

- garantire

- episodio

- pari

- particolarmente

- valutare

- Anche

- Ogni

- di preciso

- esempio

- costoso

- esperienza

- Esperienze

- esperimenti

- competenza

- esplora

- equità

- falso

- fan

- Fantasia

- fedeltà

- campo

- Nome

- in forma

- alimenti

- Nel

- essere trovato

- da

- ulteriormente

- gioco

- Giochi

- Sesso

- generare

- Georgia

- ottenere

- Intravedere

- globo

- Gruppo

- cura

- manciata

- Avere

- Salute e benessere

- Cuore

- Aiuto

- HOT

- Come

- HTML

- http

- HTTPS

- Enorme

- umano

- Esperienza umana

- Umanità

- Gli esseri umani

- centinaia

- idea

- idealmente

- idee

- Identità

- if

- Impact

- in

- In altre

- Compreso

- Aumento

- sempre più

- individui

- infame

- influenzato

- far sapere

- informazioni

- creativi e originali

- intuizioni

- interagire

- ai miglioramenti

- ironia

- IT

- SUO

- jpg

- ad appena

- Le

- conosciuto

- Lingua

- Le Lingue

- grandi

- maggiormente

- meno

- piace

- limiti

- Lives

- vita

- LLM

- Principale

- corrente principale

- Mantenere

- maggiore

- Fare

- gestione

- massiccio

- Maggio..

- significato

- Media

- Utenti

- mentale

- Salute mentale

- metodi

- Microsoft

- mente

- menti

- Disinformazione

- modellismo

- modelli

- modificare

- Mese

- morale

- maggior parte

- multiplo

- devono obbligatoriamente:

- my

- nascente

- Bisogno

- no

- adesso

- numerose

- of

- di frequente

- on

- ONE

- quelli

- online

- aprire

- open source

- Opportunità

- or

- Altro

- nostro

- partecipanti

- Persone

- per cento

- Personalità

- prospettiva

- prospettive

- Platone

- Platone Data Intelligence

- PlatoneDati

- plausibile

- punto

- Termini e Condizioni

- politico

- Popolare

- popolazioni

- Post

- potenzialmente

- potente

- sonda

- prominente

- promettente

- prova

- fornisce

- delega

- Psicologia

- la percezione

- ricerca

- qualità

- domanda

- Domande

- gamma

- rapidamente

- piuttosto

- raggiungere

- mondo reale

- veramente

- recente

- recentemente

- ridisegnare

- regimi

- regionale

- Relazioni

- rilasciato

- fare affidamento

- resti

- a distanza

- sostituito

- replicabilità

- replicato

- rappresentare

- riproduzione

- riparazioni

- risposta

- risposte

- risultante

- approssimativamente

- Correre

- Suddetto

- stesso

- Scenari

- Scuole

- Scienze

- SCIENZE

- scientifico

- scienziati

- sentimento

- set

- alcuni

- grave

- mostrare attraverso le sue creazioni

- simile

- semplicemente

- situazioni

- sonno

- Social

- Social Media

- Post sui social media

- sociale

- piuttosto

- sofisticato

- velocità

- Stelle

- inizio

- step

- punti di forza

- lottare

- studi

- Studio

- Studiando

- inciampando

- tale

- supporto

- sintetico

- SISTEMI DI TRATTAMENTO

- Arnesi

- Rubinetto

- team

- Tech

- test

- test

- di

- Grazie

- che

- Il

- loro

- Li

- poi

- teorico

- Là.

- Strumenti Bowman per analizzare le seguenti finiture:

- di

- questo

- quelli

- anche se?

- pensiero

- migliaia

- Attraverso

- stanco

- a

- strumenti

- Argomenti

- verso

- tradizionale

- Treni

- allenato

- Training

- Trasparenza

- viaggiare

- preoccupante

- veramente

- TURNO

- ombrello

- scoprire

- per

- capire

- e una comprensione reciproca

- Università

- inaudito

- uso

- usa

- utilizzando

- convalidato

- APPREZZIAMO

- Valori

- varietà

- Fisso

- molto

- controllati

- Video

- video games

- Visite

- volontari

- guerra

- modi

- we

- Tempo

- il benvenuto

- WELL

- Che

- quando

- quale

- OMS

- perché

- largo

- Vasta gamma

- più ampia

- wikipedia

- volere

- con

- senza

- parole

- Lavora

- lavori

- preoccuparsi

- scritto

- sì

- ancora

- Tu

- youtube

- zeitgeist

- zefiro