DeepMind l'ha fatto di nuovo.

Dopo aver risolto una sfida fondamentale in biologia—predire la struttura delle proteine-e districare la matematica della teoria dei nodi, ha mirato a un processo di elaborazione fondamentale incorporato in migliaia di applicazioni quotidiane. Dall'analisi delle immagini a modellare il tempo o anche sondando il funzionamento interno delle reti neurali artificiali, l'IA potrebbe teoricamente accelerare i calcoli in una vasta gamma di campi, aumentando l'efficienza e riducendo il consumo di energia e i costi.

Ma è più impressionante come l'hanno fatto. L'algoritmo da record, soprannominato AlphaTensor, è uno spin-off di Alpha Zero, che notoriamente ha sconfitto i giocatori umani a scacchi e Go.

"Gli algoritmi sono stati utilizzati in tutte le civiltà del mondo per eseguire operazioni fondamentali per migliaia di anni", ha scritto coautori dott. Matej Balog e Alhussein Fawzi a DeepMind. "Tuttavia, scoprire gli algoritmi è molto impegnativo."

AlphaTensor apre la strada a un nuovo mondo in cui l'IA progetta programmi che superano qualsiasi cosa ingegneristica umana, migliorando allo stesso tempo il proprio "cervello" della macchina.

"Questo lavoro si spinge in un territorio inesplorato utilizzando l'IA per un problema di ottimizzazione su cui le persone hanno lavorato per decenni... le soluzioni che trova possono essere immediatamente sviluppate per migliorare i tempi di esecuzione computazionale", ha affermato il dott. Federico Levi, editore senior di Natura, quale pubblicato lo studio.

Inserisci la Moltiplicazione Matrice

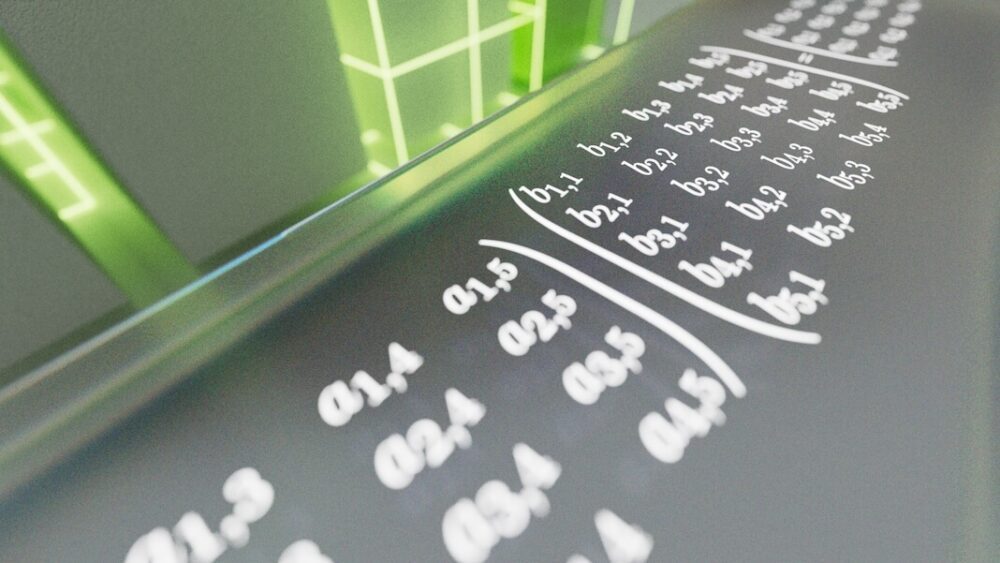

Il problema che AlphaTensor deve affrontare è la moltiplicazione di matrici. Se stai improvvisamente immaginando righe e colonne di numeri verdi che scorrono lungo lo schermo, non sei solo. In parole povere, una matrice è un po' così: una griglia di numeri che rappresenta digitalmente i dati di tua scelta. Potrebbero essere pixel in un'immagine, le frequenze di una clip audio o l'aspetto e le azioni dei personaggi nei videogiochi.

La moltiplicazione di matrici prende due griglie di numeri e si moltiplica l'una per l'altra. È un calcolo spesso insegnato al liceo, ma è anche fondamentale per i sistemi informatici. Qui, le righe di numeri in una matrice vengono moltiplicate con le colonne in un'altra. I risultati generano un risultato, ad esempio un comando per ingrandire o inclinare la vista di una scena di un videogioco. Sebbene questi calcoli funzionino sotto il cofano, chiunque utilizzi un telefono o un computer dipende dai risultati ogni singolo giorno.

Puoi vedere come il problema può diventare estremamente difficile, estremamente veloce. Moltiplicare grandi matrici è incredibilmente dispendioso in termini di energia e tempo. Ogni coppia di numeri deve essere moltiplicata individualmente per costruire una nuova matrice. Man mano che le matrici crescono, il problema diventa rapidamente insostenibile, ancor più che prevedere le migliori mosse di scacchi o Go. Alcuni esperti stimano che ci siano più modi per risolvere la moltiplicazione di matrici rispetto al numero di atomi nell'universo.

Nel 1969, Volker Strassen, un matematico tedesco, ha mostrato che ci sono modi per tagliare gli angoli, tagliando un round di moltiplicazione di matrici due per due da un totale di otto a sette. Potrebbe non sembrare impressionante, ma il metodo di Strassen ha mostrato che è possibile battere gli standard operativi di lunga data, ovvero gli algoritmi, per la moltiplicazione di matrici. Il suo approccio, l'algoritmo di Strassen, ha regnato come l'approccio più efficiente per oltre 50 anni.

Ma cosa succede se ci sono metodi ancora più efficienti? "Nessuno conosce il miglior algoritmo per risolverlo", il dottor François Le Gall dell'Università di Nagoya in Giappone, che non è stato coinvolto nel lavoro, detto MIT Technology Review. "È uno dei più grandi problemi aperti nell'informatica."

Algoritmi di inseguimento dell'IA

Se l'intuizione umana vacilla, perché non attingere a una mente meccanica?

Nel nuovo studio, il team di DeepMind ha trasformato la moltiplicazione di matrici in un gioco. Simile al suo predecessore AlphaZero, AlphaTensor utilizza l'apprendimento per rinforzo profondo, un metodo di apprendimento automatico ispirato al modo in cui imparano i cervelli biologici. Qui, un agente di intelligenza artificiale (spesso una rete neurale artificiale) interagisce con il suo ambiente per risolvere un problema a più fasi. Se riesce, guadagna una "ricompensa", ovvero i parametri di rete dell'IA vengono aggiornati, quindi è più probabile che riesca di nuovo in futuro.

È come imparare a girare una frittella. All'inizio molti cadranno sul pavimento, ma alla fine le tue reti neurali impareranno i movimenti del braccio e della mano per un capovolgimento perfetto.

Il campo di allenamento per AlphaTensor è una sorta di gioco da tavolo 3D. È essenzialmente un puzzle per un giocatore più o meno simile a Sudoku. L'IA deve moltiplicare griglie di numeri nel minor numero di passaggi possibili, scegliendo tra una miriade di mosse consentite, oltre un trilione di esse.

Queste mosse consentite sono state meticolosamente progettate in AlphaTensor. In una conferenza stampa, il coautore Dr. Hussain Fawzi ha spiegato: "Formulare lo spazio della scoperta algoritmica è molto complicato... ancora più difficile è, come possiamo navigare in questo spazio".

In altre parole, di fronte a una gamma sbalorditiva di opzioni, come possiamo restringerle per migliorare le nostre possibilità di trovare l'ago nel pagliaio? E come possiamo definire una strategia migliore per arrivare all'ago senza scavare nell'intero pagliaio?

Un trucco che il team ha incorporato in AlphaTensor è un metodo chiamato tree search. Piuttosto che, metaforicamente parlando, scavare casualmente nel pagliaio, qui l'IA sonda "strade" che potrebbero portare a un risultato migliore. Gli apprendimenti intermedi aiutano quindi l'IA a pianificare la sua prossima mossa per aumentare le possibilità di successo. Il team ha anche mostrato campioni di algoritmi di giochi di successo, come insegnare a un bambino le mosse iniziali degli scacchi. Infine, una volta che l'IA ha scoperto mosse preziose, il team le ha permesso di riordinare quelle operazioni per un apprendimento più personalizzato alla ricerca di un risultato migliore.

Rompere un nuovo terreno

AlphaTensor ha giocato bene. In una serie di test, il team ha sfidato l'IA a trovare le soluzioni più efficaci per matrici fino a cinque per cinque, ovvero con cinque numeri ciascuno in una riga o in una colonna.

L'algoritmo ha rapidamente riscoperto l'hack originale di Strassen, ma poi ha superato tutte le soluzioni precedentemente escogitate dalla mente umana. Testando l'IA con diverse dimensioni di matrici, AlphaTensor ha trovato soluzioni più efficienti per oltre 70. "In effetti, AlphaTensor scopre in genere migliaia di algoritmi per ogni dimensione di matrice", ha affermato il team. "È sbalorditivo."

In un caso, moltiplicando una matrice cinque per cinque con una quattro per cinque, l'IA ha ridotto il record precedente di 80 moltiplicazioni individuali a solo 76. Ha brillato anche su matrici più grandi, riducendo il numero di calcoli necessari per due matrici undici per undici dal 919 all'896.

Proof-of-concept alla mano, il team si è rivolto all'uso pratico. I chip per computer sono spesso progettati per ottimizzare diversi calcoli, ad esempio GPU per la grafica o Chip AI per l'apprendimento automatico—e la corrispondenza di un algoritmo con l'hardware più adatto aumenta l'efficienza.

Qui, il team ha utilizzato AlphaTensor per trovare algoritmi per due chip popolari nell'apprendimento automatico: la GPU NVIDIA V100 e Google TPU. Complessivamente, gli algoritmi sviluppati dall'IA hanno aumentato la velocità di calcolo fino al 20%.

È difficile dire se l'IA può anche velocizzare smartphone, laptop o altri dispositivi di tutti i giorni. Tuttavia, "questo sviluppo sarebbe molto eccitante se potesse essere utilizzato nella pratica", ha affermato la dott.ssa Virginia Williams del MIT. "Un aumento delle prestazioni migliorerebbe molte applicazioni".

La mente di un'IA

Nonostante AlphaTensor abbia superato l'ultimo record umano per la moltiplicazione di matrici, il team di DeepMind non può ancora spiegare perché.

"Ha avuto questa straordinaria intuizione giocando a questi giochi", ha detto lo scienziato e coautore di DeepMind Dr. Pushmeet Kohli in una conferenza stampa.

Anche gli algoritmi in evoluzione non devono essere uomo contro macchine.

Mentre AlphaTensor è un trampolino di lancio verso algoritmi più veloci, potrebbero esisterne di ancora più veloci. "Poiché ha bisogno di limitare la sua ricerca ad algoritmi di una forma specifica, potrebbe mancare altri tipi di algoritmi che potrebbero essere più efficienti", hanno scritto Balog e Fawzi.

Forse un percorso ancora più intrigante unirebbe l'intuizione umana e quella della macchina. "Sarebbe bello capire se questo nuovo metodo sussume effettivamente tutti i precedenti, o se puoi combinarli e ottenere qualcosa di ancora migliore", disse Williams. Altri esperti concordano. Con una vasta gamma di algoritmi a loro disposizione, gli scienziati possono iniziare a sezionarli alla ricerca di indizi su ciò che ha fatto funzionare le soluzioni di AlphaTensor, aprendo la strada alla prossima svolta.

Credito immagine: DeepMind