Oggi siamo entusiasti di annunciare la possibilità di ottimizzare i modelli Code Llama utilizzando Meta JumpStart di Amazon SageMaker. La famiglia Code Llama di modelli linguistici di grandi dimensioni (LLM) è una raccolta di modelli di generazione di codice pre-addestrati e ottimizzati che vanno da 7 miliardi a 70 miliardi di parametri. I modelli Code Llama ottimizzati forniscono una migliore precisione e spiegabilità rispetto ai modelli Code Llama di base, come evidente nei test contro Valutazione umana e set di dati MBPP. Puoi ottimizzare e distribuire modelli Code Llama con SageMaker JumpStart utilizzando il file Amazon Sage Maker Studio Interfaccia utente con pochi clic o utilizzando SageMaker Python SDK. La messa a punto dei modelli Llama si basa sugli script forniti nel file Repository GitHub di ricette di lama da Meta utilizzando le tecniche di quantizzazione PyTorch FSDP, PEFT/LoRA e Int8.

In questo post, spiegheremo come ottimizzare i modelli pre-addestrati di Code Llama tramite SageMaker JumpStart attraverso un'interfaccia utente con un clic e un'esperienza SDK disponibile nei seguenti Repository GitHub.

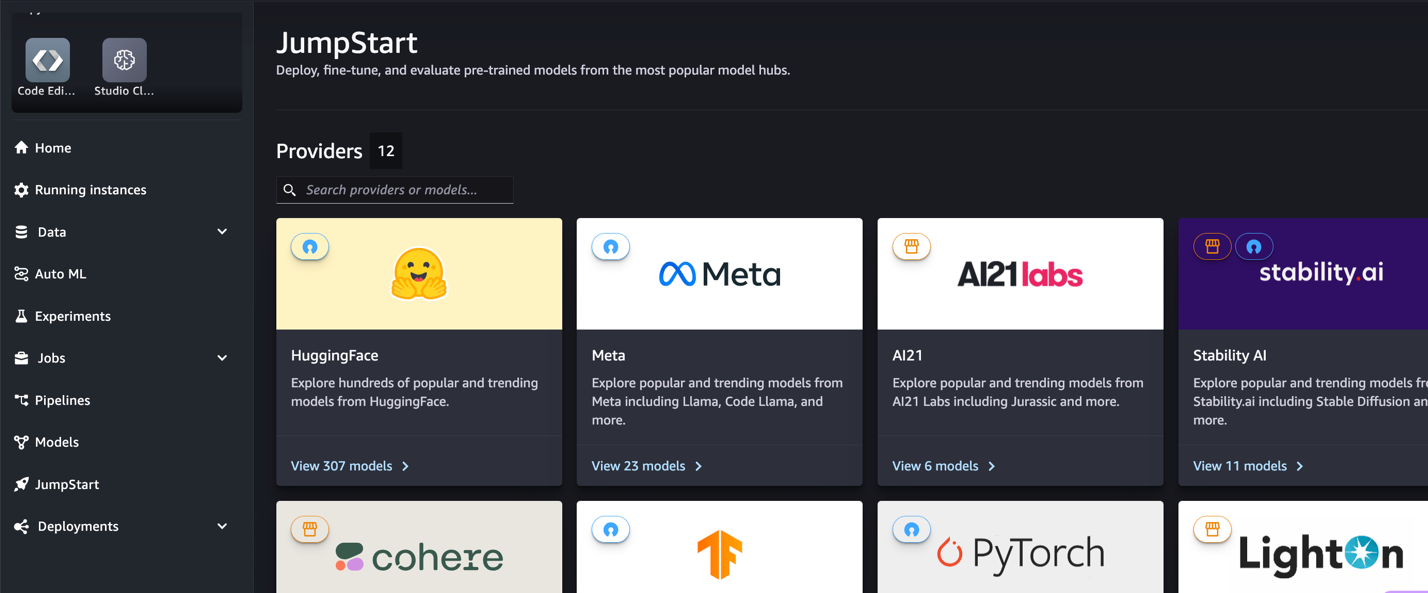

Cos'è SageMaker JumpStart

Con SageMaker JumpStart, i professionisti del machine learning (ML) possono scegliere tra un'ampia selezione di modelli di base disponibili pubblicamente. I professionisti del machine learning possono distribuire modelli di base a progetti dedicati Amazon Sage Maker istanze da un ambiente isolato dalla rete e personalizza i modelli utilizzando SageMaker per l'addestramento e la distribuzione dei modelli.

Cos'è Code Llama

Code Llama è una versione specializzata in codice di lama 2 che è stato creato addestrando ulteriormente Llama 2 sui suoi set di dati specifici del codice e campionando più dati dallo stesso set di dati per un periodo più lungo. Code Llama offre funzionalità di codifica avanzate. Può generare codice e linguaggio naturale relativo al codice, sia da istruzioni di codice che di linguaggio naturale (ad esempio, "Scrivimi una funzione che restituisca la sequenza di Fibonacci"). Puoi anche usarlo per il completamento del codice e il debug. Supporta molti dei linguaggi di programmazione più popolari utilizzati oggi, tra cui Python, C++, Java, PHP, Typescript (JavaScript), C#, Bash e altri.

Perché ottimizzare i modelli Code Llama

Meta ha pubblicato i benchmark delle prestazioni di Code Llama su HumanEval e MBPP per linguaggi di codifica comuni come Python, Java e JavaScript. Le prestazioni dei modelli Code Llama Python su HumanEval hanno dimostrato prestazioni variabili tra diversi linguaggi di codifica e attività che vanno dal 38% sul modello Python 7B al 57% sui modelli Python 70B. Inoltre, i modelli Code Llama ottimizzati sul linguaggio di programmazione SQL hanno mostrato risultati migliori, come evidente nei benchmark di valutazione SQL. Questi benchmark pubblicati evidenziano i potenziali vantaggi della messa a punto dei modelli Code Llama, consentendo prestazioni, personalizzazione e adattamento migliori a domini e attività di codifica specifici.

Ottimizzazione senza codice tramite l'interfaccia utente di SageMaker Studio

Per iniziare a perfezionare i tuoi modelli Llama utilizzando SageMaker Studio, completa i seguenti passaggi:

- Nella console di SageMaker Studio, scegli inizio di salto nel pannello di navigazione.

Troverai elenchi di oltre 350 modelli che vanno dai modelli open source e proprietari.

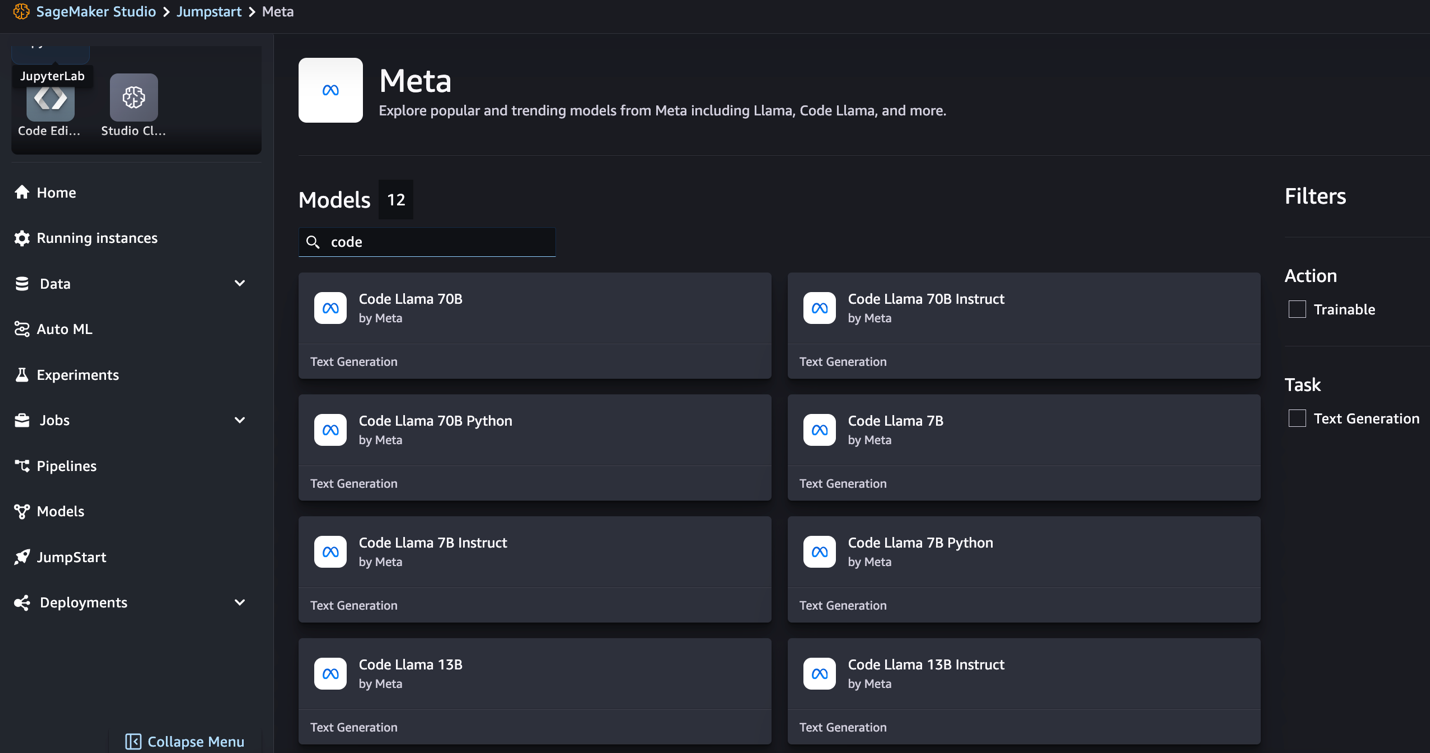

- Cerca i modelli Code Llama.

Se non vedi i modelli Code Llama, puoi aggiornare la versione di SageMaker Studio spegnendo e riavviando. Per ulteriori informazioni sugli aggiornamenti della versione, fare riferimento a Chiudi e aggiorna le app di Studio. Puoi trovare anche altre varianti del modello scegliendo Esplora tutti i modelli di generazione del codice o cercando Code Llama nella casella di ricerca.

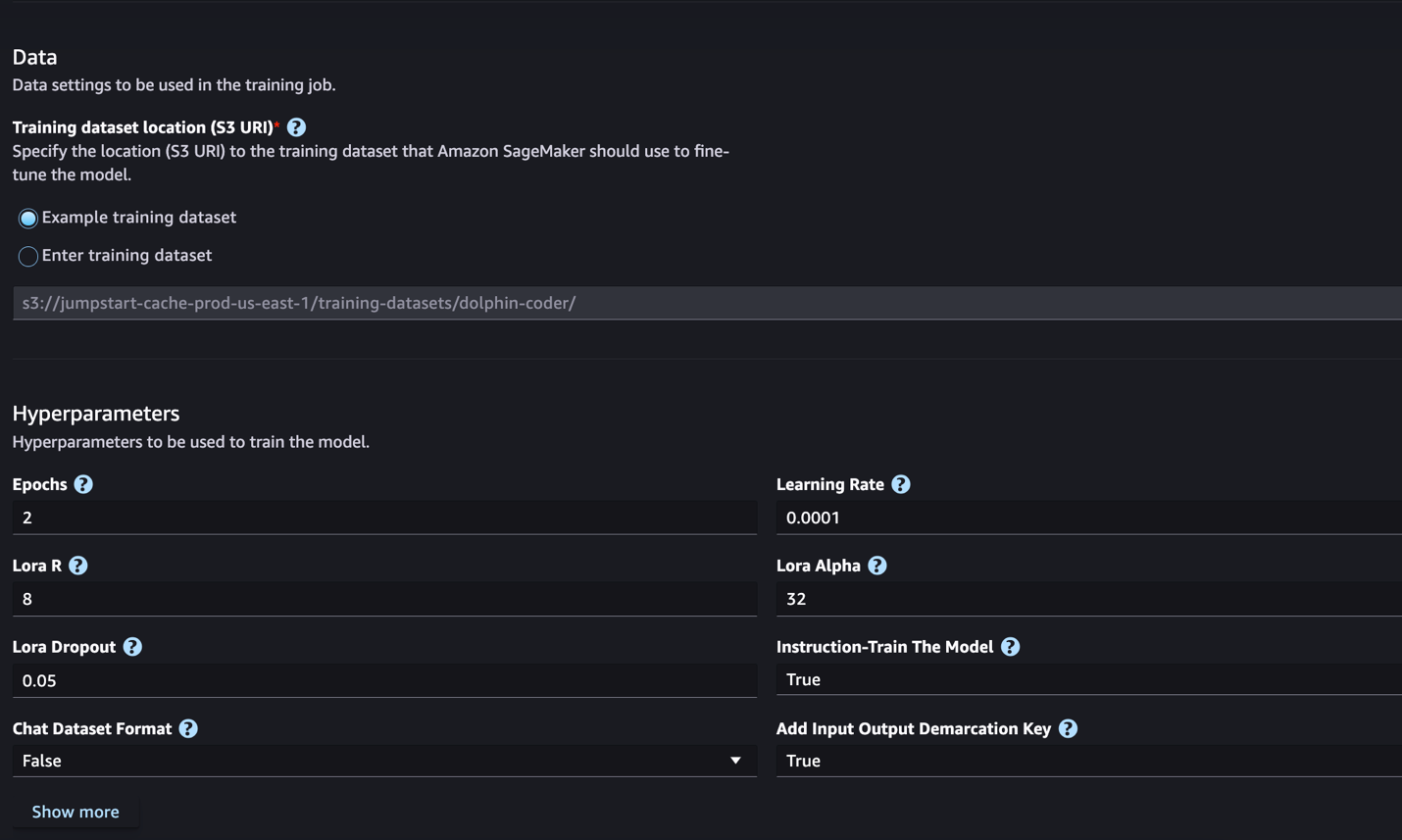

SageMaker JumpStart attualmente supporta la regolazione fine delle istruzioni per i modelli Code Llama. Lo screenshot seguente mostra la pagina di messa a punto per il modello Code Llama 2 70B.

- Nel Posizione del set di dati di addestramento, puoi indicare il Servizio di archiviazione semplice Amazon (Amazon S3) bucket contenente i set di dati di training e convalida per la messa a punto.

- Imposta la configurazione di distribuzione, gli iperparametri e le impostazioni di sicurezza per la messa a punto.

- Scegli Treni per avviare il lavoro di ottimizzazione su un'istanza SageMaker ML.

Discuteremo il formato del set di dati necessario per preparare la messa a punto delle istruzioni nella sezione successiva.

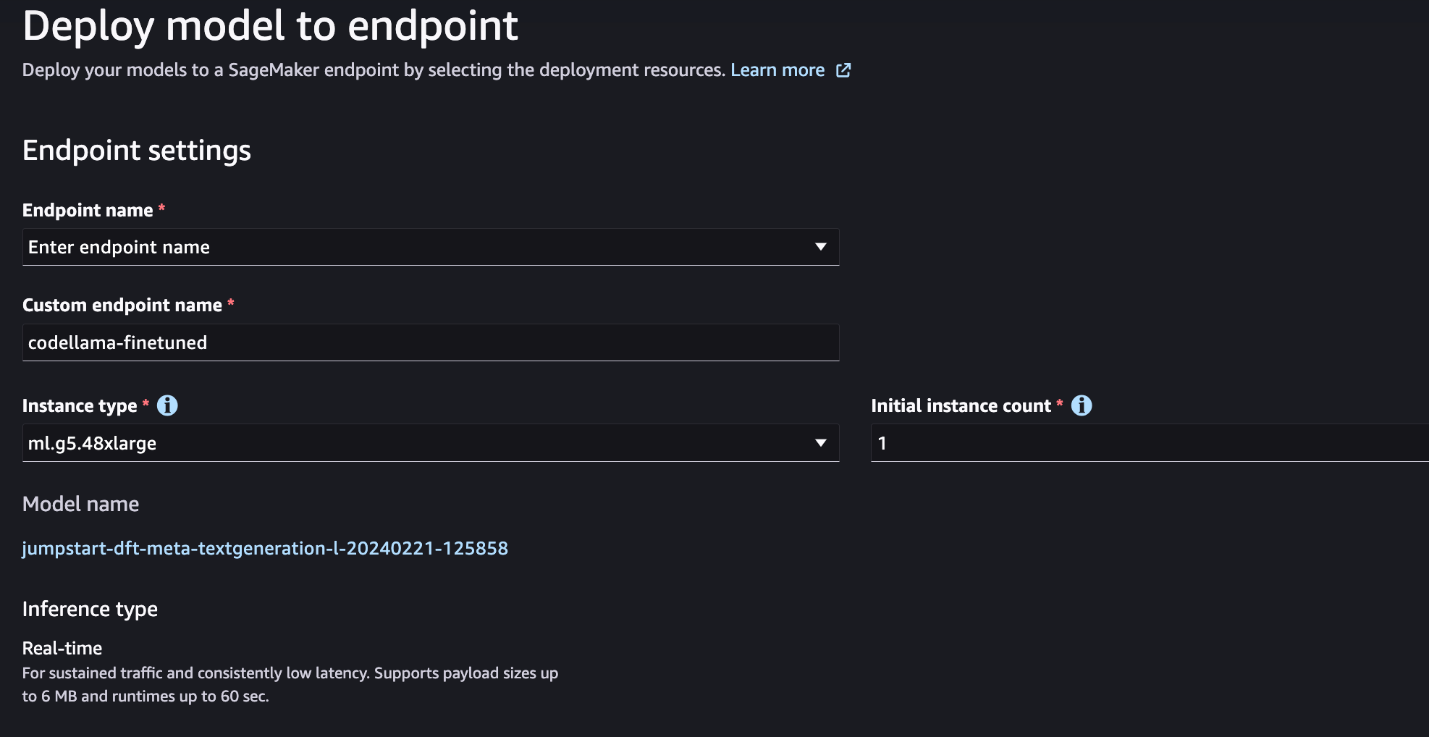

- Dopo aver ottimizzato il modello, puoi distribuirlo utilizzando la pagina del modello su SageMaker JumpStart.

L'opzione per distribuire il modello ottimizzato verrà visualizzata al termine dell'ottimizzazione, come mostrato nello screenshot seguente.

Ottimizza tramite SageMaker Python SDK

In questa sezione, dimostriamo come ottimizzare i modelli Code LIama utilizzando SageMaker Python SDK su un set di dati formattato con istruzioni. Nello specifico, il modello è ottimizzato per una serie di attività di elaborazione del linguaggio naturale (NLP) descritte utilizzando le istruzioni. Ciò aiuta a migliorare le prestazioni del modello per attività invisibili con istruzioni zero-shot.

Completa i seguenti passaggi per completare il lavoro di ottimizzazione. È possibile ottenere l'intero codice di regolazione fine dal file Repository GitHub.

Per prima cosa, diamo un'occhiata al formato del set di dati richiesto per la messa a punto dell'istruzione. I dati di training devono essere formattati in un formato di righe JSON (.jsonl), in cui ogni riga è un dizionario che rappresenta un campione di dati. Tutti i dati di allenamento devono trovarsi in un'unica cartella. Tuttavia, può essere salvato in più file .jsonl. Di seguito è riportato un esempio in formato righe JSON:

La cartella di formazione può contenere a template.json file che descrive i formati di input e output. Di seguito è riportato un modello di esempio:

Per corrispondere al modello, ogni campione nei file delle righe JSON deve includere system_prompt, questione response campi. In questa dimostrazione utilizziamo il file Set di dati di Dolphin Coder da Il viso che abbraccia.

Dopo aver preparato il set di dati e averlo caricato nel bucket S3, puoi iniziare la messa a punto utilizzando il seguente codice:

È possibile distribuire il modello ottimizzato direttamente dallo stimatore, come mostrato nel codice seguente. Per i dettagli consultare il quaderno in Repository GitHub.

Tecniche di messa a punto

I modelli linguistici come Llama hanno dimensioni superiori a 10 GB o addirittura 100 GB. La messa a punto di modelli così grandi richiede istanze con memoria CUDA significativamente elevata. Inoltre, l'addestramento di questi modelli può essere molto lento a causa delle dimensioni del modello. Pertanto, per una messa a punto efficiente, utilizziamo le seguenti ottimizzazioni:

- Adattamento di basso rango (LoRA) – Questo è un tipo di regolazione fine efficiente dei parametri (PEFT) per la regolazione fine efficiente di modelli di grandi dimensioni. Con questo metodo, si blocca l'intero modello e si aggiunge solo un piccolo set di parametri o livelli regolabili nel modello. Ad esempio, invece di allenare tutti i 7 miliardi di parametri per Llama 2 7B, puoi ottimizzare meno dell'1% dei parametri. Ciò aiuta a ridurre in modo significativo il fabbisogno di memoria poiché è necessario memorizzare gradienti, stati dell'ottimizzatore e altre informazioni relative all'allenamento solo per l'1% dei parametri. Inoltre, questo aiuta a ridurre i tempi di formazione e i costi. Per ulteriori dettagli su questo metodo, fare riferimento a LoRA: adattamento di basso rango di modelli linguistici di grandi dimensioni.

- Quantizzazione Int8 – Anche con ottimizzazioni come LoRA, modelli come Llama 70B sono ancora troppo grandi per essere addestrati. Per ridurre l'impronta di memoria durante l'addestramento, è possibile utilizzare la quantizzazione Int8 durante l'addestramento. La quantizzazione in genere riduce la precisione dei tipi di dati a virgola mobile. Sebbene ciò riduca la memoria richiesta per memorizzare i pesi del modello, riduce le prestazioni a causa della perdita di informazioni. La quantizzazione Int8 utilizza solo un quarto di precisione ma non comporta un degrado delle prestazioni perché non elimina semplicemente i bit. Arrotonda i dati da un tipo all'altro. Per ulteriori informazioni sulla quantizzazione Int8, fare riferimento a LLM.int8(): moltiplicazione di matrici a 8 bit per trasformatori su larga scala.

- Parallelo dati completamente condivisi (FSDP) – Si tratta di un tipo di algoritmo di addestramento parallelo ai dati che suddivide i parametri del modello tra i lavoratori paralleli dei dati e può facoltativamente scaricare parte del calcolo di addestramento sulle CPU. Sebbene i parametri siano suddivisi tra diverse GPU, il calcolo di ciascun microbatch è locale per il GPU Worker. Suddivide i parametri in modo più uniforme e raggiunge prestazioni ottimizzate tramite la sovrapposizione di comunicazione e calcolo durante l'addestramento.

La tabella seguente riassume i dettagli di ciascun modello con impostazioni diverse.

| Modello | Impostazione predefinita | LORA+FSDP | LORA + Nessun PFSDP | Quantizzazione Int8 + LORA + Nessun FSDP |

| Codice Lama 2 7B | LORA+FSDP | Sì | Sì | Sì |

| Codice Lama 2 13B | LORA+FSDP | Sì | Sì | Sì |

| Codice Lama 2 34B | INT8 + LORA + NESSUN PFSDP | Non | Non | Sì |

| Codice Lama 2 70B | INT8 + LORA + NESSUN PFSDP | Non | Non | Sì |

La messa a punto dei modelli Llama si basa sugli script forniti di seguito Repository GitHub.

Iperparametri supportati per l'addestramento

L'ottimizzazione di Code Llama 2 supporta una serie di iperparametri, ognuno dei quali può influire sui requisiti di memoria, sulla velocità di addestramento e sulle prestazioni del modello ottimizzato:

- epoca – Il numero di passaggi effettuati dall'algoritmo di fine tuning attraverso il set di dati di training. Deve essere un numero intero maggiore di 1. Il valore predefinito è 5.

- tasso_di_apprendimento – La velocità con cui i pesi del modello vengono aggiornati dopo aver elaborato ciascun batch di esempi di training. Deve essere un float positivo maggiore di 0. Il valore predefinito è 1e-4.

- istruzione_sintonizzata – Se addestrare il modello o meno. Deve essere

TrueorFalse. L'impostazione predefinita èFalse. - per_dispositivo_treno_dimensione_batch – La dimensione del batch per core GPU/CPU per l'addestramento. Deve essere un numero intero positivo. L'impostazione predefinita è 4.

- per_device_eval_batch_size – La dimensione del batch per core GPU/CPU per la valutazione. Deve essere un numero intero positivo. L'impostazione predefinita è 1.

- max_train_samples – Per scopi di debug o per una formazione più rapida, troncare il numero di esempi di formazione a questo valore. Il valore -1 indica l'utilizzo di tutti i campioni di training. Deve essere un numero intero positivo o -1. L'impostazione predefinita è -1.

- max_val_samples – Per scopi di debug o per una formazione più rapida, troncare il numero di esempi di convalida a questo valore. Il valore -1 indica l'utilizzo di tutti i campioni di convalida. Deve essere un numero intero positivo o -1. L'impostazione predefinita è -1.

- lunghezza_input_massima – Lunghezza massima totale della sequenza di input dopo la tokenizzazione. Le sequenze più lunghe verranno troncate. Se -1,

max_input_lengthè impostato sul minimo di 1024 e sulla lunghezza massima del modello definita dal tokenizzatore. Se impostato su un valore positivo,max_input_lengthè impostato sul minimo del valore fornito e ilmodel_max_lengthdefinito dal tokenizzatore. Deve essere un numero intero positivo o -1. L'impostazione predefinita è -1. - validation_split_ratio – Se il canale di convalida è

none, il rapporto tra la suddivisione della convalida del treno e i dati del treno deve essere compreso tra 0 e 1. L'impostazione predefinita è 0.2. - train_data_split_seed – Se i dati di convalida non sono presenti, ciò fissa la suddivisione casuale dei dati di training di input nei dati di training e di convalida utilizzati dall'algoritmo. Deve essere un numero intero. L'impostazione predefinita è 0.

- preprocessing_num_workers – Il numero di processi da utilizzare per la preelaborazione. Se

None, il processo principale viene utilizzato per la preelaborazione. L'impostazione predefinita èNone. - lora_r – Lora R. Deve essere un numero intero positivo. L'impostazione predefinita è 8.

- lora_alpha – Lora Alfa. Deve essere un numero intero positivo. L'impostazione predefinita è 32

- lora_dropout – Lora abbandona. deve essere un numero mobile positivo compreso tra 0 e 1. Il valore predefinito è 0.05.

- int8_quantizzazione - Se

True, il modello viene caricato con precisione a 8 bit per l'addestramento. L'impostazione predefinita per 7B e 13B èFalse. L'impostazione predefinita per 70B èTrue. - abilita_fsdp – Se Vero, la formazione utilizza FSDP. L'impostazione predefinita per 7B e 13B è Vero. L'impostazione predefinita per 70B è False. Notare che

int8_quantizationnon è supportato con FSDP.

Quando si scelgono gli iperparametri, considerare quanto segue:

- Configurazione

int8_quantization=Truediminuisce il fabbisogno di memoria e porta ad un allenamento più veloce. - Decrescente

per_device_train_batch_sizeedmax_input_lengthriduce il requisito di memoria e quindi può essere eseguito su istanze più piccole. Tuttavia, l'impostazione di valori molto bassi potrebbe aumentare il tempo di allenamento. - Se non stai utilizzando la quantizzazione Int8 (

int8_quantization=False), utilizzare FSDP (enable_fsdp=True) per un allenamento più rapido ed efficiente.

Tipi di istanze supportate per l'addestramento

La tabella seguente riepiloga i tipi di istanza supportati per l'addestramento di modelli diversi.

| Modello | Tipo di istanza predefinito | Tipi di istanza supportati |

| Codice Lama 2 7B | ml.g5.12xgrande |

ml.g5.12xgrande, ml.g5.24xgrande, ml.g5.48xgrande, ml.p3dn.24xgrande, ml.g4dn.12xgrande |

| Codice Lama 2 13B | ml.g5.12xgrande |

ml.g5.24xgrande, ml.g5.48xgrande, ml.p3dn.24xgrande, ml.g4dn.12xgrande |

| Codice Lama 2 70B | ml.g5.48xgrande |

ml.g5.48xgrande ml.p4d.24xlarge |

Quando si sceglie il tipo di istanza, considerare quanto segue:

- Le istanze G5 forniscono la formazione più efficiente tra i tipi di istanza supportati. Pertanto, se disponi di istanze G5, dovresti utilizzarle.

- Il tempo di addestramento dipende in gran parte dalla quantità di GPU e memoria CUDA disponibili. Pertanto, l'addestramento su istanze con lo stesso numero di GPU (ad esempio, ml.g5.2xlarge e ml.g5.4xlarge) è più o meno lo stesso. Pertanto, puoi utilizzare l'istanza più economica per l'addestramento (ml.g5.2xlarge).

- Quando si utilizzano istanze p3, l'addestramento verrà eseguito con precisione a 32 bit perché bfloat16 non è supportato su queste istanze. Pertanto, il processo di training consumerà il doppio della quantità di memoria CUDA durante il training su istanze p3 rispetto alle istanze g5.

Per informazioni sul costo della formazione per istanza, fare riferimento a Istanze Amazon EC2 G5.

Valutazione

La valutazione è un passo importante per valutare le prestazioni dei modelli ottimizzati. Presentiamo valutazioni sia qualitative che quantitative per mostrare il miglioramento dei modelli ottimizzati rispetto a quelli non ottimizzati. Nella valutazione qualitativa, mostriamo una risposta di esempio da entrambi i modelli ottimizzati e non ottimizzati. Nella valutazione quantitativa, utilizziamo Valutazione umana, una suite di test sviluppata da OpenAI per generare codice Python per testare la capacità di produrre risultati corretti e accurati. Il repository HumanEval è sotto licenza MIT. Abbiamo perfezionato le varianti Python di tutti i modelli Code LIama su diverse dimensioni (Code LIama Python 7B, 13B, 34B e 70B sul Set di dati di Dolphin Coder) e presentare i risultati della valutazione nelle sezioni seguenti.

Valutazione qualitativa

Una volta distribuito il modello ottimizzato, puoi iniziare a utilizzare l'endpoint per generare codice. Nell'esempio seguente, presentiamo le risposte delle varianti Python di base e ottimizzate di Code LIama 34B su un campione di test in Set di dati di Dolphin Coder:

Il modello Code Llama ottimizzato, oltre a fornire il codice per la query precedente, genera una spiegazione dettagliata dell'approccio e uno pseudo codice.

Codice Llama 34b Risposta Python non ottimizzata:

Codice Llama 34B Risposta ottimizzata Python

Realtà di base

È interessante notare che la nostra versione ottimizzata di Code Llama 34B Python fornisce una soluzione dinamica basata sulla programmazione per la sottostringa palindromica più lunga, che è diversa dalla soluzione fornita nella verità fondamentale dall'esempio di test selezionato. Il nostro modello ottimizzato motiva e spiega in dettaglio la soluzione basata sulla programmazione dinamica. D’altro canto, il modello non ottimizzato crea allucinazioni sui potenziali risultati subito dopo print istruzione (mostrata nella cella di sinistra) perché l'output axyzzyx non è il palindromo più lungo nella stringa data. In termini di complessità temporale, la soluzione di programmazione dinamica è generalmente migliore dell’approccio iniziale. La soluzione di programmazione dinamica ha una complessità temporale pari a O(n^2), dove n è la lunghezza della stringa di input. Ciò è più efficiente della soluzione iniziale del modello non ottimizzato, che aveva anch'esso una complessità temporale quadratica di O(n^2) ma con un approccio meno ottimizzato.

Sembra promettente! Ricorda, abbiamo perfezionato solo la variante Code LIama Python con il 10% del Set di dati di Dolphin Coder. C'è molto altro da esplorare!

Nonostante le istruzioni dettagliate nella risposta, dobbiamo ancora esaminare la correttezza del codice Python fornito nella soluzione. Successivamente, utilizziamo un quadro di valutazione chiamato Valutazione umana eseguire test di integrazione sulla risposta generata da Code LIama per esaminarne sistematicamente la qualità.

Valutazione quantitativa con HumanEval

HumanEval è un'attrezzatura di valutazione per valutare le capacità di risoluzione dei problemi di un LLM su problemi di codifica basati su Python, come descritto nel documento Valutazione di modelli linguistici di grandi dimensioni addestrati sul codice. Nello specifico, consiste in 164 problemi di programmazione originali basati su Python che valutano la capacità di un modello linguistico di generare codice in base alle informazioni fornite come firma della funzione, docstring, corpo e test unitari.

Per ogni domanda di programmazione basata su Python, la inviamo a un modello Code LIama distribuito su un endpoint SageMaker per ottenere k risposte. Successivamente, eseguiamo ciascuna delle risposte k sui test di integrazione nel repository HumanEval. Se una qualsiasi delle risposte k supera i test di integrazione, consideriamo positivo il caso di test; in caso contrario, fallito. Quindi ripetiamo il processo per calcolare il rapporto di casi di successo come punteggio di valutazione finale nominato pass@k. Seguendo la pratica standard, impostiamo k come 1 nella nostra valutazione, per generare solo una risposta per domanda e verificare se supera il test di integrazione.

Di seguito è riportato un codice di esempio per utilizzare il repository HumanEval. Puoi accedere al set di dati e generare una risposta singola utilizzando un endpoint SageMaker. Per i dettagli consultare il quaderno in Repository GitHub.

La tabella seguente mostra i miglioramenti dei modelli Code LIama Python ottimizzati rispetto ai modelli non ottimizzati in diverse dimensioni del modello. Per garantire la correttezza, distribuiamo anche i modelli Code LIama non ottimizzati negli endpoint SageMaker ed eseguiamo valutazioni di valutazione umana. IL passa@1 i numeri (la prima riga nella tabella seguente) corrispondono ai numeri riportati nel file Documento di ricerca su Code Llama. I parametri di inferenza sono costantemente impostati come "parameters": {"max_new_tokens": 384, "temperature": 0.2}.

Come possiamo vedere dai risultati, tutte le varianti Code LIama Python ottimizzate mostrano un miglioramento significativo rispetto ai modelli non ottimizzati. In particolare, Code LIama Python 70B supera il modello non ottimizzato di circa il 12%.

| . | 7B Pitone | 13B Pitone | 34B | 34B Pitone | 70B Pitone |

| Prestazioni del modello pre-addestrato (pass@1) | 38.4 | 43.3 | 48.8 | 53.7 | 57.3 |

| Prestazioni del modello ottimizzate (pass@1) | 45.12 | 45.12 | 59.1 | 61.5 | 69.5 |

Ora puoi provare a ottimizzare i modelli Code LIama sul tuo set di dati.

ripulire

Se decidi di non voler più mantenere in esecuzione l'endpoint SageMaker, puoi eliminarlo utilizzando SDK AWS per Python (Boto3), Interfaccia della riga di comando di AWS (AWS CLI) o console SageMaker. Per ulteriori informazioni, vedere Elimina endpoint e risorse. Inoltre, puoi chiudere le risorse di SageMaker Studio che non sono più necessari.

Conclusione

In questo post, abbiamo discusso della messa a punto dei modelli Code Llama 2 di Meta utilizzando SageMaker JumpStart. Abbiamo dimostrato che è possibile utilizzare la console SageMaker JumpStart in SageMaker Studio o SageMaker Python SDK per ottimizzare e distribuire questi modelli. Abbiamo anche discusso la tecnica di perfezionamento, i tipi di istanza e gli iperparametri supportati. Inoltre, abbiamo delineato raccomandazioni per un allenamento ottimizzato sulla base di vari test che abbiamo effettuato. Come possiamo vedere da questi risultati dell'ottimizzazione di tre modelli su due set di dati, l'ottimizzazione migliora il riepilogo rispetto ai modelli non ottimizzati. Come passaggio successivo, puoi provare a mettere a punto questi modelli sul tuo set di dati utilizzando il codice fornito nel repository GitHub per testare e confrontare i risultati per i tuoi casi d'uso.

Informazioni sugli autori

Dott. Xin Huang è Senior Applied Scientist per gli algoritmi integrati di Amazon SageMaker JumpStart e Amazon SageMaker. Si concentra sullo sviluppo di algoritmi di apprendimento automatico scalabili. I suoi interessi di ricerca riguardano l'elaborazione del linguaggio naturale, il deep learning spiegabile su dati tabulari e l'analisi solida del clustering spazio-temporale non parametrico. Ha pubblicato molti articoli nelle conferenze ACL, ICDM, KDD e Royal Statistical Society: Series A.

Dott. Xin Huang è Senior Applied Scientist per gli algoritmi integrati di Amazon SageMaker JumpStart e Amazon SageMaker. Si concentra sullo sviluppo di algoritmi di apprendimento automatico scalabili. I suoi interessi di ricerca riguardano l'elaborazione del linguaggio naturale, il deep learning spiegabile su dati tabulari e l'analisi solida del clustering spazio-temporale non parametrico. Ha pubblicato molti articoli nelle conferenze ACL, ICDM, KDD e Royal Statistical Society: Series A.

Vishaal Yalamanchali è uno Startup Solutions Architect che lavora con aziende in fase iniziale di intelligenza artificiale generativa, robotica e veicoli autonomi. Vishaal collabora con i suoi clienti per fornire soluzioni ML all'avanguardia ed è personalmente interessato all'apprendimento per rinforzo, alla valutazione LLM e alla generazione di codice. Prima di AWS, Vishaal era uno studente universitario presso l'UCI, specializzato in bioinformatica e sistemi intelligenti.

Vishaal Yalamanchali è uno Startup Solutions Architect che lavora con aziende in fase iniziale di intelligenza artificiale generativa, robotica e veicoli autonomi. Vishaal collabora con i suoi clienti per fornire soluzioni ML all'avanguardia ed è personalmente interessato all'apprendimento per rinforzo, alla valutazione LLM e alla generazione di codice. Prima di AWS, Vishaal era uno studente universitario presso l'UCI, specializzato in bioinformatica e sistemi intelligenti.

Meenakshisundaram Tandavarayan lavora per AWS come specialista di IA/ML. Ha una passione per progettare, creare e promuovere esperienze di analisi e dati incentrati sull'uomo. Meena si concentra sullo sviluppo di sistemi sostenibili che offrano vantaggi competitivi e misurabili per i clienti strategici di AWS. Meena è una connettore e una pensatrice del design e si impegna a guidare le aziende verso nuovi modi di lavorare attraverso l'innovazione, l'incubazione e la democratizzazione.

Meenakshisundaram Tandavarayan lavora per AWS come specialista di IA/ML. Ha una passione per progettare, creare e promuovere esperienze di analisi e dati incentrati sull'uomo. Meena si concentra sullo sviluppo di sistemi sostenibili che offrano vantaggi competitivi e misurabili per i clienti strategici di AWS. Meena è una connettore e una pensatrice del design e si impegna a guidare le aziende verso nuovi modi di lavorare attraverso l'innovazione, l'incubazione e la democratizzazione.

Dottor Ashish Khetan è un Senior Applied Scientist con algoritmi integrati di Amazon SageMaker e aiuta a sviluppare algoritmi di machine learning. Ha conseguito il dottorato di ricerca presso l'Università dell'Illinois Urbana-Champaign. È un ricercatore attivo nell'apprendimento automatico e nell'inferenza statistica e ha pubblicato numerosi articoli nelle conferenze NeurIPS, ICML, ICLR, JMLR, ACL e EMNLP.

Dottor Ashish Khetan è un Senior Applied Scientist con algoritmi integrati di Amazon SageMaker e aiuta a sviluppare algoritmi di machine learning. Ha conseguito il dottorato di ricerca presso l'Università dell'Illinois Urbana-Champaign. È un ricercatore attivo nell'apprendimento automatico e nell'inferenza statistica e ha pubblicato numerosi articoli nelle conferenze NeurIPS, ICML, ICLR, JMLR, ACL e EMNLP.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/fine-tune-code-llama-on-amazon-sagemaker-jumpstart/

- :ha

- :È

- :non

- :Dove

- 1

- 10

- 100

- 12

- 13

- 14

- 16

- 20

- 27

- 2D

- 350

- 7

- 70

- 8

- a

- abilità

- capacità

- Chi siamo

- Accetta

- accesso

- precisione

- preciso

- Realizza

- operanti in

- attivo

- adattamento

- aggiungere

- aggiunta

- Inoltre

- regolabile

- vantaggi

- Dopo shavasana, sedersi in silenzio; saluti;

- contro

- AI

- algoritmo

- Algoritmi

- Tutti

- Alpha

- già

- anche

- Sebbene il

- Amazon

- Amazon Sage Maker

- JumpStart di Amazon SageMaker

- Amazon Web Services

- tra

- quantità

- an

- .

- analitica

- ed

- Annunciare

- Un altro

- rispondere

- in qualsiasi

- apparire

- applicato

- approccio

- circa

- SONO

- RISERVATA

- AS

- valutare

- At

- autonomo

- disponibile

- AWS

- BAB

- base

- basato

- bash

- BE

- perché

- diventa

- dietro

- Segno di riferimento

- parametri di riferimento

- vantaggi

- Meglio

- fra

- Big

- Miliardo

- bit

- stile di vita

- entrambi

- Entrambe le parti

- Scatola

- Rompere

- ampio

- incassato

- aziende

- ma

- by

- C++

- calcolare

- detto

- Materiale

- Può ottenere

- funzionalità

- capacità

- svolta

- Custodie

- casi

- cella

- il cambiamento

- cambiando

- canale

- carattere

- caratteri

- chiacchierare

- più economico

- dai un'occhiata

- verifica

- Controlli

- Scegli

- la scelta

- cli

- il clustering

- istruire

- codice

- coder

- codifica

- collezione

- Uncommon

- Comunicazione

- Aziende

- rispetto

- competitivo

- completamento di una

- completamento

- complessità

- calcolo

- conferenze

- Configurazione

- consecutivo

- Prendere in considerazione

- costantemente

- Consistente

- consiste

- consolle

- consumare

- contenere

- correggere

- Costo

- contare

- creare

- creato

- Corrente

- Attualmente

- Clienti

- personalizzazione

- personalizzare

- bordo tagliente

- dati

- dataset

- decide

- diminuire

- diminuisce

- dedicato

- deep

- apprendimento profondo

- Predefinito

- definito

- consegnare

- democratizzazione

- dimostrare

- dimostrato

- dimostrazione

- dipende

- schierare

- schierato

- deployment

- derivato

- descritta

- descrivendo

- Design

- dettaglio

- dettagliati

- dettagli

- sviluppare

- sviluppato

- in via di sviluppo

- diverso

- cifre

- dimensioni

- direttamente

- discutere

- discusso

- non

- domini

- fatto

- Dont

- doppio

- giù

- guidare

- Cadere

- dovuto

- durante

- dinamico

- ogni

- fase iniziale

- efficienza

- efficiente

- o

- consentendo

- fine

- finale

- endpoint

- Inglese

- migliorata

- garantire

- Intero

- Ambiente

- pari

- la valutazione

- valutazione

- valutazioni

- Anche

- evidente

- esaminare

- esempio

- Esempi

- eccitato

- Espandere

- esperienza

- Esperienze

- Spiegare

- Spiega

- spiegazione

- Faccia

- fallito

- falso

- famiglia

- più veloce

- FB

- Caratteristiche

- pochi

- Fibonacci

- campi

- Compila il

- File

- riempire

- finale

- Infine

- Trovare

- Nome

- correzioni

- galleggiante

- galleggiante

- Focus

- concentrato

- si concentra

- i seguenti

- Orma

- Nel

- formato

- Fondazione

- Contesto

- Congelare

- da

- function

- ulteriormente

- Inoltre

- generalmente

- generare

- generato

- genera

- ELETTRICA

- generativo

- AI generativa

- ottenere

- GitHub

- dato

- dà

- ha ottenuto

- GPU

- GPU

- gradienti

- maggiore

- Terra

- ha avuto

- cura

- cintura da arrampicata

- Avere

- he

- aiuta

- Alta

- Highlight

- il suo

- Come

- Tutorial

- Tuttavia

- HTML

- http

- HTTPS

- umano

- i

- identico

- if

- Illinois

- Impact

- importare

- importante

- competenze

- miglioramento

- miglioramenti

- migliora

- in

- includere

- Compreso

- Aumento

- incremento

- INCUBAZIONE

- Index

- Indici

- informazioni

- inizialmente

- Innovazione

- ingresso

- install

- esempio

- invece

- istruzioni

- integrazione

- Intelligente

- interessato

- interessi

- ai miglioramenti

- isolato

- IT

- iterando

- iterazione

- SUO

- Java

- JavaScript

- Lavoro

- jpeg

- jpg

- json

- mantenere

- continua

- Lingua

- Le Lingue

- grandi

- maggiormente

- Cognome

- galline ovaiole

- Leads

- IMPARARE

- apprendimento

- a sinistra

- Lunghezza

- meno

- Licenza

- piace

- linea

- Linee

- Annunci

- Lama

- LLM

- locale

- più a lungo

- Guarda

- cerca

- SEMBRA

- spento

- lotto

- Basso

- macchina

- machine learning

- Principale

- mantiene

- make

- molti

- partita

- abbinato

- fiammiferi

- Matrice

- massimo

- Maggio..

- me

- si intende

- Memorie

- Meta

- metodo

- ordine

- CON

- ML

- modello

- modelli

- Scopri di più

- più efficiente

- maggior parte

- Più popolare

- multiplo

- devono obbligatoriamente:

- Detto

- Naturale

- Elaborazione del linguaggio naturale

- Navigazione

- Bisogno

- Rete

- mai

- New

- GENERAZIONE

- nlp

- no

- Nota

- taccuino

- numero

- numeri

- of

- on

- ONE

- quelli

- esclusivamente

- aprire

- open source

- OpenAI

- ottimizzazioni

- ottimizzati

- Opzione

- or

- minimo

- i

- Altro

- altrimenti

- nostro

- su

- delineato

- Sorpassa

- produzione

- uscite

- ancora

- proprio

- pagina

- vetro

- Carta

- documenti

- Parallel

- parametro

- parametri

- parte

- particolare

- Passi

- passione

- per

- performance

- Personalmente

- phd

- PHP

- Platone

- Platone Data Intelligence

- PlatoneDati

- per favore

- punto

- Popolare

- positivo

- Post

- potenziale

- pratica

- precedente

- Precisione

- Preparare

- presenti

- Precedente

- Problema

- problem-solving

- problemi

- processi

- i processi

- lavorazione

- produzione

- Programmazione

- linguaggi di programmazione

- promuoverlo

- istruzioni

- proprio

- fornire

- purché

- fornisce

- fornitura

- pubblicamente

- pubblicato

- fini

- Python

- pytorch

- quadratico

- qualitativo

- qualità

- quantitativo

- Trimestre

- domanda

- domanda

- più veloce

- R

- casuale

- che vanno

- tasso

- rapporto

- a raggiunto

- raggiunge

- motivi

- raccomandazioni

- riduce

- riduzione

- riferimento

- rimanente

- ricorda

- ripetere

- Segnalati

- deposito

- che rappresenta

- necessario

- requisito

- richiede

- riparazioni

- ricercatore

- risposta

- risposte

- colpevole

- Risultati

- ritorno

- problemi

- destra

- robotica

- robusto

- approssimativamente

- round

- RIGA

- reale

- Correre

- running

- s

- sagemaker

- stesso

- campione

- salvato

- scalabile

- Scala

- Scienziato

- Punto

- script

- sdk

- Cerca

- ricerca

- Sezione

- sezioni

- problemi di

- vedere

- selezionato

- prodotti

- inviare

- anziano

- Sequenza

- Serie

- Serie A

- Servizi

- set

- Set

- regolazione

- impostazioni

- scheggiato

- dovrebbero

- mostrare attraverso le sue creazioni

- ha mostrato

- mostrato

- Spettacoli

- chiudendo

- lati

- firma

- significativa

- significativamente

- Un'espansione

- semplicemente

- singolo

- Taglia

- Dimensioni

- rallentare

- piccole

- inferiore

- So

- Società

- soluzione

- Soluzioni

- alcuni

- Fonte

- specialista

- specifico

- in particolare

- velocità

- dividere

- Standard

- inizia a

- Di partenza

- startup

- dichiarazione

- stati

- statistiche

- step

- Passi

- Ancora

- Interrompe

- conservazione

- Tornare al suo account

- Strategico

- Corda

- sforza

- studio

- avere successo

- di successo

- tale

- suite

- supportato

- supporti

- sostenibile

- SISTEMI DI TRATTAMENTO

- tavolo

- prende

- task

- per l'esame

- tecniche

- modello

- condizioni

- test

- Testing

- test

- di

- che

- I

- L'area

- Li

- poi

- Là.

- perciò

- Strumenti Bowman per analizzare le seguenti finiture:

- pensatore

- questo

- completo

- tre

- Attraverso

- tempo

- a

- oggi

- tokenizzazione

- pure

- Totale

- pista

- Treni

- allenato

- Training

- trasformatori

- vero

- Verità

- prova

- seconda

- Digitare

- Tipi di

- Dattiloscritto

- tipicamente

- ui

- per

- unità

- Università

- fino a quando

- Aggiornanento

- aggiornato

- Aggiornamenti

- us

- uso

- utilizzato

- usa

- utilizzando

- un valido

- convalida

- APPREZZIAMO

- Valori

- Variante

- vario

- variando

- veicolo

- versione

- molto

- via

- camminare

- volere

- Prima

- modi

- we

- sito web

- servizi web

- WELL

- quando

- se

- quale

- while

- tutto

- volere

- con

- senza

- lavoratore

- lavoratori

- lavoro

- lavori

- Tu

- Trasferimento da aeroporto a Sharm

- zefiro