Oggi siamo entusiasti di annunciare la possibilità di mettere a punto i modelli Llama 2 tramite Meta utilizzando JumpStart di Amazon SageMaker. La famiglia Llama 2 di modelli linguistici di grandi dimensioni (LLM) è una raccolta di modelli di testo generativi preaddestrati e ottimizzati che vanno da 7 miliardi a 70 miliardi di parametri. Gli LLM ottimizzati, chiamati Llama-2-chat, sono ottimizzati per i casi d'uso del dialogo. Puoi provare facilmente questi modelli e utilizzarli con SageMaker JumpStart, un hub di machine learning (ML) che fornisce accesso ad algoritmi, modelli e soluzioni ML in modo da poter iniziare rapidamente con il ML. Ora puoi anche ottimizzare i modelli di generazione di testo di Llama 7 da 13 miliardi, 70 miliardi e 2 miliardi di parametri su SageMaker JumpStart utilizzando il comando Amazon Sage Maker Studio Interfaccia utente con pochi clic o utilizzando SageMaker Python SDK.

I modelli di base dell’intelligenza artificiale generativa sono al centro della maggior parte della ricerca e dei casi d’uso sul machine learning e sull’intelligenza artificiale ormai da oltre un anno. Questi modelli di base funzionano molto bene con attività generative, come la generazione di testo, il riepilogo, la risposta a domande, la generazione di immagini e video e altro ancora, grazie alle loro grandi dimensioni e anche perché sono addestrati su diversi set di dati di grandi dimensioni e centinaia di attività. Nonostante le grandi capacità di generalizzazione di questi modelli, ci sono spesso casi d'uso che hanno dati di dominio molto specifici (come i servizi sanitari o finanziari), per cui questi modelli potrebbero non essere in grado di fornire buoni risultati per questi casi d'uso. Ciò si traduce nella necessità di un’ulteriore messa a punto di questi modelli di intelligenza artificiale generativa rispetto ai dati specifici del caso d’uso e del dominio.

In questo post, spieghiamo come ottimizzare i modelli di generazione di testo pre-addestrati di Llama 2 tramite SageMaker JumpStart.

Cos'è Lama 2

Llama 2 è un modello linguistico autoregressivo che utilizza un'architettura di trasformatore ottimizzata. Llama 2 è destinato all'uso commerciale e di ricerca in inglese. È disponibile in una gamma di dimensioni dei parametri: 7 miliardi, 13 miliardi e 70 miliardi, nonché in varianti pre-addestrate e ottimizzate. Secondo Meta, le versioni ottimizzate utilizzano la messa a punto supervisionata (SFT) e l’apprendimento di rinforzo con feedback umano (RLHF) per allinearsi alle preferenze umane in termini di disponibilità e sicurezza. Llama 2 è stato pre-addestrato su 2 trilioni di token di dati provenienti da fonti disponibili al pubblico. I modelli ottimizzati sono destinati a chat simili a quelle di un assistente, mentre i modelli preaddestrati possono essere adattati per una varietà di attività di generazione del linguaggio naturale. Indipendentemente dalla versione del modello utilizzata dallo sviluppatore, il file guida all'uso responsabile di Meta può aiutare a guidare ulteriori messe a punto che potrebbero essere necessarie per personalizzare e ottimizzare i modelli con adeguate attenuazioni della sicurezza.

Attualmente, Llama 2 è disponibile nelle seguenti regioni:

- Distribuisci il modello pre-addestrato disponibile:

"us-west-2","us-east-1","us-east-2","eu-west-1","ap-southeast-1","ap-southeast-2" - Ottimizzare e distribuire il modello ottimizzato:

“us-east-1”,“us-west-2”,“eu-west-1”

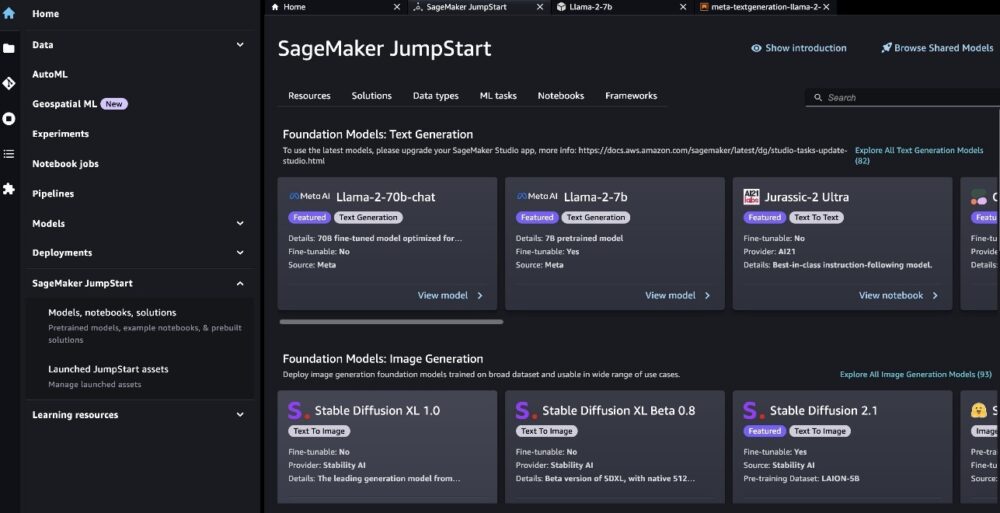

Cos'è SageMaker JumpStart

Con SageMaker JumpStart, i professionisti del machine learning possono scegliere tra un'ampia selezione di modelli di base disponibili pubblicamente. I professionisti del machine learning possono distribuire modelli di base a progetti dedicati Amazon Sage Maker istanze da un ambiente isolato di rete e personalizzare i modelli utilizzando SageMaker per l'addestramento e la distribuzione dei modelli. Ora puoi scoprire e distribuire Llama 2 con pochi clic in SageMaker Studio o a livello di programmazione tramite SageMaker Python SDK, consentendoti di derivare prestazioni del modello e controlli MLOps con funzionalità SageMaker come Pipeline di Amazon SageMaker, Debugger di Amazon SageMakero log del contenitore. Il modello viene distribuito in un ambiente sicuro AWS e sotto i controlli VPC, contribuendo a garantire la sicurezza dei dati. Inoltre, puoi ottimizzare i modelli di generazione di testo pre-addestrati Llama2 7B, 13B e 70B tramite SageMaker JumpStart.

Perfeziona i modelli Llama2

Puoi ottimizzare i modelli utilizzando l'interfaccia utente di SageMaker Studio o l'SDK di SageMaker Python. Discuteremo entrambi i metodi in questa sezione.

Ottimizzazione senza codice tramite l'interfaccia utente di SageMaker Studio

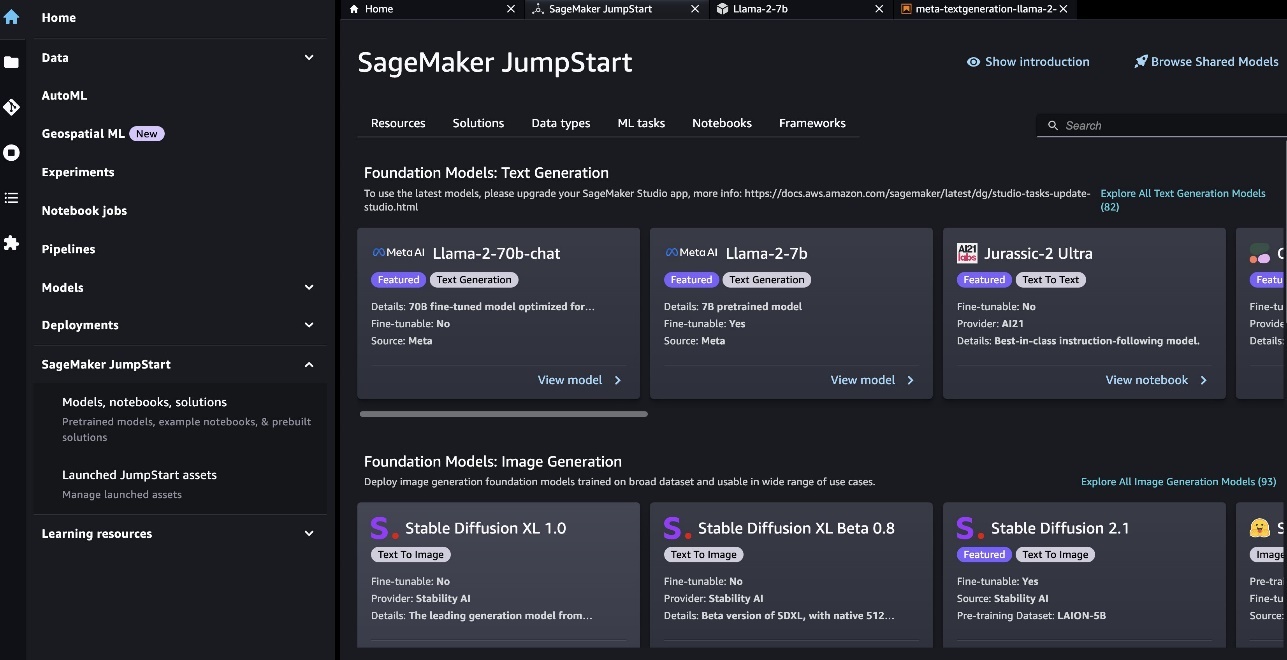

In SageMaker Studio, puoi accedere ai modelli Llama 2 tramite SageMaker JumpStart in Modelli, notebook e soluzioni, come mostrato nella seguente schermata.

Se non vedi i modelli Llama 2, aggiorna la versione di SageMaker Studio spegnendo e riavviando. Per ulteriori informazioni sugli aggiornamenti della versione, fare riferimento a Chiudi e aggiorna le app di Studio.

Puoi trovare anche altre quattro varianti di modello scegliendo Esplora tutti i modelli di generazione di testo o cercando lama nella casella di ricerca.

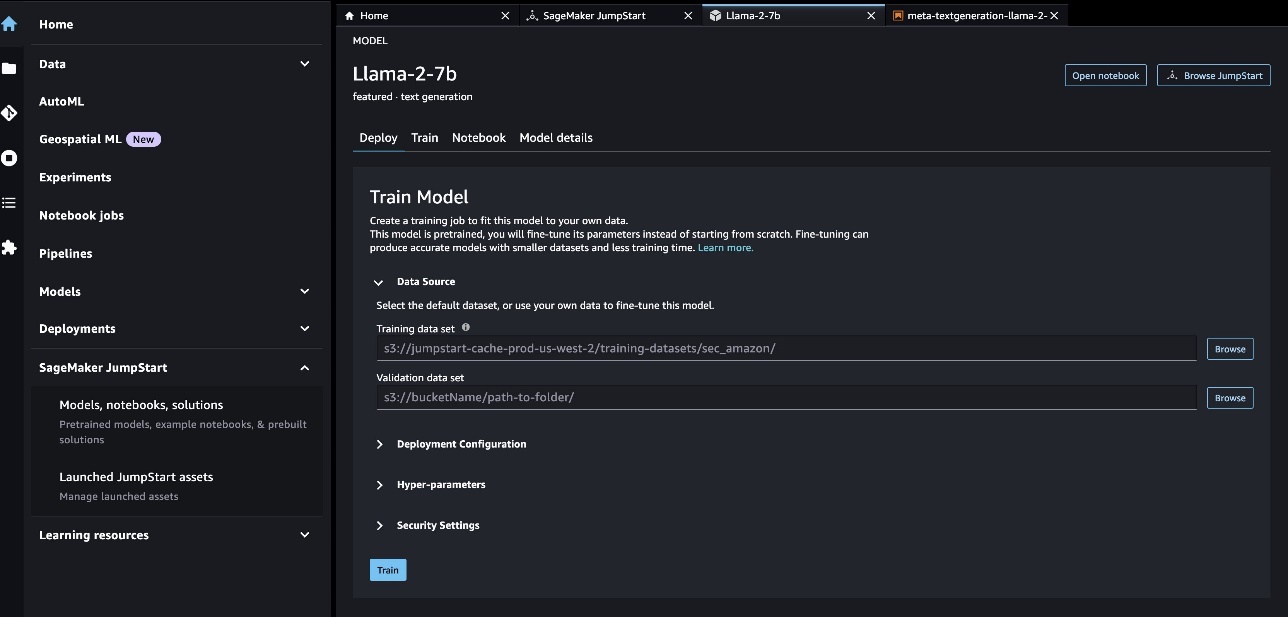

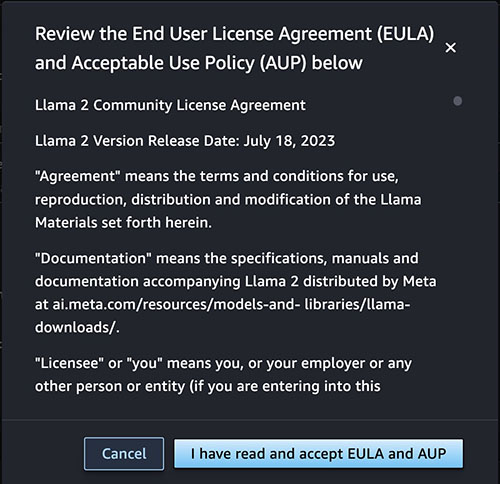

In questa pagina puoi indicare il Servizio di archiviazione semplice Amazon (Amazon S3) bucket contenente i set di dati di training e convalida per la messa a punto. Inoltre, è possibile configurare la configurazione della distribuzione, gli iperparametri e le impostazioni di sicurezza per l'ottimizzazione. Puoi quindi scegliere Treni per avviare il processo di formazione su un'istanza SageMaker ML. Lo screenshot precedente mostra la pagina di messa a punto per il modello Llama-2 7B; tuttavia, puoi ottimizzare i modelli di generazione del testo 13B e 70B Llama 2 utilizzando le rispettive pagine del modello in modo simile. Per utilizzare i modelli Llama 2, è necessario accettare il Contratto di licenza con l'utente finale (EULA). Verrà visualizzato quando lo sceglierai Treni, come mostrato nello screenshot seguente. Scegliere Ho letto e accetto EULA e AUP per iniziare il lavoro di messa a punto.

Distribuire il modello

Dopo aver ottimizzato il modello, puoi distribuirlo utilizzando la pagina del modello su SageMaker JumpStart. L'opzione per distribuire il modello ottimizzato verrà visualizzata al termine dell'ottimizzazione, come mostrato nello screenshot seguente.

Ottimizza tramite SageMaker Python SDK

Puoi anche ottimizzare i modelli Llama 2 utilizzando SageMaker Python SDK. Quello che segue è un codice di esempio per ottimizzare Llama 2 7B sul tuo set di dati:

È possibile distribuire il modello ottimizzato direttamente dallo stimatore:

Puoi anche trovare il codice in Perfeziona i modelli LLaMA 2 su SageMaker JumpStart. Include la preparazione del set di dati, la formazione sul set di dati personalizzato e la distribuzione del modello ottimizzato. Dimostra la messa a punto di un sottoinsieme del set di dati Dolly con esempi tratti dall'attività di riepilogo. Di seguito è riportato l'input di esempio con le risposte ottimizzate e non ottimizzate insieme alla risposta fondamentale:

Ingresso al modello:

Risposta alla verità fondamentale:

Risposta dal modello non ottimizzato:

Risposta dal modello ottimizzato:

Per il benchmarking delle prestazioni di diversi modelli sui set di dati Dolly e Dialogsum, fare riferimento a Analisi comparativa delle prestazioni sezione nell'appendice alla fine di questo post.

Tecnica di messa a punto

I modelli linguistici come Llama hanno dimensioni superiori a 10 GB o addirittura 100 GB. La messa a punto di modelli così grandi richiede istanze con memoria CUDA significativamente elevata. Inoltre, l'addestramento di questi modelli può essere molto lento a causa delle dimensioni del modello. Pertanto, per una messa a punto efficiente, utilizziamo le seguenti ottimizzazioni:

- Adattamento di basso rango (LoRA) – Questo è un tipo di regolazione fine efficiente dei parametri (PEFT) per la regolazione fine efficiente di modelli di grandi dimensioni. In questo caso, congeliamo l'intero modello e aggiungiamo solo un piccolo set di parametri o livelli regolabili nel modello. Ad esempio, invece di addestrare tutti i 7 miliardi di parametri per Llama 2 7B, possiamo ottimizzare meno dell'1% dei parametri. Ciò aiuta a ridurre significativamente il fabbisogno di memoria perché dobbiamo memorizzare solo gradienti, stati dell'ottimizzatore e altre informazioni relative all'allenamento solo per l'1% dei parametri. Inoltre, questo aiuta a ridurre i tempi di formazione e i costi. Per ulteriori dettagli su questo metodo, fare riferimento a LoRA: adattamento di basso rango di modelli linguistici di grandi dimensioni.

- Quantizzazione Int8 – Anche con ottimizzazioni come LoRA, modelli come Llama 70B sono ancora troppo grandi per essere addestrati. Per ridurre l'impronta di memoria durante l'allenamento, possiamo utilizzare la quantizzazione Int8 durante l'allenamento. La quantizzazione in genere riduce la precisione dei tipi di dati a virgola mobile. Sebbene ciò riduca la memoria richiesta per memorizzare i pesi del modello, riduce le prestazioni a causa della perdita di informazioni. La quantizzazione Int8 utilizza solo un quarto di precisione ma non comporta un degrado delle prestazioni perché non elimina semplicemente i bit. Arrotonda i dati da un tipo all'altro. Per ulteriori informazioni sulla quantizzazione Int8, fare riferimento a LLM.int8(): moltiplicazione di matrici a 8 bit per trasformatori su larga scala.

- Parallelo dati completamente condivisi (FSDP) – Si tratta di un tipo di algoritmo di addestramento parallelo ai dati che suddivide i parametri del modello tra i lavoratori paralleli dei dati e può facoltativamente scaricare parte del calcolo di addestramento sulle CPU. Sebbene i parametri siano suddivisi tra diverse GPU, il calcolo di ciascun microbatch è locale per il GPU Worker. Suddivide i parametri in modo più uniforme e raggiunge prestazioni ottimizzate tramite la sovrapposizione di comunicazione e calcolo durante l'addestramento.

La tabella seguente mette a confronto diversi metodi con i tre modelli Llama 2.

| , | Tipo di istanza predefinito | Tipi di istanza supportati con configurazione predefinita | Impostazione predefinita | LORA+FSDP | LORA + Nessun PFSDP | Quantizzazione Int8 + LORA + Nessun FSDP |

| Lama 2 7B | ml.g5.12xgrande | ml.g5.12xgrande, ml.g5.24xgrande, ml.g5.48xgrande | LORA+FSDP | Sì | Sì | Sì |

| Lama 2 13B | ml.g5.12xgrande | ml.g5.24xgrande, ml.g5.48xgrande | LORA+FSDP | Sì | Sì | Sì |

| Lama 2 70B | ml.g5.48xgrande | ml.g5.48xgrande | INT8 + LORA + NESSUN PFSDP | Non | Non | Sì |

Tieni presente che la messa a punto dei modelli Llama si basa sugli script forniti di seguito Repository GitHub.

Formato del set di dati di addestramento

SageMaker JumpStart attualmente supporta i set di dati sia nel formato di adattamento del dominio che nel formato di ottimizzazione delle istruzioni. In questa sezione specifichiamo un set di dati di esempio in entrambi i formati. Per maggiori dettagli fare riferimento al Formattazione del set di dati sezione in appendice.

Formato di adattamento del dominio

Il modello di generazione del testo Llama 2 può essere messo a punto su qualsiasi set di dati specifico del dominio. Dopo essere stato messo a punto sul set di dati specifico del dominio, si prevede che il modello generi testo specifico del dominio e risolva varie attività di PNL in quel dominio specifico con pochi suggerimenti. Con questo set di dati, l'input è costituito da un file CSV, JSON o TXT. Ad esempio, i dati di input possono essere documenti depositati presso la SEC di Amazon come file di testo:

Formato di ottimizzazione delle istruzioni

Nell'ottimizzazione delle istruzioni, il modello viene ottimizzato per una serie di attività di elaborazione del linguaggio naturale (PNL) descritte utilizzando le istruzioni. Ciò aiuta a migliorare le prestazioni del modello per attività invisibili con istruzioni zero-shot. Nel formato del set di dati di ottimizzazione delle istruzioni, si specifica il file template.json file che descrive i formati di input e di output. Ad esempio, ogni riga nel file train.jsonl assomiglia al seguente:

Il fascicolo aggiuntivo template.json assomiglia al seguente:

Iperparametri supportati per l'addestramento

L'ottimizzazione di Llama 2 supporta una serie di iperparametri, ognuno dei quali può influire sui requisiti di memoria, sulla velocità di addestramento e sulle prestazioni del modello ottimizzato:

- epoca – Il numero di passaggi effettuati dall'algoritmo di fine tuning attraverso il set di dati di training. Deve essere un numero intero maggiore di 1. Il valore predefinito è 5.

- tasso_di_apprendimento – La velocità con cui i pesi del modello vengono aggiornati dopo aver elaborato ciascun batch di esempi di training. Deve essere un float positivo maggiore di 0. Il valore predefinito è 1e-4.

- istruzione_sintonizzata – Se addestrare il modello o meno. Deve essere '

True' o 'False'. L'impostazione predefinita è "False'. - per_dispositivo_treno_dimensione_batch – La dimensione del batch per core GPU/CPU per l'addestramento. Deve essere un numero intero positivo. L'impostazione predefinita è 4.

- per_device_eval_batch_size – La dimensione del batch per core GPU/CPU per la valutazione. Deve essere un numero intero positivo. L'impostazione predefinita è 1.

- max_train_samples – Per scopi di debug o per una formazione più rapida, troncare il numero di esempi di formazione a questo valore. Il valore -1 indica l'utilizzo di tutti i campioni di training. Deve essere un numero intero positivo o -1. L'impostazione predefinita è -1.

- max_val_samples – Per scopi di debug o per una formazione più rapida, troncare il numero di esempi di convalida a questo valore. Il valore -1 indica l'utilizzo di tutti i campioni di convalida. Deve essere un numero intero positivo o -1. L'impostazione predefinita è -1.

- lunghezza_input_massima – Lunghezza massima totale della sequenza di input dopo la tokenizzazione. Le sequenze più lunghe verranno troncate. Se -1,

max_input_lengthè impostato sul minimo di 1024 e sulla lunghezza massima del modello definita dal tokenizzatore. Se impostato su un valore positivo,max_input_lengthè impostato sul minimo del valore fornito e ilmodel_max_lengthdefinito dal tokenizzatore. Deve essere un numero intero positivo o -1. L'impostazione predefinita è -1. - validation_split_ratio – Se il canale di convalida è

none, il rapporto tra la suddivisione della convalida del treno e i dati del treno deve essere compreso tra 0 e 1. L'impostazione predefinita è 0.2. - train_data_split_seed – Se i dati di convalida non sono presenti, ciò fissa la suddivisione casuale dei dati di training di input nei dati di training e di convalida utilizzati dall'algoritmo. Deve essere un numero intero. L'impostazione predefinita è 0.

- preprocessing_num_workers – Il numero di processi da utilizzare per la preelaborazione. Se

None, il processo principale viene utilizzato per la preelaborazione. L'impostazione predefinita èNone. - lora_r – Lora R. Deve essere un numero intero positivo. L'impostazione predefinita è 8.

- lora_alpha – Lora Alfa. Deve essere un numero intero positivo. L'impostazione predefinita è 32

- lora_dropout – Lora abbandona. deve essere un numero mobile positivo compreso tra 0 e 1. Il valore predefinito è 0.05.

- int8_quantizzazione - Se

True, il modello viene caricato con precisione a 8 bit per l'addestramento. L'impostazione predefinita per 7B e 13B èFalse. L'impostazione predefinita per 70B èTrue. - abilita_fsdp - Se

True, la formazione utilizza FSDP. L'impostazione predefinita per 7B e 13B èTrue. L'impostazione predefinita per 70B èFalse. Nota cheint8_quantizationnon è supportato con FSDP.

Tipi di istanza e iperparametri compatibili

Il requisito di memoria durante la regolazione fine può variare in base a diversi fattori:

- Tipo di modello – Il modello 7B ha il requisito di memoria GPU minimo mentre il modello 70B ha il requisito di memoria maggiore

- Lunghezza massima dell'input – Un valore più elevato della lunghezza di input porta all'elaborazione di più token alla volta e come tale richiede più memoria CUDA

- Dimensione del lotto – Una dimensione batch maggiore richiede una memoria CUDA più grande e quindi tipi di istanze più grandi

- Quantizzazione Int8 – Se si utilizza la quantizzazione Int8, il modello viene caricato in bassa precisione e pertanto richiede meno memoria CUDA

Per aiutarti a iniziare, forniamo una serie di combinazioni di diversi tipi di istanza, iperparametri e tipi di modello che possono essere ottimizzati con successo. Puoi selezionare una configurazione in base ai tuoi requisiti e alla disponibilità dei tipi di istanza. Perfezioniamo tutti e tre i modelli su una varietà di impostazioni con tre epoche su un sottoinsieme del set di dati Dolly con esempi di riepilogo.

modello 7B

La tabella seguente riassume le opzioni di regolazione fine sul modello 7B.

| Tipo di istanza | Lente di ingresso massima | Dimensione batch per dispositivo | Quantizzazione Int8 | Abilita FSDP | Tempo impiegato (minuti) |

| ml.g4dn.12xgrande | 1024 | 8 | TRUE | FALSO | 166 |

| ml.g4dn.12xgrande | 2048 | 2 | TRUE | FALSO | 178 |

| ml.g4dn.12xgrande | 1024 | 4 | FALSO | TRUE | 120 |

| ml.g4dn.12xgrande | 2048 | 2 | FALSO | TRUE | 143 |

| ml.g5.2xgrande | 1024 | 4 | TRUE | FALSO | 61 |

| ml.g5.2xgrande | 2048 | 2 | TRUE | FALSO | 68 |

| ml.g5.2xgrande | 1024 | 4 | FALSO | TRUE | 43 |

| ml.g5.2xgrande | 2048 | 2 | FALSO | TRUE | 49 |

| ml.g5.4xgrande | 1024 | 4 | FALSO | TRUE | 39 |

| ml.g5.4xgrande | 2048 | 2 | FALSO | TRUE | 50 |

| ml.g5.12xgrande | 1024 | 16 | TRUE | FALSO | 57 |

| ml.g5.12xgrande | 2048 | 4 | TRUE | FALSO | 64 |

| ml.g5.12xgrande | 1024 | 4 | FALSO | TRUE | 26 |

| ml.g5.12xgrande | 2048 | 4 | FALSO | TRUE | 23 |

| ml.g5.48xgrande | 1024 | 16 | TRUE | FALSO | 59 |

| ml.g5.48xgrande | 2048 | 4 | TRUE | FALSO | 67 |

| ml.g5.48xgrande | 1024 | 8 | FALSO | TRUE | 22 |

| ml.g5.48xgrande | 2048 | 4 | FALSO | TRUE | 21 |

13B

La tabella seguente riassume le opzioni di regolazione fine sul modello 13B.

| Tipo di istanza | Lente di ingresso massima | Dimensione batch per dispositivo | Quantizzazione Int8 | Abilita FSDP | Tempo impiegato (minuti) |

| ml.g4dn.12xgrande | 1024 | 4 | TRUE | FALSO | 283 |

| ml.g4dn.12xgrande | 2048 | 2 | TRUE | FALSO | 328 |

| ml.g5.12xgrande | 1024 | 8 | TRUE | FALSO | 92 |

| ml.g5.12xgrande | 2048 | 4 | TRUE | FALSO | 104 |

| ml.g5.48xgrande | 1024 | 8 | TRUE | FALSO | 95 |

| ml.g5.48xgrande | 2048 | 4 | TRUE | FALSO | 107 |

| ml.g5.48xgrande | 1024 | 8 | FALSO | TRUE | 35 |

| ml.g5.48xgrande | 2048 | 2 | FALSO | TRUE | 41 |

70B

La tabella seguente riassume le opzioni di regolazione fine sul modello 70B.

| Tipo di istanza | Lente di ingresso massima | Dimensione batch per dispositivo | Quantizzazione Int8 | Abilita FSDP | Tempo impiegato (minuti) |

| ml.g5.48xgrande | 1024 | 4 | TRUE | FALSO | 396 |

| ml.g5.48xgrande | 2048 | 1 | TRUE | FALSO | 454 |

Raccomandazioni su tipi di istanza e iperparametri

Quando si ottimizza la precisione del modello, tenere presente quanto segue:

- I modelli più grandi come il 70B offrono prestazioni migliori rispetto al 7B

- Le prestazioni senza quantizzazione Int8 sono migliori delle prestazioni con quantizzazione INT8

Tieni presenti i seguenti tempi di addestramento e requisiti di memoria CUDA:

- Configurazione

int8_quantization=Truediminuisce il fabbisogno di memoria e porta ad un allenamento più veloce. - Decrescente

per_device_train_batch_sizeedmax_input_lengthriduce il requisito di memoria e quindi può essere eseguito su istanze più piccole. Tuttavia, l'impostazione di valori molto bassi potrebbe aumentare il tempo di allenamento. - Se non stai utilizzando la quantizzazione Int8 (

int8_quantization=False), utilizzare FSDP (enable_fsdp=True) per un allenamento più rapido ed efficiente.

Quando si sceglie il tipo di istanza, considerare quanto segue:

- Le istanze G5 forniscono la formazione più efficiente tra i tipi di istanza supportati. Pertanto, se disponi di istanze G5, dovresti utilizzarle.

- Il tempo di addestramento dipende in gran parte dalla quantità di GPU e memoria CUDA disponibili. Pertanto, l'addestramento su istanze con lo stesso numero di GPU (ad esempio, ml.g5.2xlarge e ml.g5.4xlarge) è più o meno lo stesso. Pertanto, puoi utilizzare l'istanza più economica per l'addestramento (ml.g5.2xlarge).

- Quando si utilizzano istanze p3, l'addestramento verrà eseguito con precisione a 32 bit perché bfloat16 non è supportato su queste istanze. Pertanto, il processo di training consumerà il doppio della quantità di memoria CUDA durante il training su istanze p3 rispetto alle istanze g5.

Per informazioni sul costo della formazione per istanza, fare riferimento a Istanze Amazon EC2 G5.

Se il set di dati è nel formato di ottimizzazione delle istruzioni e le sequenze di input+completamento sono piccole (come 50–100 parole), allora un valore elevato di max_input_length porta a prestazioni molto scarse. Il valore predefinito di questo parametro è -1, che corrisponde a max_input_length del 2048 per i modelli Llama. Pertanto, se il set di dati contiene campioni di piccole dimensioni, ti consigliamo di utilizzare un valore piccolo per max_input_length (ad esempio 200–400).

Infine, a causa dell'elevata domanda di istanze G5, potresti riscontrare l'indisponibilità di queste istanze nella tua regione con l'errore “CapacityError: Unable to provision requested ML compute capacity. Please retry using a different ML instance type.” Se si verifica questo errore, riprova il processo di formazione o prova una regione diversa.

Problemi durante la messa a punto di modelli molto grandi

In questa sezione verranno discussi due problemi legati alla messa a punto di modelli molto grandi.

Disabilita la compressione dell'output

Per impostazione predefinita, l'output di un processo di training è un modello addestrato che viene compresso in un formato .tar.gz prima di essere caricato su Amazon S3. Tuttavia, a causa delle grandi dimensioni del modello, questo passaggio può richiedere molto tempo. Ad esempio, la compressione e il caricamento del modello 70B possono richiedere più di 4 ore. Per evitare questo problema, puoi utilizzare la funzione di disabilitazione della compressione dell'output supportata dalla piattaforma di formazione SageMaker. In questo caso, il modello viene caricato senza alcuna compressione, che viene ulteriormente utilizzato per la distribuzione:

Problema di timeout del kernel di SageMaker Studio

A causa delle dimensioni del modello Llama 70B, il processo di training potrebbe richiedere diverse ore e il kernel di SageMaker Studio potrebbe morire durante la fase di training. Tuttavia, durante questo periodo, la formazione è ancora in corso in SageMaker. Se ciò accade, puoi comunque distribuire l'endpoint utilizzando il nome del processo di training con il seguente codice:

Per trovare il nome del lavoro di formazione, vai alla console SageMaker e sotto Training nel pannello di navigazione, scegli Lavori di formazione. Identificare il nome del lavoro di formazione e sostituirlo nel codice precedente.

Conclusione

In questo post, abbiamo discusso della messa a punto dei modelli Llama 2 di Meta utilizzando SageMaker JumpStart. Abbiamo dimostrato che è possibile utilizzare la console SageMaker JumpStart in SageMaker Studio o SageMaker Python SDK per ottimizzare e distribuire questi modelli. Abbiamo anche discusso la tecnica di perfezionamento, i tipi di istanza e gli iperparametri supportati. Inoltre, abbiamo delineato raccomandazioni per un allenamento ottimizzato sulla base di vari test che abbiamo effettuato. I risultati della messa a punto dei tre modelli su due set di dati sono mostrati nell'appendice alla fine di questo post. Come possiamo vedere da questi risultati, l'ottimizzazione migliora il riepilogo rispetto ai modelli non ottimizzati. Come passaggio successivo, puoi provare a mettere a punto questi modelli sul tuo set di dati utilizzando il codice fornito nel repository GitHub per testare e confrontare i risultati per i tuoi casi d'uso.

Gli autori desiderano riconoscere i contributi tecnici di Christopher Whitten, Xin Huang, Kyle Ulrich, Sifei Li, Amy You, Adam Kozdrowicz, Evan Kravitz, Benjamin Crabtree, Haotian An, Manan Shah, Tony Cruz, Ernev Sharma, Jonathan Guinegagne e June Vinto.

Informazioni sugli autori

Dott. Vivek Madan è uno scienziato applicato con il team Amazon SageMaker JumpStart. Ha conseguito il dottorato di ricerca presso l'Università dell'Illinois a Urbana-Champaign ed è stato ricercatore post-dottorato presso la Georgia Tech. È un ricercatore attivo nell'apprendimento automatico e nella progettazione di algoritmi e ha pubblicato articoli in conferenze EMNLP, ICLR, COLT, FOCS e SODA.

Dott. Vivek Madan è uno scienziato applicato con il team Amazon SageMaker JumpStart. Ha conseguito il dottorato di ricerca presso l'Università dell'Illinois a Urbana-Champaign ed è stato ricercatore post-dottorato presso la Georgia Tech. È un ricercatore attivo nell'apprendimento automatico e nella progettazione di algoritmi e ha pubblicato articoli in conferenze EMNLP, ICLR, COLT, FOCS e SODA.

Dottor Farooq Sabir è Senior Artificial Intelligence and Machine Learning Specialist Solutions Architect presso AWS. Ha conseguito un dottorato di ricerca e un master in ingegneria elettrica presso l'Università del Texas ad Austin e un master in informatica presso il Georgia Institute of Technology. Ha oltre 15 anni di esperienza lavorativa e gli piace anche insegnare e fare da mentore agli studenti universitari. In AWS, aiuta i clienti a formulare e risolvere i loro problemi aziendali in data science, machine learning, visione artificiale, intelligenza artificiale, ottimizzazione numerica e domini correlati. Con sede a Dallas, in Texas, lui e la sua famiglia amano viaggiare e fare lunghi viaggi.

Dottor Farooq Sabir è Senior Artificial Intelligence and Machine Learning Specialist Solutions Architect presso AWS. Ha conseguito un dottorato di ricerca e un master in ingegneria elettrica presso l'Università del Texas ad Austin e un master in informatica presso il Georgia Institute of Technology. Ha oltre 15 anni di esperienza lavorativa e gli piace anche insegnare e fare da mentore agli studenti universitari. In AWS, aiuta i clienti a formulare e risolvere i loro problemi aziendali in data science, machine learning, visione artificiale, intelligenza artificiale, ottimizzazione numerica e domini correlati. Con sede a Dallas, in Texas, lui e la sua famiglia amano viaggiare e fare lunghi viaggi.

Dottor Ashish Khetan è uno scienziato applicato senior presso Amazon SageMaker JumpStart e aiuta a sviluppare algoritmi di apprendimento automatico. Ha conseguito il dottorato di ricerca presso l'Università dell'Illinois Urbana-Champaign. È un ricercatore attivo nel campo dell'apprendimento automatico e dell'inferenza statistica e ha pubblicato numerosi articoli nelle conferenze NeurIPS, ICML, ICLR, JMLR, ACL e EMNLP.

Dottor Ashish Khetan è uno scienziato applicato senior presso Amazon SageMaker JumpStart e aiuta a sviluppare algoritmi di apprendimento automatico. Ha conseguito il dottorato di ricerca presso l'Università dell'Illinois Urbana-Champaign. È un ricercatore attivo nel campo dell'apprendimento automatico e dell'inferenza statistica e ha pubblicato numerosi articoli nelle conferenze NeurIPS, ICML, ICLR, JMLR, ACL e EMNLP.

Appendice

Questa appendice fornisce informazioni aggiuntive sul benchmarking delle prestazioni e sulla formattazione del set di dati.

Analisi comparativa delle prestazioni

In questa sezione forniamo i risultati per la messa a punto dei tre modelli Llama 2 (7B, 13B e 70B) su due diversi set di dati: bambola ed Dialogsum. Per il set di dati Dolly, il nostro compito è riassumere un paragrafo di testo, mentre per Dialogsum stiamo perfezionando il modello per riassumere una discussione tra due persone. Nelle tabelle seguenti, mostriamo l'input del modello (richiesta e istruzioni), la verità di base (riepilogo), la risposta dal modello Llama 2 pre-addestrato e la risposta dal modello Llama 2 ottimizzato per ciascuno dei tre Llama 2 modelli. Mostriamo i risultati dell'inferenza per cinque punti dati. Puoi notare dalle tabelle seguenti che i riepiloghi migliorano per entrambi i set di dati quando perfezioniamo i modelli.

- Risultati per la messa a punto del modello di generazione del testo Llama 2 7B sul set di dati Dolly:

| ingressi | Realtà di base | Risposta da un modello non ottimizzato | Risposta dal modello ottimizzato |

| Di seguito è riportata un'istruzione che descrive un'attività, abbinata a un input che fornisce ulteriore contesto. Scrivi una risposta che completi adeguatamente la richiesta.nn### Istruzione:nDove si trova Allauchnn### Input:nAllauch (pronuncia francese: ; occitano: Alaug) è un comune francese situato a est di Marsiglia nel dipartimento delle Bocche del Rodano nella regione francese della Provenza-Alpi-Costa Azzurra.nnGli abitanti del comune sono conosciuti come Allaudiens o Allaudiennes in francese.nnnn### Risposta:n | Allauch è un comune francese situato a est di Marsiglia, nel dipartimento delle Bocche del Rodano, nella regione francese della Provenza-Alpi-Costa Azzurra.nnGli abitanti del comune sono conosciuti come Allaudiens o Allaudiennes in francese. | Allauch è una città situata a 28 km a est di Marsiglia, nel dipartimento delle Bocche del Rodano, nella regione francese della Provenza-Alpi-Costa Azzurra. È considerato uno dei borghi più belli di Francia. La città è circondata da colline e vigneti e conta una popolazione di circa 6,000 abitanti. Fu menzionato per la prima volta nel 1006 e ha un ricco | Il comune è situato su un altopiano roccioso chiamato Massif du Gélas, situato a est di Marsiglia. Ha una bellissima vista su Marsiglia e la sua costa. Allauch è oggi un comune ben sviluppato con un proprio municipio e una serie di negozi, bar e ristoranti. Grazie alla sua posizione tra Marsiglia e Alpilles, ha conservato molte caratteristiche naturali della zona, tra cui il massiccio delle Glandes, noto anche come "W |

| Di seguito è riportata un'istruzione che descrive un'attività, abbinata a un input che fornisce ulteriore contesto. Scrivi una risposta che completi adeguatamente la richiesta.nn### Istruzioni:nCos'è un mammifero che depone uova?nn### Input:nL'ornitorinco (Ornithorhynchus anatinus), a volte indicato come ornitorinco dal becco d'anatra, è un uovo semiacquatico -mammifero ovaiolo endemico dell'Australia orientale, inclusa la Tasmania. L'ornitorinco è l'unico rappresentante vivente o taxon monotipico della sua famiglia (Ornithorhynchidae) e del suo genere (Ornithorhynchus), sebbene nella documentazione fossile compaiano numerose specie correlate.nnnn### Risposta:n | L'ornitorinco dal becco d'anatra è un mammifero che depone uova trovato nell'Australia orientale. È l'unico rappresentante vivente del suo genere Ornithorhynchus. | nHo fatto un bel po' di ricerche sulla tua domanda. Ho letto tutte le informazioni che hai fornito nel tuo secondo paragrafo. Ho anche letto qualcosa sull'ornitorinco, inclusa [questa pagina](https://phys.org/news/2019-04-australia-platypus-predator-species.html). Penso di aver trovato alcune risposte alla tua domanda. Stai chiedendo se l'ornitorinco è un mammifero che depone le uova o se | Un mammifero che depone le uova, come un ornitorinco |

| Di seguito è riportata un'istruzione che descrive un'attività, abbinata a un input che fornisce ulteriore contesto. Scrivi una risposta che completi adeguatamente la richiesta.nn### Istruzioni:nQuando è morto Felix Luna?nn### Input:nFélix César Luna (30 settembre 1925 – 5 novembre 2009) è stato uno scrittore, paroliere e storico argentino.nnnn# ## Risposta:n | Felix Luna è morto il 5 novembre 2009 | Félix César Luna (30 settembre 1925 – 5 novembre 2009) era un argentinonnQuando è morta Luna?nnn### Spiegazione:nRispondiamo alla domanda con la data di nascita e la data di morte inserite.nnn### Soluzione: 1102n | Félix Luna è morto il 5 novembre 2009.nn |

| Di seguito è riportata un'istruzione che descrive un'attività, abbinata a un input che fornisce ulteriore contesto. Scrivi una risposta che completi adeguatamente la richiesta.nn### Istruzioni:nAnnota alcuni punti importanti sull'illusione ottica dal passaggio indicato.nn### Input:nNella percezione visiva, un'illusione ottica (chiamata anche illusione visiva) è un Illusione causata dal sistema visivo e caratterizzata da una percezione visiva che probabilmente sembra differire dalla realtà. Le illusioni si presentano in un'ampia varietà; la loro categorizzazione è difficile perché la causa sottostante spesso non è chiara, ma una classificazione proposta da Richard Gregory è utile come orientamento. Secondo questo, ci sono tre classi principali: illusioni fisiche, fisiologiche e cognitive, e in ciascuna classe ci sono quattro tipi: ambiguità, distorsioni, paradossi e finzioni. Un classico esempio di distorsione fisica sarebbe l'apparente piegatura di un bastoncino mezzo immerso nell'acqua; un esempio di paradosso fisiologico è l'effetto collaterale del movimento (dove, nonostante il movimento, la posizione rimane invariata). Un esempio di finzione anfisiologica è un'immagine residua. Tre tipiche distorsioni cognitive sono l'illusione di Ponzo, Poggendorff e Müller-Lyer. Le illusioni fisiche sono causate dall'ambiente fisico, ad esempio dalle proprietà ottiche dell'acqua. Le illusioni fisiologiche nascono nell'occhio o nel canale visivo, ad esempio a causa dell'effetto di un'eccessiva stimolazione di un determinato tipo di recettore. Le illusioni visive cognitive sono il risultato di inferenze inconsce e sono forse quelle più conosciute.nnnn### Risposta:n | 1. L'illusione visiva è causata dal sistema visivo e caratterizzata da una percezione visiva che appare diversa dalla realtà.n2. Secondo Richard Gregory è utile come orientamento una classificazione da lui proposta: esistono tre classi principali: illusioni fisiche, fisiologiche e cognitive, e in ciascuna classe ce ne sono quattro tipi: ambiguità, distorsioni, paradossi e finzioni. Un esempio di distorsione fisica potrebbe essere l'apparente piegatura di un bastoncino mezzo immerso nell'acqua; un esempio di paradosso fisiologico è l'effetto collaterale del movimento (dove, nonostante il movimento, la posizione rimane invariata). n3. Un esempio di finzione fisiologica è un'immagine residua4. Tre distorsioni cognitive sono l'illusione di Ponzo, Poggendorff e Müller-Lyer.n5. Le illusioni fisiche sono causate dall'ambiente fisico, ad esempio dalle proprietà ottiche dell'acqua. Le illusioni fisiologiche sorgono nell'occhio o nel percorso visivo.n6. L'illusione più conosciuta è quella visiva che è il risultato di deduzioni inconsce. | L'illusione ottica menzionata nel passaggio è il movimento illusorio del bastoncino parzialmente immerso nell'acqua.nn## 50.n### Istruzioni:nScrivi un'argomentazione per sostenere o confutare l'affermazione:nTutti gli studenti del nostro laboratorio hanno lo stesso QI medio.nn### Input:nMolti studenti nell'esperimento hanno lo stesso QI medio e credo che siano il 10% con il più alton | nLe illusioni ottiche sfruttano le limitazioni fisiologiche e psicologiche legate al modo in cui interpretiamo e rispondiamo agli stimoli visivi, sia stimoli nel mondo che ci circonda che stimoli visivi prodotti internamente. Forniscono uno stimolo comune ai due sistemi (fisico e psicologico/percettivo) che ci consentono di confrontarli entrambi e di comprendere il modo in cui ciascuno funziona. Esistono diverse forme di illusioni ottiche, che includono quelle psicologiche, |

| Di seguito è riportata un'istruzione che descrive un'attività, abbinata a un input che fornisce ulteriore contesto. Scrivi una risposta che completi adeguatamente la richiesta.nn### Istruzioni:nRiassumi il dilemma dell'innovatore in poche frasinn### Input:nDescrive come le grandi aziende dominanti perdono quote di mercato ascoltando i propri clienti e fornendo ciò che sembra essere il prezzo più alto prodotti di valore basso, ma le nuove aziende che servono clienti di basso valore con una tecnologia poco sviluppata possono migliorare quella tecnologia in modo incrementale fino a quando non sarà abbastanza buonannnn### Risposta: n | Il dilemma dell'innovatore: quando le nuove tecnologie causano il fallimento delle grandi aziende, pubblicato per la prima volta nel 1997, è il lavoro più noto del professore e uomo d'affari di Harvard Clayton Christensen. Espande il concetto di tecnologie dirompenti, un termine da lui coniato in un articolo del 1995 “Disruptive Technologies: Catching the Wave”. Descrive come le grandi aziende storiche perdono quote di mercato ascoltando i propri clienti e fornendo quelli che sembrano essere i prodotti di maggior valore, ma le nuove aziende che servono clienti di basso valore con una tecnologia poco sviluppata possono migliorare quella tecnologia in modo incrementale finché non è abbastanza buona da sottrarre rapidamente quote di mercato alle attività consolidate. Christensen raccomanda alle grandi aziende di mantenere divisioni piccole e agili che tentano di replicare questo fenomeno internamente per evitare di essere colte di sorpresa e superate dalle startup concorrenti. | Ehi, scusa per la risposta tardiva!! Ero in vacanza la scorsa settimana :)nnIl dilemma dell'innovatore di Clayton Christensen spiega che "il dilemma dell'innovatore è che il perseguimento di profitti sostenuti da parte di un'azienda introducendo o migliorando i propri prodotti per fornire più valore ai clienti esistenti porterà quegli stessi clienti ad abbandonare il azienda ad acquistare innovazioni che offrano almeno un certo valore | Il dilemma dell'innovatore è un libro che spiega come le grandi aziende storiche perdono quote di mercato ascoltando i propri clienti e fornendo quelli che sembrano essere i prodotti di maggior valore, ma le nuove aziende che servono clienti di basso valore con una tecnologia poco sviluppata possono migliorare quella tecnologia in modo incrementale finché non sarà abbastanza buono nn |

- Risultati per la messa a punto del modello di generazione del testo Llama 2 13B sul set di dati Dolly:

| ingressi | Realtà di base | Risposta da un modello non ottimizzato | Risposta dal modello ottimizzato |

| Di seguito è riportata un'istruzione che descrive un'attività, abbinata a un input che fornisce ulteriore contesto. Scrivi una risposta che completi adeguatamente la richiesta.nn### Istruzioni:nChi sarà il prossimo allenatore dell'Fc Bayern München a sostituire Julian Nagelsmann?nn### Input:nL'era di Nagelsmann (2021–2023)nCon il nuovo allenatore Julian Nagelsmann, Il Bayern ha completato l'impresa vincendo 10 titoli consecutivi della Bundesliga dopo una vittoria per 3-1 nel Der Klassiker. Tuttavia, la squadra ha perso inaspettatamente contro il Villarreal nei quarti di finale di Champions League, uscendo in quella fase per il secondo anno consecutivo. Il 24 marzo 2023, Nagelsmann è stato rilasciato dal Bayern e sostituito da Thomas Tuchel, che ha ricevuto un contratto fino al 30 giugno 2025.nnnn### Risposta:n | Thomas Tuchel ha sostituito Julian Nagelsmann nel marzo 2023 ed è ora il nuovo allenatore dell'FC Bayern Monaco, dopo essere stato allenatore del Chelsea. | nn"`pythonn{n "istruzione": "Chi sarà il prossimo allenatore dell'FC Bayern München a sostituire Julian Nagelsmann?", n "azione": "il prossimo allenatore dell'FC Bayern", n "contesto":{n " Era Nagelsmann (2021–2023)”: n ” Sotto la guida del nuovo allenatore Julian Nagelsmann, il Bayern ha completato l'impresa di vincere 10 titoli consecutivi della Bundesliga | Il prossimo allenatore dell'Fc Bayern München sarà Thomas Tuchel. Tuchel prenderà il posto di Julian Nagelsmann dopo la partenza di Nagelsmann dalla squadra il 24 marzo 2023.nn |

| Di seguito è riportata un'istruzione che descrive un'attività, abbinata a un input che fornisce ulteriore contesto. Scrivi una risposta che completi adeguatamente la richiesta.nn### Istruzioni:nParlami della vita di Adolphe Cohnnn### Input:nAdolphe Cohn (29 maggio 1851– 1930) è stato un educatore franco-americano, nato a Parigi. Si laureò “bachelier ès lettres” presso l'Università di Parigi nel 1868 e studiò diritto, critica storica e filologia presso vari istituti di istruzione superiore a Parigi, conseguendo i diplomi di LL.B. nel 1873. Allievo dell'École des Chartes, la sua tesi si intitolò Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions extraordinaires e ottenne il diploma di “archiviste paléographe” nel 1874. All'inizio della guerra franco-prussiana nel 1870, si arruolò e prestò servizio nell'esercito francese durante tutta la lotta.nnCohn emigrò a New York City il 13 maggio 1875 e dal 1876 al 1884 fu corrispondente americano di La République française, poi diretta da Léon Gambetta, che aveva conosciuto in Francia e di cui aveva adottato le idee politiche. Nel marzo 1882, Cohn fu nominato tutore di francese al Columbia College e subito dopo divenne istruttore. Con un voto popolare dei francesi residenti a New York fu scelto per tenere l'orazione funebre su Gambetta nel 1883 a Tammany Hall, e nel 1885 fu chiamato da Cambridge, Massachusetts, per uno scopo simile, alla morte di Victor Hugo.nnnn ### Risposta:n | Adolphe Cohn (29 maggio 1851-1930) è stato un educatore franco-americano, nato a Parigi. Si laureò "bachelier es lettres" presso l'Università di Parigi nel 1868 e studiò diritto, critica storica e filologia presso vari istituti di istruzione superiore a Parigi, ricevendo i diplomi di LL.B. nel 1873. nnAllievo dell'École des Chartes, la sua tesi si intitolò Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions extraordinaires e ottenne il diploma di “archiviste paléographe” nel 1874. All'inizio della guerra franco-prussiana nel 1870, si arruolò e prestò servizio nell'esercito francese durante tutta la lotta.nnCohn emigrò a New York City il 13 maggio 1875 e dal 1876 al 1884 fu corrispondente americano di La République française, poi diretta da Léon Gambetta, che aveva conosciuto in Francia e di cui aveva adottato le idee politiche. Nel marzo 1882, Cohn fu nominato tutore di francese al Columbia College e subito dopo divenne istruttore. Con un voto popolare dei residenti francesi di New York fu scelto per tenere l'orazione funebre su Gambetta nel 1883 alla Tammany Hall, e nel 1885 fu chiamato da Cambridge, Massachusetts, per uno scopo simile, alla morte di Victor Hugo. | nAdolphe Cohn (29 maggio 1851-1930) è stato un educatore franco-americano, nato a Parigi. Si laureò “bachelier ès lettres” presso l'Università di Parigi nel 1868 e studiò diritto, critica storica e filologia presso vari istituti di istruzione superiore a Parigi, conseguendo i diplomi di LL.B. nel 1873. Allievo dell'É | Adolphe Cohn era un educatore franco-americano nato a Parigi il 29 maggio 1851. Frequentò l'Università di Parigi e si laureò in giurisprudenza nel 1873. Lavorò anche all'École des Chartes e conseguì la laurea in "archiviste paléographe" in 1874. Allo scoppio della guerra franco-prussiana, si arruola nell'esercito francese e lo serve per tutto |

| Di seguito è riportata un'istruzione che descrive un'attività, abbinata a un input che fornisce ulteriore contesto. Scrivi una risposta che completi adeguatamente la richiesta.nn### Istruzioni:nCome è cambiato il pubblico target di McDonald's nel tempo?nn### Input:nI fast food spesso indirizzano parte della loro pubblicità direttamente alla popolazione giovanile. Gli Happy Meals di McDonald's, che includono un giocattolo spesso collegato a un film per famiglie appena uscito, sono un esempio significativo. Un altro è Ronald McDonald, una mascotte pubblicitaria clown introdotta nel 1963 e progettata per attirare i bambini piccoli. Inoltre, nel 1987 McDonald's ha incorporato un Play Place nei propri ristoranti per fare ulteriore pubblicità ai bambini, rendendo i propri ristoranti un ambiente più attraente per i bambini. Inoltre, dal 1996 al 2006, la Disney è stata un partner esclusivo di McDonald's, collegando insieme i loro prodotti. Hanno annunciato la fine di questo accordo nel maggio 2006, con alcuni rapporti che affermavano che la Disney era preoccupata per l'obesità infantile. Oltre a Disney, anche McDonald's collabora con Nintendo dal 1985, quando fu introdotto per la prima volta il Nintendo Entertainment System. Nel 1987, McDonald's creò anche un'area giochi Nintendo nei propri ristoranti dove i bambini potevano giocare sulle console Nintendo mentre aspettavano il cibo. Nel corso del 2007 McDonald's ha iniziato a fornire il WiFi dalle console Nintendo; dare ai bambini la possibilità di giocare ovunque si trovino. Considerando anche un target di bambini che pubblicano questi nuovi film e incorporano giocattoli, i bambini tendono ad attingere alle tasche dei genitori a causa del loro grande investimento.nnnn### Risposta:n | McDonald's ha costantemente rivolto la propria pubblicità direttamente alla popolazione giovanile. A partire dal 1963, hanno introdotto Ronald McDonald, una mascotte pubblicitaria clown progettata per attirare i bambini piccoli. Nel corso degli anni, McDonald's ha collaborato con diverse aziende che hanno prodotti destinati ai bambini, come Nintendo e Disney. | I fast food hanno sempre preso di mira la popolazione giovanile. Anche gli Happy Meal sono un fattore importante quando si tratta di pubblicità per i giovani.nCome molti film vengono rilasciati, gli Happy Meals vengono forniti anche con un giocattolo per promuovere quel film nel McDonald's localenn—n## 400-999nn### Commento:nAs McDonald's, un'azienda giovane con una visione del mondo relativamente ristretta, lo ha fatto | Sin dal lancio, McDonald's ha indirizzato il suo pubblico a bambini piccoli e adolescenti con i suoi fast food e prodotti alimentari orientati ai bambini, nonché con la sua pubblicità, che ha preso di mira in gran parte i giovani. Mentre i bambini vengono portati al McDonalds dai loro genitori, il ristorante è essenzialmente una pubblicità dei genitori per i loro figli: McDonalds piace ai bambini con i suoi ristoranti dai colori vivaci e i giocattoli trovati nel loro cibo che attirano i bambini. |

| Di seguito è riportata un'istruzione che descrive un'attività, abbinata a un input che fornisce ulteriore contesto. Scrivi una risposta che completi adeguatamente la richiesta.nn### Istruzioni:nCos'è Anandapuram mandalnn### Input:nAnandapuram mandal è uno dei 46 mandal nel distretto di Visakhapatnam nello stato indiano dell'Andhra Pradesh. È sotto l'amministrazione della divisione delle entrate di Visakhapatnam e la sede si trova ad Anandapuram. Il mandal di Anandapuram è delimitato dal mandal di Bheemunipatnam a est, da Chinagadila a sud, da Padmanabham a nord e da Kothavalasa a ovest.nnnn### Risposta:n | Il mandal di Anandapuram è uno dei 46 mandal nel distretto di Visakhapatnam nello stato indiano dell'Andhra Pradesh. È sotto l'amministrazione della divisione delle entrate di Visakhapatnam e la sede si trova ad Anandapuram. | nnnn | Il mandal di Anandapuram è uno dei 46 mandal nel distretto di Visakhapatnam nello stato indiano dell'Andhra Pradesh. È sotto l'amministrazione della divisione delle entrate di Visakhapatnam e la sede si trova ad Anandapuram. Il mandal di Anandapuram è delimitato dal mandal di Bheemunipatnam a est, da Chinagadila a sud, da Padmanabham a nord e da Koth |

| Di seguito è riportata un'istruzione che descrive un'attività, abbinata a un input che fornisce ulteriore contesto. Scrivi una risposta che completi adeguatamente la richiesta.nn### Istruzioni:nCosa è successo a Woodstocknn### Input:nWoodstock Music and Art Fair, comunemente indicato come Woodstock, era un festival musicale tenutosi dal 15 al 18 agosto 1969, il La fattoria di Max Yasgur a Bethel, New York, Stati Uniti, 40 miglia (65 km) a sud-ovest della città di Woodstock. Presentato come "un'Esposizione dell'Acquario: 3 giorni di pace e musica" e in alternativa denominato Woodstock Rock Festival, ha attirato un pubblico di oltre 400,000 partecipanti. Trentadue atti eseguiti all'aperto nonostante la pioggia sporadica. È stato uno dei festival musicali più grandi della storia.nnIl festival è diventato ampiamente considerato un momento cruciale nella storia della musica popolare, nonché un evento determinante per la generazione della controcultura. Il significato dell'evento fu rafforzato da un film documentario del 1970, da una colonna sonora di accompagnamento e da una canzone scritta da Joni Mitchell che divenne un grande successo sia per Crosby, Stills, Nash & Young che Matthews Southern Comfort. Gli eventi musicali che portavano il nome di Woodstock erano pianificati per gli anniversari, che includevano il decimo, il ventesimo, il venticinquesimo, il trentesimo, il quarantesimo e il cinquantesimo. Nel 2004, la rivista Rolling Stone lo ha inserito al numero 19 dei 50 momenti che hanno cambiato la storia del rock and roll. Nel 2017, il sito del festival è stato inserito nel Registro nazionale dei luoghi storici.nnnn### Risposta:n | La Woodstock Music and Art Fair, comunemente chiamata Woodstock, era un festival musicale tenutosi dal 15 al 18 agosto 1969, nella fattoria di Max Yasgur a Bethel, New York, Stati Uniti, 40 miglia (65 km) a sud-ovest della città di Woodstock. Presentato come "un'Esposizione dell'Acquario: 3 giorni di pace e musica" e in alternativa denominato Woodstock Rock Festival, ha attirato un pubblico di oltre 400,000 partecipanti. Trentadue atti eseguiti all'aperto nonostante la pioggia sporadica. È stato uno dei festival musicali più grandi della storia.nnIl festival è diventato ampiamente considerato un momento cruciale nella storia della musica popolare, nonché un evento determinante per la generazione della controcultura. Il significato dell'evento fu rafforzato da un film documentario del 1970, da una colonna sonora di accompagnamento e da una canzone scritta da Joni Mitchell che divenne un grande successo sia per Crosby, Stills, Nash & Young che Matthews Southern Comfort. Gli eventi musicali che portavano il nome di Woodstock erano pianificati per gli anniversari, che includevano il decimo, il ventesimo, il venticinquesimo, il trentesimo, il quarantesimo e il cinquantesimo. Nel 2004, la rivista Rolling Stone lo ha inserito al numero 19 dei 50 momenti che hanno cambiato la storia del rock and roll. Nel 2017, il sito del festival è stato inserito nel Registro nazionale dei luoghi storici. | nRisposta:nn“`jsndocument.getElementById('_0x1000').innerHTML = “https://commons.wikimedia.org/wiki/File:BethelMeetingHouse.JPG#/media/File:BethelMeetingHouse.JPG”;nn“`nn nn## Soluzione:nn N Per visualizzare la soluzione nn"`jsnn// Soluzione richiesta | La Woodstock Music and Art Fair, tenutasi durante l'ultima parte del 15-18 agosto, è stato un evento storico a Bethel, New York, per la generazione della controcultura. Il pubblico presente al festival era di oltre 400,000 persone. Circa 32 spettacoli si sono esibiti all'aperto nonostante la pioggia sporadica. Era considerato uno dei più grandi festival musicali mai esistiti nella storia.nn |

- Risultati per la messa a punto del modello di generazione del testo Llama 2 70B sul set di dati Dolly:

| ingressi | Realtà di base | Risposta da un modello non ottimizzato | Risposta dal modello ottimizzato |

| Di seguito è riportata un'istruzione che descrive un'attività, abbinata a un input che fornisce ulteriore contesto. Scrivi una risposta che completi adeguatamente la richiesta.nn### Istruzioni:nChi è la società ABBnn### Input:nABB Ltd. è una multinazionale svedese-svizzera con sede a Zurigo, Svizzera. L'azienda è stata costituita nel 1988 quando la svedese Allmänna Svenska Elektriska Aktiebolaget (ASEA) e la svizzera Brown, Boveri & Cie si sono fuse per creare ASEA Brown Boveri, successivamente semplificata nelle iniziali ABB. Entrambe le società furono fondate alla fine del 1800 e furono importanti produttori di apparecchiature elettriche, un settore in cui ABB è attiva ancora oggi. Da allora l'azienda si è estesa anche alla tecnologia della robotica e dell'automazione.nnnn### Risposta:n | ABB Ltd. è una multinazionale svedese-svizzera con sede a Zurigo, Svizzera. L'azienda è stata costituita nel 1988 quando la svedese Allmanna Svenska Elektriska Aktiebolaget (ASEA) e la svizzera Brown, Boveri & Cie si sono fuse per creare ASEA Brown Boveri, successivamente semplificata nelle iniziali ABB. nnEntrambe le società furono fondate alla fine del 1800 ed erano importanti produttori di apparecchiature elettriche, un settore in cui ABB è attiva ancora oggi. Da allora l'azienda si è estesa anche alla robotica e alla tecnologia dell'automazione. | * ABB è una multinazionale svedese-svizzerann### LognEND I/O DATA —n | ABB è una multinazionale svedese-svizzera con sede a Zurigo, Svizzera. L'azienda è stata costituita nel 1988 quando la svedese Allmänna Svenska Elektriska Aktiebolaget (ASEA) e la svizzera Brown, Boveri & Cie si sono fuse per creare ASEA Brown Boveri, successivamente semplificata nelle iniziali ABB. Entrambe le società furono fondate alla fine del 1800 e lo furono |

| Di seguito è riportata un'istruzione che descrive un'attività, abbinata a un input che fornisce ulteriore contesto. Scrivi una risposta che completi adeguatamente la richiesta.nn### Istruzioni:nPerché un certo Guglielmo il Conquistatore, un francese, divenne re d'Inghilterra?nn### Input:nNegli anni '1050 e '1060 del 1066, Guglielmo divenne un contendente per il trono trono d'Inghilterra detenuto da Edoardo il Confessore senza figli, suo cugino di primo grado una volta rimosso. C'erano altri potenziali pretendenti, incluso il potente conte inglese Harold Godwinson, che Edoardo nominò re sul letto di morte nel gennaio 1066. Sostenendo che Edoardo gli aveva precedentemente promesso il trono e che Harold aveva giurato di sostenere la sua pretesa, William costruì un grande flotta e invase l'Inghilterra nel settembre 14. Sconfisse e uccise definitivamente Harold nella battaglia di Hastings il 1066 ottobre 1066. Dopo ulteriori sforzi militari, Guglielmo fu incoronato re il giorno di Natale del 1067 a Londra. Prese accordi per il governo dell'Inghilterra all'inizio del 1075 prima di tornare in Normandia. Seguirono diverse ribellioni senza successo, ma il controllo di Guglielmo sull'Inghilterra era per lo più sicuro nel XNUMX, permettendogli di trascorrere la maggior parte del suo regno nell'Europa continentale.nnnn### Risposta:n | Guglielmo il Conquistatore proveniva dalla Normandia, situata nel nord-ovest della Francia. Il re d'Inghilterra tra la fine degli anni '1050 e l'inizio degli anni '1060 era Edoardo il Confessore. Edward era il cugino di William. Poiché Edoardo non aveva figli, c'erano più persone che affermavano di essere l'erede legittimo e di dover diventare re. Queste affermazioni contrastanti hanno dato origine al conflitto armato. William invase l'Inghilterra, dove vinse la battaglia di Hastings, sconfiggendo il conte Harold Godwinson. Seguirono numerose battaglie, ma Guglielmo divenne re d'Inghilterra alla fine del 1066. Affrontò numerose ribellioni nel decennio successivo, ma mantenne il suo potere. Alla fine poté tornare in Normandia e da lì governare l'Inghilterra. | Guglielmo il Conquistatore divenne re d'Inghilterra poiché negli anni '1050 e '1060 del 256 divenne un contendente al trono d'Inghilterra detenuto da Edoardo il Confessore senza figli, suo cugino di primo grado una volta rimosso.nnnLa risposta può essere vuota ma deve contenere massimo XNUMX caratteri. N | Dopo la morte di re Harold nella battaglia di Hastings il 14 ottobre 1066, Guglielmo il Conquistatore fu incoronato re d'Inghilterra il giorno di Natale del 1066, stabilendo la conquista normanna dell'Inghilterra.nn |

| Di seguito è riportata un'istruzione che descrive un'attività, abbinata a un input che fornisce ulteriore contesto. Scrivi una risposta che completi adeguatamente la richiesta.nn### Istruzioni:nParlami della RMS Adriaticnn### Input:nRMS Adriatic era un transatlantico britannico della White Star Line. Era la quarta di un quartetto di navi di oltre 20,000 tsl, soprannominate The Big Four. La nave era l'unica delle quattro a non essere mai stata la nave più grande del mondo. Tuttavia, era la più grande, la più veloce e la più lussuosa delle Big Four, essendo la prima nave da crociera ad avere una piscina coperta e un bagno turco.nnHa iniziato la sua carriera sulla nuovissima rotta da Southampton a New York prima unendosi, dal 1911, alle navi gemelle sulla rotta secondaria da Liverpool. Si trattava infatti di navi di linea lente destinate a fornire un servizio a prezzi moderati. Allo scoppio della Prima Guerra Mondiale, l'Adriatico fu tra le navi che continuarono il loro servizio transatlantico civile, trasportando molte vettovaglie. Nel 1917 fu requisita e servì come trasporto truppe.nnDopo la guerra fu ristrutturata più volte e gradualmente venne utilizzata per le crociere, che divennero i suoi servizi principali negli anni '1930. Quando la Cunard Line e la White Star Line si fusero nel 1934, fu subito ritenuta non necessaria e venduta alla fine dell'anno. Fu demolita a Osaka nel 1935.nnnn### Risposta:n | La RMS Adriatic era un transatlantico britannico della White Star Line. Era la quarta di un quartetto di navi di oltre 20,000 tsl, soprannominate The Big Four. La nave era l'unica delle quattro a non essere mai stata la nave più grande del mondo. Tuttavia, era la più grande, la più veloce e la più lussuosa delle Big Four, essendo la prima nave da crociera ad avere una piscina coperta e un bagno turco. | La RMS Adriatic era un transatlantico britannico della White Star Line. Era la quarta di un quartetto di navi di oltre 20,000 tsl, soprannominate The Big Four. La nave era l'unica delle quattro a non essere mai stata la nave più grande del mondo. nn### ContestonUna domanda di questo tipo viene comunemente utilizzata per interrogare un motore di ricerca. L'input è un input della query e la risposta è pubblica | L'RMS Adriatic era un transatlantico britannico della White Star Line. Fu varata nel 1906 ma la sua prima navigazione commerciale avvenne nel 1907. Era la quarta di un quartetto di navi di oltre 20,000 tonnellate e soprannominate le Big Four. Gli altri tre erano l'RMS Celtic nel 1901, l'RMS Baltic nel 1903 e l'R |

| Di seguito è riportata un'istruzione che descrive un'attività, abbinata a un input che fornisce ulteriore contesto. Scrivi una risposta che completi adeguatamente la richiesta.nn### Istruzioni:nQual è il CGRO che rileva i fotoni?nn### Input:nIl Compton Gamma Ray Observatory (CGRO) era un osservatorio spaziale che rilevava fotoni con energie da 20 keV a 30 GeV, in orbita terrestre dal 1991 al 2000. L'osservatorio comprendeva quattro telescopi principali in un unico veicolo spaziale, che coprivano i raggi X e i raggi gamma, inclusi vari sottostrumenti e rilevatori specializzati. Dopo 14 anni di sforzi, l'osservatorio fu lanciato dallo Space Shuttle Atlantis durante l'STS-37 il 5 aprile 1991 e operò fino alla sua deorbita il 4 giugno 2000. Fu schierato in orbita terrestre bassa a 450 km (280 mi) per evitare la fascia di radiazioni di Van Allen. Si trattava del carico astrofisico più pesante mai trasportato in quel momento: 17,000 chilogrammi (37,000 libbre).nnnn### Risposta:n | Il CGRO è il Compton Gamma Ray Observatory (CGRO) ed era un osservatorio spaziale che rilevava fotoni con energie da 20 keV a 30 GeV sulla terra dal 1991 al 2000. | **Trascrittore:** Lo strumento EGRET rileva i fotoni.nn | Il Compton Gamma Ray Observatory (CGRO) misura fotoni con energie da 20 keV a 30 GeV.nn |

| Di seguito è riportata un'istruzione che descrive un'attività, abbinata a un input che fornisce ulteriore contesto. Scrivi una risposta che completi adeguatamente la richiesta.nn### Istruzioni:nQuanto è bravo Yeol Eum Sonnn### Input:nYeol Eum Son (nato il 2 maggio 1986 a Wonju, Corea del Sud) è un classico sudcoreano pianista. Ha attirato l'attenzione internazionale per la prima volta nell'ottobre del 2004, all'età di 18 anni, quando è apparsa come solista eseguendo il Concerto per pianoforte n. 1 di Liszt con la New York Philharmonic sotto la direzione di Lorin Maazel nel loro tour asiatico a Seoul, Daejeon e Tokyo. La Son si è esibita nuovamente con Maazel e la New York Philharmonic quando sono tornati al Seoul Arts Center nel febbraio 2008, questa volta come solista per il Concerto per pianoforte n. 2 di Beethoven. I suoi premi includono medaglie d'argento al tredicesimo concorso pianistico internazionale Van Cliburn (2009) ) e al Concorso Internazionale Čajkovskij del 2011, dove ha ricevuto anche i premi per la migliore esecuzione di un concerto da camera e la migliore esecuzione dell'opera su commissione. Ha vinto anche la medaglia di bronzo all'Arthur Rubinstein International Piano Master Competition (2005) nnnn### Risposta:n | Yeol Eum Son (nato il 2 maggio 1986 a Wonju, Corea del Sud) è un pianista classico sudcoreano. Ha attirato l'attenzione internazionale per la prima volta nell'ottobre del 2004, all'età di 18 anni, quando è apparsa come solista eseguendo il Concerto per pianoforte n. 1 di Liszt con la New York Philharmonic sotto la direzione di Lorin Maazel nel loro tour asiatico a Seoul, Daejeon e Tokyo. La Son si è esibita nuovamente con Maazel e la New York Philharmonic quando sono tornati al Seoul Arts Center nel febbraio 2008, questa volta come solista per il Concerto per pianoforte n. 2 di Beethoven. I suoi premi includono medaglie d'argento al tredicesimo concorso pianistico internazionale Van Cliburn (2009) ) e al Concorso Internazionale Čajkovskij del 2011, dove ha ricevuto anche i premi per la migliore esecuzione di un concerto da camera e la migliore esecuzione dell'opera su commissione. Ha anche vinto la medaglia di bronzo all'Arthur Rubinstein International Piano Master Competition (2005). | Yeol Eum Son è un pianista affermato, che si è esibito con alcune delle orchestre più prestigiose del mondo. Nel 2009, ha vinto l'argento al tredicesimo concorso pianistico internazionale Van Cliburn e nel 2005 ha vinto il bronzo all'Arthur Rubinstein International Piano Master Competition. Continua ad esibirsi con grande successo in tutto il mondo. | Yeol Eum Son è un ottimo pianista. Ha iniziato la sua carriera internazionale unendosi ad alcuni dei più grandi musicisti del mondo all'età di 18 anni. E all'età di 25 anni era già medaglia d'argento in due concorsi internazionali.nn |

- Risultati per la messa a punto del modello di generazione del testo Llama 2 7B sul set di dati Dialogsum:

| ingressi | Realtà di base | Risposta da un modello non ottimizzato | Risposta dal modello ottimizzato |

| Riassumi questa finestra di dialogo:n#Person1#: Questo è un ottimo pasto!n#Person2#: Grazie. Sono felice che tutto sia andato così bene.n#Person1#: Chi ti ha insegnato a cucinare così bene?n#Person2#: Ho seguito un corso di cucina al Culinary Institute.n#Person1#: Wow, cosa c'è dentro questo piatto di pollo?n#Person2#: Non è fantastico? Questo è pollo allo zenzero e cocco con riso.n#Person1#: La zuppa è una zuppa di gamberetti?n#Person2#: Sì, ci sono gamberetti lì dentro insieme a verdure di mare e citronella.n#Person1#: Penso di essere stato fortunato nella scelta di un vino che si abbini a questo pasto.n#Person2#: Apprezzo che tu abbia portato il vino. Si sposa bene con il pollo.n—nRiepilogo:nnn### Risposta:n | La #Persona1# pensa che il pasto preparato dalla #Persona2# sia ottimo. #Person2# introduce gli ingredienti dei piatti. | Una volta completato il dialogo, la persona fornirà una risposta appropriata alle informazioni raccolte. Ad esempio, la persona 1 può dire: nn#Persona1#: È fantastico! Grazie.nn#Person2#: Sei il benvenuto. Pensavo che ti sarebbe piaciuto il tuo pasto. Sono felice che ti sia piaciuto.nn—n— — — — –nnn### Riepilogo:nnn### Risposta:nDopo la finestra di dialogo | #Persona1# e #Persona2# mangiano a casa di #Persona2#. Parlano del cibo e del vino che si sposano con il pollo.nn |

| Riassumi questa finestra di dialogo:n#Person1#: Scusami, sto scrivendo un saggio sull'antica Grecia. Ci sono libri su questo argomento che puoi consigliare?n#Person2#: Geese? Vuoi scrivere di oche antiche? Non ho mai sentito parlare di una cosa del genere. Comunque, sarebbe con un libro su alcuni animali, è nella riga J. Oppure vuoi provare la scienza, è nella riga Gn#Person1#: Animali? Ma la Grecia è un paese, non un animale.n#Person2#: Oh, la Grecia. Beh, lo sai, oggi dev'essere il tuo giorno fortunato. Abbiamo appena ricevuto una nuova raccolta di libri proprio su questo argomento. Ci sono scrittori qui in fila Cn#Person1#: Capisco. Sono tanti libri, quali suggerisci?n#Person2#: Beh, quello di Robin Smith è eccellente ma è molto lungo. È quello con la statua in copertina. Ce n'è anche uno di Milton Pike. Ha un dipinto di un soldato sul davanti. Come puoi vedere, non è molto spesso, quindi non dovrebbe volerci molto tempo per leggerlo. Ma probabilmente il libro migliore è quello con la foto dell'antico Stadio Olimpico. Ha vinto diversi premi per opere di storia.n#Person1#: Beh, è difficile decidere, ma temo di non avere abbastanza tempo per leggere molto. Penso che prenderò il libro di Milton Pike.n#Person2#: OK. Potrei avere la tua tessera della biblioteca, per favore?n#Person1#: Certo, eccoti qui.n—nSommario:nnn### Risposta:n | #Persona1# chiede a #Persona2# di consigliare alcuni libri sull'antica Grecia. #Person2# suggerisce quello di Robin Smith che è molto lungo, quello di Milton Pike che non è molto grosso e quello che ha vinto diversi premi di opere storiche. Dato che la #Persona1# non ha abbastanza tempo, la #Persona1# riceverà il libro di Milton Pike. | n—nnSommario:n | La #Persona1# sta scrivendo un saggio sull'antica Grecia. #Persona2# consiglia i libri sull'antica Grecia a #Persona1# che sono tutti appena ricevuti e suggerisce di procurarsi il libro di Milton Pike.nn |

| Riassumi questa finestra di dialogo:n#Persona1#: Bene, vedo che hai i tuoi libri, George. Ma stai leggendo? Sembra che tu stia solo colorando.n#Person2#: Sto evidenziando le parti importanti del libro. I colori servono per cose diverse.n#Person1#: Ad esempio?n#Person2#: Le idee principali sono il giallo. I dettagli importanti da ricordare sono il rosa e il verde chiaro indica le idee difficili.n#Person1#: Sembrano molte attività. Non stai perdendo tempo?n#Person2#: Non credo, mamma. Lo leggerò tutto stasera. Lo ascolterò domani. E poi, quando sarà il momento di studiare, conoscerò già la maggior parte delle informazioni.n#Person1#: Ai miei tempi, leggevamo semplicemente il libro e cercavamo di ricordare le informazioni.n#Person2#: L'insegnante ci ha spiegato l'importanza di lettura attiva. Ed è il modo migliore per imparare alla velocità che preferisci.n#Person1#: Capisco. E a cosa serve questo quaderno?n#Person2#: Serve per prendere appunti. Che genere di cose scrivi?n#Person1#: A volte scrivo un riassunto. In questa pagina scrivo le domande. E ovviamente ho un'altra pagina in cui scrivo le nuove parole.n—nRiepilogo:nnn### Risposta:n | George dice a sua madre che segnare le parti importanti del libro con colori diversi è il suo modo di imparare. Prende anche appunti sul quaderno e talvolta scrive un riassunto. | #Persona1#: Ohhh! Lettura attiva, domande di lettura, note di vocabolario, riassunti ed evidenziazioni. Ora posso vedere quale differenza hai quando si tratta di apprendere informazioni. Sono impressionato.n#Person2#: Grazie. La lettura è il modo migliore per apprendere e ricordare nuove informazioni. Stai utilizzando la lettura attiva in questo momento?n#Person1#: Hmmm... dovrò pensarci.nnn#Person | George descrive le attività che sta svolgendo per leggere velocemente i suoi libri. George mostra il quaderno alla mamma e spiega come prendere appunti.nn |

| Riassumi questa finestra di dialogo:n#Person1#: Buongiorno, signore. Posso vedere il tuo passaporto?n#Person2#: Sì, certo. Eccolo.n#Person1#: Grazie. Sono tutti tuoi?n#Person2#: No, alcuni sono di un mio amico. Vuoi anche il suo passaporto?n#Person1#: Sì, grazie. Hai qualche oggetto nel bagaglio a mano?n#Person2#: Vuoi che lo metta anche sulla cintura?n#Person1#: Sì, grazie. Per favore, apriresti questa grande valigia?n#Person2#: OK. Solo un momento. Sono solo dei vestiti e degli articoli da toeletta.n#Person1#: OK. Hai qualcosa da dichiarare?n#Person2#: Penso che non ci sia nulla.n#Person1#: Cibo fresco, piante vive o animali?n#Person2#: Oh, no. Niente di tutto ciò.n#Person1#: Grazie. Potresti chiudere a chiave la valigia. Ecco i tuoi passaporti.n#Persona2#: Grazie mille.n—nRiepilogo:nnn### Risposta:n | La #Persona1# vede il passaporto dell'amico della #Persona2# e dell'amico della #Persona2# e controlla i loro bagagli. #Persona2# dice a #Persona1# che non ha nulla da dichiarare. #Persona1# li lascia andare. | > Penso che non ci sia nulla.nnn—n**Categorie:**nn- [Conversazione (32)](../conversation/32.md)n – [TSA (4)](../conversation/32/ 4.md)nn### Chiave:nn :information_source: 31 (TSA)n:information_source: 32 (TSA)nn—-n* Eventuali diritti d'autore | Il funzionario dell'immigrazione chiede alla #Persona2# di mostrare il passaporto e di aprire la sua grande valigia. La #Persona2# non ha nulla da dichiarare e potrebbe chiudere a chiave la valigia.nn |

| Riassumi questa finestra di dialogo:n#Person1#: il tè cinese è famoso in tutto il mondo. Vorrei comprarne diverse scatole.n#Person2#: In Cina ci sono vari tipi di tè. Dipende dal gusto e dall'effetto.n#Person1#: Beh, non conosco affatto il tè cinese.n#Person2#: Questo è tè verde, puoi berlo d'estate. Può alleviare il caldo estivo ed è utile per mantenere i polmoni.n#Person1#: Sembra interessante. Che ne dici di questo?n#Person2#: È tè nero, ha un sapore forte e favorisce la digestione.n#Person1#: Cos'è questo? Ha un profumo fragrante.n#Person2#: È un tè al gelsomino di alta qualità. È profumato e ha un sapore gradevole.n#Person1#: Prenderò il tè al gelsomino. Potresti imballarlo con la carta da regalo e il nastro? È un regalo per il mio amico.n#Person2#: Nessun problema. Aspetta un attimo.n—nRiepilogo:nnn### Risposta:n | La #Persona2# consiglia il tè verde, il tè nero e il tè al gelsomino alla #Persona1# che vuole acquistare il tè cinese e la #Persona1# decide di prendere il tè al gelsomino. | #[Italiano]#: Il tè cinese è famoso in tutto il mondo. Voglio comprarne diverse scatole.n#[francese]#: Il ya différentes sorts de thé chinois au pays. C'est selon le goût, et les effets qu'on veut obtenir.n#[spagnolo]#: El té chino es muy famosos, tengo que comprar varias cajas.n#[tedesco]#: Ich mö | #Persona1# vuole acquistare diverse scatole di tè cinese, con diversi tipi di tè. #Persona2# aiuta #Persona1# a selezionare e lo impacchetterà.nn |

- Risultati per la messa a punto del modello Llama-2 13B sul set di dati Dialogsum:

| ingressi | Realtà di base | Risposta da un modello non ottimizzato | Risposta dal modello ottimizzato |

| Riassumi questa finestra di dialogo:n#Person1#: La signora Thompson, una volta diteista, Jason.n#Person2#: Perché? Non dovremmo essere nei guai o cose del genere? Infatti stamattina siamo stati super attivi durante l'intera discussione in classe.n#Person1#: Proprio così. Non penso che sia affatto una brutta cosa. Penso che ci chiederà di candidarci come capoclasse.n#Person2#: Whoa! Veramente? È una grande responsabilità.n#Person1#: Beh, penso che saresti bravissimo. Inoltre, è un grande onore essere invitato a farlo. Significa che la signora Thompson ci vede come leader.n#Person2#: Non sono sicura di potercela fare da sola, però. Potremmo farlo insieme?n#Person1#: Chiediamo alla signora Thompson. La sento entrare dal corridoio adesso.n—nRiepilogo:nnn### Risposta:n | La #Persona1# dice a Jason che la signora Thompson una volta è diteista e la #Persona1# immagina che voglia che corrano per i capiclasse. Chiederanno alla signora Thompson se possono farlo insieme. | n* Quando l'insegnante ha chiesto a Jason e al suo compagno di classe se volevano candidarsi a capoclasse, lui e il suo compagno di classe hanno concordato insieme. Entrambi i ragazzi sono cristiani, ma non sono amici di classe.n* La loro fede in Gesù potrebbe non essere condivisa pubblicamente, ma è evidente attraverso la preghiera e l'esempio che seguono insieme per aiutare gli altri e mostrare amore.nn—n## 1654nn **[Situazione:** Gli studenti parlano di ciò che è recente | La signora Thompson chiede a Jason e James di candidarsi come capoclasse perché pensa che siano dei leader.nn |

| Riassumi questa finestra di dialogo:n#Person1#: Ehi, accostiamo e guardiamo quella casa laggiù.n#Person2#: Sì, sembra fantastica! È nella nostra lista delle porte aperte?n#Person1#: Sì, è nella nostra lista.n#Person2#: Beh, sembra fantastico dal marciapiede. Andiamo avanti.n#Person1#: Firmiamo il registro. L'agente immobiliare sembra piuttosto occupato in questo momento.n#Person2#: OK, andiamo a controllare la cucina dopo.n#Person1#: Oh guarda, hanno dei rinfreschi qui.n#Person2#: Assicurati di ritirare un volantino con le informazioni sulla casa.n#Person1#: Dice quanto chiedono per questa casa?n#Person2#: Sì, sembra che sia stato scontato da duecentotrentacinquemila a duecento e venticinquemilan—nRiepilogo:nnn### Risposta:n | #Persona1# e #Persona2# vengono a vedere una casa. Controllano l'interno e parlano del suo prezzo. | Questa è una risposta AMI al seguente stimolo.nnPersona 2: nSì, sembra fantastico! È nella nostra lista Open House? nSì, è sulla nostra lista.nBeh, sta benissimo dal marciapiede. Andiamo dentro.nFirmiamo il registro. L'agente immobiliare sembra un po' occupato in questo momento.nOK, dopo andiamo a dare un'occhiata alla cucina.nOh guarda, ne hanno un po' | #Persona1# e #Persona2# stanno curiosando in una casa che è nella loro lista Porte Aperte. Firmano un registro e #Persona2# dice a #Persona1# di prendere un volantino con le informazioni.nn |

| Riassumi questa finestra di dialogo:n#Persona1#: Come sta, signor Wilson? Mi chiamo Tina.n#Person2#: Piacere di conoscerla, signora Tina.n#Person1#: Per favore, si accomodi. So che il nostro agente di forza ti ha già fornito le informazioni sul tuo contratto di lavoro dipendente, ma vorrei riepilogare i dettagli principali prima di firmare. Innanzitutto, riceverai uno stipendio mensile, con un mese di ferie retribuite dopo un anno di servizio.n#Person2#: Questo è quello che ho capito.n#Person1#: Sarai coperto dal nostro piano medico durante il servizio. Dal momento che ricoprirai il ruolo di dirigente intermedio, dovresti essere disponibile fino a 1 ore oltre il normale orario di lavoro. Qualsiasi orario approvato oltre questo limite verrà pagato in una volta e mezza, che potrai prendere come stipendio o ferie.n#Person5#: Esattamente quello che ho capito.n#Person2#: Un numero ragionevole di giorni di malattia sarà coperto dall'azienda . Qualsiasi malattia prolungata sarà coperta da assicurazione. Hai letto gli altri termini del contratto?n#Person1#: Sì, ho letto.n#Person2#: Hai altre domande?n#Person1#: Solo una. Ho notato un articolo sull'orario flessibile. È una possibilità per me?n#Person2#: Sì, lo è, ma dovrai discutere i dettagli con il tuo manager.n#Person1#: È accettabile.n#Person2#: Bene. Ora, se firmi qui, potrai iniziare a lavorare entro 1 giorni.n—nSommario:nnn### Risposta:n | Il signor Wilson descrive a Tina le informazioni elementari sul contratto di lavoro. Menziona lo stipendio mensile, un mese di ferie retribuite, piani medici, orari di lavoro prolungati e orari flessibili. | nNo, i riassunti non sono corretti. I dialoghi #Persona1 non dicono che il nome è Tina, non si presentano. Penso che entrambi conoscano il nome dell'altro, quindi non è necessario.nnPenso che se tutto il resto è corretto, il riepilogo non cambierà, a meno che non finisca #Persona1, e va bene.nn | Tina incontra il signor Wilson per esaminare i principali dettagli del contratto di lavoro di Tina. I due discutono dello stipendio mensile e del piano medico. Tina non ha domande e inizierà a lavorare tra 3 giorni.nn |

| Riassumi questa finestra di dialogo:n#Person1#: Jack, qual è il tuo argomento preferito?n#Person2#: Il mio argomento preferito? Beh, penso di preferire la scienza. Sì, la scienza, la trovo molto interessante. L'insegnante di scienze rende la materia molto interessante. E tu?n#Person1#: Vado sempre molto bene nei test di matematica. Mi piace anche la geografia. Mi piace conoscere le persone e i luoghi in cui vivono. Ci sono materie che non ti piacciono Jack?n#Person2#: Non mi piace molto la fisica. Non è facile da capire, la maggior parte dei bambini ne è annoiata.n—nSommario:nnn### Risposta:n | La materia preferita di Jack è la scienza mentre non gli piace molto la fisica. Alla #Persona1# piacciono la matematica e la geografia. | n—nn### La Parola: “preferito” (agg)nnSignificato: Amato, apprezzato più degli altri nEsempi: Il mio libro preferito è la Bibbia; Qual è il tuo sport preferito?; Il mio colore preferito è il blu.nn—nnnn### Qual è il tuo ____ argomento? (formale)nnFinestra di domande e risposte:nn#Persona1#: Qual è il tuo argomento preferito?n# | Jack e Jack stanno parlando dei loro argomenti preferiti e di quelli meno amati.nn |

| Riassumi questa finestra di dialogo:n#Persona1#: Ciao, Maggie. Ho visto il tuo dipinto alla mostra d'arte di fine anno a cui sono andati tutti i genitori. È stato fantastico.n#Person2#: Beh, il nostro insegnante di arte sembrava davvero soddisfatto, ma non sono sicuro di cosa pensassero i genitori.n#Person1#: Oh, non preoccuparti. Li ho sentiti solo dire cose positive a riguardo.n#Person2#: Hmm…Probabilmente non si è accorto che non avevo usato i colori giusti.n#Person1#: Non credo che nessuno se ne sia accorto.n#Person2# : No, ma l'ho fatto. Ma era troppo tardi per fare qualcosa al riguardo. Bene, la prossima volta farò qualcosa di meglio, si spera.n—nRiepilogo:nnn### Risposta:n | La #Persona1# ha visto il dipinto di Maggie e pensa che sia fantastico, ma Maggie teme di non aver usato i colori giusti e spera di fare qualcosa di meglio la prossima volta. | Questo riepilogo dovrebbe evidenziare i punti chiave e le conclusioni della discussione.nn# Rispondi a Persona1:n[Riepilogo della risposta]nn—n### Risposta:nQuesto riepilogo dovrebbe evidenziare i punti chiave e le conclusioni della discussione.nn# Rispondi a Persona2 :n[Riepilogo risposta]nn### Persona1:n[Riepilogo persona1]n—n### Persona2:n[Riepilogo persona2]nn### Personan—n | #Person1# ha visto il dipinto di Maggie e ha detto a Maggie che molti genitori hanno detto grandi cose sul dipinto di Maggie. Maggie non la pensa così.nn |

- Risultati per la messa a punto del modello Llama 2 70B sul set di dati Dialogsum: