Abbiamo addestrato e stiamo rendendo open source una rete neurale chiamata Whisper che si avvicina alla robustezza e alla precisione a livello umano nel riconoscimento vocale dell'inglese.

Visualizza codice

Visualizza scheda modello

Esempi di sussurri:

Whisper è un sistema di riconoscimento vocale automatico (ASR) addestrato su 680,000 ore di dati supervisionati multilingue e multitasking raccolti dal web. Mostriamo che l’uso di un set di dati così ampio e diversificato porta a una migliore robustezza degli accenti, del rumore di fondo e del linguaggio tecnico. Inoltre, consente la trascrizione in più lingue, nonché la traduzione da tali lingue all'inglese. Stiamo realizzando modelli open source e codice di inferenza che fungono da base per la creazione di applicazioni utili e per ulteriori ricerche sull'elaborazione vocale efficace.

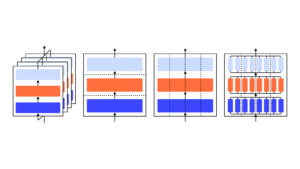

L'architettura Whisper è un semplice approccio end-to-end, implementato come un trasformatore codificatore-decodificatore. L'audio in ingresso viene suddiviso in blocchi di 30 secondi, convertito in uno spettrogramma log-Mel e quindi passato a un codificatore. Un decodificatore è addestrato a prevedere la didascalia di testo corrispondente, mescolata con token speciali che indirizzano il singolo modello a svolgere attività come l'identificazione della lingua, i timestamp a livello di frase, la trascrizione vocale multilingue e la traduzione vocale in inglese.

Altri approcci esistenti utilizzano spesso set di dati di addestramento audio-testo più piccoli e più strettamente abbinatioppure utilizzare una formazione preliminare audio ampia ma senza supervisione. Poiché Whisper è stato addestrato su un set di dati ampio e diversificato e non è stato ottimizzato per nessuno specifico, non batte i modelli specializzati nelle prestazioni di LibriSpeech, un punto di riferimento notoriamente competitivo nel riconoscimento vocale. Tuttavia, quando misuriamo le prestazioni zero-shot di Whisper su molti set di dati diversi, scopriamo che è molto più robusto e commette il 50% di errori in meno rispetto a questi modelli.

Circa un terzo del set di dati audio di Whisper non è inglese e gli viene affidato alternativamente il compito di trascrivere nella lingua originale o di tradurre in inglese. Riteniamo che questo approccio sia particolarmente efficace nell'apprendimento della traduzione da parlato a testo e surclassa il SOTA supervisionato su CoVoST2 per la traduzione in inglese zero-shot.

Ci auguriamo che l'elevata precisione e la facilità d'uso di Whisper consentano agli sviluppatori di aggiungere interfacce vocali a un insieme di applicazioni molto più ampio. Dai un'occhiata a carta, scheda modelloe codice per conoscere maggiori dettagli e provare Whisper.

- AI

- oh arte

- generatore d'arte

- un robot

- intelligenza artificiale

- certificazione di intelligenza artificiale

- intelligenza artificiale nel settore bancario

- robot di intelligenza artificiale

- robot di intelligenza artificiale

- software di intelligenza artificiale

- blockchain

- conferenza blockchain ai

- geniale

- intelligenza artificiale conversazionale

- criptoconferenza ai

- dall's

- apprendimento profondo

- google ai

- machine learning

- OpenAI

- Platone

- platone ai

- Platone Data Intelligence

- Gioco di Platone

- PlatoneDati

- gioco di plato

- riparazioni

- scala ai

- sintassi

- zefiro