Essere in grado di decodificare le onde cerebrali potrebbe aiutare i pazienti che hanno perso la capacità di parlare a comunicare di nuovo e, in definitiva, potrebbe fornire agli esseri umani nuovi modi di interagire con i computer. Ora i ricercatori Meta hanno dimostrato di poter dire quali parole è qualcuno udito utilizzando registrazioni da scansioni cerebrali non invasive.

La nostra capacità di sondare umano l'attività cerebrale è migliorata in modo significativo negli ultimi decenni poiché gli scienziati hanno sviluppato una varietà di tecnologie di interfaccia cervello-computer (BCI) che possono fornire una finestra sui nostri pensieri e intenzioni.

I risultati più impressionanti provengono da dispositivi di registrazione invasivi, che impiantano elettrodi direttamente nel cervello gray materia, combinato con AI che può imparare a interpretaret segnali cerebrali. Negli ultimi anni, questo ha made è possibile decodificare frasi complete dall'attività neurale di qualcuno con una precisione del 97% e la traduzione tentata movimenti della grafia direttamente nel testo a velocità comparabilivai a mandare SMS.

Ma dover impiantare elettrodi nel cervello di qualcuno ha evidenti svantaggi. Queste procedure rischiose sono giustificabili solo dal punto di vista medico per i pazienti che richiedono la registrazione del cervello per aiutare a risolvere altri problemi medici, come l'epilessia. E le sonde neurali si degradano nel tempo, il che solleva la prospettiva di doverle sostituire regolarmente.

Ecco perché i ricercatori della divisione di ricerca sull'intelligenza artificiale di Meta hanno deciso di indagare se potevano raggiungere obiettivi simili senza richiedere un pericoloso intervento chirurgico al cervelloy. In una carta pubblicato sul server di prestampa arXiv, il team ha riferito di aver sviluppato un sistema di intelligenza artificiale in grado di prevedere le parole che qualcuno sta ascoltando in base all'attività cerebrale registrata utilizzando un metodo non invasivo interfacce cervello-computer.

"Ovviamente è estremamente invasivo mettere un elettrodo nel cervello di qualcuno", Jean Remi King, ricercatore presso il Facebook Artificial Intelligence Research (FAIR) Lab, detto ORARIO. "Quindi abbiamo voluto provare a utilizzare registrazioni non invasive dell'attività cerebrale. E l'obiettivo era costruire un sistema di intelligenza artificiale in grado di decodificare le risposte del cervello alle storie raccontate".

I ricercatori si sono basati su quattro set di dati preesistenti sull'attività cerebrale raccolti da 169 persone mentre ascoltavano le registrazioni di persone che parlavano. Ogni volontario è stato registrato utilizzando la magnetoencefalografia (MEG) o l'elettroencefalografia (EEG), che utilizzano diversi tipi di sensori per rilevare l'attività elettrica del cervello dall'esterno del cranio.

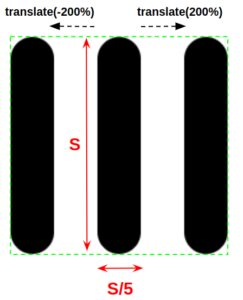

Il loro approccio coinvolged dividere il cervello e i dati audio in tre-frammenti di un secondo e alimentandoli in una rete neurale che poi guardaed per i modelli che cOuld collegare i due. Dopo aver addestrato l'IA su molte ore di questi dati, l'hanno poi testata su dati inediti.

Il sistema ha ottenuto le migliori prestazioni su uno dei set di dati MEG, dove ha ottenuto una precisione nella top-10 del 72.5%. Ciò significa che quando si è classificato il 10 parole con la più alta probabilità di essere collegate al segmento delle onde cerebrali, la parola corretta era ci Il 72.5 per cento delle volte.

Potrebbe non suonare bene, ma è importante ricordare che stava scegliendo da un potenziale vocabolario di 793 parole. Il sistema ha ottenuto un punteggio del 67.2% sull'altro set di dati MEG, ma è andato meno bene sui set di dati EEG, ottenendo il primo posto0 esattezze di solo 31.4 e 19.1.

Chiaramente questo è ancora lontano da un sistema pratico, ma rappresenta un progresso significativo su un problema difficile. I BCI non invasivi hanno rapporti segnale-rumore molto peggiori, quindi decifrare l'attività neurale in questo modo è impegnativo, ma in caso di successo potrebbe risultare in una tecnologia molto più ampiamente applicabile.

Tuttavia, non tutti sono convinti che sia un problema risolvibile. Ha detto Thomas Knopfel dell'Imperial College di Londra New Scientist che cercare di sondare i pensieri usando questi approcci non invasivi era come "cercando di trasmettere in streaming un film HD su modem telefonici analogici vecchio stile", e si è chiesto se tali approcci raggiungeranno mai livelli di precisione pratici.

Aziende come Neuralink di Elon Musk scommettono anche che alla fine supereremo la nostra schizzinosità sugli approcci invasivi man mano che la tecnologia migliora, aprendo la porta alla gente comune che riceve impianti cerebrali.

Ma la ricerca del team di Meta è alle prime fasi e c'è molto spazio per miglioramenti. E le opportunità commerciali per chiunque riesca a decifrare la scansione cerebrale non invasiva probabilmente forniranno molte motivazioni per provare.

Immagine di credito: sterco tran da Pixabay