Amazon Sage Maker semplifica l'implementazione di modelli di machine learning (ML) per l'inferenza in tempo reale e offre un'ampia selezione di istanze ML che abbracciano CPU e acceleratori come AWS Inferenza. Essendo un servizio completamente gestito, puoi ridimensionare le distribuzioni dei modelli, ridurre al minimo i costi di inferenza e gestire i modelli in modo più efficace in produzione con un carico operativo ridotto. Un endpoint di inferenza in tempo reale SageMaker è costituito da un endpoint HTTP e da istanze ML distribuite su più zone di disponibilità per un'elevata disponibilità. SageMaker ridimensionamento automatico dell'applicazione può regolare dinamicamente il numero di istanze ML fornite per un modello in risposta ai cambiamenti nel carico di lavoro. L'endpoint distribuisce in modo uniforme le richieste in entrata alle istanze ML utilizzando un algoritmo round robin.

Quando i modelli ML distribuiti sulle istanze ricevono chiamate API da un numero elevato di client, una distribuzione casuale delle richieste può funzionare molto bene quando non c'è molta variabilità nelle richieste e nelle risposte. Ma nei sistemi con carichi di lavoro di intelligenza artificiale generativa, le richieste e le risposte possono essere estremamente variabili. In questi casi, è spesso preferibile bilanciare il carico considerando la capacità e l'utilizzo dell'istanza anziché il bilanciamento del carico casuale.

In questo post, discutiamo della strategia di routing delle richieste meno eccezionali (LOR) di SageMaker e di come può ridurre al minimo la latenza per determinati tipi di carichi di lavoro di inferenza in tempo reale prendendo in considerazione la capacità e l'utilizzo delle istanze ML. Parliamo dei vantaggi rispetto al meccanismo di routing predefinito e di come abilitare LOR per le distribuzioni del modello. Infine, presentiamo un'analisi comparativa dei miglioramenti della latenza con LOR rispetto alla strategia di routing predefinita del routing casuale.

Strategia LOR di SageMaker

Per impostazione predefinita, gli endpoint SageMaker hanno una strategia di instradamento casuale. SageMaker ora supporta una strategia LOR, che consente a SageMaker di instradare in modo ottimale le richieste all'istanza più adatta a soddisfare tale richiesta. SageMaker rende tutto ciò possibile monitorando il carico delle istanze dietro l'endpoint e i modelli o i componenti di inferenza distribuiti su ciascuna istanza.

Il seguente diagramma interattivo mostra la policy di routing predefinita in cui le richieste che arrivano agli endpoint del modello vengono inoltrate in modo casuale alle istanze ML.

Il seguente diagramma interattivo mostra la strategia di routing in cui SageMaker instraderà la richiesta all'istanza che ha il minor numero di richieste in sospeso.

In generale, il routing LOR funziona bene per i modelli fondamentali o i modelli di intelligenza artificiale generativa quando il modello risponde in centinaia di millisecondi o minuti. Se la risposta del tuo modello ha una latenza inferiore (fino a centinaia di millisecondi), potresti trarre maggiori vantaggi dal routing casuale. In ogni caso, ti consigliamo di testare e identificare il miglior algoritmo di routing per i tuoi carichi di lavoro.

Come impostare le strategie di routing di SageMaker

SageMaker ora ti consente di impostare il file RoutingStrategy parametro durante la creazione del file EndpointConfiguration per gli endpoint. Il diverso RoutingStrategy i valori supportati da SageMaker sono:

LEAST_OUTSTANDING_REQUESTSRANDOM

Di seguito è riportato un esempio di distribuzione di un modello su un endpoint di inferenza con LOR abilitato:

- Creare la configurazione dell'endpoint impostando

RoutingStrategyasLEAST_OUTSTANDING_REQUESTS: - Crea l'endpoint utilizzando la configurazione dell'endpoint (nessuna modifica):

Risultati delle prestazioni

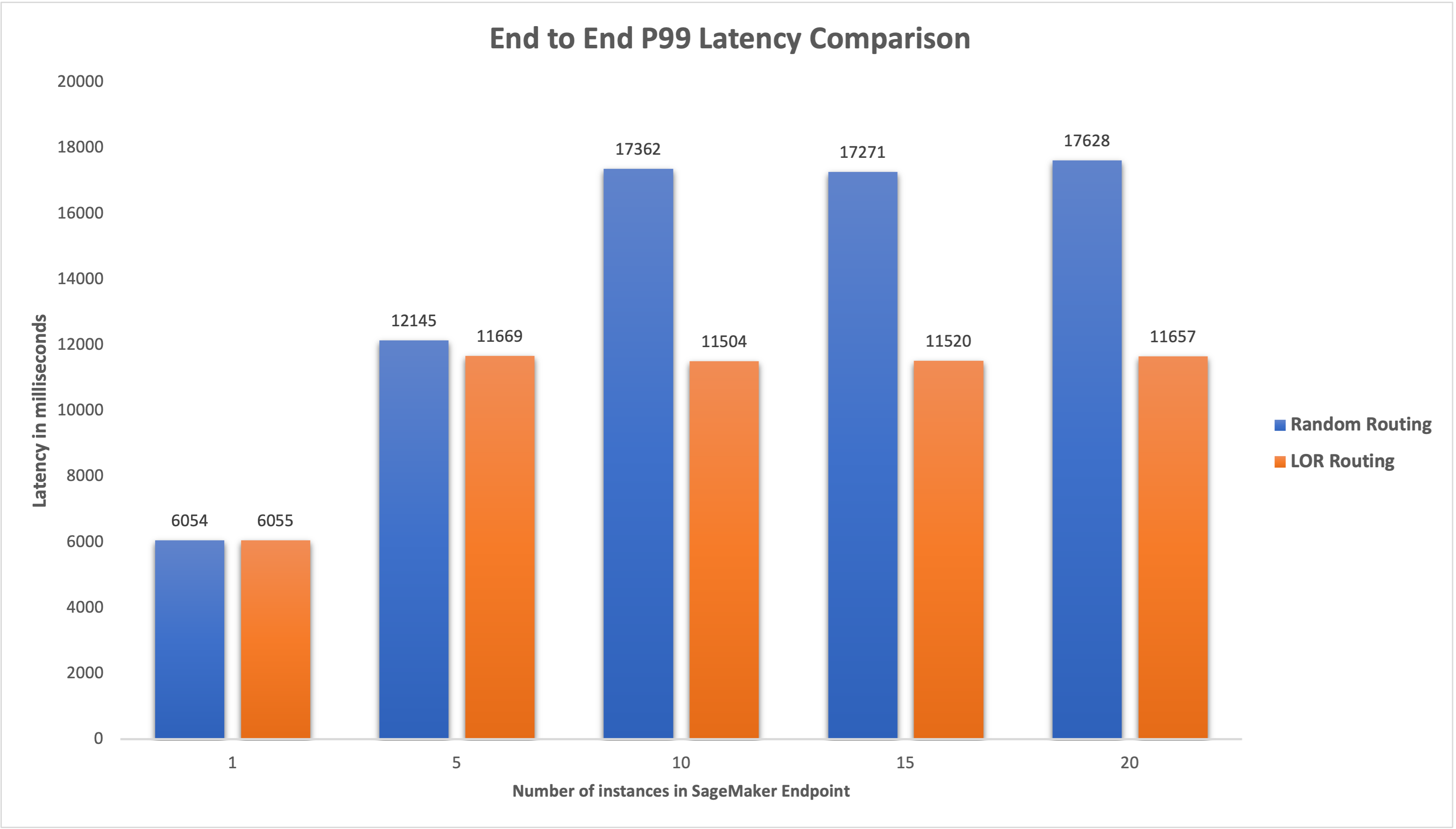

Abbiamo eseguito un benchmarking delle prestazioni per misurare la latenza di inferenza end-to-end e il throughput del codegen2-7B modello ospitato su istanze ml.g5.24xl con routing predefinito ed endpoint di routing intelligente. Il modello CodeGen2 appartiene alla famiglia dei modelli linguistici autoregressivi e genera codice eseguibile quando vengono forniti suggerimenti in inglese.

Nella nostra analisi, abbiamo aumentato il numero di istanze ml.g5.24xl dietro ciascun endpoint per ogni esecuzione di test man mano che aumentava il numero di utenti simultanei, come mostrato nella tabella seguente.

| Test | Numero di utenti simultanei | Numero di istanze |

| 1 | 4 | 1 |

| 2 | 20 | 5 |

| 3 | 40 | 10 |

| 4 | 60 | 15 |

| 5 | 80 | 20 |

Abbiamo misurato la latenza P99 end-to-end per entrambi gli endpoint e abbiamo osservato un miglioramento della latenza del 4–33% quando il numero di istanze è stato aumentato da 5 a 20, come mostrato nel grafico seguente.

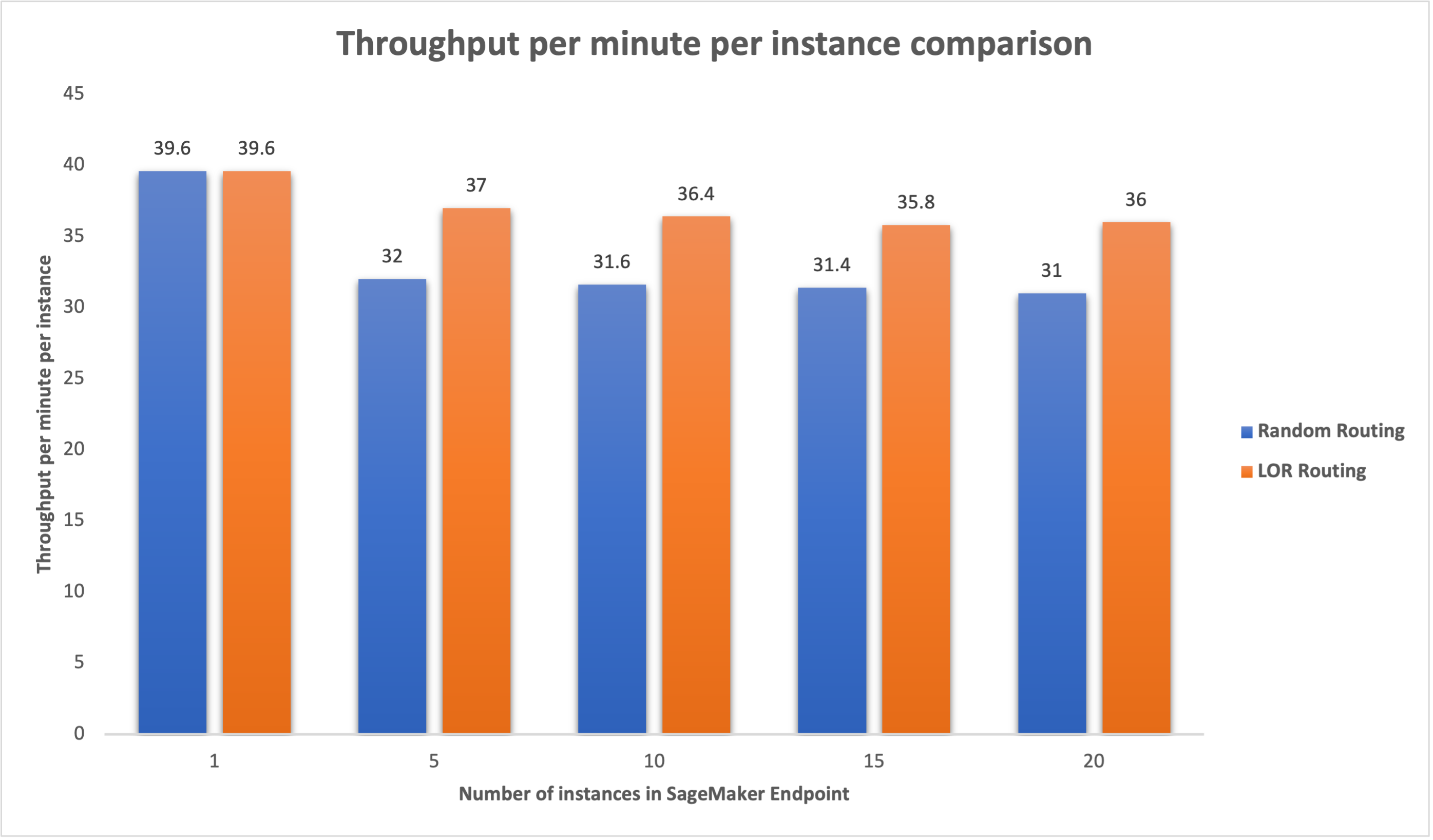

Allo stesso modo, abbiamo osservato un miglioramento del 15-16% nel throughput al minuto per istanza quando il numero di istanze è passato da 5 a 20.

Ciò dimostra che il routing intelligente è in grado di migliorare la distribuzione del traffico tra gli endpoint, portando a miglioramenti nella latenza end-to-end e nel throughput complessivo.

Conclusione

In questo post abbiamo spiegato le strategie di routing di SageMaker e la nuova opzione per abilitare il routing LOR. Abbiamo spiegato come abilitare LOR e come può apportare vantaggi alle distribuzioni del tuo modello. I nostri test sulle prestazioni hanno mostrato miglioramenti in termini di latenza e throughput durante l'inferenza in tempo reale. Per ulteriori informazioni sulle funzionalità di routing di SageMaker, fare riferimento a documentazione. Ti invitiamo a valutare i tuoi carichi di lavoro di inferenza e a determinare se sei configurato in modo ottimale con la strategia di routing.

Informazioni sugli autori

James Park è un Solutions Architect presso Amazon Web Services. Lavora con Amazon.com per progettare, costruire e distribuire soluzioni tecnologiche su AWS e ha un interesse particolare per l'intelligenza artificiale e l'apprendimento automatico. Nel tempo libero gli piace scoprire nuove culture, nuove esperienze e rimanere aggiornato sulle ultime tendenze tecnologiche. Lo puoi trovare su LinkedIn.

James Park è un Solutions Architect presso Amazon Web Services. Lavora con Amazon.com per progettare, costruire e distribuire soluzioni tecnologiche su AWS e ha un interesse particolare per l'intelligenza artificiale e l'apprendimento automatico. Nel tempo libero gli piace scoprire nuove culture, nuove esperienze e rimanere aggiornato sulle ultime tendenze tecnologiche. Lo puoi trovare su LinkedIn.

Venugopale Pai è un Solutions Architect presso AWS. Vive a Bangalore, in India, e aiuta i clienti nativi digitali a scalare e ottimizzare le loro applicazioni su AWS.

Venugopale Pai è un Solutions Architect presso AWS. Vive a Bangalore, in India, e aiuta i clienti nativi digitali a scalare e ottimizzare le loro applicazioni su AWS.

Davide Nigenda è un Senior Software Development Engineer nel team di Amazon SageMaker, che attualmente lavora per migliorare i flussi di lavoro di machine learning di produzione, oltre a lanciare nuove funzionalità di inferenza. Nel tempo libero cerca di stare al passo con i suoi figli.

Davide Nigenda è un Senior Software Development Engineer nel team di Amazon SageMaker, che attualmente lavora per migliorare i flussi di lavoro di machine learning di produzione, oltre a lanciare nuove funzionalità di inferenza. Nel tempo libero cerca di stare al passo con i suoi figli.

Deepti Ragha è un ingegnere di sviluppo software nel team di Amazon SageMaker. Il suo attuale lavoro si concentra sulla creazione di funzionalità per ospitare modelli di machine learning in modo efficiente. Nel tempo libero le piace viaggiare, fare escursioni e coltivare piante.

Deepti Ragha è un ingegnere di sviluppo software nel team di Amazon SageMaker. Il suo attuale lavoro si concentra sulla creazione di funzionalità per ospitare modelli di machine learning in modo efficiente. Nel tempo libero le piace viaggiare, fare escursioni e coltivare piante.

Alan Tan è un Senior Product Manager di SageMaker, che guida gli sforzi sull'inferenza di modelli di grandi dimensioni. È appassionato di applicare l'apprendimento automatico all'area dell'analisi. Al di fuori del lavoro, ama la vita all'aria aperta.

Alan Tan è un Senior Product Manager di SageMaker, che guida gli sforzi sull'inferenza di modelli di grandi dimensioni. È appassionato di applicare l'apprendimento automatico all'area dell'analisi. Al di fuori del lavoro, ama la vita all'aria aperta.

Dhawal Patel è un Principal Machine Learning Architect presso AWS. Ha lavorato con organizzazioni che vanno dalle grandi imprese alle startup di medie dimensioni su problemi legati all'informatica distribuita e all'intelligenza artificiale. Si concentra sull'apprendimento profondo, inclusi i domini della PNL e della visione artificiale. Aiuta i clienti a ottenere l'inferenza del modello ad alte prestazioni su SageMaker.

Dhawal Patel è un Principal Machine Learning Architect presso AWS. Ha lavorato con organizzazioni che vanno dalle grandi imprese alle startup di medie dimensioni su problemi legati all'informatica distribuita e all'intelligenza artificiale. Si concentra sull'apprendimento profondo, inclusi i domini della PNL e della visione artificiale. Aiuta i clienti a ottenere l'inferenza del modello ad alte prestazioni su SageMaker.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/minimize-real-time-inference-latency-by-using-amazon-sagemaker-routing-strategies/

- :ha

- :È

- :non

- :Dove

- $ SU

- 1

- 100

- 125

- 150

- 17

- 1870

- 20

- 7

- 9

- a

- capace

- WRI

- acceleratori

- Raggiungere

- operanti in

- AI

- Modelli AI

- Alan

- algoritmo

- consente

- Amazon

- Amazon Sage Maker

- Amazon Web Services

- Amazon.com

- tra

- an

- .

- analitica

- ed

- api

- applicazioni

- AMMISSIONE

- SONO

- RISERVATA

- artificiale

- intelligenza artificiale

- AS

- At

- auto

- disponibilità

- AWS

- Equilibrio

- bilanciamento

- BE

- dietro

- appartiene

- analisi comparativa

- beneficio

- vantaggi

- MIGLIORE

- entrambi

- ampio

- costruire

- Costruzione

- onere

- ma

- by

- Bandi

- Materiale

- Ultra-Grande

- casi

- certo

- il cambiamento

- Modifiche

- clienti

- codice

- COM

- arrivo

- componenti

- computer

- Visione computerizzata

- informatica

- concorrente

- Configurazione

- configurato

- considerazione

- considerando

- consiste

- Costi

- Creazione

- Corrente

- Attualmente

- Clienti

- Data

- deep

- apprendimento profondo

- Predefinito

- schierare

- schierato

- deployment

- implementazioni

- Design

- Determinare

- Mercato

- diverso

- discutere

- distribuito

- calcolo distribuito

- distribuzione

- domini

- durante

- dinamicamente

- ogni

- in maniera efficace

- in modo efficiente

- sforzi

- enable

- abilitato

- incoraggiare

- da un capo all'altro

- endpoint

- ingegnere

- Inglese

- aziende

- valutare

- esempio

- Esperienze

- ha spiegato

- estremamente

- famiglia

- Caratteristiche

- Infine

- Trovate

- si concentra

- i seguenti

- Nel

- fondamentale

- da

- completamente

- Generale

- genera

- generativo

- AI generativa

- gif

- dato

- grafico

- Crescita

- Avere

- he

- aiuta

- suo

- Alta

- lui

- il suo

- host

- ospitato

- Come

- Tutorial

- HTML

- HTTPS

- centinaia

- identificare

- if

- illustra

- competenze

- miglioramento

- miglioramenti

- miglioramento

- in

- Compreso

- In arrivo

- è aumentato

- India

- esempio

- Intelligence

- interattivo

- interesse

- ai miglioramenti

- IT

- SUO

- jpg

- mantenere

- bambini

- Lingua

- grandi

- Grandi imprese

- Latenza

- con i più recenti

- lancio

- principale

- IMPARARE

- apprendimento

- meno

- Lives

- caricare

- lotto

- inferiore

- macchina

- machine learning

- FA

- gestire

- gestito

- direttore

- modo

- Maggio..

- misurare

- meccanismo

- millisecondi

- minuto

- Minuti

- ML

- modello

- modelli

- monitoraggio

- Scopri di più

- multiplo

- New

- nlp

- no

- adesso

- numero

- of

- Offerte

- di frequente

- on

- operativa

- OTTIMIZZA

- Opzione

- or

- organizzazioni

- nostro

- su

- all'aperto

- al di fuori

- eccezionale

- ancora

- complessivo

- parametro

- particolare

- appassionato

- per

- performance

- piante

- Platone

- Platone Data Intelligence

- PlatoneDati

- politica

- possibile

- Post

- presenti

- Direttore

- problemi

- Prodotto

- product manager

- Produzione

- istruzioni

- casuale

- che vanno

- piuttosto

- tempo reale

- ricevere

- raccomandare

- Ridotto

- riferimento

- Indipendentemente

- relazionato

- richiesta

- richieste

- risposta

- risposte

- strada

- instradamento

- Correre

- sagemaker

- Scala

- cerca

- prodotti

- anziano

- servire

- servizio

- Servizi

- set

- regolazione

- lei

- ha mostrato

- mostrato

- Spettacoli

- smart

- Software

- lo sviluppo del software

- Soluzioni

- tensione

- Startup

- soggiorno

- lineare

- strategie

- Strategia

- tale

- supportato

- supporti

- SISTEMI DI TRATTAMENTO

- tavolo

- presa

- Parlare

- team

- Tecnologia

- test

- test

- di

- che

- Il

- L'area

- loro

- Là.

- Strumenti Bowman per analizzare le seguenti finiture:

- questo

- portata

- tempo

- a

- traffico

- Di viaggio

- tendenze

- Tipi di

- utenti

- utilizzando

- Valori

- variabile

- molto

- visione

- we

- sito web

- servizi web

- WELL

- sono stati

- quando

- quale

- while

- volere

- con

- Lavora

- lavorato

- flussi di lavoro

- lavoro

- lavori

- Tu

- Trasferimento da aeroporto a Sharm

- zefiro

- zone