Il boom dell'IA generativa è legato al calcolo. Ha la proprietà unica che l'aggiunta di più calcolo si traduce direttamente in un prodotto migliore. Di solito, l'investimento in ricerca e sviluppo è più direttamente legato al valore di un prodotto e tale relazione è marcatamente sublineare. Ma attualmente non è così con l'intelligenza artificiale e, di conseguenza, un fattore predominante che guida l'industria oggi è semplicemente il costo della formazione e dell'inferenza.

Anche se non conosciamo i numeri veri, abbiamo sentito da fonti attendibili che l'offerta di calcolo è così limitata che la domanda la supera di un fattore 10 (!) Quindi pensiamo sia giusto dire che, in questo momento, l'accesso alle risorse di elaborazione, al minor costo totale, è diventato un fattore determinante per il successo delle aziende di intelligenza artificiale.

In effetti, abbiamo visto molte aziende spendere più dell'80% del loro capitale totale raccolto in risorse di calcolo!

In questo post, proviamo ad abbattere i fattori di costo per un'azienda di intelligenza artificiale. I numeri assoluti cambieranno ovviamente nel tempo, ma non vediamo un sollievo immediato dal fatto che le aziende di intelligenza artificiale siano vincolate dal loro accesso alle risorse di calcolo. Quindi, si spera, questo è un quadro utile per riflettere sul paesaggio.

Perché i modelli AI sono così computazionalmente costosi?

Esiste un'ampia varietà di modelli di intelligenza artificiale generativa e i costi di inferenza e formazione dipendono dalle dimensioni e dal tipo di modello. Fortunatamente, i modelli più popolari oggi sono per lo più architetture basate su trasformatore, che includono popolari modelli di linguaggio di grandi dimensioni (LLM) come GPT-3, GPT-J o BERT. Mentre il numero esatto di operazioni per l'inferenza e l'apprendimento dei trasformatori è specifico del modello (vedi questo documento), esiste una regola empirica abbastanza precisa che dipende solo dal numero di parametri (ovvero i pesi delle reti neurali) del modello e dal numero di token di input e output.

I token sono essenzialmente brevi sequenze di pochi caratteri. Corrispondono a parole o parti di parole. Il modo migliore per ottenere un'intuizione per i token è provare la tokenizzazione con tokenizzatori online pubblicamente disponibili (ad es. OpenAI). Per GPT-3, la lunghezza media di un token è di 4 caratteri.

La regola pratica per i trasformatori è che un passaggio in avanti (cioè l'inferenza) per un modello con p parametri per una sequenza di input e di output di lunghezza n token ogni, impiega circa 2*n*p operazioni in virgola mobile (FLOPS)¹. L'addestramento per lo stesso modello richiede circa 6*pag FLOPS per token (ovvero, il passaggio all'indietro aggiuntivo richiede altre quattro operazioni²). È possibile approssimare il costo totale dell'addestramento moltiplicandolo per la quantità di token nei dati di addestramento.

I requisiti di memoria per i trasformatori dipendono anche dalle dimensioni del modello. Per l'inferenza, abbiamo bisogno di p parametri del modello da inserire nella memoria. Per l'apprendimento (cioè la propagazione all'indietro), abbiamo bisogno di memorizzare ulteriori valori intermedi per parametro tra il passaggio in avanti e all'indietro. Supponendo di utilizzare numeri in virgola mobile a 32 bit, si tratta di 8 byte aggiuntivi per parametro. Per addestrare un modello da 175 miliardi di parametri, avremmo bisogno di conservare più di un terabyte di dati in memoria: questo supera qualsiasi GPU esistente oggi e ci richiede di suddividere il modello tra le schede. I requisiti di memoria per l'inferenza e l'addestramento possono essere ottimizzati utilizzando valori in virgola mobile di lunghezze inferiori, con 16 bit che diventano comuni e 8 bit previsti nel prossimo futuro.

La tabella sopra mostra dimensioni e costi di calcolo per diversi modelli popolari. GPT-3 ha circa 175 miliardi di parametri, che per un input e un output di 1,024 token, si traduce in un costo computazionale di circa 350 trilioni di operazioni in virgola mobile (ovvero, Teraflop o TFLOPS). L'addestramento di un modello come GPT-3 richiede circa 3.14*10^23 operazioni in virgola mobile. Altri modelli come LLaMA di Meta ce l'hanno anche più alto requisiti di calcolo. L'addestramento di un tale modello è uno dei compiti più computazionalmente intensi che l'umanità abbia intrapreso finora.

Per riassumere: l'infrastruttura AI è costosa perché i problemi algoritmici sottostanti sono estremamente difficili dal punto di vista computazionale. La complessità algoritmica dell'ordinamento di una tabella di database con un milione di voci è insignificante rispetto alla complessità della generazione di una singola parola con GPT-3. Ciò significa che vuoi scegliere il modello più piccolo che risolva il tuo caso d'uso.

La buona notizia è che, per i trasformatori, possiamo facilmente stimare la quantità di calcolo e memoria che un modello di una certa dimensione consumerà. E, quindi, scegliere l'hardware giusto diventa la considerazione successiva.

L'argomento tempo e costo per le GPU

Come si traduce la complessità computazionale nel tempo? Un core del processore può in genere eseguire 1-2 istruzioni per ciclo e le frequenze di clock del processore sono rimaste stabili intorno ai 3 GHz negli ultimi 15 anni a causa della fine del Dennard ridimensionamento. L'esecuzione di una singola operazione di inferenza GPT-3 senza sfruttare alcuna architettura parallela richiederebbe circa 350 TFLOPS/(3 GHz*1 FLOP) o 116,000 secondi o 32 ore. Questo è estremamente poco pratico; invece abbiamo bisogno di chip specializzati che accelerino questo compito.

In pratica, tutti i modelli di IA oggi girano su schede che utilizzano un numero molto elevato di core specializzati. Ad esempio, una GPU NVIDIA A100 ha 512 "tensor core" in grado di eseguire una moltiplicazione di matrice 4×4 (che equivale a 64 moltiplicazioni e addizioni o 128 FLOPS) in un singolo ciclo. Le schede di accelerazione AI sono spesso chiamate GPU (unità di elaborazione grafica), poiché l'architettura è stata originariamente sviluppata per i giochi desktop. In futuro ci aspettiamo che l'IA diventi sempre più una famiglia di prodotti distinta.

L'A100 ha una prestazione nominale di 312 TFLOPS che in teoria ridurrebbe l'inferenza per GPT-3 a circa 1 secondo. Tuttavia questo è un calcolo eccessivamente semplificato per diversi motivi. Innanzitutto, per la maggior parte dei casi d'uso, il collo di bottiglia non è la potenza di calcolo della GPU, ma la capacità di trasferire i dati dalla memoria grafica specializzata ai tensor core. In secondo luogo, i 175 miliardi di pesi occuperebbero 700 GB e non entrerebbero nella memoria grafica di nessuna GPU. È necessario utilizzare tecniche come il partizionamento e lo streaming del peso. E, in terzo luogo, ci sono una serie di ottimizzazioni (ad esempio, utilizzando rappresentazioni in virgola mobile più brevi, come FP16, FP8 o matrici sparse) che vengono utilizzate per accelerare il calcolo. Ma, nel complesso, la matematica di cui sopra ci dà un'intuizione del costo di calcolo complessivo degli LLM di oggi.

L'addestramento di un modello di trasformatore richiede circa tre volte il tempo per token rispetto all'inferenza. Tuttavia, dato che il set di dati di addestramento è circa 300 milioni di volte più grande di un prompt di inferenza, l'addestramento richiede più tempo di un fattore 1 miliardo. Su una singola GPU, la formazione richiederebbe decenni; in pratica questo viene fatto su grandi cluster di calcolo in data center dedicati o, più probabilmente, nel cloud. L'addestramento è anche più difficile da parallelizzare rispetto all'inferenza, poiché i pesi aggiornati devono essere scambiati tra i nodi. La memoria e la larghezza di banda tra le GPU diventano spesso un fattore molto più importante, con interconnessioni ad alta velocità e fabric dedicati che sono comuni. Per l'addestramento di modelli molto grandi, la creazione di una configurazione di rete adeguata può essere la sfida principale. Guardando al futuro, gli acceleratori di intelligenza artificiale avranno capacità di rete sulla scheda o addirittura sul chip.

Come si traduce questa complessità computazionale in un costo? Un'inferenza GPT-3, che, come abbiamo visto sopra, impiega circa 1 secondo su un A100 avrebbe un costo di calcolo grezzo compreso tra $ 0.0002 e $ 0.0014 per 1,000 token (questo rispetto al prezzo di OpenAI di $ 0.002/1000 token). Un utente che genera 100 richieste di inferenza al giorno costerebbe nell'ordine di dollari all'anno. Questo è un prezzo molto basso e rende finanziariamente fattibili la maggior parte dei casi d'uso dell'intelligenza artificiale basata su testo da parte degli esseri umani.

Training GPT-3, d'altra parte, è molto più costoso. Anche in questo caso, calcolando solo il costo di calcolo per 3.14*10^23 FLOPS alle tariffe sopra citate, otteniamo una stima di $ 560,000 su schede A100 per un singola corsa di allenamento. In pratica, per l'addestramento non otterremo quasi il 100% di efficienza nella GPU; tuttavia possiamo anche utilizzare le ottimizzazioni per ridurre i tempi di addestramento. Altre stime del costo della formazione GPT-3 vanno da $500,000 a $ 4.6 milioni, a seconda delle ipotesi hardware. Si noti che questo è il costo di una singola esecuzione e non il costo complessivo. Probabilmente saranno necessarie più esecuzioni e i fornitori di servizi cloud vorranno impegni a lungo termine (maggiori informazioni di seguito). La formazione di modelli di punta rimane costosa, ma alla portata di una start-up ben finanziata.

Per riassumere, l'IA generativa richiede oggi massicci investimenti nell'infrastruttura AI. Non c'è motivo di credere che questo cambierà nel prossimo futuro. L'addestramento di un modello come GPT-3 è uno dei compiti più computazionalmente intensi che l'umanità abbia mai intrapreso. E mentre le GPU stanno diventando più veloci e troviamo modi per ottimizzare l'addestramento, la rapida espansione dell'IA annulla entrambi questi effetti.

Considerazioni per l'infrastruttura AI

A questo punto, abbiamo cercato di darti un'idea della scala richiesta per eseguire l'addestramento e l'inferenza dei modelli di intelligenza artificiale e quali parametri sottostanti li guidano. In tale contesto, vogliamo ora fornire alcune indicazioni pratiche su come decidere quale infrastruttura AI utilizzare.

Infrastruttura esterna vs. interna

Ammettiamolo: le GPU sono fantastiche. Molti ingegneri e fondatori di mentalità ingegneristica hanno una propensione verso il provisioning del proprio hardware AI, non solo perché offre un controllo granulare sull'addestramento del modello, ma perché c'è qualcosa di divertente nello sfruttare grandi quantità di potenza di calcolo (mostra A).

La realtà, tuttavia, è quella molte startup, in particolare le società di app, non hanno bisogno di costruire la propria infrastruttura AI il giorno 1. Invece, servizi di modelli ospitati come OpenAI o Hugging Face (per la lingua) e Replicate (per la generazione di immagini) consentono ai fondatori di cercare rapidamente l'adattamento del prodotto al mercato senza la necessità di gestire l'infrastruttura o i modelli sottostanti.

Questi servizi sono diventati così buoni che molte aziende non si diplomano mai. Gli sviluppatori possono ottenere un controllo significativo sulle prestazioni del modello attraverso l'ingegneria rapida e le astrazioni di fine tuning di ordine superiore (ad esempio, fine tuning tramite chiamate API). Il prezzo di questi servizi è basato sul consumo, quindi spesso è anche più economico rispetto alla gestione di un'infrastruttura separata. Abbiamo visto aziende di app generare più di $ 50 milioni di ARR e valutare oltre $ 1 miliardo, che gestiscono servizi di modelli ospitati sotto il cofano.

Il rovescio della medaglia, alcune startup, in particolare coloro che addestrano nuovi modelli di base o creano applicazioni AI integrate verticalmente non possono evitare di eseguire direttamente i propri modelli sulle GPU. O perché il modello è effettivamente il prodotto e il team è alla ricerca di "adattamento al mercato del modello" o perché è necessario un controllo granulare sull'addestramento e/o sull'inferenza per raggiungere determinate capacità o ridurre il costo marginale su larga scala. In ogni caso, la gestione dell'infrastruttura può diventare una fonte di vantaggio competitivo.

Il cloud e il data center si costruiscono

Nella maggior parte dei casi, il cloud è il posto giusto per la tua infrastruttura AI. La riduzione dei costi iniziali, la possibilità di aumentare e diminuire la scalabilità, la disponibilità regionale e una minore distrazione dalla creazione del proprio data center sono fattori interessanti per la maggior parte delle startup e delle aziende più grandi.

Ma ci sono alcune eccezioni a questa regola:

- Se si opera su larga scala, potrebbe essere più conveniente gestire il proprio data center. Il prezzo esatto varia in base alla posizione geografica e alla configurazione, ma in genere richiede una spesa infrastrutturale superiore a 50 milioni di dollari all'anno.

- Hai bisogno di hardware molto specifico che non puoi ottenere da un provider di servizi cloud. Ad esempio, tipi di GPU che non sono ampiamente disponibili, nonché requisiti di memoria, archiviazione o rete insoliti.

- Non è possibile trovare un cloud accettabile per considerazioni geopolitiche.

Se vuoi costruire il tuo data center, ci sono state analisi complete del rapporto prezzo/prestazioni delle GPU per la tua configurazione (ad es. L'analisi di Tim Dettmer). Oltre al costo e alle prestazioni della scheda stessa, la scelta dell'hardware dipende anche dall'alimentazione, dallo spazio e dal raffreddamento. Ad esempio, due schede RTX 3080 Ti insieme hanno una capacità di elaborazione grezza simile a un A100, ma il rispettivo consumo energetico è di 700 W contro 300 W. La differenza di potenza di 3,500 kWh a tariffe di mercato di $ 0.10/kWh su un ciclo di vita di tre anni aumenta il costo dell'RTX3080 Ti di quasi 2 volte (circa $ 1,000).

Detto questo, ci aspettiamo che la stragrande maggioranza delle startup utilizzi il cloud computing.

Confronto tra i fornitori di servizi cloud

Amazon Web Services (AWS), Microsoft Azure e Google Cloud Platform (GCP) offrono tutti istanze GPU, ma sembra che anche nuovi fornitori si concentrino specificamente sui carichi di lavoro AI. Ecco un framework che abbiamo visto utilizzare da molti fondatori per scegliere un fornitore di servizi cloud:

Prezzo: La tabella seguente mostra i prezzi per una serie di cloud speciali principali e minori a partire dal 7 aprile 2023. Questi dati sono solo indicativi, poiché le istanze variano notevolmente in termini di larghezza di banda di rete, costi di uscita dei dati, costo aggiuntivo da CPU e rete, disponibilità sconti e altri fattori.

La capacità di elaborazione su hardware specifico è una merce. Ingenuamente, ci aspetteremmo prezzi abbastanza uniformi, ma non è così. E sebbene esistano sostanziali differenze di funzionalità tra i cloud, non sono sufficienti per spiegare che il prezzo per una NVIDIA A100 su richiesta varia di un fattore quasi 4 volte tra i fornitori.

All'estremità superiore della scala dei prezzi, i grandi cloud pubblici applicano un premio basato sulla reputazione del marchio, sull'affidabilità comprovata e sulla necessità di gestire un'ampia gamma di carichi di lavoro. I fornitori di intelligenza artificiale più piccoli offrono prezzi più bassi, gestendo data center appositamente costruiti (ad es. Coreweave) o arbitraggiando altri cloud (ad es. Lambda Labs).

In pratica, la maggior parte degli acquirenti più grandi negozia i prezzi direttamente con i fornitori di servizi cloud, spesso impegnandosi in alcuni requisiti di spesa minima e impegni di tempo minimi (abbiamo visto 1-3 anni). Le differenze di prezzo tra i cloud si riducono leggermente dopo la negoziazione, ma abbiamo visto che la classifica nella tabella sopra rimane relativamente stabile. È anche importante notare che le aziende più piccole possono ottenere prezzi aggressivi da cloud speciali senza grandi impegni di spesa.

Disponibilità: Le GPU più potenti (ad esempio, Nvidia A100) sono state costantemente scarse negli ultimi 12 e più mesi.

Sarebbe logico pensare che i primi tre fornitori di cloud abbiano la migliore disponibilità, dato il loro grande potere d'acquisto e il pool di risorse. Ma, in qualche modo sorprendentemente, molte startup non lo hanno trovato vero. I grandi cloud hanno molto hardware ma hanno anche grandi esigenze dei clienti da soddisfare (ad esempio, Azure è l'host principale per ChatGPT) e aggiungono/affittano costantemente capacità per soddisfare la domanda. Nel frattempo, Nvidia si è impegnata a rendere l'hardware ampiamente disponibile in tutto il settore, comprese le allocazioni per nuovi fornitori specializzati. (Lo fanno sia per essere onesti sia per ridurre la loro dipendenza da pochi grandi clienti che competono anche con loro.)

Di conseguenza, molte startup trovano più chip disponibili, inclusi gli Nvidia H100 all'avanguardia, presso fornitori di servizi cloud più piccoli. Se sei disposto a lavorare con una società di infrastrutture più recente, potresti essere in grado di ridurre i tempi di attesa per l'hardware e possibilmente risparmiare denaro nel processo.

Modello di consegna del calcolo: I grandi cloud oggi offrono solo istanze con GPU dedicate, il motivo è che la virtualizzazione delle GPU è ancora un problema irrisolto. I cloud IA specializzati offrono altri modelli, come container o processi batch, in grado di gestire singole attività senza sostenere i costi di avvio e smantellamento di un'istanza. Se ti senti a tuo agio con questo modello, puoi ridurre sostanzialmente i costi.

Interconnessioni di rete: Per la formazione, in particolare, la larghezza di banda della rete è un fattore importante nella selezione del provider. I cluster con fabric dedicati tra i nodi, come NVLink, sono necessari per addestrare determinati modelli di grandi dimensioni. Per la generazione di immagini, anche le tariffe per il traffico in uscita possono essere un fattore di costo importante.

Servizio Clienti: I grandi fornitori di cloud servono un enorme pool di clienti attraverso migliaia di SKU di prodotti. Può essere difficile attirare l'attenzione dell'assistenza clienti o risolvere un problema, a meno che tu non sia un grande cliente. Molti cloud AI specializzati, invece, offrono un supporto rapido e reattivo anche per i piccoli clienti. Ciò è in parte dovuto al fatto che operano su scala ridotta, ma anche perché i loro carichi di lavoro sono più omogenei, quindi sono più incentivati a concentrarsi su funzionalità e bug specifici dell'IA.

Confronto tra GPU

A parità di condizioni, le GPU di fascia alta funzioneranno al meglio su quasi tutti i carichi di lavoro. Tuttavia, come puoi vedere nella tabella sottostante, il miglior hardware è anche sostanzialmente più costoso. Scegliere il giusto tipo di GPU per la tua applicazione specifica può ridurre sostanzialmente i costi e può fare la differenza tra un modello di business fattibile e non fattibile.

Decidere fino a che punto scendere nell'elenco, ovvero determinare le scelte GPU più convenienti per la tua applicazione, è in gran parte una decisione tecnica che va oltre lo scopo di questo articolo. Ma condivideremo di seguito alcuni dei criteri di selezione che abbiamo visto essere i più importanti:

Formazione vs. inferenza: Come abbiamo visto nella prima sezione sopra, l'addestramento di un modello Transformer ci richiede di archiviare 8 byte di dati per l'addestramento oltre ai pesi del modello. Ciò significa che una tipica GPU consumer di fascia alta con 12 GB di memoria potrebbe a malapena essere utilizzata per addestrare un modello da 4 miliardi di parametri. In pratica, l'addestramento di modelli di grandi dimensioni viene eseguito su cluster di macchine con preferibilmente molte GPU per server, molta VRAM e connessioni a larghezza di banda elevata tra i server (ad esempio, cluster creati utilizzando GPU di data center di fascia alta).

In particolare, molti modelli saranno più convenienti su NVIDIA H100, ma ad oggi è difficile da trovare e di solito richiede un impegno a lungo termine di oltre un anno. L'NVIDIA A100 esegue oggi la maggior parte dell'addestramento dei modelli; è più facile da trovare ma, per i grandi cluster, può anche richiedere un impegno a lungo termine.

Requisiti di memoria: Gli LLM di grandi dimensioni hanno conteggi di parametri troppo alti per adattarsi a qualsiasi scheda. Devono essere suddivisi su più schede e richiedono una configurazione simile all'addestramento. In altre parole, probabilmente avrai bisogno di H100 o A100 anche per l'inferenza LLM. Ma i modelli più piccoli (ad esempio Stable Diffusion) richiedono molta meno VRAM. Sebbene l'A100 sia ancora popolare, abbiamo visto le startup utilizzare le schede A10, A40, A4000, A5000 e A6000 o persino RTX.

Supporto hardware: Mentre la stragrande maggioranza dei carichi di lavoro nelle aziende di cui abbiamo parlato viene eseguita su NVIDIA, alcuni hanno iniziato a sperimentare con altri fornitori. Il più comune è il TPU di Google, ma sembra che anche Gaudi 2 di Intel stia ottenendo una certa trazione. La sfida con questi fornitori è che le prestazioni del tuo modello dipendono spesso in larga misura dalla disponibilità di ottimizzazioni software per questi chip. Probabilmente dovrai fare un PoC per capire le prestazioni.

Requisiti di latenza: In generale, i carichi di lavoro meno sensibili alla latenza (ad esempio, l'elaborazione dei dati in batch o le applicazioni che non richiedono risposte interattive dell'interfaccia utente) possono utilizzare GPU meno potenti. Ciò può ridurre i costi di calcolo fino a 3-4 volte (ad esempio, confrontando A100 con A10 su AWS). Le app rivolte all'utente, d'altra parte, spesso necessitano di schede di fascia alta per offrire un'esperienza utente coinvolgente e in tempo reale. L'ottimizzazione dei modelli è spesso necessaria per portare i costi a un intervallo gestibile.

Spinosità: Le aziende di intelligenza artificiale generativa registrano spesso picchi drammatici nella domanda poiché la tecnologia è così nuova ed entusiasmante. Non è insolito vedere i volumi delle richieste aumentare di 10 volte al giorno, in base al rilascio di un nuovo prodotto, o crescere costantemente del 50% a settimana. La gestione di questi picchi è spesso più semplice sulle GPU di fascia bassa, poiché è probabile che su richiesta siano disponibili più nodi di calcolo. Spesso ha anche senso servire questo tipo di traffico con risorse a basso costo, a scapito delle prestazioni, se proviene da utenti meno coinvolti o meno ritentivi.

Modelli di ottimizzazione e schedulazione

Le ottimizzazioni del software possono influire enormemente sul tempo di esecuzione dei modelli e i guadagni di 10 volte non sono rari. Tuttavia, dovrai determinare quali metodi saranno più efficaci con il tuo particolare modello e sistema.

Alcune tecniche funzionano con una gamma piuttosto ampia di modelli. L'utilizzo di rappresentazioni in virgola mobile più corte (ad esempio, FP16 o FP8 rispetto all'originale FP32) o la quantizzazione (INT8, INT4, INT2) consente di ottenere una velocità che è spesso lineare con la riduzione dei bit. Ciò a volte richiede la modifica del modello, ma sono sempre più disponibili tecnologie che automatizzano il lavoro con una precisione mista o inferiore. L'eliminazione delle reti neurali riduce il numero di pesi ignorando i pesi con valori bassi. Insieme a un'efficiente moltiplicazione della matrice sparsa, questo può ottenere un notevole aumento della velocità sulle moderne GPU. Un'altra serie di tecniche di ottimizzazione affronta il collo di bottiglia della larghezza di banda della memoria (ad esempio, mediante lo streaming dei pesi del modello).

Altre ottimizzazioni sono altamente specifiche del modello. Ad esempio, Stable Diffusion ha fatto grandi progressi nella quantità di VRAM richiesta per l'inferenza. Ancora un'altra classe di ottimizzazioni è specifica per l'hardware. TensorML di NVIDIA include una serie di ottimizzazioni, ma funzionerà solo su hardware NVIDIA. Ultimo, ma non meno importante, la pianificazione delle attività di intelligenza artificiale può creare enormi colli di bottiglia o miglioramenti delle prestazioni. L'assegnazione di modelli alle GPU in modo da ridurre al minimo lo scambio di pesi, la scelta della GPU migliore per un'attività se sono disponibili più GPU e la riduzione al minimo dei tempi di inattività raggruppando in anticipo i carichi di lavoro sono tecniche comuni.

Alla fine, l'ottimizzazione del modello è ancora un po' un'arte nera e la maggior parte delle startup con cui parliamo lavora con terze parti per aiutare con alcuni di questi aspetti del software. Spesso non si tratta di fornitori tradizionali di MLops, ma di aziende specializzate nell'ottimizzazione di specifici modelli generativi (ad es. OctoML o SegMind).

Come si evolverà il costo dell'infrastruttura AI?

Negli ultimi anni abbiamo assistito a una crescita esponenziale di entrambi parametri del modello ed Potenza di calcolo della GPU. Non è chiaro se questa tendenza continuerà.

Oggi è ampiamente accettato che esista una relazione tra il numero ottimale di parametri e la dimensione del set di dati di addestramento (vedi Deepmind's cincilla lavorare di più su questo). I migliori LLM oggi sono formati su Scansione comune (una raccolta di 4.5 miliardi di pagine Web, ovvero circa il 10% di tutte le pagine Web esistenti). Il corpus formativo comprende anche Wikipedia e una raccolta di libri, sebbene entrambi siano molto più piccoli (il numero totale di libri esistenti è stimato in solo circa 100 milioni). Sono state suggerite altre idee, come la trascrizione di contenuti video o audio, ma nessuna di queste si avvicina per dimensioni. Non è chiaro se potremmo ottenere un set di dati di addestramento non sintetico 10 volte più grande di quello che è già stato utilizzato.

Le prestazioni della GPU continueranno ad aumentare, ma anche a un ritmo più lento. La legge di Moore è ancora intatta consentendo più transistor e più core, ma l'alimentazione e l'I/O stanno diventando fattori limitanti. Inoltre, sono stati raccolti molti dei frutti a portata di mano per le ottimizzazioni.

Tuttavia, niente di tutto ciò significa che non ci aspettiamo un aumento della domanda di capacità di calcolo. Anche se la crescita del modello e del training set rallenta, la crescita del settore dell'intelligenza artificiale e l'aumento del numero di sviluppatori di intelligenza artificiale alimenteranno la domanda di GPU sempre più veloci. Una grande frazione della capacità della GPU viene utilizzata per i test dagli sviluppatori durante la fase di sviluppo di un modello e questa domanda si adatta linearmente con l'organico. Non vi è alcun segno che la carenza di GPU che abbiamo oggi diminuirà nel prossimo futuro.

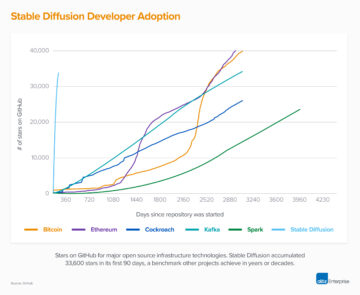

Questo continuo costo elevato dell'infrastruttura AI creerà un fossato che renderà impossibile per i nuovi entranti mettersi al passo con operatori storici ben finanziati? Non sappiamo ancora la risposta a questa domanda. Il costo della formazione di un LLM può sembrare un fossato oggi, ma i modelli open source come Alpaca o Stable Diffusion hanno dimostrato che questi mercati sono ancora agli inizi e potrebbero cambiare rapidamente. Nel tempo, la struttura dei costi dello stack di software IA emergente (vedere il nostro post precedente) potrebbe iniziare ad assomigliare di più all'industria del software tradizionale.

In definitiva, questa sarebbe una buona cosa: la storia ha dimostrato che questo porta a ecosistemi vivaci con una rapida innovazione e molte opportunità per i fondatori imprenditoriali.

Grazie a Moin Nadeem e Shangda Xu per il loro contributo e guida durante il processo di scrittura.

¹ L'intuizione qui è che per qualsiasi parametro (cioè peso) in una rete neurale, un'operazione di inferenza (cioè passaggio in avanti) deve eseguire due operazioni in virgola mobile per parametro. Innanzitutto, moltiplica il valore del nodo di input della rete neurale con il parametro. In secondo luogo, aggiunge il risultato della somma al nodo di output della rete neurale. I parametri nel codificatore vengono utilizzati una volta per token di input ei parametri nel decodificatore vengono utilizzati una volta per token di output. Se assumiamo che un modello abbia p i parametri e l'input e l'output hanno entrambi una lunghezza n token, le operazioni totali in virgola mobile sono n*p. Ci sono molte altre operazioni (ad es. normalizzazione, codifica/decodifica dell'incorporamento) che avvengono in un modello, ma il tempo necessario per eseguirle è piccolo in confronto.

² L'apprendimento richiede prima un passaggio in avanti attraverso il trasformatore come descritto sopra, seguito da un passaggio all'indietro che comporta quattro operazioni aggiuntive per parametro per calcolare il gradiente e regolare il peso. Si noti che il calcolo del gradiente richiede la conservazione dei valori dei nodi calcolati dal passaggio in avanti. Per GPT-3, I modelli linguistici sono studenti con pochi spari discute il costo della formazione.

* * *

Le opinioni qui espresse sono quelle del personale di AH Capital Management, LLC ("a16z") citato e non sono le opinioni di a16z o delle sue affiliate. Alcune informazioni qui contenute sono state ottenute da fonti di terze parti, incluse società in portafoglio di fondi gestiti da a16z. Sebbene tratti da fonti ritenute affidabili, a16z non ha verificato in modo indipendente tali informazioni e non fornisce dichiarazioni sull'accuratezza duratura delle informazioni o sulla loro adeguatezza per una determinata situazione. Inoltre, questo contenuto può includere pubblicità di terze parti; a16z non ha esaminato tali annunci pubblicitari e non approva alcun contenuto pubblicitario in essi contenuto.

Questo contenuto viene fornito solo a scopo informativo e non deve essere considerato come consulenza legale, commerciale, di investimento o fiscale. Dovresti consultare i tuoi consulenti in merito a tali questioni. I riferimenti a qualsiasi titolo o risorsa digitale sono solo a scopo illustrativo e non costituiscono una raccomandazione di investimento o un'offerta per fornire servizi di consulenza in materia di investimenti. Inoltre, questo contenuto non è diretto né destinato all'uso da parte di investitori o potenziali investitori e non può in alcun caso essere invocato quando si decide di investire in qualsiasi fondo gestito da a16z. (Un'offerta per investire in un fondo a16z sarà fatta solo dal memorandum di collocamento privato, dal contratto di sottoscrizione e da altra documentazione pertinente di tale fondo e dovrebbe essere letta nella sua interezza.) Eventuali investimenti o società in portafoglio menzionati, citati o descritti non sono rappresentativi di tutti gli investimenti in veicoli gestiti da a16z, e non si può garantire che gli investimenti saranno redditizi o che altri investimenti effettuati in futuro avranno caratteristiche o risultati simili. Un elenco degli investimenti effettuati da fondi gestiti da Andreessen Horowitz (esclusi gli investimenti per i quali l'emittente non ha autorizzato a16z a divulgare pubblicamente e gli investimenti non annunciati in asset digitali quotati in borsa) è disponibile all'indirizzo https://a16z.com/investments /.

Grafici e grafici forniti all'interno sono esclusivamente a scopo informativo e non dovrebbero essere presi in considerazione quando si prende una decisione di investimento. I rendimenti passati non sono indicativi di risultati futuri. Il contenuto parla solo a partire dalla data indicata. Eventuali proiezioni, stime, previsioni, obiettivi, prospettive e/o opinioni espresse in questi materiali sono soggette a modifiche senza preavviso e possono differire o essere contrarie alle opinioni espresse da altri. Si prega di consultare https://a16z.com/disclosures per ulteriori informazioni importanti.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoAiStream. Intelligenza dei dati Web3. Conoscenza amplificata. Accedi qui.

- Coniare il futuro con Adryenn Ashley. Accedi qui.

- Fonte: https://a16z.com/2023/04/27/navigating-the-high-cost-of-ai-compute/

- :ha

- :È

- :non

- $1 miliardi

- $ SU

- 000

- 1

- 100

- 116

- 15 anni

- 2023

- 500

- 7

- 8

- a

- a16z

- capacità

- capace

- WRI

- sopra

- Assoluta

- accelerare

- acceleratore

- acceleratori

- accettabile

- accettato

- accesso

- precisione

- preciso

- Raggiungere

- operanti in

- l'aggiunta di

- aggiunta

- aggiuntivo

- Inoltre

- integrazioni

- indirizzi

- Aggiunge

- avanzare

- avanzamenti

- Vantaggio

- Pubblicità

- consigli

- consultivo

- servizi di consulenza

- influenzare

- affiliati

- Dopo shavasana, sedersi in silenzio; saluti;

- ancora

- aggressivo

- Accordo

- AI

- algoritmica

- Tutti

- allocazioni

- Consentire

- già

- anche

- Sebbene il

- tra

- quantità

- importi

- an

- .

- ed

- Andreessen

- Andreessen Horowitz

- Un altro

- rispondere

- Anticipato

- in qualsiasi

- api

- App

- apparendo

- appare

- Applicazioni

- applicazioni

- circa

- applicazioni

- Aprile

- architettura

- SONO

- argomento

- in giro

- Arte

- articolo

- artificiale

- intelligenza artificiale

- AS

- aspetti

- Attività

- garanzia

- At

- attenzione

- Audio

- automatizzare

- disponibilità

- disponibile

- media

- evitare

- AWS

- azzurro

- Larghezza di banda

- basato

- BE

- perché

- diventare

- diventa

- diventando

- stato

- essendo

- CREDIAMO

- creduto

- sotto

- MIGLIORE

- Meglio

- fra

- Al di là di

- pregiudizio

- Big

- Miliardo

- Po

- Nero

- Libri

- boom

- entrambi

- Bound

- marca

- Rompere

- portare

- ampio

- in linea di massima

- bug

- costruire

- Costruzione

- costruito

- affari

- modello di business

- ma

- acquirenti

- by

- calcolare

- calcolato

- calcolo

- Bandi

- Materiale

- Può ottenere

- non può

- funzionalità

- Ultra-Grande

- capitale

- carta

- Carte

- Custodie

- casi

- lotta

- centro

- centri

- certo

- Challenge

- il cambiamento

- caratteristiche

- caratteri

- carica

- ChatGPT

- più economico

- patata fritta

- Chips

- scelte

- Scegli

- condizioni

- classe

- pulire campo

- Orologio

- Chiudi

- Cloud

- il cloud computing

- cloud Platform

- collezione

- Venire

- viene

- confortevole

- impegno

- impegnata

- commettere

- merce

- Uncommon

- Aziende

- azienda

- rispetto

- confronto

- confronto

- avvincente

- competere

- competitivo

- complessità

- globale

- calcolo

- Calcolare

- informatica

- potenza di calcolo

- Connessioni

- considerazione

- Considerazioni

- costantemente

- costituire

- consumare

- Consumer

- consumo

- Tecnologie Container

- contenuto

- contesto

- continua

- continua

- contrario

- di controllo

- Froids

- Nucleo

- Costo

- costo effettivo

- Costi

- potuto

- Portata

- creare

- Creazione

- criteri

- Attualmente

- cliente

- Assistenza clienti

- Clienti

- bordo tagliente

- ciclo

- dati

- Banca dati

- data center

- elaborazione dati

- set di dati

- Banca Dati

- Data

- giorno

- decenni

- decide

- decisione

- dedicato

- DeepMind

- consegnare

- consegna

- Richiesta

- dipendenza

- dipendente

- Dipendente

- dipende

- descritta

- tavolo

- Determinare

- determinazione

- sviluppato

- sviluppatori

- Mercato

- differire

- differenza

- differenze

- Emittente

- digitale

- Risorse digitali

- direttamente

- Rilevare

- sconti

- distinto

- do

- documentazione

- effettua

- fare

- dollari

- fatto

- Dont

- giù

- i tempi di inattività

- drammaticamente

- guidare

- autista

- guida

- dovuto

- durante

- e

- Presto

- più facile

- facilmente

- ecosistemi

- Efficace

- in maniera efficace

- effetti

- efficienza

- efficiente

- o

- incorporamento

- emergenti del mondo

- fine

- approvare

- duraturo

- impegnato

- impegnandosi

- Ingegneria

- Ingegneri

- interezza

- arrivo

- imprenditoriale

- Equivalente

- particolarmente

- essenzialmente

- stima

- stimato

- stime

- Anche

- EVER

- evolvere

- esempio

- supera

- coinvolgenti

- esclusa

- eseguire

- esecuzione

- esistere

- espansione

- attenderti

- costoso

- esperienza

- Spiegare

- esponenziale

- Crescita esponenziale

- espresso

- estremamente

- Tessuti

- Faccia

- Fattori

- fiera

- abbastanza

- famiglia

- FAST

- più veloce

- caratteristica

- Caratteristiche

- Costi

- pochi

- finanziariamente

- Trovate

- sottile

- Nome

- in forma

- fisso

- Capovolgere

- galleggiante

- Focus

- seguito

- Nel

- le previsioni

- per fortuna

- Avanti

- essere trovato

- Fondazione

- fondatori

- quattro

- frazione

- Contesto

- da

- Carburante

- ti divertirai

- fondo

- fondi

- Inoltre

- futuro

- Guadagni

- gaming

- Generale

- la generazione di

- ELETTRICA

- generativo

- AI generativa

- geografico

- geopolitica

- ottenere

- ottenere

- Dare

- dato

- dà

- Go

- buono

- Google cloud

- Google Cloud Platform

- GPU

- GPU

- laurea

- grafiche

- grafici

- Crescere

- Crescita

- guida

- cura

- maniglia

- Manovrabilità

- accadere

- Hard

- Hardware

- Sfruttamento

- Avere

- censimento

- sentito

- Aiuto

- utile

- qui

- Alta

- High-End

- vivamente

- storia

- cappuccio

- Fiduciosamente

- Horowitz

- host

- ospitato

- ORE

- Come

- Tutorial

- Tuttavia

- HTML

- HTTPS

- Enorme

- Enormemente

- Gli esseri umani

- i

- idee

- if

- Immagine

- immediato

- importante

- impossibile

- miglioramenti

- in

- In altre

- incentivato

- includere

- inclusi

- Compreso

- Aumento

- Aumenta

- sempre più

- indipendentemente

- indicato

- individuale

- industria

- informazioni

- Informativo

- Infrastruttura

- Innovazione

- ingresso

- esempio

- invece

- istruzioni

- integrato

- Intelligence

- interattivo

- ai miglioramenti

- Investire

- investimento

- consulenza per gli investimenti

- Investimenti

- Investitori

- Emittente

- IT

- SUO

- stessa

- Offerte di lavoro

- ad appena

- mantenere

- Genere

- Sapere

- Labs

- paesaggio

- Lingua

- grandi

- maggiormente

- superiore, se assunto singolarmente.

- Cognome

- Latenza

- Legge

- Leads

- apprendimento

- Legale

- Lunghezza

- Vita

- piace

- probabile

- Lista

- Lama

- LLM

- località

- logico

- Lunghi

- a lungo termine

- più a lungo

- Guarda

- una

- cerca

- lotto

- Basso

- inferiore

- minore

- macchine

- fatto

- maggiore

- Maggioranza

- make

- FA

- Fare

- gestire

- gestito

- gestione

- gestione

- umanità

- molti

- Rappresentanza

- Mercati

- massiccio

- Materiale

- matematica

- Matrice

- Matters

- max-width

- Maggio..

- significativo

- si intende

- Nel frattempo

- Soddisfare

- Memorandum

- Memorie

- menzionato

- metodi

- Microsoft

- Microsoft Azure

- milione

- minimizzando

- ordine

- misto

- MLOp

- modello

- modelli

- moderno

- soldi

- mese

- Scopri di più

- maggior parte

- Più popolare

- molti

- multiplo

- moltiplicando

- navigazione

- Vicino

- quasi

- necessaria

- Bisogno

- di applicazione

- esigenze

- Rete

- internazionale

- reti

- rete neurale

- reti neurali

- New

- nuovo prodotto

- notizie

- GENERAZIONE

- no

- nodo

- nodi

- Avviso..

- adesso

- numero

- numeri

- Nvidia

- ottenere

- ottenuto

- of

- offrire

- offerta

- di frequente

- on

- On-Demand

- una volta

- ONE

- online

- esclusivamente

- aprire

- open source

- OpenAI

- operativo

- operazione

- Operazioni

- Opinioni

- Opportunità

- ottimale

- ottimizzazione

- OTTIMIZZA

- ottimizzati

- ottimizzazione

- or

- minimo

- i

- originariamente

- Altro

- Altri

- nostro

- su

- produzione

- supera

- ancora

- complessivo

- proprio

- Parallel

- parametro

- parametri

- particolare

- parti

- Ricambi

- passare

- passato

- Eseguire

- performance

- autorizzazione

- Personale

- fase

- scegliere

- raccolto

- posto

- piattaforma

- Platone

- Platone Data Intelligence

- PlatoneDati

- per favore

- PoC

- punto

- pool

- Popolare

- lavori

- forse

- Post

- energia

- potente

- Pratico

- pratica

- Precisione

- Premium

- precedente

- prezzo

- Prezzi

- prezzi

- primario

- un bagno

- probabilmente

- Problema

- problemi

- processi

- lavorazione

- Processore

- Prodotto

- redditizio

- proiezioni

- proprietà

- potenziale

- prospettive

- comprovata

- fornire

- purché

- fornitore

- fornitori

- la percezione

- pubblicamente

- acquisto

- fini

- domanda

- rapidamente

- R&D

- sollevato

- gamma

- Posizione

- veloce

- rapidamente

- tasso

- Crudo

- raggiungere

- Leggi

- tempo reale

- Realtà

- ragione

- motivi

- Consigli

- ridurre

- riduce

- Riferimenti

- di cui

- regionale

- rapporto

- relativamente

- rilasciare

- pertinente

- problemi di

- affidabile

- sollievo

- rimanere

- resti

- rappresentante

- rispettabile

- reputazione

- richiesta

- richieste

- richiedere

- necessario

- requisito

- Requisiti

- richiede

- Risorse

- quelli

- di risposta

- colpevole

- Risultati

- rivisto

- rtx

- RTX 3080

- RTX 3080 Ti

- Regola

- Correre

- running

- Suddetto

- stesso

- Risparmi

- Scala

- bilancia

- programmazione

- portata

- Cerca

- ricerca

- Secondo

- secondo

- Sezione

- Valori

- vedere

- visto

- prodotti

- senso

- delicata

- separato

- Sequenza

- servire

- Server

- servizio

- Servizi

- set

- flessibile.

- alcuni

- Condividi

- Corti

- carenza

- dovrebbero

- mostrato

- Spettacoli

- lato

- segno

- simile

- semplicemente

- da

- singolo

- situazione

- Taglia

- Dimensioni

- rallenta

- piccole

- inferiore

- So

- finora

- Software

- risolve

- alcuni

- qualcosa

- piuttosto

- Fonte

- fonti

- lo spazio

- parlando

- Parla

- specializzarsi

- specializzata

- Specialità

- specifico

- in particolare

- spendere

- Spendere

- picchi

- dividere

- stabile

- pila

- inizia a

- Start-up

- iniziato

- Startup

- Ancora

- conservazione

- Tornare al suo account

- Streaming

- La struttura

- soggetto

- sottoscrizione

- sostanziale

- il successo

- tale

- adatto

- riassumere

- fornire

- supporto

- sistema

- tavolo

- Fai

- prende

- Parlare

- obiettivi

- Task

- task

- imposta

- team

- Consulenza

- tecniche

- Tecnologie

- Tecnologia

- condizioni

- Testing

- di

- che

- Il

- Il futuro

- le informazioni

- Il paesaggio

- loro

- Li

- Là.

- in essa

- Strumenti Bowman per analizzare le seguenti finiture:

- di

- cosa

- think

- Pensiero

- Terza

- terzi

- di parti terze standard

- questo

- quelli

- migliaia

- tre

- Attraverso

- Legato

- tempo

- volte

- a

- oggi

- di oggi

- insieme

- token

- tokenizzazione

- Tokens

- pure

- top

- Totale

- verso

- trazione

- negoziate

- tradizionale

- traffico

- Treni

- allenato

- Training

- trasformatori

- tradurre

- Trend

- provato

- Trilione

- vero

- seconda

- Digitare

- Tipi di

- tipico

- tipicamente

- ui

- Raro

- per

- sottostante

- capire

- unico

- unità

- aggiornato

- su

- us

- uso

- caso d'uso

- utilizzato

- Utente

- Esperienza da Utente

- utenti

- utilizzando

- generalmente

- Prezioso

- APPREZZIAMO

- valutato

- Valori

- varietà

- Fisso

- Veicoli

- fornitori

- verificato

- verticalmente

- molto

- vitale

- vivace

- Video

- visualizzazioni

- volumi

- vs

- aspettare

- volere

- Prima

- Modo..

- modi

- we

- sito web

- servizi web

- settimana

- peso

- WELL

- Che

- quando

- quale

- while

- OMS

- largo

- Vasta gamma

- ampiamente

- wikipedia

- volere

- disposto

- con

- entro

- senza

- Word

- parole

- Lavora

- lavoro

- sarebbe

- scrittura

- anno

- anni

- ancora

- Tu

- Trasferimento da aeroporto a Sharm

- zefiro