Introduzione

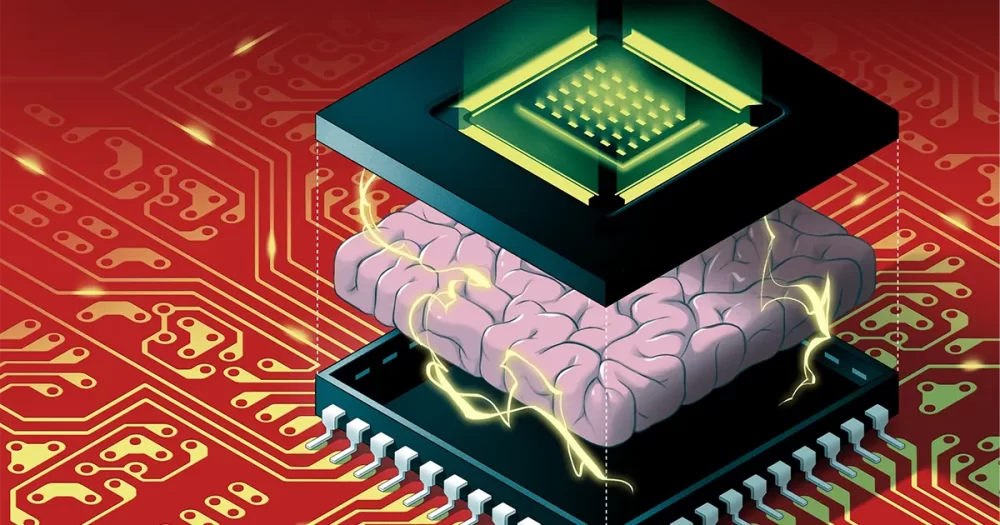

Gli algoritmi di intelligenza artificiale non possono continuare a crescere al ritmo attuale. Algoritmi come le reti neurali profonde - che sono vagamente ispirate al cervello, con più strati di neuroni artificiali collegati tra loro tramite valori numerici chiamati pesi - diventano più grandi ogni anno. Ma al giorno d'oggi, i miglioramenti hardware non tengono più il passo con l'enorme quantità di memoria e capacità di elaborazione richieste per eseguire questi enormi algoritmi. Presto, la dimensione degli algoritmi di intelligenza artificiale potrebbe colpire un muro.

E anche se potessimo continuare ad aumentare l'hardware per soddisfare le richieste dell'IA, c'è un altro problema: eseguirli su computer tradizionali spreca un'enorme quantità di energia. Le elevate emissioni di carbonio generate dall'esecuzione di algoritmi di intelligenza artificiale di grandi dimensioni sono già dannose per l'ambiente e peggioreranno solo quando gli algoritmi diventeranno sempre più giganteschi.

Una soluzione, chiamata informatica neuromorfica, si ispira ai cervelli biologici per creare progetti ad alta efficienza energetica. Sfortunatamente, mentre questi chip possono superare i computer digitali nel risparmio energetico, non hanno la potenza di calcolo necessaria per far funzionare una rete neurale profonda considerevole. Questo li ha resi facili da trascurare per i ricercatori di intelligenza artificiale.

Che finalmente è cambiato in agosto, quando Weier Wan, H.-S. Filippo Wong, Gert Cauwenberghs e i loro colleghi ha rivelato un nuovo chip neuromorfico chiamato NeuRRAM che include 3 milioni di celle di memoria e migliaia di neuroni integrati nel suo hardware per eseguire algoritmi. Utilizza un tipo di memoria relativamente nuovo chiamato RAM resistiva o RRAM. A differenza dei precedenti chip RRAM, NeuRRAM è programmato per funzionare in modo analogico per risparmiare più energia e spazio. Sebbene la memoria digitale sia binaria, che memorizza un 1 o uno 0, le celle di memoria analogiche nel chip NeuRRAM possono memorizzare ciascuna più valori lungo un intervallo completamente continuo. Ciò consente al chip di archiviare più informazioni da enormi algoritmi di intelligenza artificiale nella stessa quantità di spazio per il chip.

Di conseguenza, il nuovo chip può funzionare come i computer digitali su complesse attività di intelligenza artificiale come il riconoscimento di immagini e voce e gli autori affermano che è fino a 1,000 volte più efficiente dal punto di vista energetico, aprendo la possibilità a piccoli chip di eseguire algoritmi sempre più complicati all'interno di piccoli dispositivi precedentemente non adatti all'IA come smartwatch e telefoni.

I ricercatori non coinvolti nel lavoro sono rimasti profondamente colpiti dai risultati. "Questo documento è piuttosto unico", ha detto Zhongrui Wang, ricercatore RRAM di lunga data presso l'Università di Hong Kong. "Offre contributi a diversi livelli: a livello di dispositivo, a livello di architettura del circuito e a livello di algoritmo".

Creare nuovi ricordi

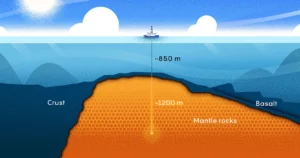

Nei computer digitali, l'enorme quantità di energia sprecata durante l'esecuzione di algoritmi di intelligenza artificiale è causata da un difetto di progettazione semplice e onnipresente che rende inefficiente ogni singolo calcolo. In genere, la memoria di un computer, che contiene i dati e i valori numerici che elabora durante il calcolo, viene posizionata sulla scheda madre lontano dal processore, dove avviene l'elaborazione.

Per le informazioni che scorrono attraverso il processore, "è un po' come se trascorri otto ore in viaggio, ma fai due ore di lavoro", ha detto Wan, uno scienziato informatico precedentemente alla Stanford University che si è recentemente trasferito alla startup AI Aizip.

Introduzione

Risolvere questo problema con i nuovi chip all-in-one che mettono memoria e calcolo nello stesso posto sembra semplice. È anche più vicino al modo in cui i nostri cervelli probabilmente elaborano le informazioni, dal momento che molti neuroscienziati credono che il calcolo avvenga all'interno di popolazioni di neuroni, mentre i ricordi si formano quando le sinapsi tra i neuroni rafforzano o indeboliscono le loro connessioni. Ma la creazione di tali dispositivi si è rivelata difficile, poiché le attuali forme di memoria sono incompatibili con la tecnologia dei processori.

Gli informatici decenni fa hanno sviluppato i materiali per creare nuovi chip che eseguono calcoli in cui è archiviata la memoria, una tecnologia nota come compute-in-memory. Ma con i tradizionali computer digitali che funzionano così bene, queste idee sono state trascurate per decenni.

"Quel lavoro, proprio come la maggior parte del lavoro scientifico, è stato un po' dimenticato", ha detto Wong, un professore a Stanford.

Infatti, la primo dispositivo di questo tipo risale almeno al 1964, quando gli ingegneri elettrici di Stanford scoprirono che potevano manipolare determinati materiali, chiamati ossidi di metallo, per attivare e disattivare la loro capacità di condurre l'elettricità. Ciò è significativo perché la capacità di un materiale di passare da uno stato all'altro fornisce la spina dorsale per l'archiviazione di memoria tradizionale. Tipicamente, nella memoria digitale, uno stato di alta tensione corrisponde a 1 e di bassa tensione a 0.

Per fare in modo che un dispositivo RRAM cambi stato, si applica una tensione agli elettrodi metallici collegati a due estremità dell'ossido di metallo. Normalmente, gli ossidi di metallo sono isolanti, il che significa che non conducono elettricità. Ma con una tensione sufficiente, la corrente si accumula, spingendo infine attraverso i punti deboli del materiale e creando un percorso verso l'elettrodo sull'altro lato. Una volta che la corrente ha attraversato, può fluire liberamente lungo quel percorso.

Wong paragona questo processo a un fulmine: quando una carica sufficiente si accumula all'interno di una nuvola, trova rapidamente un percorso a bassa resistenza e colpisce i fulmini. Ma a differenza del fulmine, il cui percorso scompare, il percorso attraverso l'ossido di metallo rimane, il che significa che rimane conduttivo indefinitamente. Ed è possibile cancellare il percorso conduttivo applicando un'altra tensione al materiale. Quindi i ricercatori possono cambiare una RRAM tra due stati e usarli per archiviare la memoria digitale.

I ricercatori della metà del secolo non hanno riconosciuto il potenziale per l'elaborazione efficiente dal punto di vista energetico, né ne avevano ancora bisogno con gli algoritmi più piccoli con cui stavano lavorando. Ci sono voluti fino all'inizio degli anni 2000, con la scoperta di nuovi ossidi metallici, perché i ricercatori realizzassero le possibilità.

Wong, che all'epoca lavorava presso IBM, ricorda che un pluripremiato collega che lavorava su RRAM ha ammesso di non aver compreso appieno la fisica coinvolta. "Se non lo capisce", ricorda Wong, "forse non dovrei cercare di capirlo".

Ma nel 2004, i ricercatori di Samsung Electronics hanno annunciato di averlo fatto memoria RRAM integrata con successo costruito su un chip di elaborazione tradizionale, suggerendo che un chip di calcolo in memoria potrebbe finalmente essere possibile. Wong decise di provare almeno.

Chip di calcolo in memoria per l'IA

Per più di un decennio, ricercatori come Wong hanno lavorato per sviluppare la tecnologia RRAM al punto da poter gestire in modo affidabile compiti di elaborazione ad alta potenza. Intorno al 2015, gli informatici hanno iniziato a riconoscere l'enorme potenziale di questi dispositivi ad alta efficienza energetica per i grandi algoritmi di intelligenza artificiale, che stavano iniziando a decollare. Quell'anno, gli scienziati dell'Università della California, Santa Barbara ha mostrato che i dispositivi RRAM potrebbero fare di più che archiviare la memoria in un modo nuovo. Potrebbero eseguire da soli compiti di calcolo di base, inclusa la stragrande maggioranza dei calcoli che avvengono all'interno dei neuroni artificiali di una rete neurale, che sono semplici compiti di moltiplicazione di matrici.

Nel chip NeuRRAM, i neuroni di silicio sono integrati nell'hardware e le celle di memoria RRAM memorizzano i pesi, i valori che rappresentano la forza delle connessioni tra i neuroni. E poiché le celle di memoria NeuRRAM sono analogiche, i pesi che memorizzano rappresentano l'intera gamma di stati di resistenza che si verificano mentre il dispositivo passa da uno stato a bassa resistenza a uno ad alta resistenza. Ciò consente un'efficienza energetica ancora maggiore rispetto a quella che la memoria RRAM digitale può ottenere perché il chip può eseguire molti calcoli di matrice in parallelo, piuttosto che in sequenza uno dopo l'altro, come nelle versioni di elaborazione digitale.

Ma poiché l'elaborazione analogica è ancora indietro di decenni rispetto all'elaborazione digitale, ci sono ancora molti problemi da appianare. Uno è che i chip RRAM analogici devono essere insolitamente precisi poiché le imperfezioni sul chip fisico possono introdurre variabilità e rumore. (Per i chip tradizionali, con solo due stati, queste imperfezioni non contano così tanto.) Ciò rende significativamente più difficile per i dispositivi RRAM analogici eseguire algoritmi di intelligenza artificiale, dato che l'accuratezza, ad esempio, del riconoscimento di un'immagine ne risentirà se il lo stato conduttivo del dispositivo RRAM non è esattamente lo stesso ogni volta.

"Quando osserviamo un percorso di illuminazione, ogni volta è diverso", ha affermato Wong. "Quindi, di conseguenza, la RRAM mostra un certo grado di stocasticità, ogni volta che la si programma è leggermente diversa." Wong e i suoi colleghi hanno dimostrato che i dispositivi RRAM possono memorizzare pesi di intelligenza artificiale continui ed essere comunque accurati come i computer digitali se gli algoritmi sono addestrati per abituarsi al rumore che incontrano sul chip, un progresso che ha permesso loro di produrre il chip NeuRRAM.

Introduzione

Un altro problema importante che hanno dovuto risolvere riguardava la flessibilità necessaria per supportare diverse reti neurali. In passato, i progettisti di chip dovevano allineare i minuscoli dispositivi RRAM in un'area accanto a neuroni di silicio più grandi. I dispositivi RRAM e i neuroni erano cablati senza programmabilità, quindi il calcolo poteva essere eseguito solo in un'unica direzione. Per supportare le reti neurali con il calcolo bidirezionale, erano necessari cavi e circuiti aggiuntivi, gonfiando le esigenze di energia e spazio.

Quindi il team di Wong ha progettato una nuova architettura di chip in cui i dispositivi di memoria RRAM e i neuroni di silicio sono stati mescolati insieme. Questa piccola modifica al design ha ridotto l'area totale e ha risparmiato energia.

"Ho pensato che [l'arrangiamento] fosse davvero bello", ha detto Melika Payvand, ricercatore neuromorfico presso l'Istituto Federale Svizzero di Tecnologia di Zurigo. "Lo considero sicuramente un lavoro rivoluzionario."

Per diversi anni, il team di Wong ha lavorato con i collaboratori per progettare, produrre, testare, calibrare ed eseguire algoritmi di intelligenza artificiale sul chip NeuRRAM. Hanno preso in considerazione l'utilizzo di altri tipi emergenti di memoria che possono essere utilizzati anche in un chip di calcolo in memoria, ma la RRAM ha avuto un vantaggio a causa dei suoi vantaggi nella programmazione analogica e perché era relativamente facile da integrare con i materiali informatici tradizionali.

I loro risultati recenti rappresentano il primo chip RRAM in grado di eseguire algoritmi di intelligenza artificiale così grandi e complessi, un'impresa che in precedenza era possibile solo nelle simulazioni teoriche. "Quando si tratta di vero silicio, quella capacità mancava", ha affermato Anup Das, uno scienziato informatico alla Drexel University. "Questo lavoro è la prima dimostrazione."

"I sistemi di intelligenza artificiale digitale sono flessibili e precisi, ma di ordini di grandezza meno efficienti", ha affermato Cauwenberghs. Ora, ha affermato Cauwenberghs, il loro chip RRAM analogico flessibile, preciso ed efficiente dal punto di vista energetico ha "colmato il divario per la prima volta".

Scalare

Il design del team mantiene il chip NeuRRAM minuscolo, delle dimensioni di un'unghia, mentre comprime 3 milioni di dispositivi di memoria RRAM che possono fungere da processori analogici. E mentre può eseguire reti neurali almeno così come fanno i computer digitali, anche il chip (e per la prima volta) può eseguire algoritmi che eseguono calcoli in direzioni diverse. Il loro chip può immettere una tensione nelle righe dell'array RRAM e leggere gli output dalle colonne come è standard per i chip RRAM, ma può anche farlo all'indietro dalle colonne alle righe, quindi può essere utilizzato nelle reti neurali che operano con dati che scorrono in direzioni diverse.

Come con la stessa tecnologia RRAM, questo è stato a lungo possibile, ma nessuno ha pensato di farlo. "Perché non ci abbiamo pensato prima?" ha chiesto Payvand. "Con il senno di poi, non lo so."

"Questo in realtà apre molte altre opportunità", ha detto Das. A titolo di esempio, ha menzionato la capacità di un semplice sistema di eseguire gli enormi algoritmi necessari per simulazioni di fisica multidimensionale o per auto a guida autonoma.

Eppure le dimensioni sono un problema. Le reti neurali più grandi ora contengono miliardi di pesi, non i milioni contenuti nei nuovi chip. Wong prevede di aumentare le dimensioni impilando più chip NeuRRAM uno sopra l'altro.

Sarà altrettanto importante mantenere bassi i costi energetici nei dispositivi futuri o ridurli ulteriormente. Un modo per arrivarci è passare copiando il cervello ancora più da vicino per adottare il segnale di comunicazione utilizzato tra i neuroni reali: lo spike elettrico. È un segnale inviato da un neurone all'altro quando la differenza di tensione tra l'interno e l'esterno della cellula raggiunge una soglia critica.

"Ci sono grandi sfide lì", ha detto Tony Kenion, ricercatore di nanotecnologie presso l'University College London. "Ma potremmo comunque voler muoverci in quella direzione, perché... è probabile che tu abbia una maggiore efficienza energetica se utilizzi picchi molto scarsi". Tuttavia, l'esecuzione di algoritmi con picchi sull'attuale chip NeuRRAM richiederebbe un'architettura completamente diversa, ha osservato Kenyon.

Per ora, l'efficienza energetica raggiunta dal team durante l'esecuzione di grandi algoritmi di intelligenza artificiale sul chip NeuRRAM ha creato nuove speranze che le tecnologie di memoria possano rappresentare il futuro dell'informatica con l'intelligenza artificiale. Forse un giorno saremo anche in grado di eguagliare gli 86 miliardi di neuroni del cervello umano e i trilioni di sinapsi che li collegano senza rimanere senza energia.