GTC I tanto attesi acceleratori Hopper H100 di Nvidia inizieranno a essere spediti entro la fine del mese prossimo nei sistemi HGX costruiti dagli OEM, ha affermato oggi il gigante del silicio al suo evento GPU Technology Conference (GTC).

Tuttavia, coloro che aspettano di mettere le mani sui sistemi DGX H100 di Nvidia dovranno aspettare fino al primo trimestre del prossimo anno. Il DGX è la linea di workstation e server di Nvidia che utilizza le sue GPU e le sue interconnessioni, e i sistemi HGX sono server realizzati da partner che utilizzano ancora la tecnologia di Nv.

E mentre Nvidia sta pubblicizzando la sua architettura Hopper nel datacenter, la maggior parte del kit aziendale annunciato questa settimana non riceverà presto l'architettura di punta del gigante dei chip.

Al limite, Nvidia sembra accontentarsi di trarre una vita piena dalla sua architettura Ampere.

Oggi, Nvidia ha dettagliato la piattaforma di robotica e AI edge di nuova generazione che chiama IGX.

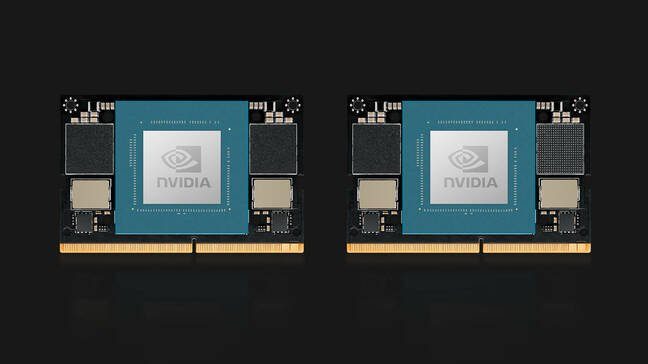

La piattaforma IGX di Nvidia è una scheda di sistema di dimensioni standard costruita attorno a un sistema Orin Industrial su modulo

IGX è una "piattaforma informatica all-in-one per accelerare l'implementazione di macchine e dispositivi medici intelligenti in tempo reale", ha affermato Kimberly Powell, veep of Healthcare di Nvidia. Al centro, il sistema è essenzialmente una versione ampliata del modulo Jetson AGX Orin precedentemente annunciato da Nvidia, ha annunciato questo primavera.

“IGX è un sistema completo con il processore robotico Nvidia Orin, la GPU Ampere tensor-core, il processore I/O streaming ConnectX, un'isola di sicurezza funzionale e un'unità microcontrollore di sicurezza perché sempre più robot e esseri umani lavoreranno nello stesso ambiente ," lei ha aggiunto.

In termini di prestazioni, non c'è molto di nuovo qui. Ci è stato detto che la piattaforma si basa su un sistema industriale Orin su modulo con 64 GB di memoria paragonabile in termini di prestazioni al modulo AGX Orin lanciato all'inizio di quest'anno. Quel sistema prevedeva 32 GB di memoria, una CPU octacore Arm Cortex A78AE e una GPU basata su Ampere.

L'IGX ottiene una scheda di rete ConnectX-7 integrata per la connettività ad alta velocità tramite due interfacce a 200 Gbps. La scheda sembra inoltre presentare una dotazione completa di storage M.2, slot PCIe e almeno uno slot PCI legacy per l'espansione.

Nvidia punta la piattaforma IGX a una varietà di casi d'uso avanzati di robotica e intelligenza artificiale nel settore sanitario, manifatturiero e logistico, dove la riservatezza o la latenza rendono impraticabili sistemi più centralizzati.

Come l'AGX Orin, il sistema è completato dalla suite software AI Enterprise di Nvidia e dalla piattaforma Fleet Command per l'implementazione e la gestione.

Una delle prime applicazioni della piattaforma IGX utilizzerà la piattaforma di imaging robotica di Nvidia.

"Nvidia Clara Holoscan è il nostro framework applicativo che si trova in cima a IGX per dispositivi medici e pipeline di robotica di imaging", ha spiegato Powell.

Tre fornitori di dispositivi medici – Activ Surgical, Moon Surgical e Proximinie – prevedono di utilizzare IGX e Clara Holoscan per alimentare le loro piattaforme di robotica chirurgica e telepresenza. I kit per sviluppatori IGX Orin dovrebbero essere spediti all'inizio del prossimo anno con sistemi di produzione disponibili da ADLink, Advantech, Dedicated Computing, Kontron, MBX e Onyx, solo per citarne alcuni.

A proposito di Orin, Nvidia ha anche presentato i suoi moduli di calcolo Jetson Orin Nano. Orin Nano è disponibile in due configurazioni al momento del lancio, inclusa una versione da 8 GB in grado di 40 TOP di inferenza AI e una versione ridotta con 4 GB di memoria in grado di 20 TOP.

Come i precedenti moduli Jetson, Orin Nano utilizza un connettore edge compatibile con pin che ricorda quello utilizzato per la memoria SODIMM per laptop e consuma tra 5 W e 15 W a seconda dell'applicazione e della SKU. I moduli Jetson Orin Nano di Nvidia sono disponibili a gennaio a partire da $ 199.

Un aggiornamento OVX

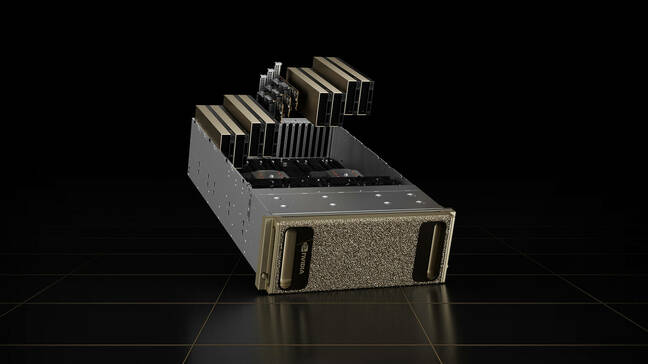

Anche i server OVX di Nvidia, progettati per eseguire la sua piattaforma Omniverse, non funzioneranno su Hopper.

I sistemi di visualizzazione e gemellaggio digitale di seconda generazione dell'azienda sono invece dotati di otto GPU L40. Le schede si basano sull'architettura Ada Lovelace di prossima generazione dell'azienda e presentano i core di ray tracing di terza generazione di Nvidia e i Tensor Core di quarta generazione.

Le GPU sono accompagnate da una coppia di CPU Ice Lake Intel Xeon Platinum 8362, per un totale di 128 thread del processore fino a 3.6GHz.

Il sistema di elaborazione è accompagnato da tre NIC ConnectX-7, ciascuna in grado di raggiungere 400 Gbps di throughput e 16 TB di storage NVMe. Sebbene il sistema sia disponibile come nodi singoli, Nvidia prevede che il sistema venga implementato come parte di quello che chiama un SuperPod OVX, che incorpora 32 sistemi collegati utilizzando gli switch Spectrum-51.2 da 3 Tbps dell'azienda.

I sistemi di seconda generazione saranno disponibili da Lenovo, Supermicro e Inspur a partire dal 2023. In futuro, Nvidia prevede di espandere la disponibilità dei sistemi ad altri partner.

Sono salito su Drive Thor

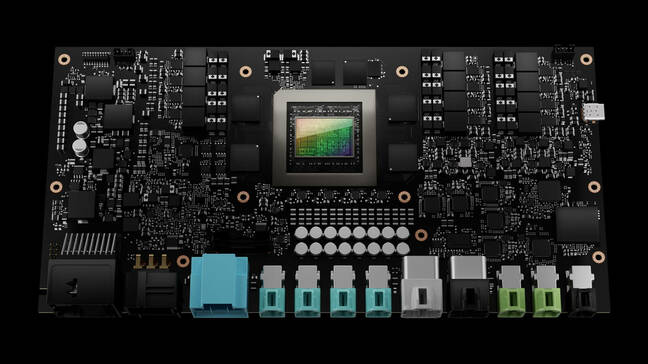

L'unico kit annunciato al GTC questa settimana che sta ottenendo l'architettura Hopper di Nvidia è il sistema di computer per veicoli autonomi Drive Thor.

Drive Thor sostituisce la piattaforma Atlan di Nvidia nella roadmap del 2025 e promette di fornire 2,000 TOP di prestazioni di inferenza al lancio.

Il computer per veicoli autonomi Drive Thor di Nvidia promette 2,000 TOP di prestazioni quando verrà lanciato nel 2025

"Drive Thor è ricco di funzionalità all'avanguardia introdotte nella nostra CPU Grace, nella nostra GPU Hopper e nella nostra architettura GPU di prossima generazione", ha detto Danny Shapiro, VP di Automotive presso Nvidia, in una conferenza stampa. Ha detto che Drive Thor è progettato per unificare la litania dei sistemi informatici che alimentano le automobili moderne in un'unica piattaforma centralizzata.

"Guarda i sistemi avanzati di assistenza alla guida di oggi - parcheggio, monitoraggio del conducente, specchietti retrovisori della fotocamera, quadro strumenti digitale, sistemi di infotainment - sono tutti su diversi computer distribuiti in tutto il veicolo", ha affermato. “Nel 2025, tuttavia, queste funzioni non saranno più computer separati. Piuttosto, Drive Thor consentirà ai produttori di consolidare in modo efficiente queste funzioni in un unico sistema".

Per far fronte a tutte le informazioni in streaming dai sensori delle automobili, il chip è dotato di isolamento multidominio, che secondo Nvidia consente al chip di eseguire processi critici simultanei senza interruzioni.

La tecnologia consente inoltre al chip di eseguire più sistemi operativi contemporaneamente per adattarsi alle varie applicazioni del veicolo. Ad esempio, il sistema operativo principale dell'auto potrebbe funzionare su Linux, mentre il sistema di infotainment potrebbe eseguire QNX o Android.

Tuttavia, non è noto quando potremmo vedere la tecnologia in azione. Allo stato attuale, tutti e tre i partner di lancio di Nvidia – Zeekr, Xpeng e QCraft – hanno sede in Cina. ®

- AI

- oh arte

- generatore d'arte

- un robot

- intelligenza artificiale

- certificazione di intelligenza artificiale

- intelligenza artificiale nel settore bancario

- robot di intelligenza artificiale

- robot di intelligenza artificiale

- software di intelligenza artificiale

- blockchain

- conferenza blockchain ai

- geniale

- intelligenza artificiale conversazionale

- criptoconferenza ai

- dall's

- apprendimento profondo

- google ai

- machine learning

- Platone

- platone ai

- Platone Data Intelligence

- Gioco di Platone

- PlatoneDati

- gioco di plato

- scala ai

- sintassi

- Il registro

- zefiro