Sì.. sto parlando delle applicazioni AI – la nostra miriade di applicazioni AI e quelle imminenti che sussurrano agli umani cosa fare…. come farlo... ma non sui sussurratori che interagiscono con i chatbot AI.

Secondo IDC Secondo le previsioni, il mercato globale dell'IA potrebbe raggiungere oltre 500 miliardi di dollari entro il 2024, un aumento di oltre il 50% rispetto al 2021. Ciò indica che siamo passati dagli esperimenti aziendali all'accettazione del fatto che è parte integrante della strategia aziendale per tutte le dimensioni. È uno strumento necessario per trasformare i dati in intuizioni per stimolare l'azione sulla base di decisioni migliori. Nessuno sta discutendo i vantaggi dell'intelligenza artificiale per ridurre il rischio aziendale e amplificare il ROI con l'innovazione. Ma, come sempre, c'è un... MA... l'IA imparziale è più facile a dirsi che a farsi.

Fondamentali per il business, questi modelli di intelligenza artificiale devono operare in modo affidabile con visibilità e responsabilità. In caso contrario, il fallimento, in questo caso, ha conseguenze disastrose che incidono sul flusso di cassa di qualsiasi azienda e potrebbero persino portare a questioni legali. L'unico modo per evitarlo è l'automazione e la trasparenza per rispondere a una domanda "Puoi dimostrare che questa applicazione/carico di lavoro AI è costruito in modo etico". Ovvero... come si governa? E puoi dimostrare che è governato continuamente?

È qui che piacciono alle aziende IBM hanno investito nella governance dell'IA per orchestrare il processo complessivo di direzione, gestione e monitoraggio delle attività di intelligenza artificiale dell'organizzazione. Il compito principale è garantire che tutte le unità aziendali rimangano proattive e infondano il quadro di governance nelle iniziative per rafforzare la capacità di soddisfare i principi e le normative etiche. In particolare, le industrie regolamentate come le banche e i servizi finanziari sono legalmente tenute a fornire le prove per soddisfare le autorità di regolamentazione.

L'influenza dell'intelligenza artificiale sta crescendo in modo esponenziale nel settore dei servizi finanziari a causa dell'enorme pressione della trasformazione digitale. Come detto, è più facile a dirsi che a farsi perché:

1. Rendere operative con sicurezza le app AI:

In alcuni casi si costruiscono modelli senza chiarezza e catalogazione; inutile dire che il monitoraggio scivola via in mezzo a tutto per tracciare il ciclo di vita end-to-end. Mentre le banche stanno lottando con le applicazioni legacy, automatizzare i processi per creare trasparenza e spiegabilità è diventato più difficile e, a sua volta, una scatola nera. Nessuno sa perché/come sono state prese le decisioni. Le nuove app aggrovigliate con le app legacy non vedono mai la luce del giorno, sebbene ad esse sia associato un enorme ROI a causa della qualità e dei rischi non percepiti.

Questo ci porta al nostro secondo punto: gestire il rischio di reputazione

2. Gestire il rischio reputazionale insieme al rischio complessivo

ho chiesto #chatGPT ed #Bardo – chi è Padma Chukka. #ChatGPT rifiutato di rispondere anche se ho cambiato la domanda in più modi. Tuttavia, Bard mi ha dato una risposta dettagliata, incluso il mio profilo LinkedIn... ma i dati provengono da vari siti in cui il mio vecchio profilo esiste ancora come parte della biografia del relatore. Da quel momento in poi, devo ancora aprire il Bardo. Così velocemente, sono stato spento, alias - Rischio di reputazione. Supponiamo che io possa disattivare un semplice chatbot quando mi rendo conto che i dati potrebbero essere incoerenti. Come potevo non esserne sicuro prima di decidere di acquistare un'applicazione basata sull'intelligenza artificiale per condurre attività critiche? Il rischio di reputazione è un fattore essenziale che a volte le aziende dimenticano. Se si quantifica il rischio reputazionale, si può vedere l'enorme impatto sull'azienda se non si è proattivi.

Per aumentare la complessità, il terzo è...

3. In che modo un'azienda può rispondere al cambiamento delle normative sull'IA?

Per evitare il rischio reputazionale, un team di intelligenza artificiale responsabile e di successo dovrebbe essere a conoscenza di ogni regolamentazione locale e globale, facendo cadere come un video tick-tock con un attimo di preavviso. E la non conformità può alla fine costare a un'organizzazione milioni di dollari di multe per il lavoro come la proposta di legge sull'IA dell'UE. Potrebbe essere fino a 30 milioni di euro o il 6% delle entrate globali dell'azienda - OUCH.

Beh, non tutto deve essere roseo all'inizio... fintanto che sappiamo come trasformare una situazione spaventosa in una situazione rosea.

Senza sorprese... sono sempre le persone, i processi e la tecnologia. Quindi, in primo luogo, crea un organo di governo interfunzionale per istruire, dirigere e monitorare le iniziative in base agli obiettivi. Quindi confronta la tecnologia e i processi di intelligenza artificiale attuali, comprendi le lacune, quindi rimedia alla prova futura. Quindi ricorri a una serie di flussi di lavoro di governance automatizzati in linea con i requisiti di conformità. Infine, imposta un sistema di monitoraggio per avvisare i proprietari se la soglia accettabile si sta avvicinando. Dal punto di vista della tecnologia, un'intelligenza artificiale ben progettata, ben eseguita e ben collegata richiede più elementi costitutivi. E assicurati che abbia alcune o tutte le funzionalità:

· Integrità dei dati in diverse distribuzioni

· Utilizzare strumenti esistenti aperti e flessibili che aderiscono alla governance dell'IA

· Assicurati di offrire l'accesso self-service con i controlli della privacy, un modo per tenere traccia

· Progettare pensando all'automazione e alla governance dell'IA

· Può connettersi ed essere personalizzabile per più parti interessate attraverso un flusso di lavoro personalizzabile

Dopo aver rinnovato l'app da spaventosa a Rosy... la domanda successiva è come dimostri...

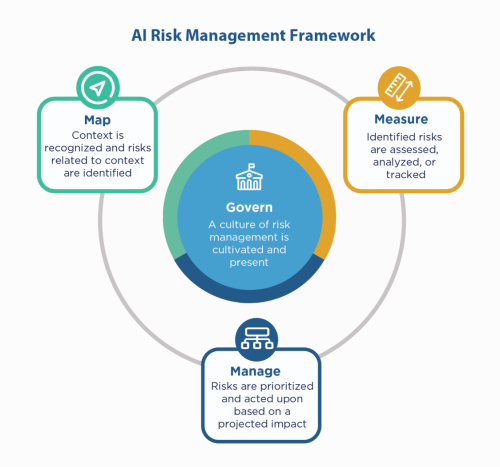

In primo luogo, ripiega sui principi di intelligenza artificiale dell'azienda: costruisci con loro, eppure devi ancora "dimostrare" di essere conforme, specialmente in ambienti regolamentati come i servizi finanziari. Poiché i servizi finanziari devono presentare reclamo al NIST 800-53, potrebbero esaminare il file NIST AI Risk Management Framework (AI RMF). Il NIST ha suggerito i controlli in quattro famiglie: Govern, Map, Measure e Manage. Utilizzandolo come fattore guida e sottoponendo a stress test le applicazioni per identificare le lacune da colmare e monitorare.

IBM può convalidare i tuoi modelli prima che tu li metta in produzione e può essere monitorato per equità, qualità e deriva. Può anche fornire la documentazione che spiega il comportamento e le previsioni del modello per soddisfare i requisiti delle autorità di regolamentazione e dei revisori. Queste spiegazioni possono fornire visibilità e alleviare il dolore dell'audit e aumentare la trasparenza e la capacità di determinare i possibili rischi.

Ascolta quei sussurri AI con fiducia!

#Servizi finanziari #responsabileai #eticoai #NISTAIRMF

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- Platoblockchain. Web3 Metaverse Intelligence. Conoscenza amplificata. Accedi qui.

- Coniare il futuro con Adryenn Ashley. Accedi qui.

- Fonte: https://www.finextra.com/blogposting/24053/the-costly-consequences-of-unethical-ai-whisperer?utm_medium=rssfinextra&utm_source=finextrablogs

- :È

- $ SU

- 2021

- 2024

- 7

- a

- capacità

- WRI

- accettabile

- accesso

- responsabilità

- operanti in

- Legge

- Action

- attività

- aderire

- AI

- Legge sull'IA

- Governance dell'IA

- aka

- Mettere in guardia

- Tutti

- sempre

- ed

- rispondere

- App

- Applicazioni

- applicazioni

- applicazioni

- SONO

- in giro

- AS

- associato

- At

- revisione

- revisori dei conti

- Automatizzata

- Automatizzare

- Automazione

- precedente

- Settore bancario

- Banche

- basato

- BE

- perché

- prima

- essendo

- Segno di riferimento

- vantaggi

- Meglio

- Miliardo

- Nero

- Blocchi

- stile di vita

- Scatola

- Porta

- costruire

- Costruzione

- costruito

- affari

- Acquistare

- by

- Materiale

- funzionalità

- Custodie

- casi

- Contanti

- flusso di cassa

- cambiando

- chatbot

- chatbots

- chiarezza

- chiusura

- Aziende

- azienda

- complessità

- conformità

- compiacente

- Segui il codice di Condotta

- con fiducia

- Connettiti

- Conseguenze

- continuamente

- controlli

- Costo

- potuto

- creare

- critico

- Corrente

- personalizzabile

- ciclo

- dati

- dibattendo

- Decidere

- decisioni

- diminuire

- Design

- dettagliati

- Determinare

- digitale

- DIGITAL TRANSFORMATION

- terribile

- dirette

- orientamento

- paesaggio differenziato

- documentazione

- dollari

- lancio

- più facile

- educare

- da un capo all'altro

- garantire

- Impresa

- ambienti

- particolarmente

- essential

- etico

- EU

- euro

- Anche

- Ogni

- qualunque cosa

- prova

- esistente

- esiste

- spiegando

- in modo esponenziale

- Fallimento

- equità

- Autunno

- famiglie

- Infine

- finanziario

- servizi finanziari

- fine

- Finextra

- Nome

- flessibile

- flusso

- Nel

- Contesto

- da

- da 2021

- futuro

- Dare

- globali

- la governance

- Crescita

- Avere

- Come

- Tutorial

- HTTPS

- Enorme

- Gli esseri umani

- i

- identificare

- Impact

- in

- Compreso

- Aumento

- indica

- industrie

- influenza

- iniziative

- Innovazione

- intuizioni

- integrale

- interezza

- interagire

- investito

- IT

- SUO

- Lavoro

- Sapere

- Eredità

- Legale

- Faccende legali

- Vita

- piace

- linea

- locale

- Lunghi

- Guarda

- fatto

- make

- gestire

- gestione

- gestione

- carta geografica

- Rappresentanza

- Matters

- Maggio..

- misurare

- Soddisfare

- forza

- milione

- milioni

- modello

- modelli

- momento

- Monitorare

- monitorati

- monitoraggio

- Scopri di più

- multiplo

- necessaria

- Bisogno

- Inutile

- New

- GENERAZIONE

- nista

- Obiettivi d'Esame

- of

- offrire

- Vecchio

- on

- ONE

- aprire

- operare

- organizzazione

- altrimenti

- complessivo

- proprietari

- Dolore

- parte

- Persone

- Platone

- Platone Data Intelligence

- PlatoneDati

- punto

- possibile

- Previsioni

- pressione

- primario

- principi

- Privacy

- Proactive

- processi

- i processi

- Produzione

- Profilo

- prova

- proposto

- Dimostra

- fornire

- metti

- qualità

- domanda

- rapidamente

- raggiungere

- rendersi conto

- regolamentati

- industrie regolamentate

- Regolamento

- normativa

- Regolatori

- reputazione

- necessario

- Requisiti

- richiede

- Rispondere

- responsabile

- colpevole

- Le vendite

- Rischio

- gestione del rischio

- rischi

- ROI

- Roseo

- s

- Suddetto

- Secondo

- settore

- Fai da te

- Servizi

- set

- dovrebbero

- mostrare attraverso le sue creazioni

- lato

- Un'espansione

- da

- Siti

- situazione

- Dimensioni

- So

- alcuni

- Scintilla

- Speaker

- stakeholder

- soggiorno

- Ancora

- Strategia

- Rafforza

- stress

- Lottando

- di successo

- sistema

- parlando

- team

- Tecnologia

- test

- che

- Il

- Li

- Strumenti Bowman per analizzare le seguenti finiture:

- Terza

- soglia

- Attraverso

- a

- strumenti

- pista

- Trasformazione

- Trasparenza

- enorme

- TURNO

- Turned

- in definitiva

- capire

- unità

- imminenti

- us

- uso

- CONVALIDARE

- vario

- Video

- visibilità

- Modo..

- modi

- Che

- while

- OMS

- con

- senza

- Lavora

- flussi di lavoro

- Tu

- Trasferimento da aeroporto a Sharm

- zefiro