Hai mai visto una piccola gazzella imparare a camminare? Un cerbiatto, che è fondamentalmente un papà mammifero con le gambe lunghe, si alza in piedi, cade, si alza e cade di nuovo. Alla fine, rimane abbastanza a lungo da agitare le sue gambe simili a stuzzicadenti in una serie di cadute vicine... ehm, passi. Sorprendentemente, pochi minuti dopo questo accattivante display, il cerbiatto saltella come un vecchio professionista.

Bene, ora abbiamo una versione robotica di questa classica scena del Serengeti.

Il cerbiatto in questo caso è un cane robotico dell'Università della California, a Berkeley. Ed è anche uno studente sorprendentemente veloce (rispetto al resto del tipo di robot). Il robot è anche speciale perché, a differenza di altri robot più appariscenti che potresti aver visto online, usa l'intelligenza artificiale per imparare a camminare.

Cominciando sulla schiena, le gambe che ondeggiano, il robot impara a capovolgersi, alzarsi e camminare in un'ora. Altri dieci minuti di molestie con un rotolo di cartone sono sufficienti per insegnargli come resistere e riprendersi dall'essere spinto in giro dai suoi conduttori.

Non è la prima volta un robot ha usato l'intelligenza artificiale per imparare a camminare. Ma mentre i robot precedenti hanno appreso l'abilità per tentativi ed errori su innumerevoli iterazioni nelle simulazioni, il bot di Berkeley ha imparato interamente nel mondo reale.

[Contenuto incorporato]

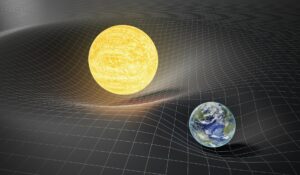

In un articolo pubblicato sul server della pubblicazione preliminare di arXiv, i ricercatori, Danijar Hafner, Alejandro Escontrela e Philipp Wu, affermano che trasferire algoritmi che hanno appreso durante la simulazione nel mondo reale non è semplice. Piccoli dettagli e differenze tra il mondo reale e la simulazione possono far inciampare robot alle prime armi. D'altra parte, l'addestramento degli algoritmi nel mondo reale non è pratico: ci vorrebbe troppo tempo e usura.

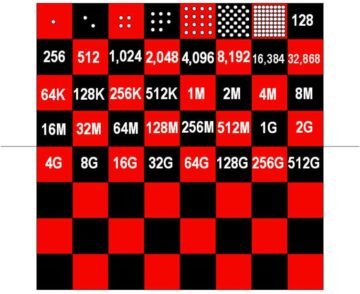

Quattro anni fa, ad esempio, OpenAI ha mostrato una mano robotica abilitata all'intelligenza artificiale in grado di manipolare un cubo. L'algoritmo di controllo, Dactyl, necessitava di circa 100 anni di esperienza in una simulazione basata su 6,144 CPU e 8 GPU Nvidia V100 per svolgere questo compito relativamente semplice. Da allora le cose sono progredite, ma il problema rimane in gran parte. Gli algoritmi di apprendimento per rinforzo puro richiedono troppi tentativi ed errori per apprendere le abilità per potersi allenare nel mondo reale. In poche parole, il processo di apprendimento spezzerebbe i ricercatori ed robot prima di compiere progressi significativi.

Il team di Berkeley ha deciso di risolvere questo problema con un algoritmo chiamato Dreamer. Costruire quello che viene chiamato un "modello mondiale”, Dreamer può proiettare la probabilità che un'azione futura raggiunga il suo obiettivo. Con l'esperienza, l'accuratezza delle sue proiezioni migliora. Filtrando in anticipo le azioni meno riuscite, il modello mondiale consente al robot di capire in modo più efficiente cosa funziona.

"L'apprendimento di modelli del mondo dall'esperienza passata consente ai robot di immaginare i risultati futuri di potenziali azioni, riducendo la quantità di tentativi ed errori nell'ambiente reale necessari per apprendere comportamenti di successo", scrivono i ricercatori. "Predicendo i risultati futuri, i modelli mondiali consentono la pianificazione e l'apprendimento del comportamento con solo piccole quantità di interazione nel mondo reale".

In altre parole, un modello mondiale può ridurre l'equivalente di anni di addestramento in una simulazione a non più di un'ora imbarazzante nel mondo reale.

L'approccio potrebbe avere una rilevanza più ampia anche rispetto ai cani robot. Il team ha anche applicato Dreamer a un braccio robotico pick-and-place e a un robot con ruote. In entrambi i casi, hanno scoperto che Dreamer permetteva ai loro robot di apprendere in modo efficiente le abilità rilevanti, senza bisogno di tempo per la simulazione. Applicazioni future più ambiziose potrebbero includere automobili auto-guida.

Naturalmente, ci sono ancora sfide da affrontare. Sebbene l'apprendimento per rinforzo automatizza alcuni degli intricati codici manuali alla base dei robot più avanzati di oggi, richiede comunque agli ingegneri di definire gli obiettivi di un robot e ciò che costituisce il successo, un esercizio che richiede tempo e senza limiti per gli ambienti del mondo reale. Inoltre, sebbene il robot sia sopravvissuto agli esperimenti della squadra qui, un addestramento più lungo su abilità più avanzate potrebbe rivelarsi troppo per i futuri robot per sopravvivere senza danni. I ricercatori affermano che potrebbe essere fruttuoso combinare l'allenamento con il simulatore con un rapido apprendimento del mondo reale.

Tuttavia, i risultati fanno avanzare l'IA nella robotica di un altro passo. Dreamer rafforza la tesi secondo cui "l'apprendimento per rinforzo sarà uno strumento fondamentale nel futuro del controllo dei robot", Jonathan Hurst, professore di robotica presso la Oregon State University detto MIT Technology Review.

Immagine di credito: Danijar Hafner/YouTube