Molte applicazioni destinate alla manutenzione delle apparecchiature industriali, al monitoraggio del commercio, alla gestione della flotta e all'ottimizzazione dei percorsi sono realizzate utilizzando API e driver Cassandra open source per elaborare i dati ad alta velocità e bassa latenza. Gestire da soli i tavoli Cassandra può richiedere tempo e denaro. Amazon Keyspaces (per Apache Cassandra) ti consente di configurare, proteggere e ridimensionare le tabelle Cassandra nel cloud AWS senza gestire un'infrastruttura aggiuntiva.

In questo post, ti guideremo attraverso i servizi AWS relativi ai modelli di apprendimento automatico (ML) utilizzando Amazon Keyspaces ad alto livello e forniremo istruzioni dettagliate per l'acquisizione di dati da Amazon Keyspaces in Amazon Sage Maker e la formazione di un modello che può essere utilizzato per un caso d'uso specifico della segmentazione della clientela.

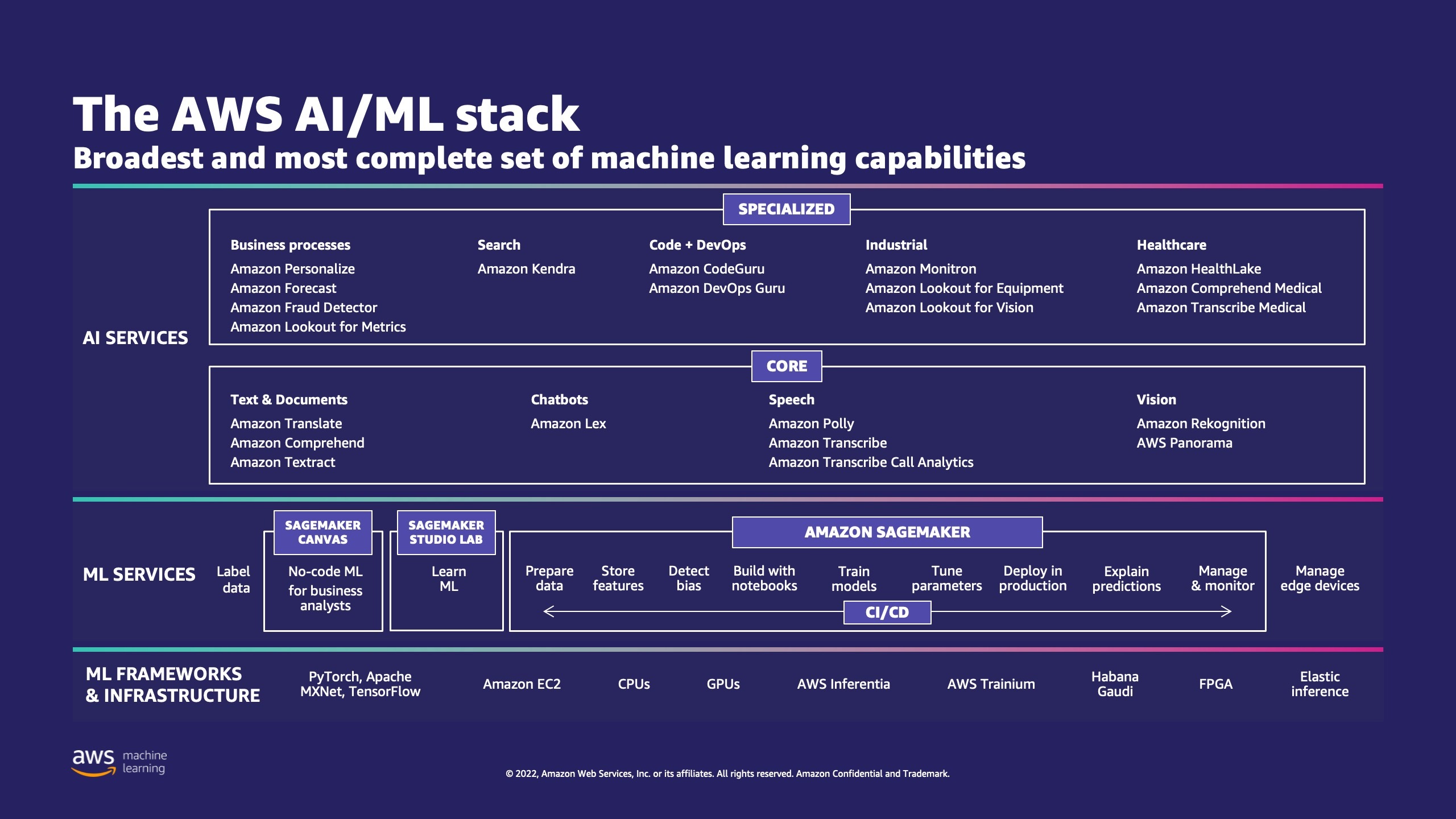

AWS offre diversi servizi per aiutare le aziende a implementare processi di machine learning nel cloud.

AWS ML Stack ha tre livelli. Nello strato intermedio c'è SageMaker, che offre a sviluppatori, data scientist e ingegneri ML la possibilità di creare, addestrare e distribuire modelli ML su larga scala. Rimuove la complessità da ogni passaggio del flusso di lavoro ML in modo da poter distribuire più facilmente i casi d'uso ML. Ciò include qualsiasi cosa, dalla manutenzione predittiva alla visione artificiale per prevedere i comportamenti dei clienti. I clienti ottengono un miglioramento fino a 10 volte della produttività dei data scientist con SageMaker.

Apache Cassandra è una scelta popolare per casi d'uso di lettura pesante con dati non strutturati o semistrutturati. Ad esempio, una nota azienda di consegna di cibo stima i tempi di consegna e un cliente al dettaglio potrebbe insistere frequentemente utilizzando le informazioni del catalogo prodotti nel database Apache Cassandra. Amazon Keyspace è un servizio di database compatibile con Apache Cassandra senza server scalabile, a disponibilità elevata e gestito. Non è necessario eseguire il provisioning, applicare patch o gestire i server e non è necessario installare, mantenere o utilizzare software. Le tabelle possono aumentare e diminuire automaticamente e paghi solo per le risorse che utilizzi. Amazon Keyspaces ti consente di eseguire i carichi di lavoro Cassandra su AWS utilizzando lo stesso codice dell'applicazione Cassandra e gli stessi strumenti di sviluppo che utilizzi oggi.

SageMaker fornisce una suite di algoritmi incorporati per aiutare i data scientist e i professionisti del machine learning a iniziare a formare e implementare rapidamente i modelli di machine learning. In questo post, ti mostreremo come un cliente al dettaglio può utilizzare la cronologia degli acquisti dei clienti nel database Keyspaces e indirizzare diversi segmenti di clienti per campagne di marketing.

K-significa è un algoritmo di apprendimento non supervisionato. Tenta di trovare raggruppamenti discreti all'interno dei dati, in cui i membri di un gruppo sono il più simili possibile tra loro e il più possibile diversi dai membri di altri gruppi. Definisci gli attributi che desideri vengano utilizzati dall'algoritmo per determinare la somiglianza. SageMaker utilizza una versione modificata di algoritmo di clustering k-means su scala web. Rispetto alla versione originale dell'algoritmo, la versione utilizzata da SageMaker è più accurata. Tuttavia, come l'algoritmo originale, si adatta a enormi set di dati e offre miglioramenti nei tempi di addestramento.

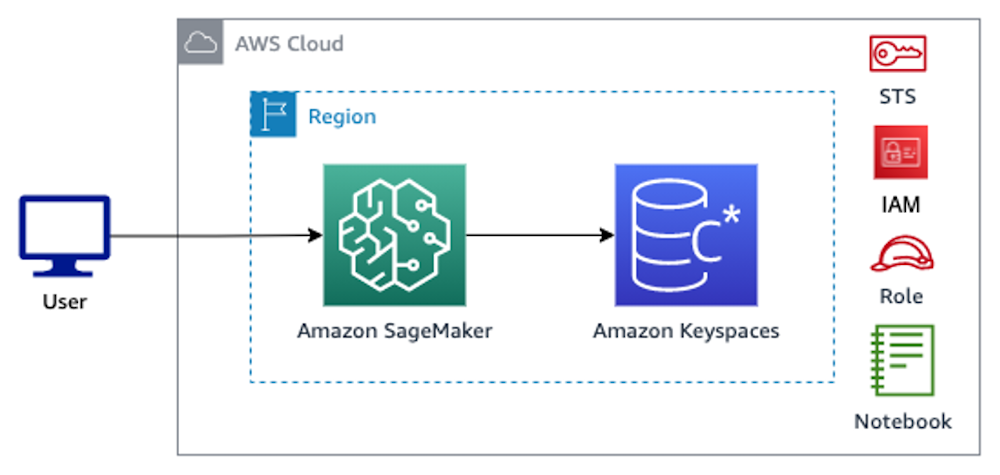

Panoramica della soluzione

Le istruzioni presuppongono che tu stia utilizzando SageMaker Studio per eseguire il codice. Il codice associato è stato condiviso su GitHub di esempio di AWS. Seguendo le istruzioni del laboratorio, è possibile eseguire le seguenti operazioni:

- Installa le dipendenze necessarie.

- Connettiti ad Amazon Keyspaces, crea una tabella e importa dati di esempio.

- Crea un modello ML di classificazione utilizzando i dati in Amazon Keyspaces.

- Esplora i risultati del modello.

- Pulisci le risorse appena create.

Una volta completato, avrai integrato SageMaker con Amazon Keyspaces per addestrare i modelli ML come mostrato nell'immagine seguente.

Ora puoi seguire il istruzioni passo-passo in questo post per importare i dati grezzi archiviati in Amazon Keyspaces utilizzando SageMaker e i dati così recuperati per l'elaborazione ML.

Prerequisiti

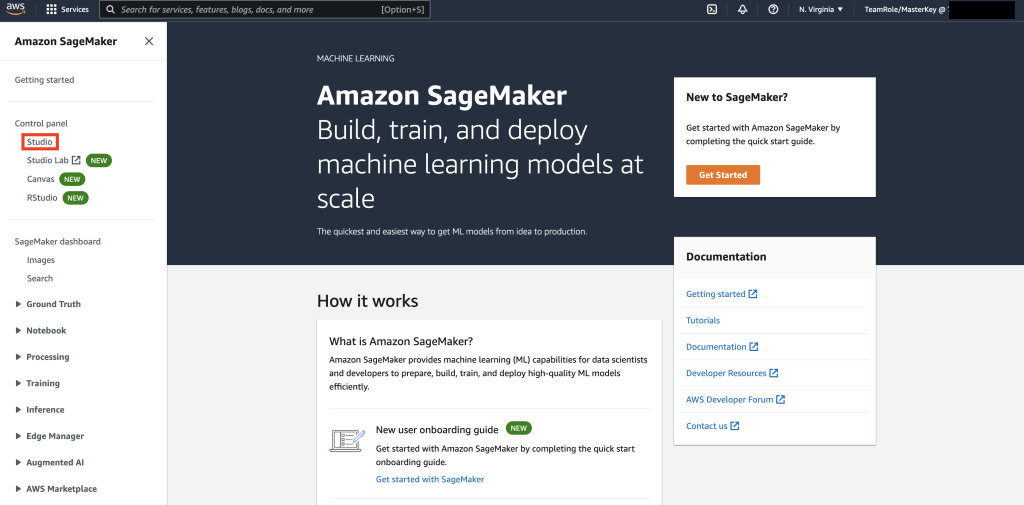

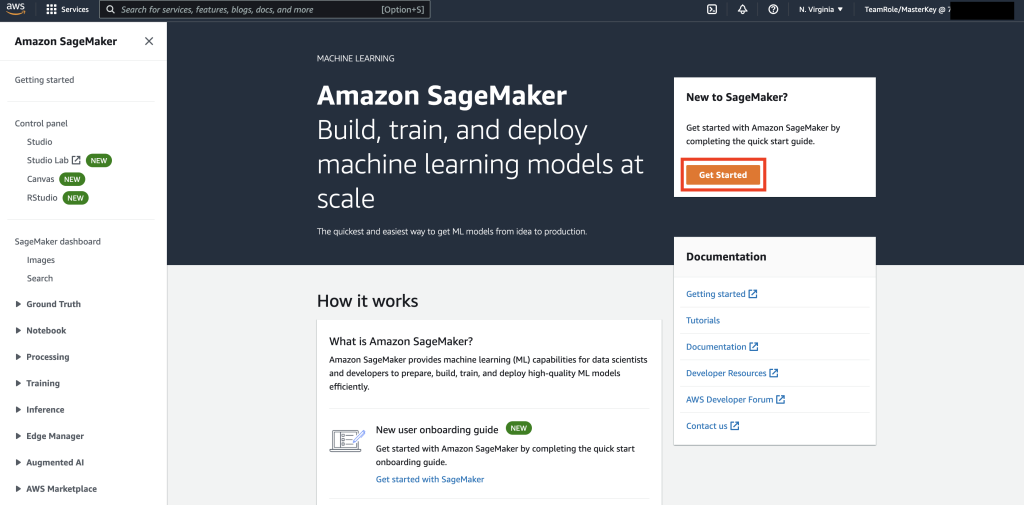

Innanzitutto, vai a SageMaker.

Quindi, se è la prima volta che utilizzi SageMaker, seleziona Inizia Ora.

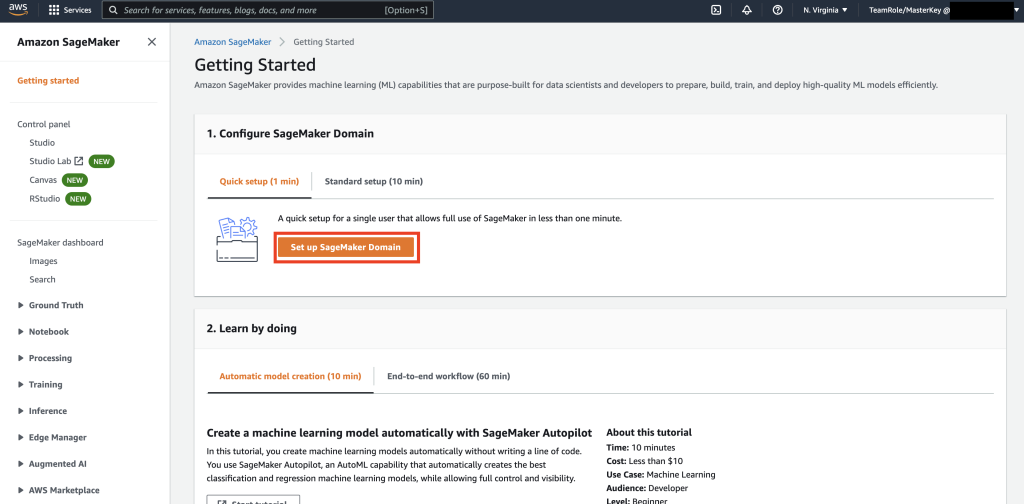

Quindi, selezionare Configura il dominio SageMaker.

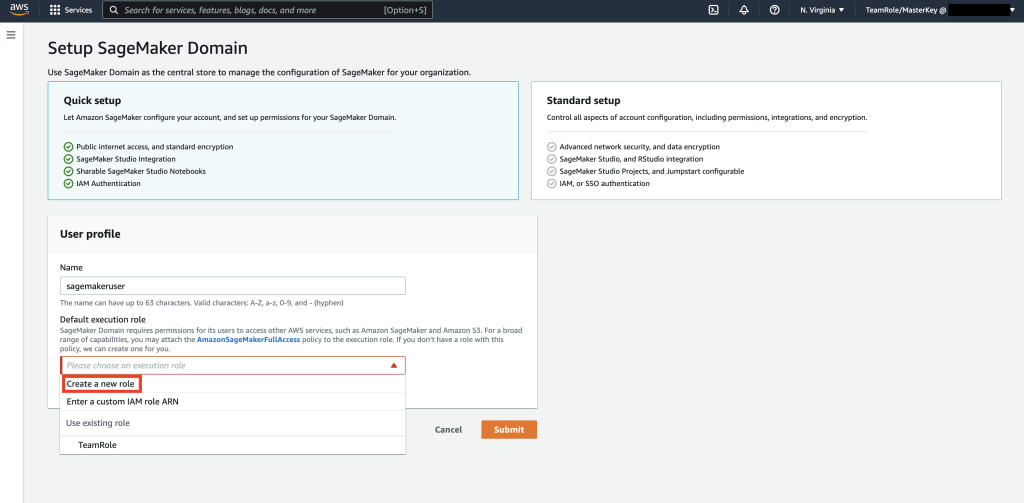

Quindi, crea un nuovo profilo utente con Nome – sagemakerusere selezionare Crea nuovo ruolo nel Ruolo di esecuzione predefinito sottosezione.

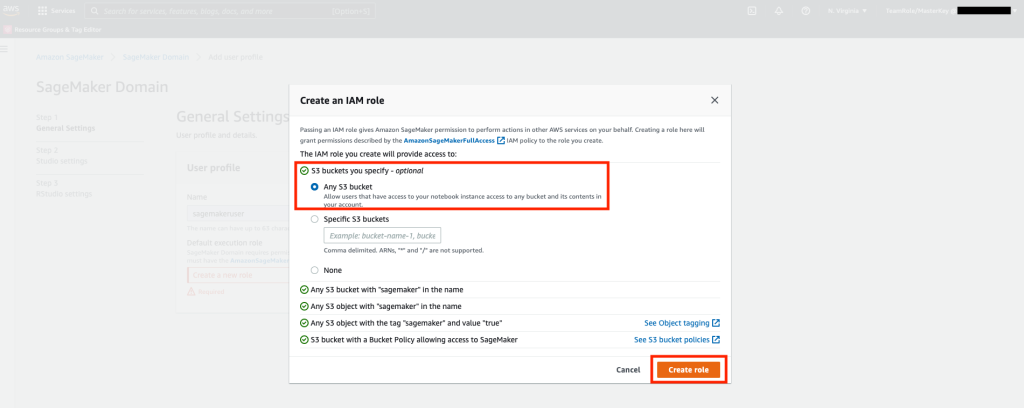

Quindi, nella schermata che si apre, seleziona qualsiasi Servizio di archiviazione semplice Amazon (Amazon S3) bucket e seleziona Crea ruolo.

Questo ruolo verrà utilizzato nei passaggi seguenti per consentire a SageMaker di accedere alla tabella degli spazi delle chiavi utilizzando le credenziali temporanee del ruolo. Ciò elimina la necessità di memorizzare un nome utente e una password nel notebook.

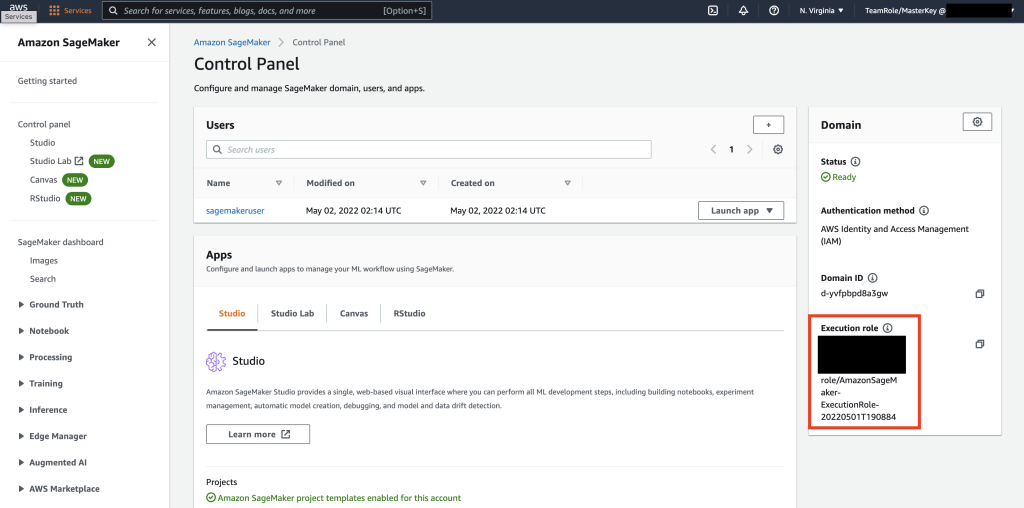

Successivamente, recupera il ruolo associato a sagemakeruser che è stato creato nel passaggio precedente dalla sezione di riepilogo.

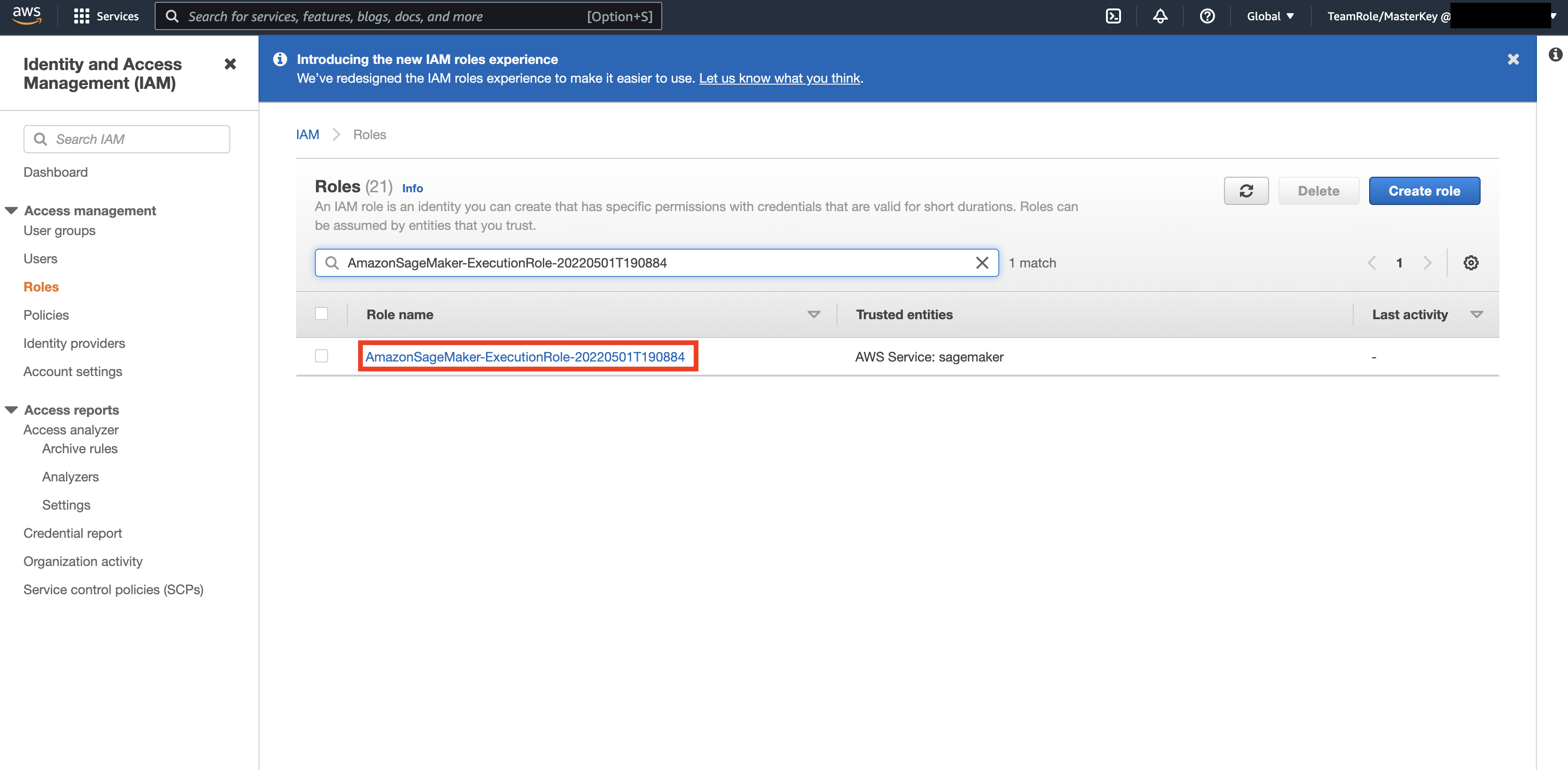

Quindi, vai a Console AWS e guarda in alto AWS Identity and Access Management (IAM). All'interno di IAM, vai a Ruoli. All'interno dei ruoli, cerca il ruolo di esecuzione identificato nel passaggio precedente.

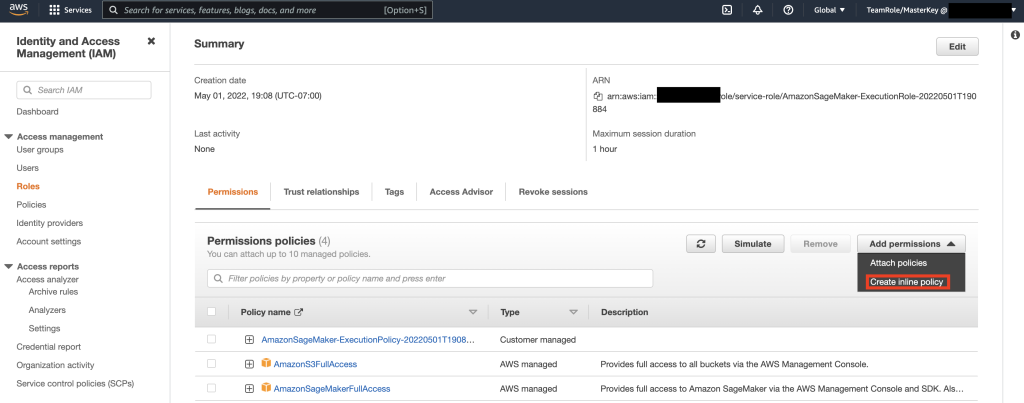

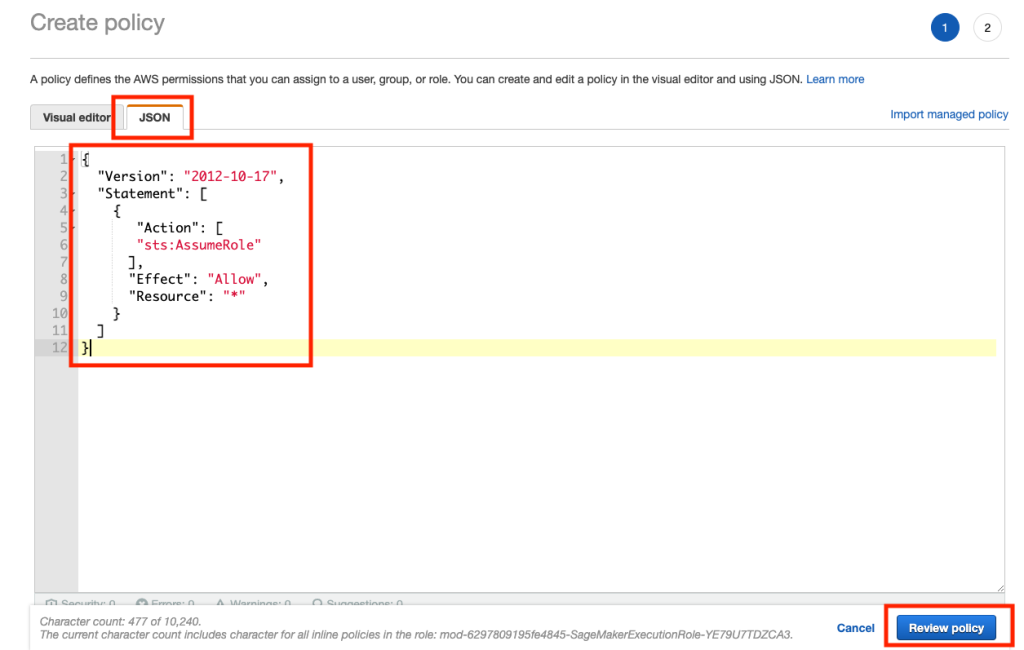

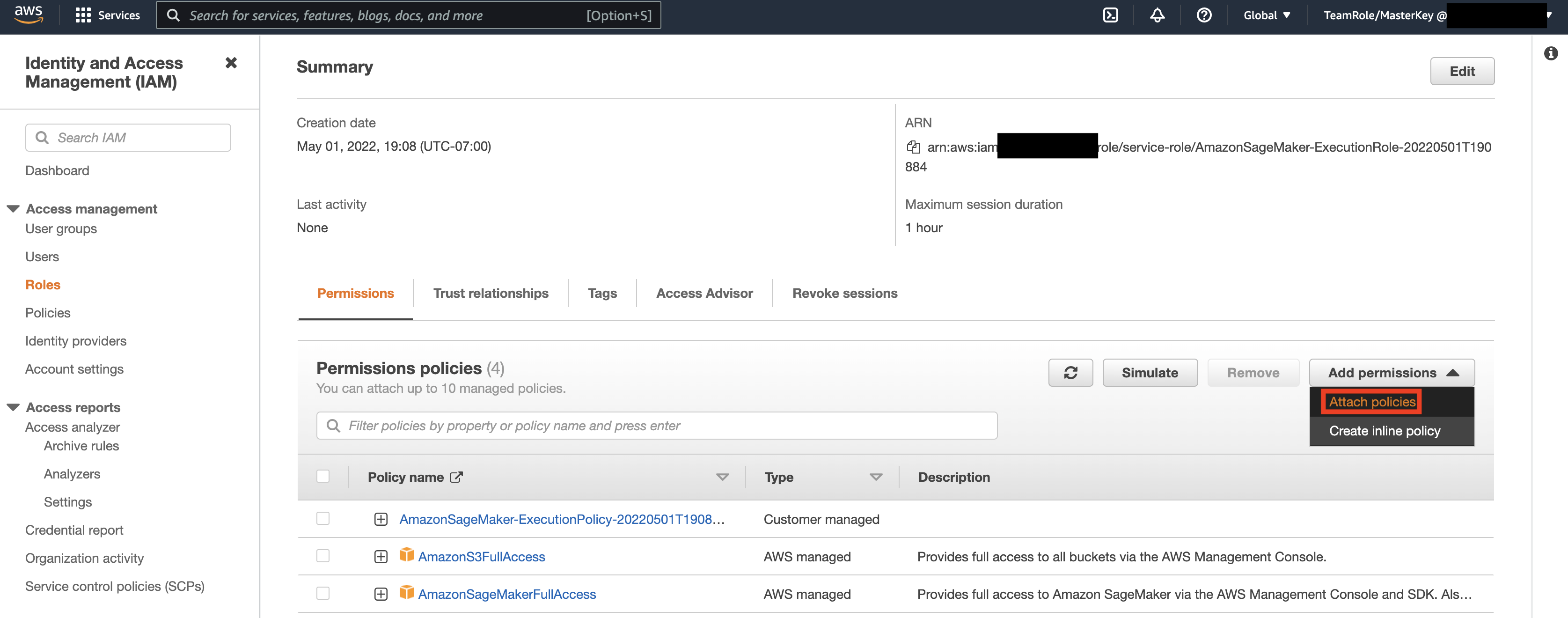

Quindi, seleziona il ruolo identificato nel passaggio precedente e seleziona Aggiungi autorizzazioni. Nel menu a discesa visualizzato, seleziona Crea criterio in linea. SageMaker consente di fornire un livello granulare di accesso che limita le azioni che un utente/applicazione può eseguire in base ai requisiti aziendali.

Quindi, seleziona la scheda JSON e copia la policy dalla sezione Note di Github pagina. Questa politica consente al notebook SageMaker di connettersi a Keyspace e recuperare i dati per un'ulteriore elaborazione.

Quindi, seleziona di nuovo Aggiungi autorizzazioni e dal menu a discesa, quindi seleziona Allega criterio.

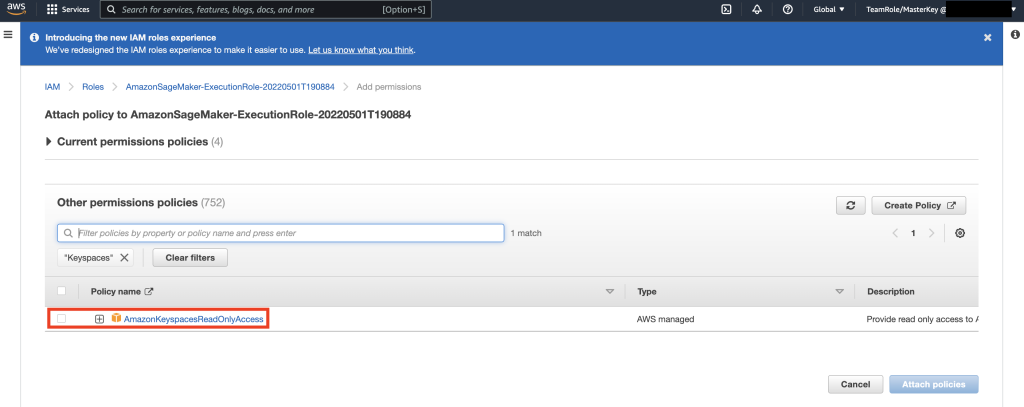

Cerca la policy AmazonKeyspacesFullAccess, seleziona la casella di controllo accanto al risultato corrispondente e seleziona Allega policy.

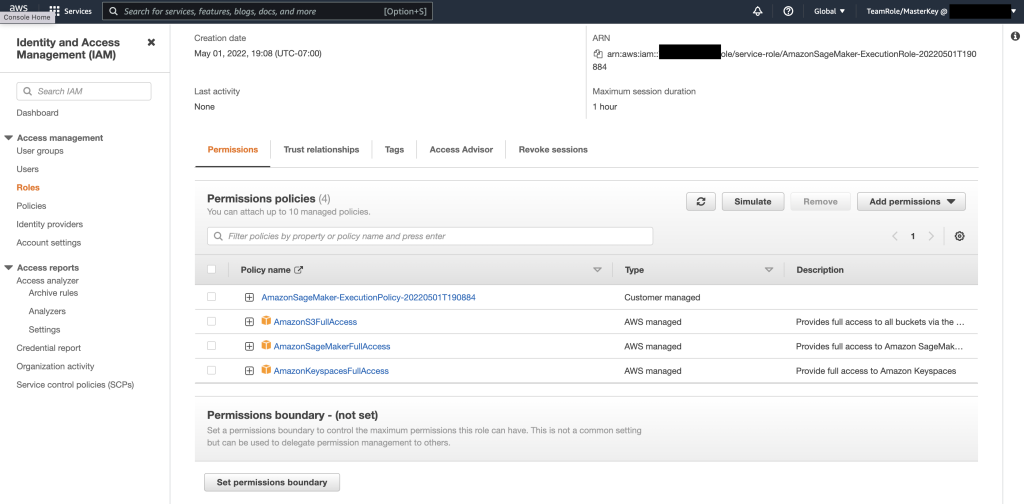

Verifica che la sezione dei criteri di autorizzazione includa AmazonS3FullAccess, AmazonSageMakerFullAccess, AmazonKeyspacesFullAccess, nonché la politica in linea appena aggiunta.

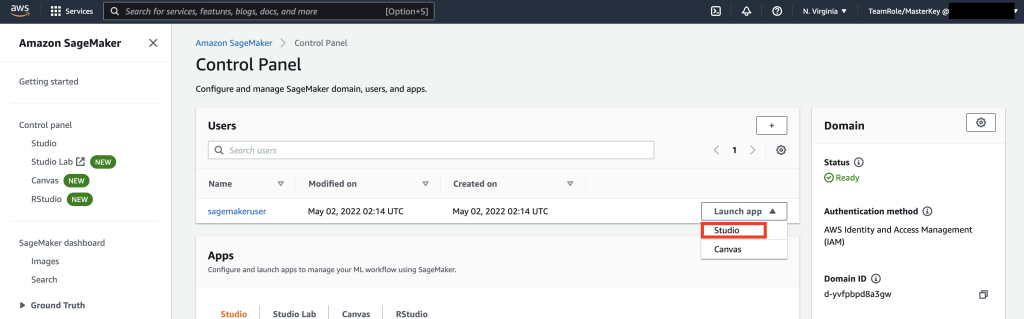

Quindi, vai a SageMaker Studio utilizzando la Console AWS e seleziona SageMaker Studio. Una volta lì, seleziona Avvia app e seleziona Studio.

Guida dettagliata del taccuino

Il modo preferito per connettersi a Keyspace da SageMaker Notebook è utilizzando Processo di firma AWS versione 4 (SigV4) basato Credenziali temporanee per l'autenticazione. In questo scenario, NON è necessario generare o archiviare le credenziali degli spazi delle chiavi e possiamo utilizzare le credenziali per autenticarci con il plug-in SigV4. Le credenziali di sicurezza temporanee sono costituite da un ID chiave di accesso e da una chiave di accesso segreta. Tuttavia, includono anche un token di sicurezza che indica quando scadono le credenziali. In questo post creeremo un ruolo IAM e genereremo credenziali di sicurezza temporanee.

Innanzitutto, installiamo un driver (cassandra-sigv4). Questo driver ti consente di aggiungere informazioni di autenticazione alle tue richieste API utilizzando il processo AWS Signature Version 4 (SigV4). Utilizzando il plug-in, puoi fornire a utenti e applicazioni credenziali a breve termine per accedere ad Amazon Keyspaces (per Apache Cassandra) utilizzando utenti e ruoli IAM. Successivamente, importerai un certificato richiesto insieme a dipendenze aggiuntive del pacchetto. Alla fine, consentirai al taccuino di assumere il ruolo di parlare con Keyspace.

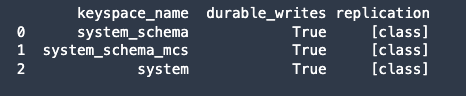

Successivamente, connettiti ad Amazon Keyspaces e leggi i dati di sistema da Keyspaces in Pandas DataFrame per convalidare la connessione.

Quindi, prepara i dati per l'addestramento sul set di dati grezzi. Nel taccuino Python associato a questo post, usa un set di dati di vendita al dettaglio scaricato da qui, ed elaborarlo. Il nostro obiettivo aziendale, dato il set di dati, è raggruppare i clienti utilizzando una specifica metrica chiamata RFM. Il modello RFM si basa su tre fattori quantitativi:

- Recente: quanto recentemente un cliente ha effettuato un acquisto.

- Frequenza: la frequenza con cui un cliente effettua un acquisto.

- Valore monetario: quanti soldi un cliente spende per gli acquisti.

L'analisi RFM classifica numericamente un cliente in ciascuna di queste tre categorie, generalmente su una scala da 1 a 5 (maggiore è il numero, migliore è il risultato). Il cliente "migliore" riceverà un punteggio massimo in ogni categoria. Useremo la funzione di discretizzazione basata sui quantili di Pandas (qcut). Aiuterà a discretizzare i valori in bucket di uguali dimensioni basati o basati su quantili campione.

In questo esempio, utilizziamo CQL per leggere i record dalla tabella Keyspace. In alcuni casi d'uso di ML, potrebbe essere necessario leggere gli stessi dati dalla stessa tabella Keyspace più volte. In questo caso, ti consigliamo di salvare i tuoi dati in un bucket Amazon S3 per evitare di incorrere in altri costosta leggendo da Amazon Keyspaces. A seconda del tuo scenario, puoi anche usare Amazon EMR a ingerire un file Amazon S3 molto grande in SageMaker.

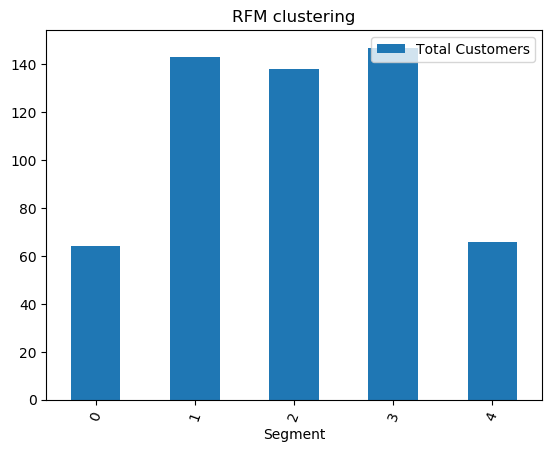

Successivamente, addestriamo un modello ML utilizzando l'algoritmo KMeans e ci assicuriamo che i cluster vengano creati. In questo scenario particolare, vedresti che i cluster creati vengono stampati, mostrando che i clienti nel set di dati non elaborati sono stati raggruppati in base a vari attributi nel set di dati. Queste informazioni sul cluster possono essere utilizzate per campagne di marketing mirate.

(Facoltativo) Successivamente, salviamo i segmenti di clienti che sono stati identificati dal modello ML in una tabella Amazon Keyspaces per un marketing mirato. Un processo batch potrebbe leggere questi dati ed eseguire campagne mirate per clienti in segmenti specifici.

Alla fine, noi ripulire le risorse creato durante questo tutorial per evitare costi aggiuntivi.

Il completamento dell'eliminazione di keyspace e tabelle potrebbe richiedere da alcuni secondi a un minuto. Quando elimini uno spazio delle chiavi, lo spazio delle chiavi e tutte le relative tabelle vengono eliminate e smetti di accumulare addebiti da esse.

Conclusione

Questo post ti ha mostrato come importare i dati dei clienti da Amazon Keyspaces in SageMaker e addestrare un modello di clustering che ti ha permesso di segmentare i clienti. Potresti utilizzare queste informazioni per marketing mirato, migliorando così notevolmente il tuo KPI aziendale. Per ulteriori informazioni su Amazon Keyspaces, consulta le seguenti risorse:

- Addestra modelli di machine learning utilizzando Amazon Keyspaces come origine dati (Taccuino SageMaker)

- Connettiti ad Amazon Keyspaces dal tuo desktop utilizzando gli IDE IntelliJ, PyCharm o DataGrip

- Riferimento al linguaggio CQL per Amazon Keyspaces (per Apache Cassandra)

- Come configurare l'accesso da riga di comando ad Amazon Keyspaces (per Apache Cassandra) utilizzando la nuova immagine Docker del toolkit per sviluppatori

- Identity and Access Management per Amazon Keyspaces (per Apache Cassandra)

- Connessione ad Amazon Keyspaces da SageMaker con credenziali specifiche del servizio

- Recente, frequenza, valore monetario (RFM)

- Riferimento codice Kaggle

Informazioni sugli autori

Vadim Ljakhovich è Senior Solutions Architect presso AWS nella Baia di San Francisco, aiutando i clienti a migrare ad AWS. Sta lavorando con organizzazioni che vanno dalle grandi imprese alle piccole startup per supportare le loro innovazioni. Sta inoltre aiutando i clienti a progettare soluzioni scalabili, sicure ed economiche su AWS.

Vadim Ljakhovich è Senior Solutions Architect presso AWS nella Baia di San Francisco, aiutando i clienti a migrare ad AWS. Sta lavorando con organizzazioni che vanno dalle grandi imprese alle piccole startup per supportare le loro innovazioni. Sta inoltre aiutando i clienti a progettare soluzioni scalabili, sicure ed economiche su AWS.

Parte Patel è Solutions Architect presso AWS nella Bay Area di San Francisco. Parth guida i clienti ad accelerare il loro viaggio verso il cloud e li aiuta ad adottare con successo il cloud AWS. Si concentra sul ML e sulla modernizzazione delle applicazioni.

Parte Patel è Solutions Architect presso AWS nella Bay Area di San Francisco. Parth guida i clienti ad accelerare il loro viaggio verso il cloud e li aiuta ad adottare con successo il cloud AWS. Si concentra sul ML e sulla modernizzazione delle applicazioni.

Ram Pathangi è Solutions Architect presso AWS nella Bay Area di San Francisco. Ha aiutato i clienti nei settori verticale Agricoltura, Assicurazioni, Banche, Vendita al dettaglio, Assistenza sanitaria e scienze della vita, Ospitalità e Hi-Tech a gestire con successo la propria attività sul cloud AWS. È specializzato in Database, Analytics e ML.

Ram Pathangi è Solutions Architect presso AWS nella Bay Area di San Francisco. Ha aiutato i clienti nei settori verticale Agricoltura, Assicurazioni, Banche, Vendita al dettaglio, Assistenza sanitaria e scienze della vita, Ospitalità e Hi-Tech a gestire con successo la propria attività sul cloud AWS. È specializzato in Database, Analytics e ML.

- Coinsmart. Il miglior scambio di bitcoin e criptovalute d'Europa.

- Platoblockchain. Web3 Metaverse Intelligence. Conoscenza amplificata. ACCESSO LIBERO.

- Criptofalco. Radar Altcoin. Prova gratuita.

- Fonte: https://aws.amazon.com/blogs/machine-learning/train-machine-learning-models-using-amazon-keyspaces-as-a-data-source/

- '

- "

- &

- 10

- 100

- 9

- capacità

- Chi siamo

- accelerare

- accesso

- preciso

- Raggiungere

- azioni

- aggiuntivo

- agricoltura

- avanti

- algoritmo

- Tutti

- Amazon

- .

- analitica

- Un altro

- api

- API

- App

- Applicazioni

- applicazioni

- RISERVATA

- attenzione

- gli attributi

- Autenticazione

- automaticamente

- disponibile

- AWS

- Settore bancario

- Baia

- Blog

- sistema

- costruire

- affari

- aziende

- chiamata

- Responsabile Campagne

- che

- casi

- Categoria

- a livello internazionale

- oneri

- scegliere

- classificazione

- Cloud

- codice

- rispetto

- computer

- Connettiti

- veloce

- consolle

- costo effettivo

- potuto

- nazione

- creare

- creato

- Credenziali

- cliente

- Clienti

- dati

- set di dati

- Banca Dati

- banche dati

- fornisce un monitoraggio

- consegna

- Dipendente

- schierare

- distribuzione

- tavolo

- Determinare

- Costruttori

- sviluppatori

- diverso

- docker

- giù

- autista

- Cadere

- durante

- facilmente

- Ingegneri

- aziende

- usate

- stime

- esempio

- esecuzione

- Fattori

- Nome

- prima volta

- FLOTTA

- si concentra

- seguire

- i seguenti

- cibo

- Francisco

- function

- ulteriormente

- generalmente

- generare

- ottenere

- GitHub

- molto

- Gruppo

- Gruppo

- Guide

- Salute e benessere

- Assistenza sanitaria

- Aiuto

- aiutare

- Alta

- superiore

- vivamente

- storia

- Come

- Tutorial

- Tuttavia

- HTTPS

- Identità

- Immagine

- realizzare

- miglioramento

- miglioramento

- includere

- inclusi

- Index

- industriale

- informazioni

- Infrastruttura

- innovazioni

- install

- assicurazione

- integrato

- IT

- Lavoro

- viaggio

- Le

- laboratorio

- Lingua

- grandi

- lanciare

- strato

- IMPARARE

- apprendimento

- Livello

- Life Sciences

- Guarda

- leale

- macchina

- machine learning

- fatto

- mantenere

- FA

- gestire

- gestito

- gestione

- gestione

- Marketing

- massiccio

- corrispondenza

- Utenti

- ML

- modello

- modelli

- Monetario

- soldi

- monitoraggio

- Scopri di più

- maggior parte

- multiplo

- necessaria

- taccuino

- numero

- operare

- ottimizzazione

- organizzazioni

- Altro

- pacchetto

- particolare

- Password

- Toppa

- Paga le

- plug-in

- Termini e Condizioni

- politica

- Popolare

- possibile

- potenziale

- predire

- Preparare

- precedente

- prezzo

- primario

- processi

- i processi

- lavorazione

- Prodotto

- della produttività

- Profilo

- promettente

- fornire

- fornisce

- Acquista

- acquisti

- quantitativo

- rapidamente

- che vanno

- Crudo

- Lettura

- ricevere

- recentemente

- raccomandare

- record

- richieste

- necessario

- Requisiti

- Risorse

- Risultati

- nello specifico retail

- recensioni

- Rischio

- Ruolo

- strada

- Correre

- San

- San Francisco

- SC

- scalabile

- Scala

- SCIENZE

- scienziati

- allo

- Cerca

- secondo

- sicuro

- problemi di

- token di sicurezza

- segmento

- segmentazione

- segmenti

- serverless

- servizio

- Servizi

- set

- condiviso

- a breve scadenza

- mostrato

- simile

- Un'espansione

- sonno

- piccole

- So

- Software

- solido

- Soluzioni

- alcuni

- specializzata

- pila

- iniziato

- Startup

- conservazione

- Tornare al suo account

- studio

- Con successo

- supporto

- sistema

- SISTEMI DI TRATTAMENTO

- Parlare

- Target

- mirata

- temporaneo

- I

- Attraverso

- tempo

- volte

- oggi

- insieme

- token

- toolkit

- strumenti

- top

- commercio

- Training

- uso

- casi d'uso

- utenti

- APPREZZIAMO

- vario

- versione

- verticali

- visione

- Che

- entro

- senza

- lavoro

- sarebbe

- Trasferimento da aeroporto a Sharm