I referti radiologici sono documenti completi e lunghi che descrivono e interpretano i risultati di un esame di imaging radiologico. In un flusso di lavoro tipico, il radiologo supervisiona, legge e interpreta le immagini, quindi riassume in modo conciso i risultati principali. Il riassunto (o impressione) è la parte più importante del report perché aiuta i medici e i pazienti a concentrarsi sui contenuti critici del report che contengono informazioni per il processo decisionale clinico. Creare un’impressione chiara e di grande impatto richiede uno sforzo molto maggiore rispetto alla semplice riaffermazione dei risultati. L'intero processo è quindi laborioso, dispendioso in termini di tempo e soggetto a errori. Spesso ci vogliono anni formazione consentire ai medici di accumulare sufficiente esperienza nella scrittura di riassunti concisi e informativi dei rapporti radiologici, evidenziando ulteriormente l’importanza dell’automazione del processo. Inoltre, generazione automatica del riepilogo dei risultati del report è fondamentale per la refertazione radiologica. Consente la traduzione dei report in un linguaggio leggibile dall'uomo, alleviando così il carico dei pazienti di leggere report lunghi e oscuri.

Per risolvere questo problema, proponiamo l’uso dell’intelligenza artificiale generativa, un tipo di intelligenza artificiale in grado di creare nuovi contenuti e idee, tra cui conversazioni, storie, immagini, video e musica. L'intelligenza artificiale generativa si basa su modelli di machine learning (ML), modelli molto grandi pre-addestrati su grandi quantità di dati e comunemente denominati modelli Foundation (FM). I recenti progressi nel machine learning (in particolare l’invenzione dell’architettura di rete neurale basata su trasformatore) hanno portato alla nascita di modelli che contengono miliardi di parametri o variabili. La soluzione proposta in questo post utilizza la messa a punto di modelli linguistici di grandi dimensioni (LLM) preaddestrati per aiutare a generare riepiloghi basati sui risultati nei referti radiologici.

Questo post dimostra una strategia per mettere a punto gli LLM disponibili al pubblico per l'attività di riepilogo dei report radiologici utilizzando i servizi AWS. Gli LLM hanno dimostrato notevoli capacità nella comprensione e nella generazione del linguaggio naturale, fungendo da modelli di base che possono essere adattati a vari domini e compiti. L'utilizzo di un modello pre-addestrato presenta vantaggi significativi. Riduce i costi di calcolo, riduce l'impronta di carbonio e consente di utilizzare modelli all'avanguardia senza doverne addestrare uno da zero.

La nostra soluzione utilizza il file FLAN-T5XL FM, utilizzando JumpStart di Amazon SageMaker, che è un hub di machine learning che offre algoritmi, modelli e soluzioni di machine learning. Dimostriamo come eseguire questa operazione utilizzando un notebook in Amazon Sage Maker Studio. La messa a punto di un modello pre-addestrato comporta un'ulteriore formazione su dati specifici per migliorare le prestazioni su un'attività diversa ma correlata. Questa soluzione prevede la messa a punto del modello FLAN-T5 XL, che è una versione migliorata di T5 (Text-to-Text Transfer Transformer) LLM per scopi generali. T5 riformula le attività di elaborazione del linguaggio naturale (NLP) in un formato testo-testo unificato, in contrasto con BERTAmodelli in stile che possono restituire solo un'etichetta di classe o un intervallo di input. È ottimizzato per un'attività di riepilogo di 91,544 referti radiologici a testo libero ottenuti dal Set di dati MIMIC-CXR.

Panoramica della soluzione

In questa sezione, discutiamo i componenti chiave della nostra soluzione: scelta della strategia per l'attività, messa a punto di un LLM e valutazione dei risultati. Illustriamo inoltre l'architettura della soluzione e i passaggi per implementare la soluzione.

Identificare la strategia per l'attività

Esistono varie strategie per affrontare il compito di automatizzare il riepilogo dei report clinici. Ad esempio, potremmo utilizzare un modello linguistico specializzato pre-addestrato su rapporti clinici partendo da zero. In alternativa, potremmo mettere a punto direttamente un modello linguistico di uso generale disponibile al pubblico per eseguire il compito clinico. L'utilizzo di un modello indipendente dal dominio ottimizzato può essere necessario in contesti in cui la formazione a modello linguistico da zero è troppo costoso. In questa soluzione, dimostriamo quest'ultimo approccio utilizzando un modello FLAN -T5 XL, che ottimizziamo per il compito clinico di riepilogo dei referti radiologici. Il diagramma seguente illustra il flusso di lavoro del modello.

Un tipico referto radiologico è ben organizzato e conciso. Tali rapporti hanno spesso tre sezioni chiave:

- sfondo – Fornisce informazioni generali sui dati demografici del paziente con informazioni essenziali sul paziente, storia clinica e storia medica rilevante e dettagli sulle procedure di esame

- Giudizio – Presenta diagnosi e risultati dettagliati dell'esame

- stampa – Riassume in modo conciso i risultati più salienti o l’interpretazione dei risultati con una valutazione del significato e una potenziale diagnosi basata sulle anomalie osservate

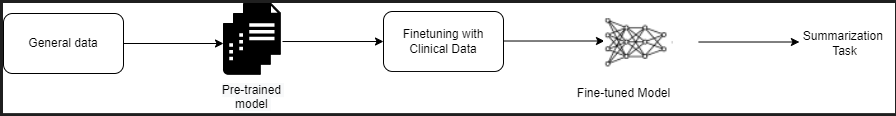

Utilizzando la sezione risultati nei referti radiologici, la soluzione genera la sezione impronte, che corrisponde al riepilogo dei medici. La figura seguente è un esempio di referto radiologico.

Ottimizzare un LLM di uso generale per un'attività clinica

In questa soluzione, perfezioniamo un modello FLAN-T5 XL (regolando tutti i parametri del modello e ottimizzandoli per l'attività). Perfezioniamo il modello utilizzando il set di dati del dominio clinico MIMIC-CXR, che è un set di dati disponibile al pubblico delle radiografie del torace. Per mettere a punto questo modello tramite SageMaker Jumpstart, è necessario fornire esempi etichettati sotto forma di coppie {prompt, completamento}. In questo caso, utilizziamo coppie di {Findings, Impression} dai report originali nel set di dati MIMIC-CXR. Per l'inferenza, utilizziamo un prompt come mostrato nell'esempio seguente:

![]()

Il modello è messo a punto su un calcolo accelerato ml.p3.16xgrande istanza con 64 CPU virtuali e 488 GiB di memoria. Per la validazione, il 5% del set di dati è stato selezionato in modo casuale. Il tempo trascorso del processo di formazione di SageMaker con la messa a punto è stato di 38,468 secondi (circa 11 ore).

Valuta i risultati

Una volta completata la formazione, è fondamentale valutare i risultati. Per un'analisi quantitativa dell'impressione generata, utilizziamo ROUGE (Recall-Oriented Understudy for Gisting Evaluation), la metrica più comunemente utilizzata per valutare il riepilogo. Questa metrica confronta un riassunto prodotto automaticamente con un riassunto o una traduzione di riferimento o una serie di riferimenti (prodotti dall'uomo). ROUGE1 si riferisce alla sovrapposizione di unigrammi (ogni parola) tra il candidato (l'output del modello) e i riepiloghi di riferimento. ROUGE2 si riferisce alla sovrapposizione di bigrammi (due parole) tra il candidato e i riassunti di riferimento. ROUGEL è una metrica a livello di frase e si riferisce alla sottosequenza comune più lunga (LCS) tra due parti di testo. Ignora i ritorni a capo nel testo. ROUGELsum è una metrica a livello di riepilogo. Per questa metrica, i ritorni a capo nel testo non vengono ignorati ma vengono interpretati come limiti di frase. Viene quindi calcolato l'LCS tra ciascuna coppia di frasi di riferimento e candidate, quindi viene calcolata l'unione-LCS. Per l'aggregazione di questi punteggi su un dato insieme di frasi di riferimento e candidate, viene calcolata la media.

Walkthrough e architettura

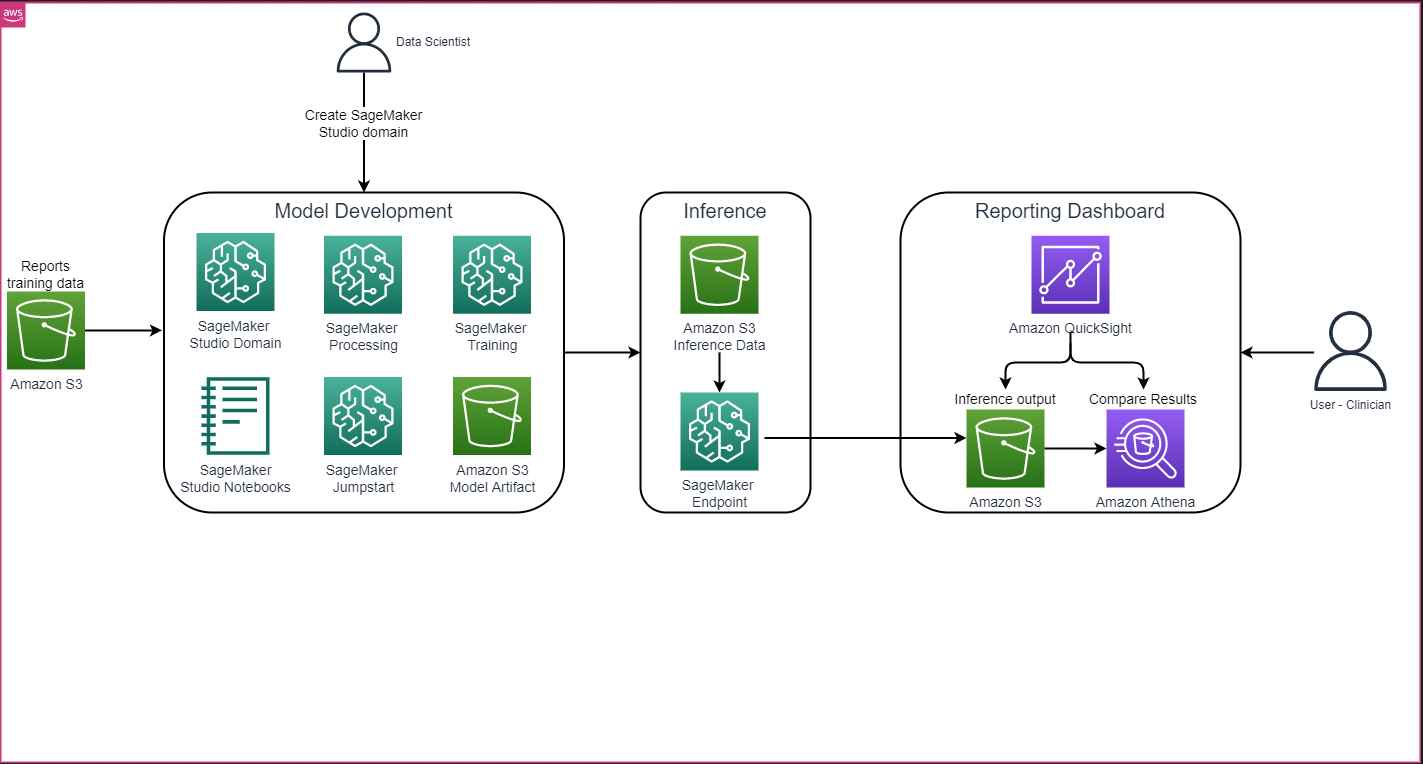

L'architettura complessiva della soluzione, come mostrato nella figura seguente, consiste principalmente in un ambiente di sviluppo del modello che utilizza SageMaker Studio, una distribuzione del modello con un endpoint SageMaker e un dashboard di reporting che utilizza Amazon QuickSight.

Nelle sezioni seguenti, dimostriamo la messa a punto di un LLM disponibile su SageMaker JumpStart per il riepilogo di un'attività specifica del dominio tramite SageMaker Python SDK. In particolare trattiamo i seguenti argomenti:

- Passaggi per configurare l'ambiente di sviluppo

- Una panoramica dei set di dati dei referti radiologici su cui il modello viene messo a punto e valutato

- Una dimostrazione della messa a punto del modello FLAN-T5 XL utilizzando SageMaker JumpStart a livello di codice con SageMaker Python SDK

- Inferenza e valutazione dei modelli pre-addestrati e ottimizzati

- Confronto dei risultati del modello pre-addestrato e dei modelli ottimizzati

La soluzione è disponibile in Generazione di impressioni di report radiologici utilizzando l'intelligenza artificiale generativa con modello linguistico di grandi dimensioni su AWS Repository GitHub.

Prerequisiti

Per iniziare, è necessario un file Account AWS in cui puoi utilizzare SageMaker Studio. Dovrai creare un profilo utente per SageMaker Studio se non ne hai già uno.

Il tipo di istanza di training utilizzato in questo post è ml.p3.16xlarge. Tieni presente che il tipo di istanza p3 richiede un aumento del limite della quota di servizio.

I Set di dati MIMIC CXR è possibile accedervi tramite un accordo sull'utilizzo dei dati, che richiede la registrazione dell'utente e il completamento di un processo di credenziale.

Configurare l'ambiente di sviluppo

Per configurare il tuo ambiente di sviluppo, crea un bucket S3, configura un notebook, crea endpoint, distribuisci i modelli e crea un dashboard QuickSight.

Crea un bucket S3

Crea un bucket S3 detto llm-radiology-bucket per ospitare i set di dati di formazione e valutazione. Questo verrà utilizzato anche per archiviare l'artefatto del modello durante lo sviluppo del modello.

Configura un taccuino

Completa i seguenti passi:

- Avvia SageMaker Studio dalla console SageMaker o da Interfaccia della riga di comando di AWS (interfaccia a riga di comando dell'AWS).

Per ulteriori informazioni sull'onboarding in un dominio, vedere Integrazione nel dominio Amazon SageMaker.

- Crea un nuovo Taccuino di SageMaker Studio per pulire i dati del report e ottimizzare il modello. Utilizziamo un'istanza notebook ml.t3.medium 2vCPU+4GiB con un kernel Python 3.

- All'interno del notebook, installare i pacchetti pertinenti come

nest-asyncio,IPyWidgets(per i widget interattivi per il notebook Jupyter) e SageMaker Python SDK:

Per inferire i modelli pre-addestrati e ottimizzati, creare un endpoint e distribuire ciascun modello nel taccuino come segue:

- Crea un oggetto modello dalla classe Model che può essere distribuito a un endpoint HTTPS.

- Crea un endpoint HTTPS con il file predefinito dell'oggetto modello

deploy()Metodo:

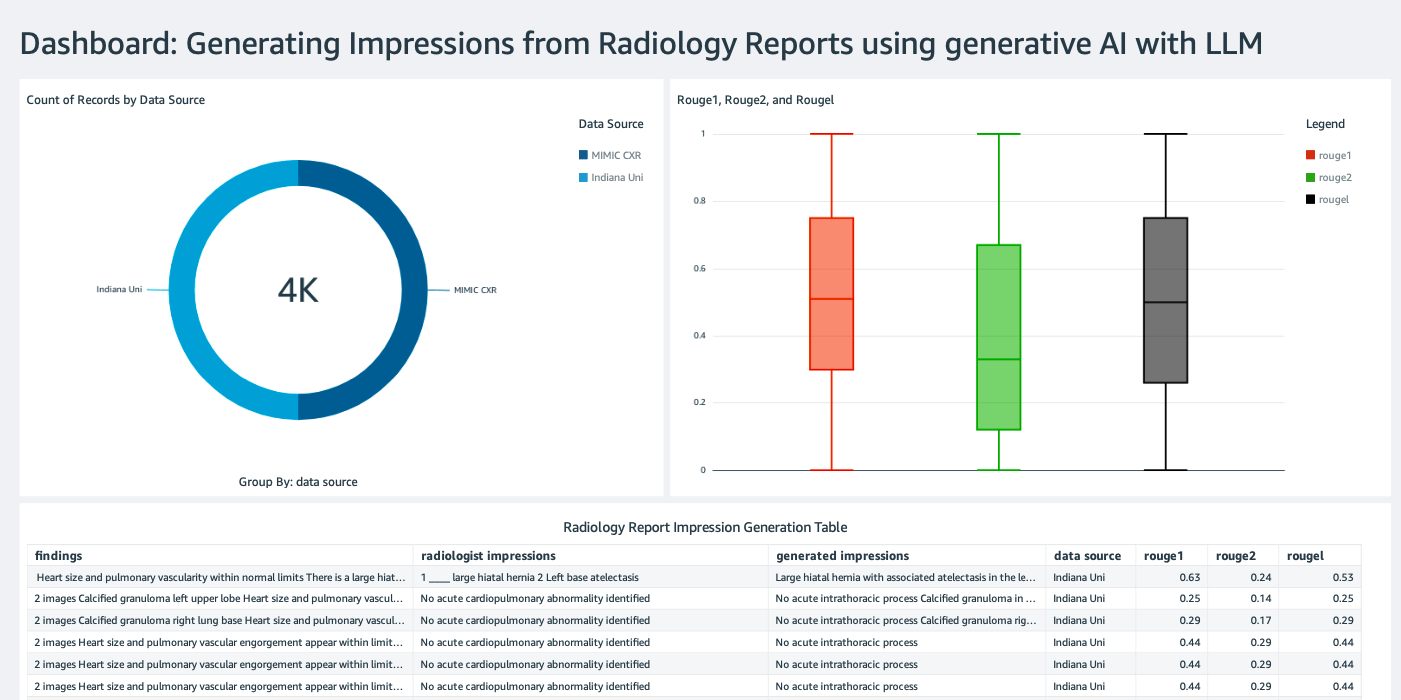

Crea una dashboard QuickSight

Creare un Dashboard QuickSight con un'origine dati Athena con i risultati dell'inferenza Servizio di archiviazione semplice Amazon (Amazon S3) per confrontare i risultati dell'inferenza con la verità fondamentale. Lo screenshot seguente mostra la nostra dashboard di esempio.

Set di dati dei referti radiologici

Il modello è ora ottimizzato, tutti i parametri del modello sono ottimizzati su 91,544 report scaricati dal Set di dati MIMIC-CXR v2.0. Poiché abbiamo utilizzato solo i dati di testo del referto radiologico, abbiamo scaricato solo un file di referto compresso (mimic-cxr-reports.zip) dal sito web MIMIC-CXR. Ora valutiamo il modello ottimizzato su 2,000 report (denominati dev1 set di dati) dal separato ha tenuto un sottoinsieme di questo set di dati. Utilizziamo altri 2,000 referti radiologici (denominati dev2) per la valutazione del modello messo a punto dalla raccolta di radiografie del torace del Rete ospedaliera dell'Università dell'Indiana. Tutti i set di dati vengono letti come file JSON e caricati nel bucket S3 appena creato llm-radiology-bucket. Tieni presente che tutti i set di dati per impostazione predefinita non contengono informazioni sanitarie protette (PHI); tutte le informazioni sensibili vengono sostituite con tre trattini bassi consecutivi (___) da parte dei fornitori.

Ottimizza con SageMaker Python SDK

Per la messa a punto, il model_id è specificato come huggingface-text2text-flan-t5-xl dall'elenco dei modelli SageMaker JumpStart. IL training_instance_type è impostato come ml.p3.16xlarge e il file inference_instance_type come ml.g5.2xlarge. I dati di addestramento in formato JSON vengono letti dal bucket S3. Il passaggio successivo consiste nell'utilizzare il model_id selezionato per estrarre gli URI delle risorse JumpStart di SageMaker, inclusi image_uri (la Registro dei contenitori Amazon Elastic (Amazon ECR) URI per l'immagine Docker), model_uri (l'URI Amazon S3 dell'artefatto del modello pre-addestrato) e script_uri (il copione della formazione):

Inoltre, una posizione di output viene configurata come cartella all'interno del bucket S3.

Solo un iperparametro, epoche, viene modificato in 3 e tutti gli altri sono impostati come predefiniti:

Le metriche di formazione come eval_loss (per perdita di convalida), loss (per perdita di allenamento) e epoch da tracciare sono definiti ed elencati:

Utilizziamo gli URI delle risorse JumpStart di SageMaker (image_uri, model_uri, script_uri) identificato in precedenza per creare uno stimatore e perfezionarlo sul set di dati di addestramento specificando il percorso S3 del set di dati. La classe Estimator richiede un file entry_point parametro. In questo caso, JumpStart utilizza transfer_learning.py. Il processo di training non viene eseguito se questo valore non è impostato.

Il completamento di questo lavoro di formazione può richiedere ore; pertanto, si consiglia di impostare il parametro wait su False e monitorare lo stato del processo di training sulla console SageMaker. Usa il TrainingJobAnalytics funzione per tenere traccia delle metriche di allenamento in vari timestamp:

Distribuire endpoint di inferenza

Per effettuare confronti, distribuiamo endpoint di inferenza sia per i modelli pre-addestrati che per quelli ottimizzati.

Innanzitutto, recupera l'URI dell'immagine Docker di inferenza utilizzando model_ide utilizzare questo URI per creare un'istanza del modello SageMaker del modello pre-addestrato. Distribuisci il modello pre-addestrato creando un endpoint HTTPS con il modello pre-costruito dell'oggetto modello deploy() metodo. Per eseguire l'inferenza tramite l'API SageMaker, assicurati di passare la classe Predictor.

Ripeti il passaggio precedente per creare un'istanza del modello SageMaker del modello ottimizzato e creare un endpoint per distribuire il modello.

Valutare i modelli

Innanzitutto, impostare la lunghezza del testo riepilogativo, il numero di output del modello (deve essere maggiore di 1 se è necessario generare più riepiloghi) e il numero di travi per ricerca del raggio.

Costruisci la richiesta di inferenza come payload JSON e utilizzala per eseguire query sugli endpoint per i modelli preaddestrati e ottimizzati.

Calcola l'aggregato ROUGE segna (ROUGE1, ROUGE2, ROUGEL, ROUGELsum) come descritto in precedenza.

Confronta i risultati

La tabella seguente illustra i risultati della valutazione per il dev1 ed dev2 set di dati. Il risultato della valutazione su dev1 (2,000 risultati dal rapporto radiologico MIMIC CXR) mostrano un miglioramento di circa 38 punti percentuali nella media aggregata ROUGE1 e ROUGE2 punteggi rispetto al modello pre-addestrato. Per dev2, si osserva un miglioramento di 31 punti percentuali e 25 punti percentuali nei punteggi ROUGE1 e ROUGE2. Nel complesso, la messa a punto ha portato a un miglioramento di 38.2 punti percentuali e 31.3 punti percentuali nei punteggi ROUGELsum per il dev1 ed dev2 set di dati, rispettivamente.

|

Valutazione dataset |

Modello pre-addestrato | Modello perfezionato | ||||||

| ROSSO1 | ROSSO2 | ROUGEL | ROUGELsomma | ROSSO1 | ROSSO2 | ROUGEL | ROUGELsomma | |

dev1 |

0.2239 | 0.1134 | 0.1891 | 0.1891 | 0.6040 | 0.4800 | 0.5705 | 0.5708 |

dev2 |

0.1583 | 0.0599 | 0.1391 | 0.1393 | 0.4660 | 0.3125 | 0.4525 | 0.4525 |

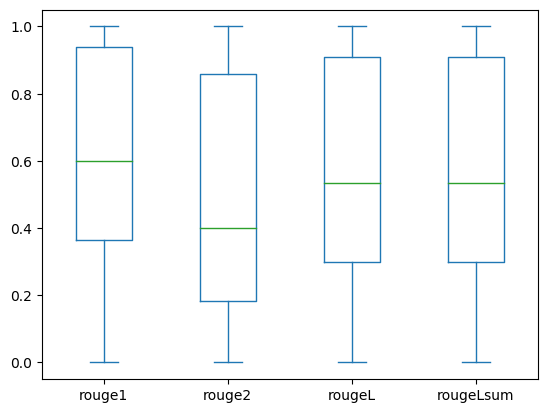

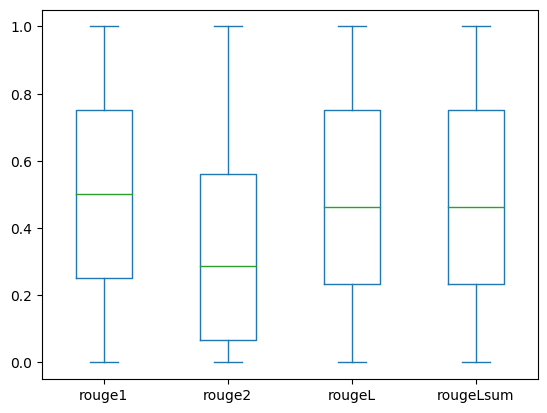

I seguenti box plot rappresentano la distribuzione dei punteggi ROUGE per dev1 ed dev2 set di dati valutati utilizzando il modello ottimizzato.

|

|

(un): dev1 |

(B): dev2 |

La tabella seguente mostra che i punteggi ROUGE per i set di dati di valutazione hanno approssimativamente la stessa mediana e media e pertanto sono distribuiti simmetricamente.

| Dataset | Partiture | Contare | Significare | Deviazione standard | Minimo | 25% percentuale | 50% percentuale | 75% percentuale | Massimo |

dev1 |

ROSSO1 | 2000.00 | 0.6038 | 0.3065 | 0.0000 | 0.3653 | 0.6000 | 0.9384 | 1.0000 |

| ROSSO 2 | 2000.00 | 0.4798 | 0.3578 | 0.0000 | 0.1818 | 0.4000 | 0.8571 | 1.0000 | |

| ROUGE L | 2000.00 | 0.5706 | 0.3194 | 0.0000 | 0.3000 | 0.5345 | 0.9101 | 1.0000 | |

| ROUGELsomma | 2000.00 | 0.5706 | 0.3194 | 0.0000 | 0.3000 | 0.5345 | 0.9101 | 1.0000 | |

dev2 |

ROSSO 1 | 2000.00 | 0.4659 | 0.2525 | 0.0000 | 0.2500 | 0.5000 | 0.7500 | 1.0000 |

| ROSSO 2 | 2000.00 | 0.3123 | 0.2645 | 0.0000 | 0.0664 | 0.2857 | 0.5610 | 1.0000 | |

| ROUGE L | 2000.00 | 0.4529 | 0.2554 | 0.0000 | 0.2349 | 0.4615 | 0.7500 | 1.0000 | |

| ROUGE Lsum | 2000.00 | 0.4529 | 0.2554 | 0.0000 | 0.2349 | 0.4615 | 0.7500 | 1.0000 |

ripulire

Per evitare di incorrere in addebiti futuri, elimina le risorse che hai creato con il seguente codice:

Conclusione

In questo post, abbiamo dimostrato come mettere a punto un modello FLAN-T5 XL per un'attività di riepilogo specifica del dominio clinico utilizzando SageMaker Studio. Per aumentare la fiducia, abbiamo confrontato le previsioni con la realtà dei fatti e valutato i risultati utilizzando le metriche ROUGE. Abbiamo dimostrato che un modello messo a punto per un compito specifico restituisce risultati migliori rispetto a un modello pre-addestrato su un compito di PNL generico. Vorremmo sottolineare che la messa a punto di un LLM generico elimina del tutto il costo della pre-formazione.

Sebbene il lavoro qui presentato si concentri sui referti delle radiografie del torace, ha il potenziale per essere esteso a set di dati più grandi con varie anatomie e modalità, come MRI e TC, per i quali i referti radiologici potrebbero essere più complessi con risultati multipli. In tali casi, i radiologi potrebbero generare impressioni in ordine di criticità e includere raccomandazioni di follow-up. Inoltre, la creazione di un ciclo di feedback per questa applicazione consentirebbe ai radiologi di migliorare le prestazioni del modello nel tempo.

Come abbiamo mostrato in questo post, il modello ottimizzato genera impressioni per referti radiologici con punteggi ROUGE elevati. Puoi provare a mettere a punto LLM su altri rapporti medici specifici del dominio di diversi dipartimenti.

Circa gli autori

Dottor Adewale Akinfaderin è un Data Scientist senior nel settore sanitario e delle scienze della vita presso AWS. La sua esperienza riguarda metodi AI/ML riproducibili ed end-to-end, implementazioni pratiche e assistenza ai clienti del settore sanitario globale nella formulazione e nello sviluppo di soluzioni scalabili a problemi interdisciplinari. Ha due lauree in Fisica e un Dottorato in Ingegneria.

Dottor Adewale Akinfaderin è un Data Scientist senior nel settore sanitario e delle scienze della vita presso AWS. La sua esperienza riguarda metodi AI/ML riproducibili ed end-to-end, implementazioni pratiche e assistenza ai clienti del settore sanitario globale nella formulazione e nello sviluppo di soluzioni scalabili a problemi interdisciplinari. Ha due lauree in Fisica e un Dottorato in Ingegneria.

Priya Padate è un Senior Partner Solutions Architect con una vasta esperienza nel settore sanitario e delle scienze della vita presso AWS. Priya guida le strategie di go-to-market con i partner e guida lo sviluppo di soluzioni per accelerare lo sviluppo basato su AI/ML. La sua passione è l'utilizzo della tecnologia per trasformare il settore sanitario e ottenere risultati migliori nella cura dei pazienti.

Priya Padate è un Senior Partner Solutions Architect con una vasta esperienza nel settore sanitario e delle scienze della vita presso AWS. Priya guida le strategie di go-to-market con i partner e guida lo sviluppo di soluzioni per accelerare lo sviluppo basato su AI/ML. La sua passione è l'utilizzo della tecnologia per trasformare il settore sanitario e ottenere risultati migliori nella cura dei pazienti.

Ekta Walia Bhullar, PhD, è un consulente senior di IA/ML presso la business unit dei servizi professionali AWS Healthcare and Life Sciences (HCLS). Ha una vasta esperienza nell'applicazione dell'intelligenza artificiale/ML nel settore sanitario, in particolare in radiologia. Al di fuori del lavoro, quando non si parla di intelligenza artificiale in radiologia, le piace correre e fare escursioni.

Ekta Walia Bhullar, PhD, è un consulente senior di IA/ML presso la business unit dei servizi professionali AWS Healthcare and Life Sciences (HCLS). Ha una vasta esperienza nell'applicazione dell'intelligenza artificiale/ML nel settore sanitario, in particolare in radiologia. Al di fuori del lavoro, quando non si parla di intelligenza artificiale in radiologia, le piace correre e fare escursioni.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Automobilistico/VE, Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Grafico Prime. Migliora il tuo gioco di trading con ChartPrime. Accedi qui.

- BlockOffset. Modernizzare la proprietà della compensazione ambientale. Accedi qui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/automatically-generate-impressions-from-findings-in-radiology-reports-using-generative-ai-on-aws/

- :ha

- :È

- :non

- :Dove

- $ SU

- 000

- 1

- 100

- 11

- 116

- 125

- 16

- 20

- 22

- 25

- 26%

- 29

- 31

- 36

- 7

- 700

- 8

- 9

- 91

- a

- capace

- Chi siamo

- accelerare

- accelerata

- accessibile

- realizzare

- Accumulare

- Inoltre

- avanzamenti

- contro

- aggregazione

- Accordo

- AI

- AI / ML

- Algoritmi

- Tutti

- consente

- già

- anche

- del tutto

- Amazon

- Amazon Sage Maker

- Amazon Web Services

- importi

- an

- .

- ed

- Un altro

- in qualsiasi

- api

- Applicazioni

- approccio

- circa

- architettura

- SONO

- argomento

- AS

- valutazione

- At

- Automatico

- automaticamente

- Automatizzare

- disponibile

- media

- evitare

- AWS

- base

- basato

- BE

- perché

- prima

- essendo

- vantaggi

- Meglio

- fra

- maggiore

- miliardi

- entrambi

- confini

- Scatola

- onere

- affari

- ma

- by

- detto

- Materiale

- candidato

- funzionalità

- carbonio

- che

- Custodie

- casi

- cambiato

- oneri

- la scelta

- classe

- Pulizia

- pulire campo

- Info su

- i medici

- codice

- collezione

- Uncommon

- comunemente

- confrontare

- rispetto

- completamento di una

- completamento

- complesso

- componenti

- globale

- calcolo

- informatica

- conciso

- fiducia

- consecutivo

- consiste

- consolle

- consulente

- contenere

- Contenitore

- contenuto

- testuali

- contrasto

- Conversazioni

- corrisponde

- Costo

- costoso

- Costi

- potuto

- Coppia

- creare

- creato

- Creazione

- critico

- criticità

- costume

- Clienti

- cruscotto

- dati

- scienziato di dati

- dataset

- Decision Making

- Predefinito

- definito

- Laurea

- Dati Demografici

- dimostrare

- dimostrato

- dimostra

- dipartimenti

- schierare

- schierato

- deployment

- descrivere

- descritta

- dettagliati

- dettagli

- sviluppare

- Mercato

- diverso

- direttamente

- discutere

- discutere

- distribuito

- distribuzione

- docker

- Dottori

- documenti

- dominio

- domini

- Dont

- disegnare

- guidare

- unità

- durante

- ogni

- In precedenza

- sforzo

- o

- elimina

- altro

- enable

- Abilita

- da un capo all'altro

- endpoint

- Ingegneria

- migliorata

- abbastanza

- Intero

- Ambiente

- epoca

- epoche

- errore

- particolarmente

- essential

- valutare

- valutato

- la valutazione

- valutazione

- e la

- esempio

- Esempi

- eseguire

- ampliato

- esperienza

- competenza

- estensivo

- Conclamata Esperienza

- estratto

- fallisce

- falso

- feedback

- figura

- Compila il

- File

- I risultati

- Focus

- si concentra

- i seguenti

- segue

- Nel

- modulo

- formato

- Fondazione

- da

- function

- ulteriormente

- Inoltre

- futuro

- Generale

- scopo generale

- generare

- generato

- genera

- ELETTRICA

- generativo

- AI generativa

- ottenere

- dato

- globali

- Andare al mercato

- laurea

- maggiore

- Terra

- Avere

- avendo

- he

- Salute e benessere

- informazioni sulla salute

- assistenza sanitaria

- settore sanitario

- Aiuto

- aiutare

- aiuta

- qui

- Alta

- mettendo in evidenza

- Escursione

- il suo

- storia

- host

- ORE

- Come

- Tutorial

- HTML

- http

- HTTPS

- Hub

- abbracciare il viso

- umano

- ID

- idee

- identificato

- if

- illustra

- Immagine

- immagini

- Imaging

- di forte impatto

- realizzare

- implementazioni

- importare

- importante

- competenze

- miglioramento

- in

- includere

- Compreso

- Aumento

- industria

- informazioni

- informativo

- ingresso

- install

- esempio

- interattivo

- interpretazione

- ai miglioramenti

- Invenzione

- IT

- Lavoro

- Offerte di lavoro

- json

- ad appena

- solo uno

- mantenere

- Le

- Discografica

- Lingua

- grandi

- lanciare

- apprendimento

- Guidato

- Lunghezza

- Vita

- Life Sciences

- piace

- piace

- LIMITE

- linea

- Lista

- elencati

- LLM

- collocato

- località

- spento

- macchina

- machine learning

- make

- Maggio..

- significare

- medicale

- medie

- Memorie

- metodo

- metodi

- metrico

- Metrica

- forza

- Minuti

- ML

- modello

- modelli

- Monitorare

- Scopri di più

- maggior parte

- MRI

- molti

- multiplo

- Musica

- devono obbligatoriamente:

- Nome

- Naturale

- Elaborazione del linguaggio naturale

- necessaria

- Bisogno

- Rete

- rete neurale

- New

- recentemente

- GENERAZIONE

- nlp

- taccuino

- adesso

- numero

- oggetto

- ottenuto

- of

- offerta

- di frequente

- on

- Procedura di Onboarding

- ONE

- esclusivamente

- ottimizzazione

- or

- minimo

- i

- Altro

- nostro

- su

- risultati

- produzione

- al di fuori

- ancora

- complessivo

- Override

- panoramica

- Packages

- coppia

- coppie

- parametro

- parametri

- parte

- particolare

- partner

- partner

- passare

- appassionato

- sentiero

- paziente

- pazienti

- percentuale

- Eseguire

- performance

- phd

- Fisica

- pezzi

- Platone

- Platone Data Intelligence

- PlatoneDati

- punto

- punti

- Post

- potenziale

- alimentato

- Pratico

- Previsioni

- Predictor

- presentata

- regali

- principalmente

- Problema

- problemi

- processi

- lavorazione

- Prodotto

- professionale

- Profilo

- offre

- proposto

- protetta

- purché

- fornitori

- fornisce

- pubblicamente

- Python

- quantitativo

- Leggi

- Lettura

- recente

- raccomandazioni

- raccomandato

- riduce

- Riferimenti

- di cui

- si riferisce

- regex

- Iscrizione

- relazionato

- pertinente

- notevole

- sostituito

- rapporto

- Reportistica

- Report

- richiesta

- necessario

- richiede

- risorsa

- Risorse

- rispettivamente

- REST

- colpevole

- Risultati

- problemi

- Aumento

- Correre

- running

- sagemaker

- stesso

- scalabile

- SCIENZE

- Scienziato

- graffiare

- sdk

- Cerca

- secondo

- Sezione

- sezioni

- vedere

- selezionato

- anziano

- delicata

- condanna

- separato

- servizio

- Servizi

- servizio

- set

- regolazione

- impostazioni

- lei

- dovrebbero

- ha mostrato

- mostrato

- Spettacoli

- significato

- significativa

- Un'espansione

- semplicemente

- piccole

- So

- soluzione

- Soluzioni

- RISOLVERE

- alcuni

- campata

- specializzata

- specifico

- in particolare

- specificato

- inizia a

- iniziato

- state-of-the-art

- Stato dei servizi

- step

- Passi

- Ancora

- conservazione

- Tornare al suo account

- Storie

- strategie

- Strategia

- studio

- tale

- SOMMARIO

- sicuro

- tavolo

- Fai

- prende

- Task

- task

- Tecnologia

- di

- che

- I

- Li

- poi

- Là.

- in tal modo

- perciò

- Strumenti Bowman per analizzare le seguenti finiture:

- questo

- quelli

- tre

- Attraverso

- tempo

- a

- pure

- Argomenti

- pista

- Treni

- Training

- trasferimento

- Trasformare

- trasformatore

- Traduzione

- Verità

- prova

- seconda

- Digitare

- tipico

- sottolineature

- e una comprensione reciproca

- unificato

- unità

- Università

- caricato

- uso

- utilizzato

- Utente

- usa

- utilizzando

- convalida

- APPREZZIAMO

- Valori

- vario

- Fisso

- versione

- via

- Video

- virtuale

- aspettare

- Prima

- we

- sito web

- servizi web

- Sito web

- quando

- quale

- while

- larghezza

- volere

- con

- entro

- senza

- Word

- parole

- Lavora

- flusso di lavoro

- sarebbe

- scrittura

- raggi X

- anni

- Tu

- Trasferimento da aeroporto a Sharm

- zefiro