I modelli di linguaggio di grandi dimensioni (LLM) con miliardi di parametri sono attualmente in prima linea nell'elaborazione del linguaggio naturale (NLP). Questi modelli stanno scuotendo il campo con le loro incredibili capacità di generare testo, analizzare il sentiment, tradurre lingue e molto altro. Con l'accesso a enormi quantità di dati, gli LLM hanno il potenziale per rivoluzionare il modo in cui interagiamo con il linguaggio. Sebbene i LLM siano in grado di svolgere vari compiti di PNL, sono considerati generalisti e non specialisti. Per addestrare un LLM a diventare un esperto in un particolare dominio, di solito è necessaria una messa a punto.

Una delle principali sfide nell'addestramento e nell'implementazione di LLM con miliardi di parametri è la loro dimensione, che può rendere difficile il loro inserimento in singole GPU, l'hardware comunemente utilizzato per il deep learning. La vastità di questi modelli richiede risorse di elaborazione ad alte prestazioni, come GPU specializzate con grandi quantità di memoria. Inoltre, le dimensioni di questi modelli possono renderli computazionalmente costosi, il che può aumentare significativamente i tempi di addestramento e inferenza.

In questo post, dimostriamo come possiamo usare JumpStart di Amazon SageMaker per ottimizzare facilmente un modello di generazione di testo in un linguaggio di grandi dimensioni su un set di dati specifico del dominio nello stesso modo in cui si addestrerebbe e si distribuirebbe qualsiasi modello su Amazon Sage Maker. In particolare, mostriamo come perfezionare il modello linguistico GPT-J 6B per la generazione di testi finanziari utilizzando sia l'SDK JumpStart che Amazon Sage Maker Studio Interfaccia utente su un set di dati pubblicamente disponibile di documenti SEC.

JumpStart ti aiuta a iniziare rapidamente e facilmente con il machine learning (ML) e fornisce una serie di soluzioni per i casi d'uso più comuni che possono essere addestrati e implementati prontamente con pochi passaggi. Tutti i passaggi di questa demo sono disponibili nel taccuino allegato Ottimizzazione del modello GPT-J 6B di generazione del testo su un set di dati specifico del dominio.

Panoramica della soluzione

Nelle sezioni seguenti, forniamo una dimostrazione dettagliata per la messa a punto di un LLM per le attività di generazione di testo tramite l'interfaccia utente di JumpStart Studio e Python SDK. In particolare, trattiamo i seguenti argomenti:

- Una panoramica dei dati di archiviazione SEC nel dominio finanziario su cui il modello è messo a punto

- Una panoramica del modello LLM GPT-J 6B che abbiamo scelto di mettere a punto

- Una dimostrazione di due diversi modi in cui possiamo mettere a punto l'LLM utilizzando JumpStart:

- Utilizza JumpStart in modo programmatico con SageMaker Python SDK

- Accedi a JumpStart utilizzando l'interfaccia utente di Studio

- Una valutazione del modello perfezionato confrontandolo con il modello preaddestrato senza perfezionamento

La messa a punto si riferisce al processo di prendere un modello linguistico pre-addestrato e addestrarlo per un'attività diversa ma correlata utilizzando dati specifici. Questo approccio è anche noto come trasferire l'apprendimento, che comporta il trasferimento delle conoscenze apprese da un compito all'altro. Gli LLM come GPT-J 6B vengono addestrati su enormi quantità di dati senza etichetta e possono essere ottimizzati su set di dati più piccoli, migliorando le prestazioni del modello in un dominio specifico.

Come esempio di come le prestazioni migliorano quando il modello viene messo a punto, potresti porre la seguente domanda:

"Cosa guida la crescita delle vendite su Amazon?"

Senza messa a punto, la risposta sarebbe:

“Amazon è il più grande rivenditore online al mondo. È anche il più grande mercato online del mondo. È anche il mondo”

Con la regolazione fine, la risposta è:

"La crescita delle vendite su Amazon è guidata principalmente dall'aumento dell'utilizzo da parte dei clienti, tra cui una maggiore selezione, prezzi più bassi, una maggiore convenienza e un aumento delle vendite da parte di altri venditori sui nostri siti Web".

Il miglioramento dalla messa a punto è evidente.

Utilizziamo il testo finanziario dei documenti SEC per mettere a punto un LLM GPT-J 6B per applicazioni finanziarie. Nelle sezioni successive, introduciamo i dati e il LLM che verranno messi a punto.

Set di dati di archiviazione SEC

I documenti SEC sono fondamentali per la regolamentazione e la divulgazione in ambito finanziario. I documenti notificano alla comunità degli investitori le condizioni commerciali delle società e le prospettive future delle società. Il testo nei documenti SEC copre l'intera gamma delle operazioni e delle condizioni commerciali di una società. A causa del loro potenziale valore predittivo, questi depositi sono buone fonti di informazioni per gli investitori. Sebbene questi documenti SEC lo siano disponibile pubblicamente per chiunque, il download di archivi analizzati e la creazione di un set di dati pulito con funzionalità aggiuntive è un esercizio che richiede tempo. Lo rendiamo possibile in alcune chiamate API nel JumpStart SDK di settore.

Utilizzando l'API SageMaker, abbiamo scaricato i rapporti annuali (Archiviazione 10-K; vedere Come leggere un 10-K per ulteriori informazioni) per un gran numero di aziende. Selezioniamo i rapporti di archiviazione SEC di Amazon per gli anni 2021-2022 come dati di addestramento per mettere a punto il modello GPT-J 6B. In particolare, concateniamo in un unico file di testo i report di archiviazione SEC della società in diversi anni, ad eccezione della sezione "Discussione e analisi della direzione", che contiene dichiarazioni previsionali della direzione della società e viene utilizzata come dati di convalida.

L'aspettativa è che dopo aver messo a punto il modello di generazione del testo GPT-J 6B sui documenti SEC finanziari, il modello sia in grado di generare un output testuale relativo alla finanza e quindi possa essere utilizzato per risolvere più attività NLP specifiche del dominio.

GPT-J 6B modello di linguaggio di grandi dimensioni

GPT-J6B è un modello open source da 6 miliardi di parametri rilasciato da Eleuther AI. GPT-J 6B è stato addestrato su un ampio corpus di dati di testo ed è in grado di eseguire varie attività di PNL come la generazione di testo, la classificazione del testo e il riepilogo del testo. Sebbene questo modello sia impressionante su una serie di attività di PNL senza la necessità di alcuna messa a punto, in molti casi dovrai mettere a punto il modello su un set di dati specifico e attività di PNL che stai cercando di risolvere. I casi d'uso includono chatbot personalizzati, generazione di idee, estrazione di entità, classificazione e analisi del sentiment.

Accedi agli LLM su SageMaker

Ora che abbiamo identificato il set di dati e il modello su cui eseguire la messa a punto, JumpStart offre due strade per iniziare a utilizzare la messa a punto della generazione di testo: SageMaker SDK e Studio.

Usa JumpStart a livello di codice con SageMaker SDK

Esaminiamo ora un esempio di come è possibile utilizzare SageMaker JumpStart SDK per accedere a un LLM (GPT-J 6B) e perfezionarlo sul set di dati di archiviazione SEC. Al termine della messa a punto, distribuiremo il modello ottimizzato e faremo inferenza su di esso. Tutti i passaggi di questo post sono disponibili nel taccuino allegato: Ottimizzazione del modello GPT-J 6B di generazione del testo su un set di dati specifico del dominio.

In questo esempio, JumpStart utilizza il file SageMaker Hugging Face Contenitore per il deep learning (DLC) e deepspeed libreria per mettere a punto il modello. La libreria DeepSpeed è progettata per ridurre la potenza di calcolo e l'utilizzo della memoria e per addestrare modelli distribuiti di grandi dimensioni con un migliore parallelismo sull'hardware del computer esistente. Supporta l'addestramento distribuito a nodo singolo, utilizzando il checkpoint del gradiente e il parallelismo del modello per addestrare modelli di grandi dimensioni su una singola istanza di addestramento SageMaker con più GPU. Con JumpStart, integriamo per te la libreria DeepSpeed con il DLC SageMaker Hugging Face e ci occupiamo di tutto sotto il cofano. Puoi facilmente ottimizzare il modello sul set di dati specifico del tuo dominio senza configurarlo manualmente.

Ottimizza il modello pre-addestrato su dati specifici del dominio

Per mettere a punto un modello selezionato, dobbiamo ottenere l'URI di tale modello, nonché lo script di addestramento e l'immagine del contenitore utilizzati per l'addestramento. Per semplificare le cose, questi tre input dipendono esclusivamente dal nome del modello, versione (per un elenco dei modelli disponibili, vedere Algoritmi incorporati con tabella modello pre-addestrata) e il tipo di istanza su cui desideri eseguire l'addestramento. Ciò è dimostrato nel seguente frammento di codice:

Recuperiamo il model_id corrispondente allo stesso modello che vogliamo utilizzare. In questo caso, perfezioniamo huggingface-textgeneration1-gpt-j-6b.

La definizione degli iperparametri comporta l'impostazione dei valori per vari parametri utilizzati durante il processo di addestramento di un modello ML. Questi parametri possono influire sulle prestazioni e sulla precisione del modello. Nel passaggio successivo, stabiliamo gli iperparametri utilizzando le impostazioni predefinite e specificando valori personalizzati per parametri come epochs ed learning_rate:

JumpStart fornisce un ampio elenco di iperparametri disponibili per l'ottimizzazione. L'elenco seguente fornisce una panoramica di parte degli iperparametri chiave utilizzati per la messa a punto del modello. Per un elenco completo degli iperparametri, vedere il notebook Ottimizzazione del modello GPT-J 6B di generazione del testo su un set di dati specifico del dominio.

- epoche – Specifica al massimo quante epoche del set di dati originale verranno iterate.

- tasso_di_apprendimento – Controlla la dimensione del passo o la velocità di apprendimento dell'algoritmo di ottimizzazione durante l'addestramento.

- eval_passi – Specifica il numero di passaggi da eseguire prima di valutare il modello sul set di convalida durante l'addestramento. Il set di convalida è un sottoinsieme dei dati che non viene utilizzato per l'addestramento, ma viene invece utilizzato per verificare le prestazioni del modello su dati invisibili.

- peso_decadimento – Controlla la forza di regolarizzazione durante l'addestramento del modello. La regolarizzazione è una tecnica che consente di impedire al modello di eseguire l'overfitting dei dati di addestramento, il che può comportare prestazioni migliori sui dati non visualizzati.

- fp16 – Controlla se utilizzare l'addestramento di precisione fp16 a 16 bit (misto) anziché l'addestramento a 32 bit.

- valutazione_strategia – La strategia di valutazione utilizzata durante la formazione.

- gradient_accumulation_steps – Il numero di passaggi di aggiornamento per cui accumulare i gradienti, prima di eseguire un passaggio all'indietro/di aggiornamento.

Per ulteriori dettagli sugli iperparametri, fare riferimento al funzionario Documentazione di Hugging Face Trainer.

Ora puoi perfezionare questo modello JumpStart sul tuo set di dati personalizzato utilizzando SageMaker SDK. Utilizziamo i dati di archiviazione SEC che abbiamo descritto in precedenza. I dati di addestramento e convalida sono ospitati in train_dataset_s3_path ed validation_dataset_s3_path. Il formato supportato dei dati include CSV, JSON e TXT. Per i dati CSV e JSON, i dati di testo vengono utilizzati dalla colonna richiamata text o la prima colonna se non viene trovata alcuna colonna chiamata testo. Poiché questo è per la messa a punto della generazione del testo, non sono richieste etichette di verità di base. Il codice seguente è un esempio SDK di come ottimizzare il modello:

Dopo aver impostato SageMaker Estimator con gli iperparametri richiesti, istanziamo uno stimatore SageMaker e chiamiamo il .fit metodo per iniziare a mettere a punto il nostro modello, passandogli il Servizio di archiviazione semplice Amazon (Amazon S3) URI per i nostri dati di addestramento. Come puoi vedere, il entry_point lo script fornito è denominato transfer_learning.py (lo stesso per altre attività e modelli) e il canale dati di input a cui è passato .fit deve essere denominato train e validation.

JumpStart supporta anche l'ottimizzazione degli iperparametri con Ottimizzazione automatica del modello di SageMaker. Per i dettagli, vedere l'esempio taccuino.

Distribuire il modello ottimizzato

Al termine dell'addestramento, puoi distribuire il tuo modello ottimizzato. Per fare ciò, tutto ciò che dobbiamo ottenere è l'URI dello script di inferenza (il codice che determina come il modello viene utilizzato per l'inferenza una volta distribuito) e l'URI dell'immagine del contenitore di inferenza, che include un server di modello appropriato per ospitare il modello scelto. Vedere il codice seguente:

Dopo pochi minuti, il nostro modello viene distribuito e possiamo ottenere previsioni da esso in tempo reale!

Accedi a JumpStart tramite l'interfaccia utente di Studio

Un altro modo per perfezionare e distribuire i modelli JumpStart è tramite l'interfaccia utente di Studio. Questa interfaccia utente fornisce una soluzione low-code/no-code per ottimizzare gli LLM.

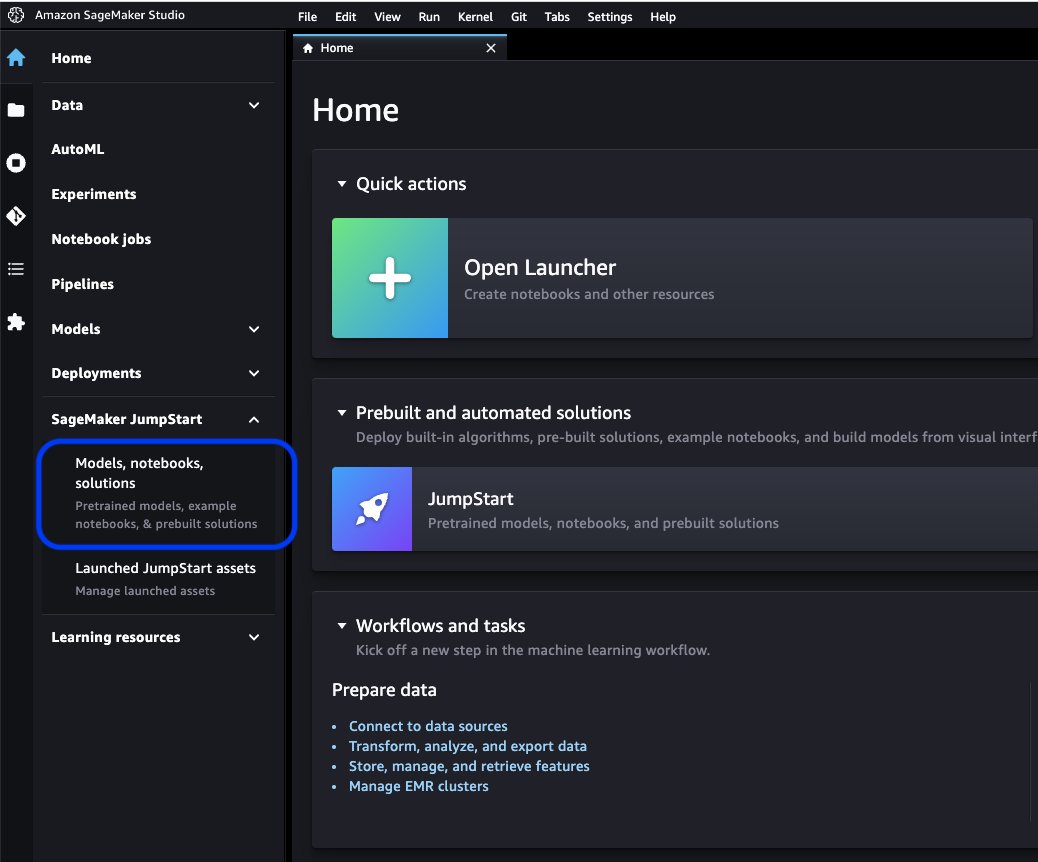

Nella console di Studio, scegli Modelli, taccuini, soluzioni per SageMaker JumpStart nel pannello di navigazione.

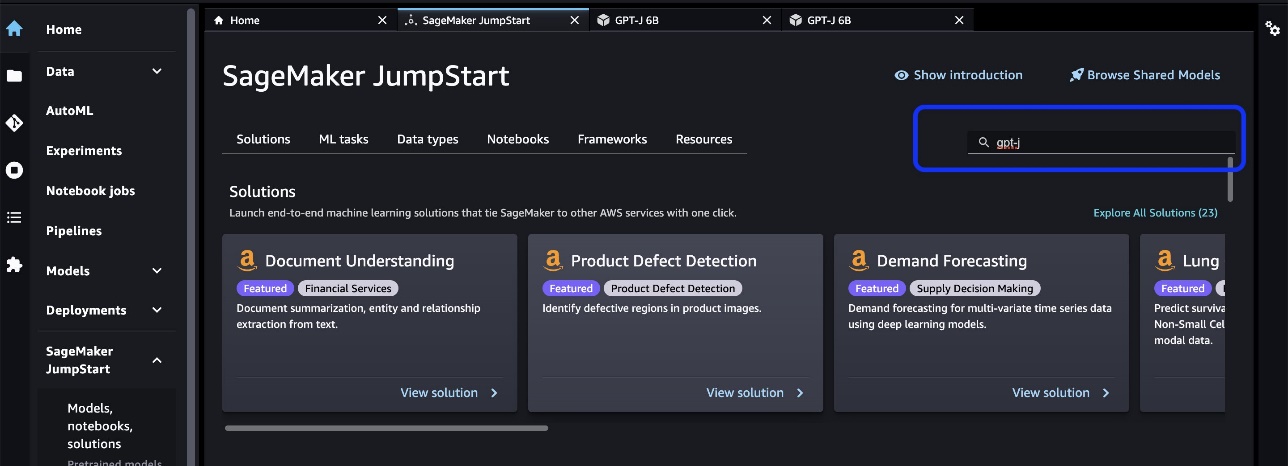

Nella barra di ricerca, cerca il modello che desideri ottimizzare e distribuire.

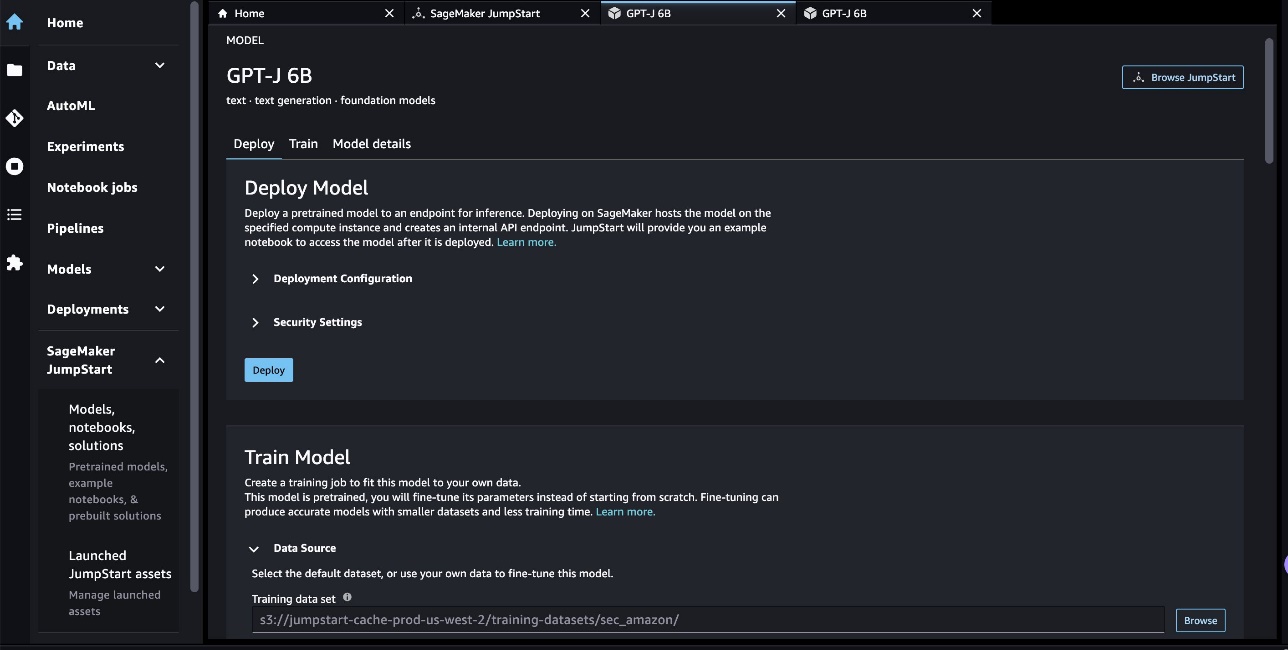

Nel nostro caso, abbiamo scelto la scheda modello GPT-J 6B. Qui possiamo perfezionare o distribuire direttamente l'LLM.

Valutazione del modello

Quando valutiamo un LLM, possiamo usare la perplessità (PPL). PPL è una misura comune di quanto bene un modello linguistico è in grado di prevedere la parola successiva in una sequenza. In termini più semplici, è un modo per misurare quanto bene il modello può comprendere e generare un linguaggio simile a quello umano.

Un punteggio di perplessità inferiore indica che il modello mostra prestazioni migliori nel prevedere la parola successiva. In termini pratici, possiamo usare la perplessità per confrontare diversi modelli linguistici e determinare quale si comporta meglio in un determinato compito. Possiamo anche usarlo per monitorare le prestazioni di un singolo modello nel tempo. Per maggiori dettagli, fare riferimento a Perplessità dei modelli a lunghezza fissa.

Valutiamo le prestazioni del modello attraverso un confronto tra le sue prestazioni prima e dopo l'ottimizzazione. PPL è emesso nel lavoro di formazione Amazon Cloud Watch log. Inoltre, esaminiamo l'output generato dal modello in risposta a specifici prompt di test.

| Metrica di valutazione sui dati di validazione | Prima della messa a punto | Dopo la messa a punto |

| Perplessità (PPL) | 8.147 | 1.437 |

Le migliori prestazioni del modello sono dimostrate da due esperimenti:

- Generazione di testo – Mostriamo che l'output del GPT-J perfezionato genera un testo che ha una somiglianza con il set di dati SEC, indicando che ha imparato a emulare i modelli linguistici e le convenzioni del dominio normativo finanziario

- Apprendimento zero-shot – Dimostriamo che il GPT-J ottimizzato mostra prestazioni significativamente migliori rispetto al GPT-J non ottimizzato nella risposta a domande zero-shot

Per l'esperimento di generazione del testo, utilizziamo i seguenti parametri di inferenza per ottenere i nostri risultati: max_length di 400 (numero di token restituiti), num_return_sequences di 1 (numero di esempi di testo di risposta), top_k di 250 (scegli da una delle prime 250 possibili continuazioni), top_p di 0.8 (selezionare solo da continuazioni che hanno almeno l'80% di probabilità), do_sample is True (campionamento), e temperature di 1 (l'alta temperatura è maggiore casualità nelle risposte). Per maggiori dettagli sui parametri, fare riferimento a GenerazioneConfig. La tabella seguente confronta il GPT-J ottimizzato e quello non ottimizzato in un'attività di completamento del testo.

| Esempio di inferenza | Uscita da GPT-J 6B prima della messa a punto | Uscita da GPT-J 6B dopo la messa a punto |

| Questo rapporto del modulo 10-K lo dimostra |

Questo rapporto del modulo 10-K mostra che: L'utile netto della Società attribuibile alla Società per l'esercizio chiuso al 31 dicembre 2016 è stato di $ 3,923,000, o $ 0.21 per azione diluita, rispetto a $ 3,818,000, o $ 0.21 per azione diluita, per l'anno chiuso al 31 dicembre 2015. L'utile netto della Società attribuibile alla Società per l'esercizio chiuso al 31 dicembre 2016 è stato di $ 4,816,000, o $ 0.28 per azione diluita, rispetto a $ 4,726,000, o $ 0.27 per azione diluita, per l'anno chiuso al 31 dicembre 2015. L'utile netto della Società attribuibile alla Società per l'esercizio chiuso al 31 dicembre 2016 è stato di $ 5,828,000, o $ 0.34 per azione diluita, rispetto a $ 5,716,000, o $ 0.33 per azione diluita, per l'anno chiuso al 31 dicembre 2015. Il 21 agosto 2009, la Società ha depositato un modulo 10-Q per il trimestre conclusosi il 31 dicembre 2008. Il 21 agosto 2009, la Società ha depositato un modulo 10-Q per il trimestre conclusosi il 30 settembre 2008. Il 21 agosto 2009, la Società ha depositato un modulo 10-Q per il trimestre conclusosi il 31 marzo 2009. |

Questo rapporto del Modulo 10-K mostra che:(1) Il nome, l'indirizzo e il numero di telefono del registrante sono i seguenti:Amazon.com, Inc. c/o Ernst & Young LLPSeattle, Washington All'attenzione: Segretario aziendale (2) Per il ai fini dell'articolo III del Securities Exchange Act del 1934, il nome e l'indirizzo del registrante sono i seguenti:(3) Il periodo di tempo oggetto di comunicazione del registrant Exchange Act va dal 1° gennaio 2020 compreso al presente.(4) La valutazione soggettiva del dichiarante è che i rendiconti finanziari e le altre informazioni finanziarie incluse nella presente relazione siano abbastanza presenti in tutti gli aspetti sostanziali della condizione finanziaria, dei risultati delle operazioni e dei flussi di cassa del dichiarante a partire da e per i periodi presentati nella presente relazione. (5) La direzione del dichiarante la valutazione è che i rendiconti finanziari e le altre informazioni finanziarie incluse nella presente relazione siano abbastanza presenti in tutti gli aspetti sostanziali della condizione finanziaria, dei risultati delle operazioni e dei flussi di cassa del dichiarante a partire da e per i periodi presentati in questa relazione./s/ Ernst & Young LLPSeattle, Washington29 gennaio 2020EX-31.1 5 amzn-20201231xex311.htm EX-31.1 DocumentoAllegato 31.1CERTIFICAZIONISI, Andrew R. Jassy, certifica che:1. Ho esaminato questo modulo 10-K di Amazon.com, Inc.;2. In base alle mie conoscenze, la presente relazione non contiene alcuna dichiarazione non veritiera di un fatto sostanziale né omette di indicare un fatto sostanziale necessario per rendere le dichiarazioni rese, alla luce delle circostanze in cui tali dichiarazioni sono state rese, non fuorvianti rispetto al periodo coperto dalla presente rapporto; |

| Serviamo i consumatori attraverso |

Serviamo i consumatori attraverso: Il nostro Blog Sei un imprenditore e vuoi far crescere la tua attività? Vuoi creare un business più efficace ed efficiente? Vuoi imparare a far crescere la tua attività? Se hai risposto "sì" a una di queste domande, allora devi leggere questo articolo. Il primo passo per far crescere la tua attività è capire la tua attività. Devi essere in grado di rispondere alle seguenti domande sulla tua attività: Chi sono i vostri clienti? Qual è il tuo prodotto o servizio? Qual è la tua proposta di vendita unica? Qual è la tua strategia di marketing? Qual è la tua previsione di vendita? Qual è la tua previsione di vendita? Qual è la tua previsione di vendita? Qual è la tua previsione di vendita? Qual è la tua previsione di vendita? |

Serviamo i consumatori attraverso: Amazon.com, un rivenditore di prodotti fisici e digitali; Amazon Web Services, che fornisce servizi di infrastruttura tecnologica che consentono praticamente qualsiasi tipo di attività; Amazon Enterprise Solutions, che fornisce alle aziende tecnologia e servizi personalizzati per consentire migliori processi aziendali e migliorare l'efficienza e la produttività; e Audible, un editore di audiolibri digitali. Serviamo sviluppatori e aziende di tutte le dimensioni tramite AWS, che offre un'ampia gamma di servizi globali di elaborazione, archiviazione, database e altri servizi. Produciamo e vendiamo anche dispositivi elettronici. Abbiamo organizzato le nostre operazioni in due segmenti principali: Nord America e Internazionale. Si veda il punto 8 della Parte II, “”Bilancio e dati integrativi-Nota 12-Informazioni di settore.”” Si veda il punto 7 della Parte II, “”Discussione e analisi della direzione sulla situazione finanziaria e sui risultati delle operazioni-Risultato operativo-Informazioni supplementari” ” per ulteriori informazioni sulle nostre vendite nette. Consumatori Serviamo i consumatori attraverso i nostri negozi online e fisici e ci concentriamo su selezione, prezzo e convenienza. Progettiamo i nostri negozi per consentire a centinaia di milioni di prodotti unici di essere venduti da noi e da terze parti in dozzine di categorie di prodotti. I clienti accedono alle nostre offerte tramite i nostri siti Web, app mobili, Alexa e visitando fisicamente i nostri negozi. Produciamo e vendiamo anche dispositivi Kindle. Ci sforziamo di offrire ai nostri clienti i prezzi più bassi possibili attraverso i prezzi dei prodotti e le offerte di spedizione più bassi di tutti i giorni e di migliorare la nostra efficienza operativa in modo da poter continuare a ridurre i prezzi per i nostri clienti. Forniamo anche funzionalità di facile utilizzo, evasione rapida e affidabile e servizio clienti tempestivo. Inoltre, offriamo Amazon Prime, un programma di abbonamento che include la spedizione gratuita illimitata su oltre 100 milioni di articoli, l'accesso allo streaming illimitato di decine di migliaia di film e Episodi TV e altri vantaggi. |

| Quest'anno puntiamo particolarmente su |

Quest'anno ci concentriamo in particolare su: Il ruolo del sistema sanitario nella prevenzione dell'obesità e del diabete Il ruolo del sistema sanitario nella prevenzione dell'obesità e del diabete Il ruolo del sistema sanitario nella prevenzione dell'obesità e del diabete Il ruolo del sistema sanitario nella prevenzione dell'obesità e del diabete Il ruolo del sistema sanitario nella prevenzione dell'obesità e del diabete Il ruolo del sistema sanitario nella prevenzione dell'obesità e del diabete Il ruolo del sistema sanitario nella prevenzione dell'obesità e del diabete |

Quest'anno ci concentriamo in particolare su: -continua espansione internazionale, compreso lo sviluppo di nuove attività in segmenti di mercato internazionali esistenti, nonché lo sviluppo di nuovi segmenti di mercato internazionale; - Espandere la nostra base di clienti, incluso l'aumento delle vendite ai clienti esistenti e l'attrazione di nuovi clienti; -Sviluppo di nuove opportunità di business e conclusione di accordi commerciali, anche tramite licenze e altri accordi, con altre società o tramite l'acquisizione di altre società; - Sviluppare una tecnologia che fornisca un migliore servizio clienti e fornisca in modo efficiente i nostri prodotti e servizi; -Sviluppo di nuove offerte di prodotti e servizi e integrazione di queste in offerte di prodotti e servizi esistenti e nuove; -Sviluppare sistemi efficienti ed efficaci per supportare la nostra attività; e -Altre iniziative commerciali e strategiche. Crediamo che offrire prezzi bassi ai nostri clienti sia fondamentale per il nostro futuro successo. Un modo in cui offriamo prezzi più bassi è attraverso offerte di spedizione gratuita che comportano un costo netto per noi nella consegna dei prodotti e attraverso l'iscrizione ad Amazon Prime, che fornisce la spedizione gratuita su milioni di articoli e l'accesso a film e altri contenuti. Offriamo anche altre promozioni che ci consentono di trasformare un costo netto di vendita inferiore. Abbiamo organizzato le nostre operazioni in due segmenti principali: Nord America e Internazionale. Si veda il punto 8 della Parte II, “”Bilanci e dati integrativi-Nota 12-Informazioni di settore.”” Si veda il punto 7 della Parte II,””Discussione e analisi della direzione sulla situazione finanziaria e sui risultati delle operazioni-Risultati delle operazioni-Informazioni supplementari”” per informazioni supplementari sulle nostre vendite nette. Consumatori Serviamo i consumatori attraverso i nostri siti Web di vendita al dettaglio e negozi fisici e ci concentriamo su selezione, prezzo e convenienza. |

Per il secondo esperimento con un'attività di risposta a domande zero-shot, impostiamo il max_length essere un valore diverso (rispettivamente 40, 200 e 40) in base all'output che ci aspettiamo da ciascuna domanda. I parametri di top_k, top_p, do_sample, temperature sono impostati come 250, 0.8, False, e 0, rispettivamente. Impostiamo la temperatura vicino a 0 per controllare la casualità dell'output, mentre nell'attività di generazione del testo la impostiamo vicino a 1 per rendere il modello più creativo. La tabella seguente confronta i risultati. Per ogni domanda, l'output di GPT-J ottimizzato è più preciso di quello non ottimizzato.

| Ingresso | Uscita da GPT-J 6B prima della messa a punto | Uscita da GPT-J 6B dopo la messa a punto |

| Di cosa tratta l'articolo 7 del deposito 10-K SEC?: |

Di cosa tratta l'articolo 7 del deposito 10-K SEC?: L'articolo 7 del deposito 10-K SEC è il seguente: “La Società non ha ricevuto alcun materiale negativo |

Punto 7. Discussione della direzione e analisi delle condizioni finanziarie e dei risultati delle operazioni Dichiarazioni previsionali |

| In che modo la pandemia di COVID-19 ha influito sull'attività di Amazon?: |

In che modo la pandemia di COVID-19 ha influito sull'attività di Amazon?: L'attività di Amazon è stata influenzata dalla pandemia di COVID-19 in diversi modi. La società sta assistendo a un calo del numero di abbonamenti Prime, che rappresentano una parte importante della sua attività. La società sta inoltre assistendo a un calo del numero di abbonamenti Prime. Anche Amazon sta assistendo a un calo del numero di ordini effettuati sul suo sito web. L'azienda sta inoltre assistendo a un calo del numero di persone che fanno acquisti sul suo sito web. Amazon sta anche assistendo a un calo del numero di persone che fanno acquisti sul suo sito web. Amazon sta anche assistendo a un calo del numero di persone che fanno acquisti sul suo sito web. Amazon sta anche assistendo a un calo del numero di persone che fanno acquisti sul suo sito web. Amazon sta anche assistendo a un calo del numero di persone che fanno acquisti |

In che modo la pandemia di COVID-19 ha influito sull'attività di Amazon?:La pandemia di COVID-19 ha avuto un impatto sulla nostra attività in diversi modi. In primo luogo, ha interrotto la nostra catena di approvvigionamento e ha influito sulla domanda dei clienti, che a sua volta ha influito sulle nostre vendite e sui risultati operativi. In secondo luogo, ha aumentato la nostra spesa in pubblicità e marketing, che potrebbe non essere efficace a lungo termine. In terzo luogo, ha aumentato la nostra spesa in infrastrutture tecnologiche e capacità di calcolo, che potrebbero non essere efficaci a lungo termine. In quarto luogo, ha aumentato la nostra spesa per l'adempimento e il servizio clienti, che potrebbe non essere efficace a lungo termine. Infine, ha aumentato la nostra spesa per i contenuti, che potrebbero non essere efficaci a lungo termine. Cfr. punto 8 della parte II, “Bilancio e dati integrativi – Nota 1 – Descrizione dell'attività e dei principi contabili. |

| Cosa guida la crescita delle vendite su Amazon?: | Amazon è il più grande rivenditore online al mondo. È anche il più grande mercato online del mondo. È anche il mondo' | La crescita delle vendite su Amazon è guidata principalmente dall'aumento dell'utilizzo da parte dei clienti, tra cui una maggiore selezione, prezzi più bassi, una maggiore convenienza e un aumento delle vendite da parte di altri venditori sui nostri siti web. |

ripulire

Per evitare addebiti continui, elimina gli endpoint di inferenza SageMaker. Puoi eliminare gli endpoint tramite la console SageMaker o dal notebook utilizzando i seguenti comandi:

Conclusione

JumpStart è una funzionalità di SageMaker che ti consente di iniziare rapidamente con ML. JumpStart utilizza modelli preaddestrati open source per risolvere problemi di ML comuni come la classificazione delle immagini, il rilevamento degli oggetti, la classificazione del testo, la classificazione delle coppie di frasi e la risposta alle domande.

In questo post, ti abbiamo mostrato come mettere a punto e distribuire un LLM preaddestrato (GPT-J 6B) per la generazione di testo basato sul set di dati di riempimento SEC. Abbiamo dimostrato come il modello si sia trasformato in un esperto del dominio finanziario sottoponendosi al processo di messa a punto solo su due report annuali dell'azienda. Questa messa a punto ha consentito al modello di generare contenuti con una comprensione degli argomenti finanziari e una maggiore precisione. Prova tu stesso la soluzione e facci sapere come va nei commenti.

Importante: questo post è solo a scopo dimostrativo. Non è un consiglio finanziario e non dovrebbe essere considerato un consiglio finanziario o di investimento. Il post ha utilizzato modelli pre-addestrati sui dati ottenuti dal database SEC EDGAR. Sei responsabile del rispetto dei termini e delle condizioni di accesso di EDGAR se utilizzi i dati SEC.

Per saperne di più su JumpStart, dai un'occhiata ai seguenti post:

Informazioni sugli autori

Dott. Xin Huang è Senior Applied Scientist per gli algoritmi integrati di Amazon SageMaker JumpStart e Amazon SageMaker. Si concentra sullo sviluppo di algoritmi di apprendimento automatico scalabili. I suoi interessi di ricerca riguardano l'elaborazione del linguaggio naturale, il deep learning spiegabile su dati tabulari e l'analisi solida del clustering spazio-temporale non parametrico. Ha pubblicato molti articoli nelle conferenze ACL, ICDM, KDD e Royal Statistical Society: Series A.

Dott. Xin Huang è Senior Applied Scientist per gli algoritmi integrati di Amazon SageMaker JumpStart e Amazon SageMaker. Si concentra sullo sviluppo di algoritmi di apprendimento automatico scalabili. I suoi interessi di ricerca riguardano l'elaborazione del linguaggio naturale, il deep learning spiegabile su dati tabulari e l'analisi solida del clustering spazio-temporale non parametrico. Ha pubblicato molti articoli nelle conferenze ACL, ICDM, KDD e Royal Statistical Society: Series A.

Marc Karp è un ML Architect del team Amazon SageMaker Service. Si concentra sull'aiutare i clienti a progettare, distribuire e gestire i carichi di lavoro ML su larga scala. Nel tempo libero ama viaggiare ed esplorare posti nuovi.

Marc Karp è un ML Architect del team Amazon SageMaker Service. Si concentra sull'aiutare i clienti a progettare, distribuire e gestire i carichi di lavoro ML su larga scala. Nel tempo libero ama viaggiare ed esplorare posti nuovi.

Dott. Sanjiv Das è Amazon Scholar e Terry Professor of Finance and Data Science presso la Santa Clara University. Ha conseguito lauree post-laurea in Finanza (M.Phil e PhD presso la New York University) e Informatica (MS presso UC Berkeley) e un MBA presso l'Indian Institute of Management, Ahmedabad. Prima di diventare accademico, ha lavorato nel settore dei derivati nella regione Asia-Pacifico come Vice President presso Citibank. Si occupa di machine learning multimodale nell'area delle applicazioni finanziarie.

Dott. Sanjiv Das è Amazon Scholar e Terry Professor of Finance and Data Science presso la Santa Clara University. Ha conseguito lauree post-laurea in Finanza (M.Phil e PhD presso la New York University) e Informatica (MS presso UC Berkeley) e un MBA presso l'Indian Institute of Management, Ahmedabad. Prima di diventare accademico, ha lavorato nel settore dei derivati nella regione Asia-Pacifico come Vice President presso Citibank. Si occupa di machine learning multimodale nell'area delle applicazioni finanziarie.

Arun Kumar Lokanatha è un Senior ML Solutions Architect del team di assistenza di Amazon SageMaker. Si concentra sull'aiutare i clienti a creare, addestrare e migrare i carichi di lavoro di produzione ML a SageMaker su larga scala. È specializzato in deep learning, in particolare nell'area della PNL e CV. Al di fuori del lavoro, ama correre e fare escursioni.

Arun Kumar Lokanatha è un Senior ML Solutions Architect del team di assistenza di Amazon SageMaker. Si concentra sull'aiutare i clienti a creare, addestrare e migrare i carichi di lavoro di produzione ML a SageMaker su larga scala. È specializzato in deep learning, in particolare nell'area della PNL e CV. Al di fuori del lavoro, ama correre e fare escursioni.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- Platoblockchain. Web3 Metaverse Intelligence. Conoscenza amplificata. Accedi qui.

- Coniare il futuro con Adryenn Ashley. Accedi qui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/domain-adaptation-fine-tuning-of-foundation-models-in-amazon-sagemaker-jumpstart-on-financial-data/

- :ha

- :È

- :non

- $3

- $ SU

- 000

- 1

- 100

- 11

- 20

- 200

- 2016

- 2020

- 28

- 7

- 8

- 9

- a

- abilità

- capace

- Chi siamo

- accademico

- accesso

- Contabilità

- Accumulare

- precisione

- preciso

- Raggiungere

- acquisizione

- operanti in

- Legge

- aggiunto

- Funzionalità aggiunte

- aggiunta

- Inoltre

- indirizzo

- Pubblicità

- consigli

- influenzare

- Dopo shavasana, sedersi in silenzio; saluti;

- contro

- AI

- Alexa

- algoritmo

- Algoritmi

- Tutti

- consente

- anche

- Sebbene il

- Amazon

- Amazon Sage Maker

- JumpStart di Amazon SageMaker

- Amazon Web Services

- Amazon.com

- America

- importi

- an

- .

- analizzare

- ed

- Andrea

- annuale

- Un altro

- rispondere

- in qualsiasi

- chiunque

- api

- applicazioni

- applicato

- approccio

- opportuno

- applicazioni

- SONO

- RISERVATA

- articolo

- AS

- valutazione

- At

- attenzione

- attirando

- AGOSTO

- Automatico

- disponibile

- AWS

- bar

- base

- basato

- BE

- perché

- diventare

- stato

- prima

- essendo

- CREDIAMO

- vantaggi

- Berkeley

- Meglio

- Big

- miliardi

- entrambi

- ampio

- costruire

- incassato

- affari

- ma

- by

- chiamata

- detto

- Bandi

- Materiale

- Può ottenere

- capace

- Ultra-Grande

- carta

- che

- Custodie

- casi

- certificare

- catena

- sfide

- canale

- oneri

- chatbots

- dai un'occhiata

- Scegli

- ha scelto

- scelto

- condizioni

- Citibank

- Clara

- classificazione

- Chiudi

- il clustering

- codice

- Colonna

- COM

- Commenti

- Uncommon

- comunemente

- comunità

- Aziende

- azienda

- Società

- confrontare

- rispetto

- confronto

- confronto

- completamento di una

- completamento

- Calcolare

- computer

- Informatica

- informatica

- potenza di calcolo

- condizione

- condizioni

- conferenze

- Prendere in considerazione

- considerato

- consolle

- costruire

- Consumatori

- contenere

- Contenitore

- contiene

- contenuto

- continua

- di controllo

- controlli

- comodità

- Aziende

- Corrispondente

- Costo

- coperto

- Copertine

- COVID-19

- Pandemia di COVID-19

- creare

- Creative

- critico

- Attualmente

- costume

- cliente

- Servizio clienti

- Clienti

- dati

- scienza dei dati

- Banca Dati

- dataset

- Dicembre

- Rifiuta

- deep

- apprendimento profondo

- Predefinito

- consegna

- fornisce un monitoraggio

- Richiesta

- dimostrare

- dimostrato

- schierare

- schierato

- distribuzione

- Derivati

- descritta

- descrizione

- Design

- progettato

- dettagli

- rivelazione

- Determinare

- determina

- sviluppatori

- in via di sviluppo

- Mercato

- dispositivi

- DID

- diverso

- difficile

- digitale

- direttamente

- Rivelazione

- discutere

- discussione

- distribuito

- formazione distribuita

- docker

- documenti

- dominio

- decine

- spinto

- durante

- ogni

- In precedenza

- facilmente

- facile da usare

- Efficace

- efficienze

- efficienza

- efficiente

- Elettronico

- enable

- abilitato

- endpoint

- migliorata

- Impresa

- aziende

- Intero

- entità

- epoche

- Ernst & Young

- particolarmente

- stabilire

- valutare

- la valutazione

- valutazione

- quotidiano

- qualunque cosa

- esempio

- Esempi

- Tranne

- exchange

- Esercitare

- esistente

- espansione

- attenderti

- aspettativa

- costoso

- esperimento

- esperto

- Esplorare

- estensivo

- Faccia

- FAST

- Caratteristiche

- pochi

- campo

- Compila il

- Limatura

- Infine

- finanziare

- finanziario

- consulenza finanziaria

- dati finanziari

- informazioni finanziarie

- sottile

- Nome

- in forma

- Focus

- si concentra

- i seguenti

- segue

- Nel

- per gli investitori

- Previsione

- prima linea

- modulo

- formato

- lungimirante

- essere trovato

- Fondazione

- Quarto

- da

- pieno

- funzionalità

- fondamentale

- ulteriormente

- futuro

- generare

- generato

- genera

- ELETTRICA

- ottenere

- dato

- globali

- Go

- va

- andando

- buono

- GPU

- gradienti

- maggiore

- Terra

- Crescere

- Crescita

- Crescita

- Hardware

- Avere

- he

- Salute e benessere

- Assistenza sanitaria

- aiutare

- aiuta

- qui

- Alta

- Alte prestazioni

- detiene

- cappuccio

- host

- ospitato

- Come

- Tutorial

- HTML

- http

- HTTPS

- abbracciare il viso

- centinaia

- centinaia di milioni

- Ottimizzazione dell'iperparametro

- i

- idea

- identificato

- Immagine

- Classificazione delle immagini

- Impact

- impattato

- importare

- impressionante

- competenze

- miglioramento

- in

- Inc.

- includere

- incluso

- inclusi

- Compreso

- Reddito

- incorporando

- Aumento

- è aumentato

- crescente

- incredibile

- indiano

- informazioni

- Infrastruttura

- iniziative

- ingresso

- esempio

- invece

- Istituto

- integrare

- interagire

- interessi

- Internazionale

- ai miglioramenti

- introdurre

- investimento

- Investopedia

- investitore

- Investitori

- IT

- elementi

- SUO

- Lavoro

- jpg

- json

- ad appena

- Le

- Sapere

- conoscenze

- conosciuto

- per il tuo brand

- Lingua

- Le Lingue

- grandi

- maggiore

- lanciare

- IMPARARE

- imparato

- apprendimento

- Biblioteca

- Licenze

- leggera

- piace

- Lista

- LLM

- Lunghi

- Guarda

- cerca

- spento

- Basso

- prezzi bassi

- macchina

- machine learning

- fatto

- maggiore

- make

- Fare

- gestire

- gestione

- manualmente

- molti

- Marzo

- Rappresentanza

- Marketing

- mercato

- massiccio

- materiale

- Maggio..

- si intende

- misurare

- iscrizione

- appartenenze

- Memorie

- metodo

- metrico

- migrare

- milione

- milioni

- Minuti

- misto

- ML

- Mobile

- mobili-apps

- modello

- modelli

- Scopri di più

- maggior parte

- Film

- MS

- multiplo

- Nome

- Detto

- Naturale

- Elaborazione del linguaggio naturale

- Navigazione

- necessaria

- Bisogno

- rete

- New

- nuovo prodotto

- New York

- GENERAZIONE

- nlp

- nodo

- Nord

- America del Nord

- taccuino

- adesso

- numero

- Obesità

- oggetto

- Rilevazione dell'oggetto

- ottenere

- ottenuto

- of

- offrire

- offerta

- offerte

- Offerte

- on

- ONE

- in corso

- online

- mercato online

- rivenditore online

- esclusivamente

- open source

- operativo

- Operazioni

- Opportunità

- ottimizzazione

- or

- minimo

- ordini

- Organizzato

- i

- Altro

- nostro

- Outlook

- produzione

- al di fuori

- ancora

- Override

- panoramica

- proprio

- proprietario

- pandemia

- vetro

- documenti

- parametri

- parte

- particolare

- particolarmente

- parti

- passare

- Passato

- Di passaggio

- sentiero

- modelli

- Persone

- Eseguire

- performance

- esecuzione

- esegue

- periodo

- periodi

- PHIL

- Fisico

- Fisicamente

- scegliere

- Partner

- Platone

- Platone Data Intelligence

- PlatoneDati

- Termini e Condizioni

- possibile

- Post

- Post

- potenziale

- energia

- Pratico

- Precisione

- predire

- previsione

- Previsioni

- Predictor

- presenti

- presentata

- Presidente

- prevenire

- Frodi

- precedente

- prezzo

- Prezzi

- prezzi

- principalmente

- premio

- Direttore

- Precedente

- problemi

- processi

- i processi

- lavorazione

- Prodotto

- Produzione

- della produttività

- Prodotti

- Insegnante

- Programma

- Promozioni

- proposizione

- fornire

- purché

- fornisce

- pubblicamente

- pubblicato

- editore

- scopo

- fini

- Python

- Trimestre

- domanda

- Domande

- rapidamente

- casualità

- tasso

- Leggi

- di rose

- ricevuto

- ridurre

- si riferisce

- per quanto riguarda

- regex

- regione

- Regolamento

- normativo

- relazionato

- rilasciato

- rapporto

- Report

- necessario

- richiede

- riparazioni

- Risorse

- rispetto

- risposta

- responsabile

- colpevole

- Risultati

- nello specifico retail

- rivenditore

- rivisto

- rivoluzionare

- robusto

- Ruolo

- reale

- Correre

- running

- sagemaker

- Inferenza di SageMaker

- vendite

- stesso

- Babbo

- scalabile

- Scala

- Scienze

- Scienziato

- Punto

- sdk

- Cerca

- SEC

- Deposito SEC

- Secondo

- segretario

- Sezione

- sezioni

- Valori

- vedendo

- segmenti

- selezionato

- prodotti

- venda

- Sellers

- Vendita

- anziano

- condanna

- sentimento

- Settembre

- Sequenza

- Serie

- Serie A

- servire

- servizio

- Servizi

- set

- regolazione

- impostazioni

- alcuni

- Condividi

- Spedizione

- Shopping

- dovrebbero

- mostrare attraverso le sue creazioni

- mostrato

- Spettacoli

- significativamente

- Un'espansione

- singolo

- Taglia

- Dimensioni

- inferiore

- So

- Società

- venduto

- soluzione

- Soluzioni

- RISOLVERE

- fonti

- specialisti

- specializzata

- specializzata

- specifico

- Spendere

- inizia a

- iniziato

- Regione / Stato

- dichiarazioni

- statistiche

- step

- Passi

- conservazione

- negozi

- Strategico

- Strategia

- Streaming

- forza

- lottare

- studio

- il successo

- tale

- fornire

- supply chain

- supportato

- Supporto

- supporti

- sistema

- SISTEMI DI TRATTAMENTO

- tavolo

- Fai

- presa

- Task

- task

- team

- Tecnologia

- condizioni

- i termini e le condizioni

- test

- Classificazione del testo

- di

- che

- I

- L'area

- Il futuro

- loro

- Li

- perciò

- Strumenti Bowman per analizzare le seguenti finiture:

- di

- cose

- Terza

- terzi

- questo

- tre

- Attraverso

- tempo

- richiede tempo

- volte

- a

- Tokens

- top

- Argomenti

- pista

- Treni

- allenato

- Training

- Trasferimento

- trasformato

- tradurre

- Di viaggio

- Verità

- TURNO

- tv

- ui

- per

- capire

- e una comprensione reciproca

- unico

- Università

- illimitato

- Aggiornamenti

- us

- Impiego

- uso

- utilizzato

- utilizzando

- generalmente

- utilizzati

- Utilizzando

- convalida

- APPREZZIAMO

- Valori

- vario

- versione

- via

- Vicepresidente

- potenzialmente

- Prima

- Washington

- Modo..

- modi

- we

- sito web

- servizi web

- Sito web

- siti web

- WELL

- se

- quale

- OMS

- volere

- con

- senza

- Word

- Lavora

- lavorato

- lavori

- Il mondo di

- sarebbe

- anno

- anni

- Tu

- giovane

- Trasferimento da aeroporto a Sharm

- zefiro