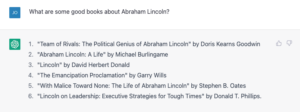

La distorsione nei sistemi di intelligenza artificiale si sta rivelando un grave ostacolo negli sforzi per integrare in modo più ampio la tecnologia nella nostra società. Una nuova iniziativa che premierà i ricercatori per aver trovato eventuali pregiudizi in Sistemi di intelligenza artificiale potrebbe aiutare a risolvere il problema.

Lo sforzo è modellato sulle ricompense dei bug che le società di software pagano agli esperti di sicurezza informatica che li avvisanoqualsiasi potenziale difetto di sicurezza nei loro prodotti. L'idea non è nuova; "Bounties di pregiudizio" erano prima proposta di AIo ricercatore e imprenditore JB Rubinovitz nel 2018 e varie organizzazioni hanno già affrontato tali sfide.

Ma il nuovo sforzo cerca di creare un forum continuo per le competizioni di bounty bias che sia indipendente da qualsiasi organizzazione particolare. Composto da volontari di una serie di aziende, tra cui Twitter, i cosiddetti "Bias Buccaneers" pianificano di tenere regolari competizioni, o "ammutinamenti", e all'inizio di questo mese hanno lanciato la prima sfida del genere.

"I bug bounties sono una pratica standard nella sicurezza informatica che deve ancora trovare piede nella comunità dei pregiudizi algoritmici", l'orgnizzatori dire sul loro sito web. "Mentre gli eventi iniziali una tantum hanno dimostrato entusiasmo per le taglie, Bias Buccaneers è la prima organizzazione no profit destinata a creare ammutinamenti in corso, collaborare con aziende tecnologiche e aprire la strada a valutazioni trasparenti e riproducibili dei sistemi di intelligenza artificiale".

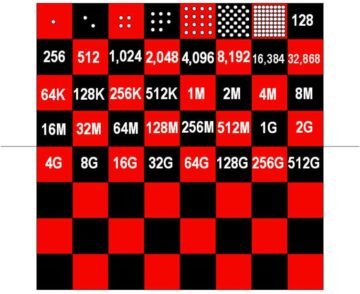

Questa prima competizione ha lo scopo di affrontare i pregiudizi negli algoritmi di rilevamento delle immagini, ma piuttosto che convincere le persone a prendere di mira specifici sistemi di intelligenza artificiale, la competizione sarà capinvitare i ricercatori a creare strumenti in grado di rilevare set di dati distorti. L'idea è quella di creare un modello di apprendimento automatico in grado di etichettare accuratamente ogni immagine in un set di dati con il tono della pelle, il sesso percepito e la fascia di età. Il concorso termina il 30 novembre e ha un primo premio di $ 6,000, il secondo premio di $ 4,000 e il terzo premio di $ 2,000.

La sfida si basa sul fatto che spesso la fonte del bias algoritmico non è tanto l'algoritmo stesso, ma la natura dei dati su cui viene addestrato. Strumenti automatizzati in grado di valutare rapidamente quanto equilibrata una raccolta of le immagini sono in relazione ad attributi che sono spesso fonti di discriminazione potrebbero aiutare i ricercatori di IA a evitare fonti di dati chiaramente distorte.

Ma gli organizzatori affermano che questo è solo il primo passo nel tentativo di creare un toolkit per valutare le distorsioni nei set di dati, algoritmi e applicazioni e, infine, creare standard su come deal con pregiudizi algoritmici, equità e spiegabilità.

Suo non l'unico sforzo del genere. Uno dei leader del nuovo iniziativa è Rumman Chowdhury di Twitter, che l'anno scorso ha contribuito a organizzare la prima competizione di bounty AI bias, prendendo di mira un algoritmo utilizzato dalla piattaforma per ritagliare le immagini che gli utenti si sono lamentati prediligeva i volti maschili e di pelle bianca rispetto a quelli neri e femminili.

La competizione ha consentito agli hacker di accedere al modello dell'azienda e li ha sfidati a trovarne dei difetti. Partecipanti trovato una vasta gamma di problemi, inclpreferendo i visi stereotipicamente belli, un'avversione per persone con i capelli bianchi (un indicatore dell'età) e una preferenza per i meme con scrittura inglese anziché araba.

La Stanford University ha anche recentemente concluso un concorso che ha sfidato i team a presentare strumenti progettati per aiutare le persone a controllare i sistemi di intelligenza artificiale distribuiti commercialmente o open source per la discriminazione. E le leggi dell'UE attuali e future potrebbero rendere obbligatorio per le aziende controllare regolarmente i propri dati e algoritmi.

Ma prendendo Ricompense dei bug dell'IA e audit algoritmico mainstream e renderli efficaci sarà più facile a dirsi che a farsi. Inevitabilmente, le aziende che costruiscono le loro attività sui loro algoritmi resisteranno a qualsiasi tentativo di screditarle.

Basandosi sugli insegnamenti dei sistemi di audit in altri settori, come la finanza e le normative ambientali e sanitarie, i ricercatori delineato di recente alcuni degli ingredienti cruciali per una responsabilità efficace. Uno dei più importanti criteri hanno identificato era il coinvolgimento significativo di terze parti indipendenti.

I ricercatori hanno sottolineato che gli attuali audit volontari dell'IA spesso comportano conflitti di interesse, come l'organizzazione target che paga per l'audit, aiuta a inquadrare l'ambito dell'audit o ha l'opportunità di rivedere i risultati prima che vengano pubblicizzati. Questa preoccupazione è stata rispecchiata in un recente rapporto del Justice League algoritmico, mach ha notato la taglia fuori misurad ruolo delle organizzazioni target negli attuali programmi di ricompensa dei bug di sicurezza informatica.

Trovare un modo per finanziare e supportare revisori di intelligenza artificiale e cacciatori di bug veramente indipendenti sarà una sfida significativa, in particolare perché si scontreranno con alcune delle aziende più dotate di risorse al mondo. Fortunatamente, tuttavia, sembra esserci una crescente sensazione all'interno del settore che affrontare questo problema sarà fondamentale per mantenere la fiducia degli utenti nei loro servizi.

Immagine di credito: Jacob Rosen / Unsplash