La creazione di soluzioni di machine learning (ML) ad alte prestazioni si basa sull'esplorazione e sull'ottimizzazione dei parametri di training, noti anche come iperparametri. Gli iperparametri sono le manopole e le leve che utilizziamo per regolare il processo di formazione, come il tasso di apprendimento, la dimensione del batch, la forza della regolarizzazione e altri, a seconda del modello specifico e dell'attività da svolgere. L'esplorazione degli iperparametri implica la variazione sistematica dei valori di ciascun parametro e l'osservazione dell'impatto sulle prestazioni del modello. Sebbene questo processo richieda ulteriori sforzi, i vantaggi sono significativi. L'ottimizzazione degli iperparametri (HPO) può portare a tempi di addestramento più rapidi, una migliore accuratezza del modello e una migliore generalizzazione a nuovi dati.

Continuiamo il nostro viaggio dal post Ottimizza gli iperparametri con l'ottimizzazione automatica dei modelli di Amazon SageMaker. In precedenza abbiamo esplorato l'ottimizzazione di un singolo lavoro, visualizzato i risultati dell'algoritmo integrato di SageMaker e appreso l'impatto di particolari valori di iperparametri. Oltre a utilizzare HPO come ottimizzazione una tantum alla fine del ciclo di creazione del modello, possiamo anche utilizzarlo in più passaggi in modo conversazionale. Ogni lavoro di ottimizzazione ci aiuta ad avvicinarci a una buona prestazione, ma inoltre apprendiamo anche quanto il modello sia sensibile a determinati iperparametri e possiamo utilizzare questa comprensione per informare il successivo lavoro di ottimizzazione. Possiamo rivedere gli iperparametri e i loro intervalli di valori in base a ciò che abbiamo imparato e quindi trasformare questo sforzo di ottimizzazione in una conversazione. E nello stesso modo in cui noi, professionisti del machine learning, accumuliamo conoscenza durante queste corse, Ottimizzazione automatica del modello (AMT) di Amazon SageMaker con l'avvio a caldo è possibile mantenere queste conoscenze acquisite nei lavori di ottimizzazione precedenti anche per il lavoro di ottimizzazione successivo.

In questo post, eseguiamo più lavori HPO con un algoritmo di training personalizzato e diverse strategie HPO come l'ottimizzazione bayesiana e la ricerca casuale. Mettiamo anche in atto le partenze a caldo e confrontiamo visivamente le nostre prove per perfezionare l’esplorazione spaziale iperparametrica.

Concetti avanzati di SageMaker AMT

Nelle sezioni successive, esamineremo più da vicino ciascuno dei seguenti argomenti e mostreremo come SageMaker AMT può aiutarti a implementarli nei tuoi progetti ML:

- Utilizza il codice di formazione personalizzato e il popolare framework ML Scikit-learn in SageMaker Training

- Definire metriche di valutazione personalizzate in base ai log per la valutazione e l'ottimizzazione

- Eseguire l'HPO utilizzando una strategia appropriata

- Utilizza gli avvii a caldo per trasformare una singola ricerca di iperparametri in un dialogo con il nostro modello

- Utilizza tecniche di visualizzazione avanzate utilizzando la nostra libreria di soluzioni per confrontare due strategie HPO e ottimizzare i risultati dei lavori

Sia che tu stia utilizzando gli algoritmi integrati utilizzati nel nostro primo post o il tuo codice di formazione, SageMaker AMT offre un'esperienza utente fluida per l'ottimizzazione dei modelli ML. Fornisce funzionalità chiave che ti consentono di concentrarti sul problema ML in questione tenendo traccia automaticamente delle prove e dei risultati. Allo stesso tempo, gestisce automaticamente l’infrastruttura sottostante per te.

In questo post ci allontaniamo dall'algoritmo integrato di SageMaker e utilizziamo codice personalizzato. Usiamo una foresta casuale da SkLearn. Ma ci atteniamo alla stessa attività e set di dati ML del nostro primo post, che rileva le cifre scritte a mano. Copriamo il contenuto del taccuino Jupyter 2_advanced_tuning_with_custom_training_and_visualizing.ipynb e ti invitiamo a richiamare il codice fianco a fianco per leggere oltre.

Immergiamoci più a fondo e scopriamo come possiamo utilizzare il codice di training personalizzato, distribuirlo ed eseguirlo, esplorando allo stesso tempo lo spazio di ricerca degli iperparametri per ottimizzare i nostri risultati.

Come creare un modello ML ed eseguire l'ottimizzazione degli iperparametri

Come si presenta un tipico processo per la creazione di una soluzione ML? Sebbene esistano molti casi d’uso possibili e una grande varietà di attività di ML, suggeriamo il seguente modello mentale per un approccio graduale:

- Comprendi il tuo scenario ML a portata di mano e seleziona un algoritmo in base ai requisiti. Ad esempio, potresti voler risolvere un'attività di riconoscimento di immagini utilizzando un algoritmo di apprendimento supervisionato. In questo post continuiamo a utilizzare lo scenario di riconoscimento delle immagini scritte a mano e lo stesso set di dati del nostro primo post.

- Decidi quale implementazione dell'algoritmo in SageMaker Training desideri utilizzare. Esistono varie opzioni, interne a SageMaker o esterne. Inoltre, devi definire quale metrica sottostante si adatta meglio alla tua attività e per cui desideri ottimizzare (come precisione, punteggio F1 o ROC). SageMaker supporta quattro opzioni a seconda delle tue esigenze e risorse:

- Utilizzare un modello preaddestrato tramite JumpStart di Amazon SageMaker, che puoi utilizzare immediatamente o semplicemente perfezionarlo.

- Utilizza uno degli algoritmi integrati per l'addestramento e la messa a punto, come XGBoost, come abbiamo fatto nel nostro post precedente.

- Addestra e ottimizza un modello personalizzato basato su uno dei principali framework come Scikit-learn, TensorFlow o PyTorch. AWS fornisce una selezione di immagini Docker predefinite a questo scopo. Per questo post utilizziamo questa opzione, che ti consente di sperimentare rapidamente eseguendo il tuo codice su un'immagine contenitore predefinita.

- Porta la tua immagine Docker personalizzata nel caso in cui desideri utilizzare un framework o un software che non sia altrimenti supportato. Questa opzione richiede il massimo sforzo, ma offre anche il massimo grado di flessibilità e controllo.

- Addestra il modello con i tuoi dati. A seconda dell'implementazione dell'algoritmo del passaggio precedente, ciò può essere semplice come fare riferimento ai dati di addestramento ed eseguire il processo di addestramento o fornire inoltre un codice personalizzato per l'addestramento. Nel nostro caso, utilizziamo del codice di formazione personalizzato in Python basato su Scikit-learn.

- Applica l'ottimizzazione degli iperparametri (come una "conversazione" con il tuo modello ML). Dopo l'addestramento, in genere desideri ottimizzare le prestazioni del tuo modello trovando la combinazione di valori più promettente per gli iperparametri del tuo algoritmo.

A seconda dell'algoritmo ML e delle dimensioni del modello, l'ultimo passaggio dell'ottimizzazione degli iperparametri potrebbe rivelarsi una sfida più grande del previsto. Le seguenti domande sono tipiche per i professionisti del machine learning in questa fase e potrebbero suonarti familiari:

- Che tipo di iperparametri hanno un impatto sul mio problema di machine learning?

- Come posso cercare in modo efficace un enorme spazio di iperparametri per trovare i valori con le migliori prestazioni?

- In che modo la combinazione di determinati valori di iperparametri influenza la mia metrica delle prestazioni?

- I costi contano; come posso utilizzare le mie risorse in modo efficiente?

- Che tipo di esperimenti di tuning sono utili e come posso confrontarli?

Non è facile rispondere a queste domande, ma c’è una buona notizia. SageMaker AMT ti prende il lavoro pesante e ti consente di concentrarti sulla scelta della giusta strategia HPO e delle gamme di valori che desideri esplorare. Inoltre, la nostra soluzione di visualizzazione facilita l'analisi iterativa e il processo di sperimentazione per trovare in modo efficiente valori di iperparametri con buone prestazioni.

Nelle sezioni successive, creeremo da zero un modello di riconoscimento delle cifre utilizzando Scikit-learn e mostreremo tutti questi concetti in azione.

Panoramica della soluzione

SageMaker offre alcune funzionalità molto utili per addestrare, valutare e ottimizzare il nostro modello. Copre tutte le funzionalità di un ciclo di vita ML end-to-end, quindi non abbiamo nemmeno bisogno di lasciare il nostro notebook Jupyter.

Nel nostro primo post, abbiamo utilizzato l'algoritmo integrato di SageMaker XGBoost. A scopo dimostrativo, questa volta passiamo a un classificatore Random Forest perché possiamo quindi mostrare come fornire il proprio codice di addestramento. Abbiamo optato per fornire il nostro script Python e utilizzare Scikit-learn come framework. Ora, come esprimiamo che vogliamo utilizzare uno specifico framework ML? Come vedremo, SageMaker utilizza un altro servizio AWS in background per recuperare un'immagine del contenitore Docker precostruita per l'addestramento:Registro dei contenitori Amazon Elastic (Amazon ECR).

Tratteremo i seguenti passaggi in dettaglio, inclusi frammenti di codice e diagrammi per collegare i punti. Come accennato in precedenza, se ne hai la possibilità, apri il notebook ed esegui le celle di codice passo dopo passo per creare gli artefatti nel tuo ambiente AWS. Non esiste modo migliore di apprendimento attivo.

- Per prima cosa caricare e preparare i dati. Noi usiamo Servizio di archiviazione semplice Amazon (Amazon S3) per caricare un file contenente i dati delle nostre cifre scritte a mano.

- Successivamente, preparare lo script di training e le dipendenze del framework. Forniamo il codice di training personalizzato in Python, facciamo riferimento ad alcune librerie dipendenti ed effettuiamo un test.

- Per definire le metriche degli obiettivi personalizzati, SageMaker ci consente di definire un'espressione regolare per estrarre le metriche di cui abbiamo bisogno dai file di registro del contenitore.

- Addestra il modello utilizzando il framework scikit-learn. Facendo riferimento a un'immagine contenitore predefinita, creiamo un oggetto Estimator corrispondente e passiamo il nostro script di training personalizzato.

- AMT ci consente di provare varie strategie HPO. Ci concentreremo su due di essi per questo post: ricerca casuale e ricerca bayesiana.

- Scegli tra le strategie HPO di SageMaker.

- Visualizza, analizza e confronta i risultati dell'ottimizzazione. Il nostro pacchetto di visualizzazione ci consente di scoprire quale strategia funziona meglio e quali valori di iperparametri offrono le migliori prestazioni in base alle nostre metriche.

- Continuare l'esplorazione dello spazio degli iperparametri e avviare a caldo i processi HPO.

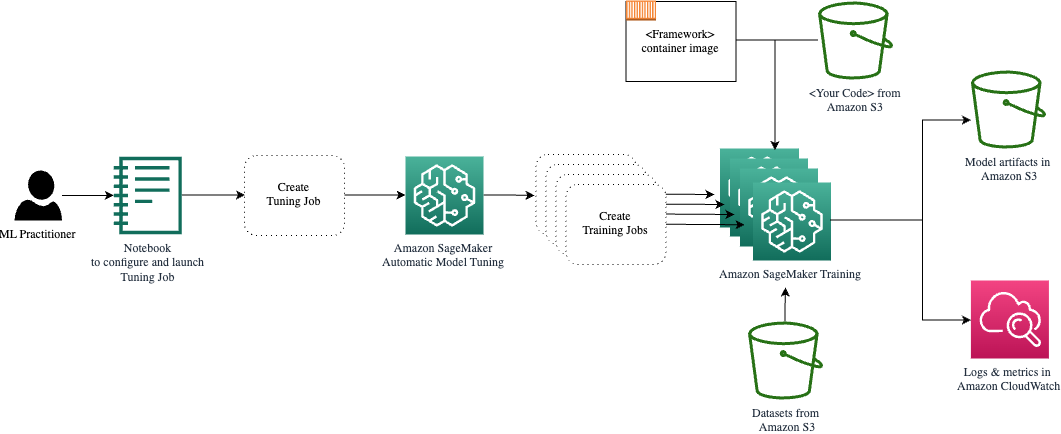

AMT si occupa del dimensionamento e della gestione dell'infrastruttura di calcolo sottostante su cui eseguire i vari lavori di ottimizzazione Cloud di calcolo elastico di Amazon (Amazon EC2). In questo modo, non dovrai impegnarti a fornire istanze, gestire eventuali problemi relativi al sistema operativo e all'hardware o aggregare file di registro per conto tuo. L'immagine del framework ML viene recuperata da Amazon ECR e gli artefatti del modello, inclusi i risultati dell'ottimizzazione, vengono archiviati in Amazon S3. Tutti i log e le metriche vengono raccolti in Amazon Cloud Watch per un comodo accesso e ulteriori analisi, se necessario.

Prerequisiti

Poiché questa è la continuazione di una serie, se ne consiglia la lettura, ma non necessariamente obbligatoria il nostro primo post su SageMaker AMT e HPO. Oltre a ciò, è utile una familiarità di base con i concetti di ML e la programmazione Python. Ti consigliamo inoltre di seguire ogni passaggio del file quaderno di accompagnamento dal nostro repository GitHub durante la lettura di questo post. Il notebook può essere eseguito indipendentemente dal primo, ma necessita di codice dalle sottocartelle. Assicurati di clonare l'intero repository nel tuo ambiente come descritto nel file README.

Sperimentare con il codice e utilizzare le opzioni di visualizzazione interattiva migliora notevolmente la tua esperienza di apprendimento. Quindi, per favore, dai un'occhiata.

Caricare e preparare i dati

Come primo passo, ci assicuriamo che il file sia scaricato dati in cifre di cui abbiamo bisogno per la formazione è accessibile a SageMaker. Amazon S3 ci consente di farlo in modo sicuro e scalabile. Fate riferimento al notebook per il codice sorgente completo e sentitevi liberi di adattarlo con i vostri dati.

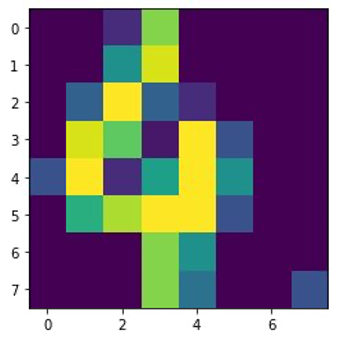

I digits.csv il file contiene dati ed etichette sulle funzionalità. Ogni cifra è rappresentata da valori di pixel in un'immagine 8×8, come illustrato dall'immagine seguente per la cifra 4.

Preparare lo script di training e le dipendenze del framework

Ora che i dati sono archiviati nel nostro bucket S3, possiamo definire il nostro script di training personalizzato basato su Scikit-learn in Pitone. SageMaker ci offre la possibilità di fare semplicemente riferimento al file Python in un secondo momento per l'addestramento. Eventuali dipendenze come le librerie Scikit-learn o pandas possono essere fornite in due modi:

- Possono essere specificati esplicitamente in a

requirements.txtfiletto - Sono preinstallati nell'immagine del contenitore ML sottostante, fornita da SageMaker o creata su misura

Entrambe le opzioni sono generalmente considerate metodi standard per la gestione delle dipendenze, quindi potresti già averne familiarità. SageMaker supporta una varietà di framework ML in un ambiente gestito pronto all'uso. Ciò include molti dei framework di data science e ML più popolari come PyTorch, TensorFlow o Scikit-learn, come nel nostro caso. Non usiamo un ulteriore requirements.txt file, ma sentiti libero di aggiungere alcune librerie per provarlo.

Il codice della nostra implementazione contiene un metodo chiamato fit(), che crea un nuovo classificatore per l'attività di riconoscimento delle cifre e lo addestra. A differenza del nostro primo post in cui utilizzavamo l'algoritmo XGBoost integrato di SageMaker, ora utilizziamo un RandomForestClassifier fornito dalla libreria ML sklearn. La chiamata del fit() Il metodo sull'oggetto classificatore avvia il processo di addestramento utilizzando un sottoinsieme (80%) dei nostri dati CSV:

Vedi lo script completo nel nostro taccuino Jupyter su GitHub.

Prima di avviare le risorse del contenitore per l'intero processo di formazione, hai provato a eseguire direttamente lo script? Questa è una buona pratica per garantire rapidamente che il codice non contenga errori di sintassi, verificare tempestivamente le dimensioni corrispondenti delle strutture dati e altri errori.

Esistono due modi per eseguire il codice localmente. Innanzitutto, puoi eseguirlo subito nel notebook, il che ti consente anche di utilizzare il debugger Python pdb:

In alternativa, esegui lo script train dalla riga di comando nello stesso modo in cui potresti volerlo utilizzare in un contenitore. Ciò supporta anche l'impostazione di vari parametri e la sovrascrittura dei valori predefiniti secondo necessità, ad esempio:

Come output, puoi vedere i primi risultati delle prestazioni del modello in base alla precisione delle metriche oggettive, al richiamo e al punteggio F1. Per esempio, pre: 0.970 rec: 0.969 f1: 0.969.

Non male per un allenamento così veloce. Ma da dove vengono questi numeri e cosa ne facciamo?

Definire le metriche degli obiettivi personalizzati

Ricorda, il nostro obiettivo è addestrare e ottimizzare completamente il nostro modello in base alle metriche oggettive che consideriamo rilevanti per il nostro compito. Poiché utilizziamo uno script di formazione personalizzato, dobbiamo definire esplicitamente tali parametri per SageMaker.

Il nostro script emette la precisione delle metriche, il richiamo e il punteggio F1 durante l'allenamento semplicemente utilizzando il file print funzione:

L'output standard viene acquisito da SageMaker e inviato a CloudWatch come flusso di log. Per recuperare i valori metrici e utilizzarli successivamente in SageMaker AMT, dobbiamo fornire alcune informazioni su come analizzare tale output. Possiamo raggiungere questo obiettivo definendo istruzioni di espressioni regolari (per ulteriori informazioni, fare riferimento a Monitora e analizza i processi di formazione utilizzando le metriche di Amazon CloudWatch):

Esaminiamo insieme la prima definizione di metrica nel codice precedente. SageMaker cercherà l'output nel registro che inizia con pre: ed è seguito da uno o più spazi bianchi e poi da un numero che vogliamo estrarre, motivo per cui utilizziamo le parentesi tonde. Ogni volta che SageMaker trova un valore del genere, lo trasforma in un parametro CloudWatch con quel nome valid-precision.

Addestra il modello utilizzando il framework Scikit-learn

Dopo aver creato il nostro script di formazione train.py e istruire SageMaker su come monitorare i parametri all'interno di CloudWatch, definiamo a Estimatore di SageMaker oggetto. Avvia il processo di training e utilizza il tipo di istanza specificato. Ma come può questo tipo di istanza essere diverso da quello eseguito su an Amazon Sage Maker Studio notebook acceso e perché? SageMaker Studio esegue i tuoi processi di training (e inferenza) su istanze di calcolo separate rispetto al tuo notebook. Ciò ti consente di continuare a lavorare sul tuo notebook mentre i lavori vengono eseguiti in background.

Il parametro framework_version si riferisce alla versione Scikit-learn che utilizziamo per il nostro lavoro di formazione. In alternativa possiamo passare image_uri Vai all’email estimator. Puoi verificare se il tuo framework preferito o la libreria ML è disponibile come file immagine Docker SageMaker precostruita e usarlo così com'è o con estensioni.

Inoltre, possiamo eseguire lavori di formazione SageMaker su istanze Spot EC2 impostando use_spot_instances a True. Sono istanze di capacità di riserva che possono risparmiare fino al 90% dei costi. Queste istanze forniscono flessibilità su quando vengono eseguiti i processi di formazione.

Dopo aver configurato l'oggetto Estimator, iniziamo l'addestramento chiamando il file fit() funzione, fornendo il percorso al set di dati di addestramento su Amazon S3. Possiamo utilizzare questo stesso metodo per fornire dati di convalida e test. Impostiamo il wait parametro True quindi possiamo utilizzare il modello addestrato nelle celle di codice successive.

estimator.fit({'train': s3_data_url}, wait=True)Definire gli iperparametri ed eseguire processi di ottimizzazione

Finora abbiamo addestrato il modello con un set di valori di iperparametri. Ma quei valori erano buoni? Oppure potremmo cercarne di migliori? Usiamo il Classe HyperparameterTuner per eseguire una ricerca sistematica nello spazio degli iperparametri. Come cerchiamo questo spazio con il sintonizzatore? I parametri necessari sono il nome della metrica dell'obiettivo e il tipo di obiettivo che guideranno l'ottimizzazione. La strategia di ottimizzazione è un altro argomento chiave per il sintonizzatore perché definisce ulteriormente lo spazio di ricerca. Di seguito sono riportate quattro diverse strategie tra cui scegliere:

- Ricerca a griglia

- Ricerca casuale

- Ottimizzazione bayesiana (impostazione predefinita)

- Iperbanda

Descriviamo ulteriormente queste strategie e ti forniamo alcune indicazioni per sceglierne una più avanti in questo post.

Prima di definire ed eseguire il nostro oggetto tuner, ricapitoliamo la nostra comprensione dal punto di vista dell'architettura. Abbiamo trattato la panoramica dell'architettura di SageMaker AMT in il nostro ultimo post e ne riproponiamo qui per comodità un estratto.

Possiamo scegliere quali iperparametri vogliamo ottimizzare o lasciare statici. Per gli iperparametri dinamici, forniamo hyperparameter_ranges che può essere utilizzato per ottimizzare gli iperparametri sintonizzabili. Poiché utilizziamo un classificatore Random Forest, abbiamo utilizzato gli iperparametri del file Documentazione Scikit-learn Random Forest.

Limitiamo inoltre le risorse con il numero massimo di lavori di formazione e lavori di formazione paralleli che il sintonizzatore può utilizzare. Vedremo come questi limiti ci aiutano a confrontare tra loro i risultati delle varie strategie.

Simile a quello dello stimatore fit funzione, iniziamo un lavoro di ottimizzazione chiamando il sintonizzatore fit:

Questo è tutto ciò che dobbiamo fare per consentire a SageMaker di eseguire i lavori di formazione (n=50) in background, ciascuno utilizzando un diverso set di iperparametri. Esploreremo i risultati più avanti in questo post. Ma prima, iniziamo un altro lavoro di messa a punto, questa volta applicando la strategia di ottimizzazione bayesiana. Confronteremo visivamente entrambe le strategie dopo il loro completamento.

Tieni presente che entrambi i processi di ottimizzazione possono essere eseguiti in parallelo perché SageMaker orchestra le istanze di calcolo richieste indipendentemente l'una dall'altra. Ciò è molto utile per i professionisti che sperimentano approcci diversi allo stesso tempo, come facciamo qui.

Scegli tra le strategie HPO di SageMaker

Quando si tratta di ottimizzare le strategie, con SageMaker AMT hai alcune opzioni: ricerca su griglia, ricerca casuale, ottimizzazione bayesiana e iperbanda. Queste strategie determinano il modo in cui gli algoritmi di ottimizzazione automatica esplorano gli intervalli specificati di iperparametri.

La ricerca casuale è piuttosto semplice. Seleziona casualmente combinazioni di valori dagli intervalli specificati e può essere eseguito in modo sequenziale o parallelo. È come lanciare freccette con gli occhi bendati, sperando di colpire il bersaglio. Abbiamo iniziato con questa strategia, ma con un’altra i risultati miglioreranno?

L'ottimizzazione bayesiana adotta un approccio diverso rispetto alla ricerca casuale. Considera la cronologia delle selezioni precedenti e sceglie i valori che probabilmente produrranno i migliori risultati. Se vuoi imparare dalle esplorazioni precedenti, puoi raggiungere questo obiettivo solo eseguendo un nuovo lavoro di ottimizzazione dopo quelli precedenti. Ha senso, vero? In questo modo, l'ottimizzazione bayesiana dipende dalle esecuzioni precedenti. Ma vedi quale strategia HPO consente una maggiore parallelizzazione?

Iperbanda è interessante! Utilizza una strategia multi-fedeltà, il che significa che alloca dinamicamente le risorse ai lavori di formazione più promettenti e blocca quelli che hanno prestazioni inferiori. Pertanto, Hyperband è computazionalmente efficiente con le risorse, imparando da precedenti lavori di formazione. Dopo aver interrotto le configurazioni con prestazioni inferiori, viene avviata una nuova configurazione i cui valori vengono scelti in modo casuale.

A seconda delle tue esigenze e della natura del tuo modello, puoi scegliere tra ricerca casuale, ottimizzazione bayesiana o iperbanda come strategia di ottimizzazione. Ognuno ha il proprio approccio e vantaggi, quindi è importante considerare quale funziona meglio per la tua esplorazione del machine learning. La buona notizia per i professionisti del machine learning è che è possibile selezionare la migliore strategia HPO confrontando visivamente l'impatto di ciascuna sperimentazione sulla metrica oggettiva. Nella sezione successiva, vediamo come identificare visivamente l’impatto delle diverse strategie.

Visualizza, analizza e confronta i risultati dell'ottimizzazione

Quando i nostri lavori di messa a punto sono completi, diventa emozionante. Quali risultati forniscono? Che tipo di incremento puoi aspettarti sulla nostra metrica rispetto al tuo modello base? Quali sono gli iperparametri più performanti per il nostro caso d'uso?

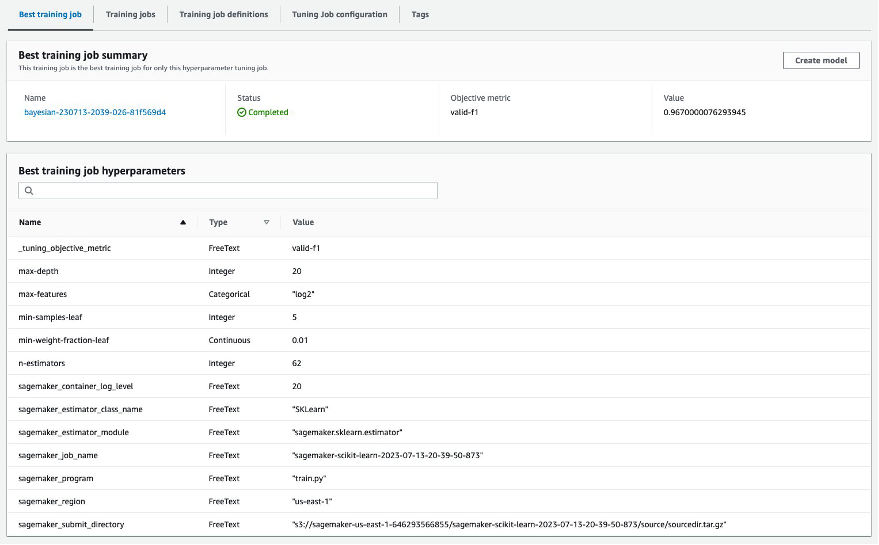

Un modo rapido e semplice per visualizzare i risultati HPO è visitare la console SageMaker. Sotto Lavori di ottimizzazione degli iperparametri, possiamo vedere (per processo di ottimizzazione) la combinazione di valori di iperparametri che sono stati testati e hanno fornito le migliori prestazioni misurate dalla nostra metrica oggettiva (valid-f1).

È tutto ciò di cui hai bisogno? In qualità di professionista del ML, potresti non solo essere interessato a questi valori, ma sicuramente voler saperne di più sul funzionamento interno del tuo modello per esplorarne tutto il potenziale e rafforzare la tua intuizione con feedback empirico.

Un buon strumento di visualizzazione può aiutarti notevolmente a comprendere il miglioramento apportato da HPO nel tempo e ottenere feedback empirico sulle decisioni di progettazione del tuo modello ML. Mostra l'impatto di ogni singolo iperparametro sulla metrica oggettiva e fornisce indicazioni per ottimizzare ulteriormente i risultati dell'ottimizzazione.

Usiamo il amtviz pacchetto di visualizzazione personalizzato per visualizzare e analizzare i lavori di ottimizzazione. È semplice da usare e fornisce funzionalità utili. Dimostriamo i suoi vantaggi interpretando alcuni grafici individuali e infine confrontando la ricerca casuale con l'ottimizzazione bayesiana.

Innanzitutto, creiamo una visualizzazione per la ricerca casuale. Possiamo farlo chiamando visualize_tuning_job() da amtviz e passando il nostro primo oggetto tuner come argomento:

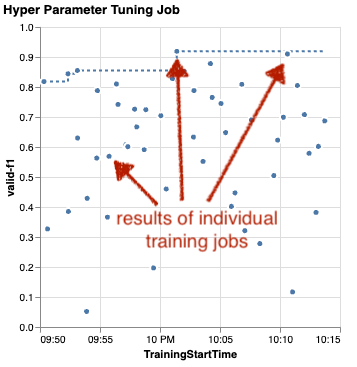

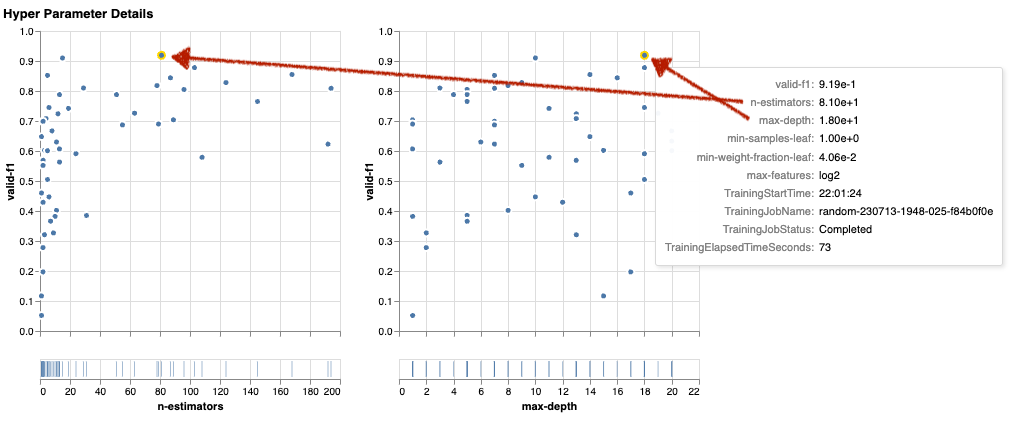

Vedrai un paio di grafici, ma procediamo per gradi. Il primo grafico a dispersione dell'output è simile al seguente e ci fornisce già alcuni indizi visivi che non riconosceremmo in nessuna tabella.

Ogni punto rappresenta la prestazione di un lavoro di formazione individuale (il nostro obiettivo valid-f1 sull'asse y) in base al suo tempo di inizio (asse x), prodotto da un insieme specifico di iperparametri. Pertanto, esaminiamo le prestazioni del nostro modello man mano che progredisce nel corso della durata del lavoro di ottimizzazione.

La linea tratteggiata evidenzia il miglior risultato riscontrato finora e indica il miglioramento nel tempo. I migliori due lavori di formazione hanno ottenuto un punteggio F1 di circa 0.91.

Oltre alla linea tratteggiata che mostra il progresso cumulativo, vedi una tendenza nel grafico?

Probabilmente no. E questo è previsto, perché stiamo visualizzando i risultati della strategia HPO casuale. Ogni processo di training è stato eseguito utilizzando un set di iperparametri diverso ma selezionato casualmente. Se continuassimo il nostro lavoro di messa a punto (o ne eseguissimo un altro con la stessa impostazione), probabilmente vedremmo risultati migliori nel tempo, ma non possiamo esserne sicuri. La casualità è una cosa complicata.

I grafici successivi ti aiutano a valutare l'influenza degli iperparametri sulle prestazioni complessive. Vengono visualizzati tutti gli iperparametri, ma per brevità ci concentriamo su due di essi: n-estimators ed max-depth.

I nostri due principali lavori di formazione stavano utilizzando n-estimators di circa 20 e 80, e max-depth rispettivamente di circa 10 e 18. I valori esatti degli iperparametri vengono visualizzati tramite descrizione comando per ciascun punto (lavoro di training). Sono anche evidenziati dinamicamente in tutti i grafici e ti offrono una visione multidimensionale! Hai visto che? Ogni iperparametro viene tracciato rispetto alla metrica oggettiva, come un grafico separato.

Ora, che tipo di intuizioni otteniamo? n-estimators?

In base al grafico a sinistra, sembra che intervalli di valori molto bassi (sotto 10) forniscano più spesso risultati scarsi rispetto a valori più alti. Pertanto, valori più alti possono aiutare il tuo modello a funzionare meglio: interessante.

Al contrario, la correlazione di max-depth iperparametro rispetto alla nostra metrica oggettiva è piuttosto basso. Non possiamo dire chiaramente quali intervalli di valori abbiano il rendimento migliore da una prospettiva generale.

In sintesi, la ricerca casuale può aiutarti a trovare un insieme di iperparametri con buone prestazioni anche in un periodo di tempo relativamente breve. Inoltre, non è sbilanciato verso una buona soluzione ma offre una visione equilibrata dello spazio di ricerca. L'utilizzo delle risorse, tuttavia, potrebbe non essere molto efficiente. Continua a eseguire lavori di training con iperparametri in intervalli di valori noti per fornire scarsi risultati.

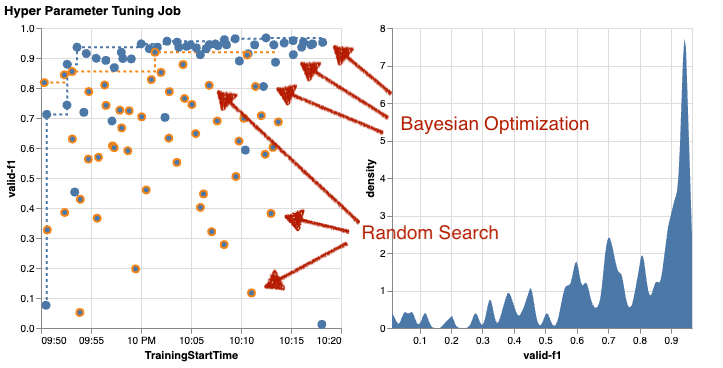

Esaminiamo i risultati del nostro secondo lavoro di ottimizzazione utilizzando l'ottimizzazione bayesiana. Possiamo usare amtviz per visualizzare i risultati nello stesso modo in cui abbiamo fatto finora per il sintonizzatore di ricerca casuale. Oppure, ancora meglio, possiamo sfruttare la capacità della funzione per confrontare entrambi i lavori di ottimizzazione in un unico set di grafici. Abbastanza utile!

Ora ci sono più punti perché visualizziamo i risultati di tutti i lavori di training sia per la ricerca casuale (punti arancioni) che per l'ottimizzazione bayesiana (punti blu). Sul lato destro puoi vedere un grafico della densità che visualizza la distribuzione di tutti i punteggi F1. La maggior parte dei lavori di formazione ha ottenuto risultati nella parte alta della scala F1 (oltre 0.6): questo è positivo!

Qual è il punto chiave qui? Il grafico a dispersione mostra chiaramente i vantaggi dell'ottimizzazione bayesiana. Fornisce risultati migliori nel tempo perché può imparare dalle esecuzioni precedenti. Ecco perché abbiamo ottenuto risultati significativamente migliori utilizzando il metodo bayesiano rispetto a quello casuale (0.967 contro 0.919) con lo stesso numero di processi di addestramento.

C'è ancora di più che puoi fare con amtviz. Approfondiamo.

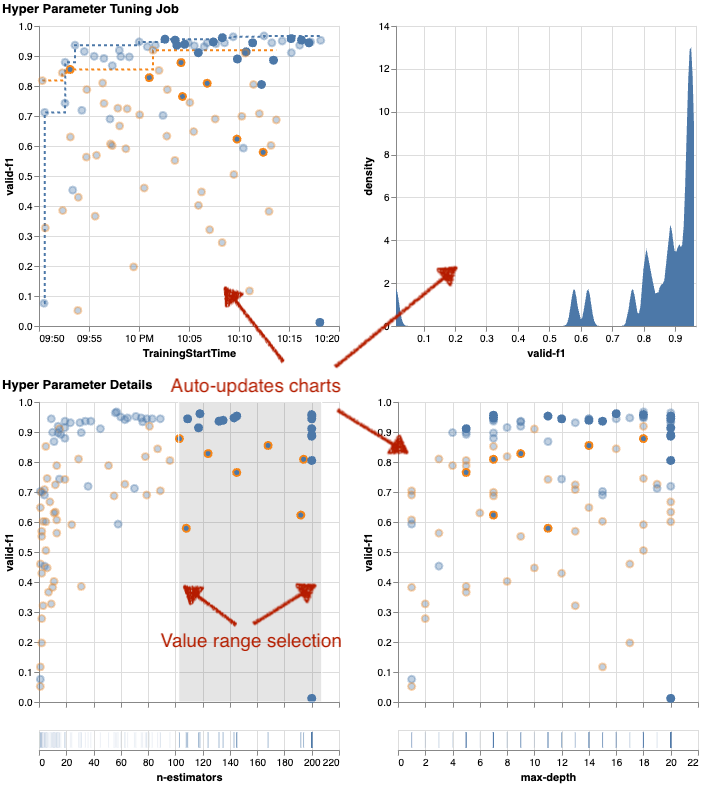

Se dai a SageMaker AMT l'istruzione di eseguire un numero maggiore di lavori per l'ottimizzazione, vedere molte prove contemporaneamente può creare confusione. Questo è uno dei motivi per cui abbiamo reso questi grafici interattivi. È possibile fare clic e trascinare su ogni grafico a dispersione degli iperparametri per ingrandire determinati intervalli di valori e perfezionare l'interpretazione visiva dei risultati. Tutti gli altri grafici vengono aggiornati automaticamente. È piuttosto utile, vero? Guarda i grafici successivi come esempio e provalo tu stesso sul tuo quaderno!

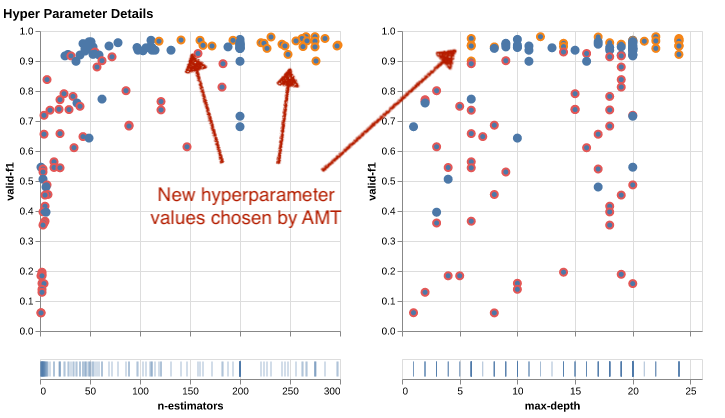

In qualità di massimalista di ottimizzazione, potresti anche decidere che l'esecuzione di un altro processo di ottimizzazione degli iperparametri potrebbe migliorare ulteriormente le prestazioni del tuo modello. Ma questa volta è possibile esplorare un intervallo più specifico di valori degli iperparametri perché si sa già (approssimativamente) dove aspettarsi risultati migliori. Ad esempio, puoi scegliere di concentrarti su valori compresi tra 100 e 200 per n-estimators, come mostrato nel grafico. Ciò consente ad AMT di concentrarsi sui lavori di formazione più promettenti e aumenta l'efficienza della messa a punto.

Riassumendo, amtviz fornisce un ricco set di funzionalità di visualizzazione che ti consentono di comprendere meglio l'impatto degli iperparametri del tuo modello sulle prestazioni e di consentire decisioni più intelligenti nelle attività di ottimizzazione.

Continuare l'esplorazione dello spazio degli iperparametri e avviare a caldo i processi HPO

Abbiamo visto che AMT ci aiuta a esplorare in modo efficiente lo spazio di ricerca degli iperparametri. Ma cosa succede se abbiamo bisogno di più cicli di messa a punto per migliorare in modo iterativo i nostri risultati? Come accennato all'inizio, vogliamo stabilire un ciclo di feedback sull'ottimizzazione: la nostra "conversazione" con il modello. Dobbiamo ricominciare da capo ogni volta?

Esaminiamo il concetto di esecuzione di a processo di ottimizzazione degli iperparametri con avvio a caldo. Non avvia nuovi lavori di ottimizzazione da zero, riutilizza ciò che è stato appreso nelle precedenti esecuzioni HPO. Questo ci aiuta a essere più efficienti con i tempi di ottimizzazione e le risorse di calcolo. Possiamo ripetere ulteriormente i nostri risultati precedenti. Per utilizzare gli avviamenti a caldo, creiamo a WarmStartConfig e specificare warm_start_type as IDENTICAL_DATA_AND_ALGORITHM. Ciò significa che modifichiamo i valori degli iperparametri ma non modifichiamo i dati o l'algoritmo. Diciamo ad AMT di trasferire le conoscenze precedenti al nostro nuovo lavoro di ottimizzazione.

Facendo riferimento ai nostri precedenti lavori di ottimizzazione bayesiana e di ottimizzazione della ricerca casuale come parents, possiamo usarli entrambi per l'avvio a caldo:

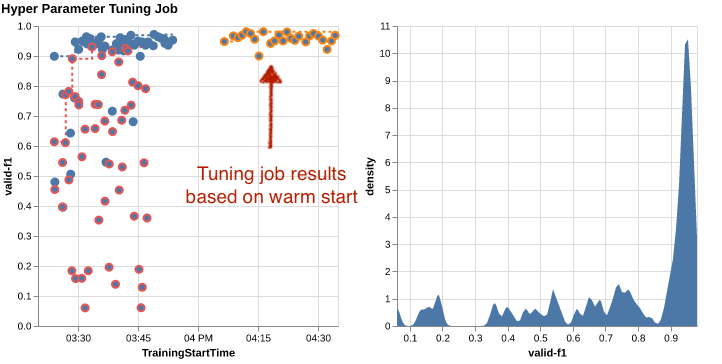

Per verificare i vantaggi derivanti dall'utilizzo degli avviamenti a caldo, fare riferimento ai grafici seguenti. Questi sono generati da amtviz in modo simile a quello fatto in precedenza, ma questa volta abbiamo aggiunto un altro lavoro di messa a punto basato su un avvio a caldo.

Nel grafico a sinistra, possiamo osservare che i nuovi lavori di ottimizzazione si trovano principalmente nell'angolo in alto a destra del grafico della metrica delle prestazioni (vedi punti contrassegnati in arancione). La partenza a caldo ha effettivamente riutilizzato i risultati precedenti, motivo per cui questi punti dati sono tra i migliori risultati per il punteggio F1. Questo miglioramento si riflette anche nel grafico della densità a destra.

In altre parole, AMT seleziona automaticamente insiemi promettenti di valori di iperparametri in base alle conoscenze acquisite da prove precedenti. Questo è mostrato nel grafico successivo. Ad esempio, l'algoritmo testerebbe un valore basso per n-estimators meno spesso perché è noto che producono punteggi F1 scarsi. Non sprechiamo risorse in questo senso, grazie alle partenze calde.

ripulire

Per evitare di incorrere in costi indesiderati quando hai finito di sperimentare con HPO, devi rimuovere tutti i file nel tuo bucket S3 con il prefisso amt-visualize-demo e anche chiudere le risorse di SageMaker Studio.

Esegui il seguente codice sul tuo notebook per rimuovere tutti i file S3 da questo post:

Se si desidera conservare i set di dati o gli artefatti del modello, è possibile modificare il prefisso nel codice a amt-visualize-demo/data cancellare solo i dati o amt-visualize-demo/output per eliminare solo gli artefatti del modello.

Conclusione

Abbiamo imparato come l'arte di creare soluzioni ML implica l'esplorazione e l'ottimizzazione degli iperparametri. La regolazione di manopole e leve è un processo impegnativo ma gratificante che porta a tempi di addestramento più rapidi, maggiore precisione del modello e soluzioni ML complessivamente migliori. La funzionalità AMT di SageMaker ci aiuta a eseguire più processi di ottimizzazione e ad avviarli a caldo e fornisce punti dati per ulteriori revisioni, confronti visivi e analisi.

In questo post abbiamo esaminato le strategie HPO che utilizziamo con SageMaker AMT. Abbiamo iniziato con la ricerca casuale, una strategia semplice ma efficace in cui gli iperparametri vengono campionati casualmente da uno spazio di ricerca. Successivamente, abbiamo confrontato i risultati con l’ottimizzazione bayesiana, che utilizza modelli probabilistici per guidare la ricerca di iperparametri ottimali. Dopo aver identificato una strategia HPO adeguata e buoni intervalli di valori degli iperparametri attraverso le prove iniziali, abbiamo mostrato come utilizzare gli avvii a caldo per semplificare i futuri lavori HPO.

È possibile esplorare lo spazio di ricerca degli iperparametri confrontando i risultati quantitativi. Abbiamo suggerito il confronto visivo fianco a fianco e fornito il pacchetto necessario per l'esplorazione interattiva. Facci sapere nei commenti quanto ti è stato utile nel tuo percorso di ottimizzazione degli iperparametri!

Circa gli autori

Umit Yoldas è un Senior Solutions Architect presso Amazon Web Services. Lavora con clienti aziendali in tutti i settori in Germania. Il suo obiettivo è tradurre i concetti di intelligenza artificiale in soluzioni del mondo reale. Al di fuori del lavoro, gli piace trascorrere del tempo con la famiglia, assaporare il buon cibo e perseguire la forma fisica.

Umit Yoldas è un Senior Solutions Architect presso Amazon Web Services. Lavora con clienti aziendali in tutti i settori in Germania. Il suo obiettivo è tradurre i concetti di intelligenza artificiale in soluzioni del mondo reale. Al di fuori del lavoro, gli piace trascorrere del tempo con la famiglia, assaporare il buon cibo e perseguire la forma fisica.

Elina Lesyk è un Solutions Architect con sede a Monaco. Il suo focus è sui clienti aziendali del settore dei servizi finanziari. Nel tempo libero, puoi trovare Elina che crea applicazioni con intelligenza artificiale generativa in alcuni incontri IT, che porta avanti una nuova idea su come risolvere rapidamente il cambiamento climatico o che corre nella foresta per prepararsi a una mezza maratona con una tipica deviazione dal programma pianificato.

Elina Lesyk è un Solutions Architect con sede a Monaco. Il suo focus è sui clienti aziendali del settore dei servizi finanziari. Nel tempo libero, puoi trovare Elina che crea applicazioni con intelligenza artificiale generativa in alcuni incontri IT, che porta avanti una nuova idea su come risolvere rapidamente il cambiamento climatico o che corre nella foresta per prepararsi a una mezza maratona con una tipica deviazione dal programma pianificato.

Mariano Campi è un Principal Solutions Architect presso Amazon Web Services. Lavora con banche e compagnie assicurative in Germania sull'apprendimento automatico. Nel tempo libero Mariano ama fare escursioni con la moglie.

Mariano Campi è un Principal Solutions Architect presso Amazon Web Services. Lavora con banche e compagnie assicurative in Germania sull'apprendimento automatico. Nel tempo libero Mariano ama fare escursioni con la moglie.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/explore-advanced-techniques-for-hyperparameter-optimization-with-amazon-sagemaker-automatic-model-tuning/

- :ha

- :È

- :non

- :Dove

- $ SU

- 01

- 1

- 10

- 100

- 11

- 12

- 13

- 14

- 17

- 179

- 20

- 200

- 24

- 33

- 50

- 60

- 7

- 80

- 9

- 91

- 970

- a

- Chi siamo

- accesso

- accessibile

- Accumulare

- precisione

- Raggiungere

- raggiunto

- acquisito

- operanti in

- Action

- attivo

- attività

- adattare

- aggiungere

- aggiunto

- aggiuntivo

- Inoltre

- Avanzate

- vantaggi

- Dopo shavasana, sedersi in silenzio; saluti;

- contro

- aggregato

- AI

- algoritmo

- Algoritmi

- Tutti

- alloca

- consentire

- consente

- lungo

- già

- anche

- Sebbene il

- Amazon

- Amazon EC2

- Amazon Sage Maker

- Amazon Web Services

- quantità

- an

- .

- analizzare

- ed

- Un altro

- rispondere

- in qualsiasi

- a parte

- applicazioni

- AMMISSIONE

- approccio

- approcci

- opportuno

- architettonico

- architettura

- SONO

- argomento

- in giro

- Arte

- AS

- At

- auto

- Automatico

- automaticamente

- disponibile

- evitare

- lontano

- AWS

- sfondo

- Vasca

- Banche

- base

- basato

- basic

- bayesiano

- BE

- perché

- stato

- prima

- Inizio

- sotto

- beneficio

- vantaggi

- MIGLIORE

- Meglio

- fra

- parziale

- maggiore

- Blu

- Incremento

- entrambi

- Scatola

- costruire

- Costruzione

- incassato

- onere

- ma

- by

- chiamata

- detto

- chiamata

- Materiale

- Può ottenere

- funzionalità

- capacità

- Ultra-Grande

- catturato

- che

- Custodie

- casi

- Celle

- certo

- certamente

- Challenge

- possibilità

- il cambiamento

- Grafico

- Grafici

- dai un'occhiata

- Scegli

- la scelta

- scelto

- chiaramente

- clicca

- Clima

- Cambiamento climatico

- più vicino

- codice

- combinazione

- combinazioni

- Venire

- viene

- Commenti

- Aziende

- confrontare

- rispetto

- confronto

- confronto

- completamento di una

- completamento

- Calcolare

- concentrarsi

- concetto

- concetti

- Configurazione

- Connettiti

- Prendere in considerazione

- considerato

- ritiene

- consolle

- Contenitore

- contiene

- contenuto

- continuazione

- continua

- continua

- continua

- contrasto

- di controllo

- comodità

- Comodo

- Conversazione

- discorsivo

- Angolo

- Correlazione

- Corrispondente

- Costi

- potuto

- Coppia

- coprire

- coperto

- Copertine

- creare

- crea

- creazione

- costume

- Clienti

- ciclo

- dati

- punti dati

- scienza dei dati

- dataset

- decide

- decisioni

- più profondo

- Predefinito

- definire

- definisce

- definizione

- definizione

- Laurea

- consegnare

- consegnato

- fornisce un monitoraggio

- esigente

- dimostrare

- dipendenze

- Dipendenza

- dipendente

- Dipendente

- schierare

- descrivere

- descritta

- Design

- dettaglio

- dettagli

- Determinare

- deviazione

- diagrammi

- dialogo

- DID

- diverso

- cifre

- dimensioni

- direttamente

- scopri

- visualizzati

- distribuzione

- immersione

- do

- docker

- effettua

- non

- fatto

- Dont

- DOT

- giù

- spinto

- guida

- durata

- durante

- dinamico

- dinamicamente

- ogni

- In precedenza

- Presto

- facile

- in maniera efficace

- efficienza

- efficiente

- in modo efficiente

- sforzo

- sforzi

- o

- enable

- Abilita

- fine

- da un capo all'altro

- Migliora

- garantire

- Impresa

- Ambiente

- errori

- stabilire

- valutare

- valutazione

- Anche

- Ogni

- esaminare

- esempio

- coinvolgenti

- attenderti

- previsto

- esperienza

- esperimento

- esperimenti

- espressamente

- esplorazione

- esplora

- Esplorazione

- Esplorare

- esprimere

- espressione

- esterno

- estratto

- f1

- facilita

- familiare

- Familiarità

- famiglia

- lontano

- FAST

- più veloce

- preferito

- caratteristica

- Caratteristiche

- feedback

- sentire

- pochi

- Compila il

- File

- Infine

- finanziario

- servizi finanziari

- Trovare

- ricerca

- trova

- Nome

- in forma

- fitness

- Flessibilità

- Focus

- messa a fuoco

- seguito

- i seguenti

- cibo

- Nel

- foresta

- essere trovato

- quattro

- Contesto

- quadri

- Gratis

- da

- pieno

- completamente

- function

- funzionalità

- ulteriormente

- futuro

- valutare

- Generale

- generalmente

- generato

- generativo

- AI generativa

- Germania

- ottenere

- GitHub

- Dare

- dà

- scopo

- buono

- grafico

- molto

- Griglia

- guida

- guida

- cura

- maniglia

- a portata di mano

- Hardware

- Avere

- he

- pesante

- sollevamento pesante

- Aiuto

- utile

- aiuta

- suo

- qui

- Alte prestazioni

- superiore

- massimo

- massimo grado

- Evidenziato

- evidenzia

- il suo

- storia

- Colpire

- sperando

- Come

- Tutorial

- Tuttavia

- HTML

- http

- HTTPS

- Enorme

- Ottimizzazione dell'iperparametro

- Sintonia iperparametro

- i

- idea

- identificato

- identificare

- if

- Immagine

- Riconoscimento dell'immagine

- immagini

- Impact

- di forte impatto

- realizzare

- implementazione

- importare

- importante

- competenze

- migliorata

- miglioramento

- in

- inclusi

- Compreso

- Aumenta

- infatti

- indipendentemente

- indica

- individuale

- industrie

- industria

- influenza

- far sapere

- informazioni

- Infrastruttura

- inizialmente

- avviare

- iniziati

- interno

- intuizioni

- esempio

- assicurazione

- interattivo

- interessato

- interessante

- interpretazione

- ai miglioramenti

- invitare

- sicurezza

- IT

- SUO

- Lavoro

- Offerte di lavoro

- viaggio

- ad appena

- mantenere

- conservazione

- Le

- Genere

- Sapere

- conoscenze

- conosciuto

- per il tuo brand

- grandi

- superiore, se assunto singolarmente.

- Cognome

- dopo

- portare

- Leads

- IMPARARE

- imparato

- apprendimento

- Lasciare

- a sinistra

- meno

- lasciare

- Consente di

- biblioteche

- Biblioteca

- Bugia

- ciclo di vita

- di sollevamento

- piace

- probabile

- LIMITE

- limiti

- linea

- Linee

- caricare

- a livello locale

- collocato

- ceppo

- Guarda

- una

- guardò

- SEMBRA

- Basso

- macchina

- machine learning

- fatto

- mantenere

- maggiore

- Maggioranza

- make

- FA

- gestito

- gestione

- gestisce

- gestione

- modo

- molti

- segnato

- corrispondenza

- Importanza

- massimalista

- Massimizzare

- massimo

- Maggio..

- si intende

- Meetups

- mentale

- menzionato

- metodo

- metrico

- Metrica

- forza

- ML

- modello

- modelli

- modificare

- Monitorare

- Scopri di più

- più efficiente

- maggior parte

- Più popolare

- soprattutto

- cambiano

- multiplo

- devono obbligatoriamente:

- my

- Nome

- Natura

- necessariamente

- necessaria

- Bisogno

- di applicazione

- esigenze

- New

- notizie

- GENERAZIONE

- no

- taccuino

- adesso

- numero

- numeri

- oggetto

- obiettivo

- osservare

- of

- Offerte

- di frequente

- on

- una volta

- ONE

- quelli

- esclusivamente

- aprire

- operativo

- sistema operativo

- ottimale

- ottimizzazione

- OTTIMIZZA

- ottimizzazione

- Opzione

- Opzioni

- or

- Arancio

- Altro

- Altri

- altrimenti

- nostro

- su

- risultati

- produzione

- al di fuori

- ancora

- complessivo

- panoramica

- proprio

- pacchetto

- panda

- Parallel

- parametro

- parametri

- parte

- particolare

- passare

- Di passaggio

- sentiero

- per

- Eseguire

- performance

- esecuzione

- esegue

- prospettiva

- pixel

- previsto

- Platone

- Platone Data Intelligence

- PlatoneDati

- per favore

- punti

- povero

- Popolare

- possibile

- Post

- potenziale

- pratica

- pre

- Precisione

- previsto

- Preparare

- piuttosto

- precedente

- in precedenza

- Direttore

- probabilmente

- Problema

- processi

- produrre

- Prodotto

- Programmazione

- Progressi

- progetti

- promettente

- fornire

- purché

- fornisce

- fornitura

- fornitura

- scopo

- fini

- metti

- Python

- pytorch

- quantitativo

- Domande

- Presto

- rapidamente

- abbastanza

- R

- casuale

- casualità

- gamma

- gamme

- tasso

- piuttosto

- Leggi

- Lettura

- mondo reale

- motivi

- ricapitolare

- riconoscimento

- riconoscere

- raccomandare

- raccomandato

- riferimento

- riferimento

- riferimento

- si riferisce

- raffinare

- riflette

- regex

- Basic

- relativamente

- pertinente

- rimuovere

- deposito

- rappresentato

- rappresenta

- necessario

- Requisiti

- richiede

- risorsa

- Risorse

- rispettivamente

- colpevole

- Risultati

- ritorno

- recensioni

- rivedere

- gratificante

- Ricco

- destra

- approssimativamente

- tondo

- round

- Correre

- running

- corre

- sicura

- sagemaker

- Sintonizzazione automatica del modello SageMaker

- sake

- stesso

- scalabile

- Scala

- scala

- scenario

- programma

- Scienze

- scikit-impara

- Punto

- graffiare

- copione

- senza soluzione di continuità

- Cerca

- Secondo

- Sezione

- sezioni

- vedere

- vedendo

- sembra

- visto

- selezionato

- prodotti

- anziano

- senso

- delicata

- inviato

- separato

- Serie

- servizio

- Servizi

- Sessione

- set

- Set

- regolazione

- lei

- Corti

- mostrare attraverso le sue creazioni

- ha mostrato

- mostrato

- Spettacoli

- lato

- significativa

- significativamente

- simile

- Un'espansione

- semplicemente

- singolo

- Taglia

- più intelligente

- So

- finora

- Software

- soluzione

- Soluzioni

- RISOLVERE

- alcuni

- Suono

- Fonte

- codice sorgente

- lo spazio

- specifico

- specificato

- Spin

- Spot

- Stage

- Standard

- inizia a

- iniziato

- inizio

- dichiarazioni

- statico

- step

- Passi

- sosta

- Interrompe

- conservazione

- memorizzati

- lineare

- strategie

- Strategia

- ruscello

- snellire

- forza

- Rafforza

- strutture

- studio

- successivo

- tale

- suggerire

- adatto

- SOMMARIO

- fornitura

- supportato

- supporti

- sicuro

- Interruttore

- sintassi

- sistema

- tavolo

- Fai

- prende

- Target

- Task

- task

- tecniche

- dire

- tensorflow

- test

- testato

- di

- Grazie

- che

- I

- loro

- Li

- poi

- Là.

- perciò

- Strumenti Bowman per analizzare le seguenti finiture:

- di

- cosa

- questo

- quelli

- tre

- Attraverso

- Lancio

- tempo

- volte

- a

- insieme

- top

- Argomenti

- verso

- pista

- Treni

- allenato

- Training

- forma

- trasferimento

- tradurre

- Trend

- prova

- studi clinici

- vero

- prova

- sintonizzare

- sintonia

- TURNO

- si

- seconda

- Digitare

- tipico

- tipicamente

- per

- sottostante

- capire

- e una comprensione reciproca

- non desiderato

- aggiornato

- us

- uso

- caso d'uso

- utilizzato

- Utente

- Esperienza da Utente

- usa

- utilizzando

- utilizzati

- convalida

- APPREZZIAMO

- Valori

- varietà

- vario

- variando

- versione

- molto

- via

- Visualizza

- visualizzazione

- visualizzazione

- visualizzare

- visivamente

- vs

- camminare

- volere

- caldo

- Prima

- Rifiuto

- Modo..

- modi

- we

- sito web

- servizi web

- WELL

- sono stati

- Che

- quando

- se

- quale

- while

- OMS

- perché

- moglie

- volere

- desiderio

- con

- entro

- parole

- Lavora

- lavoro

- lavorazioni

- lavori

- utile

- sarebbe

- XGBoost

- ancora

- dare la precedenza

- Tu

- Trasferimento da aeroporto a Sharm

- te stesso

- zefiro

- zoom