Le GPU sono uno strumento potente per i carichi di lavoro di apprendimento automatico, anche se non sono necessariamente lo strumento giusto per ogni lavoro di intelligenza artificiale, secondo Michael Bronstein, responsabile della ricerca sull'apprendimento dei grafici di Twitter.

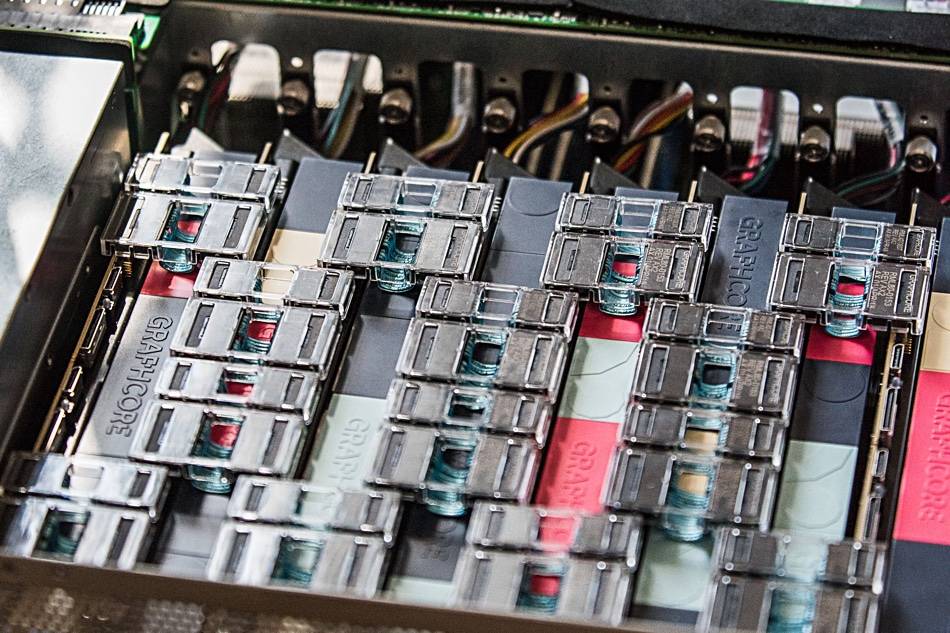

Il suo team ha recentemente mostrato che l'hardware AI di Graphcore offriva un "aumento dell'ordine di grandezza quando si confrontava un singolo processore IPU con una GPU Nvidia A100", nei modelli TGN (temporal Graph Network).

"La scelta dell'hardware per l'implementazione dei modelli Graph ML è un problema cruciale, ma spesso trascurato", si legge a articolo comune scritto da Bronstein con Emanuele Rossi, ricercatore ML di Twitter, e Daniel Justus, ricercatore di Graphcore.

Le reti neurali a grafo offrono un mezzo per trovare l'ordine nei sistemi complessi e sono comunemente utilizzate nei social network e nei sistemi di raccomandazione. Tuttavia, la natura dinamica di questi ambienti rende questi modelli particolarmente difficili da addestrare, ha spiegato il trio.

Il gruppo ha studiato la fattibilità delle IPU di Graphcore nella gestione di diversi modelli TGN. Il test iniziale è stato eseguito su un piccolo modello TGN basato su JODIE Set di dati di Wikipedia che collega gli utenti alle modifiche apportate alle pagine. Il grafico era composto da 8,227 utenti e 1,000 articoli per un totale di 9,227 nodi. JODIE è un sistema di previsione open source progettato per dare un senso alle reti di interazione temporale.

La sperimentazione del trio ha rivelato che lotti di grandi dimensioni hanno comportato una convalida ridotta e una precisione di inferenza, rispetto a lotti di dimensioni inferiori.

"La memoria del nodo e la connettività del grafico vengono entrambe aggiornate solo dopo l'elaborazione di un batch completo", ha scritto il trio. "Pertanto, gli eventi successivi all'interno di un batch possono basarsi su informazioni obsolete poiché non sono a conoscenza di eventi precedenti".

Tuttavia, utilizzando una dimensione batch di 10, il gruppo è stato in grado di ottenere una convalida e una precisione di inferenza ottimali, ma notano che le prestazioni sull'IPU erano comunque superiori a quelle di una GPU, anche quando si utilizzavano batch di grandi dimensioni.

"Quando si utilizza un lato batch di 10, il TGN può essere addestrato sull'IPU circa 11 volte più velocemente e, anche con un batch di grandi dimensioni di 200, l'addestramento è ancora tre volte più veloce sull'IPU", si legge nel post. "Durante tutte le operazioni, l'IPU gestisce lotti di piccole dimensioni in modo più efficiente".

Il team ipotizza che l'accesso veloce alla memoria e l'elevato throughput offerti dalla grande cache SRAM interna del processore di Graphcore abbiano dato un vantaggio all'IPU.

Questo vantaggio in termini di prestazioni si estendeva anche ai modelli grafici che superavano la memoria interna del processore dell'IPU (ogni IPU dispone di una cache SRAM da 1 GB) che richiedono l'uso di una memoria DRAM più lenta collegata ai chip.

Nel test su un modello grafico composto da 261 milioni di follower tra 15.5 milioni di utenti Twitter, l'uso della DRAM per la memoria del nodo ha ridotto il throughput di un fattore due, ha scoperto il team di Bronstein.

Tuttavia, quando ha indotto diversi sottografici basati su un set di dati sintetico 10 volte la dimensione del grafico di Twitter, il team ha riscontrato che il throughput è scalato indipendentemente dalle dimensioni del grafico. In altre parole, il calo delle prestazioni è stato il risultato dell'utilizzo di una memoria più lenta e non il risultato delle dimensioni del modello.

"Utilizzando questa tecnica sull'IPU, TGN può essere applicato a dimensioni del grafico quasi arbitrarie, limitate solo dalla quantità di memoria host disponibile pur mantenendo un throughput molto elevato durante l'addestramento e l'inferenza", si legge nell'articolo.

Il team ha concluso che l'architettura IPU di Graphcore mostra un vantaggio significativo rispetto alle GPU nei carichi di lavoro in cui elaborazione e accesso alla memoria sono eterogenei.

Tuttavia, il punto più ampio è che i ricercatori ML dovrebbero considerare attentamente la loro scelta di hardware e non dovrebbero utilizzare le GPU per impostazione predefinita.

"La disponibilità di servizi di cloud computing che astraggono l'hardware sottostante porta a una certa pigrizia al riguardo", ha scritto il trio. "Ci auguriamo che il nostro studio attiri maggiore attenzione su questo importante argomento e apra la strada a futuri algoritmi e architetture hardware più efficienti per le applicazioni Graph ML". ®

- AI

- oh arte

- generatore d'arte

- un robot

- intelligenza artificiale

- certificazione di intelligenza artificiale

- intelligenza artificiale nel settore bancario

- robot di intelligenza artificiale

- robot di intelligenza artificiale

- software di intelligenza artificiale

- blockchain

- conferenza blockchain ai

- geniale

- intelligenza artificiale conversazionale

- criptoconferenza ai

- dall's

- apprendimento profondo

- google ai

- machine learning

- Platone

- platone ai

- Platone Data Intelligence

- Gioco di Platone

- PlatoneDati

- gioco di plato

- scala ai

- sintassi

- Il registro

- zefiro