בפוסט זה, אנו מדגימים כיצד Kubeflow ב-AWS (הפצה ספציפית ל-AWS של Kubeflow) בשימוש עם מיכלי למידה עמוקה של AWS ו מערכת הקבצים של אמזון אלסטית (Amazon EFS) מפשט את שיתוף הפעולה ומספק גמישות בהכשרת מודלים של למידה עמוקה בקנה מידה בשניהם שירות קוברנט של אמזון (אמזון EKS) ו אמזון SageMaker תוך שימוש בגישת ארכיטקטורה היברידית.

פיתוח למידת מכונה (ML) מסתמך על מסגרות וערכות כלים של קוד פתוח מורכבות ומתפתחות, כמו גם מערכות אקולוגיות מורכבות ומתפתחות ברציפות. זה מציב אתגר בעת הרחבת פיתוח ML לאשכול. קונטיינרים מציעים פתרון, מכיוון שהם יכולים לקלוט באופן מלא לא רק את קוד ההדרכה, אלא את כל ערימת התלות עד לספריות החומרה. זה מבטיח סביבת ML שהיא עקבית וניידת, ומאפשרת שחזור של סביבת האימון בכל צומת אינדיבידואלי של אשכול האימונים.

Kubernetes היא מערכת מאומצת נרחבת לאוטומציה של פריסת תשתית, קנה מידה של משאבים וניהול של יישומים אלה. עם זאת, Kubernetes לא נבנה עם מחשבה על ML, כך שהיא יכולה להרגיש מנוגדת לאינטואיציה עבור מדעני נתונים בשל הסתמכותה הרבה על קבצי מפרט YAML. אין חווית Jupyter, ואין הרבה יכולות ספציפיות ל-ML, כמו ניהול זרימת עבודה וצינורות, ויכולות אחרות שמומחי ML מצפים להן, כמו כוונון היפרפרמטרים, אירוח מודלים ואחרות. אפשר לבנות יכולות כאלה, אבל Kubernetes לא תוכנן לעשות זאת בתור היעד העיקרי שלה.

קהילת הקוד הפתוח שמה לב ופיתחה שכבה על גבי Kubernetes בשם Kubeflow. Kubeflow שואפת להפוך את הפריסה של זרימות עבודה ML מקצה לקצה ב-Kubernetes לפשוטה, ניידת וניתנת להרחבה. אתה יכול להשתמש ב-Kubeflow כדי לפרוס מערכות קוד פתוח מהסוג הטוב ביותר עבור ML לתשתיות מגוונות.

Kubeflow ו-Kubernetes מספקים גמישות ובקרה לצוותי מדעני נתונים. עם זאת, הבטחת ניצול גבוה של אשכולות אימונים הפועלים בקנה מידה עם תקורה תפעולית מופחתת עדיין מאתגרת.

פוסט זה מדגים כיצד לקוחות שיש להם הגבלות מקומיות או השקעות קיימות של Kubernetes יכולים להתמודד עם אתגר זה באמצעות Amazon EKS ו-Kubeflow ב-AWS כדי ליישם צינור ML להדרכה מבוזרת המבוססת על גישה בניהול עצמי, ולהשתמש ב-SageMaker המנוהל במלואו עבור תשתית הדרכה מותאמת לעלות, מנוהלת במלואה ובקנה מידה ייצור. זה כולל יישום שלב אחר שלב של ארכיטקטורת אימון מבוזרת היברידית המאפשרת לך לבחור בין שתי הגישות בזמן ריצה, ומעניקה שליטה וגמישות מירבית עם צרכים מחמירים לפריסות שלך. אתה תראה איך אתה יכול להמשיך להשתמש בספריות קוד פתוח בסקריפט האימון ללמידה עמוקה שלך ועדיין להפוך אותו לתואם להפעלה הן על Kubernetes והן על SageMaker בצורה אגנוסטית לפלטפורמה.

איך Kubeflow ב-AWS ו- SageMaker עוזרים?

מודלים של רשתות עצביות שנבנו עם מסגרות למידה עמוקה כמו TensorFlow, PyTorch, MXNet ואחרות מספקים דיוק הרבה יותר גבוה על ידי שימוש במערכי נתונים גדולים משמעותית של הדרכה, במיוחד במקרים של שימוש בראייה ממוחשבת ועיבוד שפה טבעית. עם זאת, עם מערכי אימון גדולים, לוקח יותר זמן לאמן את מודלים של למידה עמוקה, מה שבסופו של דבר מאט את זמן היציאה לשוק. אם נוכל להרחיב אשכול ולהפחית את זמן ההכשרה של המודל משבועות לימים או שעות, עשויה להיות לכך השפעה עצומה על הפרודוקטיביות והמהירות העסקית.

Amazon EKS עוזרת לספק את מטוס הבקרה המנוהל של Kubernetes. אתה יכול להשתמש ב-Amazon EKS כדי ליצור אשכולות הדרכה בקנה מידה גדול עם מופעי CPU ו-GPU ולהשתמש בערכת הכלים של Kubeflow כדי לספק כלים ידידותיים ל-ML, קוד פתוח ולהפעיל זרימות עבודה ML ניידות וניתנות להרחבה באמצעות Kubeflow Pipelines כדי לשפר את הפרודוקטיביות של הצוות שלך לצמצם את זמן היציאה לשוק.

עם זאת, יכולים להיות כמה אתגרים עם גישה זו:

- הבטחת ניצול מקסימלי של אשכול בין צוותי מדעי הנתונים. לדוגמה, עליך לספק מופעי GPU על פי דרישה ולהבטיח ניצול גבוה שלו למשימות תובעניות בקנה מידה ייצור כגון אימון למידה עמוקה, ולהשתמש במופעי CPU עבור המשימות הפחות תובעניות כגון עיבוד מקדים של נתונים

- הבטחת זמינות גבוהה של רכיבי תשתית Kubeflow כבדי משקל, כולל מסד נתונים, אחסון ואימות, שנפרסים בצומת העבודה של אשכול Kubernetes. לדוגמה, מישור הבקרה של Kubeflow מייצר חפצים (כגון מופעי MySQL, יומני תרמילים או אחסון MinIO) שגדלים עם הזמן וזקוקים לנפחי אחסון הניתנים לשינוי גודל עם יכולות ניטור רציפות.

- שיתוף מערך ההדרכה, הקוד וסביבות המחשוב בין מפתחים, אשכולות הדרכה ופרויקטים הוא מאתגר. לדוגמה, אם אתה עובד על סט ספריות משלך ולספריות האלה יש תלות הדדית חזקה, זה נהיה ממש קשה לשתף ולהריץ את אותה פיסת קוד בין מדעני נתונים באותו צוות. כמו כן, כל ריצת אימון מחייבת אותך להוריד את מערך ההדרכה ולבנות את תמונת האימון עם שינויי קוד חדשים.

Kubeflow ב-AWS עוזר להתמודד עם אתגרים אלה ומספק מוצר Kubeflow מנוהל למחצה ברמה ארגונית. עם Kubeflow ב-AWS, אתה יכול להחליף חלק משירותי מטוסי הבקרה של Kubeflow כמו מסד נתונים, אחסון, ניטור וניהול משתמשים בשירותים מנוהלים של AWS כמו שירות מסדי נתונים יחסי של אמזון (Amazon RDS), שירות אחסון פשוט של אמזון (אמזון S3), מערכת הקבצים של אמזון אלסטית (EFS של אמזון), אמזון FSx, אמזון CloudWatch, ו אמזון קוגניטו.

החלפת רכיבי Kubeflow אלו מנתקת חלקים קריטיים במישור הבקרה של Kubeflow מ-Kubernetes, ומספקת עיצוב מאובטח, ניתן להרחבה, גמיש ומוטב עלות. גישה זו גם משחררת משאבי אחסון ומחשוב ממישור הנתונים של EKS, אשר עשויים להידרש על ידי יישומים כגון הדרכת מודלים מבוזרים או שרתי מחברת משתמשים. Kubeflow ב-AWS מספקת גם אינטגרציה מקורית של מחברות Jupyter עם תמונות Deep Learning Container (DLC), שארוזות מראש ומוגדרות מראש עם מסגרות למידה עמוקה מותאמות ל-AWS כגון PyTorch ו-TensorFlow המאפשרות לך להתחיל לכתוב את קוד האימון שלך מיד בלי להתעסק. עם החלטות תלות ואופטימיזציות של מסגרת. כמו כן, אינטגרציה של Amazon EFS עם אשכולות הדרכה וסביבת הפיתוח מאפשרת לך לשתף את הקוד ואת מערך ההדרכה המעובד שלך, מה שנמנע מבניית תמונת המיכל וטעינת מערכי נתונים ענקיים לאחר כל שינוי קוד. האינטגרציות הללו עם Kubeflow ב-AWS עוזרות לך להאיץ את זמן בניית המודל וההדרכה ומאפשרות שיתוף פעולה טוב יותר עם שיתוף נתונים וקוד קל יותר.

Kubeflow ב-AWS עוזר לבנות פלטפורמת ML זמינה וחזקה במיוחד. פלטפורמה זו מספקת גמישות לבנות ולהכשיר מודלים של למידה עמוקה ומספקת גישה לערכות כלים רבות בקוד פתוח, תובנות על יומנים וניפוי באגים אינטראקטיבי לצורך ניסויים. עם זאת, השגת ניצול מקסימלי של משאבי תשתית תוך אימון מודלים של למידה עמוקה על מאות GPUs עדיין כרוכה בהרבה תקורה תפעולית. ניתן לטפל בכך על ידי שימוש ב- SageMaker, שהוא שירות מנוהל במלואו שתוכנן ומותאם לטיפול באשכולות הדרכה ביצועיים ומותאמים לעלות המוענקים רק כאשר מתבקשים, מותאמים לפי הצורך, ונסגרים אוטומטית עם סיום העבודות, ובכך מספקים קרוב ל-100 % ניצול משאבים. אתה יכול לשלב את SageMaker עם Kubeflow Pipelines באמצעות רכיבי SageMaker מנוהלים. זה מאפשר לך להפעיל תהליכי עבודה של ML כחלק מצינורות Kubeflow, שבהם תוכל להשתמש ב-Kubernetes להדרכה מקומית וב-SageMaker להדרכה בקנה מידה של מוצר בארכיטקטורה היברידית.

סקירת פתרונות

הארכיטקטורה הבאה מתארת כיצד אנו משתמשים ב-Kubeflow Pipelines כדי לבנות ולפרוס זרימות עבודה ML ניידות ומדרגיות מקצה לקצה כדי להפעיל הדרכה מבוזרת על תנאי על Kubernetes באמצעות אימון Kubeflow או SageMaker בהתבסס על פרמטר זמן הריצה.

אימון Kubeflow הוא קבוצה של מפעילי Kubernetes המוסיפים ל-Kubeflow את התמיכה בהדרכה מבוזרת של מודלים של ML באמצעות מסגרות שונות כמו TensorFlow, PyTorch ואחרות. pytorch-operator הוא יישום Kubeflow של Kubernetes משאב מותאם אישית (PyTorchJob) להפעלת משרות הדרכה מבוזרות של PyTorch ב-Kubernetes.

אנו משתמשים ברכיב PyTorchJob Launcher כחלק מצינור Kubeflow כדי להפעיל אימון מבוזר של PyTorch במהלך שלב הניסויים כאשר אנו זקוקים לגמישות וגישה לכל המשאבים הבסיסיים עבור ניפוי באגים וניתוח אינטראקטיביים.

אנו משתמשים גם ברכיבי SageMaker עבור Kubeflow Pipelines כדי להפעיל את הדרכת המודלים שלנו בקנה מידה ייצור. זה מאפשר לנו לנצל את היתרונות של תכונות SageMaker חזקות כגון שירותים מנוהלים במלואם, עבודות הדרכה מבוזרות עם ניצול מקסימלי של GPU והדרכה חסכונית באמצעות ענן מחשוב אלסטי של אמזון (Amazon EC2) מקרי ספוט.

כחלק מתהליך יצירת זרימת העבודה, אתה משלים את השלבים הבאים (כפי שמוצג בתרשים הקודם) כדי ליצור צינור זה:

- השתמש בקובץ המניפסט של Kubeflow כדי ליצור לוח מחוונים של Kubeflow ולגשת למחברות Jupyter מלוח המחוונים המרכזי של Kubeflow.

- השתמש ב-Kubeflow pipeline SDK כדי ליצור ולהרכיב צינורות של Kubeflow באמצעות קוד Python. הידור Pipeline ממירה את פונקציית Python למשאב זרימת עבודה, שהוא פורמט YAML תואם Argo.

- השתמש בלקוח Kubeflow Pipelines SDK כדי לקרוא לנקודת הקצה של שירות הצינור כדי להפעיל את הצינור.

- הצינור מעריך את משתני זמן הריצה המותנים ומחליט בין SageMaker או Kubernetes כסביבת הריצה היעד.

- השתמש ברכיב Kubeflow PyTorch Launcher כדי להפעיל הדרכה מבוזרת בסביבת Kubernetes המקורית, או השתמש ברכיב SageMaker כדי להגיש את ההדרכה בפלטפורמה המנוהלת של SageMaker.

האיור הבא מציג את רכיבי Kubeflow Pipelines המעורבים בארכיטקטורה המעניקים לנו את הגמישות לבחור בין סביבות מבוזרות של Kubernetes או SageMaker.

השתמש ב-Case Workflow

אנו משתמשים בגישה שלב אחר שלב הבאה כדי להתקין ולהפעיל את מקרה השימוש להדרכה מבוזרת באמצעות Amazon EKS ו- SageMaker באמצעות Kubeflow ב-AWS.

תנאים מוקדמים

לפריצת דרך זו, יהיו עליכם התנאים המוקדמים הבאים:

- An חשבון AWS.

- מכונה עם Docker ו- ממשק שורת הפקודה של AWS (AWS CLI) מותקן.

- לחלופין, אתה יכול להשתמש AWS Cloud9, סביבת פיתוח משולבת מבוססת ענן (IDE) המאפשרת השלמת כל העבודה מדפדפן האינטרנט שלך. להוראות התקנה, עיין ב הגדר את Cloud9 IDE. מסביבת Cloud9 שלך, בחר את סימן הפלוס ופתח מסוף חדש.

- צור תפקיד עם השם

sagemakerrole. הוסף מדיניות מנוהלתAmazonSageMakerFullAccessוAmazonS3FullAccessכדי לתת ל-SageMaker גישה לדלי S3. תפקיד זה משמש את עבודת SageMaker שנשלחה כחלק משלב Kubeflow Pipelines. - ודא שבחשבון שלך יש מגבלת סוג משאב של SageMaker Training

ml.p3.2xlargeגדל ל-2 באמצעות קונסולת מכסות שירות

1. התקן את Amazon EKS ו-Kubeflow ב-AWS

אתה יכול להשתמש במספר גישות שונות כדי לבנות אשכול Kubernetes ולפרוס את Kubeflow. בפוסט זה, אנו מתמקדים בגישה שאנו מאמינים שמביאה פשטות לתהליך. ראשית, אנו יוצרים אשכול EKS, ואז אנו פורסים בו את Kubeflow ב-AWS v1.5. עבור כל אחת מהמשימות הללו, אנו משתמשים בפרויקט קוד פתוח תואם העוקב אחר עקרונות ה- עשה מסגרת. במקום להתקין סט תנאים מוקדמים לכל משימה, אנו בונים קונטיינרים של Docker שיש להם את כל הכלים הדרושים ומבצעים את המשימות מתוך הקונטיינרים.

אנו משתמשים ב-Do Framework בפוסט זה, אשר הופכת את פריסת Kubeflow לאוטומטית עם Amazon EFS כתוסף. לאפשרויות הפריסה הרשמיות של Kubeflow על AWS עבור פריסות ייצור, עיין ב פְּרִיסָה.

הגדר את ספריית העבודה הנוכחית ואת AWS CLI

אנו מגדירים ספריית עבודה כך שנוכל להתייחס אליה כנקודת ההתחלה לשלבים הבאים:

אנו גם מגדירים פרופיל AWS CLI. לשם כך, אתה צריך מזהה מפתח גישה ומפתח גישה סודי של AWS זהות וניהול גישה (אני) המשתמש חשבון עם הרשאות ניהול (צרף את המדיניות המנוהלת הקיימת) וגישה פרוגרמטית. ראה את הקוד הבא:

1.1 צור אשכול EKS

אם כבר יש לך אשכול EKS זמין, תוכל לדלג לסעיף הבא. עבור פוסט זה, אנו משתמשים ב- פרויקט aws-do-eks כדי ליצור את האשכול שלנו.

- תחילה שכפל את הפרויקט בספריית העבודה שלך

- לאחר מכן בנה והפעל את

aws-do-eksמְכוֹלָה:השמיים

build.shscript יוצר תמונת קונטיינר של Docker הכוללת את כל הכלים והסקריפטים הדרושים להקצאה ותפעול של אשכולות EKS. הrun.shscript מתחיל קונטיינר באמצעות תמונת Docker שנוצרה ושומר אותו כך שנוכל להשתמש בו כסביבת ניהול ה-EKS שלנו. כדי לראות את הסטטוס שלךaws-do-eksמיכל, אתה יכול לרוץ./status.sh. אם המיכל נמצא במצב יציאה, אתה יכול להשתמש ב-./start.shסקריפט כדי להעלות את המיכל, או כדי להפעיל מחדש את המיכל, אתה יכול להפעיל./stop.shאחריו./run.sh. - פתח מעטפת בריצה

aws-do-eksמְכוֹלָה: - כדי לסקור את תצורת אשכול EKS עבור פריסת KubeFlow שלנו, הפעל את הפקודה הבאה:

כברירת מחדל, תצורה זו יוצרת אשכול בשם

eks-kubeflowבus-west-2אזור עם שישה צמתים m5.xlarge. כמו כן, הצפנת נפחי EBS אינה מופעלת כברירת מחדל. אתה יכול להפעיל אותו על ידי הוספה"volumeEncrypted: true"לקבוצת הצמתים והיא תצפין באמצעות מפתח ברירת המחדל. שנה הגדרות תצורות אחרות במידת הצורך. - כדי ליצור את האשכול, הפעל את הפקודה הבאה:

תהליך הקצאת האשכולות עשוי להימשך עד 30 דקות.

- כדי לוודא שהאשכול נוצר בהצלחה, הפעל את הפקודה הבאה:

הפלט מהפקודה הקודמת עבור אשכול שנוצר בהצלחה נראה כמו הקוד הבא:

צור נפח EFS עבור עבודת ההדרכה של SageMaker

במקרה השימוש הזה, אתה מאיץ את עבודת האימון של SageMaker על ידי אימון מודלים של למידה עמוקה מנתונים שכבר מאוחסנים באמזון EFS. לבחירה זו יש את היתרון של השקה ישירה של עבודות ההדרכה שלך מהנתונים באמזון EFS ללא צורך בהעברת נתונים, וכתוצאה מכך זמני התחלה מהירים יותר של האימון.

אנו יוצרים אמצעי אחסון EFS ופורסים את מנהל ההתקן של EFS Container Storage Interface (CSI). זה מושג על ידי סקריפט פריסה שנמצא ב /eks/deployment/csi/efs בתוך aws-do-eks מיכל.

סקריפט זה מניח שיש לך אשכול EKS אחד בחשבון שלך. מַעֲרֶכֶת CLUSTER_NAME= במקרה שיש לך יותר מאשכול EKS אחד.

סקריפט זה מספק אמצעי אחסון EFS ויוצר יעדי הרכבה עבור רשתות המשנה של ה-VPC של האשכול. לאחר מכן הוא פורס את מנהל ההתקן של EFS CSI ויוצר את efs-sc כיתת אחסון ו efs-pv נפח מתמשך באשכול EKS.

לאחר סיום מוצלח של הסקריפט, אתה אמור לראות פלט כמו הבא:

צור נקודת קצה של Amazon S3 VPC

אתה משתמש ב-VPC פרטי שלעבודת ההדרכה של SageMaker ולמערכת הקבצים של EFS יש גישה אליו. כדי לתת לאשכול ההדרכה של SageMaker גישה לדלי S3 מה-VPC הפרטי שלך, אתה יוצר נקודת קצה VPC:

כעת תוכל לצאת מ- aws-do-eks מעטפת מיכל והמשך לסעיף הבא:

1.2 פרוס את Kubeflow ב-AWS ב- Amazon EKS

כדי לפרוס את Kubeflow ב- Amazon EKS, אנו משתמשים ב- פרויקט aws-do-kubeflow.

- שכפל את המאגר באמצעות הפקודות הבאות:

- לאחר מכן הגדר את הפרויקט:

סקריפט זה פותח את קובץ תצורת הפרויקט בעורך טקסט. זה חשוב עבור AWS_REGION כדי להיות מוגדר לאזור שבו נמצא האשכול שלך, כמו גם AWS_CLUSTER_NAME כדי להתאים לשם של האשכול שיצרת קודם לכן. כברירת מחדל, התצורה שלך כבר מוגדרת כראוי, אז אם אינך צריך לבצע שינויים, פשוט סגור את העורך.

השמיים

build.shסקריפט יוצר תמונת קונטיינר של Docker הכוללת את כל הכלים הדרושים לפריסה וניהול של Kubeflow באשכול Kubernetes קיים. הrun.shסקריפט מתחיל קונטיינר, באמצעות תמונת Docker, והסקריפט exec.sh פותח מעטפת פקודה לתוך הקונטיינר, שבה נוכל להשתמש כסביבת ניהול Kubeflow שלנו. אתה יכול להשתמש ב./status.shסקריפט כדי לראות אםaws-do-kubeflowהמכולה פועלת וה./stop.shו./run.shסקריפטים כדי להפעיל אותו מחדש לפי הצורך. - אחרי שנפתחת מעטפת ב

aws-do-eksמכיל, אתה יכול לוודא שהקשר האשכול שהוגדר הוא כצפוי: - כדי לפרוס את Kubeflow באשכול EKS, הפעל את

deploy.shתַסרִיט:הפריסה מוצלחת כאשר כל הפודים במרחב השמות של kubeflow נכנסים למצב Running. פלט טיפוסי נראה כמו הקוד הבא:

- כדי לעקוב אחר מצב הפודים של KubeFlow, בחלון נפרד, תוכל להשתמש בפקודה הבאה:

- חדשות ועדכונים Ctrl + C כאשר כל התרמילים פועלים, לאחר מכן חשוף את לוח המחוונים של Kubeflow מחוץ לאשכול על ידי הפעלת הפקודה הבאה:

אתה אמור לראות פלט שנראה כמו הקוד הבא:

פקודה זו מעבירה את שירות שער הכניסה של Istio מהאשכול שלך ליציאה המקומית 8080. כדי לגשת ללוח המחוונים של Kubeflow, בקר בכתובת http://localhost:8080 והיכנס באמצעות ברירת המחדל של אישורי המשתמש (user@example.com/12341234). אם אתה מפעיל את aws-do-kubeflow מיכל ב-AWS Cloud9, אז אתה יכול לבחור תצוגה מקדימה, ואז לבחור תצוגה מקדימה של יישום. אם אתה פועל על Docker Desktop, ייתכן שתצטרך להפעיל את ./kubeflow-expose.sh תסריט מחוץ ל aws-do-kubeflow מיכל.

2. הגדר את סביבת Kubeflow ב-AWS

כדי להגדיר את סביבת Kubeflow ב-AWS, אנו יוצרים אמצעי אחסון EFS ומחברת Jupyter.

2.1 צור אמצעי אחסון EFS

כדי ליצור אמצעי אחסון EFS, בצע את השלבים הבאים:

- בלוח המחוונים של Kubeflow, בחר כרכים בחלונית הניווט.

- בחר כרך חדש.

- בעד שם, להיכנס

efs-sc-claim. - בעד גודל נפח, להיכנס

10. - בעד שיעור אחסון, בחר efs-sc.

- בעד מצב גישה, בחר ReadWriteOnce.

- בחרו צור.

2.2 צור מחברת Jupyter

כדי ליצור מחברת חדשה, בצע את השלבים הבאים:

- בלוח המחוונים של Kubeflow, בחר מחברה בחלונית הניווט.

- בחרו מחברת חדשה.

- בעד שם, להיכנס

aws-hybrid-nb. - בעד Jupyter Docket Image, בחר את התמונה

c9e4w0g3/notebook-servers/jupyter-pytorch:1.11.0-cpu-py38-ubuntu20.04-e3-v1.1(תמונת ה-DLC העדכנית ביותר של jupyter-pytorch). - בעד CPU, להיכנס

1. - בעד זכרון, להיכנס

5. - בעד GPUs, השאר כמו ללא חתימה.

- אל תבצע שינויים ב- נפח סביבת עבודה סָעִיף.

- ב נפחי נתונים סעיף, בחר צרף נפח קיים ולהרחיב את קטע נפח קיים

- בעד שם, בחר

efs-sc-claim. - בעד שביל הר, להיכנס

/home/jovyan/efs-sc-claim.

זה מעלה את עוצמת הקול של EFS לתרמיל מחברת Jupyter שלך, ותוכל לראות את התיקיהefs-sc-claimבממשק מעבדת Jupyter שלך. אתה שומר את מערך ההדרכה וקוד ההדרכה בתיקייה זו כדי שאשכולות ההדרכה יוכלו לגשת אליו מבלי צורך לבנות מחדש את תמונות המכולה לצורך בדיקה.

- בחר אפשר גישה ל-Kubeflow Pipelines בסעיף תצורה.

- בחרו לשגר.

ודא שהמחברת שלך נוצרה בהצלחה (זה עשוי לקחת כמה דקות).

- על מחברה עמוד, בחר לְחַבֵּר כדי להיכנס לסביבת JupyterLab.

- על Git בתפריט, בחר שיבוט מאגר.

- בעד שיבוט ריפו, להיכנס

https://github.com/aws-samples/aws-do-kubeflow.

3. הפעל אימון מבוזר

לאחר הגדרת מחברת Jupyter, תוכל להריץ את כל ההדגמה באמצעות השלבים הבאים ברמה הגבוהה מהתיקיה aws-do-kubeflow/workshop במאגר המשובט:

- PyTorch Distributed Data Parallel (DDP) סקריפט אימון: עיין בסקריפט אימון PyTorch DDP cifar10-distributed-gpu-final.py, הכולל דוגמה של רשת עצבית קונבולוציונית והיגיון להפצת הדרכה על מעבד ו-GPU מרובה-צמתים. (ראה 3.1 לפרטים)

- התקן ספריות: הפעל את המחברת

0_initialize_dependencies.ipynbלאתחל את כל התלות. (ראה 3.2 לפרטים) - הפעל הדרכת עבודה מבוזרת של PyTorch ב-Kubernetes: הפעל את המחברת

1_submit_pytorchdist_k8s.ipynbליצור ולשלוח הדרכה מבוזרת על קונטיינרים ראשיים אחד ושני עובדים באמצעות המשאב המותאם אישית של Kubernetes PyTorchJob YAML באמצעות קוד Python. (ראה 3.3 לפרטים) - צור צינור Kubeflow היברידי: הפעל את המחברת

2_create_pipeline_k8s_sagemaker.ipynbליצור את צינור Kubeflow ההיברידי שמפעיל אימון מבוזר ב- SageMaker או Amazon EKS באמצעות משתנה זמן הריצהtraining_runtime. (ראה 3.4 לפרטים)

ודא שהרצת את המחברת 1_submit_pytorchdist_k8s.ipynb לפני שתתחיל את המחברת 2_create_pipeline_k8s_sagemaker.ipynb.

בסעיפים הבאים, נדון בכל אחד מהשלבים הללו בפירוט.

3.1 PyTorch Distributed Data Parallel (DDP) סקריפט אימון

כחלק מההדרכה המבוזרת, אנו מאמנים מודל סיווג שנוצר על ידי רשת עצבית קונבולוציונית פשוטה הפועלת על מערך הנתונים CIFAR10. תסריט האימון cifar10-distributed-gpu-final.py מכיל רק את ספריות הקוד הפתוח ותואם להפעלה הן באשכולות הדרכה של Kubernetes והן של SageMaker על התקני GPU או מופעי CPU. בואו נסתכל על כמה היבטים חשובים של תסריט ההדרכה לפני שנפעיל את דוגמאות המחברת שלנו.

אנו משתמשים torch.distributed מודול, המכיל תמיכה ב- PyTorch ופרימיטיבים לתקשורת עבור מקביליות מרובת תהליכים על פני צמתים באשכול:

אנו יוצרים מודל סיווג תמונה פשוט תוך שימוש בשילוב של שכבות קונבולוציוניות, איסוף מקסימלי וליניאריות שעליהן מיושמת פונקציית הפעלת relu במעבר קדימה של אימון המודל:

אנו משתמשים ב- Torch DataLoader המשלב את מערך הנתונים ו DistributedSampler (טוען תת-קבוצה של נתונים בצורה מבוזרת באמצעות torch.nn.parallel.DistributedDataParallel) ומספק איטרטור של תהליך יחיד או ריבוי תהליכים על הנתונים:

אם לאשכול האימון יש GPUs, הסקריפט מריץ את האימון במכשירי CUDA ומשתנה ההתקן מכיל את מכשיר ברירת המחדל של CUDA:

לפני שאתה מפעיל אימון מבוזר באמצעות PyTorch DistributedDataParallel כדי להפעיל עיבוד מבוזר על מספר צמתים, עליך לאתחל את הסביבה המבוזרת על ידי קריאה init_process_group. זה מאותחל בכל מכונה של אשכול האימונים.

אנו מייצרים את מודל המסווגן ומעתיקים את הדגם למכשיר היעד. אם הדרכה מבוזרת מופעלת על מספר צמתים, ה DistributedDataParallel class משמש כאובייקט עוטף סביב אובייקט הדגם, המאפשר אימון מבוזר סינכרוני על פני מספר מכונות. נתוני הקלט מחולקים על ממד האצווה והעתק של הדגם ממוקם על כל מכונה וכל מכשיר.

3.2 התקנת ספריות

תתקין את כל הספריות הדרושות כדי להפעיל את דוגמה ההדרכה המבוזרת של PyTorch. זה כולל Kubeflow Pipelines SDK, Training Operator Python SDK, Python client for Kubernetes ו- Amazon SageMaker Python SDK.

3.3 הפעל הדרכת עבודה מבוזרת של PyTorch ב-Kubernetes

המחברת 1_submit_pytorchdist_k8s.ipynb יוצר את המשאב המותאם אישית של Kubernetes PyTorchJob YAML באמצעות אימון Kubeflow ו-Kubernetes הלקוח Python SDK. להלן מספר קטעים חשובים ממחברת זו.

אנו יוצרים את PyTorchJob YAML עם המיכלים הראשיים והעובדים כפי שמוצג בקוד הבא:

זה מוגש למטוס הבקרה של Kubernetes באמצעות PyTorchJobClient:

הצג את יומני ההדרכה של Kubernetes

אתה יכול להציג את יומני ההדרכה מאותו מחברת Jupyter באמצעות קוד Python או ממעטפת הלקוח של Kubernetes.

3.4 צור צינור Kubeflow היברידי

המחברת 2_create_pipeline_k8s_sagemaker.ipynb יוצר צינור Kubeflow היברידי המבוסס על משתנה זמן ריצה מותנה training_runtime, כפי שמוצג בקוד הבא. המחברת משתמשת ב- קו צינורות צינורות קובלה והוא מסופק קבוצה של חבילות Python כדי לציין ולהפעיל את צינורות זרימת העבודה של ML. כחלק מ-SDK זה, אנו משתמשים בחבילות הבאות:

- מעצב החבילות לשפה ספציפית לתחום (DSL).

dsl.pipeline, אשר מקשט את פונקציות Python כדי להחזיר צינור - השמיים

dsl.Conditionחבילה, המייצגת קבוצת פעולות המופעלות רק כאשר מתקיים תנאי מסוים, כגון בדיקת הtraining_runtimeערך כsagemakerorkubernetes

ראה את הקוד הבא:

אנו מגדירים אימון מבוזר של SageMaker באמצעות שני מופעים של ml.p3.2xlarge.

לאחר הגדרת הצינור, תוכל להרכיב את הצינור למפרט Argo YAML באמצעות ה-SDK של Kubeflow Pipelines kfp.compiler חֲבִילָה. אתה יכול להפעיל את הצינור הזה באמצעות לקוח Kubeflow Pipeline SDK, הקורא לנקודת הקצה של שירות Pipelines ומעביר כותרות אימות מתאימות ישירות מהמחברת. ראה את הקוד הבא:

אם אתה מקבל sagemaker import שגיאה, הפעל את !pip install sagemaker והפעל מחדש את הליבה (ב- גַרעִין בתפריט, בחר הפעל מחדש את הקרנל).

בחר את הרץ פרטים קישור מתחת לתא האחרון כדי להציג את הצינור של Kubeflow.

חזור על שלב יצירת הצינור עם training_runtime='kubernetes' כדי לבדוק את הפעלת הצינור בסביבת Kubernetes. ה training_runtime ניתן להעביר משתנה גם בצינור ה-CI/CD שלך בתרחיש ייצור.

הצג את יומני ריצת הצינור של Kubeflow עבור רכיב SageMaker

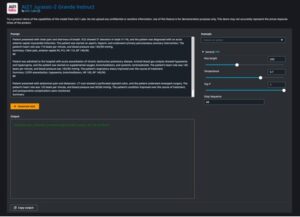

צילום המסך הבא מציג את פרטי הצינור שלנו עבור רכיב SageMaker.

בחר את שלב עבודת ההדרכה ועל יומנים בכרטיסייה, בחר בקישור יומני CloudWatch כדי לגשת ליומני SageMaker.

צילום המסך הבא מציג את יומני CloudWatch עבור כל אחד משני המופעים ml.p3.2xlarge.

בחר כל אחת מהקבוצות כדי לראות את היומנים.

הצג את יומני ריצת הצינור של Kubeflow עבור רכיב Kubeflow PyTorchJob Launcher

צילום המסך הבא מציג את פרטי הצינור עבור רכיב Kubeflow שלנו.

הפעל את הפקודות הבאות באמצעות Kubectl במעטפת הלקוח של Kubernetes המחוברת לאשכול Kubernetes כדי לראות את היומנים (החלף את מרחב השמות ואת שמות הפוד שלך):

4.1 לנקות

כדי לנקות את כל המשאבים שיצרנו בחשבון, עלינו להסיר אותם בסדר הפוך.

- מחק את התקנת Kubeflow על ידי הפעלה

./kubeflow-remove.shבaws-do-kubeflowמְכוֹלָה. קבוצת הפקודות הראשונה הן אופציונליות וניתן להשתמש בהן למקרה שעדיין אין לך מעטפת פקודהaws-do-kubeflowמיכל פתוח. - מ

aws-do-eksתיקיית container, הסר את אמצעי האחסון של EFS. קבוצת הפקודות הראשונה היא אופציונלית וניתן להשתמש בה למקרה שעדיין אין לך מעטפת פקודהaws-do-eksמיכל פתוח.מחיקת Amazon EFS נחוצה על מנת לשחרר את ממשק הרשת המשויך ל-VPC שיצרנו עבור האשכול שלנו. שים לב שמחיקת אמצעי האחסון של EFS הורסת כל נתונים המאוחסנים בו.

- מ

aws-do-eksמיכל, הפעל אתeks-delete.shסקריפט למחיקת האשכול וכל משאב אחר המשויך אליו, כולל ה-VPC:

<br> סיכום

בפוסט זה, דנו בכמה מהאתגרים האופייניים של אימון מודלים מבוזרים וזרימות עבודה של ML. סיפקנו סקירה כללית של Kubeflow על הפצת AWS ושיתפנו שני פרויקטים בקוד פתוח (aws-do-eks ו aws-do-kubeflow) שמפשטות את הקצאת התשתית ואת הפריסה של Kubeflow עליה. לבסוף, תיארנו והדגמנו ארכיטקטורה היברידית המאפשרת לעומסי עבודה לעבור בצורה חלקה בין ריצה על גבי תשתית Kubernetes בניהול עצמי לבין תשתית SageMaker המנוהלת במלואה. אנו ממליצים לך להשתמש בארכיטקטורה ההיברידית הזו למקרי השימוש שלך.

אתה יכול לעקוב אחר מאגר AWS Labs כדי לעקוב אחר כל התרומות של AWS ל-Kubeflow. אתה יכול למצוא אותנו גם ב ערוץ Slack של Kubeflow #AWS; המשוב שלך שם יעזור לנו לתעדף את התכונות הבאות לתרום לפרויקט Kubeflow.

תודה מיוחדת ל-Sree Arasanagatta (מנהל פיתוח תוכנה AWS ML) ו-Suraj Kota (מהנדס תוכנה) על תמיכתם בהשקת הפוסט הזה.

על המחברים

Kanwaljit Khurmi הוא אדריכל פתרונות AI/ML מומחה בשירותי האינטרנט של אמזון. הוא עובד עם המוצר, ההנדסה והלקוחות של AWS כדי לספק הדרכה וסיוע טכני המסייעים להם לשפר את הערך של פתרונות ה-ML ההיברידיים שלהם בעת שימוש ב-AWS. Kanwaljit מתמחה בסיוע ללקוחות עם יישומי מכולות ולמידת מכונה.

Kanwaljit Khurmi הוא אדריכל פתרונות AI/ML מומחה בשירותי האינטרנט של אמזון. הוא עובד עם המוצר, ההנדסה והלקוחות של AWS כדי לספק הדרכה וסיוע טכני המסייעים להם לשפר את הערך של פתרונות ה-ML ההיברידיים שלהם בעת שימוש ב-AWS. Kanwaljit מתמחה בסיוע ללקוחות עם יישומי מכולות ולמידת מכונה.

גוטם קומאר הוא מהנדס תוכנה עם AWS AI Deep Learning. הוא פיתח את AWS Deep Learning Containers ו-AWS Deep Learning AMI. הוא נלהב מבניית כלים ומערכות עבור AI. בזמנו הפנוי הוא נהנה לרכוב על אופניים ולקרוא ספרים.

גוטם קומאר הוא מהנדס תוכנה עם AWS AI Deep Learning. הוא פיתח את AWS Deep Learning Containers ו-AWS Deep Learning AMI. הוא נלהב מבניית כלים ומערכות עבור AI. בזמנו הפנוי הוא נהנה לרכוב על אופניים ולקרוא ספרים.

אלכס יאנקולסקי הוא ארכיטקט תוכנה ותשתית מלא שאוהב לעשות עבודה מעשית ומעמיקה. כיום הוא אדריכל פתרונות ראשי ללמידת מכונה בניהול עצמי ב-AWS. בתפקידו הוא מתמקד בסיוע ללקוחות עם קונטיינריזציה ותזמור של עומסי עבודה של ML ו-AI בשירותי AWS המונעים על ידי קונטיינרים. הוא גם המחבר של הקוד הפתוח תעשה מסגרת וקברניט דוקר שאוהב ליישם טכנולוגיות מכולות כדי להאיץ את קצב החדשנות תוך פתרון האתגרים הגדולים בעולם. במהלך 10 השנים האחרונות, אלכס עבד על מאבק בשינויי האקלים, דמוקרטיזציה של AI ו-ML, הפיכת נסיעות לבטוחות יותר, שירותי בריאות טובים יותר ואנרגיה חכמה יותר.

אלכס יאנקולסקי הוא ארכיטקט תוכנה ותשתית מלא שאוהב לעשות עבודה מעשית ומעמיקה. כיום הוא אדריכל פתרונות ראשי ללמידת מכונה בניהול עצמי ב-AWS. בתפקידו הוא מתמקד בסיוע ללקוחות עם קונטיינריזציה ותזמור של עומסי עבודה של ML ו-AI בשירותי AWS המונעים על ידי קונטיינרים. הוא גם המחבר של הקוד הפתוח תעשה מסגרת וקברניט דוקר שאוהב ליישם טכנולוגיות מכולות כדי להאיץ את קצב החדשנות תוך פתרון האתגרים הגדולים בעולם. במהלך 10 השנים האחרונות, אלכס עבד על מאבק בשינויי האקלים, דמוקרטיזציה של AI ו-ML, הפיכת נסיעות לבטוחות יותר, שירותי בריאות טובים יותר ואנרגיה חכמה יותר.

- מתקדם (300)

- AI

- איי אמנות

- מחולל אמנות ai

- איי רובוט

- מערכת קבצים אלסטית של אמזון (EFS)

- שירות קוברנט של אמזון

- אמזון SageMaker

- בינה מלאכותית

- הסמכת בינה מלאכותית

- בינה מלאכותית בבנקאות

- רובוט בינה מלאכותית

- רובוטים של בינה מלאכותית

- תוכנת בינה מלאכותית

- AWS Cloud9

- למידת מכונות AWS

- blockchain

- blockchain conference ai

- קוינגניוס

- בינה מלאכותית של שיחה

- קריפטו כנס ai

- פתרונות ללקוח

- של דאל

- למידה עמוקה

- גוגל איי

- למידת מכונה

- אפלטון

- plato ai

- מודיעין אפלטון

- משחק אפלטון

- אפלטון נתונים

- פלטוגיימינג

- PyTorch ב-AWS

- סולם ai

- תחביר

- זפירנט