כאשר תקנות פרטיות מידע חדשות כמו GDPR (General Data Protection Regulation, 2017) נכנסו לתוקף, הלקוחות נמצאים תחת לחץ מוגבר לייצר רווחים מנכסי מדיה תוך ציות לכללים החדשים. מונטיזציה של מדיה תוך כיבוד תקנות הפרטיות מחייבת את היכולת לחלץ אוטומטית מטא נתונים פרטניים מנכסים כמו טקסט, תמונות, וידאו וקבצי אודיו בקנה מידה אינטרנטי. זה גם דורש דרך ניתנת להרחבה למיפוי נכסי מדיה לטקסונומיות בתעשייה המאפשרות גילוי ומונטיזציה של תוכן. מקרה שימוש זה משמעותי במיוחד עבור תעשיית הפרסום מכיוון שכללי פרטיות הנתונים גורמים לשינוי ממיקוד התנהגותי באמצעות קובצי Cookie של צד שלישי.

קובצי cookie של צד שלישי לעזור לאפשר מודעות מותאמות אישית עבור משתמשי אינטרנט, ולאפשר למפרסמים להגיע לקהל המיועד להם. פתרון מסורתי להצגת מודעות ללא קובצי Cookie של צד שלישי הוא פרסום קונטקסטואלי, המציב מודעות בדפי אינטרנט על סמך התוכן המתפרסם בדפים. עם זאת, פרסום קונטקסטואלי מציב את האתגר של חילוץ הקשר מנכסי מדיה בקנה מידה, וכמו כן שימוש בהקשר זה כדי לייצר רווח מהנכסים.

בפוסט זה, אנו דנים כיצד ניתן לבנות פתרון למידת מכונה (ML) שאנו מכנים Contextual Intelligence Taxonomy Mapper (CITM) כדי לחלץ הקשר מתוכן דיגיטלי ולמפות אותו לטקסונומיות סטנדרטיות על מנת לייצר ערך. למרות שאנו מיישמים פתרון זה על פרסום הקשרי, אתה יכול להשתמש בו כדי לפתור מקרי שימוש אחרים. לדוגמה, חברות טכנולוגיות חינוך יכולות להשתמש בו כדי למפות את התוכן שלהן לטקסונומיות בתעשייה כדי להקל על למידה אדפטיבית המספקת חוויות למידה מותאמות אישית המבוססות על הצרכים האישיים של התלמידים.

סקירת פתרונות

הפתרון מורכב משני מרכיבים: מודיעין המדיה של AWS יכולות (AWS MI) לחילוץ הקשר מתוכן בדפי אינטרנט, ו-CITM למיפוי חכם של תוכן לטקסונומיה של התעשייה. אתה יכול לגשת לפתרונות מאגר קוד לתצוגה מפורטת של האופן שבו אנו מיישמים את מרכיביו.

מודיעין המדיה של AWS

יכולות AWS MI מאפשרות חילוץ אוטומטי של מטא נתונים המספקים הבנה הקשרית של תוכן דף אינטרנט. אתה יכול לשלב טכניקות ML כמו ראייה ממוחשבת, דיבור לטקסט ועיבוד שפה טבעית (NLP) כדי ליצור אוטומטית מטא נתונים מטקסט, סרטונים, תמונות וקובצי אודיו לשימוש בעיבוד במורד הזרם. שירותי AI מנוהלים כגון אמזון, אמזון תעתיק, אמזון להתבונן, ו טקסטורה באמזון להפוך את טכניקות ה-ML הללו לנגישות באמצעות קריאות API. זה מבטל את התקורה הדרושה לאימון ובניית דגמי ML מאפס. בפוסט זה, אתה רואה כיצד השימוש ב-Amazon Comprehend וב-Amazon Rekognition עבור מודיעין מדיה מאפשר חילוץ מטא נתונים בקנה מידה.

מיפוי טקסונומיה של אינטליגנציה קונטקסטואלית

לאחר חילוץ מטא נתונים מתוכן מדיה, אתה צריך דרך למפות את המטא נתונים האלה לטקסונומיה של התעשייה כדי להקל על מיקוד לפי הקשר. לשם כך, אתה בונה Contextual Intelligence Taxonomy Mapper (CITM), המופעל על ידי שנאי משפטי BERT מבית Hugging Face.

שנאי המשפטים של BERT מאפשר ל-CITM לסווג תוכן אינטרנט עם מילות מפתח הקשורות להקשר. לדוגמה, הוא יכול לסווג מאמר אינטרנט על אורח חיים בריא עם מילות מפתח מהטקסונומיה של התעשייה, כגון "בישול ואכילה בריא", "ריצה וריצה" ועוד, בהתבסס על הטקסט שנכתב והתמונות המשמשות במאמר. CITM מספקת גם את היכולת לבחור את מונחי הטקסונומיה הממופים לשימוש עבור תהליך הגשת הצעות המודעה שלך על סמך הקריטריונים שלך.

התרשים הבא ממחיש את ההשקפה הרעיונית של הארכיטקטורה עם CITM.

טקסונומיית התוכן של IAB (Interactive Advertising Bureau).

לפוסט זה אנו משתמשים ב- טקסונומיית התוכן של IAB Tech Lab כטקסונומיה הסטנדרטית בתעשייה עבור מקרה השימוש בפרסום הקשרי. בתכנון, הטקסונומיה של IAB עוזרת ליוצרי תוכן לתאר בצורה מדויקת יותר את התוכן שלהם, והיא מספקת שפה משותפת לכל הצדדים בתהליך הפרסום הפרוגרמטי. השימוש בטרמינולוגיה נפוצה הוא חיוני מכיוון שהבחירה של מודעות עבור דף אינטרנט שמשתמש מבקר בו צריכה להתרחש תוך אלפיות שניות. הטקסונומיה של IAB משמשת כדרך סטנדרטית לסווג תוכן ממקורות שונים, תוך שהיא גם פרוטוקול תעשייתי שפלטפורמות הגשת הצעות בזמן אמת משתמשות בו לבחירת מודעות. יש לו מבנה היררכי, המספק פירוט של מונחי טקסונומיה והקשר משופר למפרסמים.

זרימת עבודה של פתרון

התרשים הבא ממחיש את זרימת העבודה של הפיתרון.

השלבים הם כדלקמן:

- שירות אחסון פשוט של אמזון (Amazon S3) מאחסן את טקסונומיית התוכן של IAB ואת תוכן האינטרנט שחולץ.

- Amazon Comprehend מבצעת מודלים של נושאים כדי לחלץ נושאים נפוצים מאוסף המאמרים.

- ההכרה של אמזון API של תווית אובייקט מזהה תוויות בתמונות.

- CITM ממפה תוכן לטקסונומיה סטנדרטית.

- לחלופין, אתה יכול לאחסן תוכן למיפוי טקסונומיה במאגר מטא נתונים.

בסעיפים הבאים, נעבור על כל שלב בפירוט.

אמזון S3 מאחסנת את טקסונומיית התוכן של IAB ותוכן אינטרנט שחולץ

אנו מאחסנים טקסט ותמונות שחולצו מאוסף מאמרי אינטרנט בדלי S3. אנו מאחסנים גם את טקסונומיית התוכן של IAB. כצעד ראשון, אנו משרשרים שכבות שונות בטקסונומיה כדי ליצור מונחי טקסונומיה משולבים. גישה זו עוזרת לשמור על המבנה ההיררכי של הטקסונומיה כאשר מתמר המשפטים BERT יוצר הטבעות עבור כל מילת מפתח. ראה את הקוד הבא:

התרשים הבא ממחיש את טקסונומיית ההקשר של IAB עם שכבות משולבות.

Amazon Comprehend מבצעת מודלים של נושאים כדי לחלץ נושאים נפוצים מאוסף המאמרים

עם ה-API למודלים של נושאים של Amazon Comprehend, אתה מנתח את כל טקסטי המאמר באמצעות מודל הקצאת Dirichlet Latent (LDA). המודל בוחן כל מאמר בקורפוס ומקבץ מילות מפתח לאותו נושא בהתבסס על ההקשר והתדירות שבה הן מופיעות על פני כל אוסף המאמרים. כדי להבטיח שמודל ה-LDA יזהה נושאים מאוד קוהרנטיים, אתה מבצע שלב עיבוד מקדים לפני הקריאה ל-Amazon Comprehend API. אתה יכול להשתמש ב ספריית גנסים CoherenceModel לקביעת המספר האופטימלי של נושאים לזיהוי מאוסף המאמרים או קבצי הטקסט. ראה את הקוד הבא:

לאחר שתקבל את המספר האופטימלי של נושאים, אתה משתמש בערך זה עבור עבודת הדוגמנות של Amazon Comprehend. מתן ערכים שונים לפרמטר NumberOfTopics ב-Amazon Comprehend פעולת StartTopicsDetectionJob גורם לשינוי בהתפלגות מילות המפתח המוצבות בכל קבוצת נושאים. ערך אופטימלי עבור הפרמטר NumberOfTopics מייצג את מספר הנושאים המספקים את הקיבוץ הקוהרנטי ביותר של מילות מפתח עם רלוונטיות הקשרית גבוהה יותר. אתה יכול לאחסן את פלט דוגמנות הנושא מ- Amazon Comprehend בפורמט הגולמי שלו באמזון S3.

ה-API של תווית האובייקטים של Amazon Rekognition מזהה תוויות בתמונות

אתה מנתח כל תמונה שחולצה מכל דפי האינטרנט באמצעות ה פעולת Amazon Rekognition DetectLabels. עבור כל תמונה, הפעולה מספקת תגובת JSON עם כל התוויות שזוהו בתוך התמונה, יחד עם ציון ביטחון עבור כל אחת מהן. במקרה השימוש שלנו, אנו בוחרים באופן שרירותי ציון ביטחון של 60% ומעלה כסף לשימוש בתוויות אובייקטים בשלב הבא. אתה מאחסן תוויות אובייקט בפורמט הגולמי שלהם באמזון S3. ראה את הקוד הבא:

CITM ממפה תוכן לטקסונומיה סטנדרטית

CITM משווה מטא נתונים של תוכן שחולצו (נושאים מטקסט ותוויות מתמונות) עם מילות מפתח בטקסונומיה של IAB, ולאחר מכן ממפה את המטא נתונים של התוכן למילות מפתח מהטקסונומיה הקשורות סמנטי. עבור משימה זו, CITM משלים את שלושת השלבים הבאים:

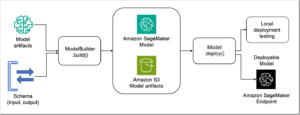

- צור הטבעות עצביות עבור טקסונומיית התוכן, מילות מפתח בנושא ותוויות תמונה באמצעות שנאי המשפטים BERT של Hugging Face. אנו ניגשים למודל שנאי המשפט מ אמזון SageMaker. בפוסט זה אנו משתמשים ב- פרפרזה-MiniLM-L6-v2 מודל, אשר ממפה מילות מפתח ותוויות למרחב וקטור צפוף של 384 ממדים.

- חשב את ציון הדמיון הקוסינוס בין מילות מפתח בטקסונומיה למילות מפתח בנושא באמצעות ההטמעות שלהן. זה גם מחשב דמיון קוסינוס בין מילות המפתח בטקסונומיה לבין תוויות אובייקט התמונה. אנו משתמשים בדמיון קוסינוס כמנגנון ניקוד כדי למצוא התאמות דומות מבחינה סמנטית בין המטא נתונים של התוכן והטקסונומיה. ראה את הקוד הבא:

- זהה זיווגים עם ציוני דמיון שהם מעל סף שהוגדר על ידי המשתמש והשתמש בהם כדי למפות את התוכן למילות מפתח הקשורות מבחינה סמנטית בטקסונומיית התוכן. במבחן שלנו, אנו בוחרים את כל מילות המפתח מתוך זיווגים בעלות ציון דמיון קוסינוס של 0.5 ומעלה. ראה את הקוד הבא:

אתגר נפוץ בעבודה עם ייצוג שפה בקנה מידה אינטרנט (כמו במקרה השימוש הזה) הוא שאתה צריך מודל שיכול להתאים לרוב התוכן - במקרה זה, מילים בשפה האנגלית. שנאי BERT של Hugging Face עבר הכשרה מוקדמת באמצעות קורפוס גדול של פוסטים בוויקיפדיה בשפה האנגלית כדי לייצג את המשמעות הסמנטית של מילים ביחס זו לזו. אתה מכוונן את המודל שהוכשר מראש באמצעות מערך הנתונים הספציפי שלך של מילות מפתח בנושא, תוויות תמונה ומילות מפתח בטקסונומיה. כאשר אתה מציב את כל ההטמעות באותו מרחב תכונה ומדמיין אותן, אתה רואה ש-BERT מייצג מבחינה לוגית דמיון סמנטי בין מונחים.

הדוגמה הבאה מציגה את מילות המפתח של טקסונומיית התוכן של IAB עבור המחלקה Automotive המיוצגת כווקטורים באמצעות BERT. BERT ממקמת מילות מפתח לרכב מהטקסונומיה קרובה למונחים דומים מבחינה סמנטית.

וקטורי התכונה מאפשרים ל-CITM להשוות את תוויות המטא נתונים ומילות המפתח של הטקסונומיה באותו מרחב תכונה. במרחב תכונה זה, CITM מחשבת דמיון קוסינוס בין כל וקטור תכונה עבור מילות מפתח בטקסונומיה וכל וקטור תכונה עבור מילות מפתח בנושא. בשלב נפרד, CITM משווה וקטורים של תכונה טקסונומית ווקטורי תכונה עבור תוויות תמונה. זיווגים עם ציוני קוסינוס הקרובים ביותר ל-1 מזוהים כדומים מבחינה סמנטית. שים לב שהתאמה יכולה להיות מילת מפתח בנושא ומילת מפתח טקסונומית, או תווית אובייקט ומילת מפתח טקסונומית.

צילום המסך הבא מציג צימודים לדוגמה של מילות מפתח בנושא ומילות מפתח בטקסונומיה באמצעות דמיון קוסינוס המחושב עם הטבעות BERT.

כדי למפות תוכן למילות מפתח בטקסונומיה, CITM בוחר מילות מפתח מתוך זיווג עם ציוני קוסינוס העומדים בסף שהוגדר על ידי המשתמש. אלו הן מילות המפתח שישמשו בפלטפורמות למתן הצעות בזמן אמת לבחירת מודעות למלאי של דף האינטרנט. התוצאה היא מיפוי עשיר של תוכן מקוון לטקסונומיה.

אופציונלי לאחסן תוכן למיפוי טקסונומיה במאגר מטא נתונים

לאחר שתזהה מונחי טקסונומיה דומים מבחינה הקשרית מ-CITM, אתה צריך דרך עבור ממשקי API עם אחזור נמוך לגשת למידע הזה. בהצעת הצעות פרוגרמטית לפרסומות, זמן תגובה נמוך ובהקדמות גבוהה משחקים תפקיד חשוב במונטיזציה של התוכן. הסכימה של מאגר הנתונים צריכה להיות גמישה כדי להכיל מטא נתונים נוספים בעת הצורך כדי להעשיר בקשות להצעות מחיר. אמזון דינמו יכול להתאים לדפוסי הגישה לנתונים ולדרישות התפעול עבור שירות כזה.

סיכום

בפוסט זה, למדת כיצד לבנות פתרון מיקוד לפי הקשר מבוסס טקסונומיה באמצעות Contextual Intelligence Taxonomy Mapper (CITM). למדת כיצד להשתמש ב-Amazon Comprehend וב-Amazon Rekognition כדי לחלץ מטא נתונים מפורטים מנכסי המדיה שלך. לאחר מכן, באמצעות CITM מיפית את הנכסים לטקסונומיה סטנדרטית בתעשייה כדי להקל על הגשת הצעות מודעות פרוגרמטיות עבור מודעות הקשורות להקשר. אתה יכול להחיל מסגרת זו על מקרי שימוש אחרים הדורשים שימוש בטקסונומיה סטנדרטית כדי לשפר את הערך של נכסי מדיה קיימים.

כדי להתנסות עם CITM, אתה יכול לגשת אליו מאגר קוד והשתמש בו עם מערך נתונים של טקסט ותמונה לבחירתך.

אנו ממליצים ללמוד עוד על רכיבי הפתרון שהוצגו בפוסט זה. גלה עוד על מודיעין המדיה של AWS כדי לחלץ מטא נתונים מתוכן מדיה. כמו כן, למד עוד על אופן השימוש דגמי חיבוק פנים עבור NLP באמצעות Amazon SageMaker.

על הכותבים

ארמיד קהיינדה הוא ארכיטקט פתרונות Sr. Partner ב-AWS בלמידת מכונה ובינה מלאכותית. מסע הקריירה שלה השתרע על תחומי הבינה העסקית והאנליטיקה המתקדמת במגוון תעשיות. היא פועלת כדי לאפשר לשותפים לבנות פתרונות עם שירותי AWS AI/ML המשרתים את צרכי הלקוחות לחדשנות. היא גם נהנית לבנות את ההצטלבות של AI וזירות יצירתיות ולבלות עם משפחתה.

ארמיד קהיינדה הוא ארכיטקט פתרונות Sr. Partner ב-AWS בלמידת מכונה ובינה מלאכותית. מסע הקריירה שלה השתרע על תחומי הבינה העסקית והאנליטיקה המתקדמת במגוון תעשיות. היא פועלת כדי לאפשר לשותפים לבנות פתרונות עם שירותי AWS AI/ML המשרתים את צרכי הלקוחות לחדשנות. היא גם נהנית לבנות את ההצטלבות של AI וזירות יצירתיות ולבלות עם משפחתה.

אנוג 'גופטה הוא ארכיטקט פתרונות ראשי שעובד עם חברות היפר-צמיחה במסע המקור שלהן לענן. הוא נלהב משימוש בטכנולוגיה כדי לפתור בעיות מאתגרות ועבד עם לקוחות כדי לבנות יישומים מפוזרים מאוד ועם חביון נמוך. הוא תורם לפתרונות ללא שרת ולמידת מכונה בקוד פתוח. מחוץ לעבודה, הוא אוהב לטייל עם משפחתו ולכתוב שירים ובלוגים פילוסופיים.

אנוג 'גופטה הוא ארכיטקט פתרונות ראשי שעובד עם חברות היפר-צמיחה במסע המקור שלהן לענן. הוא נלהב משימוש בטכנולוגיה כדי לפתור בעיות מאתגרות ועבד עם לקוחות כדי לבנות יישומים מפוזרים מאוד ועם חביון נמוך. הוא תורם לפתרונות ללא שרת ולמידת מכונה בקוד פתוח. מחוץ לעבודה, הוא אוהב לטייל עם משפחתו ולכתוב שירים ובלוגים פילוסופיים.

- AI

- איי אמנות

- מחולל אמנות ai

- איי רובוט

- אמזון להתבונן

- אמזון

- אמזון SageMaker

- בינה מלאכותית

- הסמכת בינה מלאכותית

- בינה מלאכותית בבנקאות

- רובוט בינה מלאכותית

- רובוטים של בינה מלאכותית

- תוכנת בינה מלאכותית

- למידת מכונות AWS

- blockchain

- blockchain conference ai

- קוינגניוס

- בינה מלאכותית של שיחה

- קריפטו כנס ai

- של דאל

- למידה עמוקה

- גוגל איי

- למידת מכונה

- שיווק ופרסום

- אפלטון

- plato ai

- מודיעין אפלטון

- משחק אפלטון

- אפלטון נתונים

- פלטוגיימינג

- סולם ai

- תחביר

- מדריך טכני

- מנהיגות מחשבתית

- זפירנט