ארגונים ברחבי העולם נמצאים במרוץ לאמץ טכנולוגיות בינה מלאכותית לתוכניות וכלי אבטחת הסייבר שלהם. א רוב (65%) מהמפתחים להשתמש או לתכנן שימוש בבינה מלאכותית במאמצי בדיקה בשלוש השנים הבאות. ישנם יישומי אבטחה רבים שייהנו מ-AI גנרטיבי, אך האם תיקון הקוד הוא אחד מהם?

עבור צוותי DevSecOps רבים, בינה מלאכותית גנרטיבית מייצגת את הגביע הקדוש לניקוי צבר הפגיעות ההולך וגובר שלהם. הרבה יותר ממחצית (66%) מהארגונים אומרים שהצבר שלהם מורכב מיותר מ-100,000 נקודות תורפה, ולמעלה משני שלישים מהממצאים המדווחים של בדיקות אבטחת יישומים סטטיות (SAST) נותרו פתוחים שלושה חודשים לאחר הזיהוי, עם 50% נותרו פתוחים לאחר 363 ימים. החלום הוא שמפתח יוכל פשוט לבקש מ-ChatGPT "לתקן את הפגיעות הזו", והשעות והימים שהושקעו קודם לכן בתיקון פרצות יהיו נחלת העבר.

זה לא רעיון מטורף לגמרי, בתיאוריה. אחרי הכל, למידת מכונה שימשה ביעילות בכלי אבטחת סייבר במשך שנים כדי להפוך תהליכים לאוטומטיים ולחסוך זמן - AI מועיל מאוד כשמיושם על משימות פשוטות שחוזרות על עצמן. אבל ליישום AI גנרטיבי על יישומי קוד מורכבים יש כמה פגמים, בפועל. ללא פיקוח אנושי ופיקוד מפורש, צוותי DevSecOps עלולים ליצור יותר בעיות ממה שהם פותרים.

יתרונות ומגבלות AI גנרטיבי הקשורים לתיקון קוד

כלי בינה מלאכותית יכולים להיות כלים חזקים להפליא לניתוח, ניטור או אפילו צרכים פשוטים של אבטחת סייבר בסיכון נמוך. החשש מתעורר כאשר ההימור הופך להיות תוצאתי. זה בסופו של דבר עניין של אמון.

חוקרים ומפתחים עדיין קובעים את היכולות של טכנולוגיית AI גנרטיבית חדשה לייצר תיקוני קוד מורכבים. AI גנרטיבי מסתמך על מידע קיים וזמין כדי לקבל החלטות. זה יכול להיות מועיל עבור דברים כמו תרגום קוד משפה אחת לאחרת, או תיקון פגמים ידועים. לדוגמה, אם תבקש מ-ChatGPT "לכתוב את קוד ה-JavaScript הזה ב-Python", סביר להניח שתקבל תוצאה טובה. השימוש בו כדי לתקן תצורת אבטחה בענן יהיה מועיל מכיוון שהתיעוד הרלוונטי לעשות זאת זמין לציבור ונמצא בקלות, וה-AI יכול לבצע את ההוראות הפשוטות.

עם זאת, תיקון רוב פגיעויות הקוד מצריך פעולה לפי סט ייחודי של נסיבות ופרטים, הצגת תרחיש מורכב יותר עבור ה-AI לנווט. ה-AI עשוי לספק "תיקון", אך ללא אימות, אין לסמוך עליו. AI גנרטיבי, בהגדרה, לא יכול ליצור משהו שלא ידוע כבר, והוא יכול לחוות הזיות שגורמות לפלט מזויף.

בדוגמה עדכנית, עורך דין מתמודד עם השלכות חמורות לאחר שהשתמש ב-ChatGPT כדי לעזור בכתיבת מסמכים משפטיים שצוטטו שישה מקרים לא קיימים שכלי הבינה המלאכותית המציא. אם בינה מלאכותית הייתה הוזה שיטות שאינן קיימות ואז מיישם את השיטות הללו לכתיבת קוד, זה היה גורם לבזבוז זמן על "תיקון" שלא ניתן להידור. בנוסף, לפי OpenAI's נייר לבן GPT-4, מעללים חדשים, פריצות לכלא והתנהגויות מתעוררות יתגלו עם הזמן ויהיה קשה למנוע אותם. לכן נדרשת שיקול דעת זהיר כדי להבטיח שכלי אבטחת AI ופתרונות צד שלישי נבדקים ומתעדכנים באופן קבוע כדי להבטיח שהם לא יהפכו לדלת אחורית לא מכוונת למערכת.

לסמוך או לא לסמוך?

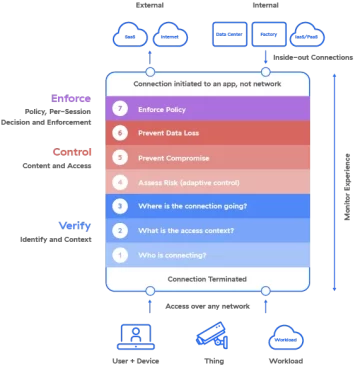

זו דינמיקה מעניינת לראות את האימוץ המהיר של בינה מלאכותית גנרטיבית מתחילה בשיאה של תנועת אפס האמון. רוב כלי אבטחת הסייבר בנויים על הרעיון שארגונים לעולם לא צריכים לבטוח בהם, תמיד לאמת. בינה מלאכותית גנרטיבית בנויה על עיקרון האמון המובנה במידע הזמין לה על ידי מקורות ידועים ולא ידועים. התנגשות עקרונות זו נראית כמו מטפורה הולמת למאבק העיקש שארגונים מתמודדים עם מציאת האיזון הנכון בין אבטחה לתפוקה, שמרגיש מוחרף במיוחד ברגע זה.

בעוד שבינה מלאכותית גנרטיבית אולי עדיין לא היא הגביע הקדוש לו קיוו צוותי DevSecOps, זה יעזור להתקדם מצטבר בהפחתת צבר פגיעות. לעת עתה, ניתן ליישם אותו כדי לבצע תיקונים פשוטים. לתיקונים מורכבים יותר, הם יצטרכו לאמץ מתודולוגיית אימות לאמון הרותמת את הכוח של AI המונחה על ידי הידע של המפתחים שכתבו והבעלים של הקוד.

- הפצת תוכן ויחסי ציבור מופעל על ידי SEO. קבל הגברה היום.

- PlatoData.Network Vertical Generative Ai. העצים את עצמך. גישה כאן.

- PlatoAiStream. Web3 Intelligence. הידע מוגבר. גישה כאן.

- PlatoESG. רכב / רכבים חשמליים, פחמן, קלינטק, אנרגיה, סביבה, שמש, ניהול פסולת. גישה כאן.

- BlockOffsets. מודרניזציה של בעלות על קיזוז סביבתי. גישה כאן.

- מקור: https://www.darkreading.com/application-security/can-generative-ai-be-trusted-to-fix-your-code-

- :יש ל

- :הוא

- :לֹא

- $ למעלה

- 000

- 100

- 7

- a

- פי

- משחק

- בנוסף

- לְאַמֵץ

- אימוץ

- יתרונות

- לאחר

- AI

- תעשיות

- כְּבָר

- תמיד

- an

- אנליזה

- ו

- אחר

- בקשה

- אבטחת יישומים

- יישומים

- יישומית

- החל

- מריחה

- ARE

- At

- אוטומטי

- זמין

- דלתות אחוריות

- איזון

- BE

- כי

- להיות

- היה

- מועיל

- תועלת

- בֵּין

- נבנה

- אבל

- by

- CAN

- יכולות

- זהיר

- מקרים

- ChatGPT

- בנסיבות

- מצוטט

- התנגשות

- קרחת יער

- ענן

- אבטחת ענן

- קוד

- מורכב

- מורכב

- דְאָגָה

- תְצוּרָה

- השלכות

- תוצאתית

- התחשבות

- יכול

- בית דין

- הגשות לבית המשפט

- משוגע

- לִיצוֹר

- יוצרים

- אבטחת סייבר

- ימים

- החלטות

- הגדרה

- פרטים

- איתור

- קביעה

- מפתח

- מפתחים

- קשה

- גילה

- do

- תיעוד

- חלום

- דינמי

- בקלות

- יעילות

- סוף

- לְהַבטִיחַ

- לַחֲלוּטִין

- אֲפִילוּ

- דוגמה

- להתקיים

- קיימים

- ניסיון

- מעללים

- אקספרס

- פָּנִים

- מול

- מְזוּיָף

- תלונות

- מציאת

- ממצאים

- הוֹלֵם

- לסדר

- פגמים

- לעקוב

- בעד

- מצא

- החל מ-

- גנרטטיבית

- AI Generative

- לקבל

- טוב

- חצי

- גובה

- לעזור

- מועיל

- מקווה

- שעות

- HTML

- HTTPS

- הַרבֵּה מְאוֹד

- בן אנוש

- רעיון

- if

- in

- גדל

- בצורה מדהימה

- מידע

- הטמון

- הוראות

- מעניין

- אל תוך

- החדרה

- בדוי

- סוגיה

- IT

- JavaScript

- jpg

- ידע

- ידוע

- שפה

- עורך דין

- למידה

- כמו

- סביר

- מגבלות

- ll

- סיכון נמוך

- מכונה

- למידת מכונה

- עשוי

- הרוב

- לעשות

- רב

- מֵתוֹדוֹלוֹגִיָה

- שיטות

- יכול

- רֶגַע

- ניטור

- חודשים

- יותר

- רוב

- תנועה

- נווט

- צורך

- צרכי

- לעולם לא

- חדש

- הבא

- לא קיים

- עַכשָׁיו

- of

- on

- ONE

- לפתוח

- OpenAI

- or

- להזמין

- ארגונים

- הַחוּצָה

- יותר

- מֶחדָל

- שֶׁלוֹ

- במיוחד

- עבר

- תכנית

- אפלטון

- מודיעין אפלטון

- אפלטון נתונים

- לְשַׂחֵק

- כּוֹחַ

- חזק

- תרגול

- למנוע

- קוֹדֶם

- עקרון

- עקרונות

- בעיות

- תהליכים

- פִּריוֹן

- תוכניות

- התקדמות

- לספק

- בפומבי

- פיתון

- גזע

- מהיר

- לאחרונה

- הפחתה

- באופן קבוע

- קָשׁוּר

- רלוונטי

- להשאר

- נותר

- חוזר על עצמו

- דווח

- מייצג

- נדרש

- דורש

- תוצאה

- תקין

- s

- שמור

- לומר

- תרחיש

- אבטחה

- לִרְאוֹת

- נראה

- רציני

- סט

- צריך

- פָּשׁוּט

- בפשטות

- שישה

- So

- פתרונות

- לפתור

- כמה

- משהו

- מקורות

- בילה

- עוד

- מַאֲבָק

- מערכת

- משימות

- צוותי

- טכנולוגיות

- טכנולוגיה

- בדיקות

- מֵאֲשֶׁר

- זֶה

- השמיים

- המידע

- שֶׁלָהֶם

- אותם

- אז

- התאוריה

- שם.

- הֵם

- דבר

- דברים

- צד שלישי

- זֶה

- אלה

- שְׁלוֹשָׁה

- זמן

- ל

- כלי

- כלים

- סומך

- מהימן

- שני שליש

- בסופו של דבר

- ייחודי

- לא ידוע

- מְעוּדכָּן

- להשתמש

- מְשׁוּמָשׁ

- באמצעות

- אימות

- לאמת

- בוטה

- פגיעויות

- פגיעות

- מוכר

- היו

- מתי

- אשר

- מי

- יצטרך

- עם

- לְלֹא

- עולמי

- היה

- לכתוב

- כתיבה

- שנים

- עוד

- אתה

- זפירנט