בנובמבר 2021, בשיתוף עם RStudio PBC, אנחנו הודיע הזמינות הכללית של RStudio ב- Amazon SageMaker, RStudio Workbench IDE המנוהל במלואו הראשון בענן בענן. כעת תוכל להביא את רישיון RStudio הנוכחי שלך כדי להעביר בקלות את סביבות RStudio בניהול עצמי שלך אמזון SageMaker בכמה שלבים פשוטים.

RStudio הוא אחד ה-IDEs הפופולריים ביותר בקרב מפתחי R עבור לימוד מכונה (ML) ופרויקטים של מדעי נתונים. RStudio מספקת כלים בקוד פתוח עבור R ותוכנה מקצועית מוכנה לארגונים עבור צוותי מדעי הנתונים כדי לפתח ולשתף את עבודתם בארגון. הבאת RStudio ל- SageMaker לא רק מעניקה לך גישה לתשתית AWS בצורה מנוהלת במלואה, אלא היא גם מעניקה לך גישה מקורית ל- SageMaker.

בפוסט זה, אנו חוקרים כיצד ניתן להשתמש בתכונות SageMaker דרך RStudio ב- SageMaker כדי לבנות צינור של SageMaker שבונה, מעבד, מאמן ורושם את דגמי ה-R שלך. אנו גם חוקרים את השימוש ב- SageMaker לפריסת המודל שלנו, הכל באמצעות R.

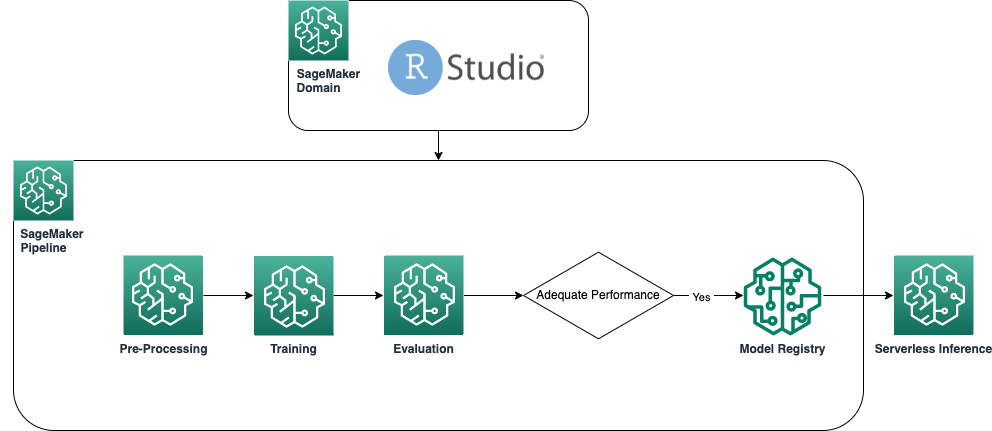

סקירת פתרונות

התרשים הבא מציג את הארכיטקטורה המשמשת בפתרון שלנו. כל הקוד המשמש בדוגמה זו ניתן למצוא ב- מאגר GitHub.

תנאים מוקדמים

כדי לעקוב אחר הפוסט הזה, נדרשת גישה ל- RStudio ב- SageMaker. אם אתה חדש בשימוש ב- RStudio ב- SageMaker, בדוק התחל עם RStudio באמזון SageMaker.

אנחנו צריכים גם לבנות מכולות Docker מותאמות אישית. אנו משתמשים בניית קוד AWS כדי לבנות את המכולות האלה, אז אתה צריך עוד כמה AWS זהות וניהול גישה הרשאות (IAM) שאולי אין לך כברירת מחדל. לפני שתמשיך, ודא שלתפקיד IAM שבו אתה משתמש יש מדיניות אמון עם CodeBuild:

ההרשאות הבאות נדרשות גם בתפקיד IAM כדי להפעיל בנייה ב-CodeBuild ולדחוף את התמונה אליה מרשם מיכל אלסטי של אמזון (Amazon ECR):

צור מיכלי R בסיסיים

כדי להשתמש בסקריפט R שלנו לעיבוד והדרכה בעבודות עיבוד והדרכה של SageMaker, עלינו ליצור משלנו מכולות דוקר המכילים את זמן הריצה והחבילות הדרושים. היכולת להשתמש בקונטיינר משלך, המהווה חלק מהיצע SageMaker, מעניקה גמישות רבה למפתחים ומדעני נתונים להשתמש בכלים ובמסגרות לפי בחירתם, כמעט ללא מגבלות.

אנו יוצרים שני מכולות Docker התומכות ב-R: אחת עבור עבודות עיבוד ואחת להדרכה ופריסה של המודלים שלנו. עיבוד נתונים דורש בדרך כלל חבילות וספריות שונות מאשר מודלים, ולכן הגיוני כאן להפריד בין שני השלבים ולהשתמש בקונטיינרים שונים.

לפרטים נוספים על שימוש במכולות עם SageMaker, עיין ב שימוש בקונטיינרים של Docker עם SageMaker.

המיכל המשמש לעיבוד מוגדר כדלקמן:

לפוסט זה אנו משתמשים במיכל פשוט וקל יחסית. בהתאם לצרכים שלך או של הארגון שלך, ייתכן שתרצה להתקין מראש עוד כמה חבילות R.

המכולה המשמשת לאימון ופריסה מוגדרת כדלקמן:

ליבת RStudio פועלת על קונטיינר Docker, כך שלא תוכל לבנות ולפרוס את הקונטיינרים באמצעות פקודות Docker ישירות בהפעלת הסטודיו שלך. במקום זאת, אתה יכול להשתמש בספרייה שימושית מאוד sagemaker-studio-image-build, שבעצם מוציאה למיקור חוץ את משימת בניית הקונטיינרים ל-CodeBuild.

עם הפקודות הבאות, אנו יוצרים שני רישום ECR של אמזון: sagemaker-r-processing ו sagemaker-r-train-n-deploy, ובנו את המיכלים המתאימים שבהם אנו משתמשים מאוחר יותר:

צור את הצינור

כעת, כשהקונטיינרים בנויים ומוכנים, נוכל ליצור את צינור SageMaker שמתארגן את תהליך בניית המודל. הקוד המלא של זה נמצא מתחת לקובץ pipeline.R במאגר. הדרך הקלה ביותר ליצור צינור של SageMaker היא באמצעות SageMaker SDK, שהיא ספריית Python שאנו יכולים לגשת אליה באמצעות הספרייה לרשת. זה נותן לנו גישה לכל הפונקציות של SageMaker מבלי לצאת מסביבת שפת R.

הצינור שאנו בונים כולל את הרכיבים הבאים:

- שלב עיבוד מקדים - זוהי עבודת עיבוד של SageMaker (המשתמשת ב-

sagemaker-r-processingcontainer) האחראי על עיבוד מוקדם של הנתונים ופיצול הנתונים למערך נתונים של רכבת ובדיקה. - שלב אימון - זוהי עבודת הכשרה של SageMaker (המשתמשת ב-

sagemaker-r-train-n-deployמיכל) אחראי להכשרת המודל. בדוגמה זו, אנו מאמנים מודל ליניארי פשוט. - שלב הערכה - זוהי עבודת עיבוד של SageMaker (המשתמשת ב-

sagemaker-r-processingcontainer) אחראי על ביצוע הערכה של המודל. ספציפית בדוגמה זו, אנו מעוניינים ב-RMSE (שגיאת בסיס מרובעת) במערך הנתונים של הבדיקה, שבו אנו רוצים להשתמש בשלב הבא וכן לשייך למודל עצמו. - צעד מותנה – זהו שלב מותנה, מקורי בצנרת של SageMaker, המאפשר לנו להסיע את הלוגיקה של הצינור על סמך פרמטר כלשהו. במקרה זה, הצינור מסתעף על סמך הערך של RMSE שחושב בשלב הקודם.

- רישום שלב הדגם – אם השלב המותנה הקודם הוא

True, והביצועים של המודל מקובלים, אז המודל נרשם ברישום המודלים. למידע נוסף, עיין ב רישום ופריסה של מודלים עם רישום מודלים.

תחילה קרא לפונקציה upsert כדי ליצור (או לעדכן) את הצינור ולאחר מכן קרא לפונקציית ההתחלה כדי להתחיל בפועל להפעיל את הצינור:

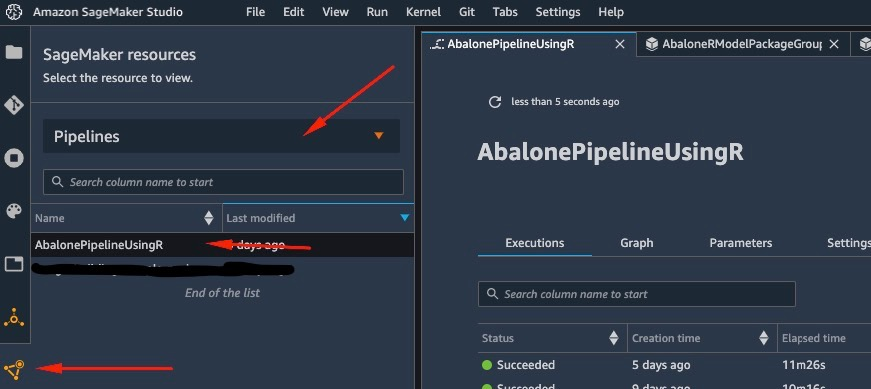

בדוק את רישום הצינור והמודל

אחד הדברים הנהדרים בשימוש ב- RStudio ב- SageMaker הוא שעל ידי הימצאות בפלטפורמת SageMaker, אתה יכול להשתמש בכלי הנכון לעבודה הנכונה ולעבור במהירות ביניהם בהתבסס על מה שאתה צריך לעשות.

ברגע שנתחיל את הפעלת הצינור, נוכל לעבור ל סטודיו SageMaker של אמזון, המאפשר לנו לדמיין את הצינור ולפקח על שוטף וריצות קודמות שלו.

כדי להציג פרטים על הצינור שזה עתה יצרנו והרצנו, נווט אל ממשק Studio IDE, בחר משאבי SageMaker, בחר צינורות בתפריט הנפתח, ובחר את הצינור (במקרה זה, AbalonePipelineUsingR).

זה חושף פרטים על הצינור, כולל כל הריצות הנוכחיות והקודמות. בחר את האחרון כדי להעלות ייצוג חזותי של הצינור, לפי צילום המסך הבא.

ה-DAG של הצינור נוצר אוטומטית על ידי השירות בהתבסס על התלות בנתונים בין השלבים, וכן על סמך תלות מותאמות אישית שנוספו (לא נוספו כאלה בדוגמה זו).

כשהריצה תושלם, אם תצליח, אתה אמור לראות את כל השלבים הופכים לירוקים.

בחירה בכל אחד מהשלבים הבודדים מעלה פרטים על השלב הספציפי, כולל כניסות, יציאות, יומנים והגדרות תצורה ראשוניות. זה מאפשר לך להתעמק בצנרת ולחקור כל צעד שנכשל.

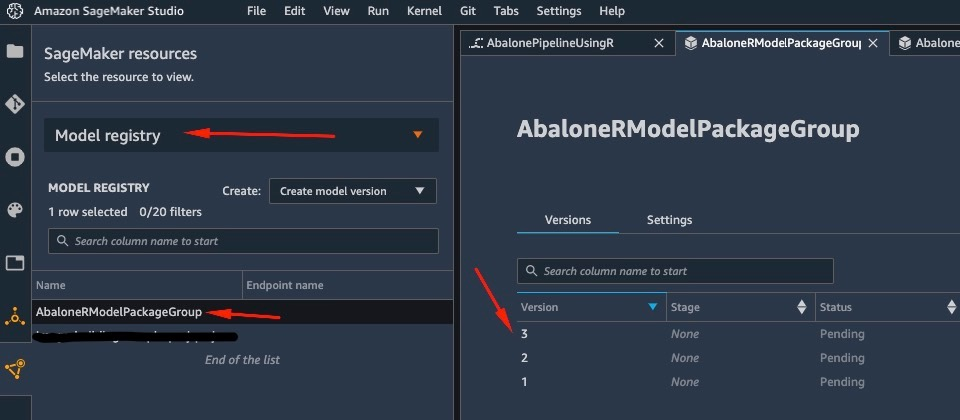

באופן דומה, כאשר הצינור הסתיים לפעול, מודל נשמר ברישום המודלים. כדי לגשת אליו, ב- משאבי SageMaker חלונית, בחר רישום דגמים בתפריט הנפתח ובחר את הדגם שלך. זה חושף את רשימת הדגמים הרשומים, כפי שמוצג בצילום המסך הבא. בחר אחד כדי לפתוח את דף הפרטים עבור גרסת הדגם המסוים הזה.

לאחר פתיחת גרסה של הדגם, בחר עדכון מצב ו לאשר לאשר את הדגם.

בשלב זה, בהתבסס על מקרה השימוש שלך, אתה יכול להגדיר אישור זה כדי להפעיל פעולות נוספות, כולל פריסת המודל לפי הצרכים שלך.

פריסה ללא שרת של המודל

לאחר שאימנת ורשמה דגם ב- SageMaker, פריסת הדגם ב- SageMaker היא פשוטה.

ישנן מספר אפשרויות כיצד ניתן לפרוס מודל, כגון הסקת אצווה, נקודות קצה בזמן אמת או נקודות קצה אסינכרוניות. כל שיטה מגיעה עם מספר תצורות נדרשות, כולל בחירת סוג המופע הרצוי וכן מנגנון קנה המידה.

עבור דוגמה זו, אנו משתמשים בתכונה שהוכרזה לאחרונה של SageMaker, מסקנות ללא שרת (במצב תצוגה מקדימה נכון למועד הכתיבה), לפרוס את מודל ה-R שלנו בנקודת קצה ללא שרת. עבור סוג זה של נקודת קצה, אנו מגדירים רק את כמות ה-RAM שברצוננו שיוקצה למודל לצורך הסקת מסקנות, כמו גם את המספר המרבי של הפעלות בו-זמניות של המודל. SageMaker דואגת לאירוח הדגם ולשינוי קנה מידה אוטומטי לפי הצורך. אתה מחויב רק עבור המספר המדויק של שניות ונתונים המשמשים את הדגם, ללא עלות עבור זמן סרק.

אתה יכול לפרוס את המודל לנקודת קצה ללא שרת עם הקוד הבא:

אם אתה רואה את השגיאה ClientError: An error occurred (ValidationException) when calling the CreateModel operation: Invalid approval status "PendingManualApproval" הדגם שברצונך לפרוס לא אושר. בצע את השלבים מהסעיף הקודם כדי לאשר את הדגם שלך.

הפעל את נקודת הקצה על ידי שליחת בקשה לנקודת הקצה של HTTP שפרסנו, או במקום זאת השתמש ב-SageMaker SDK. בקוד הבא, אנו מפעילים את נקודת הקצה על כמה נתוני בדיקה:

נקודת הקצה שהפעלנו הייתה נקודת קצה ללא שרת, וככזו אנו מחויבים עבור משך הזמן המדויק והנתונים שבהם נעשה שימוש. ייתכן שתבחין שבפעם הראשונה שאתה מפעיל את נקודת הקצה לוקח בערך שנייה להגיב. זה נובע מזמן ההתחלה הקרה של נקודת הקצה ללא שרת. אם תבצע הזמנה נוספת זמן קצר לאחר מכן, המודל מחזיר את החיזוי בזמן אמת כי הוא כבר חם.

כשתסיים להתנסות בנקודת הקצה, תוכל למחוק אותה באמצעות הפקודה הבאה:

סיכום

בפוסט זה, עברנו על תהליך יצירת צינור SageMaker באמצעות R בסביבת RStudio שלנו והצגנו כיצד לפרוס את מודל ה-R שלנו בנקודת קצה ללא שרת ב- SageMaker באמצעות רישום המודל של SageMaker.

עם השילוב של RStudio ו- SageMaker, כעת תוכל ליצור ולתזמר זרימות עבודה מלאות של ML מקצה לקצה ב-AWS באמצעות השפה המועדפת עלינו, R.

כדי לצלול עמוק יותר לתוך פתרון זה, אני ממליץ לך לעיין בקוד המקור של פתרון זה, כמו גם דוגמאות אחרות, ב GitHub.

על המחבר

גאורגיוס שינאס הוא אדריכל פתרונות מומחה עבור AI/ML באזור EMEA. הוא מבוסס בלונדון ועובד בשיתוף פעולה הדוק עם לקוחות בבריטניה ובאירלנד. Georgios עוזר ללקוחות לתכנן ולפרוס יישומי למידת מכונה בייצור ב-AWS עם עניין מיוחד בפרקטיקות של MLOps ומאפשר ללקוחות לבצע למידת מכונה בקנה מידה. בזמנו הפנוי הוא נהנה לטייל, לבשל ולבלות עם חברים ובני משפחה.

גאורגיוס שינאס הוא אדריכל פתרונות מומחה עבור AI/ML באזור EMEA. הוא מבוסס בלונדון ועובד בשיתוף פעולה הדוק עם לקוחות בבריטניה ובאירלנד. Georgios עוזר ללקוחות לתכנן ולפרוס יישומי למידת מכונה בייצור ב-AWS עם עניין מיוחד בפרקטיקות של MLOps ומאפשר ללקוחות לבצע למידת מכונה בקנה מידה. בזמנו הפנוי הוא נהנה לטייל, לבשל ולבלות עם חברים ובני משפחה.

- AI

- איי אמנות

- מחולל אמנות ai

- איי רובוט

- אמזון SageMaker

- בינה מלאכותית

- הסמכת בינה מלאכותית

- בינה מלאכותית בבנקאות

- רובוט בינה מלאכותית

- רובוטים של בינה מלאכותית

- תוכנת בינה מלאכותית

- למידת מכונות AWS

- blockchain

- blockchain conference ai

- קוינגניוס

- בינה מלאכותית של שיחה

- קריפטו כנס ai

- של דאל

- למידה עמוקה

- גוגל איי

- למידת מכונה

- אפלטון

- plato ai

- מודיעין אפלטון

- משחק אפלטון

- אפלטון נתונים

- פלטוגיימינג

- סולם ai

- תחביר

- זפירנט