אדג ' הוא מונח המתייחס למיקום, רחוק מהענן או ממרכז נתונים גדול, שבו יש לך התקן מחשב (מכשיר קצה) המסוגל להריץ אפליקציות (קצה). מחשוב קצה הוא הפעולה של הפעלת עומסי עבודה במכשירי קצה אלה. למידת מכונה בקצה (ML@Edge) היא תפיסה שמביאה את היכולת להפעיל דגמי ML באופן מקומי למכשירי קצה. לאחר מכן ניתן להפעיל מודלים אלה של ML על ידי אפליקציית הקצה. ML@Edge חשוב עבור תרחישים רבים שבהם נתונים גולמיים נאספים ממקורות רחוקים מהענן. לתרחישים אלה עשויים להיות גם דרישות או הגבלות ספציפיות:

- תחזיות בזמן אמת עם אחזור נמוך

- קישוריות לקויה או לא קיימת לענן

- הגבלות משפטיות שאינן מאפשרות שליחת נתונים לשירותים חיצוניים

- מערכי נתונים גדולים שצריך לעבד מראש באופן מקומי לפני שליחת תגובות לענן

להלן כמה ממקרי שימוש רבים שיכולים להפיק תועלת מדגמי ML הפועלים קרוב לציוד שיוצר את הנתונים המשמשים לתחזיות:

- בטחון ובטיחות – אזור מוגבל שבו פועלות מכונות כבדות בנמל אוטומטי מנוטר על ידי מצלמה. אם אדם נכנס בטעות לאזור זה, מופעל מנגנון בטיחות לעצירת המכונות ולהגן על האדם.

- תחזוקה ניבוי - חיישני רטט ושמע אוספים נתונים מתיבת הילוכים של טורבינת רוח. מודל זיהוי חריגות מעבד את נתוני החיישן ומזהה אם יש חריגות בציוד. אם מזוהה חריגה, התקן הקצה יכול להתחיל מדידת מגירה בזמן אמת כדי למנוע פגיעה בציוד, כמו הפעלת הפסקות או ניתוק הגנרטור מהרשת.

- איתור ליקויים בקווי ייצור – מצלמה מצלמת תמונות של מוצרים על גבי מסוע ומעבדת את הפריימים עם מודל סיווג תמונה. אם מתגלה פגם, ניתן להשליך את המוצר באופן אוטומטי ללא התערבות ידנית.

למרות ש-ML@Edge יכול לתת מענה למקרי שימוש רבים, ישנם אתגרים אדריכליים מורכבים שצריכים להיפתר על מנת לקבל עיצוב מאובטח, חזק ואמין. בפוסט זה, אתה לומד כמה פרטים על ML@Edge, נושאים קשורים וכיצד להשתמש בשירותי AWS כדי להתגבר על האתגרים הללו ולהטמיע פתרון מלא עבור ה-ML שלך בעומס העבודה הקצה.

סקירה כללית של ML@Edge

קיים בלבול נפוץ כשמדובר ב-ML@Edge ובאינטרנט של הדברים (IoT), לכן חשוב להבהיר במה שונה ML@Edge מ-IoT וכיצד שניהם יכולים להתאחד כדי לספק פתרון רב עוצמה במקרים מסוימים.

לפתרון edge שמשתמש ב-ML@Edge יש שני מרכיבים עיקריים: אפליקציית edge ומודל ML (המופעל על ידי האפליקציה) הפועל על מכשיר הקצה. ML@Edge עוסק בשליטה במחזור החיים של מודל ML אחד או יותר הפרוסים לצי של התקני קצה. מחזור החיים של מודל ML יכול להתחיל בצד הענן (ב אמזון SageMaker, למשל) אך בדרך כלל מסתיים בפריסה עצמאית של הדגם במכשיר הקצה. כל תרחיש דורש מחזורי חיים שונים של מודל ML שיכול להיות מורכב על ידי שלבים רבים, כגון איסוף נתונים; הכנת נתונים; בניית מודל, קומפילציה ופריסה למכשיר הקצה; טעינה והרצה של דגם; וחזרה על מחזור החיים.

מנגנון ML@Edge אינו אחראי למחזור החיים של האפליקציה. לשם כך יש לנקוט בגישה שונה. ניתוק מחזור החיים של מודל ML ומחזור חיי היישום נותן לך את החופש והגמישות להמשיך ולפתח אותם בקצבים שונים. תארו לעצמכם אפליקציה לנייד שמטביעה מודל ML כמשאב כמו תמונה או קובץ XML. במקרה זה, בכל פעם שאתה מאמן דגם חדש וברצונך לפרוס אותו לטלפונים הניידים, עליך לפרוס מחדש את כל האפליקציה. זה גוזל זמן וכסף, ויכול להכניס באגים לאפליקציה שלך. על ידי ניתוק מחזור החיים של מודל ML, אתה מפרסם את האפליקציה לנייד פעם אחת ופרוס כמה גרסאות של מודל ML שאתה צריך.

אבל איך IoT מתאם ל-ML@Edge? IoT מתייחס לאובייקטים פיזיים המוטבעים בטכנולוגיות כמו חיישנים, יכולת עיבוד ותוכנה. אובייקטים אלו מחוברים להתקנים ומערכות אחרים דרך האינטרנט או רשתות תקשורת אחרות, על מנת להחליף נתונים. האיור הבא ממחיש את הארכיטקטורה הזו. הרעיון נוצר בהתחלה כשחושבים על מכשירים פשוטים שפשוט אוספים נתונים מהקצה, מבצעים עיבוד מקומי פשוט ושולחים את התוצאה ליחידת מחשוב חזקה יותר שמפעילה תהליכי אנליטיקה שעוזרים לאנשים ולחברות בקבלת ההחלטות שלהם. פתרון ה-IoT אחראי לשליטה במחזור החיים של יישום הקצה. למידע נוסף על IoT, עיין ב אינטרנט של דברים.

אם כבר יש לך יישום IoT, אתה יכול להוסיף יכולות ML@Edge כדי להפוך את המוצר ליעיל יותר, כפי שמוצג באיור הבא. זכור ש-ML@Edge לא תלוי ב-IoT, אבל אתה יכול לשלב אותם כדי ליצור פתרון חזק יותר. כשאתה עושה זאת, אתה משפר את הפוטנציאל של המכשיר הפשוט שלך לייצר תובנות בזמן אמת עבור העסק שלך מהר יותר מאשר רק שליחת נתונים לענן לעיבוד מאוחר יותר.

אם אתה יוצר פתרון קצה חדש מאפס עם יכולות ML@Edge, חשוב לתכנן ארכיטקטורה גמישה שתומכת הן במחזור החיים של היישום והן במודל ML. אנו מספקים כמה ארכיטקטורות ייחוס עבור יישומי קצה עם ML@Edge בהמשך הפוסט הזה. אבל ראשית, בואו נצלול עמוק יותר לתוך מחשוב קצה ונלמד כיצד לבחור את התקן הקצה המתאים לפתרון שלכם, בהתבסס על מגבלות הסביבה.

מחשוב קצה

בהתאם למרחק המכשיר מהענן או ממרכז נתונים גדול (בסיס), יש לקחת בחשבון שלושה מאפיינים עיקריים של מכשירי הקצה כדי למקסם את הביצועים ואריכות החיים של המערכת: קיבולת מחשוב ואחסון, קישוריות וצריכת חשמל. התרשים הבא מציג שלוש קבוצות של התקני קצה המשלבים מפרטים שונים של מאפיינים אלה, בהתאם למרחקים מהם מהבסיס.

הקבוצות הן כדלקמן:

- MECs (Multi-Access Edge Computing) - MECs או מרכזי נתונים קטנים, המאופיינים בהשהייה נמוכה או נמוכה במיוחד ורוחב פס גבוה, הן סביבות נפוצות שבהן ML@Edge יכול להביא יתרונות ללא הגבלות גדולות בהשוואה לעומסי עבודה בענן. אנטנות ושרתים של 5G במפעלים, מחסנים, מעבדות וכן הלאה עם מגבלות אנרגיה מינימליות ועם קישוריות אינטרנט טובה מציעים דרכים שונות להפעיל דגמי ML על GPUs ו-CPUs, מכונות וירטואליות, קונטיינרים ושרתי מתכת חשופה.

- קרוב לקצה - זה כאשר ניידות או צבירת נתונים הם דרישות ולמכשירים יש אילוצים מסוימים לגבי צריכת חשמל וכוח עיבוד, אך עדיין יש להם קישוריות מהימנה, אם כי עם חביון גבוה יותר, עם תפוקה מוגבלת ויקרה יותר מ"קרוב לקצה". יישומים ניידים, לוחות ספציפיים להאצת דגמי ML, או מכשירים פשוטים בעלי יכולת להפעיל דגמי ML, המכוסים על ידי רשתות אלחוטיות, כלולים בקבוצה זו.

- קצה רחוק - בתרחיש קיצוני זה, למכשירי קצה יש מגבלות צריכת חשמל או קישוריות חמורות. כתוצאה מכך, כוח העיבוד מוגבל גם בתרחישי קצה רחוקים רבים. חקלאות, כרייה, מעקב ואבטחה ותחבורה ימית הם כמה תחומים שבהם התקני קצה רחוקים ממלאים תפקיד חשוב. לוחות פשוטים, בדרך כלל ללא GPUs או מאיצי AI אחרים, הם נפוצים. הם מתוכננים לטעון ולהריץ מודלים פשוטים של ML, לשמור את התחזיות במסד נתונים מקומי ולישון עד למחזור החיזוי הבא. למכשירים שצריכים לעבד נתונים בזמן אמת יכולים להיות אחסון מקומי גדול כדי למנוע אובדן נתונים.

אתגרים

זה נפוץ שיש תרחישי ML@Edge שבהם יש לך מאות או אלפי (אולי אפילו מיליוני) מכשירים המריצים את אותם דגמים ויישומי קצה. כאשר אתה מרחיב את המערכת שלך, חשוב שיהיה לך פתרון חזק שיכול לנהל את מספר המכשירים שאתה צריך לתמוך בהם. זוהי משימה מורכבת ועבור תרחישים אלה, עליך לשאול שאלות רבות:

- כיצד אוכל להפעיל דגמי ML בצי מכשירים בקצה?

- כיצד אוכל לבנות, לייעל ולפרוס דגמי ML למכשירי קצה מרובים?

- איך אני מאבטח את הדגם שלי בזמן פריסה והפעלתו בקצה?

- כיצד אוכל לעקוב אחר הביצועים של הדגם שלי ולאמן אותו מחדש, במידת הצורך?

- איך אני מבטל את הצורך בהתקנת מסגרת גדולה כמו TensorFlow או PyTorch במכשיר המוגבל שלי?

- כיצד אוכל לחשוף מודל אחד או מודלים רבים עם אפליקציית הקצה שלי כ-API פשוט?

- כיצד אוכל ליצור מערך נתונים חדש עם המטענים והתחזיות שנלכדו על ידי מכשירי הקצה?

- כיצד אוכל לבצע את כל המשימות הללו באופן אוטומטי (MLOps פלוס ML@Edge)?

בחלק הבא, אנו מספקים תשובות לכל השאלות הללו באמצעות מקרי שימוש לדוגמה וארכיטקטורות התייחסות. אנו גם דנים באילו שירותי AWS אתה יכול לשלב כדי לבנות פתרונות מלאים עבור כל אחד מהתרחישים שנחקרו. עם זאת, אם אתה רוצה להתחיל עם זרימה פשוטה מאוד המתארת כיצד להשתמש בחלק מהשירותים שמספקת AWS כדי ליצור את פתרון ML@Edge שלך, זו דוגמה:

עם SageMaker, אתה יכול בקלות להכין מערך נתונים ולבנות את דגמי ה-ML שנפרסים למכשירי הקצה. עם אמזון SageMaker Neo, תוכל להרכיב ולמטב את הדגם שאימנת למכשיר הקצה הספציפי שבחרת. לאחר קומפילציה של המודל, אתה צריך רק זמן ריצה קל כדי להפעיל אותו (מסופק על ידי השירות). מנהל הקצה של אמזון SageMaker אחראי על ניהול מחזור החיים של כל דגמי ה-ML הפרוסים בצי מכשירי הקצה שלך. Edge Manager יכול לנהל ציים של עד מיליוני מכשירים. סוכן, המותקן בכל אחד מהתקני הקצה, חושף את דגמי ה-ML הפרוסים כ-API לאפליקציה. הסוכן אחראי גם לאיסוף מדדים, מטענים ותחזיות שתוכל להשתמש בהם לניטור או בניית מערך נתונים חדש כדי לאמן מחדש את המודל במידת הצורך. לבסוף, עם צינורות SageMaker של אמזון, אתה יכול ליצור צינור אוטומטי עם כל השלבים הנדרשים לבנייה, אופטימיזציה ופריסה של מודלים של ML בצי המכשירים שלך. הצינור האוטומטי הזה יכול להיות מופעל על ידי אירועים פשוטים שאתה מגדיר, ללא התערבות אנושית.

השתמש במקרה 1

נניח שיצרן מטוס רוצה לזהות ולעקוב אחר חלקים וכלים בהאנגר הייצור. כדי לשפר את הפרודוקטיביות, כל החלקים הנדרשים והכלים הנכונים צריכים להיות זמינים עבור המהנדסים בכל שלב של ייצור. אנחנו רוצים להיות מסוגלים לענות על שאלות כמו: איפה חלק א'? או איפה כלי ב'? יש לנו כבר מספר מצלמות IP מותקנות ומחוברות לרשת מקומית. המצלמות מכסות את כל ההאנגר ויכולות להזרים וידאו HD בזמן אמת דרך הרשת.

AWS פנורמה משתלב יפה במקרה הזה. AWS Panorama מספקת מכשיר ML ושירות מנוהל המאפשרים לך להוסיף ראייה ממוחשבת (CV) לצי מצלמות ה-IP הקיים שלך ולבצע אוטומציה. AWS Panorama מעניקה לך את היכולת להוסיף קורות חיים למצלמות פרוטוקול האינטרנט (IP) הקיימות שלך ולהפוך משימות לאוטומטיות שדורשות באופן מסורתי בדיקה וניטור אנושיים.

בארכיטקטורת ההתייחסות הבאה, אנו מציגים את הרכיבים העיקריים של היישום הפועל על AWS Panorama Appliance. ה-SDK של אפליקציות פנורמה מקל על צילום וידאו מזרמי מצלמה, ביצוע הסקה עם צינור של דגמי ML מרובים, ועיבוד התוצאות באמצעות קוד Python הפועל בתוך מיכל. אתה יכול להריץ מודלים מכל ספריית ML פופולרית כגון TensorFlow, PyTorch או TensorRT. ניתן לשלב את התוצאות מהמודל עם מערכות עסקיות ברשת המקומית שלך, ולאפשר לך להגיב לאירועים בזמן אמת.

הפתרון מורכב מהשלבים הבאים:

- חבר והגדר מכשיר AWS Panorama לאותה רשת מקומית.

- אימון מודל ML (זיהוי אובייקטים) לזיהוי חלקים וכלים בכל מסגרת.

- בנו אפליקציית AWS Panorama שמקבלת את התחזיות ממודל ה-ML, מחילה מנגנון מעקב על כל אובייקט ושולחת את התוצאות למסד נתונים בזמן אמת.

- המפעילים יכולים לשלוח שאילתות למסד הנתונים כדי לאתר את החלקים והכלים.

השתמש במקרה 2

במקרה השימוש הבא שלנו, דמיינו שאנחנו יוצרים מצלמת דשבורים לכלי רכב המסוגלת לתמוך בנהג במצבים רבים, כמו הימנעות מהולכי רגל, על בסיס לוח CV25 מבית Ambaralla. אירוח דגמי ML במכשיר עם משאבי מערכת מוגבלים יכול להיות קשה. במקרה זה, הבה נניח שכבר יש לנו מנגנון אספקה מבוסס היטב (OTA) כדי לפרוס את רכיבי היישום הדרושים על התקן הקצה. עם זאת, עדיין נרוויח מהיכולת לבצע פריסת OTA של המודל עצמו, ובכך לבודד את מחזור החיים של האפליקציה ומחזור החיים של המודל.

מנהל הקצה של אמזון SageMaker ו אמזון SageMaker Neo מתאים היטב למקרה שימוש זה.

Edge Manager מקל על מפתחי ML Edge להשתמש באותם כלים מוכרים בענן או במכשירי Edge. זה מקטין את הזמן והמאמץ הנדרשים כדי להביא דגמים לייצור, תוך שהוא מאפשר לך לנטר ולשפר את איכות הדגמים באופן רציף בכל צי המכשירים שלך. SageMaker Edge כולל מנגנון פריסת OTA שעוזר לך לפרוס דגמים בצי ללא תלות באפליקציה או קושחת המכשיר. ה סוכן מנהל הקצה מאפשר לך להפעיל מספר דגמים על אותו מכשיר. הסוכן אוסף נתוני חיזוי על סמך ההיגיון שבו אתה שולט, כגון מרווחים, ומעלה אותם לענן כך שתוכל לאמן מחדש את המודלים שלך מעת לעת לאורך זמן. SageMaker Edge חותם באופן קריפטוגרפי על הדגמים שלך כדי שתוכל לוודא שלא התעסק בהם בזמן שהוא עובר מהענן למכשיר הקצה.

Neo הוא מהדר כשירות ומתאים במיוחד במקרה השימוש הזה. Neo מבצעת אופטימיזציה אוטומטית של דגמי ML להסקת מסקנות על מופעי ענן ומכשירי קצה כדי לרוץ מהר יותר ללא אובדן דיוק. אתה מתחיל עם מודל ML שנבנה עם אחד מהם מסגרות נתמכות והוכשרה ב- SageMaker או בכל מקום אחר. לאחר מכן אתה בוחר את פלטפורמת החומרה היעד שלך, (עיין ברשימה של מכשירים נתמכים). בלחיצה אחת, Neo מייעל את הדגם המאומן ומרכיב אותו לחבילה שניתן להפעיל באמצעות זמן הריצה קל משקל SageMaker Edge. המהדר משתמש במודל ML כדי ליישם את אופטימיזציות הביצועים המחלצות את הביצועים הזמינים הטובים ביותר עבור הדגם שלך במופע הענן או במכשיר הקצה. לאחר מכן, אתה פורס את המודל כנקודת קצה של SageMaker או במכשירי קצה נתמכים ומתחיל לבצע תחזיות.

התרשים הבא ממחיש ארכיטקטורה זו.

זרימת העבודה של הפתרון מורכבת מהשלבים הבאים:

- המפתח בונה, מאמן, מאמת ויוצר את חפץ הדגם הסופי שצריך לפרוס למצלמת הדשב.

- הפעל את Neo כדי להרכיב את המודל המאומן.

- סוכן SageMaker Edge מותקן ומוגדר במכשיר ה-Edge, במקרה זה מצלמת הדשבורים.

- צור חבילת פריסה עם מודל חתום וזמן הריצה המשמש את סוכן SageMaker Edge כדי לטעון ולהפעיל את המודל הממוטב.

- פרוס את החבילה באמצעות מנגנון הפריסה הקיים של OTA.

- אפליקציית הקצה מקיימת אינטראקציה עם סוכן SageMaker Edge כדי לעשות מסקנות.

- ניתן להגדיר את הסוכן (אם נדרש) לשלוח נתוני קלט לדוגמה בזמן אמת מהאפליקציה למטרות ניטור וחידוד מודל.

השתמש במקרה 3

נניח שהלקוח שלך מפתח אפליקציה שמזהה חריגות במנגנונים של טורבינת רוח (כמו תיבת ההילוכים, הגנרטור או הרוטור). המטרה היא למזער את הנזק לציוד על ידי הפעלת נהלי הגנה מקומיים תוך כדי תנועה. הטורבינות הללו יקרות מאוד וממוקמות במקומות שאינם נגישים בקלות. ניתן להצטייד בכל טורבינה במכשיר NVIDIA Jetson לניטור נתוני חיישנים מהטורבינה. לאחר מכן אנו זקוקים לפתרון ללכידת הנתונים ולהשתמש באלגוריתם ML כדי לזהות חריגות. אנחנו צריכים גם מנגנון OTA כדי לעדכן את התוכנה ודגמי ה-ML במכשיר.

AWS IoT Greengrass V2 יחד עם Edge Manager מתאימים היטב במקרה השימוש הזה. AWS IoT Greengrass הוא שירות זמן ריצה וענן בקוד פתוח של IoT Edge שעוזר לך לבנות, לפרוס ולנהל יישומי IoT במכשירים שלך. אתה יכול להשתמש ב-AWS IoT Greengrass כדי לבנות יישומי קצה באמצעות מודולי תוכנה מובנים מראש, הנקראים רכיבים, שיכול לחבר את מכשירי הקצה שלך לשירותי AWS או לשירותי צד שלישי. היכולת הזו של AWS IoT Greengrass מקלה על פריסת נכסים למכשירים, כולל סוכן SageMaker Edge. AWS IoT Greengrass אחראי על ניהול מחזור החיים של האפליקציה, בעוד Edge Manager מנתק את מחזור החיים של מודל ה-ML. זה נותן לך את הגמישות להמשיך ולפתח את הפתרון כולו על ידי פריסת גרסאות חדשות של אפליקציית הקצה ודגמי ML באופן עצמאי. התרשים הבא ממחיש ארכיטקטורה זו.

הפתרון מורכב מהשלבים הבאים:

- היזם בונה, מאמן, מאמת ויוצר את חפץ הדגם הסופי שצריך לפרוס לטורבינת הרוח.

- הפעל את Neo כדי להרכיב את המודל המאומן.

- צור רכיב דגם באמצעות Edge Manager עם שילוב AWS IoT Greengrass V2.

- הגדר את AWS IoT Greengrass V2.

- צור רכיב מסקנות באמצעות AWS IoT Greengrass V2.

- אפליקציית הקצה מקיימת אינטראקציה עם סוכן SageMaker Edge כדי לעשות מסקנות.

- ניתן להגדיר את הסוכן (אם נדרש) לשלוח נתוני קלט לדוגמה בזמן אמת מהאפליקציה למטרות ניטור וחידוד מודל.

השתמש במקרה 4

למקרה השימוש הסופי שלנו, בואו נסתכל על כלי שיט המוביל מכולות, כאשר לכל מכולה יש כמה חיישנים ומזרימה אות לתשתית המחשוב והאחסון הפרוסה באופן מקומי. האתגר הוא שאנו רוצים לדעת את התוכן של כל מכולה, ואת מצב הסחורה על סמך טמפרטורה, לחות וגזים בתוך כל מכולה. אנחנו גם רוצים לעקוב אחר כל הסחורה בכל אחת מהמכולות. אין חיבור לאינטרנט לאורך כל ההפלגה, וההפלגה יכולה להימשך חודשים. מודלים של ML הפועלים על תשתית זו צריכים לעבד מראש את הנתונים ולייצר מידע כדי לענות על כל השאלות שלנו. הנתונים שנוצרו צריכים להישמר באופן מקומי במשך חודשים. אפליקציית הקצה מאחסנת את כל המסקנות במסד נתונים מקומי ולאחר מכן מסנכרנת את התוצאות עם הענן כאשר כלי השיט מתקרב לנמל.

AWS Snowcone ו כדור השלג של AWS מ משפחת שלג AWS יכול להתאים מאוד במקרה השימוש הזה.

AWS Snowcone הוא מכשיר קטן, מחוספס ומאובטח מחשוב קצה והעברת נתונים. Snowcone תוכנן לפי תקן OSHA עבור מכשיר הניתן להרמה לאדם אחד. Snowcone מאפשר לך להפעיל עומסי עבודה קצה באמצעות ענן מחשוב אלסטי של אמזון (Amazon EC2) מחשוב ואחסון מקומי בסביבות שטח קשות ומנותקות כמו אסדות נפט, רכבי חיפוש והצלה, אתרים צבאיים או קומות מפעלים, כמו גם משרדים מרוחקים, בתי חולים ובתי קולנוע.

Snowball מוסיף יותר מחשוב בהשוואה ל-Snowcone ולכן עשוי להתאים ליישומים תובעניים יותר. תכונת Compute Optimized מספקת NVIDIA Tesla V100 GPU אופציונלי יחד עם מופעי EC2 כדי להאיץ את ביצועי האפליקציה בסביבות מנותקות. עם אפשרות ה-GPU, אתה יכול להפעיל יישומים כמו ML מתקדם וניתוח וידאו מלא בסביבות עם קישוריות מועטה או ללא קישוריות.

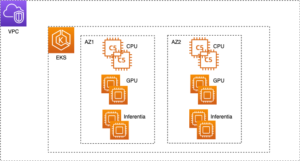

בנוסף למופע EC2, יש לך את החופש לבנות ולפרוס כל סוג של פתרון קצה. לדוגמה: אתה יכול להשתמש אמזון ECS או מנהל קונטיינר אחר כדי לפרוס את אפליקציית ה-Edge, Edge Manager Agent ומודל ה-ML כמכולות בודדות. ארכיטקטורה זו תהיה דומה ל-Use Case 2 (פרט לכך שהיא תעבוד במצב לא מקוון רוב הזמן), עם תוספת של כלי למנהל מיכל.

התרשים הבא ממחיש את ארכיטקטורת הפתרון הזו.

כדי ליישם פתרון זה, פשוט הזמינו את מכשיר הסנו שלכם מה- קונסולת הניהול של AWS ולהפעיל את המשאבים שלך.

סיכום

בפוסט זה, דנו בהיבטים השונים של קצה שאתה עשוי לבחור לעבוד איתם בהתבסס על מקרה השימוש שלך. דנו גם בכמה מהמושגים המרכזיים סביב ML@Edge וכיצד ניתוק מחזור החיים של האפליקציה ומחזור החיים של מודל ML נותן לך את החופש לפתח אותם ללא תלות זה בזה. הדגשנו כיצד בחירת מכשיר הקצה הנכון לעומס העבודה שלך ושאלת השאלות הנכונות במהלך תהליך הפתרון יכולים לעזור לך לעבוד אחורה ולצמצם את שירותי ה-AWS הנכונים. הצגנו גם מקרי שימוש שונים יחד עם ארכיטקטורות התייחסות כדי לעורר בך השראה ליצור פתרונות משלך שיעבדו עבור עומס העבודה שלך.

על הכותבים

דינש קומאר סוברמאני הוא אדריכל פתרונות בכיר בצוות UKIR SMB, שבסיסו באדינבורו, סקוטלנד. הוא מתמחה בבינה מלאכותית ולמידת מכונה. Dinesh נהנית לעבוד עם לקוחות בכל תעשיות כדי לעזור להם לפתור את הבעיות שלהם עם שירותי AWS. מחוץ לעבודה, הוא אוהב לבלות עם משפחתו, לשחק שח וליהנות ממוזיקה חוצה ז'אנרים.

דינש קומאר סוברמאני הוא אדריכל פתרונות בכיר בצוות UKIR SMB, שבסיסו באדינבורו, סקוטלנד. הוא מתמחה בבינה מלאכותית ולמידת מכונה. Dinesh נהנית לעבוד עם לקוחות בכל תעשיות כדי לעזור להם לפתור את הבעיות שלהם עם שירותי AWS. מחוץ לעבודה, הוא אוהב לבלות עם משפחתו, לשחק שח וליהנות ממוזיקה חוצה ז'אנרים.

סמיר אראוג'ו הוא אדריכל פתרונות AI / ML ב- AWS. הוא עוזר ללקוחות ליצור פתרונות AI / ML אשר פותרים את האתגרים העסקיים שלהם באמצעות AWS. הוא עבד על כמה פרויקטים של AI / ML הקשורים בראיית מחשב, עיבוד שפה טבעית, חיזוי, ML בקצה ועוד. הוא אוהב לשחק בפרויקטים של חומרה ואוטומציה בזמנו הפנוי, ויש לו עניין מיוחד ברובוטיקה.

סמיר אראוג'ו הוא אדריכל פתרונות AI / ML ב- AWS. הוא עוזר ללקוחות ליצור פתרונות AI / ML אשר פותרים את האתגרים העסקיים שלהם באמצעות AWS. הוא עבד על כמה פרויקטים של AI / ML הקשורים בראיית מחשב, עיבוד שפה טבעית, חיזוי, ML בקצה ועוד. הוא אוהב לשחק בפרויקטים של חומרה ואוטומציה בזמנו הפנוי, ויש לו עניין מיוחד ברובוטיקה.

- "

- 100

- 5G

- a

- יכולת

- אודות

- להאיץ

- מאיצים

- נגיש

- לרוחב

- לפעול

- תוספת

- כתובת

- מתקדם

- חקלאות

- AI

- אַלגוֹרִיתְם

- תעשיות

- מאפשר

- מאפשר

- כְּבָר

- למרות

- אמזון בעברית

- אנליזה

- ניתוח

- לענות

- בְּכָל מָקוֹם

- API

- האפליקציה

- בקשה

- יישומים

- החל

- גישה

- גישות

- אדריכלי

- ארכיטקטורה

- AREA

- סביב

- מלאכותי

- בינה מלאכותית

- בינה מלאכותית ולמידה מכונה

- נכסים

- אודיו

- אוטומטי

- אוטומטי

- באופן אוטומטי

- אוטומציה

- זמין

- הימנעות

- AWS

- לפני

- תועלת

- הטבות

- הטוב ביותר

- נתונים גדולים

- לוּחַ

- הפסקות

- להביא

- באגים

- לִבנוֹת

- בִּניָן

- בונה

- עסקים

- מצלמות

- יכולות

- מסוגל

- קיבולת

- ללכוד

- לוכדת

- מקרה

- מקרים

- מסוים

- לאתגר

- האתגרים

- שחמט

- בחרו

- מיון

- ענן

- קוד

- לגבות

- איסוף

- אוסף

- איך

- Common

- תקשורת

- חברות

- לעומת

- להשלים

- מורכב

- רְכִיב

- רכיבים

- מורכב

- לחשב

- המחשב

- מחשוב

- מושג

- מצב

- בלבול

- לְחַבֵּר

- מחובר

- קישוריות

- צְרִיכָה

- מכולה

- מכולות

- תוכן

- לִשְׁלוֹט

- יכול

- זוג

- לכסות

- לִיצוֹר

- נוצר

- יוצר

- יוצרים

- לקוח

- לקוחות

- נתונים

- מרכז נתונים

- מסד נתונים

- עמוק יותר

- מסירה

- דרישות

- תלוי

- לפרוס

- פרס

- פריסה

- פריסה

- עיצוב

- מעוצב

- פרטים

- זוהה

- איתור

- מפתח

- מפתחים

- מתפתח

- מכשיר

- התקנים

- אחר

- קשה

- לדון

- לא

- מטה

- נהג

- בְּמַהֲלָך

- כל אחד

- בקלות

- אדג '

- קצה

- יעיל

- מאמץ

- בוטל

- מוטבע

- הדגיש

- מאפשר

- נקודת קצה

- מסתיים

- אנרגיה

- לעסוק

- מהנדסים

- נכנס

- סביבה

- ציוד

- במיוחד

- אירועים

- להתפתח

- מתפתח

- דוגמה

- אלא

- חליפין

- קיימים

- קיצוני

- מפעלים

- מפעל

- מוכר

- משפחה

- מהר יותר

- מאפיין

- תרשים

- בסופו של דבר

- ראשון

- מתאים

- צי

- גמישות

- גמיש

- תזרים

- הבא

- כדלקמן

- מסגרת

- מסגרת

- חופשי

- חופש

- החל מ-

- מלא

- ליצור

- נוצר

- גנרטור

- מטרה

- טוב

- סחורות

- GPU

- GPUs

- גדול

- רֶשֶׁת

- קְבוּצָה

- קבוצה

- חומרה

- לעזור

- עוזר

- גָבוֹהַ

- גבוה יותר

- בתי חולים

- אירוח

- איך

- איך

- אולם

- HTTPS

- בן אנוש

- מאות

- לזהות

- תמונה

- תמונות

- ליישם

- חשוב

- לשפר

- כלול

- כולל

- כולל

- עצמאי

- באופן עצמאי

- בנפרד

- תעשיות

- מידע

- תשתית

- קלט

- תובנות

- למשל

- משולב

- השתלבות

- מוֹדִיעִין

- אינטרס

- אינטרנט

- אינטרנט של דברים

- IOT

- IP

- IT

- עצמו

- שמור

- מפתח

- לדעת

- שפה

- לשגר

- לִלמוֹד

- למידה

- סִפְרִיָה

- מחזורי חיים

- אוֹר

- קַל מִשְׁקָל

- מוגבל

- קווים

- רשימה

- קְצָת

- לִטעוֹן

- טוען

- מקומי

- באופן מקומי

- מיקום

- נראה

- מכונה

- למידת מכונה

- מכונה

- גדול

- לעשות

- עושה

- עשייה

- לנהל

- הצליח

- ניהול

- מנהל

- ניהול

- מדריך ל

- יַצרָן

- מנגנון

- מדדים

- צבאי

- מיליונים

- אכפת לי

- כרייה

- ML

- סלולרי

- אפליקציה לנייד

- אפליקציות ניידות

- טלפונים ניידים

- ניידות

- מודל

- מודלים

- כסף

- צג

- ניטור

- חודשים

- יותר

- רוב

- סרט

- מספר

- כלי נגינה

- טבעי

- צרכי

- NEO

- רשת

- רשתות

- הבא

- בדרך כלל

- מספר

- Nvidia

- הַצָעָה

- משרדים

- לא מחובר

- שמן

- להפעיל

- מפעילי

- מטב

- אופטימיזציה

- אפשרות

- להזמין

- אחר

- שֶׁלוֹ

- חבילה

- חלק

- מסוים

- אֲנָשִׁים

- ביצועים

- אדם

- טלפונים

- גופני

- פלטפורמה

- לְשַׂחֵק

- משחק

- פופולרי

- פוטנציאל

- כּוֹחַ

- חזק

- נבואה

- התחזיות

- להכין

- בעיות

- תהליך

- תהליכים

- תהליך

- המוצר

- הפקה

- פִּריוֹן

- מוצרים

- פרויקטים

- להגן

- .

- פרוטוקול

- לספק

- ובלבד

- מספק

- לפרסם

- מטרה

- למטרות

- איכות

- חי

- זמן אמת

- נתונים בזמן אמת

- מתייחס

- בדבר

- אָמִין

- מרחוק

- לדרוש

- נדרש

- דרישות

- משאב

- משאבים

- אחראי

- הגבלות

- תוצאות

- רובוטיקה

- תפקיד

- הפעלה

- ריצה

- בְּטִיחוּת

- אותו

- סולם

- Sdk

- חיפוש

- לבטח

- אבטחה

- שרות

- שירותים

- כמה

- הראה

- שלטים

- דומה

- פָּשׁוּט

- יחיד

- אתרים

- לִישׁוֹן

- קטן

- שלג

- So

- תוכנה

- פִּתָרוֹן

- פתרונות

- לפתור

- כמה

- מתמחה

- ספציפי

- מפרטים

- הוצאה

- התמחות

- שלבים

- עצמאי

- תֶקֶן

- התחלה

- עוד

- אחסון

- חנויות

- זרם

- תמיכה

- נתמך

- מסייע

- תומך

- מעקב

- מערכת

- מערכות

- יעד

- משימות

- נבחרת

- טכנולוגיות

- טסלה

- השמיים

- בכך

- לכן

- דברים

- חושב

- צד שלישי

- אלפים

- שְׁלוֹשָׁה

- דרך

- בכל

- תפוקה

- זמן

- יַחַד

- כלי

- כלים

- חלק עליון

- נושאים

- לעקוב

- מעקב

- באופן מסורתי

- רכבות

- הובלה

- מופעל

- אחדות

- להשתמש

- כלי רכב

- לאמת

- וִידֵאוֹ

- וירטואלי

- חזון

- דרכים

- בזמן

- ויקיפדיה

- רוח

- אלחוטי

- לְלֹא

- תיק עבודות

- עובד

- היה

- XML