מבוא

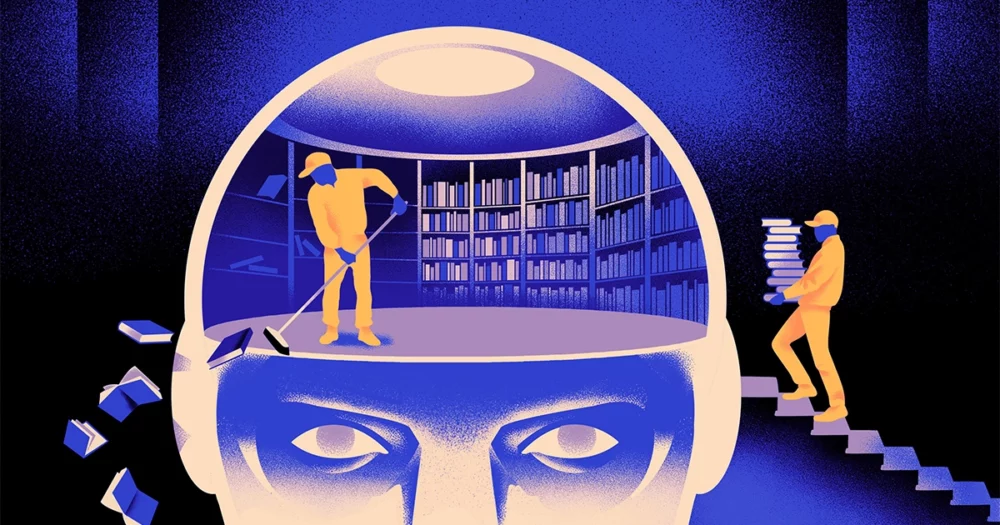

צוות של מדעני מחשב יצר א סוג זריז, גמיש יותר של מודל למידת מכונה. הטריק: הוא חייב מדי פעם לשכוח את מה שהוא יודע. ולמרות שגישה חדשה זו לא תחליף את הדגמים הענקיים שעומדים בבסיס האפליקציות הגדולות ביותר, היא יכולה לחשוף יותר על האופן שבו תוכניות אלו מבינות שפה.

המחקר החדש מסמן "התקדמות משמעותית בתחום", אמר ז'ה קוון, מהנדס בינה מלאכותית במכון למדע בסיסי בדרום קוריאה.

מנועי שפת הבינה המלאכותית הנמצאים בשימוש כיום מופעלים בעיקר על ידי רשתות עצביות מלאכותיות. כל "נוירון" ברשת הוא פונקציה מתמטית שמקבלת אותות מתאי עצב אחרים, מפעילה כמה חישובים ושולחת אותות דרך מספר שכבות של נוירונים. בתחילה זרימת המידע היא אקראית פחות או יותר, אך באמצעות אימון, זרימת המידע בין נוירונים משתפרת ככל שהרשת מסתגלת לנתוני האימון. אם חוקרת בינה מלאכותית רוצה ליצור מודל דו לשוני, למשל, היא תאמן את המודל עם ערימה גדולה של טקסט משתי השפות, שתתאים את הקשרים בין נוירונים בצורה כזו שתקשר את הטקסט בשפה אחת עם מקבילה מילים באחר.

אבל תהליך האימון הזה דורש כוח מחשוב רב. אם הדגם לא עובד טוב במיוחד, או אם הצרכים של המשתמש משתנים בהמשך, קשה להתאים אותו. "נניח שיש לך מודל שיש לו 100 שפות, אבל תאר לעצמך ששפה אחת שאתה רוצה לא מכוסה", אמר מיקל ארטקס, מחבר שותף של המחקר החדש ומייסד סטארט-אפ הבינה המלאכותית Reka. "אתה יכול להתחיל מחדש מאפס, אבל זה לא אידיאלי."

ארטקס ועמיתיו ניסו לעקוף מגבלות אלו. לפני כמה שנים, Artetxe ואחרים אימנו רשת עצבית בשפה אחת, ואז מחקו את מה שהיא ידעה על אבני הבניין של מילים, המכונות אסימונים. אלה מאוחסנים בשכבה הראשונה של הרשת העצבית, הנקראת שכבת הטבעה. הם השאירו את כל שאר השכבות של הדגם לבד. לאחר מחיקת האסימונים של השפה הראשונה, הם אימנו מחדש את המודל על השפה השנייה, שמילאה את שכבת ההטמעה באסימונים חדשים מאותה שפה.

למרות שהמודל הכיל מידע לא תואם, ההכשרה מחדש עבדה: המודל יכול היה ללמוד ולעבד את השפה החדשה. החוקרים שיערו שבעוד ששכבת ההטמעה אוגרת מידע ספציפי למילים המשמשות בשפה, ברמות העמוקות של הרשת אוחסנו מידע מופשט יותר על המושגים שמאחורי שפות אנושיות, מה שעזר אז למודל ללמוד את השפה השנייה.

"אנחנו חיים באותו עולם. אנחנו משיגים את אותם דברים עם מילים שונות" בשפות שונות, אמר Yihong Chen, המחבר הראשי של המאמר האחרון. "בגלל זה יש לך את אותה הנמקה ברמה גבוהה במודל. תפוח הוא משהו מתוק ועסיסי, במקום רק מילה".

מבוא

בעוד שגישת השכחה הזו הייתה דרך יעילה להוסיף שפה חדשה למודל שכבר הוכשר, ההכשרה מחדש עדיין הייתה תובענית - היא דרשה הרבה נתונים לשוניים וכוח עיבוד. חן הציע תיקון: במקום לאמן, למחוק את שכבת ההטמעה, ואז לאמן מחדש, עליהם לאפס מעת לעת את שכבת ההטמעה במהלך סבב האימון הראשוני. "על ידי כך, המודל כולו מתרגל לאיפוס", אמר Artetxe. "זה אומר שכשאתה רוצה להרחיב את המודל לשפה אחרת, זה קל יותר, כי זה מה שעשית."

החוקרים לקחו מודל שפה נפוץ שנקרא רוברטה, אימנו אותו באמצעות טכניקת השכחה התקופתית שלהם, והשוו אותו לביצועים של אותו דגם כאשר הוא אומן בגישה הסטנדרטית, ללא השכחה. מודל השכחה הצליח מעט יותר מהרגיל, וקיבל ציון של 85.1 בהשוואה ל-86.1 במדד נפוץ אחד של דיוק השפה. אחר כך הם אימנו מחדש את המודלים בשפות אחרות, תוך שימוש במערכות נתונים קטנות בהרבה של 5 מיליון אסימונים בלבד, ולא ב-70 מיליארד שהם השתמשו בהם במהלך האימון הראשון. הדיוק של הדגם הסטנדרטי ירד ל-53.3 בממוצע, אך הדגם הנשכח ירד רק ל-62.7.

מודל השכחה גם הצליח הרבה יותר אם הצוות הטיל מגבלות חישוביות במהלך הסבה מחדש. כאשר החוקרים קיצצו את אורך האימון מ-125,000 צעדים ל-5,000 בלבד, הדיוק של מודל השכחה ירד ל-57.8 בממוצע, בעוד המודל הסטנדרטי צלל ל-37.2, וזה לא יותר מאשר ניחושים אקראיים.

מבוא

הצוות הגיע למסקנה שנראה כי שכחה תקופתית הופכת את המודל לטוב יותר בלימוד שפות באופן כללי. "מכיוון ש[הם] ממשיכים לשכוח וללמוד מחדש במהלך האימון, ללמד את הרשת משהו חדש מאוחר יותר נעשה קל יותר", אמר יבגני ניקישין, חוקר במילה, מרכז מחקר ללמידה עמוקה בקוויבק. זה מציע שכאשר מודלים של שפה מבינים שפה, הם עושים זאת ברמה עמוקה יותר מאשר רק המשמעויות של מילים בודדות.

הגישה דומה לאופן שבו פועל המוח שלנו. "זיכרון אנושי באופן כללי אינו טוב במיוחד באחסון מדויק של כמויות גדולות של מידע מפורט. במקום זאת, בני אדם נוטים לזכור את תמצית החוויות שלנו, תוך הפשטה והפקעה", אמר בנימין לוי, מדען מוח באוניברסיטת סן פרנסיסקו. "הפעלת AI עם תהליכים דמויי אנוש יותר, כמו שכחה אדפטיבית, היא אחת הדרכים להביא אותם לביצועים גמישים יותר."

בנוסף למה שזה עשוי לומר על אופן הפעולה של הבנה, Artetxe מקווה שמודלים גמישים יותר של שכחת שפות יכולים גם לעזור להביא את פריצות הדרך האחרונות של AI לשפות נוספות. למרות שדגמי בינה מלאכותית טובים בטיפול בספרדית ואנגלית, שתי שפות עם חומרי הדרכה רבים, הדגמים אינם כל כך טובים עם הבאסקית המולדת שלו, השפה המקומית הספציפית לצפון מזרח ספרד. "רוב הדגמים מחברות טכנולוגיה גדולות לא עושים את זה טוב", אמר. "התאמת מודלים קיימים לבסקים היא הדרך ללכת."

חן גם מצפה לעולם שבו פורחים יותר פרחי בינה מלאכותית. "אני חושב על מצב שבו העולם לא צריך מודל שפה אחד גדול. יש לנו כל כך הרבה", היא אמרה. "אם יש מפעל שמייצר דגמי שפה, אתה צריך סוג כזה של טכנולוגיה. יש לו מודל בסיס אחד שיכול להסתגל במהירות לתחומים חדשים."

- הפצת תוכן ויחסי ציבור מופעל על ידי SEO. קבל הגברה היום.

- PlatoData.Network Vertical Generative Ai. העצים את עצמך. גישה כאן.

- PlatoAiStream. Web3 Intelligence. הידע מוגבר. גישה כאן.

- PlatoESG. פחמן, קלינטק, אנרגיה, סביבה, שמש, ניהול פסולת. גישה כאן.

- PlatoHealth. מודיעין ביוטכנולוגיה וניסויים קליניים. גישה כאן.

- מקור: https://www.quantamagazine.org/how-selective-forgetting-can-help-ai-learn-better-20240228/

- :יש ל

- :הוא

- :לֹא

- :איפה

- ][עמ'

- 000

- 1

- 100

- 125

- 7

- 70

- 8

- a

- אודות

- תקציר

- דיוק

- במדויק

- להסתגל

- הסתגלות

- מסתגל

- להוסיף

- תוספת

- לקדם

- לאחר

- AI

- דגמי AI

- תעשיות

- לבד

- כְּבָר

- גם

- כמויות

- an

- ו

- אחר

- תפוח עץ

- גישה

- אפליקציות

- ARE

- AS

- At

- מחבר

- מְמוּצָע

- בסיס

- בסיסי

- כי

- הופך להיות

- היה

- מאחור

- מוטב

- בֵּין

- גָדוֹל

- ביג טק

- הגדול ביותר

- B

- אבני

- לִפְרוֹחַ

- שניהם

- פריצות דרך

- להביא

- בִּניָן

- אבל

- by

- חישובים

- נקרא

- CAN

- מרכז

- שינוי

- חן

- עקיפה

- מחבר שותף

- עמיתים

- Common

- בדרך כלל

- חברות

- לעומת

- חישובית

- המחשב

- מחשוב

- - כוח מחשוב

- מושגים

- הגיע למסקנה

- חיבורי

- הכלול

- מקובל

- יכול

- מכוסה

- לִיצוֹר

- נוצר

- חותך

- נתונים

- ערכות נתונים

- ירד

- עמוק

- למידה עמוקה

- עמוק יותר

- תובעני

- מְפוֹרָט

- DID

- אחר

- do

- לא

- עושה

- תחומים

- לא

- ירד

- בְּמַהֲלָך

- כל אחד

- קל יותר

- אפקטיבי

- הטבעה

- מהנדס

- מנועים

- אנגלית

- שלם

- שווה

- דוגמה

- קיימים

- חוויות

- להאריך

- מפעל

- מעטים

- שדה

- ממולא

- ראשון

- גמיש

- תזרים

- בעד

- קדימה

- מייסד

- פרנסיסקו

- החל מ-

- פונקציה

- כללי

- בדרך כלל

- לקבל

- GitHub

- Go

- טוב

- טיפול

- קשה

- יש

- he

- לעזור

- עזר

- ברמה גבוהה

- שֶׁלוֹ

- מקווה

- איך

- HTTPS

- עצום

- בן אנוש

- כמו אנושי

- בני אדם

- אידאל

- if

- תמונה

- מוּטָל

- משפר

- in

- בנפרד

- מידע

- בתחילה

- בהתחלה

- במקום

- מכון

- IT

- רק

- שמור

- סוג

- יודע

- קוריאה

- שפה

- שפות

- גָדוֹל

- מאוחר יותר

- האחרון

- שכבה

- שכבות

- עוֹפֶרֶת

- לִלמוֹד

- למידה

- עזבו

- אורך

- פחות

- רמה

- רמות

- כמו

- מגבלות

- גבולות

- לחיות

- מקומי

- נראה

- מגרש

- מכונה

- למידת מכונה

- מגזין

- לעשות

- עשייה

- רב

- חומרים

- מתימטי

- משמעויות

- אומר

- למדוד

- זכרון

- יכול

- מִילִיוֹן

- מודל

- מודלים

- יותר

- בעיקר

- הרבה

- מספר

- צריך

- יליד

- צורך

- צרכי

- רשת

- עצבי

- רשת עצבית

- נוירונים

- חדש

- לא

- of

- on

- ONE

- רק

- or

- אחר

- אחרים

- שלנו

- יותר

- שֶׁלוֹ

- מאמר

- ביצועים

- תקופתי

- אפלטון

- מודיעין אפלטון

- אפלטון נתונים

- צלל

- כּוֹחַ

- מופעל

- תהליך

- תהליכים

- תהליך

- כוח עיבוד

- תוכניות

- קוונטמגזין

- קוויבק

- מהירות

- אקראי

- במקום

- מקבל

- קבלה

- לאחרונה

- לזכור

- נדרש

- מחקר

- חוקר

- חוקרים

- לגלות

- עגול

- פועל

- אמר

- אותו

- סן

- סן פרנסיסקו

- לומר

- מדע

- מדענים

- ציון

- לגרד

- שְׁנִיָה

- נראה

- סֶלֶקטִיבִי

- שולח

- סטים

- היא

- צריך

- אותות

- משמעותי

- דומה

- מצב

- קטן יותר

- So

- כמה

- משהו

- דרום

- דרום קוריאה

- ספרד

- ספרדי

- ספציפי

- תֶקֶן

- התחלה

- סטארט - אפ

- צעדים

- עוד

- מאוחסן

- אחסון

- כזה

- מציע

- מתוק

- לוקח

- הוראה

- נבחרת

- טק

- טק

- טכניקה

- טכנולוגיה

- נוטה

- טֶקסט

- מֵאֲשֶׁר

- זֶה

- השמיים

- המידע

- העולם

- שֶׁלָהֶם

- אותם

- אז

- אלה

- הֵם

- דברים

- חושב

- זֶה

- אם כי?

- דרך

- ל

- היום

- מטבעות

- לקח

- רכבת

- מְאוּמָן

- הדרכה

- טריק

- ניסיתי

- לצבוט

- שתיים

- להבין

- הבנה

- אוניברסיטה

- להשתמש

- מְשׁוּמָשׁ

- באמצעות

- מאוד

- רוצה

- רוצה

- היה

- דֶרֶך..

- we

- webp

- טוֹב

- מה

- מתי

- אשר

- בזמן

- למה

- עם

- Word

- מילים

- תיק עבודות

- עבד

- עובד

- עוֹלָם

- גרוע יותר

- היה

- שנים

- אתה

- זפירנט