ארגונים משתמשים בשירותי למידת מכונה (ML) ובשירותי AI כדי לשפר את חווית הלקוח, להפחית את העלות התפעולית ולפתוח אפשרויות חדשות לשיפור התוצאות העסקיות. הנתונים עומדים בבסיס מקרי שימוש ב-ML ובינה מלאכותית ומהווים נכס אסטרטגי לארגון. מכיוון שהנתונים גדלים בקצב אקספוננציאלי, ארגונים מחפשים להקים פלטפורמת נתונים משולבת, חסכונית ובעלת ביצועים על מנת לעבד נתונים מראש, לבצע הנדסת תכונות ולבנות, לאמן ולהפעיל מודלים של ML בקנה מידה. כדי להשיג זאת, AWS מציעה פלטפורמת נתונים מודרנית מאוחדת המופעלת על ידי שירות אחסון פשוט של אמזון (Amazon S3) בתור אגם הנתונים עם כלים ומנועי עיבוד ייעודיים לתמיכה בניתוח ועומסי עבודה של ML. לחוויית ML מאוחדת, אתה יכול להשתמש סטודיו SageMaker של אמזון, אשר מציעה אינטגרציה מקורית עם הפעלות אינטראקטיביות של AWS Glue לבצע הנדסת תכונות בקנה מידה עם הגנה על נתונים רגישים. בפוסט זה, אנו מדגימים כיצד ליישם פתרון זה.

אמזון SageMaker הוא שירות ML מנוהל במלואו המאפשר לך לבנות, לאמן ולפרוס מודלים בקנה מידה עבור מגוון רחב של מקרי שימוש. לאימון מודלים, אתה יכול להשתמש בכל אחד מה אלגוריתמים מובנים בתוך SageMaker כדי להתחיל בהדרכה ובפריסה של מודלים של ML במהירות.

מרכיב מרכזי בתהליך בניית ופיתוח המודלים הוא הנדסת תכונות. דבק AWS היא אחת האפשרויות המומלצות להשגת הנדסת תכונות בקנה מידה. AWS Glue מאפשר לך להריץ אינטגרציה וטרנספורמציה של נתונים בצורה מבוזרת על תשתית Apache Spark ללא שרת, ומקלה על השימוש בספריית Spark ML הפופולרית להנדסת תכונות ופיתוח מודלים. בנוסף, אתה יכול להשתמש ב-AWS Glue לעיבוד נתונים מצטבר באמצעות סימניות עבודה, להטמיע נתונים מיותר מ-100 מקורות באמצעות מחברים, והפעל עומסי עבודה קוצניים או בלתי צפויים באמצעות קנה מידה אוטומטי.

דרישה חשובה נוספת ליישומים מבוססי ML היא אבטחת מידע ובקרת גישה. דרישה נפוצה היא לקבל שליטה הדוקה יותר על מי שיכול לגשת לנתונים הרגישים ביותר כחלק מתהליך הנדסת התכונות ובניית המודלים על ידי ביצוע עיקרון הגישה הפחותה. כדי להשיג זאת, אתה יכול להשתמש בשילוב AWS Glue עם תצורת אגם AWS להגברת הממשל והניהול של נכסי אגם הנתונים. עם Lake Formation, אתה יכול להגדיר בקרת גישה לנתונים ומדיניות אבטחה עדינה על גבי אגם הנתונים של Amazon S3 שלך. המדיניות מוגדרת במיקום מרכזי, המאפשרת מספר שירותי ניתוח ו-ML, כגון AWS Glue, אמזונה אתנה, ו- SageMaker, כדי ליצור אינטראקציה עם נתונים המאוחסנים באמזון S3.

דבק AWS כולל א זיהוי מידע אישי (PII). טרנספורמציה המספקת את היכולת לזהות, להסוות או להסיר ישויות לפי הצורך, להגברת הציות והממשל. עם טרנספורמציה של PII, אתה יכול לזהות נתוני PII במערך נתונים ולהחיל אוטומטית בקרת גישה עדינה באמצעות Lake Formation כדי להגביל נתונים רגישים עבור קבוצות משתמשים שונות.

השתמש במקרה

אנו מתמקדים במקרה של שימוש במודל נטייה הכולל מערך נתונים של שיווק לקוחות וכולל שתי אישיות משתמשים: מהנדס נתונים ומדען נתונים. מערך הנתונים מכיל מידע לכל לקוח, כולל מקור לידים, הערות ליצירת קשר, תפקיד תפקיד, כמה דגלים, צפיות בדפים לכל ביקור ועוד. מערך הנתונים כולל גם מידע רגיש כמו מספרי טלפון אישיים.

מהנדס הנתונים אחראי על בניית צינור עיבוד הנתונים מקצה לקצה, כולל הכנת נתונים, עיבוד מקדים ובקרת גישה. מדען הנתונים אחראי על הנדסת תכונות, והדרכה ופריסה של מודל ה-ML. שימו לב כי מדען הנתונים אינו רשאי לגשת לנתונים רגישים ל-PII לצורך הנדסת תכונות או אימון מודל ה-ML.

כחלק ממקרה שימוש זה, מהנדס הנתונים בונה צינור נתונים כדי לעבד מראש את מערך הנתונים, סורק את מערך הנתונים עבור כל מידע PII, ומגביל את הגישה של העמודה PII למשתמש של מדען הנתונים. כתוצאה מכך, כאשר מדען נתונים משתמש במערך הנתונים כדי לבצע הנדסת תכונות ולבנות מודלים של ML, אין לו גישה לעמודה הרגישה ל-PII (מספרי טלפון, במקרה זה). תהליך הנדסת התכונות כולל המרת עמודות של מחרוזת סוג לפורמט אופטימלי עבור דגמי ML. כמקרה שימוש מתקדם, אתה יכול להרחיב את דפוס הגישה הזה כדי ליישם אבטחה ברמת השורה וברמת התא באמצעות Lake Formation.

סקירת פתרונות

הפתרון מכיל את השלבים הבאים ברמה גבוהה:

- הגדר משאבים עם AWS CloudFormation.

- עבד מראש את מערך הנתונים, כולל זיהוי PII ובקרת גישה עדינה, בהפעלה אינטראקטיבית של AWS Glue.

- בצע הנדסת תכונות במפגש אינטראקטיבי של AWS Glue.

- אימון ופריסה של מודל ML באמצעות אלגוריתם XGBoost המובנה של SageMaker.

- הערך את מודל ה-ML.

התרשים הבא ממחיש את ארכיטקטורת הפתרונות.

תנאים מוקדמים

כדי להשלים מדריך זה, עליך לעמוד בדרישות הקדם הבאות:

הגדר משאבים עם AWS CloudFormation

פוסט זה כולל תבנית CloudFormation להגדרה מהירה. אתה יכול לסקור ולהתאים אותו כך שיתאים לצרכים שלך. אם אתה מעדיף להגדיר משאבים ב- קונסולת הניהול של AWS ואת AWS CLI ולא AWS CloudFormation, ראה את ההוראות בנספח בסוף פוסט זה.

תבנית CloudFormation מייצרת את המשאבים הבאים:

- S3 דליים עם מערך נתונים לדוגמה

- An AWS למבדה פונקציה לטעינת מערך הנתונים

- AWS זהות וניהול גישה (IAM) קבוצה, משתמשים, תפקידים ומדיניות

- הגדרות והרשאות אגם נתוני אגם Formation

- פרופילי משתמש של SageMaker

כדי ליצור את המשאבים שלך, בצע את השלבים הבאים:

- היכנס לקונסולה.

- בחרו השקת ערימה:

- בחרו הַבָּא.

- בעד DataEngineerPwd ו DataScientistPwd, הזן סיסמה משלך עבור משתמשי מהנדס הנתונים ומדען הנתונים.

- בעד GlueDatabaseName, להיכנס

demo. - בעד GlueTableName, להיכנס

web_marketing. - בעד S3BucketNameForInput, להיכנס

blog-studio-pii-dataset-. - בעד S3BucketNameForOutput, להיכנס

blog-studio-output-. - בעד SageMakerDomainId, הזן את מזהה הדומיין שלך ב-SageMaker שהכנת בשלבים המוקדמים.

- בחרו הַבָּא.

- בדף הבא בחר הַבָּא.

- עיין בפרטים בדף הסופי ובחר אני מאשר ש- AWS CloudFormation עשוי ליצור משאבי IAM.

- בחרו צור.

יצירת מחסנית יכולה להימשך עד 10 דקות. המחסנית יוצרת תפקידי IAM ופרופילי משתמש של SageMaker עבור שתי פרסונות: מהנדס נתונים ומדען נתונים. זה גם יוצר הדגמה וטבלה של מסד נתונים web_marketing עם מערך נתונים לדוגמה.

בזמן יצירת המחסנית, לפרסונה של מהנדס הנתונים יש גישה מלאה לטבלה, אך לפרסונת מדען הנתונים אין עדיין גישה לטבלה.

עבד מראש את מערך הנתונים

בואו נתחיל לעבד נתונים מראש בהפעלה אינטראקטיבית של AWS Glue. פרסונת מהנדס הנתונים רוצה לאמת את הנתונים כדי לראות אם יש נתונים רגישים או לא, ולהעניק הרשאת גישה מינימלית לפרסונה של מדען הנתונים. אתה יכול להוריד מחברת מ מיקום זה.

- היכנס למסוף באמצעות המשתמש מהנדס נתונים.

- במסוף SageMaker בחר משתמש.

- בחר את המשתמש מהנדס נתונים ובחר סטודיו פתוח.

- צור מחברת חדשה ובחר SparkAnalytics 1.0 ל תמונה ו דבק PySpark ל גַרעִין.

- התחל הפעלה אינטראקטיבית עם הקסם הבא להתקנת הגרסה החדשה יותר של Boto3 (זה נדרש לשימוש ב-

create_data_cells_filterשיטה): - אתחול הפגישה:

- צור AWS Glue DynamicFrame מהטבלה החדשה שנוצרה, ו לפתור סוגי בחירה מבוסס על סכימת קטלוג, מכיוון שאנו רוצים להשתמש בסכימה המוגדרת בקטלוג במקום בסכימה המבוססת על נתונים אוטומטית:

- אמת בטבלה אם יש נתוני PII באמצעות זיהוי AWS Glue PII:

- ודא אם העמודות המסווגות כ-PII מכילות נתונים רגישים או לא (אם לא, עדכן את classified_map כדי להסיר את העמודות הלא רגישות):

- הגדר הרשאות של Lake Formation באמצעות מסנן תאי נתונים עבור עמודות שזוהו אוטומטית, והגביל את העמודות לאישיות מדען הנתונים:

- היכנס ל-Studio כמדען נתונים כדי לראות שעמודות ה-PII אינן גלויות. אתה יכול להוריד מחברת מ מיקום זה.

- צור מחברת חדשה ובחר SparkAnalytics 1.0 ל תמונה ו דבק PySpark ל גַרעִין:

בצע הנדסת תכונות

אנו משתמשים בספריית Apache Spark ML כדי לבצע הנדסת תכונות כמשתמש מדען הנתונים ולאחר מכן כותבים בחזרה את הפלט לאמזון S3.

- בתא הבא, אנו מיישמים תכונות מה- ספריית Apache Spark ML:

StringIndexerממפה עמודת מחרוזת של תוויות לעמודה של אינדקסים של תוויות.OneHotEncoderממפה תכונה קטגורית, המיוצגת כאינדקס תווית, לוקטור בינארי עם לכל היותר ערך אחד בודד המציין את נוכחותה של תכונה קטגורית ספציפית. טרנספורמציה זו משמשת עבור אלגוריתמי ML המצפים לתכונות רציפות.VectorAssemblerהוא שנאי המשלב רשימה נתונה של עמודות לעמוד וקטור אחד, אשר משמש לאחר מכן באימון מודלים של ML עבור אלגוריתמים כגון רגרסיה לוגיסטית ועצי החלטה.

- ניתן ליצור את ה-DataFrame הסופי שעבר שינוי באמצעות ספריית Pipeline. צינור מוגדר כרצף של שלבים. שלבים אלה מופעלים לפי הסדר ו-DataFrame הקלט עובר טרנספורמציה בזמן שהוא עובר בכל שלב.

- לאחר מכן, אנו מפצלים את מערך הנתונים לאימון, מאמתים ובודקים את DataFrame ונשמור אותו בדלי S3 כדי לאמן את מודל ה-ML (ספק את מזהה חשבון ה-AWS שלך בקוד הבא):

אימון ופריסה של מודל ML

בסעיף הקודם, השלמנו הנדסת תכונות, שכללה המרת עמודות מחרוזות כגון region, jobrole, ו usedpromo לפורמט אופטימלי עבור דגמי ML. כללנו גם עמודות כגון pageviewspervisit ו totalwebvisits, שיעזור לנו לחזות את נטיית הלקוח לקנות מוצר.

כעת אנו מאמנים מודל ML על ידי קריאת מערך הרכבות והאימות באמצעות אלגוריתם XGBoost המובנה של SageMaker. לאחר מכן אנו פורסים את המודל ומבצעים בדיקת דיוק. אתה יכול להוריד מחברת מ מיקום זה.

בתא הבא, אנו קוראים נתונים מדלי S3 השני, הכולל את הפלט מפעולות הנדסת התכונות שלנו. לאחר מכן אנו משתמשים באלגוריתם המובנה XGBoost כדי לאמן את המודל.

- פתח מחברת חדשה. בחר מדע נתונים ל תמונה ו פייתון 3 ל גַרעִין (ספק את מזהה חשבון AWS שלך בקוד הבא):

- בסיום ההכשרה, נוכל לפרוס את המודל באמצעות שירותי אירוח של SageMaker:

הערך את מודל ה-ML

אנו משתמשים במערך הנתונים של הבדיקה כדי להעריך את המודל ולמחוק את נקודת הסיום כאשר סיימנו כדי להימנע מחיובים מתמשכים.

- הערך את המודל עם הקוד הבא:

תוצאת הדיוק עבור ריצת המדגם הייתה 84.6%. זה יכול להיות שונה במקצת עבור הריצה שלך בגלל הפיצול האקראי של מערך הנתונים.

- אנו יכולים למחוק את נקודת הסיום עם הקוד הבא:

לנקות את

עכשיו לשלב האחרון, ניקוי המשאבים.

- רוקן את שני הדליים שנוצרו דרך ערימת CloudFormation.

- מחק את האפליקציות המשויכות למשתמש

profiles data-scientistוdata-engineerבתוך הסטודיו. - מחק את מחסנית CloudFormation.

סיכום

בפוסט זה, הדגמנו פתרון המאפשר לפרסונות כמו מהנדסי נתונים ומדעני נתונים לבצע הנדסת תכונות בקנה מידה. עם הפעלות אינטראקטיביות של AWS Glue, אתה יכול בקלות להשיג הנדסת תכונות בקנה מידה עם זיהוי PII אוטומטי ובקרת גישה עדינה ללא צורך בניהול כל תשתית בסיסית. על ידי שימוש ב-Studio כנקודת הכניסה היחידה, אתה יכול לקבל חוויה פשוטה ומשולבת לבניית זרימת עבודה של ML מקצה לקצה: מהכנה ואבטחת נתונים ועד לבנייה, הדרכה, כוונון ופריסה של מודלים של ML. למידע נוסף, בקר תחילת העבודה עם הפעלות אינטראקטיביות של AWS Glue ו סטודיו SageMaker של אמזון.

אנחנו מאוד נרגשים מהיכולת החדשה הזו ומעוניינים לראות מה אתה הולך לבנות איתה!

נספח: הגדר משאבים דרך המסוף וה-AWS CLI

השלם את ההוראות בסעיף זה כדי להגדיר משאבים באמצעות המסוף ו-AWS CLI במקום תבנית CloudFormation.

תנאים מוקדמים

כדי להשלים מדריך זה, חייבת להיות לך גישה ל-AWS CLI (ראה תחילת העבודה עם AWS CLI) או השתמש בגישה לשורת הפקודה מ AWS CloudShell.

קבע את התצורה של קבוצת IAM, משתמשים, תפקידים ומדיניות

בחלק זה, אנו יוצרים שני משתמשי IAM: מהנדס נתונים ומדען נתונים, השייכים לקבוצת הנתונים-פלטפורמות-נתונים של IAM. לאחר מכן אנו מוסיפים מדיניות IAM יחידה לקבוצת IAM.

- במסוף IAM, ליצור מדיניות בלשונית JSON ליצור מדיניות חדשה מנוהלת IAM בשם

DataPlatformGroupPolicy. המדיניות מאפשרת למשתמשים בקבוצה לגשת לסטודיו, אך רק באמצעות פרופיל משתמש של SageMaker עם תג התואם את שם המשתמש שלהם ב-IAM. השתמש במסמך המדיניות הבא של JSON כדי לספק הרשאות: - צור קבוצת IAM נקרא

data-platform-group. - חפש וצרף את המדיניות המנוהלת של AWS בשם DataPlatformGroupPolicy לקבוצה.

- צור משתמשי IAM נקרא מהנדס נתונים ומדען נתונים תחת קבוצת הנתונים-פלטפורמות-נתונים של IAM.

- צור מדיניות מנוהלת חדשה בשם SageMakerExecutionPolicy (ספק אזור ומזהה חשבון בקוד הבא):

- צור מדיניות מנוהלת חדשה בשם

SageMakerAdminPolicy: - צור תפקיד IAM עבור SageMaker עבור מהנדס הנתונים (מהנדס נתונים), המשמש כתפקיד הביצוע של פרופיל המשתמש המתאים. על צרף מדיניות הרשאות דף, AmazonSageMakerFullAccess (מדיניות מנוהלת AWS) מצורף כברירת מחדל. אתה מסיר מדיניות זו מאוחר יותר כדי לשמור על הרשאות מינימליות.

- בעד שם התפקיד, השתמש במוסכמות השמות שהוצגה בתחילת סעיף זה כדי לתת שם לתפקיד SageMakerStudioExecutionRole_data-engineer.

- בעד תגים, הוסף את שם המפתח פרופיל משתמש ואת מהנדס הנתונים של הערך.

- בחרו צור תפקיד.

- כדי להוסיף את המדיניות הנותרת, על תפקידים בדף, בחר את שם התפקיד שיצרת זה עתה.

- תַחַת הרשאות, הסר את המדיניות AmazonSageMakerFullAccess.

- על צרף מדיניות הרשאות בדף, בחר את המדיניות המנוהלת של AWS AwsGlueSessionUserRestrictedServiceRole, ואת המדיניות המנוהלת על ידי הלקוח SageMakerExecutionPolicy ו- SageMakerAdminPolicy שיצרת.

- בחרו צרף מדיניות.

- שינוי יחסי האמון של התפקיד שלך:

- צור תפקיד IAM עבור SageMaker עבור מדען הנתונים (Data-Scientist), המשמש כתפקיד הביצוע של פרופיל המשתמש המתאים.

- בעד שם התפקיד, שם לתפקיד SageMakerStudioExecutionRole_data-scientist.

- בעד תגים, הוסף את שם המפתח פרופיל משתמש ואת מדען הנתונים הערך.

- בחרו צור תפקיד.

- כדי להוסיף את המדיניות הנותרת, על תפקידים בדף, בחר את שם התפקיד שיצרת זה עתה.

- תַחַת הרשאות, הסר את המדיניות AmazonSageMakerFullAccess.

- על צרף מדיניות הרשאות בדף, בחר את המדיניות המנוהלת של AWS AwsGlueSessionUserRestrictedServiceRole, ואת המדיניות המנוהלת על ידי הלקוח SageMakerExecutionPolicy שיצרת.

- בחרו צרף מדיניות.

- שינוי יחסי האמון של התפקיד שלך:

הגדר את פרופילי המשתמש של SageMaker

כדי ליצור את פרופילי המשתמש שלך ב-SageMaker עם studiouserid תג, בצע את השלבים הבאים:

- השתמש ב-AWS CLI או ב-CloudShell כדי ליצור את פרופיל המשתמש של Studio עבור מהנדס הנתונים (ספק את מזהה החשבון ומזהה הדומיין של Studio בקוד הבא):

- חזור על השלב ליצירת פרופיל משתמש עבור מדען הנתונים, החלפת מזהה החשבון ומזהה הדומיין של Studio:

צור דלי S3 והעלה את מערך הנתונים לדוגמה

בסעיף זה, אתה יוצר שני דליים S3. בדלי הראשון יש מערך נתונים לדוגמה הקשור לשיווק באינטרנט. הדלי השני משמש את מדען הנתונים לאחסון פלט ממשימות הנדסת תכונות, ומערך פלט זה משמש לאימון מודל ה-ML.

ראשית, צור את דלי S3 עבור נתוני הקלט:

- הורדה מערך הנתונים.

- במסוף S3 של אמזון בחר דליים בחלונית הניווט.

- בחרו צור דלי.

- בעד אזור, בחר את האזור עם הדומיין של SageMaker הכולל את פרופילי המשתמש שיצרת.

- בעד שם הדלי, להיכנס

blog-studio-pii-dataset-. - בחרו צור דלי.

- בחר את הדלי שיצרת ובחר העלה.

- ב בחר קבצים סעיף, בחר הוסף קבצים והעלה את מערך הנתונים שהורדת.

כעת אתה יוצר את הדלי עבור נתוני הפלט: - על דליים עמוד, בחר צור דלי.

- בעד אזור, בחר את האזור עם הדומיין של SageMaker הכולל את פרופילי המשתמש שיצרת.

- בעד שם הדלי, להיכנס

blog-studio-output-. - בחרו צור דלי.

צור מסד נתונים וטבלה של AWS Glue

בסעיף זה, אתה יוצר מסד נתונים וטבלה של AWS Glue עבור מערך הנתונים.

- על קונסולת האגם, מתחת קטלוג נתונים בחלונית הניווט, בחר מאגרי מידע.

- בחרו הוסף מסד נתונים.

- בעד שם, הכנס להדגמה.

- בחרו צור בסיס נתונים.

- תַחַת קטלוג נתונים, בחר לוחות.

- בעד שם, להיכנס

web_marketing. - בעד מסד נתונים, בחר

demo. - בעד כלול מסלול, הזן את הנתיב של דלי S3 שלך עבור נתוני קלט.

- בעד מִיוּן, בחר CSV.

- תַחַת סכימה, בחר העלה סכימה.

- הזן את מערך ה-JSON הבא בתיבת הטקסט:

- בחרו העלה.

- בחרו חפש.

- תַחַת פרטי טבלה, בחר ערוך טבלה.

- תַחַת מאפייני טבלה, בחר להוסיף.

- בעד מפתח, להיכנס

skip.header.line.count, ועבור ערך, הזן 1. - בחרו שמור.

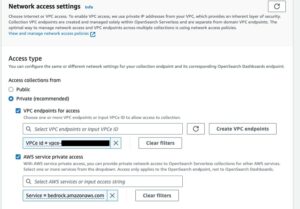

הגדר הרשאות Lake Formation

בסעיף זה, אתה מגדיר הרשאות Lake Formation כדי לאפשר תפקיד IAM SageMakerStudioExecutionRole_data-engineer כדי ליצור מסד נתונים ולרשום את מיקום S3 בתוך Lake Formation.

ראשית, רשום את מיקום אגם הנתונים כדי לנהל טבלאות מתחת למיקום בהרשאות Lake Formation:

- בחרו מיקומי אגם נתונים.

- בחרו רשום מיקום.

- בעד נתיב S3 של אמזון, להיכנס

s3://blog-studio-pii-dataset-/(הדלי שמכיל את מערך הנתונים). - בחרו רשום מיקום.

כעת אתה מעניק הרשאות מסד נתונים וטבלה של Lake Formation לתפקידי IAMSageMakerStudioExecutionRole_data-engineerוSageMakerStudioExecutionRole_data-scientist.ראשית, הענק הרשאת מסד נתונים עבורSageMakerStudioExecutionRole_data-engineer: - תַחַת הרשאות, בחר הרשאות אגם נתונים.

- תַחַת הרשאת נתונים, בחר להעניק.

- בעד מנהלים, בחר משתמשים ותפקידי IAM, ובחר את התפקיד

SageMakerStudioExecutionRole_data-engineer. - בעד תגי מדיניות או משאבי קטלוג, בחר משאבי קטלוג נתונים בעלי שם.

- בעד מאגרי מידע, בחר הדגמה.

- בעד הרשאות מסד נתונים, בחר סוּפֶּר.

- בחרו להעניק.

לאחר מכן, הענק הרשאת טבלה עבורSageMakerStudioExecutionRole_data-engineer: - תַחַת הרשאת נתונים, בחר להעניק.

- בעד מנהלים, בחר משתמשים ותפקידי IAM, ובחר את התפקיד

SageMakerStudioExecutionRole_data-engineer. - בעד תגי מדיניות או משאבי קטלוג, בחר משאבי קטלוג נתונים בעלי שם.

- בעד מאגרי מידע, בחר

demo. - בעד לוחות, בחר

web_marketing. - בעד טבלתי הרשאות, בחר סוּפֶּר.

- בעד ניתן להענקה הרשאות, בחר סוּפֶּר.

- בחרו להעניק.

לבסוף, הענק הרשאת מסד נתונים עבורSageMakerStudioExecutionRole_data-scientist: - תַחַת הרשאת נתונים, בחר להעניק.

- בעד מנהלים, בחר משתמשים ותפקידי IAM, ובחר את התפקיד

SageMakerStudioExecutionRole_data-scientist. - בעד תגי מדיניות או משאבי קטלוג, בחר משאבי קטלוג נתונים בעלי שם.

- בעד מאגרי מידע, בחר

demo. - בעד הרשאות מסד נתונים, בחר לתאר.

- בחרו להעניק.

על הכותבים

פראביין קומאר הוא ארכיטקט פתרונות אנליטיקה ב-AWS עם מומחיות בתכנון, בנייה והטמעה של פלטפורמות נתונים וניתוח מודרניות באמצעות שירותים מקוריים בענן. תחומי העניין שלו הם טכנולוגיה ללא שרת, מחסני נתונים מודרניים בענן, סטרימינג ויישומי ML.

נוריטקה סקיאמה הוא אדריכל ביג דאטה ראשי בצוות AWS Glue. הוא נהנה לשתף פעולה עם צוותים שונים כדי לספק תוצאות כמו הפוסט הזה. בזמנו הפנוי הוא נהנה לשחק משחקי וידאו עם משפחתו.

- מתקדם (300)

- AI

- איי אמנות

- מחולל אמנות ai

- איי רובוט

- אמזון SageMaker

- בינה מלאכותית

- הסמכת בינה מלאכותית

- בינה מלאכותית בבנקאות

- רובוט בינה מלאכותית

- רובוטים של בינה מלאכותית

- תוכנת בינה מלאכותית

- AWS Big Data

- דבק AWS

- תצורת אגם AWS

- למידת מכונות AWS

- blockchain

- blockchain conference ai

- קוינגניוס

- בינה מלאכותית של שיחה

- קריפטו כנס ai

- של דאל

- למידה עמוקה

- גוגל איי

- למידת מכונה

- אפלטון

- plato ai

- מודיעין אפלטון

- משחק אפלטון

- אפלטון נתונים

- פלטוגיימינג

- סולם ai

- תחביר

- מנהיגות מחשבתית

- זפירנט