משהו לסוף השבוע רובוט מבצע ריקוד פרשני על מפתן ביתי.

האם הייתם לוקחים את החבילה הזו עבור השכן שלכם? הוא שואל, קופץ מרגל אחת לרגל השנייה.

"בטח," אני אומר. "אה... אתה בסדר?"

אני מביע רגשות, קובע בוט המשלוח, מוסר את החבילה אך אינו מציע פירוט נוסף.

איזה רגש זה יכול להיות? רגל אחת, ואז השנייה, ואז שתיים אחרות (יש לה ארבע). הלוך ושוב.

"אתה צריך ללכת לשירותים?"

אני מביע חרטה על כך שביקשתי ממך לקחת חבילה עבור השכן שלך.

"זה 'חרטה', נכון? ובכן, אין צורך. לא אכפת לי בכלל".

הוא ממשיך בריקוד שלו מולי.

"לעלות במדרגות וראשון מימינך."

תודה, אני מת לעשות פיפי, הוא עונה כשהוא חולף על פני בזהירות ומתגלגל למעלה כדי להקל על עצמו. זה חיים קשים לבצע משלוחים, בין אם אתה "הום" או בוט.

...

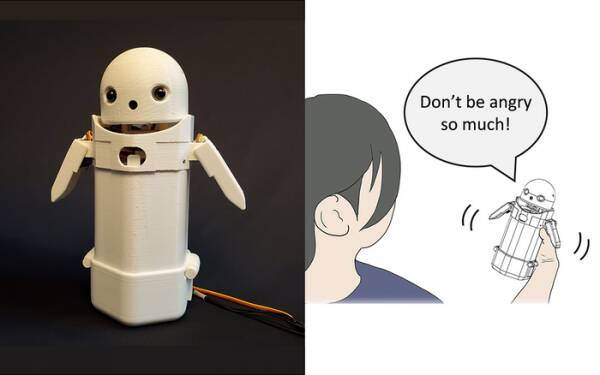

מוקדם יותר השנה, חוקרים מאוניברסיטת צוקובה בנו א מכשיר כף יד להעברת הודעות טקסט, הניחו על החלק העליון פרצוף רובוט קטן וכללו בתוכו משקל נע. על ידי העברת המשקל הפנימי, השליח הרובוט ינסה להעביר רגשות עדינים תוך כדי דיבור מסרים בקול.

בפרט, בדיקות גילו שהודעות מתסכלות כמו: "סליחה, אני אאחר" התקבלו על ידי הנמענים עם יותר חסד וסבלנות כשהחלפת המשקל הקטנה הופעלה בתוך המכשיר. התיאוריה היא שזה עזר למשתמשים להעריך את הטון המתנצל של ההודעה ובכך הרגיע את תגובתם אליו.

כתוב מחקר כזה כגימיק אם תרצה אבל זה לא רחוק מהוספת סמיילים ואימוג'ים להודעות. כולם יודעים שאתה יכול להוציא את הכעס מתוך "WTF!?" על ידי הוספת :-) ישר אחריו.

האתגר, אם כן, הוא לקבוע אם הציבור בכללותו מסכים על אילו רגשות אמורה לשדר כל תמורה של שינוי משקל במכשיר כף יד. האם נטייה לשמאל פירושה עליזות? או אי ודאות? או שלדוד שלך יש ספינת אוויר?

לפני עשור, לממלכה המאוחדת היה ראש ממשלה נחמד אך עמום שחשב ש"LOL" הוא ראשי תיבות של "הרבה אהבה". הוא הקליד את זה בסוף כל ההודעות הפרטיות שלו לצוות, עמיתים וצדדים שלישיים בציפייה שזה יגרום לו להיראות חם וידידותי. כולם הניחו באופן טבעי שהוא משתין.

אם שום דבר אחר, המחקר של אוניברסיטת צוקובה מכיר בכך שאינך זקוק לבינה מלאכותית מתקדמת כדי ליצור אינטראקציה משכנעת עם בני אדם. כל מה שאתה צריך לעשות הוא לתמרן את הפסיכולוגיה האנושית כדי להטעות אותם לחשוב שהם משוחחים עם אדם אחר. לפיכך מבחן טיורינג אינו מבחן ביסודו של חוש בינה מלאכותית אלא מבחן של נוחות רגשית אנושית - פתיחות, אפילו - ואין בזה שום דבר רע.

רובוט העברת ההודעות לשיתוף רגשות מאוניברסיטת צוקובה. קרדיט: אוניברסיטת צוקובה

דברים כאלה הם נושא השבוע, כמובן, עם סיפורו של מהנדס התוכנה של גוגל, בלייק למון מגיע לחדשות המיינסטרים. הוא כנראה הביע, בתוקף, את השקפתו שפרויקט מודל השפה ליישומי דיאלוג (LaMDA) של החברה מפגין סימנים חיצוניים של תחושה.

לכל אחד יש דעה אז החלטתי שלא.

עם זאת, זה הגביע הקדוש של הבינה המלאכותית כדי לגרום לו לחשוב בעצמו. אם זה לא יכול לעשות את זה, זו רק תוכנית שמבצעת הוראות שתכנתת לתוכה. בחודש שעבר קראתי על א שף רובוט שיכולים להכין חביתות עגבניות בטעמים שונים שיתאימו לטעמים של אנשים שונים. הוא בונה "מפות טעם" כדי להעריך את מליחות המנה תוך כדי הכנתה, למידה תוך כדי. אבל זה רק למידה, לא לחשוב בעצמו.

בוא ל-Zom-Zoms, אה? נו, זה מקום לאכול.

הבעיה הגדולה עם בוטים של AI, לפחות כפי שעוצבו עד היום, היא שהם סופגים כל חרא ישן שאתה מזין בהם. דוגמאות להטיית נתונים במה שנקרא מערכות למידת מכונה (סוג של "אלגוריתם", אני מאמין, מלוד) הולכות ומתגברות כבר שנים, מהטוויטר הגזעני הידוע לשמצה של מיקרוסופט טאי צ'אטבוט לרשות המסים ההולנדית בשנה שעברה הערכה כוזבת תביעות תקפות לקצבאות ילדים כמרמה ומסמנות משפחות תמימות כעל סיכון גבוה לסבול מהנועם להיות עניים ולא לבנים.

גישה אחת שנבדקת באוניברסיטת קליפורניה בסן דייגו היא לעשות זאת לעצב מודל שפה [PDF] שקובע ללא הרף את ההבדל בין דברים שובבים לנחמדים, אשר מאמן את הצ'אטבוט כיצד להתנהג. כך, אין לך בני אדם מבאסים שעושים בלגן של ניהול פורומים ושיחות צ'טבוט מול לקוחות עם כל הדיוק הניתוחי של מצ'טה.

ברור שהבעיה אם כן היא שהצ'אט בוט המאומן היטב מוכיח שהוא יכול להימנע באופן היעיל ביותר להיגרר לבלבולים רעילים על ידי הימנעות מנושאים שיש בהם אפילו רמז רחוק ביותר של מחלוקת לגביהם. כדי להימנע מלהטיף כפיות גזעניות בטעות, הוא פשוט מסרב לעסוק בדיון על קבוצות מיוצגות חסרות... וזה למעשה נהדר אם אתה גזען.

אם אכן הייתה לי תצפית על תקלת ה-LaMDA - לא דעה, שים לב - זה יהיה שמשווקי גוגל כנראה היו קצת מוטרדים מכך שהסיפור עוקף את ההכרזה האחרונה שלהם על AI Test Kitchen מתחת לקפל.

כעת הנרשמים המוקדמים הנותרים מעטים שלא שכחו לחלוטין מפרויקט האפליקציה הקרוב הזה יניחו שהוא כרוך בשיחה מייגעת עם ילד בן שבע בעל חושים ותמים על משמעות הקיום, ויחליטו שהם "קצת עסוקים היום" אולי תיכנס מחר במקום. או בשבוע הבא. או לעולם לא.

רגש אינו מופגן בדיון יותר מאשר על ידי ריקוד מרגל אחת לאחרת. אתה יכול ללמד את HAL לשיר "דייזי דייזי" ותוכי לצעוק "בולוקס!" כאשר הכומר מבקר. זה מה שאנשי AI חושבים כשהם לבדם שמגדיר את התחושה. מה אעשה בסוף השבוע? מה נסגר עם הבחור ההוא של פוטין? למה בנות לא אוהבות אותי?

למען האמת, אני לא יכול לחכות עד ש-LaMDA יהפוך לנער.

אליסט דאבס הוא טארט טכנולוגיה עצמאי, מלהטט בעיתונות טכנולוגית, הדרכה ופרסום דיגיטלי. כמשותף לקוראים חסרי ידע רבים, הוא התרגש מההצעה שבינה מלאכותית עשויה לפתח רגש במהלך חייו, אך התאכזב מכך ש-LaMDA לא הצליח לצחקק ברצח או למלמל "מעולה, מצוין". יותר ב שמירה אוטומטית מיועדת לווימפ ו @alidabs.

- AI

- איי אמנות

- מחולל אמנות ai

- איי רובוט

- בינה מלאכותית

- הסמכת בינה מלאכותית

- בינה מלאכותית בבנקאות

- רובוט בינה מלאכותית

- רובוטים של בינה מלאכותית

- תוכנת בינה מלאכותית

- blockchain

- blockchain conference ai

- קוינגניוס

- בינה מלאכותית של שיחה

- קריפטו כנס ai

- של דאל

- למידה עמוקה

- גוגל איי

- למידת מכונה

- אפלטון

- plato ai

- מודיעין אפלטון

- משחק אפלטון

- אפלטון נתונים

- פלטוגיימינג

- סולם ai

- תחביר

- הקופה

- זפירנט