אמזון SageMaker עושה את זה פשוט לפרוס מודלים של למידת מכונה (ML) להסקת מסקנות בזמן אמת ומציע מבחר רחב של מופעי ML המתפרשים על מעבדים ומאיצים כגון Afer Inferentia. כשירות מנוהל במלואו, אתה יכול להגדיל את פריסת המודלים שלך, למזער עלויות מסקנות ולנהל את המודלים שלך בצורה יעילה יותר בייצור עם נטל תפעולי מופחת. נקודת קצה של מסקנות בזמן אמת של SageMaker מורכבת מנקודת קצה של HTTPs וממופעי ML שנפרסים על פני מספר אזורי זמינות לזמינות גבוהה. SageMaker קנה מידה אוטומטי של יישום יכול להתאים באופן דינמי את מספר מופעי ML המסופקים עבור מודל בתגובה לשינויים בעומס העבודה. נקודת הקצה מפיצה באופן אחיד בקשות נכנסות למופעי ML באמצעות אלגוריתם עגול.

כאשר מודלים של ML הפרוסים במופעים מקבלים קריאות API ממספר רב של לקוחות, הפצה אקראית של בקשות יכולה לעבוד טוב מאוד כאשר אין הרבה שונות בבקשות ובתגובות שלך. אבל במערכות עם עומסי עבודה בינה מלאכותית, בקשות ותגובות יכולות להיות משתנות ביותר. במקרים אלה, לעתים קרובות רצוי לבצע איזון עומסים על ידי התחשבות בקיבולת ובניצול של המופע ולא באיזון עומס אקראי.

בפוסט זה, אנו דנים באסטרטגיית ניתוב הבקשות הפחות מצטיינות (LOR) של SageMaker וכיצד היא יכולה למזער את השהייה עבור סוגים מסוימים של עומסי עבודה מסקנות בזמן אמת על ידי התחשבות בקיבולת ובניצול של מופעי ML. אנו מדברים על היתרונות שלו על פני מנגנון הניתוב המוגדר כברירת מחדל וכיצד אתה יכול להפעיל LOR עבור פריסות המודל שלך. לבסוף, אנו מציגים ניתוח השוואתי של שיפורים בחביון עם LOR לעומת אסטרטגיית הניתוב המוגדרת כברירת מחדל של ניתוב אקראי.

אסטרטגיית SageMaker LOR

כברירת מחדל, לנקודות הקצה של SageMaker יש אסטרטגיית ניתוב אקראית. SageMaker תומך כעת באסטרטגיית LOR, המאפשרת ל-SageMaker לנתב בקשות בצורה מיטבית למופע המתאים ביותר לשרת אותה בקשה. SageMaker מאפשר זאת על ידי ניטור העומס של המופעים מאחורי נקודת הקצה שלך, והמודלים או רכיבי ההסקה שנפרסים בכל מופע.

הדיאגרמה האינטראקטיבית הבאה מציגה את מדיניות ניתוב ברירת המחדל שבה בקשות המגיעות לנקודות הקצה של המודל מועברות באופן אקראי למופעי ML.

הדיאגרמה האינטראקטיבית הבאה מציגה את אסטרטגיית הניתוב שבה SageMaker תנתב את הבקשה למופע בעל מספר הבקשות הנמוך ביותר.

באופן כללי, ניתוב LOR עובד היטב עבור מודלים בסיסיים או מודלים של בינה מלאכותית כאשר המודל שלך מגיב בתוך מאות אלפיות שניות לדקות. אם לתגובת הדגם שלך יש זמן אחזור נמוך יותר (עד מאות אלפיות שניות), אתה עשוי להפיק תועלת רבה יותר מניתוב אקראי. ללא קשר, אנו ממליצים לבדוק ולזהות את אלגוריתם הניתוב הטוב ביותר עבור עומסי העבודה שלך.

כיצד להגדיר אסטרטגיות ניתוב של SageMaker

SageMaker מאפשר לך כעת להגדיר את RoutingStrategy פרמטר בזמן יצירת ה EndpointConfiguration עבור נקודות קצה. השונה RoutingStrategy הערכים הנתמכים על ידי SageMaker הם:

LEAST_OUTSTANDING_REQUESTSRANDOM

להלן דוגמה לפריסה של מודל על נקודת קצה של הסקת מסקנות שבה LOR מופעלת:

- צור את תצורת נקודת הקצה על ידי הגדרה

RoutingStrategyasLEAST_OUTSTANDING_REQUESTS: - צור את נקודת הקצה באמצעות תצורת נקודת הקצה (ללא שינוי):

תוצאות ביצועים

הרצנו מדדי ביצועים כדי למדוד את זמן ההסקה מקצה לקצה ואת התפוקה של codegen2-7B דגם מתארח במופעים של ml.g5.24xl עם ניתוב ברירת מחדל ונקודות קצה של ניתוב חכם. מודל CodeGen2 שייך למשפחת המודלים של שפה אוטורגרסיבית ומייצר קוד הפעלה כאשר מקבלים הנחיה באנגלית.

בניתוח שלנו, הגדלנו את מספר המופעים של ml.g5.24xl מאחורי כל נקודת קצה עבור כל ריצת בדיקה ככל שמספר המשתמשים במקביל גדל, כפי שמוצג בטבלה הבאה.

| מִבְחָן | מספר משתמשים במקביל | מספר מופעים |

| 1 | 4 | 1 |

| 2 | 20 | 5 |

| 3 | 40 | 10 |

| 4 | 60 | 15 |

| 5 | 80 | 20 |

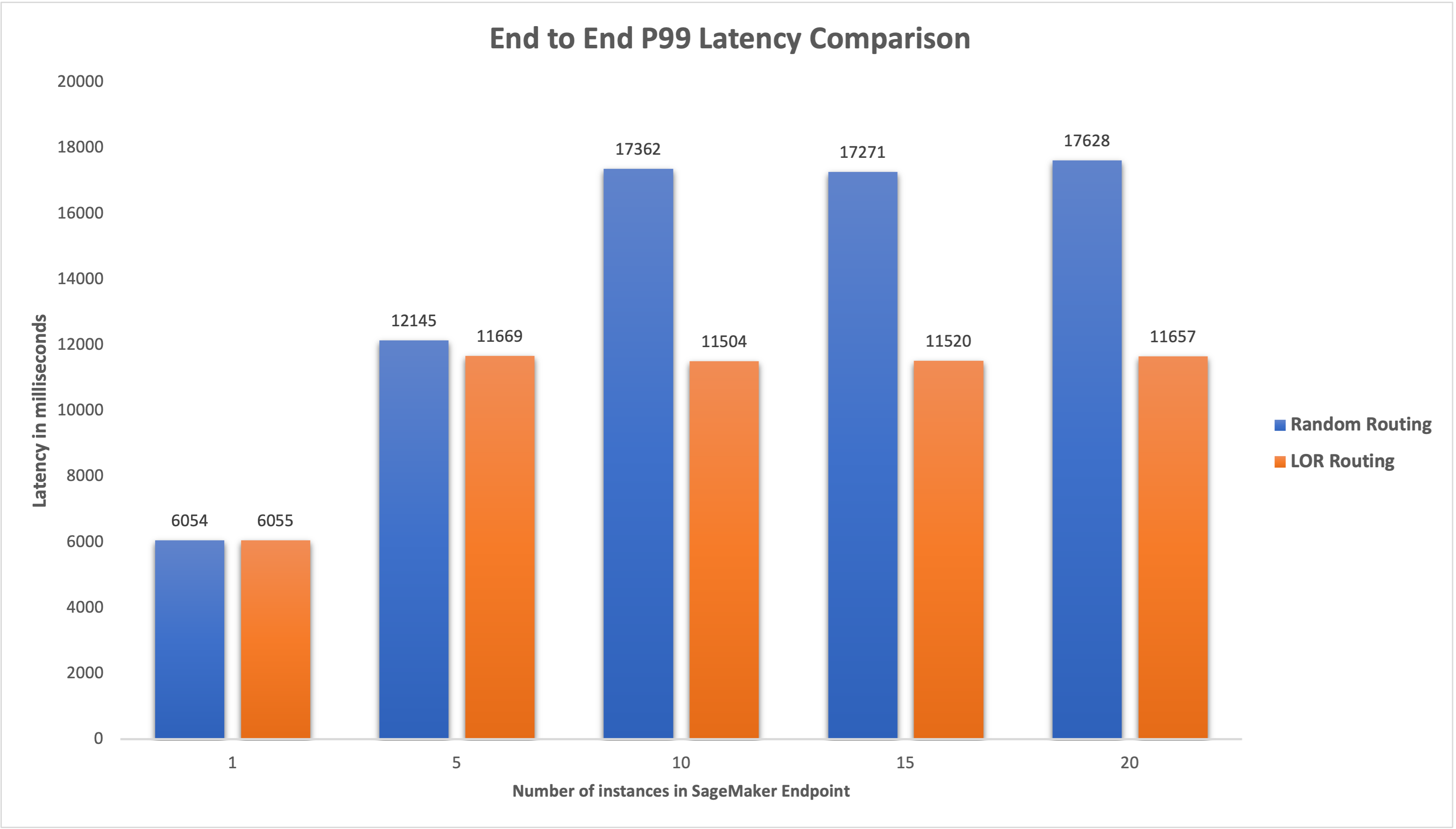

מדדנו את חביון P99 מקצה לקצה עבור שתי נקודות הקצה וצפינו בשיפור של 4-33% בהשהיה כאשר מספר המקרים גדל מ-5 ל-20, כפי שמוצג בגרף הבא.

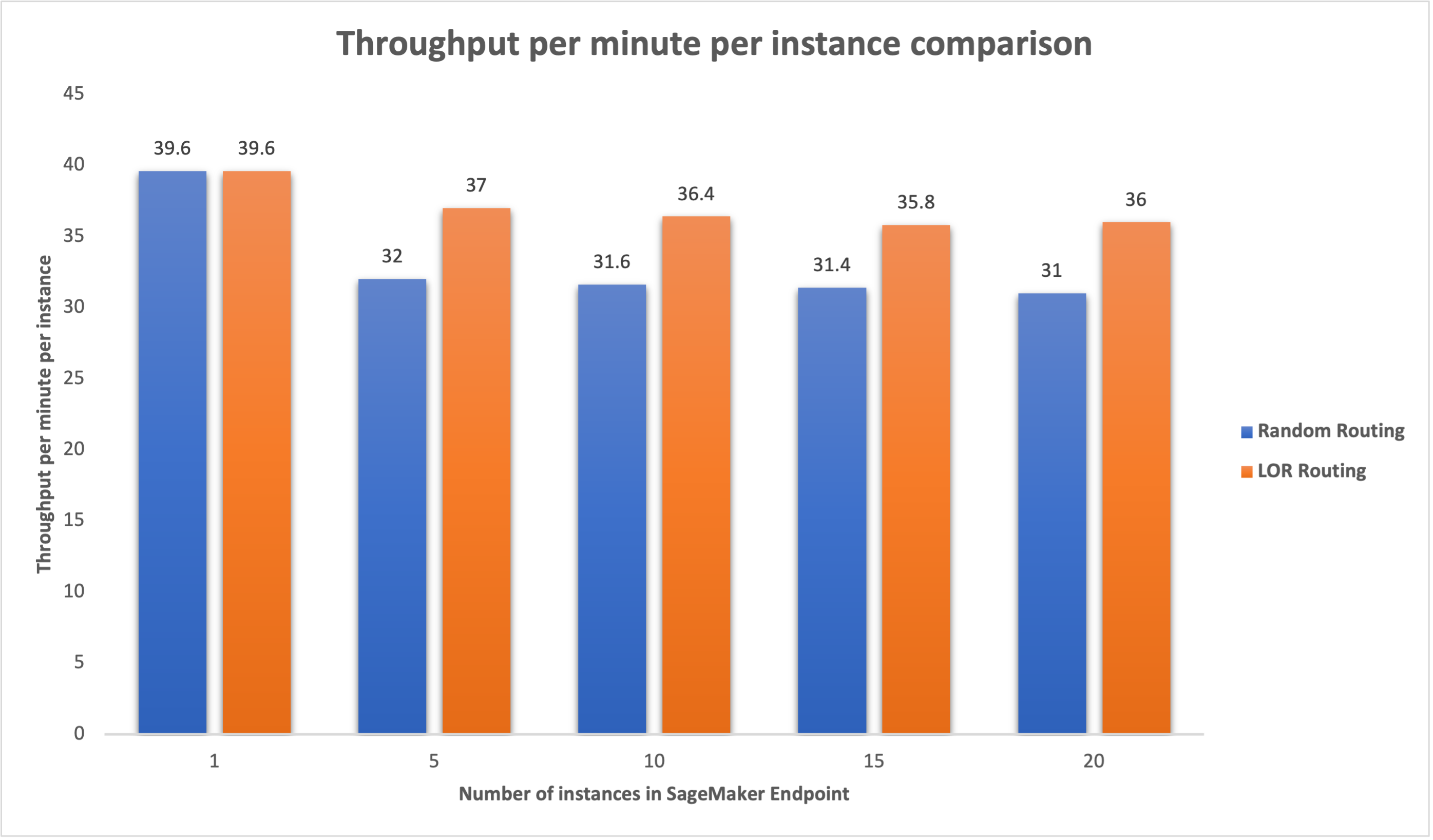

באופן דומה, ראינו שיפור של 15-16% בתפוקה לדקה למופע כאשר מספר המקרים גדל מ-5 ל-20.

זה ממחיש כי ניתוב חכם מסוגל לשפר את חלוקת התעבורה בין נקודות הקצה, מה שמוביל לשיפורים בהשהיה מקצה לקצה ובתפוקה הכוללת.

סיכום

בפוסט זה, הסברנו את אסטרטגיות הניתוב של SageMaker ואת האפשרות החדשה לאפשר ניתוב LOR. הסברנו כיצד להפעיל את LOR וכיצד זה יכול להועיל לפריסות המודל שלך. מבחני הביצועים שלנו הראו שיפורים בהשהייה ובתפוקה במהלך הסקת מסקנות בזמן אמת. למידע נוסף על תכונות הניתוב של SageMaker, עיין ב תיעוד. אנו ממליצים לך להעריך את עומסי העבודה המסקנות שלך ולקבוע אם אתה מוגדר בצורה מיטבית עם אסטרטגיית הניתוב.

על הכותבים

פארק ג'יימס הוא אדריכל פתרונות בשירותי האינטרנט של אמזון. הוא עובד עם Amazon.com כדי לתכנן, לבנות ולפרוס פתרונות טכנולוגיים ב-AWS, ויש לו עניין מיוחד בבינה מלאכותית ולמידת מכונה. בזמן הפנוי הוא נהנה לחפש תרבויות חדשות, חוויות חדשות, ולהישאר מעודכן בטרנדים הטכנולוגיים העדכניים ביותר. אתה יכול למצוא אותו על לינקדין.

פארק ג'יימס הוא אדריכל פתרונות בשירותי האינטרנט של אמזון. הוא עובד עם Amazon.com כדי לתכנן, לבנות ולפרוס פתרונות טכנולוגיים ב-AWS, ויש לו עניין מיוחד בבינה מלאכותית ולמידת מכונה. בזמן הפנוי הוא נהנה לחפש תרבויות חדשות, חוויות חדשות, ולהישאר מעודכן בטרנדים הטכנולוגיים העדכניים ביותר. אתה יכול למצוא אותו על לינקדין.

Venugopal Pai הוא אדריכל פתרונות ב-AWS. הוא מתגורר בבנגלורו, הודו, ועוזר ללקוחות מקוריים דיגיטליים להגדיל ולמטב את היישומים שלהם ב-AWS.

Venugopal Pai הוא אדריכל פתרונות ב-AWS. הוא מתגורר בבנגלורו, הודו, ועוזר ללקוחות מקוריים דיגיטליים להגדיל ולמטב את היישומים שלהם ב-AWS.

דייוויד ניג'נדה הוא מהנדס פיתוח תוכנה בכיר בצוות אמזון SageMaker, שעובד כעת על שיפור תהליכי עבודה של למידת מכונה בייצור, כמו גם על השקת תכונות מסקנות חדשות. בזמנו הפנוי, הוא מנסה לשמור על קשר עם ילדיו.

דייוויד ניג'נדה הוא מהנדס פיתוח תוכנה בכיר בצוות אמזון SageMaker, שעובד כעת על שיפור תהליכי עבודה של למידת מכונה בייצור, כמו גם על השקת תכונות מסקנות חדשות. בזמנו הפנוי, הוא מנסה לשמור על קשר עם ילדיו.

דיפטי ראגה הוא מהנדס פיתוח תוכנה בצוות אמזון SageMaker. עבודתה הנוכחית מתמקדת בבניית תכונות לאירוח מודלים של למידת מכונה ביעילות. בזמנה הפנוי היא נהנית לטייל, לטייל ולגדל צמחים.

דיפטי ראגה הוא מהנדס פיתוח תוכנה בצוות אמזון SageMaker. עבודתה הנוכחית מתמקדת בבניית תכונות לאירוח מודלים של למידת מכונה ביעילות. בזמנה הפנוי היא נהנית לטייל, לטייל ולגדל צמחים.

אלן טאן הוא מנהל מוצר בכיר ב- SageMaker, המוביל מאמצים בהסקת דגמים גדולים. הוא נלהב ליישם למידת מכונה לתחום האנליטיקה. מחוץ לעבודה, הוא נהנה בחוץ.

אלן טאן הוא מנהל מוצר בכיר ב- SageMaker, המוביל מאמצים בהסקת דגמים גדולים. הוא נלהב ליישם למידת מכונה לתחום האנליטיקה. מחוץ לעבודה, הוא נהנה בחוץ.

דוואל פאטל הוא אדריכל ראשי למידת מכונה ב-AWS. הוא עבד עם ארגונים החל מארגונים גדולים ועד סטארט-אפים בינוניים על בעיות הקשורות למחשוב מבוזר ובינה מלאכותית. הוא מתמקד בלמידה עמוקה כולל תחומי NLP ו-Computer Vision. הוא עוזר ללקוחות להשיג מסקנות מודל עם ביצועים גבוהים על SageMaker.

דוואל פאטל הוא אדריכל ראשי למידת מכונה ב-AWS. הוא עבד עם ארגונים החל מארגונים גדולים ועד סטארט-אפים בינוניים על בעיות הקשורות למחשוב מבוזר ובינה מלאכותית. הוא מתמקד בלמידה עמוקה כולל תחומי NLP ו-Computer Vision. הוא עוזר ללקוחות להשיג מסקנות מודל עם ביצועים גבוהים על SageMaker.

- הפצת תוכן ויחסי ציבור מופעל על ידי SEO. קבל הגברה היום.

- PlatoData.Network Vertical Generative Ai. העצים את עצמך. גישה כאן.

- PlatoAiStream. Web3 Intelligence. הידע מוגבר. גישה כאן.

- PlatoESG. פחמן, קלינטק, אנרגיה, סביבה, שמש, ניהול פסולת. גישה כאן.

- PlatoHealth. מודיעין ביוטכנולוגיה וניסויים קליניים. גישה כאן.

- מקור: https://aws.amazon.com/blogs/machine-learning/minimize-real-time-inference-latency-by-using-amazon-sagemaker-routing-strategies/

- :יש ל

- :הוא

- :לֹא

- :איפה

- $ למעלה

- 1

- 100

- 125

- 150

- 17

- 1870

- 20

- 7

- 9

- a

- יכול

- אודות

- מאיצים

- להשיג

- לרוחב

- AI

- דגמי AI

- אלן

- אַלגוֹרִיתְם

- מאפשר

- אמזון בעברית

- אמזון SageMaker

- אמזון שירותי אינטרנט

- Amazon.com

- בין

- an

- אנליזה

- ניתוח

- ו

- API

- יישומים

- מריחה

- ARE

- AREA

- מלאכותי

- בינה מלאכותית

- AS

- At

- המכונית

- זמינות

- AWS

- איזון

- איזון

- BE

- מאחור

- שייך

- בהשוואות

- תועלת

- הטבות

- הטוב ביותר

- שניהם

- רחב

- לִבנוֹת

- בִּניָן

- ניטל

- אבל

- by

- שיחות

- CAN

- קיבולת

- מקרים

- מסוים

- שינוי

- שינויים

- לקוחות

- קוד

- COM

- מגיע

- רכיבים

- המחשב

- ראייה ממוחשבת

- מחשוב

- במקביל

- תְצוּרָה

- מוגדר

- התחשבות

- בהתחשב

- מורכב

- עלויות

- יוצרים

- נוֹכְחִי

- כיום

- לקוחות

- תַאֲרִיך

- עמוק

- למידה עמוקה

- בְּרִירַת מֶחדָל

- לפרוס

- פרס

- פריסה

- פריסות

- עיצוב

- לקבוע

- צעצועי התפתחות

- אחר

- לדון

- מופץ

- מחשוב מבוזר

- הפצה

- תחומים

- בְּמַהֲלָך

- באופן דינמי

- כל אחד

- יעילות

- יעילות

- מַאֲמָצִים

- לאפשר

- מופעל

- לעודד

- מקצה לקצה

- נקודת קצה

- מהנדס

- אנגלית

- חברות

- להעריך

- דוגמה

- חוויות

- מוסבר

- מאוד

- משפחה

- תכונות

- בסופו של דבר

- מתמקד

- הבא

- בעד

- היסוד

- החל מ-

- לגמרי

- כללי

- מייצר

- גנרטטיבית

- AI Generative

- gif

- נתן

- גרף

- גדל

- יש

- he

- עוזר

- לה

- גָבוֹהַ

- לו

- שֶׁלוֹ

- המארח

- אירח

- איך

- איך

- HTML

- HTTPS

- מאות

- לזהות

- if

- מדגים

- לשפר

- השבחה

- שיפורים

- שיפור

- in

- כולל

- נכנס

- גדל

- הודו

- למשל

- מוֹדִיעִין

- אינטראקטיבי

- אינטרס

- אל תוך

- IT

- שֶׁלָה

- jpg

- שמור

- הילדים

- שפה

- גָדוֹל

- מפעלים גדולים

- חֶבִיוֹן

- האחרון

- השקה

- מוביל

- לִלמוֹד

- למידה

- הכי פחות

- לינקדין

- חי

- לִטעוֹן

- מגרש

- להוריד

- מכונה

- למידת מכונה

- עושה

- לנהל

- הצליח

- מנהל

- דרך

- מאי..

- למדוד

- מנגנון

- מילי שניות

- דקה

- דקות

- ML

- מודל

- מודלים

- ניטור

- יותר

- מספר

- חדש

- NLP

- לא

- עַכשָׁיו

- מספר

- of

- המיוחדות שלנו

- לעתים קרובות

- on

- מבצעי

- מטב

- אפשרות

- or

- ארגונים

- שלנו

- הַחוּצָה

- בחוץ

- בחוץ

- בולט

- יותר

- מקיף

- פרמטר

- מסוים

- לוהט

- עבור

- ביצועים

- צמחים

- אפלטון

- מודיעין אפלטון

- אפלטון נתונים

- מדיניות

- אפשרי

- הודעה

- להציג

- מנהל

- בעיות

- המוצר

- מנהל מוצר

- הפקה

- הנחיות

- אקראי

- טִוּוּחַ

- במקום

- זמן אמת

- לקבל

- להמליץ

- מופחת

- להתייחס

- ללא קשר

- קָשׁוּר

- לבקש

- בקשות

- תגובה

- תגובות

- מסלול

- ניתוב

- הפעלה

- בעל חכמים

- סולם

- מחפשים

- מבחר

- לחצני מצוקה לפנסיונרים

- לשרת

- שרות

- שירותים

- סט

- הצבה

- היא

- הראה

- הראה

- הופעות

- חכם

- תוכנה

- פיתוח תוכנה

- פתרונות

- מתח

- חברות סטארט

- להישאר

- פשוט

- אסטרטגיות

- אִסטרָטֶגִיָה

- כזה

- נתמך

- תומך

- מערכות

- שולחן

- נטילת

- לדבר

- נבחרת

- טכנולוגיה

- מבחן

- בדיקות

- מֵאֲשֶׁר

- זֶה

- השמיים

- האזור

- שֶׁלָהֶם

- שם.

- אלה

- זֶה

- תפוקה

- זמן

- ל

- תְנוּעָה

- נסיעה

- מגמות

- סוגים

- משתמשים

- באמצעות

- ערכים

- משתנה

- מאוד

- חזון

- we

- אינטרנט

- שירותי אינטרנט

- טוֹב

- היו

- מתי

- אשר

- בזמן

- יצטרך

- עם

- תיק עבודות

- עבד

- זרימות עבודה

- עובד

- עובד

- אתה

- זפירנט

- אזורי