מבוא

בלמידת מכונה, החלפת הטיה-שונות היא מושג בסיסי המשפיע על הביצועים של כל מודל חזוי. זה מתייחס לאיזון העדין בין טעות הטיה לשגיאת שונות של מודל, מכיוון שאי אפשר למזער את שניהם בו זמנית. האיזון הנכון הוא חיוני להשגת ביצועי דגם מיטביים.

במאמר קצר זה, נגדיר הטיות ושונות, נסביר כיצד הם משפיעים על מודל למידת מכונה, ונספק כמה עצות מעשיות כיצד להתמודד איתם בפועל.

הבנת הטיה ושונות

לפני שנצלול לתוך הקשר בין הטיה לשונות, בואו נגדיר מה המונחים הללו מייצגים בלמידת מכונה.

טעות הטיה מתייחסת להבדל בין חיזוי של מודל לבין הערכים הנכונים שהוא מנסה לחזות (אמת קרקע). במילים אחרות, הטיה היא השגיאה שהמודל מבצע עקב ההנחות השגויות שלו לגבי התפלגות הנתונים הבסיסית. מודלים של הטיה גבוהה הם לרוב פשטניים מדי, לא מצליחים ללכוד את מורכבות הנתונים, מה שמוביל לחוסר התאמה.

שגיאת שונות, לעומת זאת, מתייחסת לרגישות המודל לתנודות קטנות בנתוני האימון. מודלים של שונות גבוהה הם מורכבים מדי ונוטים להתאים את הרעש בנתונים, ולא את התבנית הבסיסית, מה שמוביל להתאמת יתר. זה מביא לביצועים גרועים בנתונים חדשים שלא נראים.

הטיה גבוהה עלולה להוביל לחוסר התאמה, כאשר המודל פשוט מכדי לתפוס את מורכבות הנתונים. הוא מניח הנחות חזקות לגבי הנתונים ולא מצליח ללכוד את הקשר האמיתי בין משתני קלט ופלט. מצד שני, שונות גבוהה יכולה להוביל להתאמת יתר, כאשר המודל מורכב מדי ולומד את הרעש בנתונים ולא את הקשר הבסיסי בין משתני קלט ופלט. לפיכך, מודלים של התאמה יתר נוטים להתאים את נתוני האימון באופן הדוק מדי ולא יכללו היטב לנתונים חדשים, בעוד שמודלים מתאימים אפילו אינם מסוגלים להתאים את נתוני האימון במדויק.

כפי שהוזכר קודם לכן, הטיה ושונות קשורות, ומודל טוב מאזן בין טעות הטיה לשגיאת שונות. הפשרה בין הטיה לשונות היא התהליך של מציאת האיזון האופטימלי בין שני מקורות הטעות הללו. מודל עם הטיה נמוכה ושונות נמוכה ככל הנראה יתפקד היטב הן באימונים והן בנתונים חדשים, וימזער את השגיאה הכוללת.

הפשרה על הטיה-שונות

השגת איזון בין מורכבות המודל והיכולת שלו להכליל לנתונים לא ידועים היא הליבה של הפשרה בין הטיה לשונות. באופן כללי, למודל מורכב יותר תהיה הטיה נמוכה יותר אך שונות גבוהה יותר, בעוד שלמודל פשוט יותר תהיה הטיה גבוהה יותר אך שונות נמוכה יותר.

מכיוון שאי אפשר למזער הטיות ושונות בו זמנית, מציאת האיזון האופטימלי ביניהם חיונית בבניית מודל למידת מכונה חזק. לדוגמה, ככל שאנו מגדילים את המורכבות של מודל, אנו גם מגדילים את השונות. הסיבה לכך היא שמודל מורכב יותר צפוי להתאים את הרעש בנתוני האימון, מה שיוביל להתאמת יתר.

מצד שני, אם נשאיר את המודל פשוט מדי, נגדיל את ההטיה. הסיבה לכך היא שמודל פשוט יותר לא יוכל ללכוד את הקשרים הבסיסיים בנתונים, מה שיוביל לחוסר התאמה.

המטרה היא להכשיר מודל מורכב מספיק כדי ללכוד את הקשרים הבסיסיים בנתוני האימון, אך לא כל כך מורכב שיתאים לרעש בנתוני האימון.

חלוקת הטיה-שונות בפועל

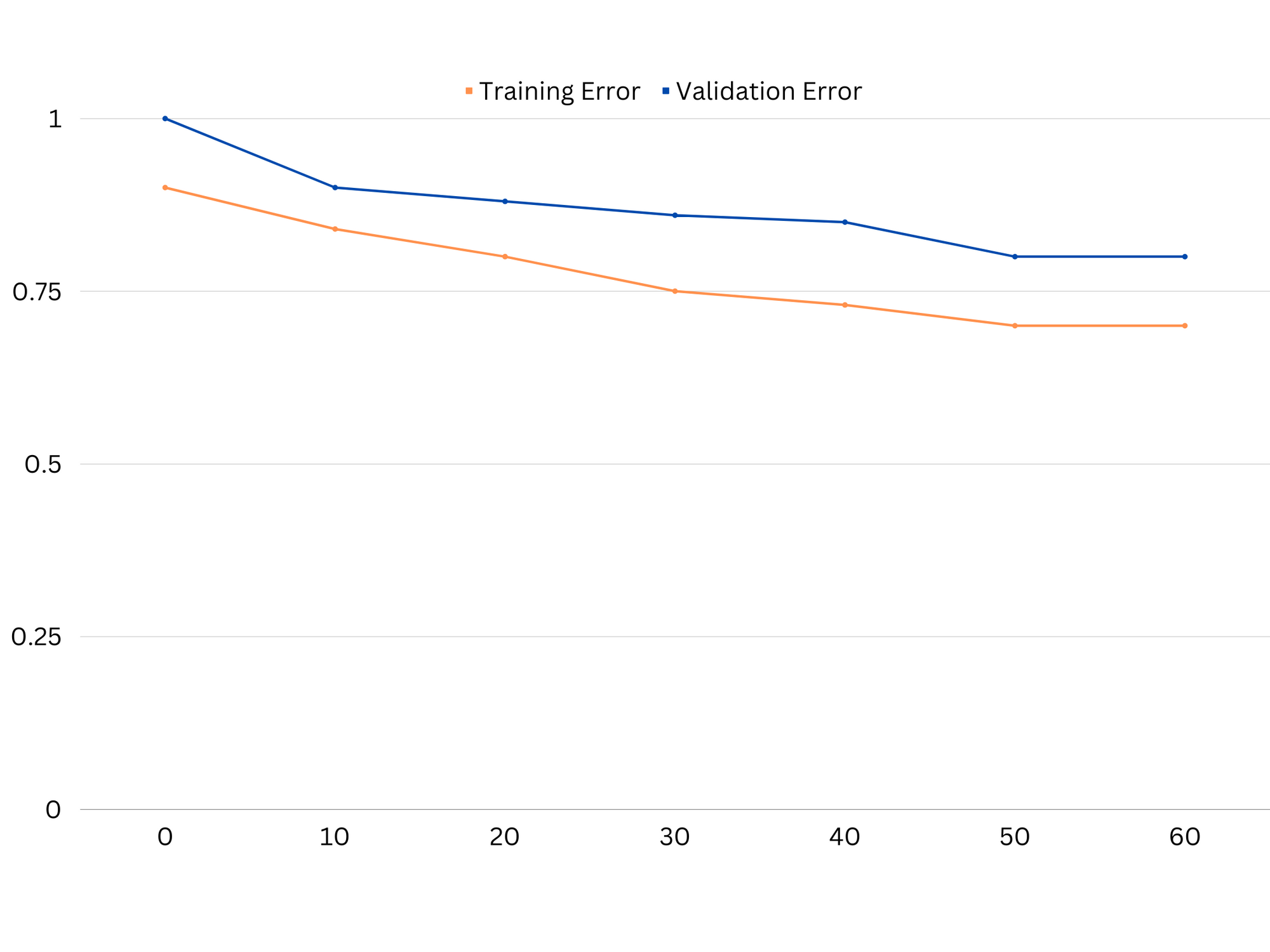

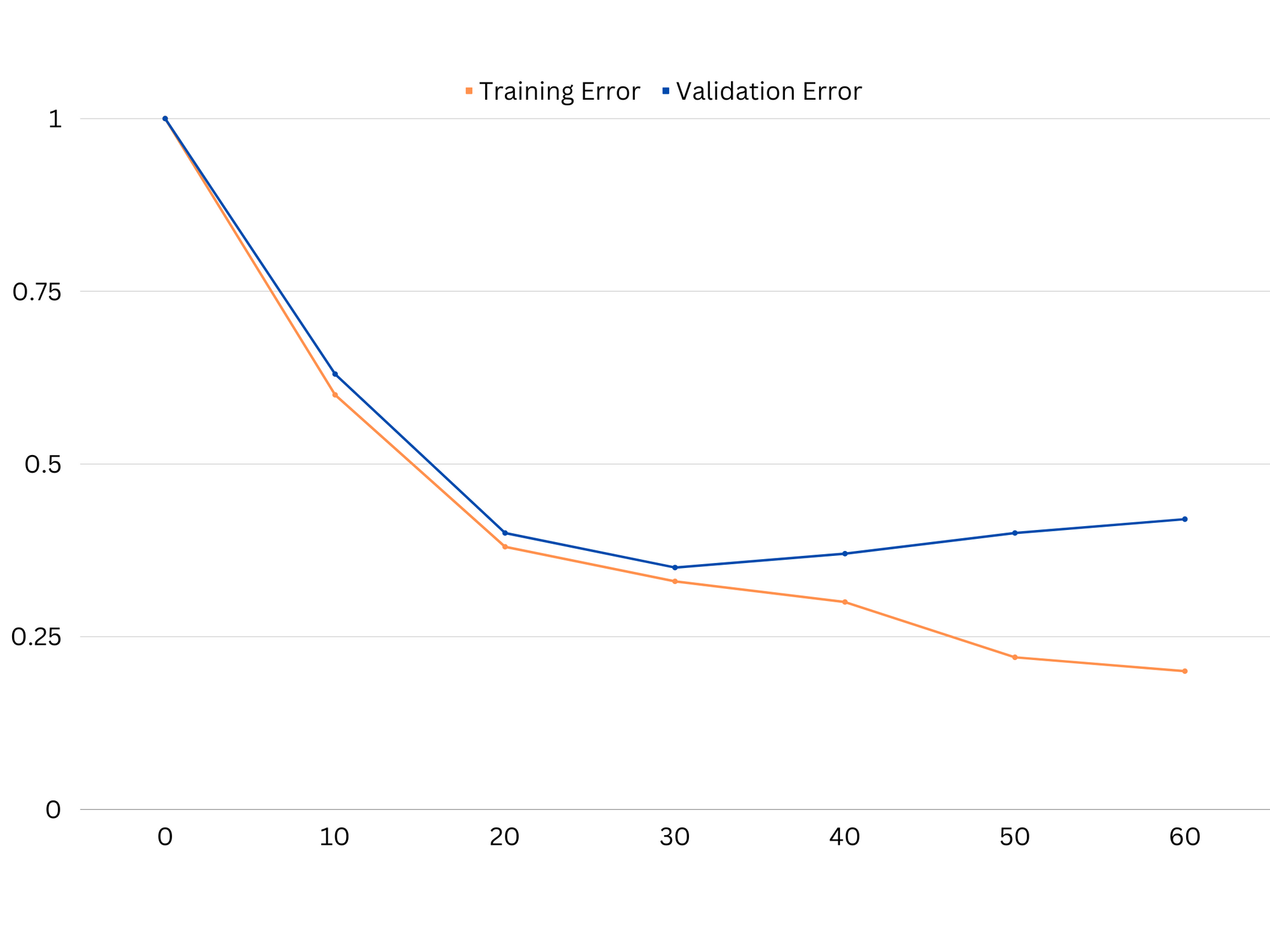

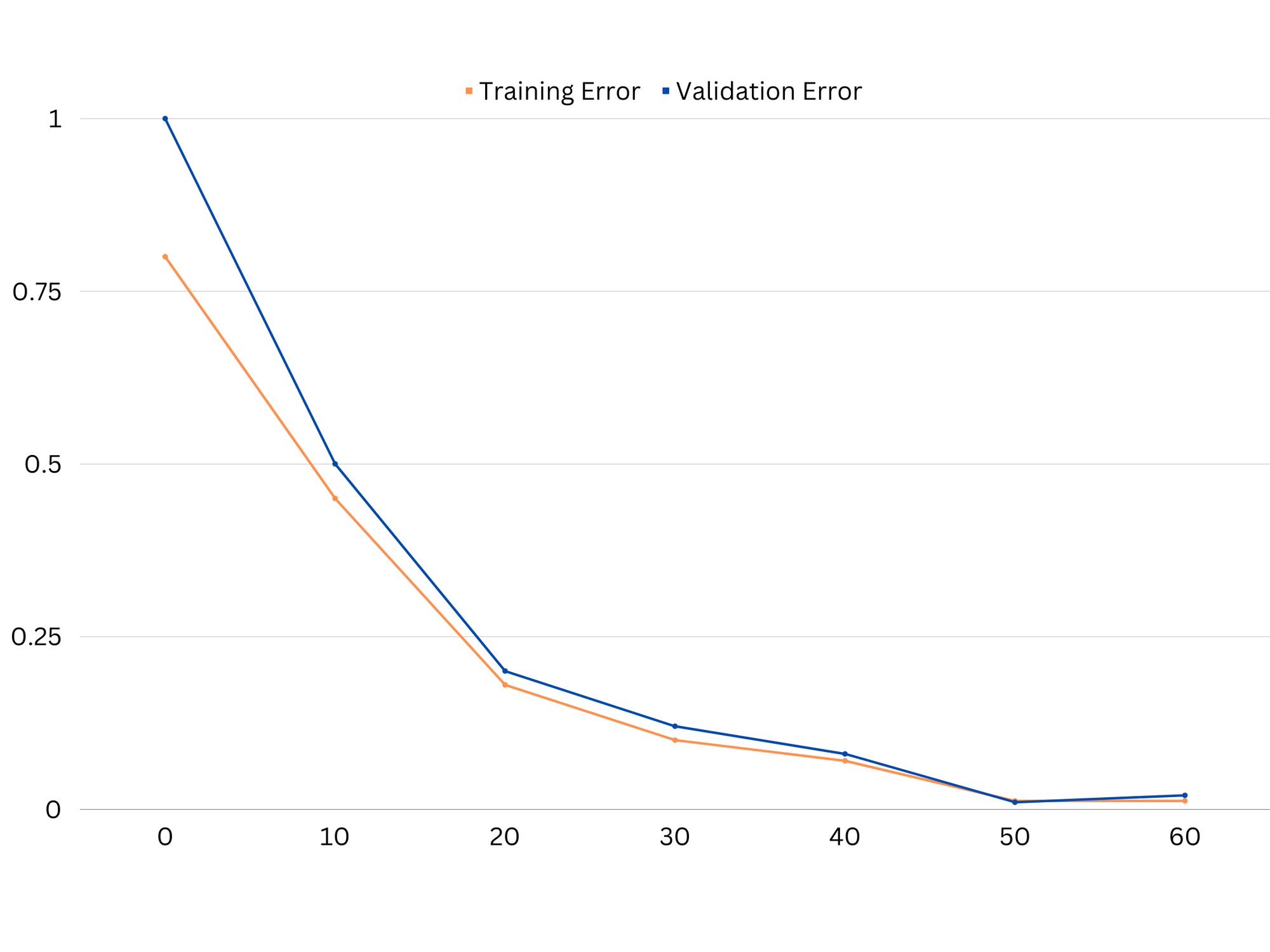

כדי לאבחן את ביצועי המודל, אנו בדרך כלל מחשבים ומשווים את שגיאות הרכבת והאימות. כלי שימושי להמחשה של זה הוא עלילה של עקומות הלמידה, המציגה את ביצועי המודל הן ברכבת והן בנתוני האימות לאורך תהליך האימון. על ידי בחינת עקומות אלו, נוכל לקבוע אם מודל מתאים יתר על המידה (שונות גבוהה), תת התאמה (הטיה גבוהה), או מתאים היטב (איזון אופטימלי בין הטיה לשונות).

דוגמה לעקומות למידה של מודל חסר התאמה. גם שגיאת הרכבת וגם שגיאת האימות גבוהות.

בפועל, ביצועים נמוכים הן בנתוני האימון והן באימות מצביעים על כך שהמודל פשוט מדי, מה שמוביל לחוסר התאמה. מצד שני, אם המודל מתפקד טוב מאוד בנתוני האימון אך גרוע בנתוני הבדיקה, סביר להניח שמורכבות המודל גבוהה מדי, וכתוצאה מכך להתאמת יתר. כדי לטפל בחוסר התאמה, אנו יכולים לנסות להגדיל את מורכבות המודל על ידי הוספת תכונות נוספות, שינוי אלגוריתם הלמידה או בחירת היפרפרמטרים שונים. במקרה של התאמה יתר, עלינו לשקול להסדיר את המודל או להשתמש בטכניקות כמו אימות צולב כדי לשפר את יכולות ההכללה שלו.

דוגמה לעקומות למידה של דגם התאמה יתר. שגיאת הרכבת פוחתת בעוד שגיאת האימות מתחילה לגדול. המודל אינו מסוגל להכליל.

רגוליזציה היא טכניקה שניתן להשתמש בה כדי להפחית את שגיאת השונות במודלים של למידת מכונה, ועוזרת להתמודד עם הפשרה בין הטיה לשונות. ישנן מספר טכניקות רגוליזציה שונות, לכל אחת יתרונות וחסרונות משלה. כמה טכניקות רגוליזציה פופולריות כוללות רגרסיית רכס, רגרסיית לאסו וסידור נטו אלסטי. כל הטכניקות הללו מסייעות במניעת התאמת יתר על ידי הוספת מונח ענישה לתפקוד האובייקטיבי של המודל, מה שמרתיע ערכי פרמטר קיצוניים ומעודד מודלים פשוטים יותר.

רגרסיה של רכס, הידוע גם בשם L2 regularization, מוסיף מונח עונש פרופורציונלי לריבוע של פרמטרי המודל. טכניקה זו נוטה לגרום למודלים עם ערכי פרמטרים קטנים יותר, מה שיכול להוביל לשונות מופחתת ולהכללה משופרת. עם זאת, הוא אינו מבצע בחירת תכונות, כך שכל התכונות נשארות בדגם.

עיין במדריך המעשי והמעשי שלנו ללימוד Git, עם שיטות עבודה מומלצות, סטנדרטים מקובלים בתעשייה ודף רמאות כלול. תפסיק לגוגל פקודות Git ולמעשה ללמוד זה!

רגרסיה של לאסו, או הסדרת L1, מוסיפה מונח עונש פרופורציונלי לערך המוחלט של פרמטרי המודל. טכניקה זו יכולה להוביל למודלים עם ערכי פרמטרים דלילים, המבצעים למעשה בחירת תכונה על ידי קביעת פרמטרים מסוימים לאפס. זה יכול לגרום למודלים פשוטים יותר שקל יותר לפרש.

הסדרת נטו אלסטית הוא שילוב של רגוליזציה L1 ו-L2, המאפשרת איזון בין רכס ורגרסיית לאסו. על ידי שליטה ביחס בין שני תנאי הענישה, רשת אלסטית יכולה להשיג את היתרונות של שתי הטכניקות, כגון הכללה משופרת ובחירת תכונה.

דוגמה לעקומות למידה של מודל מתאים.

מסקנות

הפשרה בין הטיה לשונות היא מושג מכריע בלמידת מכונה שקובע את האפקטיביות והטובות של מודל. בעוד שהטיה גבוהה מובילה לחוסר התאמה ושונות גבוהה מובילה להתאמת יתר, מציאת האיזון האופטימלי בין השניים הכרחי לבניית מודלים חזקים שמכלילים היטב לנתונים חדשים.

בעזרת עקומות למידה, ניתן לזהות בעיות של התאמה יתר או תת-התאמה, ועל ידי כוונון מורכבות המודל או יישום טכניקות רגוליזציה, ניתן לשפר את הביצועים הן על נתוני ההדרכה והן על נתוני האימות, וכן על נתוני הבדיקה.

- הפצת תוכן ויחסי ציבור מופעל על ידי SEO. קבל הגברה היום.

- PlatoAiStream. Web3 Data Intelligence. הידע מוגבר. גישה כאן.

- הטבעת העתיד עם אדריאן אשלי. גישה כאן.

- קנה ומכירה של מניות בחברות PRE-IPO עם PREIPO®. גישה כאן.

- מקור: https://stackabuse.com/the-bias-variance-trade-off-in-machine-learning/

- :הוא

- :לֹא

- :איפה

- 1

- 12

- 20

- 8

- a

- יכולת

- יכול

- אודות

- מוּחלָט

- במדויק

- להשיג

- השגתי

- למעשה

- מוסיף

- כתובת

- מוסיף

- יתרונות

- עצה

- להשפיע על

- משפיע

- אַלגוֹרִיתְם

- תעשיות

- מאפשר

- גם

- an

- ו

- כל

- ARE

- מאמר

- AS

- איזון

- יתרות

- BE

- כי

- הטבות

- בֵּין

- הטיה

- גבול

- שניהם

- בִּניָן

- אבל

- by

- לחשב

- CAN

- יכולות

- ללכוד

- מקרה

- משתנה

- בחירה

- מקרוב

- שילוב

- לְהַשְׁווֹת

- מורכב

- מורכבות

- מושג

- לשקול

- שליטה

- ליבה

- לתקן

- מכריע

- נתונים

- עסקה

- ירידות

- לקבוע

- קובע

- הבדל

- אחר

- מציג

- הפצה

- עושה

- ראוי

- כל אחד

- מוקדם יותר

- קל יותר

- יעילות

- יְעִילוּת

- מעודד את

- מספיק

- שגיאה

- שגיאות

- אֲפִילוּ

- בוחן

- דוגמה

- להסביר

- קיצוני

- אי

- נכשל

- מאפיין

- תכונות

- מציאת

- מתאים

- הוֹלֵם

- תנודות

- להתמקד

- בעד

- פונקציה

- יסודי

- כללי

- Git

- מטרה

- טוב

- קרקע

- מדריך

- יד

- ידות על

- יש

- לעזור

- עזרה

- גָבוֹהַ

- גבוה יותר

- לרחף

- איך

- איך

- אולם

- HTTPS

- לזהות

- if

- יישום

- בלתי אפשרי

- לשפר

- משופר

- in

- באחר

- לכלול

- כלול

- להגדיל

- גדל

- קלט

- אל תוך

- מבוא

- IT

- שֶׁלָה

- שמור

- ידוע

- L1

- l2

- עוֹפֶרֶת

- מוביל

- מוביל

- למידה

- לתת

- LG

- כמו

- סביר

- ll

- נמוך

- להוריד

- מכונה

- למידת מכונה

- עושה

- מוּזְכָּר

- מזעור

- מודל

- מודלים

- יותר

- הכרחי

- נטו

- חדש

- רעש

- מספר

- מטרה

- of

- לעתים קרובות

- on

- אופטימלי

- or

- אחר

- שלנו

- הַחוּצָה

- תפוקה

- שֶׁלוֹ

- פרמטר

- פרמטרים

- תבנית

- לְבַצֵעַ

- ביצועים

- ביצוע

- מבצע

- אפלטון

- מודיעין אפלטון

- אפלטון נתונים

- עני

- פופולרי

- אפשרי

- מעשי

- תרגול

- לחזות

- נבואה

- למנוע

- בעיות

- תהליך

- לספק

- במקום

- יחס

- להפחית

- מופחת

- מתייחס

- קָשׁוּר

- קשר

- מערכות יחסים

- להשאר

- לייצג

- תוצאה

- וכתוצאה מכך

- תוצאות

- תקין

- טַבַּעַת

- חָסוֹן

- s

- מבחר

- רְגִישׁוּת

- הצבה

- Shadow

- גיליון

- קצר

- צריך

- פָּשׁוּט

- בו זמנית

- קטן

- קטן יותר

- So

- כמה

- מקורות

- מרובע

- Stackabuse

- תקנים

- עצור

- חזק

- כזה

- מציע

- טכניקות

- טווח

- מונחים

- מבחן

- מֵאֲשֶׁר

- זֶה

- השמיים

- שֶׁלָהֶם

- אותם

- שם.

- אלה

- הֵם

- זֶה

- בכל

- ל

- גַם

- כלי

- סה"כ

- רכבת

- הדרכה

- מַעֲבָר

- נָכוֹן

- אמת

- לנסות

- שתיים

- בדרך כלל

- לא מסוגל

- בְּסִיסִי

- לא ידוע

- מְשׁוּמָשׁ

- באמצעות

- אימות

- ערך

- ערכים

- מאוד

- we

- טוֹב

- מה

- אם

- אשר

- בזמן

- יצטרך

- עם

- מילים

- זפירנט

- אפס