AmazonSageMakerデータラングラー 機械学習 (ML) 用のデータの集計と準備にかかる時間を数週間から数分に短縮 Amazon SageMakerスタジオは、ML 向けの初の完全統合開発環境 (IDE) です。 Data Wrangler を使用すると、データの準備と特徴量エンジニアリングのプロセスを簡素化し、データの選択、クレンジング、探索、視覚化など、データ準備ワークフローの各ステップを単一のビジュアル インターフェイスから完了することができます。 次のような複数のデータ ソースからデータをインポートできます。 Amazon シンプル ストレージ サービス (Amazon S3)、 Amazonレッドシフト, スノーフレーク, 26 のフェデレーテッド クエリ データ ソース による支援 アマゾンアテナ.

本日より、Athena データ ソースからデータをインポートするときに、S3 クエリの出力場所とデータ保持期間を構成して Data Wrangler にデータをインポートし、Athena が中間データを保存する場所と期間を制御できます。 この投稿では、この新機能について説明します。

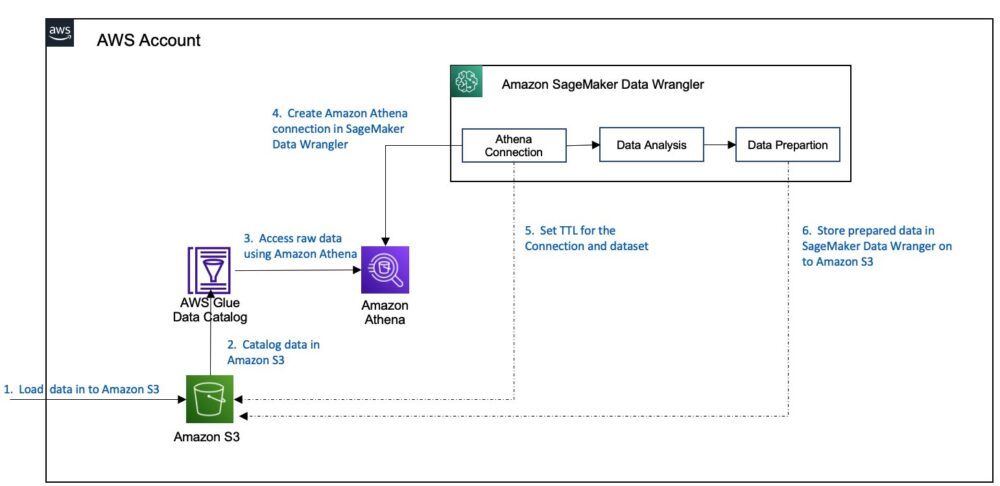

ソリューションの概要

Athena は、簡単に閲覧できるインタラクティブなクエリ サービスです。 AWSグルー Data Catalog を使用し、標準 SQL を使用して Amazon S3 および 26 のフェデレーテッド クエリ データ ソースのデータを分析します。 Athena を使用してデータをインポートする場合、Data Wrangler のデフォルトの S3 の場所を Athena クエリ出力に使用するか、Athena ワークグループを指定してカスタムの S3 の場所を強制することができます。 以前は、クリーンアップ ワークフローを実装してこの中間データを削除するか、S3 ライフサイクル構成を手動でセットアップしてストレージ コストを制御し、組織のデータ セキュリティ要件を満たす必要がありました。 これは運用上の大きなオーバーヘッドであり、スケーラブルではありません。

Data Wrangler は、Athena クエリ出力のカスタム S3 ロケーションとデータ保持期間をサポートするようになりました。 この新機能により、Athena クエリの出力場所をカスタム S3 バケットに変更できます。 これで、Athena クエリ出力のデフォルトのデータ保持ポリシーが 5 日間になりました。これを変更して、組織のデータ セキュリティ要件を満たすことができます。 保持期間に基づいて、S3 バケットの Athena クエリ出力は自動的にクリーンアップされます。 データをインポートした後、このデータセットで探索的データ分析を実行し、クリーンなデータを Amazon S3 に保存できます。

次の図は、このアーキテクチャを示しています。

このユース ケースでは、サンプルの銀行データセットを使用してソリューションを説明します。 ワークフローは次の手順で構成されます。

- ダウンロード サンプルデータセット S3 バケットにアップロードします。

- AWS Glue をセットアップする クローラー スキーマをクロールし、メタデータ スキーマを AWS Glue データ カタログに保存します。

- Athena を使用して Data Catalog にアクセスし、S3 バケットからデータをクエリします。

- Athena に接続するための新しい Data Wrangler フローを作成します。

- 接続を作成するときに、データセットの保持 TTL を設定します。

- ワークフローでこの接続を使用し、クリーンなデータを別の S3 バケットに保存します。

簡単にするために、Athena 環境が既にセットアップされていることを前提としています (ステップ 1 ~ 3)。 以降の手順については、この投稿で詳しく説明します。

前提条件

Athena 環境を設定するには、 ユーザーガイド ステップバイステップの手順については、前のセクションで概説した手順 1 ~ 3 を完了してください。

Athena から Data Wrangler にデータをインポートする

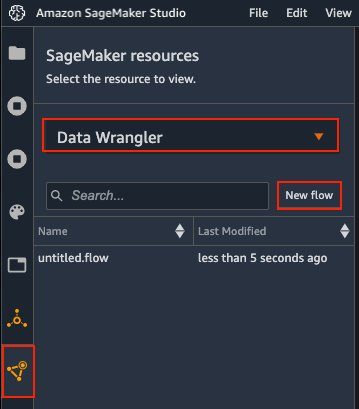

データをインポートするには、次の手順を実行します。

- Studio コンソールで、 リソース アイコンをクリックします。

- 選択する データラングラー ドロップダウンメニューで

- 選択する 新しいフロー.

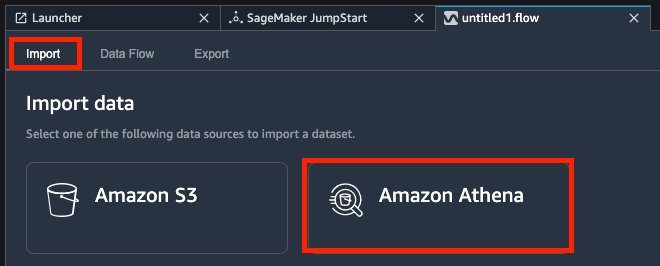

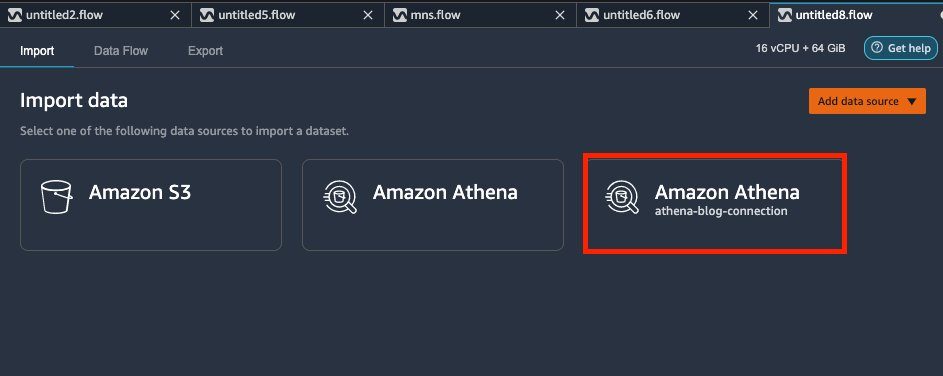

- ソフトウェア設定ページで、下図のように インポート タブを選択 アマゾンアテナ.

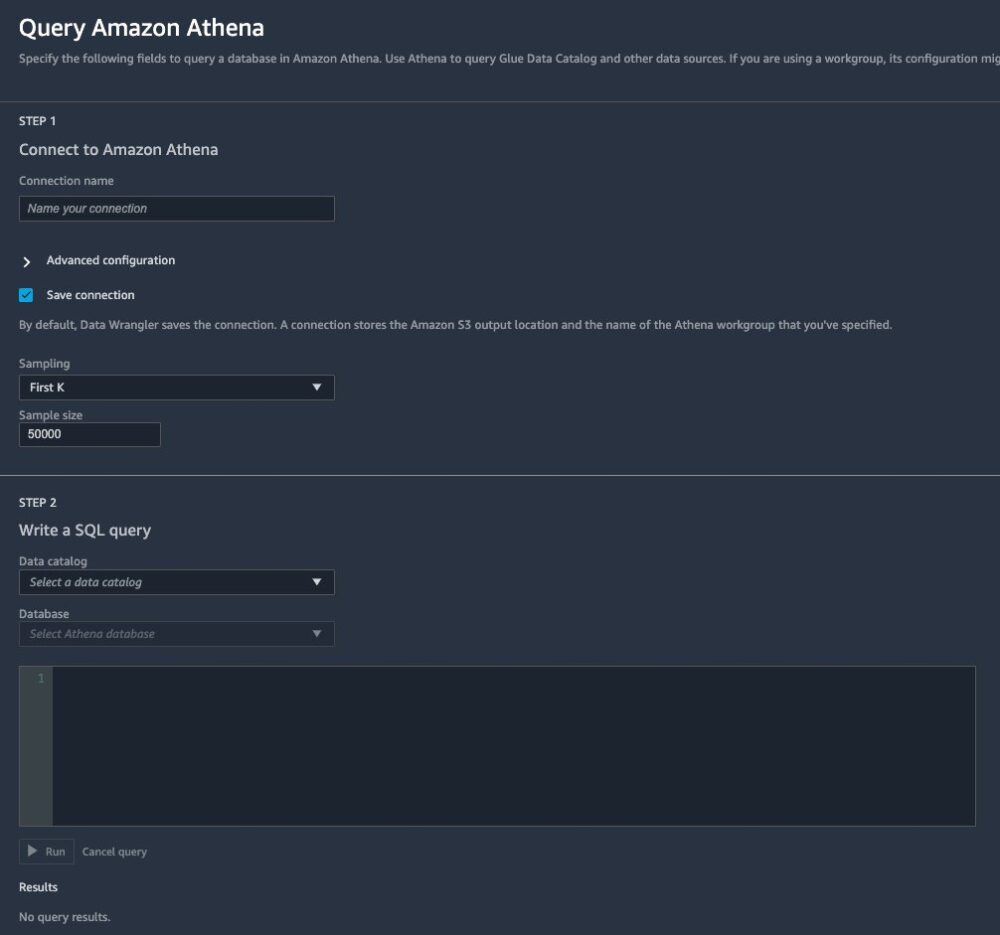

詳細ページが開き、Athena に接続して、データベースからインポートする SQL クエリを記述できます。 - 接続の名前を入力します。

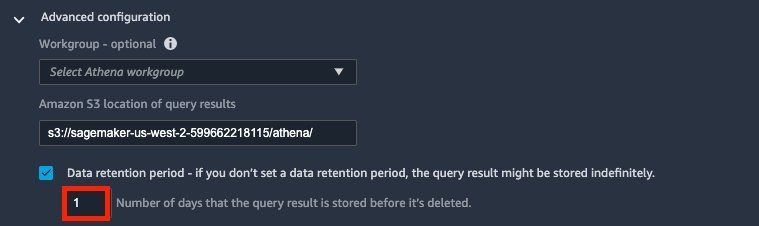

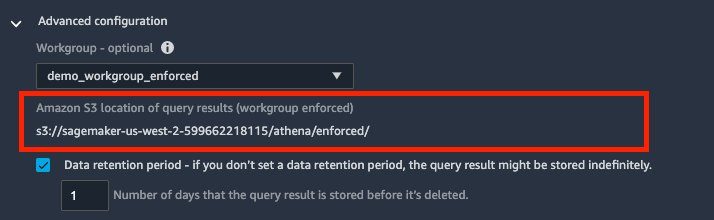

- 詳細 高度な設定.

Athena に接続するとき、Data Wrangler は Amazon S3 を使用してクエリされたデータをステージングします。 デフォルトでは、このデータは S3 の場所にステージングされますs3://sagemaker-{region}-{account_id}/athena/保持期間は 5 日間です。 - クエリ結果の Amazon S3 の場所、S3 の場所を入力します。

- 選択 データ保持期間 データ保持期間を設定します (この投稿では 1 日)。

このオプションの選択を解除すると、データは無期限に保持されます。 バックグラウンドで、Data Wrangler は S3 ライフサイクル構成ポリシーをその S3 の場所にアタッチして、自動的にクリーンアップします。 次のポリシーの例を参照してください。

バックグラウンドで、Data Wrangler は S3 ライフサイクル構成ポリシーをその S3 の場所にアタッチして、自動的にクリーンアップします。 次のポリシーの例を参照してください。

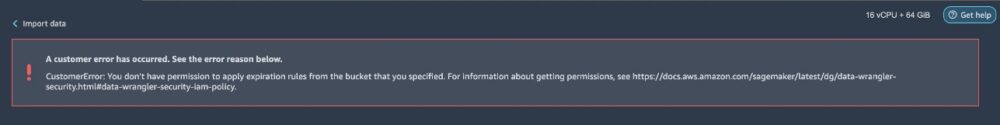

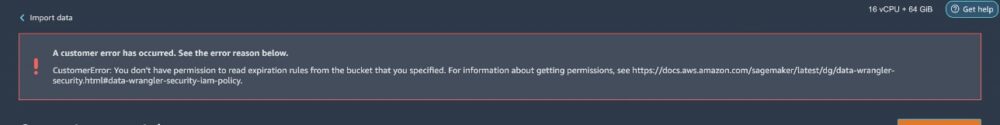

あなたが必要です

s3:GetLifecycleConfigurationおよびs3:PutLifecycleConfigurationSageMaker 実行ロールがライフサイクル設定ポリシーを正しく適用できるようにします。 これらのアクセス許可がない場合、データをインポートしようとするとエラー メッセージが表示されます。次のエラー メッセージは、

GetLifecycleConfiguration許可。

次のエラー メッセージは、

PutLifecycleConfiguration許可。 - オプションで、 ワークグループ、Athena ワークグループを指定できます。

Athena ワークグループは、ユーザー、チーム、アプリケーション、またはワークロードをグループに分離し、それぞれが独自のアクセス許可と構成設定を持ちます。 ワークグループを指定すると、Data Wrangler は Athena で定義されたワークグループ設定を継承します。 たとえば、ワークグループに、クエリ結果を保存するために定義された S3 の場所があり、有効になっている場合 クライアント側をオーバーライドする 設定では、S3 クエリ結果の場所を編集できません。 デフォルトでは、Data Wrangler は Athena 接続も保存します。 これは、新しい Athena タイルとして表示されます。 インポート タブ。 いつでもその接続を再度開いてクエリを実行し、さまざまなデータを Data Wrangler に取り込むことができます。

デフォルトでは、Data Wrangler は Athena 接続も保存します。 これは、新しい Athena タイルとして表示されます。 インポート タブ。 いつでもその接続を再度開いてクエリを実行し、さまざまなデータを Data Wrangler に取り込むことができます。

- 選択を解除 接続を保存 接続を保存したくない場合。

- Athena 接続を設定するには、 なし for サンプリング データセット全体をインポートします。

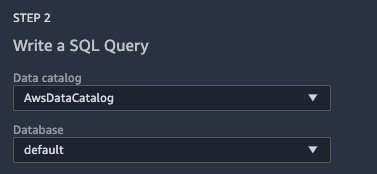

大規模なデータセットの場合、Data Wrangler を使用すると、データのサブセットをインポートして変換ワークフローを構築し、準備が整ったときにのみデータセット全体を処理できます。 これにより、反復サイクルが高速化され、処理時間とコストが節約されます。 利用可能なさまざまなデータ サンプリング オプションの詳細については、次の URL をご覧ください。 Amazon SageMaker Data Wrangler がランダムサンプリングと階層化サンプリングをサポートするようになりました. - データカタログ¸選ぶ AWSデータカタログ.

- データベース、データベースを選択します。

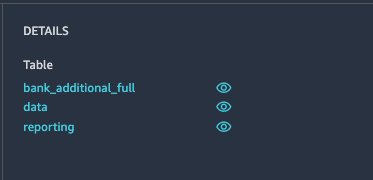

Data Wrangler に使用可能なテーブルが表示されます。 各テーブルを選択して、スキーマを確認し、データをプレビューできます。

- クエリ フィールドに次のコードを入力します。

- 選択する ラン データをプレビューします。

- すべてが良さそうな場合は、選択してください インポート.

- データセット名を入力して選択します Add データを Data Wrangler ワークスペースにインポートします。

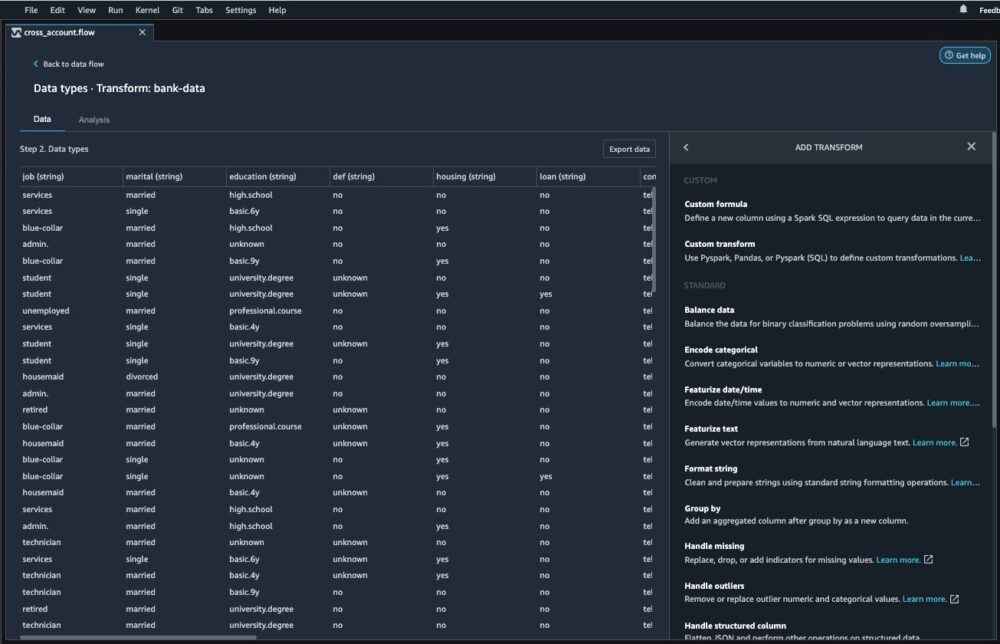

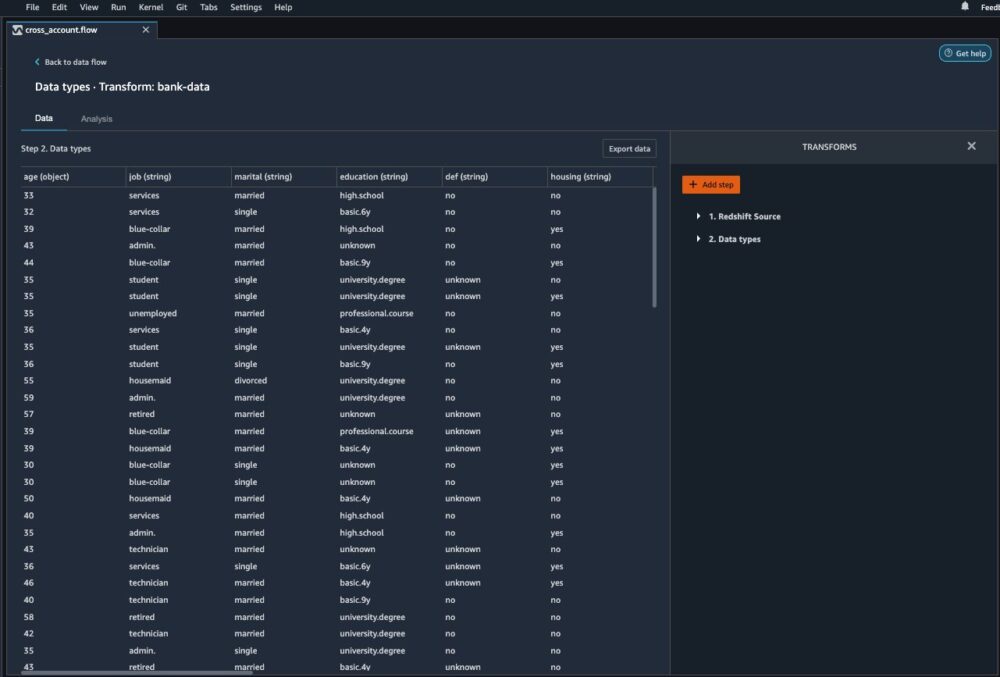

データラングラーを使用してデータを分析および処理する

データを Data Wrangler にロードした後、探索的データ分析 (EDA) を実行して、機械学習用のデータを準備できます。

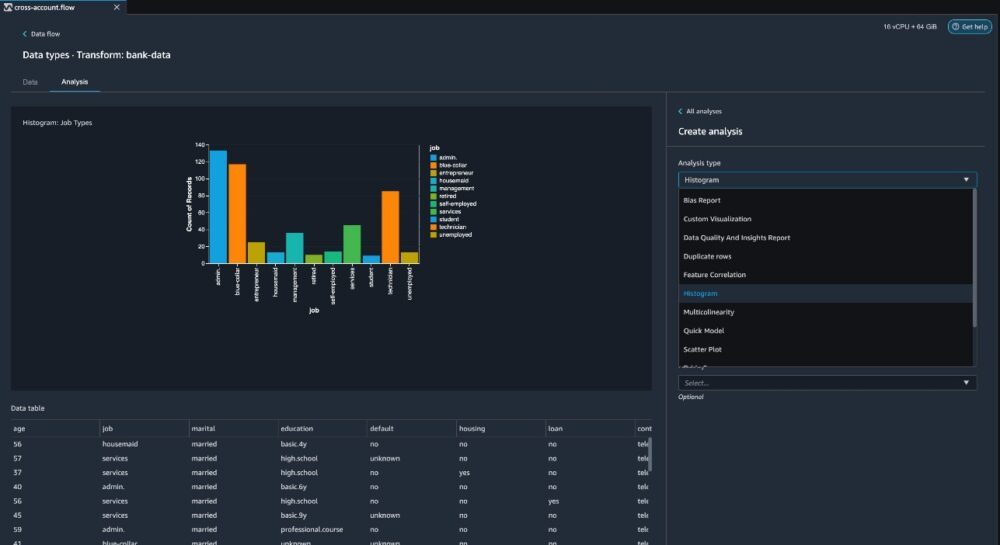

- の横にあるプラス記号を選択します

bank-dataデータフローのデータセット、および選択 分析を追加.

Data Wrangler には、Data Quality and Insights Report、データ相関、事前トレーニング バイアス レポート、データセットの概要、視覚化 (ヒストグラムや散布図など) などの組み込みの分析が用意されています。 さらに、独自のカスタム ビジュアライゼーションを作成できます。

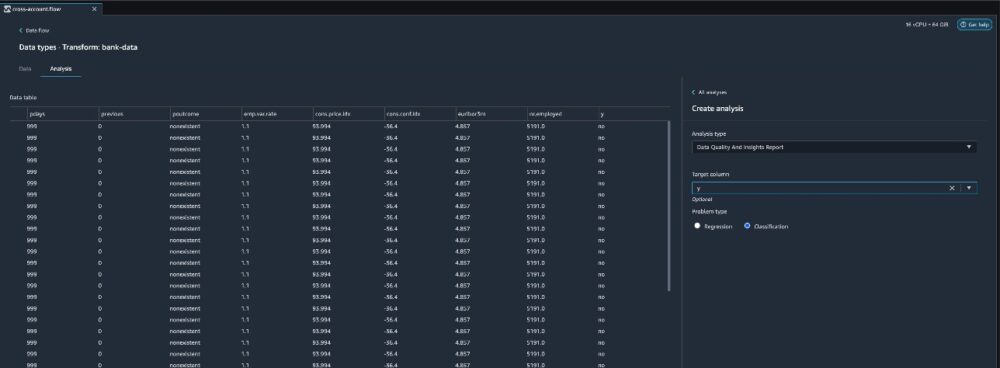

- 分析タイプ¸選ぶ データ品質とインサイト レポート.

これにより、視覚化、データ品質の問題を特定するための分析、およびデータセットに必要な適切な変換の推奨事項が自動的に生成されます。 - ターゲット列、選択する Y.

- これは分類問題ステートメントであるため、 問題の種類選択 Classification.

- 選択する 創造する.

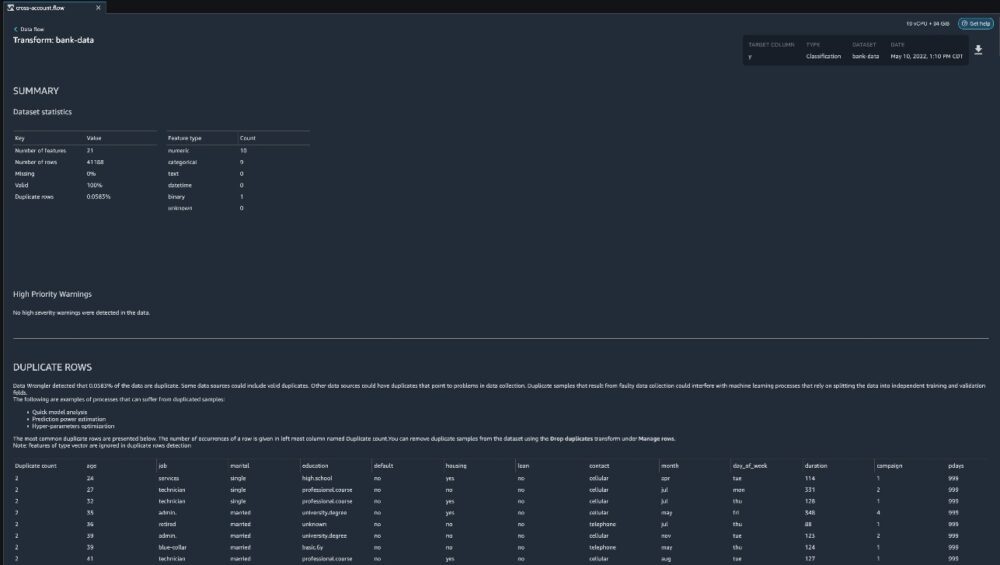

データラングラーは、データセットに関する詳細なレポートを作成します。 レポートをローカルマシンにダウンロードすることもできます。

- データを準備するには、データ フローの銀行データ データセットの横にあるプラス記号を選択し、 変換を追加.

- 選択する ステップを追加 変革の構築を開始します。

この記事の執筆時点で、DataWranglerは300を超える組み込みの変換を提供しています。 PandasまたはPySparkを使用して独自の変換を作成することもできます。

これで、ビジネス要件に基づいて変換と分析の構築を開始できます。

クリーンアップ

継続的なコストを回避するには、終了時に以下の手順を使用して Data Wrangler リソースを削除します。

- [実行中のインスタンスとカーネル] アイコンを選択します。

- [RUNNING APPS] の下で、横にあるシャットダウン アイコンをクリックします。

sagemaker-data-wrangler-1.0 app. - [すべてシャットダウン] を選択して確認します。

まとめ

この投稿では、S3 の場所をカスタマイズし、Athena から Data Wrangler にデータをインポートするための S3 ライフサイクル構成を有効にする方法の概要を説明しました。 この機能を使用すると、中間データを安全な S3 の場所に保存し、保持期間後にデータ コピーを自動的に削除して、データへの不正アクセスのリスクを軽減できます。 この新機能をぜひお試しください。 ハッピービル!

Athena と SageMaker の詳細については、次の Web サイトをご覧ください。 Athenaユーザーガイド および AmazonSageMakerのドキュメント.

著者について

ミーナクシスンダラム・タンダヴァラヤン AWSのシニアAI/MLスペシャリストです。 彼は、AIとMLの旅でハイテク戦略アカウントを支援しています。 彼はデータ駆動型AIに非常に情熱を注いでいます。

ミーナクシスンダラム・タンダヴァラヤン AWSのシニアAI/MLスペシャリストです。 彼は、AIとMLの旅でハイテク戦略アカウントを支援しています。 彼はデータ駆動型AIに非常に情熱を注いでいます。

ハリッシュラジャゴパラン アマゾンウェブサービスのシニアソリューションアーキテクトです。 Harishは企業のお客様と協力し、クラウドへの移行を支援します。

ハリッシュラジャゴパラン アマゾンウェブサービスのシニアソリューションアーキテクトです。 Harishは企業のお客様と協力し、クラウドへの移行を支援します。

ジェームズ・ウー AWSのシニアAI/MLスペシャリストソリューションアーキテクトです。 お客様がAI/MLソリューションを設計および構築するのを支援します。 Jamesの仕事は、コンピュータビジョン、ディープラーニング、企業全体でのMLのスケーリングに主な関心を持って、幅広いMLユースケースをカバーしています。 AWSに入社する前、Jamesは、エンジニアリングで10年間、マーケティングおよび広告業界で6年間を含む、4年以上にわたってアーキテクト、開発者、およびテクノロジーのリーダーでした。

ジェームズ・ウー AWSのシニアAI/MLスペシャリストソリューションアーキテクトです。 お客様がAI/MLソリューションを設計および構築するのを支援します。 Jamesの仕事は、コンピュータビジョン、ディープラーニング、企業全体でのMLのスケーリングに主な関心を持って、幅広いMLユースケースをカバーしています。 AWSに入社する前、Jamesは、エンジニアリングで10年間、マーケティングおよび広告業界で6年間を含む、4年以上にわたってアーキテクト、開発者、およびテクノロジーのリーダーでした。