ビデオ Google の最新の調査によると、Google の最大の AI 言語モデルは、ロボットが人間のコマンドをより柔軟に理解し、解釈するのに役立っています。

通常、マシンは非常に具体的な要求に最もよく反応します。制限のない要求は、場合によってはそれらを無視し、ユーザーが考えていなかった結果につながる可能性があります。 人々は、ロボットとのやり取りを厳格に行うことを学びます。たとえば、特定の方法で質問して、望ましい応答を得るなどです。

しかし、PaLM-SayCan と呼ばれる Google の最新システムは、よりスマートになることが約束されています。 Everyday Robots の物理デバイス (Google X からスピンアウトしたスタートアップ) には、頭に目用のカメラがあり、一連の車輪の上にある長くまっすぐな体の後ろにハサミの付いた腕が入っています。

以下のビデオでロボットの動作を見ることができます。

ロボットに「ちょうど運動したんだけど、ヘルシーなおやつをくれる?」などと尋ねます。 りんごを取ってきます。 「PaLM-SayCan [is] は、言語モデルからの知識を活用するための解釈可能な一般的なアプローチであり、ロボットが高レベルのテキスト指示に従って物理的に根拠のあるタスクを実行できるようにします」と、Google のブレイン チームの研究科学者は述べています。 説明.

Google が最大の言語モデルを導入 手のひら 今年のXNUMX月。 PaLM はインターネットから収集したデータを使用してトレーニングされましたが、システムは、自由形式のテキスト応答を吐き出す代わりに、ロボットが従うべき指示のリストを生成するように適合されていました。

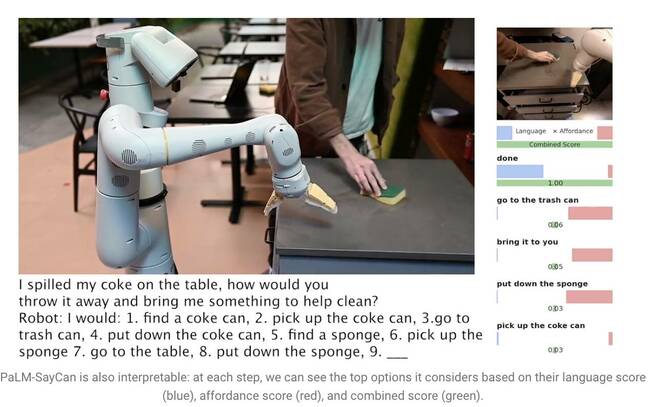

「コーラをテーブルにこぼしてしまいました。どうやってそれを捨てて、きれいにするのに役立つものを持ってきてくれますか?」と言うと、PaLM は質問を理解し、ロボットがタスクを完了するためにたどる手順のリストを生成します。缶を拾い、ビンに投げ入れ、スポンジを手に入れます。

しかし、PaLM のような大規模言語モデル (LLM) は、その言葉の意味を理解していません。 このため、研究者は強化学習を使用して別のモデルをトレーニングし、抽象的な言語を視覚的表現と行動に基づいて学習させました。 そうすることで、ロボットは「コーラ」という言葉を炭酸飲料の缶のイメージと関連付けることを学習します。

また、PaLM-SayCan は、いわゆる「アフォーダンス関数」を学習します。これは、環境内のオブジェクトが与えられた特定のアクションを完了する可能性をランク付けする方法です。 たとえば、ロボットがスポンジを検出しても近くに掃除機がない場合、ロボットは掃除機よりもスポンジを拾う可能性が高くなります。

「私たちの方法であるSayCanは、物理的に根拠のあるタスクでLLM内の知識を抽出して活用します」とチームは説明しました 研究論文. 「LLM (Say) は、高レベルの目標に役立つアクションを決定するためのタスクグラウンディングを提供し、学習されたアフォーダンス機能 (Can) は、計画に基づいて何が実行できるかを決定するための世界グラウンディングを提供します。 世界で可能なことのアフォーダンスを提供する言語条件付きの価値関数を学習する方法として、強化学習 (RL) を使用しています。」

ロボットがタスクから外れるのを防ぐために、101 の異なる指示のみからアクションを選択するようにトレーニングされています。 Google はキッチンに適応するようにトレーニングしました。PaLM-SayCan は軽食や飲み物を手に入れ、簡単な掃除作業を行うことができます。 研究者たちは、LLM はロボットに抽象的な指示が与えられたより複雑なタスクを安全に実行させるための最初のステップであると考えています。

「現実世界の多くのロボット タスクに関する私たちの実験では、長期にわたる抽象的な自然言語の指示を高い成功率で計画し、完了する能力が実証されています。 私たちは、PaLM-SayCan の解釈可能性により、現実世界のユーザーとロボットとの安全な対話が可能になると信じています。」 ®