ますますデータ中心の世界では、企業は、貴重な物理情報の収集と、必要だが簡単に取得できない情報の生成の両方に集中する必要があります。 データ アクセス、規制、およびコンプライアンスは、分析と人工知能 (AI) のイノベーションに対する摩擦の増大する原因となっています。

金融サービス、ヘルスケア、ライフ サイエンス、自動車、ロボティクス、製造などの規制の厳しいセクターでは、問題はさらに大きくなります。 これは、システム設計、データ共有 (内部および外部)、収益化、分析、および機械学習 (ML) に対する障壁を引き起こします。

合成データは、多くのデータの課題、特にプライバシー保護、規制順守、アクセシビリティ、データ不足、バイアスなどの AI と分析の問題に対処するツールです。 これには、データ共有とデータ取得までの時間 (つまり、市場投入までの時間) も含まれます。

合成データはアルゴリズムによって生成されます。 これは、ソース データの統計プロパティとパターンを反映しています。 ただし、重要なことは、機密データ、プライベート データ、または個人データ ポイントが含まれていないことです。

合成データについて質問すると、実際のデータから得たのと同じ答えが得られます。

以前の投稿, Generative Adversarial Networks (GANS) のような敵対的ネットワークを使用して表形式のデータセットを生成し、信用詐欺モデルのトレーニングを強化する方法を示しました。

ビジネス関係者が ML および分析プロジェクトに合成データを採用するには、生成された合成データが目的と予想されるダウンストリーム アプリケーションに適合することを確認するだけでなく、その品質を測定および実証できることが不可欠です。生成されたデータ。

プライバシー保護の法的および倫理的義務が高まる中、合成データの強みの XNUMX つは、合成中に機密情報や元の情報を削除できることです。 したがって、品質に加えて、個人情報が漏洩した場合のリスクを評価し、生成プロセスが元のデータを「記憶」またはコピーしていないことを評価するためのメトリクスが必要です。

これらすべてを達成するために、合成データの品質をディメンションにマッピングできます。これにより、ユーザー、利害関係者、および生成されたデータをよりよく理解することができます。

合成データの品質評価の XNUMX つの側面

生成された合成データは、次の XNUMX つの主要なディメンションに対して測定されます。

- 忠実

- ユーティリティ

- 個人情報保護

以下は、合成データ品質レポートで回答する必要がある、生成された合成データに関する質問の一部です。

- 元のトレーニング セットと比較して、この合成データはどの程度類似していますか?

- この合成データは、ダウンストリーム アプリケーションにどの程度役立ちますか?

- 元のトレーニング データから合成データに情報が漏洩していませんか?

- (モデルのトレーニングに使用されていない他のデータセットからの) 現実の世界で機密と見なされるデータが、モデルによって誤って合成されたことがありますか?

エンドユーザー向けにこれらの各ディメンションを変換するメトリックは、ある程度柔軟です。 結局、生成されるデータは、分布、サイズ、および動作に関してさまざまです。 また、理解しやすく、解釈しやすいものにする必要があります。

最終的に、メトリクスは完全にデータ駆動型である必要があり、予備知識やドメイン固有の情報は必要ありません。 ただし、ユーザーが特定のビジネス ドメインに適用可能な特定のルールと制約を適用したい場合は、統合プロセス中にそれらを定義して、ドメイン固有の忠実度が確実に満たされるようにする必要があります。

次のセクションでは、これらの各指標について詳しく説明します。

忠実度を理解するための指標

どのようなデータ サイエンス プロジェクトでも、特定のサンプル母集団が解決しようとしている問題に関連しているかどうかを理解する必要があります。 同様に、生成された合成データの関連性を評価するプロセスでは、次の観点から評価する必要があります。 忠実 オリジナルと比べて。

これらの指標を視覚的に表現すると、理解しやすくなります。 カテゴリのカーディナリティと比率が尊重されているかどうか、さまざまな変数間の相関関係が維持されているかどうかなどを示すことができました。

データを視覚化することは、合成データの品質を評価するのに役立つだけでなく、データをよりよく理解するためのデータ サイエンス ライフサイクルの最初のステップの XNUMX つとしても適しています。

いくつかの忠実度指標について詳しく見ていきましょう。

探索的統計比較

探索的統計比較では、元のデータセットと合成データセットの特徴が、平均、中央値、標準偏差、個別値、欠損値、最小値、最大値、連続特徴の四分位数などの主要な統計的尺度を使用して調査されます。カテゴリごとのレコード数、カテゴリごとの欠損値、およびカテゴリ属性の最も出現頻度の高い文字。

この比較は、元のホールドアウト データセットと合成データの間で実施する必要があります。 この評価により、比較されたデータセットが統計的に類似しているかどうかが明らかになります。 そうでない場合は、どの機能とメジャーが異なるかを理解できます。 大きな違いが見られる場合は、異なるパラメーターを使用して合成データを再トレーニングおよび再生成することを検討する必要があります。

このテストは、合成データが元のデータセットに対して妥当な忠実度を持っていることを確認するための最初のスクリーニングとして機能し、したがって、より厳密なテストを有効に受けることができます。

ヒストグラム類似度スコア

ヒストグラム類似度スコアは、合成データセットと元のデータセットの各特徴の限界分布を測定します。

類似性スコアは XNUMX から XNUMX の間で制限され、スコア XNUMX は、合成データの分布が元のデータの分布と完全に重複していることを示します。

XNUMX に近いスコアは、ホールドアウト データセットと合成データセットが統計的に類似しているという確信をユーザーに与えます。

相互情報量

相互情報量スコアは、数値またはカテゴリの XNUMX つの特徴の相互依存性を測定し、別の特徴を観察することによって XNUMX つの特徴からどの程度の情報を取得できるかを示します。

相互情報は非線形関係を測定でき、変数の関係の保存の程度を理解できるため、合成データの品質をより包括的に理解できます。

スコア XNUMX は、特徴間の相互依存性が合成データに完全に取り込まれていることを示します。

相関スコア

相関スコアは、元のデータセットの相関が合成データにどの程度うまく取り込まれているかを測定します。

XNUMX つ以上の列間の相関関係は、ML アプリケーションにとって非常に重要です。これは、特徴とターゲット変数の間の関係を明らかにし、十分にトレーニングされたモデルを作成するのに役立ちます。

相関スコアは XNUMX から XNUMX の間で制限され、XNUMX のスコアは相関が完全に一致したことを示します。

データの問題でよく遭遇する構造化された表形式データとは異なり、一部のタイプの構造化データには、過去の観測が次の観測に影響を与える可能性があるという特定の動作があります。 これらは、時系列データまたは連続データとして知られています。たとえば、室温を XNUMX 時間ごとに測定したデータセットです。

この動作は、これらの時系列データセットの品質を具体的に測定できる特定のメトリックを定義する必要があることを意味します

自己相関スコアと偏自己相関スコア

相関に似ていますが、自己相関は、以前の値に関連する現在の値での時系列の関係を示します。 前のタイム ラグの影響を取り除くと、部分的な自己相関が得られます。 したがって、自己相関スコアは、合成データが元のデータセットから有意な自己相関または偏相関をどの程度うまく捉えたかを測定します。

有用性を理解するための指標

これで、合成データが元のデータセットに似ていることが統計的にわかったかもしれません。 さらに、合成されたデータセットが、複数の ML アルゴリズムでトレーニングされたときに、一般的なデータ サイエンスの問題をどの程度うまく処理できるかを評価する必要もあります。

以下を使用する ユーティリティ 元のデータがどのように機能したかについて、ダウンストリーム アプリケーションで実際にパフォーマンスを達成できるという確信を築くことを目指しています。

予測スコア

元の実際のデータと比較した合成データのパフォーマンスの測定は、ML モデルを通じて行うことができます。 ダウンストリーム モデル スコアは、合成データセットと元のデータセットの両方でトレーニングされ、元のデータセットから保留されたテスト データで検証された ML モデルのパフォーマンスを比較することにより、合成データの品質をキャプチャします。 これにより、 合成テスト リアル (TSTR) スコアのトレーニング フォルダーとその下に トレーニング リアル テスト リアル (TRTR) それぞれ採点。

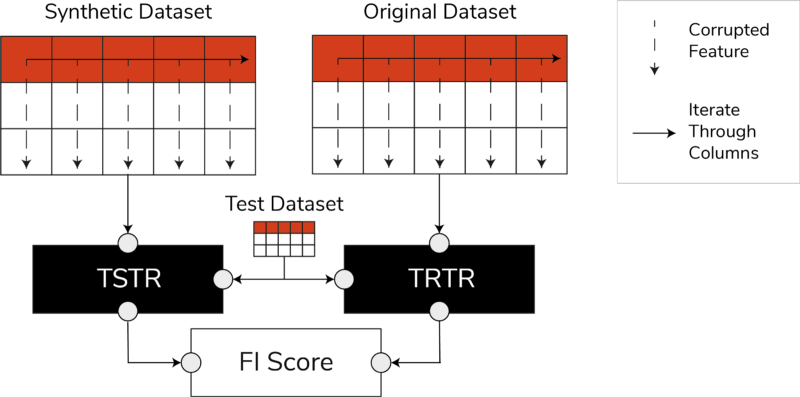

TSTR、TRTR スコア、機能重要度スコア (著者による画像)

スコアには、回帰または分類タスク用の最も信頼できる ML アルゴリズムが幅広く組み込まれています。 いくつかの分類子とリグレッサーを使用すると、ほとんどのアルゴリズムでスコアがより一般化できるようになり、合成データが将来的に有用であると見なされる可能性があります。

最終的に、TSTR スコアと TRTR スコアが同程度であれば、合成データが実際のアプリケーション向けに効果的な ML モデルをトレーニングするために使用できる品質を備えていることを示しています。

機能の重要度スコア

予測スコアに大きく関係する機能重要度 (FI) スコアは、TSTR および TRTR スコアに解釈可能性を追加することで予測スコアを拡張します。

F1 スコアは、得られた特徴の重要度の順序の変化と安定性を予測スコアと比較します。 合成データ セットは、元の実際のデータと同じ順序で特徴の重要度が得られる場合、有用性が高いと見なされます。

Qスコア

新しく生成されたデータでトレーニングされたモデルが、元のデータを使用してトレーニングされたモデルと同じ質問に対して同じ回答を生成することを確認するために、Qscore を使用します。 これは、合成データセットと元の (およびホールドアウト) データセットの両方に対して多数のランダム集計ベースのクエリを実行することにより、合成データのダウンストリーム パフォーマンスを測定します。

ここでの考え方は、これらの両方のクエリが同様の結果を返す必要があるということです。

高い QScore により、クエリと集計操作を利用するダウンストリーム アプリケーションが、元のデータセットとほぼ同等の値を提供できるようになります。

プライバシーを理解するための指標

プライバシー 規制はすでに実施されているため、機密情報を確実に保護することは倫理的義務であり、法的要件でもあります。

この合成データを自由に共有して下流のアプリケーションに使用する前に、漏洩情報の範囲に関して、生成された合成データが元のデータと比較してどこにあるのかを利害関係者が理解するのに役立つプライバシー メトリクスを検討する必要があります。 さらに、合成データをどのように共有して使用できるかについて、重要な決定を下さなければなりません。

完全一致スコア

プライバシーの直接的かつ直感的な評価は、合成記録の中から実際のデータのコピーを探すことです。 完全一致スコアは、合成セット内で検出できる実際のレコードの数をカウントします。

スコアはゼロで、合成データには実際の情報がそのまま存在しないことを示します。 このメトリクスは、さらなるプライバシー メトリクスを評価する前のスクリーニング メカニズムとして機能します。

ネイバーのプライバシー スコア

さらに、隣人のプライバシー スコアは、類似性が本物のレコードに近すぎる可能性のある合成レコードの比率を測定します。 つまり、それらは直接のコピーではありませんが、プライバシー漏洩の潜在的なポイントであり、推論攻撃の有用な情報源になることを意味します。

スコアは、元のデータと重ね合わせた合成データに対して高次元最近傍検索を実行することによって計算されます。

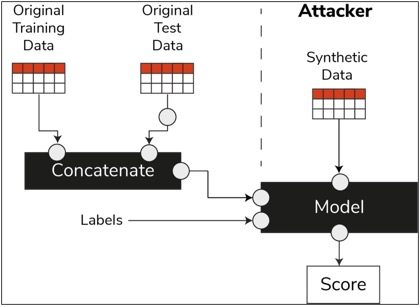

メンバーシップ推論スコア

データ サイエンスのライフサイクルでは、モデルがトレーニングされると、トレーニング サンプルにアクセスする必要がなくなり、目に見えないデータに対して予測を行うことができます。 同様に、私たちの場合、シンセサイザー モデルがトレーニングされると、元のデータを必要とせずに合成データのサンプルを生成できます。

と呼ばれるタイプの攻撃によって 「メンバーシップ推論攻撃」、攻撃者は、元のデータにアクセスすることなく、合成データの作成に使用されたデータを明らかにしようとすることができます. これにより、プライバシーが侵害されます。

メンバーシップ推定スコアは、メンバーシップ推定攻撃が成功する可能性を測定します。

低いスコアは、特定のレコードが合成データの作成につながったトレーニング データセットのメンバーであったという推論の実現可能性を示唆しています。 つまり、攻撃によって個人の記録の詳細が推測され、プライバシーが侵害される可能性があります。

高いメンバーシップ推論スコアは、特定のレコードが合成データの作成に使用された元のデータセットの一部であったかどうかを攻撃者が判断する可能性が低いことを示します。 これは、合成データによって個人の情報が侵害されなかったことも意味します。

ホールドアウトのコンセプト

従わなければならない重要なベスト プラクティスは、合成データが十分に一般的であり、トレーニングに使用された元のデータに過適合しないようにすることです。 典型的なデータ サイエンス フローでは、ランダム フォレスト分類器などの ML モデルを構築する際に、テスト データを脇に置き、トレーニング データを使用してモデルをトレーニングし、目に見えないテスト データの指標を評価します。

同様に、合成データの場合、元のデータのサンプル (一般にホールドアウト データセットまたは非表示の保留テスト データと呼ばれます) を確保し、生成された合成データをホールドアウト データセットに対して評価します。

ホールドアウト データセットは元のデータの表現であると予想されますが、合成データが生成されたときには表示されません。 したがって、元のデータセットとホールドアウト データセットおよび合成データセットを比較するときは、すべてのメトリックのスコアが類似していることが重要です。

同様のスコアが得られた場合、同じ忠実度と有用性を維持しながら、合成データ ポイントが元のデータ ポイントの記憶の結果ではないことを立証できます。

最終的な考え

世界は合成データの戦略的重要性を理解し始めています。 データ サイエンティストおよびデータ ジェネレーターとして、生成する合成データに信頼を築き、それが目的のためのものであることを確認することは、私たちの義務です。

合成データは、データ サイエンス開発ツールキットの必須アイテムに進化しています。 MITテクノロジーレビューは 注意 合成データは、2022 年の画期的な技術の XNUMX つです。合成データなしで優れた価値の AI モデルを構築することは想像できないと主張しています。 ガートナー.

による マッキンゼー、合成データは、アルゴリズムを開発したりデータにアクセスしたりする際に発生するコストと障壁を最小限に抑えます。

合成データの生成とは、下流のアプリケーションを知り、合成データの品質に関するさまざまな次元間のトレードオフを理解することです。

まとめ

合成データのユーザーとして、合成のすべてのサンプルが将来使用されるユースケースのコンテキストを定義することが不可欠です。 実際のデータと同様に、合成データの品質は、意図したユースケースと、合成のために選択されたパラメーターに依存します。

たとえば、元のデータと同じように合成データの外れ値を維持することは、不正検出のユースケースに役立ちます。 ただし、外れ値は一般に情報漏えいの可能性があるため、プライバシーが懸念される医療のユースケースでは役に立ちません。

さらに、忠実度、実用性、およびプライバシーの間にはトレードオフが存在します。 XNUMX つすべてについて同時にデータを最適化することはできません。 これらのメトリクスにより、利害関係者は各ユースケースに不可欠なものに優先順位を付け、生成された合成データからの期待を管理できます。

最終的に、各メトリクスの値を確認し、それらが期待を満たしている場合、関係者は合成データを使用して構築したソリューションに自信を持つことができます。

構造化された合成データのユース ケースは、ソフトウェア開発用のテスト データから臨床試験における合成コントロール アームの作成まで、幅広い用途をカバーしています。

これらの機会を探索するために手を差し伸べるか、価値を実証するために PoC を構築してください。

ファリス・ハダッド AABG Strategic Pursuits チームの Data & Insights Lead です。 彼は、企業がデータ駆動型になるのを支援しています。

ファリス・ハダッド AABG Strategic Pursuits チームの Data & Insights Lead です。 彼は、企業がデータ駆動型になるのを支援しています。