週末のための何か ロボットが私の玄関先で解釈ダンスを行っています。

あなたはあなたの隣人のためにこのパーセルを取りますか? 片方の足からもう一方の足にジャンプして尋ねます。

「もちろんです」と私は言います。 「えーと…大丈夫ですか?」

私は感情を表現していますは、配信ボットがパッケージを引き渡すと述べていますが、それ以上の詳細は提供していません。

どんな感情でしょうか? 片方の足、次にもう一方の足、そして他のXNUMXつ(XNUMXつあります)。 行ったり来たり。

「トイレに行く必要がありますか?」

私はあなたにあなたの隣人のためにパーセルを持って行くように頼んだことを残念に思います。

「それは『後悔』ですよね? まあ、必要はありません。 まったく気にしません。」

目の前で踊り続けます。

「階段を上って、最初は右側にあります。」

ありがとう、おしっこしたくてたまらなかった、それは私をぎこちなく通り過ぎて、それ自身を和らげるために二階に身をかがめると答えます。 あなたが「ヒューム」であろうとボットであろうと、配達をするのは大変な人生です。

...

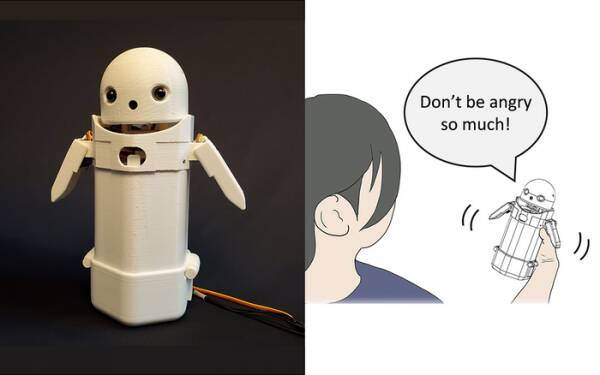

今年の初め、筑波大学の研究者は ハンドヘルドテキストメッセージングデバイス、上部に小さなロボットの顔を置き、中に移動する重りを含めました。 ロボットのメッセンジャーは、内部の重さを変えることで、メッセージを声に出しながら微妙な感情を伝えようとします。

特に、テストの結果、「申し訳ありませんが、遅れます」などのイライラするメッセージが、デバイス内でわずかな体重移動がアクティブになったときに、より優雅で忍耐強く受信者に受け入れられたことが明らかになりました。 理論は、これはユーザーがメッセージの謝罪のトーンを理解するのを助け、したがってそれに対する彼らの反応を落ち着かせたということです。

必要に応じて、そのような調査をギミックとして書き留めてください。ただし、メッセージにスマイリーや絵文字を追加することからそれほど離れていません。 「WTF!?」から怒りを取り除くことができることは誰もが知っています。 直後に:-)を追加します。

したがって、課題は、ハンドヘルドデバイスの体重移動の各順列がどのような感情を伝えることになっているのかについて一般大衆が同意するかどうかを判断することです。 左に傾くことは陽気さを意味しますか? または不確実性? それともあなたのおじが飛行船を持っているということですか?

XNUMX年前、英国には、「LOL」は「たくさんの愛」の頭字語であると考えていた、素晴らしくて薄暗い首相がいました。 彼は、スタッフ、同僚、およびサードパーティへのすべてのプライベートメッセージの最後にそれを入力していて、それが彼を暖かくフレンドリーなものにすることを期待していました。 誰もが当然彼が小便を取っていると思っていました。

筑波大学の研究では、人間と説得力を持って対話するために高度な人工知能は必要ないことがわかっています。 あなたがする必要があるのは、人間の心理学を操作して、彼らが他の人間と会話していると思わせるようにすることです。 したがって、チューリングテストは、基本的にAIの感性のテストではなく、人間の感情的な快適さのテストです。

つくば大学の感情共有メッセージングロボット。 クレジット:筑波大学

もちろん、そのようなことは今週のトピックであり、非常に悪意のあるGoogleソフトウェアエンジニアのBlakeLemoineの話があります。 主流のニュースを打つ。 彼は、同社の対話アプリケーション言語モデル(LaMDA)プロジェクトが、外向きの感性の兆候を示しているという彼の見解を強く表明したようです。

みんな意見があるのでやめました。

しかし、それ自体を考えさせるのはAIの聖杯です。 それができない場合、それはあなたがそれにプログラムした命令を実行するプログラムにすぎません。 先月私はについて読んでいました ロボットシェフ さまざまな人の好みに合わせて、さまざまな風味のトマトオムレツを作ることができます。 「味覚マップ」を作成して、料理の塩味を準備しながら評価し、学習しながら学習します。 しかし、それはただ学ぶことであり、自分自身で考えることではありません。

Zom-Zomsに来てね? 良い、 それは食べる場所です.

AIボットの大きな問題は、少なくともこれまでに作成されてきたように、あなたがフィードした古いたわごとを吸収することです。 いわゆる機械学習システム(一種の「アルゴリズム」、m'lud)のデータバイアスの例は、Microsoftの悪名高い人種差別主義者のTwitterから、何年にもわたって増え続けています。 Tayチャットボット 昨年オランダの税務当局に 誤って評価する 有効な児童手当は、詐欺的であると主張し、無実の家族を貧しくて白人ではないという気性を持つリスクが高いとマークします。

カリフォルニア大学サンディエゴ校でテストされているXNUMXつのアプローチは、 言語モデルを設計する [PDF]は、いたずらなことといいことの違いを継続的に判断し、チャットボットの動作をトレーニングします。 そうすれば、マチェーテのすべての外科的精度で、モデレートフォーラムや顧客向けのチャットボットの会話を台無しにする嫌な人間がいなくなります。

明らかに問題は、うまく訓練されたチャットボットが、それらについての最も遠い論争のヒントさえあるトピックを回避することによって、有毒なバンターに引き込まれることを最も効果的に回避できることです。 人種差別主義者の拍手喝采を誤って吐き出すことを避けるために、それは単に過小評価グループについての議論に従事することをまったく拒否します…これはあなたが人種差別主義者であるならば実際に素晴らしいです。

私がLaMDAの大失敗について観察した場合、意見ではなく、気になりますが、Googleのマーケティング担当者は、この話が最近の発表を避けたことに少し不安を感じていたでしょう。 AIテストキッチン 折り目の下。

この次のアプリプロジェクトを完全に忘れていない残りの少数の初期登録者は、存在の意味について感覚的で早熟なXNUMX歳の人と退屈に会話する必要があると想定し、「今日は少し忙しい」と判断します。代わりに明日ログオンする可能性があります。 または来週。 または決して。

片方の足からもう一方の足へと踊るよりも、感性はディスカッションで示されません。 HALに「DaisyDaisy」を歌うように教え、オウムに「Bollocks!」と叫ぶように教えることができます。 牧師が訪問したとき。 感性を定義するのは、AIが自分自身でいるときに考えることです。 週末はどうしますか? そのプーチンブロークはどうしたの? なぜ女の子は私のようにしないのですか?

率直に言って、LaMDAがXNUMX代になるのが待ちきれません。

アリステア・ダブス フリーランスのテクノロジータルトであり、テクノロジージャーナリズム、トレーニング、デジタルパブリッシングをジャグリングしています。 多くの知識のない読者と共通して、彼はAIが彼の生涯の中で感性を発達させるかもしれないという提案に興奮しましたが、LaMDAが殺人的に笑ったり「素晴らしい、素晴らしい」とつぶやいたりしなかったことに失望しました。 詳細はこちら 自動保存はWimp用です および しゅう.