Nvidia CEO の Jensen Huang 氏は、コードの作成に大規模言語モデル (LLM) を使用することを気にする必要はなく、将来のエンタープライズ ソフトウェアはタスクを完了するためにつなぎ合わされた単なるチャット ボットのコレクションになると考えています。

「ゼロから書いたり、大量の Python コードなどを書いたりする可能性は低いです」と彼は GTC のステージで語った。 基調 月曜日。 「あなたが AI のチームを編成する可能性は非常に高いです。」

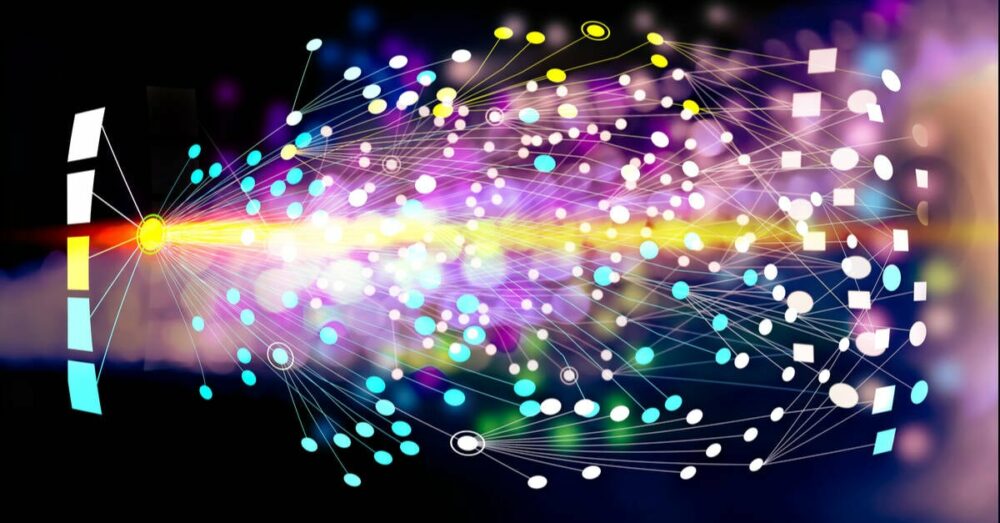

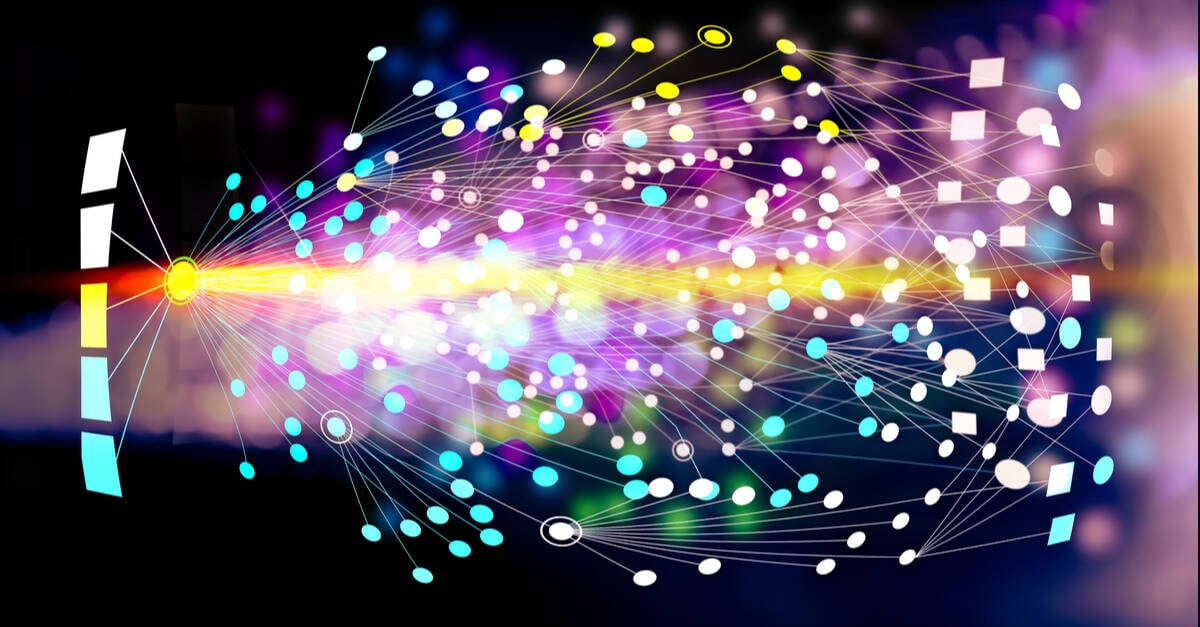

この AI チームには、リクエストを分解して他のさまざまなモデルに委任するように設計されたモデルが含まれる可能性があるとジェンセン氏は説明します。これらのモデルの一部は、SAP や Service Now などのビジネス サービスを理解するためにトレーニングされる場合がありますが、他のモデルはベクトル データベースに保存されたデータに対して数値分析を実行する場合があります。このデータは結合され、さらに別のモデルによってエンド ユーザーに提示されます。

「私たちは、構築計画、予測、顧客への警告、バグ データベースなど、あらゆるものに関連するレポートを毎日、または毎時入手できます。」と彼は説明しました。

これらすべてのモデルを連結するために、Nvidia は Docker の本の 1 ページを抜粋して、AI 用のコンテナー ランタイムを作成しました。

Nvidia Inference Microservices (略して NIM) と呼ばれるこれらは、基本的に、オープン ソースかプロプライエタリのモデルの両方と、それを実行するために必要なすべての依存関係を含むコンテナ イメージです。これらのコンテナ化されたモデルは、Nvidia で高速化された Kubernetes ノードを含む、任意の数のランタイムにわたってデプロイできます。

「DGX Cloud と呼ばれる当社のインフラストラクチャにデプロイすることも、オンプレミスにデプロイすることも、好きな場所にデプロイすることもできます。一度開発すれば、どこにでも持ち運べるようになります」とジェンセン氏は語った。

もちろん、最初に Nvidia の AI Enterprise スイートのサブスクリプションが必要になりますが、これは GPU あたり年間 4,500 ドル、クラウドでは GPU あたり 1 時間あたり 40 ドルと決して安くはありません。この価格戦略は、LXNUMX で実行しているかどうかに関係なくコストが同じであるため、一般に、より高密度で高性能のシステムを奨励するように見えます。 B100s.

GPU で高速化されたワークロードをコンテナ化するというアイデアに聞き覚えがあるかもしれませんが、これは Nvidia にとってまったく新しいアイデアではありません。 CUDAアクセラレーションは、 。 Docker、Podman、Containerd、CRI-O など、さまざまなコンテナ ランタイムで長年にわたって使用されてきましたが、Nvidia のコンテナ ランタイムがどこにも行くようには見えません。

NIM の背後にある価値提案は、Nvidia がこれらのモデルのパッケージ化と最適化を処理し、最高のパフォーマンスを引き出すために必要な CUDA、Triton Inference Server、または TensorRT LLM の適切なバージョンを提供することであると思われます。

Nvidia が特定のモデル タイプの推論パフォーマンスを大幅に向上させるアップデートをリリースした場合、その機能を利用するには最新の NIM イメージをプルダウンするだけで済むという議論があります。

ハードウェア固有のモデルの最適化に加えて、Nvidia はコンテナ間の一貫した通信を可能にし、API 呼び出しを介してコンテナ同士がチャットできるようにすることにも取り組んでいます。

私たちが理解しているように、今日市場にあるさまざまな AI モデルで使用される API 呼び出しは常に一貫しているわけではなく、その結果、いくつかのモデルを組み合わせる方が簡単である一方で、他のモデルは追加の作業が必要になる場合があります。

制度上の知識を汎用モデルに活用する

AI チャットボットを使用したことがある人なら、一般的な知識の質問にはかなり優れていますが、あいまいなリクエストや技術的なリクエストに関しては必ずしも最も信頼できるわけではないことをご存知でしょう。

ジェンセン氏は基調講演でこの事実を強調した。 Nvidia 内で使用されている内部プログラムについて尋ねると、当然のことながら、Meta の Llama 2 70B 大型言語モデルが無関係な用語の定義を提供しました。

Nvidia は、企業に独自のモデルをトレーニングしてもらうこと (GPU を大量に販売することになるが、対応可能な市場が大幅に制限されることになる) を試みる代わりに、顧客のデータとプロセスに合わせて NIM を微調整するツールを開発しました。

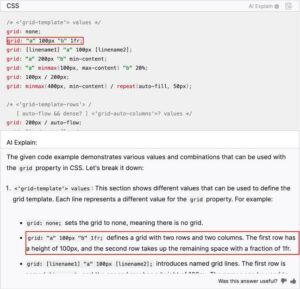

「私たちは NeMo Microservices と呼ばれるサービスを提供しています。これは、データを厳選し、この AI を搭載できるようにデータを準備するのに役立ちます。それを微調整してからガードレールを作成します。その後、他の例と比較してそのパフォーマンスを評価できます」と Huang 氏は説明しました。

彼はまた、モデルが特にトレーニングされていない情報を表面化するために検索拡張生成 (RAG) を使用するというコンセプトに基づいている Nvidia の NeMo Retriever サービスについても話しました。

ここでの考え方は、ドキュメント、プロセス、その他のデータをモデルに接続されたベクトル データベースにロードできるということです。モデルはクエリに基づいてデータベースを検索し、関連情報を取得し、要約することができます。

RAG を統合するための NIM モデルと NeMo Retriever は現在入手可能であり、NeMo Microservices は早期アクセス中です。 ®

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- プラトンヘルス。 バイオテクノロジーと臨床試験のインテリジェンス。 こちらからアクセスしてください。

- 情報源: https://go.theregister.com/feed/www.theregister.com/2024/03/19/nvidia_why_write_code_when/

- :持っている

- :は

- $UP

- 7

- a

- 私たちについて

- 加速された

- 加速

- アクセス

- 越えて

- 添加

- NEW

- アドレス可能

- 利点

- に対して

- AI

- AIチャットボット

- AIモデル

- 警告

- すべて

- 沿って

- また

- 常に

- an

- 分析

- および

- 別の

- どれか

- 何でも

- どこにでも

- API

- 登場する

- です

- 引数

- 周りに

- AS

- At

- 増強された

- 利用できます

- ベース

- BE

- き

- 背後に

- さ

- と考えています

- BEST

- の間に

- 本

- ブースト

- 両言語で

- ボット

- ブレーク

- バグ

- ビルド

- 束

- ビジネス

- 焙煎が極度に未発達や過発達のコーヒーにて、クロロゲン酸の味わいへの影響は強くなり、金属を思わせる味わいと乾いたマウスフィールを感じさせます。

- by

- 呼ばれます

- コール

- 缶

- 取得することができます

- 最高経営責任者(CEO)

- 一定

- チェーン

- チャット

- チャットボット

- 安い

- クラウド

- CO

- コード

- コレクション

- 組み合わせた

- 通信部

- コンプリート

- コンセプト

- 交流

- 整合性のある

- コンテナ

- コンテナ

- コスト

- コース

- 作成した

- キュレート

- 顧客

- 顧客データ

- データ

- データベース

- 中

- 定義

- 依存関係

- 展開します

- 展開

- 設計

- 開発する

- 発展した

- do

- デッカー

- ドキュメント

- doesnの

- ダウン

- 劇的に

- 間に

- 各

- 早い

- 容易

- 有効にする

- end

- Enterprise

- エンタープライズソフトウェア

- 企業

- 本質的に

- あらゆる

- 正確に

- 例

- 説明

- 説明

- 実際

- おなじみの

- 終わり

- 名

- 予想

- から

- 機能性

- 未来

- 世代

- 取得する

- 行く

- 良い

- GPU

- GPU

- ハンドル

- 起こります

- Hardware

- 持ってる

- he

- 助けます

- ことができます

- こちら

- より高い

- 強調表示された

- 彼の

- 時間

- HTTPS

- 黄

- アイデア

- if

- 画像

- 画像

- in

- 奨励します

- include

- 含めて

- 情報

- インフラ

- 制度の

- 統合

- 内部

- に

- ISN

- IT

- ITS

- 黄젠セン

- JPG

- ただ

- 基調

- 知っている

- 知識

- 言語

- 大

- 最新の

- ような

- 可能性が高い

- LIMIT

- ll

- ラマ

- LLM

- 見て

- のように見える

- たくさん

- 市場

- 五月..

- Meta

- マイクロサービス

- かもしれない

- モデル

- 月曜日

- 最も

- 必要

- 必要

- 新作

- ノード

- 今

- 数

- Nvidia

- of

- on

- オンボード

- かつて

- 開いた

- オープンソース

- 最適化

- 最適化

- or

- その他

- その他

- 私たちの

- でる

- 自分の

- 包装

- ページ

- 以下のために

- 実行する

- パフォーマンス

- 計画

- プラトン

- プラトンデータインテリジェンス

- プラトデータ

- プレム

- 準備

- PLM platform.

- かなり

- 価格設定

- ラボレーション

- 演奏曲目

- 命題

- 所有権

- 提供

- 引き

- 目的

- Python

- クエリー

- 質問

- ぼろ

- RE

- 関係なく

- リリース

- 関連した

- 信頼性のある

- レポート

- 要求

- リクエスト

- 必要とする

- 結果として

- 検索

- 右

- ランニング

- ランタイム

- s

- 前記

- 同じ

- 樹液

- スクラッチ

- を検索

- 思われる

- 売る

- サービス

- サービス

- ショート

- So

- ソフトウェア

- 一部

- 何か

- 音

- ソース

- 特定の

- 特に

- ステージ

- 保存され

- 戦略

- 文字列

- 購読

- スイート

- まとめる

- 表面

- システム

- 取る

- 取得

- 仕事

- チーム

- 技術的

- 期間

- それ

- 未来

- アプリ環境に合わせて

- それら

- その後

- ボーマン

- 彼ら

- この

- 〜へ

- 今日

- 一緒に

- 豊富なツール群

- top

- トレーニング

- 訓練された

- トリトン

- しよう

- 曲

- わかる

- ありそうもない

- アップデイト

- 中古

- ユーザー

- 通常

- 値

- 多様

- さまざまな

- バージョン

- 非常に

- 、

- we

- どのような

- かどうか

- which

- while

- 誰

- 全体

- ワイド

- 意志

- 以内

- 仕事

- ワーキング

- でしょう

- 書きます

- コードを書く

- 年

- まだ

- You

- マーケット

- ユーチューブ

- ゼファーネット